17 nov. 2025·8 min

Checklist de préparation pour l’entreprise : faire évoluer un logiciel de façon fiable à la manière de VMware

Utilisez cette checklist de préparation entreprise pour faire évoluer votre produit vers de plus gros clients, avec des leçons pratiques de fiabilité inspirées par Diane Greene et VMware.

Ce qui casse quand vous commencez à vendre aux entreprises

Vendre à de petites équipes porte surtout sur les fonctionnalités et la rapidité. Vendre aux entreprises change la définition du « bon ». Une panne, un bug de permissions déroutant, ou une preuve d’audit manquante peut annuler des mois de confiance.

La fiabilité, en termes simples, signifie trois choses : l’application reste disponible, les données sont protégées, et le comportement reste prévisible. Cette dernière partie compte plus qu’on ne le croit. Les utilisateurs entreprise organisent leur travail autour de votre système. Ils s’attendent au même résultat aujourd’hui, la semaine prochaine et après la prochaine mise à jour.

Ce qui casse généralement en premier n’est pas un serveur isolé. C’est l’écart entre ce que vous avez construit pour quelques utilisateurs et ce que les grands clients considèrent comme acquis. Ils apportent plus de trafic, plus de rôles, plus d’intégrations et plus de contrôle de la part de la sécurité et de la conformité.

Les points de tension initiaux sont prévisibles. Les attentes de disponibilité passent de « globalement correct » à « doit être ennuyeusement stable », avec une gestion d’incident claire. La sécurité des données devient une question au niveau du conseil : sauvegardes, récupération, journaux d’accès et propriété. Les permissions se compliquent vite : départements, prestataires, et principe du moindre privilège. Les changements deviennent risqués : les releases ont besoin de rollback et d’un moyen d’éviter les comportements surprises. Le support cesse d’être « utile » pour devenir partie intégrante du produit, avec des temps de réponse et des chemins d’escalade.

Un client startup peut accepter une panne de deux heures et des excuses rapides. Un client entreprise peut demander un résumé de la cause racine, une preuve que cela ne se reproduira pas, et un plan pour prévenir des échecs similaires.

Une checklist de préparation entreprise ne vise pas un « logiciel parfait ». Elle vise à monter en charge sans rompre la confiance, en améliorant simultanément le design produit, les habitudes d’équipe et les opérations quotidiennes.

Diane Greene et l’état d’esprit VMware en une page

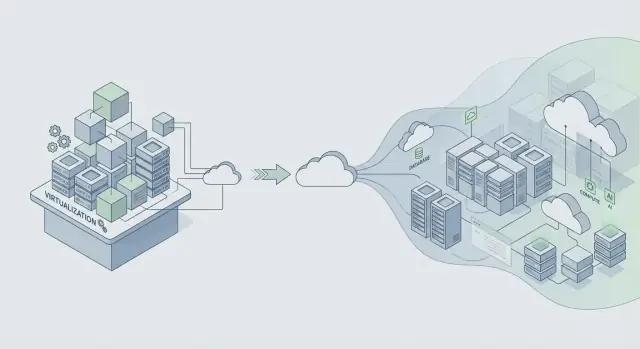

Diane Greene a cofondé VMware à un moment où l’IT entreprise face à un compromis douloureux : avancer vite et risquer des pannes, ou rester stable et accepter le changement lent. VMware a compté parce qu’il a fait en sorte que les serveurs se comportent comme des briques fiables. Cela a permis la consolidation, des mises à jour plus sûres et une récupération plus rapide, sans demander à chaque équipe applicative de réécrire tout son logiciel.

La promesse centrale pour l’entreprise est simple : la stabilité d’abord, les fonctionnalités ensuite. Les entreprises veulent bien de nouvelles capacités, mais elles veulent les avoir au-dessus d’un système qui continue de tourner pendant les patchs, la mise à l’échelle et les erreurs de routine. Quand un produit devient critique pour le business, « nous corrigerons la semaine prochaine » se transforme en perte de revenus, délais manqués et problèmes de conformité.

La virtualisation était un outil pratique de fiabilité, pas seulement une économie de coûts. Elle créait des frontières d’isolation. Une charge de travail pouvait planter sans emporter toute la machine. Elle rendait aussi l’infrastructure plus répétable : si on peut snapshotter, cloner et déplacer une charge de travail, on peut tester des changements et récupérer plus vite quand quelque chose tourne mal.

Cet état d’esprit s’applique toujours : concevez pour le changement sans arrêt de service. Supposez que des composants vont tomber en panne, que les exigences vont bouger, et que les mises à jour auront lieu sous charge réelle. Puis construisez des habitudes qui rendent le changement sûr.

Une façon rapide de décrire l’état d’esprit VMware : isoler la défaillance pour qu’un problème ne se propage pas, traiter les upgrades comme routiniers, rendre le rollback rapide, et préférer le comportement prévisible aux astuces brillantes. La confiance se gagne par une fiabilité ennuyeuse, jour après jour.

Si vous construisez sur des plateformes modernes (ou générez des applis avec des outils comme Koder.ai), la leçon tient : livrez des fonctionnalités uniquement de façons que vous pouvez déployer, surveiller et annuler sans casser l’exploitation des clients.

De VMware aux plateformes cloud : ce qui est resté

VMware a grandi dans un monde de logiciels packagés où « une release » était un grand événement. Les plateformes cloud ont inversé le rythme : des changements plus petits livrés plus souvent. Cela peut être plus sûr, mais seulement quand vous contrôlez le changement.

La constante : le changement est le risque majeur de fiabilité

Que vous livriez un installateur packagé ou poussiez un déploiement cloud, la plupart des pannes commencent de la même manière : un changement atterrit, une hypothèse cachée casse, et le périmètre d’impact est plus grand que prévu. Des releases plus rapides ne suppriment pas le risque. Elles le multiplient quand il manque des garde‑fous.

Les équipes qui montent en charge de façon fiable supposent que chaque release peut échouer, et elles conçoivent le système pour qu’il échoue en sécurité.

Un exemple simple : un changement « sans conséquence » d’index de base de données semble correct en staging, mais en production il augmente la latence d’écriture, met les requêtes en file et fait ressembler les timeouts à des erreurs réseau aléatoires. Des releases fréquentes multiplient les occasions d’introduire ce genre de surprise.

L’infrastructure partagée a changé les modes de défaillance

Les applis de l’ère cloud servent souvent de nombreux clients sur des systèmes partagés. Le multi‑tenant apporte de nouveaux problèmes qui se recoupent toujours sur le même principe : isoler les fautes.

Les problèmes de noisy neighbor (le pic d’un client ralentit les autres) et les pannes partagées (un mauvais déploiement touche tout le monde) sont la version moderne de « un bug fait tomber le cluster ». Les contrôles sont familiers, simplement appliqués en continu : déploiements graduels, contrôles par locataire, limites de ressources (quotas, limites de débit, timeouts), et designs qui acceptent la défaillance partielle.

L’observabilité est l’autre constante. Vous ne pouvez pas protéger la fiabilité si vous ne voyez pas ce qui se passe. De bons logs, métriques et traces vous aident à repérer rapidement les régressions, surtout pendant les rollouts.

Le rollback n’est plus non plus un mouvement d’urgence rare. C’est un outil normal. Beaucoup d’équipes associent rollback, snapshots et étapes de déploiement plus sûres. Des plateformes comme Koder.ai incluent snapshots et rollback, ce qui aide les équipes à annuler rapidement des changements risqués, mais le point le plus important est culturel : le rollback doit être pratiqué, pas improvisé.

Fixez des objectifs de fiabilité avant de monter en charge

Si vous attendez de définir la fiabilité jusqu’à ce qu’un contrat entreprise soit sur la table, vous vous retrouvez à argumenter sur des impressions : « ça a l’air bien ». Les plus gros clients veulent des promesses claires qu’ils peuvent répéter en interne, comme « l’app reste disponible » et « les pages se chargent assez vite aux heures de pointe ».

Commencez par un petit ensemble d’objectifs écrits simplement. Deux sur lesquels les équipes peuvent se mettre d’accord rapidement sont la disponibilité (à quelle fréquence le service est utilisable) et le temps de réponse (à quelle vitesse les actions clés paraissent). Gardez les objectifs liés à ce que font les utilisateurs, pas à une seule métrique serveur.

Un budget d’erreur rend ces objectifs utilisables au quotidien. C’est la quantité d’échec que vous pouvez « dépenser » sur une période tout en tenant votre promesse. Quand vous êtes dans le budget, vous pouvez prendre plus de risques sur la livraison. Quand vous le grignotez, le travail de fiabilité devient prioritaire par rapport aux nouvelles fonctionnalités.

Pour garder les objectifs honnêtes, suivez quelques signaux qui correspondent à l’impact réel : latence sur les actions principales, erreurs (requêtes échouées, crashes, flux cassés), saturation (CPU, mémoire, connexions base, files), et disponibilité sur le chemin critique de bout en bout.

Une fois les objectifs fixés, ils doivent influencer les décisions. Si une release fait monter les erreurs, ne débattez pas. Pausez, corrigez ou rollbackez.

Si vous utilisez une plateforme de développement rapide comme Koder.ai pour livrer plus vite, les objectifs comptent encore plus. La vitesse n’aide que si elle est bornée par des promesses de fiabilité que vous pouvez tenir.

Habitudes d’architecture qui protègent la fiabilité à l’échelle

Faire de la fiabilité un processus d’équipe

Rassemblez vos coéquipiers dans un même endroit pour planifier, construire, déployer et revenir en arrière ensemble.

Le saut de fiabilité entre « marche pour notre équipe » et « marche pour un Fortune 500 » est surtout une question d’architecture. Le changement de mentalité clé est simple : supposez que des parties de votre système tomberont en panne un jour normal, pas seulement lors d’une grosse panne.

Concevez pour la défaillance en rendant les dépendances optionnelles quand c’est possible. Si votre fournisseur de facturation, service d’email ou pipeline analytics est lent, votre application centrale devrait toujours se charger, permettre la connexion et laisser les gens accomplir le travail principal.

Les frontières d’isolation sont votre meilleure amie. Séparez le chemin critique (connexion, workflows principaux, écritures vers la base principale) des fonctionnalités agréables à avoir (recommandations, flux d’activité, exports). Quand des parties optionnelles cassent, elles doivent échouer sans entraîner le cœur du service.

Quelques habitudes évitent les défaillances en cascade en pratique :

- Mettez des timeouts stricts sur chaque appel réseau.

- Réessayez uniquement les opérations sûres à répéter, et ajoutez du jitter pour éviter les tempêtes de retry.

- Utilisez des circuit breakers pour qu’une dépendance en panne ne consomme pas tous vos workers ou connexions DB.

- Contrôlez la charge avec des files et du backpressure pour que les pics deviennent des ralentissements, pas des pannes.

- Préférez la dégradation élégante : retournez des résultats partiels avec un message clair plutôt qu’un 500.

La sécurité des données est l’endroit où « on pourra réparer plus tard » se transforme en temps d’arrêt. Planifiez les sauvegardes, les changements de schéma et la récupération comme si vous en auriez vraiment besoin, parce que vous en aurez.

Exemple : une équipe expédie une app React avec une API Go et PostgreSQL. Un nouveau client entreprise importe 5 millions d’enregistrements. Sans limites, l’import concurrence le trafic normal et tout ralentit. Avec les bons garde‑fous, l’import passe par une file, écrit par lots, utilise des timeouts et des retries sûrs, et peut être mis en pause sans affecter les utilisateurs quotidiens. Si vous construisez sur une plateforme comme Koder.ai, traitez le code généré de la même façon : ajoutez ces garde‑fous avant que des clients réels en dépendent.

Opérations : la partie que la plupart des produits ajoutent trop tard

Les incidents ne sont pas la preuve d’un échec. Ils sont un coût normal d’exploitation d’un vrai logiciel pour de vrais clients, surtout quand l’usage grandit et que les déploiements sont plus fréquents. La différence est la façon dont l’équipe réagit : calmement et corrige la cause, ou panique et répète la même panne le mois suivant.

Au début, beaucoup de produits s’appuient sur quelques personnes qui « savent quoi faire ». Les entreprises n’acceptent pas cela. Elles veulent une réponse prévisible, une communication claire et la preuve que vous apprenez des pannes.

Préparation on‑call (avant d’en avoir besoin)

L’on‑call concerne moins l’héroïsme que la suppression des hypothèses à 2 h du matin. Une configuration simple couvre la plupart de ce qui importe pour les gros clients :

- Nommez un propriétaire principal pour chaque service.

- Gardez des runbooks courts pour les modes de panne principaux.

- Définissez l’escalade : qui appeler, quand et à quelle vitesse.

- Exécutez au moins un exercice planifié.

- Maintenez un endroit unique pour vérifier le statut courant et les changements récents.

Monitoring qui importe

Si les alertes sonnent toute la journée, les gens les désactivent, et le vrai incident passe inaperçu. Lie zles alertes à l’impact utilisateur : échec de connexion, hausse du taux d’erreur, latence dépassant un seuil clair, ou accumulation de jobs en arrière‑plan.

Après un incident, faites un post‑mortem qui se concentre sur les corrections, pas sur les reproches. Capturez ce qui s’est passé, quels signaux manquaient, et quels garde‑fous auraient réduit le rayon d’impact. Transformez cela en un ou deux changements concrets, assignez un responsable et fixez une date d’échéance.

Ces bases opérationnelles séparent une « appli qui marche » d’un service en qui les clients peuvent avoir confiance.

Pas à pas : durcir votre appli pour des clients plus gros

Les grands clients demandent rarement des fonctionnalités nouvelles en premier. Ils demandent : « Peut‑on faire confiance à ça en production, tous les jours ? » La façon la plus rapide de répondre est de suivre un plan de durcissement et de produire des preuves, pas des promesses.

Un plan pratique de durcissement en 5 étapes

-

Listez ce que vous respectez déjà vs ce qui manque. Écrivez les attentes entreprise que vous pouvez honnêtement soutenir aujourd’hui (objectifs de disponibilité, contrôle d’accès, journaux d’audit, rétention des données, localisation des données, SSO, heures de support). Marquez chaque élément comme prêt, partiel ou non prêt. Cela transforme la pression vague en un backlog court.

-

Ajoutez la sécurité des releases avant d’envoyer plus. Les entreprises se préoccupent moins de la fréquence de vos déploiements que de votre capacité à déployer sans incidents. Utilisez un environnement de staging qui reflète la production. Utilisez des feature flags pour les changements risqués, des canary releases pour un déploiement progressif, et un plan de rollback exécutable rapidement. Si vous vous appuyez sur une plateforme qui supporte snapshots et rollback (Koder.ai le fait), entrainez‑vous à restaurer une version précédente pour que ce soit de la mémoire musculaire.

-

Prouvez la protection des données, puis prouvez‑le encore. Les sauvegardes ne sont pas une case à cocher. Planifiez des sauvegardes automatisées, définissez la rétention et exécutez des tests de restauration selon un calendrier. Ajoutez des pistes d’audit pour les actions clés (changements d’admin, exports de données, modifications de permissions) pour que les clients puissent enquêter et satisfaire la conformité.

-

Documentez le support et la réponse aux incidents en langage clair. Rédigez une promesse d’une page : comment signaler un incident, temps de réponse attendus, qui communique les mises à jour, et comment vous réalisez les rapports post‑incident.

-

Organisez une revue de préparation avec un plan de test de charge réaliste. Choisissez un scénario de type entreprise et testez‑le de bout en bout : pic de trafic, base lente, nœud en échec, et rollback. Exemple : un nouveau client importe 5 millions d’enregistrements un lundi matin pendant que 2 000 utilisateurs se connectent et génèrent des rapports. Mesurez ce qui casse, corrigez le principal goulot, et répétez.

Faites ces cinq étapes et les conversations commerciales deviennent plus simples parce que vous pouvez montrer votre travail.

Une histoire réaliste de montée en charge : un nouveau client entreprise

Renforcer ce que vous expédiez

Créez rapidement un scénario de test de charge, puis durcissez-le avec files, timeouts et retries.

Une appli SaaS mid‑market a quelques centaines de clients et une petite équipe. Puis elle signe son premier client régulé : une banque régionale. Le contrat inclut des attentes strictes de disponibilité, des contrôles d’accès serrés et la promesse de répondre rapidement aux questions de sécurité. Rien dans les fonctionnalités principales ne change, mais les règles d’exploitation oui.

Dans les 30 premiers jours, l’équipe effectue des améliorations « invisibles » que les clients ressentent quand même. Le monitoring passe de « est‑on up ? » à « qu’est‑ce qui casse, où et pour qui ? ». Ils ajoutent des dashboards par service et des alertes liées à l’impact utilisateur, pas au bruit CPU. Les contrôles d’accès deviennent formels : authentification renforcée pour les actions admin, rôles revus, et accès production journalisé et limité dans le temps. L’auditabilité devient une exigence produit, avec des logs cohérents pour les échecs de connexion, les changements de permission, les exports et les éditions de config.

Deux semaines plus tard, une release tourne mal. Une migration de base de données prend plus de temps que prévu et commence à faire timeout des requêtes pour un sous‑ensemble d’utilisateurs. Ce qui empêche que ça devienne un incident de plusieurs jours, c’est la discipline de base : un plan de rollback clair, un responsable d’incident unique, et un script de communication.

Ils mettent en pause le rollout, redirigent le trafic loin du chemin lent, et rollbackent vers la dernière version connue bonne. Si votre plateforme supporte snapshots et rollback (Koder.ai le fait), cela peut aller beaucoup plus vite, mais il faut quand même une procédure entraînée. Pendant la récupération, ils envoient des mises à jour courtes toutes les 30 minutes : ce qui est impacté, ce qui est fait, et l’heure du prochain point.

Un mois plus tard, le « succès » ressemble à de l’ennui dans le meilleur sens. Les alertes sont moins nombreuses mais plus significatives. La récupération est plus rapide parce que les responsabilités sont claires : une personne on‑call, une personne qui coordonne, et une personne qui communique. La banque cesse de demander « avez‑vous le contrôle ? » et commence à demander « quand pouvons‑nous étendre le déploiement ? »

Pièges courants qui nuisent à la fiabilité en grandissant

La croissance change les règles. Plus d’utilisateurs, plus de données et de gros clients font que de petites lacunes deviennent des pannes, des incidents bruyants ou de longs fils de support. Beaucoup de ces problèmes semblent « acceptables » jusqu’à la semaine où vous signez votre premier gros contrat.

Les pièges les plus fréquents :

- Livrer vite sans bouton d’annulation sûr. Si vous ne pouvez pas rollbacker en quelques minutes, chaque déploiement devient risqué. Ça vous ralentit et augmente le stress.

- Faire de la fiabilité « le boulot des ingénieurs ». Les pannes sont aussi un problème support et communication. Si le support n’a pas d’états clairs, la correction technique arrive trop tard pour protéger la confiance.

- Bruitage d’alertes qui habitue à ignorer les alarmes. Si tout déclenche une page, rien n’est urgent.

- Supposer que des backups signifient pouvoir restaurer. Les backups prouvent que les données sont sauvegardées, pas que la restauration est rapide. Si vous n’avez pas pratiqué la restauration, vous ne connaissez pas votre temps réel de récupération.

- Features entreprise one‑off qui affaiblissent le cœur. Comportements personnalisés, flags cachés et déploiements spéciaux s’accumulent. Chaque exception augmente la surface de test et complique le diagnostic des incidents.

Un exemple simple : une équipe ajoute une intégration custom pour un gros client et la déploie en hotfix un vendredi soir. Il n’y a pas de rollback rapide, les alertes sont déjà bruyantes, et la personne on‑call improvise. Le bug est petit, mais la récupération s’éternise parce que le chemin de restauration n’a jamais été testé.

Si votre checklist de préparation entreprise ne contient que des éléments techniques, élargissez‑la. Incluez le rollback, les exercices de restauration et un plan de communication que le support peut exécuter sans ingénierie dans la salle.

Checklist de préparation entreprise (vérifications rapides)

Construire la première version fiable

Créez une application React, Go et Postgres via le chat, puis itérez en toute sécurité au fur et à mesure des besoins.

Quand des clients plus gros demandent « Êtes‑vous prêts pour l’entreprise ? », ils posent généralement une seule question : peut‑on faire confiance à ça en production ? Utilisez ceci comme un auto‑audit rapide avant de promettre quoi que ce soit dans un appel commercial.

- La fiabilité et la gestion des incidents sont définies (pas implicites). Vous avez des objectifs clairs de disponibilité et performance, du monitoring avec alertes, et un processus d’incident que l’on suit réellement.

- Les bases de sécurité sont appliquées par défaut. L’accès suit le moindre privilège, les actions admin sont journalisées, et clés/secrets ont un propriétaire et un plan de rotation.

- Les données peuvent être restaurées intentionnellement, pas par hasard. Les sauvegardes sont automatisées, la restauration est testée selon un calendrier, et vous pouvez expliquer les migrations et la rétention en termes simples.

- Les releases sont contrôlées et réversibles. Vous pouvez faire des déploiements étagés, rollbacker rapidement, et avez un processus d’approbation simple (même si c’est juste une note de changement et une seconde paire d’yeux).

- Les promesses de support reflètent la réalité. Vous avez un workflow de support (intake, gravité, temps de réponse) et un propriétaire clair pour les escalades.

Avant de montrer une démo, rassemblez des preuves que vous pouvez montrer sans vague : captures d’écran du monitoring montrant taux d’erreur et latence, un exemple de journal d’audit expurgé (« qui a fait quoi, quand »), une note courte sur un exercice de restauration (ce que vous avez restauré et combien de temps ça a pris), et une note d’une page sur les releases et rollback.

Si vous bâtissez des applications sur une plateforme comme Koder.ai, traitez ces vérifications de la même façon. Objectifs, preuves et habitudes répétables comptent plus que les outils utilisés.

Prochaines étapes : transformer la préparation en habitude répétable

La préparation entreprise n’est pas un coup d’éclat avant une grosse affaire. Traitez‑la comme une routine qui garde votre produit calme sous pression, même quand les équipes, le trafic et les attentes clients augmentent.

Transformez votre checklist en un plan d’action court. Choisissez les 3 principaux manques qui créent le plus de risque, rendez‑les visibles et assignez des responsables avec des dates réalistes. Définissez le « fait » en termes simples (par exemple « l’alerte se déclenche en 5 minutes » ou « restauration testée de bout en bout »). Gardez une petite file dans votre backlog pour les blocages entreprise afin que le travail urgent n’étouffe pas le travail important. Quand vous comblez un écart, écrivez ce qui a changé pour que les nouveaux venus puissent le reproduire.

Créez un document interne de préparation que vous réutilisez pour chaque prospect majeur. Gardez‑le court et mettez‑le à jour après chaque conversation client sérieuse. Un format simple fonctionne bien : objectifs de fiabilité, bases de sécurité, gestion des données, déploiement et rollback, et qui est on‑call.

Faites des revues de fiabilité mensuelles liées à des événements réels, pas à des opinions. Servez‑vous des incidents et quasi‑incidents comme ordre du jour : qu’est‑ce qui a échoué, comment l’avons‑nous détecté, comment avons‑nous récupéré, et qu’est‑ce qui empêchera une répétition.

Si vous construisez avec Koder.ai, intégrez la préparation à votre manière de livrer. Utilisez Planning Mode tôt pour cartographier les exigences entreprise avant de lancer des builds, et appuyez‑vous sur snapshots et rollback pendant les releases pour que les corrections restent peu stressantes à mesure que votre processus mûrit. Si vous voulez un endroit unique pour centraliser ce workflow, koder.ai est conçu autour de la construction et de l’itération via le chat tout en gardant des contrôles pratiques comme l’export de source, le déploiement et le rollback à portée de main.

FAQ

Quand devons-nous commencer à nous préparer pour des clients entreprise ?

Commencez avant que l’accord soit signé. Choisissez 2–3 objectifs mesurables (disponibilité, latence pour actions clés, et taux d’erreur acceptable), puis mettez en place les bases pour atteindre ces objectifs : monitoring lié à l’impact utilisateur, une voie de rollback exécutable rapidement, et des restaurations testées.

Si vous attendez que les achats demandent, vous serez contraint à des promesses vagues que vous ne pourrez pas démontrer.

Pourquoi les clients entreprise accordent-ils autant d’importance à la « fiabilité ennuyeuse » ?

Parce que les entreprises optimisent pour des opérations prévisibles, pas seulement des fonctionnalités. Une petite équipe peut tolérer une courte panne suivie d’une réparation ; une entreprise exigera souvent :

- Une indication claire de l’impact (qui/quoi est affecté)

- Un résumé de la cause racine

- Une preuve des mesures préventives (changements spécifiques)

- Des journaux d’audit et des timelines

La confiance se perd quand le comportement est surprenant, même si le bug est mineur.

Quels objectifs de fiabilité devons-nous fixer en premier ?

Utilisez une courte liste de promesses orientées utilisateur :

- Disponibilité : le service est utilisable de bout en bout (pas « un serveur est up »).

- Latence : les actions clés restent sous un seuil en charge normale et de pointe.

- Taux d’erreur : les requêtes échouées ou les flux cassés restent sous une limite.

Créez ensuite un pour une fenêtre temporelle. Quand vous le dépensez, vous arrêtez les déploiements risqués et corrigez la fiabilité en priorité.

Quelle est la façon la plus rapide de rendre les releases plus sûres ?

Traitez le changement comme le principal risque :

- Utilisez un environnement de staging fidèle à la production.

- Déployez progressivement (canary ou déploiement phasé).

- Cachez les changements risqués derrière des feature flags.

- Gardez les migrations réversibles quand c’est possible.

- Entraînez-vous au rollback pour que ce soit routinier, pas panique.

Si votre plateforme prend en charge snapshots et rollback (par exemple, Koder.ai le fait), utilisez-les — mais répétez quand même la procédure humaine.

Les sauvegardes ne suffisent-elles pas pour la sécurité des données entreprise ?

Les sauvegardes prouvent seulement que les données ont été copiées quelque part. Les entreprises demanderont si vous pouvez restaurer volontairement et combien de temps cela prend.

Étapes pratiques minimales :

- Sauvegardes automatisées avec une rétention claire.

- Tests de restauration réguliers (sur calendrier).

- Temps de récupération et point de récupération documentés.

- Un plan pour les changements de schéma et les migrations longues.

Une sauvegarde jamais testée en restauration reste une hypothèse, pas une capacité.

Qu’est-ce qui pose généralement problème avec les permissions quand on monte en charge ?

Commencez simple et strict :

- Par défaut, appliquez le principe du moindre privilège.

- Séparez les rôles admins et utilisateurs normaux.

- Exigez une authentification renforcée pour les actions sensibles d’administration.

- Journalisez les changements de permissions et les accès privilégiés.

Attendez-vous à de la complexité : départements, sous‑traitants, accès temporaire et la question « qui peut exporter des données ? » arrivent vite.

Que doit contenir une piste d’audit pour être prête entreprise ?

Consignez les actions qui répondent à « qui a fait quoi, quand et d’où » pour les événements sensibles :

- Connexions et échecs de connexion

- Changements de rôles/permissions

- Exportations de données et téléchargements massifs

- Modifications de configuration admin

- Accès support ou ingénieur à la production (limitée dans le temps)

Conservez des logs résistants aux altérations, avec une rétention conforme aux attentes clients.

Comment mettre en place le monitoring et l’on-call sans noyer l’équipe d’alertes ?

Visez moins d’alertes mais plus de signal :

- Alertez sur des symptômes impactant l’utilisateur (échec de connexion, hausse du taux d’erreur, dépassement de seuils de latence, backlog de jobs).

- Fournissez des runbooks pour les modes de défaillance principaux.

- Définissez la responsabilité on-call et l’escalade.

- Après un incident, rédigez 1–2 corrections concrètes avec des responsables et des dates.

Les alertes bruyantes habituent les équipes à ignorer la seule notification qui compte.

Qu’est-ce qui change quand on devient multi‑tenant ou qu’on ajoute de gros clients sur une infrastructure partagée ?

Contrôles d’isolation et maîtrise de la charge :

- Limites et quotas par locataire pour réduire l’effet noisy‑neighbor.

- Timeouts et circuit breakers pour empêcher qu’une dépendance consomme tous les workers.

- Files et mécanismes de backpressure pour transformer les pics en ralentissements maîtrisés.

- Déploiements progressifs pour qu’un mauvais deploy ne touche pas tout le monde en même temps.

Le but est d’éviter qu’un problème chez un client devienne une panne pour tous.

Quel est un test de charge réaliste pour la « préparation entreprise » ?

Exécutez un scénario réaliste de bout en bout :

- Connexions de pointe + rapports lourds

- Base de données lente ou migration bloquée

- Nœud/service en échec

- Rollback vers la dernière version connue comme bonne

Mesurez ce qui casse (latence, timeouts, profondeur des files), corrigez le goulot principal et recommencez. Un test courant : un import massif réalisé pendant que le trafic normal continue, avec l’import isolé via batching et files.