Ce que signifie vraiment « meilleur langage backend »

« Meilleur langage backend » est généralement une abréviation pour « le mieux adapté à ce que je construis, avec les personnes et les contraintes dont je dispose. » Un langage peut être parfait pour une charge backend et très inadapté pour une autre — même s'il est populaire, rapide ou apprécié de votre équipe.

Commencez par définir l'objectif réel

Avant de comparer Node.js backend vs Python backend vs Java backend (etc.), nommez le travail que votre backend doit accomplir :

- API pour mobile/web : latence prévisible, modèles de développement d'API clairs, bonne observabilité

- Applications web : itération rapide, templates, jobs en arrière-plan, intégrations

- Microservices : cohérence opérationnelle, outils de déploiement, contrats solides entre services

- Services à forte intensité de données : traitement par lots, streaming, comportement mémoire, intégrations BD/queues

- Systèmes temps réel : modèle de concurrence, backpressure, WebSockets, architecture événementielle

Différents objectifs font pencher la balance entre performance et productivité. Un langage qui accélère la livraison de fonctionnalités pour une API CRUD peut vous ralentir pour du streaming à haut débit ou des systèmes à faible latence.

Clarifiez les contraintes qui l'emportent sur le « meilleur technique »

Le choix d'un langage backend est souvent dicté par des contraintes plus que par des fonctionnalités :

- Calendrier : pouvez-vous livrer en semaines, ou est-ce une plateforme sur plusieurs années ?

- Compétences de l'équipe : êtes-vous déjà armés pour Go/.NET aujourd'hui, ou sera-ce un projet d'apprentissage ?

- Hébergement et exploitation : conteneur-first ? Serverless ? Environnement Windows uniquement ? Limites de coût ?

- Conformité et sécurité : besoins d'audit, politiques de dépendances, cadence de patchs

- Code existant : réutilisation de bibliothèques, modèles partagés, monorepo, points d'intégration

Fixez la bonne attente

Il n'existe pas de langage backend unique « meilleur » en 2026 — seulement des compromis. Ruby on Rails peut gagner sur la vitesse de construction produit, Go sur la simplicité opérationnelle, Java sur l'écosystème mature et les outils d'entreprise, et Node.js sur les usages temps réel et l'alignement full‑stack JavaScript.

À la fin de ce guide, vous devriez pouvoir choisir un langage en connaissance de cause, en l'alignant sur votre charge, vos contraintes et la propriété à long terme — et non sur la hype ou les classements.

Les critères de base à utiliser avant de comparer les langages

Choisir un langage backend, c'est moins se demander « lequel est le meilleur » que quel choix optimise vos résultats spécifiques. Avant de comparer un Node.js backend à un Python backend, ou un Java backend à un Go backend, explicitez les critères — sinon vous débattez des préférences au lieu de décider.

Un ensemble pratique de critères de décision

Commencez par une courte liste que vous pouvez réellement noter :

- Time-to-market : à quelle vitesse votre équipe peut livrer une API stable, itérer et corriger des bugs.

- Performance runtime : latence et débit sous votre charge attendue — pas des microbenchmarks.

- Modèle de concurrence : comment le langage gère de nombreuses requêtes simultanées, les jobs en arrière-plan, le streaming et l'I/O.

- Stabilité et maturité : cadence des sorties, compatibilité ascendante, et à quelle fréquence des « mises à jour mineures » deviennent des projets.

Ajoutez les exigences spécifiques au domaine (p. ex. fonctionnalités temps réel, traitement lourd de données, conformité stricte) comme critères additionnels.

Le TCO bat la « vitesse développeur » seule

Le TCO est le coût combiné de construire et de posséder le système :

- Vitesse de développement : scaffolding, frameworks, et combien de boilerplate votre équipe doit maintenir.

- Exploitation : observabilité, complexité des déploiements, empreinte runtime, charge en on-call.

- Recrutement et montée en compétence : disponibilité des talents pour .NET, Go, Ruby on Rails, etc.

- Maintenance : lisibilité, testabilité, sécurité, et coût des refactors sur plusieurs années.

Un langage rapide pour prototyper peut devenir coûteux s'il provoque des incidents fréquents ou du code difficile à changer.

Contraintes cachées qui décident souvent à votre place

Certaines contraintes sont non négociables, mieux vaut les révéler tôt :

- Fournisseurs/services cloud : SDK first-class, stacks d'authentification, queues managées, runtimes serverless.

- Standards d'entreprise : runtimes approuvés, politiques de sécurité, exigences d'audit.

- Systèmes legacy : bibliothèques existantes, dépendances JVM/.NET, code partagé.

Pondérez les critères selon les priorités business

Ne traitez pas chaque critère de la même façon. Si vous validez un marché, donnez plus de poids au time-to-market. Si vous construisez une plateforme interne à long terme, privilégiez maintenabilité et stabilité opérationnelle. Une matrice de score pondérée simple garde la discussion factuelle et rend les compromis explicites.

Commencez par votre charge backend et votre architecture

Avant de comparer la syntaxe ou les benchmarks, écrivez ce que votre backend doit faire et comment il sera structuré. Les langages paraissent « meilleurs » lorsqu'ils correspondent à la charge et à l'architecture que vous construisez réellement.

Cartographiez vos types de charge

La plupart des backends sont mixtes, mais le type dominant compte :

- APIs CRUD (apps produit typiques) : request/response, validations, auth, lectures/écritures BD.

- Tâches CPU-bound : traitement d'images/vidéo, transformations lourdes, chiffrement, rapports complexes.

- Services I/O-bound : chat, gateways, agrégateurs, webhooks, beaucoup d'attente sur BD et tiers.

- Streaming et temps réel : ingestion d'événements, pipelines de logs, services websocket, analytics quasi temps réel.

Si votre système est majoritairement I/O-bound, les primitives de concurrence, l'ergonomie async et les outils importent souvent plus que la vitesse brute. Si c'est CPU-bound, la performance prévisible et le parallélisme facile deviennent prioritaires.

Comprenez le profil de trafic et besoins de fiabilité

La forme du trafic change la pression sur le langage :

- Trafic en rafales (lancements marketing, drop de tickets) : démarrages à froid rapides, comportement d'autoscaling, efficience des ressources.

- Haut débit soutenu : performance soutenue, comportement mémoire, maturité de l'observabilité.

Notez aussi les attentes de latence globale et le SLA visé. Un SLA API 99.9% avec des contraintes p95 strictes vous pousse vers des runtimes matures, des outils solides et des patterns de déploiement éprouvés.

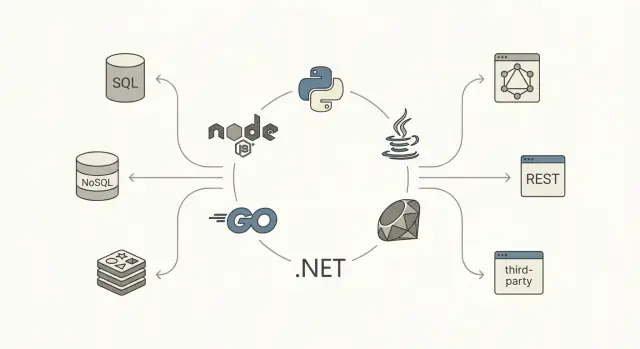

Soyez précis sur les données et les intégrations

Documentez votre pipeline de données :

- SQL vs NoSQL, exigences transactionnelles et de consistance.

- Couches de cache (Redis/memcached), replicas en lecture, pipelines analytiques.

Enfin, listez les intégrations : APIs tierces, messaging/queues (Kafka, RabbitMQ, SQS) et jobs en arrière-plan. Si le travail asynchrone et les consommateurs de queue sont centraux, choisissez un écosystème où workers, retries, idempotence et monitoring sont d'abord des fonctions natives, pas des rustines.

La performance n'est pas un nombre unique. Pour les backends, elle se décompose souvent en latence (rapidité d'une requête), débit (nombre de requêtes par seconde) et usage de ressources (CPU, mémoire, parfois réseau/I/O). Le langage et le runtime affectent ces trois aspects — surtout par la façon dont ils planifient le travail, gèrent la mémoire et traitent les opérations bloquantes.

Latence vs débit (et pourquoi votre p95 importe)

Un langage qui semble rapide en microbenchmarks peut produire de mauvaises latences de queue (p95/p99) sous charge — souvent à cause de contention, appels bloquants ou pression mémoire. Si votre service est I/O-heavy (BD, cache, appels HTTP), les plus gros gains viennent souvent de la réduction des attentes et de l'amélioration de la concurrence, pas de micro-optimisations CPU.

Modèles de concurrence que vous ressentirez vraiment

Différents écosystèmes poussent différentes approches :

- I/O asynchrone (event loop) : courant dans Node.js et de plus en plus présent en Python/.NET/Java. Idéal pour l'I/O à haute concurrence, mais le travail CPU doit être externalisé.

- Threads / pools de threads : classique en Java et .NET. Modèle simple, attention à la saturation des pools et au coût de switching.

- Goroutines : en Go, la concurrence légère facilite le spawning de nombreuses tâches, mais il faut gérer les points bloquants, l'état partagé et le backpressure.

- Acteurs / passage de messages : vu avec Akka (JVM), Orleans (.NET), etc. Isole l'état et simplifie certains problèmes de concurrence au prix d'une discipline architecturale.

Ramasse‑miettes et comportement mémoire

Les runtimes gérés par GC améliorent la productivité, mais taux d'allocation et croissance du heap peuvent impacter la latence de queue via des pauses ou une charge CPU accrue pour le GC. Vous n'avez pas besoin d'être expert GC, mais sachez que « plus d'allocations » et « objets volumineux » peuvent devenir problématiques à l'échelle.

Règle pratique : benchmarquez vos chemins critiques

Avant de trancher, implémentez (ou prototypez) quelques endpoints représentatifs et mesurez :

- latences p50/p95/p99 sous charge réaliste

- débit à taux d'erreur acceptable

- profils CPU/mémoire aux pics

Considérez cela comme une expérience d'ingénierie, pas une supposition. Le mix I/O/compute/concurrence de votre charge fera paraître un langage « le plus rapide » différemment en pratique.

Prototypez votre backend

Créez un prototype d'API léger en chat et testez la latence et les flux réels.

Un langage backend ne réussit presque jamais sur la seule syntaxe. L'expérience quotidienne est façonnée par son écosystème : vitesse pour scaffolder des services, faire évoluer des schémas, sécuriser des endpoints, tester et livrer en toute sécurité.

Frameworks et « chemins standards »

Cherchez des frameworks qui correspondent à votre style (minimaliste vs batteries‑incluses) et à votre architecture (monolithe, monolithe modulaire, microservices). Un écosystème sain a généralement au moins une option « par défaut » largement adoptée et des alternatives solides.

Portez attention aux parties ingrates : ORM mature ou query builders, migrations fiables, bibliothèques d'auth/authz, validation d'input et tooling pour jobs en arrière-plan. Si ces pièces sont fragmentées ou obsolètes, les équipes ré-implémentent souvent des bases et accumulent des patterns incohérents.

Gestion des dépendances et cadence de release

Le meilleur gestionnaire de paquets est celui que votre équipe peut opérer de façon prévisible. Évaluez :

- Comment les dépendances sont pinées et verrouillées (builds reproductibles)

- Outils d'audit et alertes de sécurité

- Discipline SemVer dans les bibliothèques populaires

- Ergonomie des montées de version (breaking changes, guides de migration)

Vérifiez aussi la cadence des releases du langage et du framework. Des sorties rapides sont excellentes si votre organisation peut suivre. En environnement régulé ou avec beaucoup de services, un rythme plus lent ou LTS peut réduire le risque opérationnel.

Observabilité et débogage en production

Les backends modernes exigent une observabilité de première classe. Assurez-vous que l'écosystème propose des options mûres pour logging structuré, métriques (Prometheus/OpenTelemetry), tracing distribué et profiling.

Test pratique : pouvez-vous passer d'une « hausse de latence p95 » à un endpoint, une requête ou un appel de dépendance spécifique en quelques minutes ? Les langages avec de bonnes intégrations de profiling et tracing font économiser beaucoup de temps d'ingénierie sur l'année.

Adéquation opérationnelle : conteneurs, serverless et services long‑cours

Les contraintes opérationnelles doivent influencer le choix. Certains runtimes brillent en conteneurs (images petites, démarrage rapide) ; d'autres excellent pour des services long‑cours avec comportement mémoire prévisible. Si le serverless est envisagé, cold-starts, limites de packaging et gestion des connexions importent.

Avant de vous engager, construisez une tranche verticale et déployez-la comme vous comptez l'exploiter (Kubernetes ou plateforme de fonctions). C'est souvent plus révélateur que de lire des listes de fonctionnalités.

Maintenabilité, sécurité et expérience développeur

La maintenabilité, c'est moins la « beauté du code » que la rapidité à laquelle une équipe peut changer le comportement sans casser la production. Le choix du langage influence cela via les systèmes de types, les outils et les normes de l'écosystème.

Typage statique vs dynamique : refactorings et fiabilité

Les langages fortement typés (Java, Go, C#/.NET) rendent les refactors larges plus sûrs car le compilateur agit comme second relecteur. Renommez un champ, changez une signature, ou séparez un module : le retour est immédiat.

Les langages dynamiques (Python, Ruby, JavaScript vanilla) peuvent être très productifs, mais la correction repose davantage sur des conventions, la couverture de tests et des vérifications runtime. Si vous choisissez cette voie, le « typage progressif » aide souvent : TypeScript pour Node.js, ou hints + mypy/pyright pour Python. L'important est la cohérence — le code « à moitié typé » peut être pire que l'un ou l'autre extrême.

Contrats d'API : DTOs, schémas et OpenAPI

Les systèmes backend échouent souvent aux frontières : formats request/response, payloads d'événements et mappings BD. Une stack maintenable rend les contrats explicites.

OpenAPI/Swagger est la base commune pour les APIs HTTP. Beaucoup d'équipes l'associent à une validation de schéma et des DTOs pour éviter les API « stringly-typed ». Exemples pratiques :

- Node.js : OpenAPI + Zod/Joi pour validation ; DTOs via types TypeScript

- Python : FastAPI + modèles Pydantic

- Java : Bean Validation + DTOs générés depuis OpenAPI

- .NET : FluentValidation + DTOs forts + génération OpenAPI

Le support de génération de code importe : générer clients/servers/DTOs réduit la dérive et facilite l'onboarding.

Culture de test et outillage

Les écosystèmes diffèrent par la facilité d'intégration des tests. Node utilise souvent Jest/Vitest pour un feedback rapide. pytest en Python est expressif et excelle avec les fixtures. JUnit/Testcontainers en Java est solide pour les tests d'intégration. Le package testing en Go encourage des tests simples, tandis que xUnit/NUnit en .NET s'intègre aux IDEs et CI. RSpec en Ruby est opinionné et lisible.

Règle pratique : choisissez l'écosystème où il est le plus facile pour votre équipe d'exécuter des tests localement, simuler les dépendances proprement et écrire des tests d'intégration sans lourdeur.

Compétences de l'équipe, marché du recrutement et ownership long terme

Choisir un langage backend, c'est aussi une décision de staffing. Un langage « parfait » sur le papier peut devenir coûteux si vous ne pouvez pas embaucher, onboarder et retenir des personnes capables de l'exploiter.

Alignez le langage avec l'équipe que vous avez réellement

Inventoriez les forces actuelles : pas seulement qui peut coder, mais qui peut déboguer la production, tuner la perf, mettre en place la CI, gérer les incidents et relire les PR rapidement.

Règle simple : préférez les langages que l'équipe sait exploiter, pas seulement écrire. Si la rotation on-call a déjà du mal avec l'observabilité, les déploiements ou les bugs de concurrence, ajouter un nouveau runtime ou paradigme peut amplifier le risque.

Disponibilité du recrutement : région et séniorité comptent

Les marchés d'embauche varient selon la géographie et le niveau d'expérience. Vous pouvez trouver beaucoup de juniors Node.js/Python localement, mais moins de seniors spécialisés en tuning JVM ou en concurrence Go — ou l'inverse, selon la région.

Pour évaluer la disponibilité, regardez :

- Local vs remote : pouvez-vous embaucher à distance dans vos fuseaux horaires ?

- Distribution de la séniorité : recrutez-vous des seniors pour diriger la conception ou surtout des mid-level pour délivrer ?

- Demande concurrente : si toutes les boîtes locales recrutent le même profil, attendez des délais de recrutement plus longs et des salaires plus élevés.

Courbe d'apprentissage et temps d'onboarding

Même de bons ingénieurs ont besoin de temps pour être efficaces dans un nouvel écosystème : idiomes, frameworks, pratiques de test, gestion des dépendances et tooling de déploiement. Estimez l'onboarding en semaines, pas en jours.

Questions pratiques :

- Un nouveau peut-il livrer une modification sûre et revue en deux semaines ?

- Disposez-vous de templates internes (squelettes de service, logging, auth, CI) qui réduisent la variance ?

- Y a-t-il assez de reviewers expérimentés pour maintenir la qualité pendant la montée en compétence ?

Ownership long terme (2–3 ans)

Optimiser pour la vélocité initiale peut se retourner si l'équipe n'aime pas maintenir la stack. Considérez la cadence de montée de version, le churn des frameworks et le confort à écrire des tests, refactorer et tracer des bugs.

Si vous prévoyez une rotation d'équipe, priorisez la lisibilité, des outils prévisibles et un vivier de mainteneurs — car l'ownership dure plus que la première livraison.

Comparaison rapide : Node.js, Python, Java, Go, .NET, Ruby

Expérimentez sans crainte

Testez des changements risqués, puis revenez en arrière si les performances ou le comportement régressent.

Node.js

Node.js brille pour les APIs I/O-heavy, le chat, les outils collaboratifs et les fonctionnalités temps réel (WebSockets, streaming). Stack courant : TypeScript + Express/Fastify/NestJS, souvent avec PostgreSQL/Redis et des queues.

Pièges habituels : travail CPU bloquant l'event loop, prolifération de dépendances, typage incohérent si on reste en JavaScript pur. Quand la perf compte, externalisez le calcul intensif vers des workers/services et imposez TypeScript strict + linting.

Python

Python est un leader en productivité, surtout pour les backends data-heavy mêlant analytics, ML, ETL et automatisation. Frameworks : Django (batteries-incluses) ou FastAPI (moderne, typé, API-first).

La performance est souvent « suffisante » pour beaucoup de systèmes CRUD, mais les chemins chauds peuvent coûter cher à l'échelle. Stratégies fréquentes : I/O asynchrone, cache, déplacer le calcul vers des services spécialisés ou utiliser des runtime/extension plus rapides si nécessaire.

Java

Java reste un choix solide pour l'entreprise : outils JVM matures, perf prévisible et écosystème profond (Spring Boot, Quarkus, Kafka, observabilité). La maturité ops est un avantage clé — les équipes savent déployer et exploiter Java.

Cas d'usage typiques : APIs haut débit, domaines complexes et environnements régulés où stabilité et support long terme importent.

Go

Go convient aux microservices et services réseau où la concurrence et la simplicité sont prioritaires. Les goroutines rendent la gestion de nombreuses tâches concurrentes naturelle, et la standard library est pragmatique.

Compromis : moins de frameworks « batteries-incluses » que Java/.NET, et vous écrirez peut-être plus de plomberie (ce qui peut être un avantage).

.NET

Le .NET moderne (ASP.NET Core) est excellent pour les APIs d'entreprise, avec de bons tools (Visual Studio, Rider), de belles performances et une parité Windows/Linux. Stack courant : ASP.NET Core + EF Core + SQL Server/PostgreSQL.

Ruby

Ruby on Rails reste l'un des moyens les plus rapides pour livrer un produit web soigné. La montée en charge se fait souvent en extrayant les workloads lourds en jobs et services.

Compromis : débit brut par instance ; on scale généralement horizontalement et on investit tôt dans le cache et les queues de jobs.

Scénarios courants et langages souvent adaptés

Il n'y a presque jamais un « meilleur » langage absolu — seulement le meilleur ajustement pour une charge, une équipe et un profil de risque. Voici des patterns fréquents.

Startups qui livrent vite (MVP → product‑market fit)

Si l'itération et le recrutement de généralistes comptent, Node.js et Python sont des choix fréquents. Node.js brille quand la même équipe souhaite partager TypeScript front/back et quand l'API est essentiellement I/O-bound. Python est fort pour les produits axés données et intégrations analytics/ML précoces.

Ruby on Rails reste une excellente « usine à fonctionnalités » si l'équipe connaît Rails et construit une appli web conventionnelle avec beaucoup de CRUD et workflows d'admin.

APIs haut débit et services concurrency-heavy

Pour des services où latence, débit et utilisation prévisible des ressources dominent, Go est un choix courant : démarrage rapide, modèle de concurrence simple, containerisation facile. Java et .NET excellent aussi, surtout quand vous avez besoin de profiling mature, du tuning JVM/CLR et de bibliothèques éprouvées pour les systèmes distribués.

Si vous attendez des connexions long‑cours (streaming, websockets) ou un fan‑out important, priorisez le comportement runtime en charge et le tooling ops plutôt que des microbenchmarks.

Outils internes et automatisation business

Pour les outils internes, le temps développeur coûte souvent plus que le compute. Python, Node.js et .NET (dans les organisations Microsoft-heavy) gagnent typiquement grâce à la livraison rapide, aux bibliothèques et à l'intégration aisée.

Environnements régulés et entreprises

En contextes compliance-heavy (audit, contrôles d'accès, cycles de support longs), Java et .NET tendent à être les plus sûrs : pratiques de sécurité mûres, gouvernance établie et options LTS prévisibles. Cela compte quand « qui peut approuver une dépendance ? » est aussi important que perf vs productivité.

Monolithe vs microservices (et choix de langage)

Un monolithe profite souvent d'un langage unique pour simplifier l'onboarding et la maintenance. Les microservices peuvent justifier plus de diversité — mais seulement si les équipes sont réellement autonomes et que le tooling plateforme (CI/CD, observabilité, standards) est fort.

Réalité polyglotte : quand deux langages sont raisonnables

Un split pragmatique est courant : p.ex. Java/.NET/Go pour APIs cœur et Python pour pipelines data. Évitez le polyglottisme « par préférence » tôt ; chaque langage ajouté multiplie la réponse aux incidents, la revue sécuritaire et la charge d'ownership.

Cadre décisionnel pratique et matrice de scoring

Lancez un PoC backend rapidement

Générez un backend Go + PostgreSQL depuis un prompt et itérez rapidement sur les endpoints.

Choisir un langage backend devient plus simple si vous le traitez comme une décision produit : définissez contraintes, notez les options, puis validez par un PoC. L'objectif n'est pas une option « parfaite » mais une option défendable, explicable à l'équipe et aux futurs hires.

Étape 1 : séparez les indispensables des agréables à avoir

Commencez par deux listes :

- Exigences must-have (non négociables) : p.ex. runtime/cloud requis, conformité, livrer en 8 semaines, support gRPC, contrainte mémoire.

- Nice-to-have : p.ex. « meilleure DX », « plus grand écosystème », « syntaxe la plus élégante ».

Si un langage échoue sur un must-have, il est éliminé — pas de débat. Cela évite la paralysie d'analyse.

Étape 2 : utilisez une fiche de score simple (poids + score 1–5)

Créez une matrice courte et gardez-la cohérente entre candidats.

| Critère | Poids (%) | Score (1–5) | Score pondéré |

|---|

| Adéquation performance & concurrence | 20 | | |

| Écosystème & librairies (BD, auth, queues) | 20 | | |

| Productivité développeur | 15 | | |

| Recrutement & maintenabilité long terme | 15 | | |

| Adéquation opérationnelle (déploiement, observabilité) | 15 | | |

| Sécurité & correction (typage, tooling) | 15 | | |

Comment calculer : Score pondéré = Poids × Score. Faites la somme par langage. Limitez à ~5–7 critères pour que les nombres restent significatifs.

Étape 3 : lancez un PoC qui reflète le travail réel

Checklist PoC (time-boxez 1–3 jours par langage) :

- Un endpoint API (validation + gestion d'erreurs)

- Auth (JWT/session/OAuth réel)

- CRUD DB + migration

- Job en arrière-plan / consumer de queue

- Logging, métriques et trace

- Déploiement dans l'environnement cible

Étape 4 : définissez les métriques de succès du PoC

Décidez à l'avance ce qui est « bon » :

- Objectif de latence : p.ex. p95 < 150ms pour un endpoint représentatif

- Temps de déploiement : p.ex. < 10 minutes d'un checkout propre au déploiement en production

- Taux d'erreur : p.ex. < 0.1% lors d'un petit test de charge réaliste

- Vélocité dev : temps pour implémenter la checklist PoC + nombre de points douloureux rencontrés

Réinjectez les résultats du PoC dans la matrice, puis choisissez l'option avec le meilleur total et le moins de risques must-have.

Se tromper arrive quand la décision est prise de l'extérieur vers l'intérieur — selon la tendance, une présentation en conférence, ou un seul benchmark.

N'optimisez pas pour la hype (ou un seul graphique)

Un micro-benchmark reflète rarement vos vrais goulots : requêtes BD, APIs tierces, sérialisation ou latence réseau. Prenez les revendications « les plus rapides » comme point de départ, pas comme verdict. Validez par un PoC fin qui reproduit vos patterns d'accès aux données, tailles de payload et profil de concurrence.

Surveillez les inadéquations opérationnelles

Beaucoup d'équipes choisissent un langage productif en code, puis payent le prix en production :

- Complexité async : certains stacks rendent l'async simple ; d'autres demandent une discipline stricte pour éviter deadlocks, famine de threads ou sprawl async.

- Tuning GC et comportement mémoire : les runtimes managés sont excellents, mais exigent que vous soyez à l'aise avec le dimensionnement du heap, pauses et observabilité.

- Contraintes de déploiement : conteneurs, cold starts, images minimales et tooling de build peuvent rendre le simple surprenamment coûteux.

Si l'organisation ne peut pas supporter le modèle opérationnel, le langage ne vous sauvera pas.

Planifiez la migration comme un produit, pas une réécriture

Future-proofing signifie souvent ne pas tout miser en une fois. Favorisez la migration incrémentale :

- Commencez les nouvelles fonctionnalités comme petits services/modules tout en gardant le coeur stable.

- Utilisez le strangler pattern : redirigez des endpoints ou flows spécifiques vers la nouvelle implémentation et élargissez progressivement.

- Conservez des contrats partagés (OpenAPI/JSON Schema/Protobuf) comme source de vérité pour réduire la dérive cross‑langage.

Checklist et prochaines étapes

- Définissez les 3 contraintes principales (latence, débit, coût, conformité, recrutement).

- Prototypiez avec des chemins de données réels, puis testez en charge.

- Vérifiez la readiness ops : CI/CD, monitoring, gestion d'incidents, tuning runtime.

- Choisissez une voie de migration (incrémentale > rewrite) et verrouillez les contrats API.

- Lancez un pilote 60–90 jours, puis standardisez conventions et tooling.