Ce qui cloche quand le CI plante et que l'IA devine

Un échec CI n'est généralement pas mystérieux. Le log indique où ça s'est arrêté, quelle commande a échoué et le message d'erreur. Un bon log contient une trace de pile, une erreur de compilation avec fichier et numéro de ligne, ou un rapport de test montrant quelle assertion a échoué. Parfois on a même un indice de type diff comme "expected X, got Y" ou une étape clairement en échec comme "lint", "build" ou "migrate database".

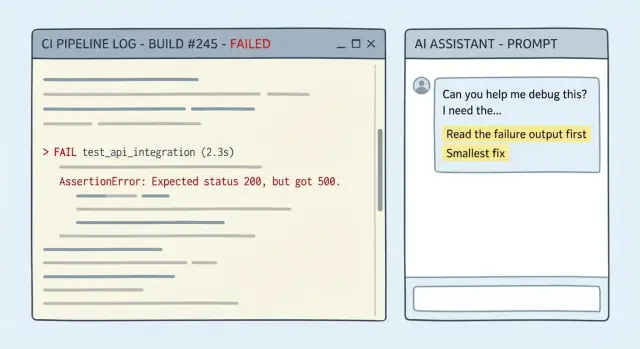

Le vrai problème, c'est que les gens (et l'IA) traitent souvent le log comme du bruit de fond. Si vous collez un long log et demandez "une correction", beaucoup de modèles sautent à une explication familière au lieu de lire les dernières lignes significatives. Les suppositions empirent lorsque l'erreur semble courante ("module not found", "timeout", "permission denied"). On se retrouve avec une refonte massive, une nouvelle dépendance ou un "essayez de tout mettre à jour" qui ne correspond pas à la vraie panne.

L'objectif n'est pas "faire passer les tests coûte que coûte". C'est plus simple :

- Lire la sortie en échec.

- Identifier le plus petit changement qui fait réussir l'étape en échec.

- Ne rien changer d'autre.

En pratique, la "correction minimale" est souvent l'une de ces choses : un changement de quelques lignes dans un seul endroit, un import manquant ou un mauvais chemin, une valeur de config manifestement incorrecte pour l'environnement CI, ou revenir sur un changement accidentel cassant plutôt que de repenser le code.

Un test de suivi compte aussi. Passer le CI une fois n'empêche pas la récurrence. Si l'échec vient d'un cas limite (entrée nulle, fuseau horaire, arrondi, permissions), ajoutez un test de régression qui échoue avant le correctif et passe après. Cela transforme un secours ponctuel en garde‑fou.

Ce qu'il faut rassembler avant de demander de l'aide

La plupart des mauvaises corrections commencent par un manque de contexte. Si vous ne collez que la dernière ligne rouge, le modèle doit deviner ce qui s'est passé plus tôt, et les suppositions se transforment souvent en refontes.

Visez à fournir assez de détails pour que quelqu'un puisse suivre l'échec depuis la première erreur réelle jusqu'à la fin, puis changer le moins possible.

Copiez ceci dans votre message (littéralement quand c'est possible) :

- Le log complet en échec depuis la première ligne d'erreur jusqu'à la fin (pas seulement la trace finale).

- La commande exacte que CI a exécutée (par exemple

go test ./..., npm test, flutter test, golangci-lint run).

- Les chemins de fichiers mentionnés dans l'erreur, plus toute config pertinente (config de test, config de linter, scripts de build).

- Ce qui a changé récemment : résumé du diff du PR, bumps de dépendances, modifications de la config CI.

- Si c'est instable : deux ou trois runs en échec et un run passant si vous les avez.

Ajoutez des contraintes en clair. Si vous voulez une correction minime, dites‑le : pas de refactor, pas de changement de comportement sauf si nécessaire, limitez le patch à la zone en échec.

Un exemple simple : le CI échoue à l'étape de lint après un bump de dépendance. Collez la sortie du linter à partir du premier avertissement, incluez la commande que CI a utilisée, et mentionnez la seule modification de version de paquet. C'est assez pour suggérer un réglage de config en une ligne ou un petit changement de code, plutôt que de reformater la moitié du repo.

Si vous voulez quelque chose de prêt à coller, cette structure suffit généralement :

CI command:

Failing output (full):

Recent changes:

Constraints (smallest fix, no refactor):

Flaky? (runs attached):

Règles d'invite qui l'obligent à lire la sortie en échec

Quand un modèle manque la cible sur une panne CI, c'est généralement parce que votre prompt lui permet de deviner. Votre travail est de le forcer à montrer son raisonnement en utilisant la sortie en échec exacte, puis à s'engager sur le plus petit changement qui pourrait faire réussir le job.

Règles pour garder le modèle honnête

Exigez des preuves et un petit plan. Une bonne invite force cinq choses :

- Citer les lignes en échec exactes du log CI (erreurs, trace de pile, fichier:ligne) et dire explicitement "J'utilise ces lignes."

- Donner un diagnostic en une phrase, sans hésitation.

- Proposer un plan de patch minimal avec 1–3 modifications, en nommant les fichiers exacts concernés.

- Éviter les changements sans rapport (pas de formatage, de renommages, de refactors, de bumps de dépendances) sauf si vous approuvez.

- Lister ce dont il n'est pas sûr et l'unique information qui confirmerait le diagnostic.

L'incertitude est acceptable. L'incertitude cachée est ce qui fait perdre du temps.

Fragment d'invite prêt à coller

Collez ceci en haut de votre question CI :

Use ONLY the evidence in the CI output below.

1) Quote the exact failing lines you are using.

2) Give ONE sentence: the most likely cause.

3) Propose the smallest fix: 1-3 edits, with file paths.

4) Do NOT do formatting/renames/refactors or "cleanup".

5) List uncertainties + the one extra detail that would confirm the diagnosis.

Si le log dit "expected 200, got 500" plus une trace dans user_service.go:142, cette structure pousse la réponse vers cette fonction et un petit garde‑fou ou un traitement d'erreur, pas une refonte de l'endpoint.

Un modèle d'invite prêt à l'emploi pour les échecs CI

Les plus gros gains viennent d'une invite qui force la citation des logs, reste dans les contraintes et s'arrête quand il manque quelque chose.

You are helping me fix a CI failure.

Repo context (short):

- Language/framework:

- Test/build command that failed: <PASTE THE EXACT COMMAND>

- CI environment (OS, Node/Go/Python versions, etc.):

Failing output (verbatim, include the first error and 20 lines above it):

<PASTE LOG>

Constraints:

- Propose the smallest possible code change that makes CI pass.

- Do NOT rewrite/refactor unrelated code.

- Do NOT touch files you do not need for the fix.

- If behavior changes, make it explicit and justify why it is correct.

Stop rule (no guessing):

- If the log is incomplete or you need more info (missing stack trace, config, versions, failing test name), STOP and ask only the minimum questions needed.

Your response format (follow exactly):

1) Evidence: Quote the exact log lines that matter.

2) Hypothesis: Explain the most likely cause in 2-4 sentences.

3) Smallest fix: Describe the minimal change and why it addresses the evidence.

4) Patch: Provide a unified diff.

5) Follow-up: Tell me the exact command(s) to rerun locally to confirm.

Then, write ONE regression test (or tweak an existing one) that would fail before this fix and pass after it, to prevent the same failure class.

- Keep the test focused. No broad test suites.

- If a test is not feasible, explain why and propose the next-best guardrail (lint rule, type check, assertion).

Deux détails qui réduisent les allers‑retours :

- Inclure la commande exacte en échec et la première erreur (pas seulement le résumé final).

- S'il y a plusieurs échecs, dites lequel corriger en premier (généralement la première vraie erreur dans le log).

Soyez récompensé pour le partage

Partagez comment vous corrigez des échecs CI avec Koder.ai et gagnez des crédits pour votre contenu.

La manière la plus rapide de perdre du temps est d'accepter un jeu de changements de "nettoyage" qui modifie cinq choses à la fois. Définissez "minimal" dès le départ : le plus petit diff qui fait passer le job en échec, avec le moindre risque et la vérification la plus rapide.

Une règle simple fonctionne bien : corriger le symptôme d'abord, puis décider si une refonte plus large en vaut la peine. Si le log pointe vers un fichier, une fonction, un import manquant ou un cas limite, visez là. Évitez les modifications "tant qu'on y est".

Si vous avez réellement besoin d'alternatives, demandez‑en deux et seulement deux : "correction minimale la plus sûre" vs "correction minimale la plus rapide." Vous voulez des compromis, pas un menu.

Exigez aussi une vérification locale qui correspond au CI. Demandez la même commande que le pipeline exécute (ou l'équivalent le plus proche), pour confirmer en quelques minutes :

make test

npm test

Si la réponse propose un grand changement, opposez‑vous avec : "Montrez le plus petit patch qui corrige l'assertion en échec, sans formatage ou renommages non liés."

Inviter à écrire un test de suivi qui empêche les récurrences

Un correctif sans test, c'est un pari que le bug ne reviendra pas. Demandez toujours un test de régression qui échoue avant le patch et passe après.

Soyez précis sur ce que signifie "bon" :

- Si l'échec était un crash de test unitaire, vous voulez probablement un nouveau test ou une assertion renforcée.

- Si l'échec était une construction, un lint ou une règle de format, vous voulez un contrôle qui impose la règle pour empêcher le même type d'erreur.

Un pattern utile exige quatre choses : où mettre le test, comment le nommer, quel comportement il doit couvrir, et une brève note expliquant pourquoi il prévient les régressions futures.

Fragment prêt à coller :

- Écrivez un test de régression qui échoue sur la branche main actuelle et passe après votre correctif.

- Ciblez la même classe d'échec, pas juste la ligne exacte cassée.

- Mettez le test dans : <path or folder>. Suivez la convention de nommage : <your convention>.

- Si c'est une règle de lint/build, ajoutez ou ajustez un contrôle qui l'impose.

- Ajoutez 2–3 phrases : pourquoi ce test attraperait un bug similaire plus tard.

Exemple : le CI montre un panic quand un handler API reçoit un ID vide. N'écrivez pas un test « pour cette ligne ». Écrivez un test qui couvre IDs invalides (vide, espaces, mauvais format). La correction minimale peut être une clause de garde qui retourne 400. Le test de suivi doit vérifier plusieurs entrées invalides pour que toute refonte future casse immédiatement le CI.

Si votre projet a déjà des conventions de test, précisez‑les. Sinon, demandez au modèle de calquer les tests voisins dans le même package/dossier, et gardez le nouveau test minimal et lisible.

Un workflow réutilisable pas à pas

1) Donnez l'échec tel quel

Collez la section du log CI contenant l'erreur et 20–40 lignes au-dessus. Collez aussi la commande exacte qui a échoué et les détails d'environnement importants (OS, versions runtime, flags importants).

Demandez ensuite au modèle de reformuler ce qui a échoué en langage simple et de pointer les lignes du log qui le prouvent. S'il ne peut pas citer le log, il ne l'a pas vraiment lu.

2) Exigez le patch le plus petit en premier

Demandez le plus petit changement possible qui fait réussir la commande en échec. Repoussez les refactors. Avant d'appliquer quoi que ce soit, faites‑l lister :

- Les fichiers qu'il touchera

- Le comportement exact qui changera

- Ce qu'il ne change pas

3) Relancez la même commande, boucle serrée

Appliquez le patch et relancez la commande exacte qui a échoué localement (ou dans le job CI si c'est votre seule option). Si ça échoue encore, collez seulement la nouvelle sortie en échec et répétez. Garder le contexte réduit aide à rester ciblé.

4) Ajoutez un test de régression pour la classe d'échec

Une fois vert, ajoutez un test de suivi focalisé qui aurait échoué avant le patch et qui passe après. Un test, une raison.

Relancez la commande avec le nouveau test inclus pour confirmer que vous n'avez pas simplement masqué l'erreur.

5) Terminez avec un paquet PR propre

Demandez un message de commit court et une description de PR qui inclue ce qui a échoué, ce qui a changé, comment vous l'avez vérifié, et quel test empêche une répétition. Les réviseurs vont plus vite quand le raisonnement est explicite.

Un exemple réaliste : de la sortie en échec au correctif et au test

Expérimentez en toute sécurité avec des snapshots

Essayez une correction risquée, puis revenez en arrière instantanément si elle aggrave l'échec CI.

Un échec courant : tout fonctionnait localement, puis un petit changement fait échouer les tests sur le runner CI. Voici un cas simple d'une API Go où un handler a commencé à accepter une valeur date seule (2026-01-09) mais le code ne parse toujours que des timestamps RFC3339 complets.

Ceci est le type d'extrait à coller (gardez‑le court, mais incluez la ligne d'erreur) :

--- FAIL: TestCreateInvoice_DueDate (0.01s)

invoice_test.go:48: expected 201, got 400

invoice_test.go:49: response: {"error":"invalid due_date: parsing time \"2026-01-09\" as \"2006-01-02T15:04:05Z07:00\": cannot parse \"\" as \"T\""}

FAIL

exit status 1

FAIL app/api 0.243s

Utilisez ensuite une invite qui force les preuves, une correction minimale et un test :

You are fixing a CI failure. You MUST use the log to justify every claim.

Context:

- Language: Go

- Failing test: TestCreateInvoice_DueDate

- Log snippet:

<PASTE LOG>

Task:

1) Quote the exact failing line(s) from the log and explain the root cause in 1-2 sentences.

2) Propose the smallest possible code change (one function, one file) to accept both RFC3339 and YYYY-MM-DD.

3) Show the exact patch.

4) Add one regression test that fails before the fix and passes after.

Return your answer with headings: Evidence, Minimal Fix, Patch, Regression Test.

Une bonne réponse pointera le décalage du layout de parsing, puis fera un petit changement dans une seule fonction (par exemple parseDueDate dans invoice.go) pour essayer RFC3339 d'abord puis retomber sur 2006-01-02. Pas de refactor, pas de nouveaux packages.

Le test de régression est le garde‑fou : envoyer due_date: "2026-01-09" et attendre 201. Si quelqu'un supprime plus tard le fallback, le CI casse immédiatement avec la même classe d'erreur.

La manière la plus rapide de perdre une heure est de donner une vue tronquée du problème. Les logs CI sont bruyants, mais la partie utile se trouve souvent 20 lignes au‑dessus de l'erreur finale.

Un piège est de ne coller que la dernière ligne rouge (par exemple "exit 1") en cachant la vraie cause plus haut (une variable d'environnement manquante, un snapshot raté, ou le premier test qui a crashé). Solution : incluez la commande en échec plus la fenêtre du log où apparaît la première vraie erreur.

Un autre temps perdu est de laisser le modèle "nettoyer" en chemin. Formatage, bumps de dépendances ou refactors compliquent la revue et risquent de casser autre chose. Solution : verrouillez la portée sur le plus petit changement et rejetez tout ce qui n'est pas lié.

Quelques motifs à surveiller :

- Ne coller que la dernière ligne d'erreur : inclure la commande en échec et la première erreur.

- Laisser changer des dépendances ou des fichiers non liés : exigez un diff minimal et une justification pour chaque fichier touché.

- Accepter un correctif non vérifié contre la commande CI : relancez la même commande pour confirmer.

- Écrire un test qui passe même quand le bug revient : exigez un test qui échoue sur l'ancien code et passe sur le correctif.

- Mélanger flaky et vraies régressions : décidez si c'est nondéterministe (timing, réseau, ordre) ou logique stable, puis traitez en conséquence.

Si vous suspectez de l'instabilité, ne la masquez pas avec des retries. Supprimez l'aléa (temps fixe, RNG seedé, répertoires temporaires isolés) pour clarifier le signal.

Vérifications rapides avant d'envoyer le correctif

Ajoutez le test qui empêche les récurrences

Rédigez un test de régression ciblé qui échoue avant le correctif et passe après.

Avant de pousser, faites une courte passe de sanity. L'objectif est de s'assurer que le changement est réel, minimal et reproductible, pas un passage chanceux.

- Preuves : l'explication cite‑t‑elle les lignes en échec exactes ?

- Portée : les changements sont‑ils limités au nécessaire ?

- Causalité : explique‑t‑on pourquoi ce changement fait passer l'état en échec à passant ?

- Repro : avez‑vous relancé la commande CI exacte (mêmes flags, même répertoire de travail) ?

- Régression : le nouveau test échouait‑il avant le correctif et passe‑t‑il après ?

Enfin, lancez un jeu légèrement plus large que le job en échec (par exemple lint + tests unitaires). Un piège fréquent est un correctif qui passe le job initial mais casse une autre cible.

Étapes suivantes : faites de ce workflow une habitude

Si vous voulez gagner du temps durablement, traitez votre prompt et le format de réponse comme un processus d'équipe. L'objectif est des entrées reproductibles, des sorties reproductibles et moins de "corrections mystères" qui cassent autre chose.

Transformez votre meilleure invite en un snippet partagé et épinglez‑le dans le chat d'équipe. L'objectif : (1) preuves, (2) diagnostic en une ligne, (3) changement minimal, (4) test de suivi, (5) comment vérifier localement. Quand tout le monde utilise le même format, les revues vont plus vite parce que les réviseurs savent où regarder.

Un léger cycle d'habitude utile :

- Sauvegardez l'invite comme snippet de repo et épinglez‑le dans la discussion d'équipe.

- Étiquetez les échecs CI par type (lint, unit, integration, packaging, deploy).

- Quand une étiquette revient, ajoutez un test ou un contrôle qui aurait dû le détecter plus tôt.

- Gardez les expériences risquées réversibles pour pouvoir revenir vite en arrière.

Si vous préférez un workflow centré chat pour construire et itérer sur des applis, vous pouvez exécuter la même boucle fix‑and‑test dans Koder.ai, utiliser des snapshots pendant l'expérimentation, et exporter le code quand vous êtes prêt à le merger dans votre dépôt habituel.