Ce que signifie qu’une IA « infère » une stack technique

Une stack technique est simplement l’ensemble des briques choisies pour créer et exécuter un produit. En termes simples, elle comprend généralement :

- Frontend : ce que les utilisateurs voient et avec quoi ils interagissent (UI web ou mobile)

- Backend : logique côté serveur et API

- Base de données : où les données sont stockées et requêtées

- Hébergement/déploiement : où l’app tourne (cloud, on‑prem, plateformes managées)

- Outils : monitoring, CI/CD, authentification, analytics, tests, etc.

« Inférer » n’est pas lire dans la tête

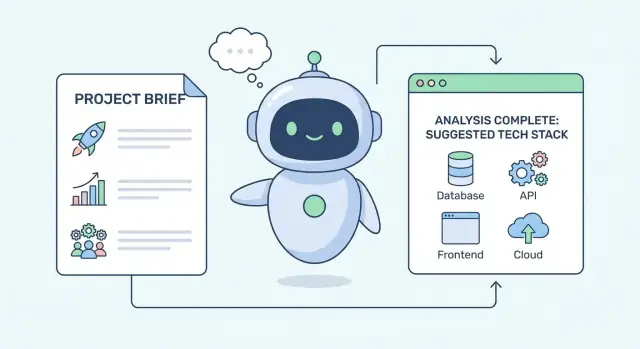

Quand une IA « infère » une stack, elle ne devine pas votre framework favori. Elle fait un raisonnement structuré : elle prend ce que vous lui dites sur votre situation, le met en correspondance avec des patterns d’ingénierie courants, et propose des options de stack qui fonctionnent généralement dans des cas similaires.

Pensez‑y comme un assistant de décision qui traduit des contraintes en implications techniques. Par exemple, « on doit lancer en 6 semaines » implique souvent de choisir des frameworks matures, des services managés et moins de composants personnalisés.

Les contraintes centrales que l’IA examine

La plupart des recommandations de stack commencent par un petit ensemble de contraintes pratiques :

- Échelle et performance : utilisateurs attendus, pics de trafic, objectifs de latence, volume de données

- Vitesse de mise sur le marché : délais, MVP vs plateforme long terme, cadence d’itération

- Compétences et recrutement : ce que vos développeurs connaissent déjà et ce qu’il est facile de recruter

- Budget : build vs buy, dépenses cloud, licences, effectifs ops

- Conformité et sécurité : localisation des données, exigences d’audit, chiffrement, contrôles d’accès

Poser les attentes

Les recommandations d’IA sont mieux vues comme des shortlists avec des compromis, pas comme des réponses définitives. Les bonnes sorties expliquent pourquoi une stack convient (et où elle pêche), proposent des alternatives viables et soulignent les risques à valider avec votre équipe — parce que les humains restent responsables des décisions.

Les entrées que l’IA utilise pour suggérer une stack

L’IA ne « devine » pas une stack à partir d’un seul prompt. Elle fonctionne plutôt comme un intervieweur : elle rassemble des signaux, les pondère, puis produit un petit ensemble d’options plausibles — chacune optimisée pour des priorités différentes.

Exigences produit et expérience utilisateur

Les signaux les plus puissants sont ce que le produit doit faire et ce que les utilisateurs vont ressentir. Parmi eux :

- Objectifs produit (validation d’un MVP vs plateforme long terme)

- Fonctionnalités clés (collaboration en temps réel, recherche, paiements, traitement de fichiers)

- Volume d’utilisateurs attendu et trajectoire de croissance

- Besoins de latence et de réactivité (par ex. « doit sembler instantané »)

- Sensibilité des données et exigences de conformité (PII, HIPAA, SOC 2)

Ces détails orientent des choix comme « application rendue côté serveur vs SPA », « base relationnelle vs base document », ou « traitement par file vs API synchrones ».

Contexte et contraintes autour du build

Les recommandations s’améliorent quand vous fournissez le contexte du projet, pas seulement la liste des fonctionnalités :

- Systèmes existants à intégrer (ERP/CRM, fournisseur d’identité, entrepôt de données)

- Fournisseurs ou engagements cloud préférés (AWS/GCP/Azure, services managés spécifiques)

- Environnement de déploiement (Kubernetes, serverless, on‑prem)

- Calendrier et séquencement des releases (lancement unique vs déploiement par phases)

Une contrainte stricte (par ex. « doit tourner on‑prem ») peut éliminer des candidats autrement solides.

Signaux d’équipe qui affectent la maintenabilité

Les choix de stack réussissent ou échouent selon qui va les construire et les exploiter. Entrées utiles : langages actuels, projets similaires passés, maturité ops (monitoring/on‑call) et réalités du recrutement local.

À quoi doit ressembler la sortie

Une bonne réponse IA n’est pas une « stack parfaite ». C’est 2 à 4 candidats, chacun avec :

- Pourquoi il correspond aux contraintes

- Principaux compromis et risques

- Ce qu’il faut valider ensuite (benchmarks, revue sécurité, spike)

Si vous voulez un modèle pour partager ces entrées, voyez /blog/requirements-for-tech-stack-selection.

Des contraintes aux exigences : l’étape de traduction

Avant qu’une IA ne recommande une stack, elle doit traduire ce que vous dites vouloir en ce dont vous avez réellement besoin pour construire. Les briefs de projet démarrent souvent avec des objectifs flous — « rapide », « scalable », « pas cher », « sécurisé », « facile à maintenir ». Ceux‑ci sont utiles, mais ne sont pas encore des exigences.

L’IA convertit typiquement des adjectifs en nombres, seuils et hypothèses opérationnelles. Par exemple :

- « Application rapide » → temps de réponse p95 (par ex. <300 ms pour les actions clés), budget de chargement de page, latence acceptable en pic

- « Livrer vite » → cadence de release (hebdomadaire vs mensuelle), temps jusqu’à la première version, tolérance pour la dette technique

- « Scalable » → utilisateurs attendus, requêtes/seconde en pic, taux de croissance, volume de données sur 6–18 mois

Une fois les cibles définies, la conversation sur la stack devient moins subjective et davantage axée sur des compromis.

Séparer contraintes dures et préférences

Une grande partie de la traduction consiste à classer les entrées :

- Contraintes dures (must‑have) : conformité, localisation des données, contrats fournisseurs existants, intégrations obligatoires, objectifs de disponibilité

- Préférences (nice‑to‑have) : « utiliser des microservices », « adopter un framework tendance », « éviter le vendor lock‑in » (sauf si contractuel)

Les recommandations ne valent que ce que vaut ce classement. Un « must » réduit les options ; une « préférence » influence le classement.

Demander ce qui manque (et pourquoi c’est important)

Une bonne IA signale les informations manquantes et pose des questions courtes à fort impact, par exemple :

- Quels sont vos workflows les plus chargés et vos fenêtres de pic ?

- Quel est le budget ops (personnes + outils), pas seulement le cloud ?

- Quelles compétences avez‑vous déjà, et que pouvez‑vous raisonnablement recruter ?

- Quelles données sont sensibles et quels audits s’appliquent ?

Construire un profil de contraintes d’une page

La sortie de cette étape est un « profil de contraintes » compact : cibles mesurables, must‑haves et questions ouvertes. Ce profil guide les décisions ultérieures — du choix de la base à celui du déploiement — sans vous enfermer trop tôt dans un outil particulier.

Quand l’IA recommande une stack, « échelle » et « vitesse » sont souvent les premiers filtres. Ces exigences excluent rapidement des options qui conviendraient pour un prototype mais peineraient sous un trafic réel.

Ce que « échelle » signifie concrètement

L’IA décompose l’échelle en dimensions concrètes :

- Utilisateurs et volume de requêtes : moyenne vs pics par seconde, et attentes de croissance

- Taille des données : vitesse d’accumulation (logs, events, fichiers) et durée de conservation

- Ratio lecture/écriture : les produits de type navigation se optimisent différemment des produits à forte écriture

- Patrons de pic : « constant toute la journée » est plus simple que « pics ×10 le vendredi » ou des campagnes soudaines

Ces éléments restreignent les choix concernant la dépendance à une seule base, la nécessité de cache tôt, et l’obligation d’autoscaling.

Exigences de vitesse : latence, débit et temps réel

La performance n’est pas un seul chiffre. L’IA sépare :

- Latence (rapidité perçue d’une requête), qui influence CDN, cache et conception d’API

- Débit (nombre de requêtes/jobs par minute), qui influence load balancing et scalabilité horizontale

- Jobs en arrière‑plan (email, traitement vidéo, imports), qui poussent vers files + workers

- Temps réel (chat, présence, tableaux de bord live), qui ajoute souvent WebSockets et un composant pub/sub

Si la faible latence est critique, l’IA penche vers des chemins de requête plus simples, un cache agressif et la distribution en edge. Si le débit et le travail asynchrone dominent, elle privilégie files et mise à l’échelle des workers.

Les cibles de fiabilité restreignent les options

Les attentes de disponibilité et de récupération comptent autant que la vitesse. Des objectifs de fiabilité élevés orientent généralement vers :

- Services managés (bases, files) pour réduire le risque opérationnel

- Redondance multi‑zone/région

- Sauvegardes/restores et workflows d’incident clairs

Échelle élevée + exigences strictes de vitesse + fiabilité serrée poussent la stack vers cache, traitement asynchrone et infrastructure managée plus tôt dans la vie du produit.

Compétences d’équipe et time‑to‑market

Transformez vos contraintes en code

Décrivez vos contraintes et obtenez une base d'application fonctionnelle pour itérer rapidement.

Les recommandations semblent souvent optimiser la « meilleure technologie », mais le signal le plus fort est souvent : ce que votre équipe peut construire, livrer et supporter sans blocage.

La familiarité bat le « meilleur » théorique

Si vos développeurs maîtrisent déjà un framework, l’IA le favorisera typiquement — même si une alternative est légèrement meilleure en benchmark. Les outils familiers réduisent débats, revues et le risque d’erreurs subtiles.

Par exemple, une équipe avec une forte expérience React recevra souvent des recommandations basées sur React (Next.js, Remix) plutôt que sur un frontend plus « chaud ». Même logique pour le backend : une équipe Node/TypeScript sera guidée vers NestJS ou Express plutôt qu’un changement de langage qui ajoute des mois d’apprentissage.

Le time‑to‑market oriente vers des choix éprouvés

Quand la rapidité de lancement est prioritaire, l’IA recommande souvent :

- Frameworks matures avec conventions fortes (moins de décisions d’architecture)

- Templates/starter kits couvrant auth, routing et déploiement

- Services managés supprimant des étapes d’installation et de maintenance

C’est pourquoi des choix « ennuyeux » reviennent fréquemment : trajectoire vers la production prévisible, bonne documentation et beaucoup de problèmes déjà résolus. L’objectif n’est pas l’élégance, mais la livraison avec moins d’inconnues.

C’est aussi là que des outils d’accélération (« vibe‑coding ») peuvent être utiles : par exemple, Koder.ai aide à passer des exigences à un squelette web/server/mobile fonctionnel via une interface conversationnelle, tout en conservant une stack conventionnelle en dessous (React pour le web, Go + PostgreSQL pour backend/data, Flutter pour mobile). Bien utilisé, il accélère les prototypes et premières releases sans remplacer la validation de la stack face à vos contraintes.

Charge opérationnelle : auto‑hébergé vs managé

L’IA infère aussi votre capacité opérationnelle. Si vous n’avez pas de DevOps dédié ou une faible maturité on‑call, les recommandations se déplacent vers des plateformes managées (Postgres managé, Redis hébergé, queues managées) et des déploiements simplifiés.

Une équipe réduite peut rarement gérer des clusters, faire tourner manuellement la rotation des secrets et construire le monitoring from scratch. Quand les contraintes suggèrent ce risque, l’IA pousse vers des services avec sauvegardes intégrées, dashboards et alerting.

Recrutement et onboarding

Les choix de stack influent sur votre future équipe. L’IA pèse la popularité des langages, la courbe d’apprentissage et le support communautaire car cela affecte le recrutement et le temps de montée en compétence. Une stack largement adoptée (TypeScript, Python, Java, React) gagne souvent quand vous prévoyez croissance, sous‑traitance ou onboarding fréquent.

Si vous voulez approfondir la manière dont les recommandations se transforment en choix concrets couche par couche, voyez /blog/mapping-constraints-to-stack-layers.

Logique de décision : pondérer compromis et priorités

Les recommandations ne sont pas des « best practices » copiées d’un template. Elles résultent souvent d’un score des options par rapport à vos contraintes, puis d’un choix de la combinaison qui satisfait le plus ce qui compte maintenant — même si ce n’est pas parfait.

La plupart des décisions de stack sont des compromis :

- Flexibilité vs simplicité : configuration très personnalisable = workflows inhabituels, mais augmente la maintenance et l’onboarding

- Coût vs contrôle : services managés réduisent le travail ops et le risque, mais limitent le réglage fin et accroissent la dépendance

- Vitesse vs sûreté : livrer vite peut signifier moins de pièces et moins d’optimisation, alors que la sûreté favorise outillage strict, tests et composants éprouvés

L’IA cadre souvent ces choix sous forme de scores plutôt que de débats. Si vous dites « lancement en 6 semaines avec petite équipe », simplicité et rapidité auront plus de poids que la flexibilité long terme.

Contraintes pondérées : ce qui compte aujourd’hui

Un modèle pratique est une checklist pondérée : time‑to‑market, compétences de l’équipe, budget, conformité, trafic attendu, besoins de latence, sensibilité des données, réalité du recrutement. Chaque composant candidat (framework, base, hébergement) reçoit des points selon son adéquation.

C’est pourquoi la même idée produit peut donner des réponses différentes : les poids changent quand vos priorités changent.

Pistes multiples : stack MVP vs stack montée en charge

De bonnes recommandations incluent souvent deux voies :

- Voie MVP : minimiser complexité et charge opérationnelle ; tooling mainstream que l’équipe peut livrer immédiatement

- Voie montée en charge : plan de migration compatible (ajout de cache, séparation des services, introduction d’une file) quand l’usage justifie

« Suffisamment bon » avec hypothèses explicites

L’IA peut justifier des choix « suffisants » en énonçant les hypothèses : volume d’utilisateurs attendu, downtime acceptable, fonctionnalités non négociables et ce qui peut être différé. La transparence est clé — si une hypothèse est fausse, vous savez quelles parties de la stack revoir.

Cartographier les contraintes par couche (du frontend aux données)

Une manière utile de comprendre les recommandations : les voir comme un exercice de cartographie couche par couche. Au lieu de nommer des outils au hasard, le modèle transforme chaque contrainte (vitesse, compétence, conformité, calendrier) en exigences pour le frontend, backend et couche données — puis suggère des technologies.

Frontend : web vs mobile (et ce que doit faire l’UI)

L’IA commence généralement par préciser où les utilisateurs interagissent : navigateur, iOS/Android, ou les deux.

Si le SEO et des temps de chargement rapides comptent (sites marketing, marketplaces, produits de contenu), les choix web s’orientent vers des frameworks supportant le rendu serveur et de bons budgets de performance.

Si le mode hors‑ligne est central (travail sur le terrain, voyages, réseaux instables), la recommandation penche vers des applis mobiles (ou un PWA bien conçu) avec stockage local et synchronisation.

Si l’UI est temps réel (collaboration, dashboards), la contrainte devient « pousser les mises à jour efficacement », ce qui influence la gestion d’état, WebSockets et le traitement d’événements.

Backend : monolithe vs microservices, API et travaux en arrière‑plan

Pour les produits en early stage, l’IA préfère souvent un monolithe modulaire : une unité déployable, frontières internes claires et API simple (REST ou GraphQL). La contrainte : time‑to‑market et moins de pièces à gérer.

Les microservices apparaissent quand il faut mise à l’échelle indépendante, isolation stricte ou de nombreuses équipes délivrant en parallèle.

Le traitement en arrière‑plan est une autre étape de cartographie : emails, traitement vidéo, génération de rapports, retries de facturation ou intégrations pousseront l’ajout d’une file + workers pour conserver l’API utilisateur réactive.

Couche données : choisir la base la plus simple qui convient, puis ajouter des spécialistes

Les bases relationnelles sont suggérées quand vous avez besoin de transactions, reporting et règles métier cohérentes.

Les stores documentaires ou clé‑valeur apparaissent quand la contrainte est un schéma flexible, un très fort débit d’écriture ou des accès rapides simples.

La recherche (filtrage, ranking, tolérance aux fautes de frappe) devient souvent un composant séparé ; l’IA la recommande seulement quand les requêtes DB n’atteignent plus les besoins UX.

Intégrations : ne réinventez pas l’essentiel

Quand les contraintes incluent paiements, auth, analytics, messagerie ou notifications, les recommandations favorisent généralement des services établis et des bibliothèques plutôt que de tout construire — fiabilité, conformité et coût de maintenance comptent autant que les fonctionnalités.

Bases de données, cache et messaging : raisonnement typique de l’IA

Simplifiez le choix de la stack

Utilisez Planning Mode pour clarifier les exigences avant de générer quoi que ce soit.

Quand l’IA recommande une DB ou ajoute cache et files, elle répond principalement à trois types de contraintes : cohérence nécessaire, trafic en rafales, et besoin de livrer vite sans alourdir l’opérationnel.

Base relationnelle vs alternatives

Une base relationnelle (Postgres, MySQL) est souvent le choix par défaut quand vous avez des relations claires (utilisateurs → commandes → factures), forte cohérence et mises à jour multi‑étapes sûres (ex. « débiter puis créer abonnement puis envoyer reçu »). L’IA tend à choisir relationnel quand on mentionne :

- reporting et requêtes ad‑hoc pour finance/ops

- migrations et schémas évolutifs

- transactions et garanties « pas de double facturation »

Les alternatives sont proposées quand les contraintes penchent : base document pour schémas imbriqués évolutifs ; wide‑column/key‑value pour lectures/écritures ultra‑basses latences à grande échelle.

Cache et files : quand c’est pertinent

Le cache (souvent Redis ou un service managé) est recommandé quand des lectures répétées submergeraient la DB : pages produits populaires, données de session, rate limiting, feature flags. Si la contrainte est « pics de trafic » ou « p95 bas », le cache réduit fortement la charge DB.

Les files et workers s’imposent quand du travail peut être asynchrone : envoi d’emails, génération de PDF, synchronisations tierces, imports. Elles améliorent la réactivité et la résilience pendant les rafales.

Stockage de fichiers et event streams

Pour fichiers uploadés et assets, l’IA choisit généralement le stockage d’objet (style S3) : moins cher, scalabilité et base légère. Si le système doit suivre des flux d’événements (clicks, updates, signaux IoT), un event stream (Kafka/ PubSub‑style) peut être proposé pour gérer le traitement ordonné et haut débit.

Sécurité des données : contraintes qui forcent des choix prudents

Si la contrainte mentionne conformité, traçabilité ou objectifs de RTO, les recommandations incluent sauvegardes automatisées, restores testés, outils de migration et contrôles d’accès stricts (principe du moindre privilège, gestion des secrets). Plus « on ne peut pas perdre de données » apparaît, plus l’IA favorisera des services managés et des patterns éprouvés.

Déploiement, sécurité et opérations

Une recommandation de stack n’est pas que langage et base. L’IA infère aussi comment vous exécuterez le produit : où il sera hébergé, comment les mises à jour seront livrées, comment gérer les incidents et quelles protections mettre autour des données.

Cloud et hébergement : managé vs containers vs serverless

Quand les contraintes privilégient la vitesse et une petite équipe, l’IA favorise souvent des plateformes managées (PaaS) : patching automatique, rollbacks plus simples et scaling intégré. Si vous avez besoin de plus de contrôle (réseaux custom, runtimes spécialisés, communication interne entre services), les containers (souvent avec Kubernetes ou un orchestrateur plus simple) deviennent plus probables.

Le serverless est suggéré quand le trafic est imprévisible et que vous voulez payer essentiellement à l’usage. Les compromis : debugging plus complexe, cold starts qui peuvent impacter la latence perçue et coûts qui peuvent exploser si une fonction s’exécute en continu.

Si vous mentionnez PII, journaux d’audit ou localisation des données, l’IA recommande typiquement :

- contrôles d’accès forts (rôles least‑privilege, MFA)

- chiffrement en transit et au repos

- journalisation centralisée des actions sensibles

- stockage et sauvegardes verrouillés par région si nécessaire

Ce n’est pas un conseil juridique, mais des mesures pratiques pour réduire le risque et faciliter les revues.

Observabilité : être « prêt pour la montée en charge »

« Prêt pour la montée en charge » se traduit souvent par : logs structurés, métriques basiques (latence, taux d’erreur, saturation) et alerting lié à l’impact utilisateur. L’IA peut recommander le trio standard — logging + metrics + tracing — pour répondre aux questions : Qu’est‑ce qui a cassé ? Qui est affecté ? Qu’est‑ce qui a changé ?

Coûts : dépenses prévisibles vs pay‑per‑use

L’IA pèse si vous préférez des coûts mensuels prévisibles (capacité réservée, DB managée dimensionnée) ou du pay‑per‑use (serverless, autoscaling). Les bonnes recommandations signalent les risques de « facture surprise » : logs trop verbeux, jobs non bornés, egress de données, et donnent des limites/budgets simples pour contrôler les coûts.

Trois scénarios exemples et stacks suggérées

Ajoutez une appli mobile sans repartir de zéro

Transformez les mêmes exigences en une application Flutter pour iOS et Android quand vous en avez besoin.

Les recommandations sont présentées comme « meilleur ajustement selon ces contraintes », pas comme une réponse unique. Voici trois scénarios fréquents, sous la forme Option A / Option B avec hypothèses explicites.

Exemple 1 : petite équipe, délai serré, échelle modérée

Hypothèses : 2–5 ingénieurs, lancement en 6–10 semaines, trafic stable mais modéré (10k–200k utilisateurs/mois), capacité ops limitée.

Option A (vitesse d’abord, moins d’éléments mobiles) :

Suggestion typique : React/Next.js (frontend), Node.js (NestJS) ou Python (FastAPI) (backend), PostgreSQL (base), et une plateforme managée comme Vercel + Postgres managé. Auth et email sont souvent des choix « buy » (Auth0/Clerk, SendGrid) pour réduire le temps de build.

Si le principal impératif est le temps et que vous voulez éviter d’assembler plusieurs starters, une plateforme comme Koder.ai peut aider à mettre en place rapidement un frontend React et un backend Go + PostgreSQL depuis un spec conversationnel, avec options d’export du code et de déploiement — utile pour un MVP où l’on veut garder la propriété du code.

Option B (aligné avec l’équipe, horizon plus long) :

Si l’équipe est déjà forte dans un écosystème, on standardise souvent : Rails + Postgres ou Django + Postgres, avec une file minimale (Redis managé) seulement si les jobs en arrière‑plan sont nécessaires.

Exemple 2 : produit haut trafic, faible latence

Hypothèses : trafic en rafales, SLAs de latence stricte, workloads en lecture majoritaire, utilisateurs globaux.

Option A (performance avec defaults éprouvés) :

L’IA ajoute des couches : CDN (Cloudflare/Fastly), cache edge pour contenu statique, Redis pour lectures chaudes et rate limits, et une queue comme SQS/RabbitMQ pour asynchrone. Le backend peut évoluer vers Go/Java pour une latence prévisible, tout en gardant PostgreSQL avec réplicas en lecture.

Option B (garder la stack et optimiser les bords) :

Si le recrutement et le temps empêchent un changement de langage, la recommandation est souvent : conserver le backend actuel, mais investir dans stratégie de cache, traitement par files et indexation DB avant de réécrire.

Exemple 3 : données réglementées ou sensibles

Hypothèses : exigences de conformité (HIPAA/SOC 2/GDPR), audits, contrôle d’accès strict, journaux d’audit.

Option A (services managés matures) :

Choix fréquents : AWS/Azure avec KMS, chiffrement, réseau privé, IAM, journalisation centralisée et bases managées avec fonctions d’audit.

Option B (auto‑hébergé pour le contrôle) :

Quand la localisation ou des règles fournisseurs l’exigent, l’IA peut proposer Kubernetes + PostgreSQL avec contrôles ops renforcés — généralement avec l’avertissement que cela augmente le coût opérationnel récurrent.

Limites, risques et validation des recommandations IA

L’IA peut proposer une stack cohérente en apparence, mais elle devine toujours à partir de signaux partiels. Traitez la sortie comme une hypothèse structurée — pas comme une vérité absolue.

Limites courantes

D’abord, l’entrée est souvent incomplète. Si vous ne spécifiez pas le volume de données, la concurrence maximale, les besoins de conformité, les objectifs de latence ou les intégrations, la recommandation comblera les vides par des hypothèses.

Ensuite, les écosystèmes évoluent vite. Un modèle peut suggérer un outil qui était « best practice » récemment mais qui est maintenant déprécié, racheté, re‑tarifé ou plus supporté par votre cloud.

Enfin, certains contextes sont difficiles à encoder : politique interne, contrats existants, maturité on‑call réelle, ou coût d’une migration future.

Beaucoup de suggestions IA penchent vers des outils largement discutés. La popularité n’est pas forcément mauvaise, mais elle peut masquer des options mieux adaptées aux contraintes réglementaires, budgétaires ou à des workloads atypiques.

Contrez cela en énonçant clairement vos contraintes :

- « Nous ne pouvons pas embaucher d’ops spécialisés cette année. »

- « Les données doivent rester en région et être traçables. »

- « Nous privilégions des coûts prévisibles plutôt que la performance maximale. »

Des contraintes nettes forcent la recommandation à justifier les compromis au lieu de retomber sur des noms familiers.

Étapes de validation pour réduire les erreurs coûteuses

Avant de s’engager :

- Construisez un petit prototype sur les chemins les plus risqués (auth, paiements, realtime)

- Testez la charge tôt avec des patterns réalistes

- Estimez les coûts (compute, stockage, egress, logs) à court terme et pour 6–12 mois

- Réalisez une revue sécurité : modélisation de menace, gestion des accès, secrets, journaux d’audit

Utiliser l’IA en sécurité : conserver une trace écrite

Demandez à l’IA de produire un court « decision record » : objectifs, contraintes, composants choisis, alternatives rejetées et déclencheurs de changement. Garder ce raisonnement écrit accélère les débats futurs et rend les évolutions moins coûteuses.

Si vous utilisez un accélérateur de build (incluant des plateformes conversationnelles comme Koder.ai), appliquez la même discipline : capturez les hypothèses, validez tôt avec une tranche fonctionnelle, et gardez des mécanismes de sauvegarde/rollback et l’export du code source pour que la vitesse ne sacrifi pas le contrôle.