05 juin 2025·8 min

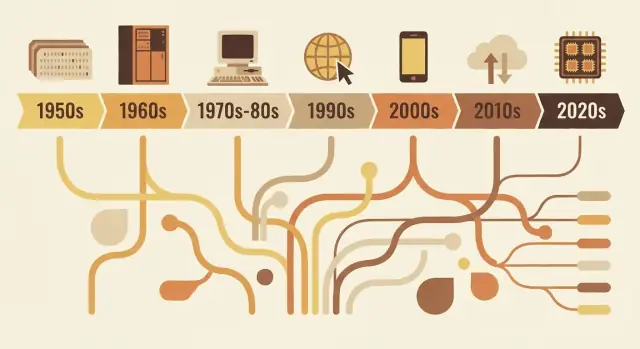

Comment les langages de programmation reflètent les besoins de leur époque

De FORTRAN à Rust, les langages reflètent les priorités de leur époque : limites matérielles, sécurité, web et travail en équipe. Voyez comment les choix de conception répondent à des problèmes concrets.

Pourquoi les langages ont l'apparence qu'ils ont

Les langages de programmation ne sont pas simplement des versions « meilleures » ou « pires » les uns des autres. Ce sont des réponses de conception aux problèmes que l'on devait résoudre à un moment donné de l'informatique.

Ce que « conception d'un langage » englobe réellement

Quand on parle de conception d'un langage, on parle de plus que de l'apparence du code sur une page. Un langage est un ensemble de choix tels que :

- Syntaxe : comment on exprime les idées (mots-clés, ponctuation, lisibilité)

- Types : si les valeurs ont des catégories déclarées (et à quel point le langage les vérifie strictement)

- Modèle mémoire : qui gère la mémoire, et quelles garanties de sécurité existent

- Modèle d'exécution : compilé vs interprété, comportement au runtime, compromis de performance

- Bibliothèque standard + outillage : paquets, systèmes de build, débogueurs, formateurs, et comment les équipes livrent le logiciel

Ces choix tendent à s'agréger autour des contraintes de l'époque : matériel limité, coût élevé du calcul, fonctionnalités système manquantes, ou (plus tard) équipes massives, réseaux mondiaux et menaces de sécurité.

L'idée centrale

Les langages reflètent leur époque. Les premiers langages privilégiaient l'extraction de valeur de machines rares. Les suivants misaient sur la portabilité lorsque le logiciel devait tourner sur de nombreux systèmes. À mesure que les projets grandissaient, les langages ont mis l'accent sur la structure, l'abstraction et l'outillage pour maintenir de grandes bases de code compréhensibles. Récemment, la concurrence, le déploiement dans le cloud et les exigences de sécurité ont imposé de nouveaux compromis.

Cet article se concentre sur quelques exemples représentatifs — pas une chronologie exhaustive année par année. Vous verrez comment quelques langages influents incarnent les besoins de leur période, et comment les idées se recyclent et se raffinent.

Pourquoi c'est utile pour choisir des outils aujourd'hui

Comprendre le « pourquoi » derrière un langage vous aide à prédire ses forces et ses angles morts. Cela clarifie des questions comme : ce langage est-il optimisé pour la performance, l'itération rapide, la maintenance par de grandes équipes ou la sécurité ? Quand vous décidez quoi apprendre ou quoi utiliser sur un projet, ce contexte vaut autant qu'une simple liste de fonctionnalités.

Contraintes de l'informatique précoce qui ont tout façonné

Les premiers langages ont été façonnés moins par le goût que par la physique et les budgets. Les machines avaient très peu de mémoire, le stockage était rare, et les CPU étaient lents par rapport aux standards actuels. Cela imposait des compromis constants : chaque fonctionnalité supplémentaire, chaque instruction plus longue et chaque couche d'abstraction avait un coût réel.

Petite mémoire, cycles coûteux

Si vous n'avez de la place que pour un petit programme et un petit jeu de données, vous concevez des langages et des outils qui gardent les programmes compacts et prévisibles. Les premiers systèmes poussaient les programmeurs vers des flux de contrôle simples et un support runtime minimal. Même des fonctionnalités « agréables à avoir » — comme des chaînes riches, la gestion dynamique de la mémoire ou des structures de données de haut niveau — pouvaient être impraticables car elles demandaient du code et de la tenue de comptes supplémentaires.

Traitement par lots et longs cycles de rétroaction

Beaucoup de premiers programmes s'exécutaient en mode batch. On préparait un travail (souvent via des cartes perforées), on le soumettait et on attendait. Si quelque chose échouait, on pouvait ne savoir pourquoi que bien plus tard, après l'exécution ou l'échec du job.

Ce long cycle de rétroaction changeait les priorités :

- les programmes devaient fonctionner correctement dès la première exécution, car relancer coûtait cher ;

- le débogage étant plus lent, les développeurs s'appuyaient sur une planification et des conventions soignées ;

- l'outillage et l'exploration interactive n'étaient pas l'expérience par défaut.

Pourquoi la lisibilité et les messages d'erreur n'étaient pas prioritaires

Quand le temps machine était précieux et les interfaces limitées, les langages n'optimisaient pas l'ergonomie des diagnostics ou la clarté pour les débutants. Les messages d'erreur devaient souvent être brefs, parfois cryptiques, et se concentrer sur l'aide à la localisation d'un problème dans un jeu de cartes ou une ligne de sortie imprimée.

La science et les maths ont guidé les premières fonctionnalités

Une grande part de la demande initiale venait du calcul scientifique et technique : calculs, simulations et méthodes numériques. C'est pourquoi les premières fonctionnalités tournaient souvent autour d'opérations arithmétiques efficaces, des tableaux et d'une façon d'exprimer les formules qui se mappait bien au matériel — et aux habitudes des chercheurs qui travaillaient déjà sur papier.

FORTRAN, COBOL et les langages conçus pour des tâches précises

Certains langages précoces n'ambitionnaient pas d'être universels. Ils étaient conçus pour résoudre très bien une catégorie restreinte de problèmes — parce que les ordinateurs étaient chers, le temps rare, et « assez bon pour tout » revenait souvent à « excellent pour rien ».

FORTRAN : calcul numérique, vitesse et charge de travail scientifique

FORTRAN (FORmula TRANslation) ciblait directement l'informatique scientifique et d'ingénierie. Sa promesse centrale était pratique : laisser les gens écrire des programmes mathématiques sans coder chaque détail en assembleur.

Ce but a façonné son design. Il privilégiait les opérations numériques et le calcul sur tableaux, et mettait l'accent sur la performance. L'innovation réelle n'était pas que syntaxique : c'était l'idée qu'un compilateur pouvait générer du code machine suffisamment efficace pour que les scientifiques lui fassent confiance. Quand votre tâche principale est la simulation ou le calcul physique, gagner du temps d'exécution n'est pas un luxe, c'est la différence entre obtenir des résultats aujourd'hui ou la semaine suivante.

COBOL : traitement des dossiers, lisibilité et reporting

COBOL ciblait un univers différent : gouvernements, banques, assurances, paie et inventaires. Ce sont des problèmes de « dossiers et rapports » — données structurées, flux de travail prévisibles et beaucoup d'audit.

COBOL a donc favorisé un style verbeux, proche de l'anglais, qui rendait les programmes plus faciles à relire et à maintenir dans de grandes organisations. La définition des données était une préoccupation de premier plan, parce que le logiciel métier vit et meurt selon la qualité de son modèle de formulaires, comptes et transactions.

Ce que signifie « proche du domaine »

Les deux langages illustrent un principe de conception toujours pertinent : le vocabulaire doit refléter le travail.

FORTRAN parle en mathématiques et calcul. COBOL parle en dossiers et procédures. Leur popularité révèle les priorités de leur époque : il ne s'agissait pas d'expérimentation abstraite, mais de faire tourner des charges réelles — que cela signifie accélérer des calculs numériques ou mieux modéliser des données métier.

L'ère des systèmes : portabilité et contrôle (C, Unix)

À la fin des années 1960 et dans les années 1970, les ordinateurs devenaient moins chers et plus répandus — mais restaient très hétérogènes. Un logiciel écrit pour une machine demandait souvent une réécriture importante pour tourner sur une autre.

La souffrance de l'assembleur a poussé les langages vers le haut

Beaucoup de logiciels importants étaient écrits en assembleur, ce qui donnait une performance et un contrôle maximaux, mais au prix élevé d'une dépendance forte au jeu d'instructions du processeur. Ce coût a créé la demande pour un langage qui reste « proche du métal » sans enfermer sur un seul processeur.

L'objectif central de C : code système portable

C est né comme un compromis pratique. Il a été conçu pour écrire des systèmes d'exploitation et des outils — en particulier Unix — tout en restant portable entre matériels. C offrait :

- un ensemble de fonctionnalités simple et maniable compilable sur beaucoup de machines ;

- un accès direct à la mémoire via des pointeurs ;

- la capacité d'écrire du code bas niveau sans revenir systématiquement à l'assembleur.

La réécriture d'Unix en C est la preuve célèbre : le système pouvait migrer vers de nouveaux matériels bien plus facilement qu'un système écrit uniquement en assembleur.

Pourquoi la gestion manuelle de la mémoire était acceptable

C attendait que vous gériez la mémoire vous-même (allocation, libération, éviter les erreurs). Cela paraît risqué aujourd'hui, mais correspondait aux priorités de l'époque : ressources limitées, systèmes d'exploitation nécessitant des performances prévisibles, et programmeurs souvent proches du matériel — parfois conscients de l'agencement mémoire exact qu'ils voulaient.

Le compromis durable

C a optimisé pour la vitesse et le contrôle, et a tenu ses promesses. Le prix fut la sécurité et la facilité : débordements de tampon, plantages et bugs subtils sont devenus des risques courants. À l'époque, ces risques étaient souvent considérés comme un coût acceptable pour la portabilité et la performance.

Rendre les gros programmes maintenables : structure et types

Quand les programmes sont passés d'utilitaires petits et monofonctions à des produits gérant des entreprises, un nouveau problème a dominé : pas seulement « est-ce que ça marche ? » mais « peut-on le maintenir pendant des années ? » Le code ancien était souvent évolutif par rustines et sauts (goto), produisant du « spaghetti code » difficile à lire, tester ou modifier en toute sécurité.

Ce que la programmation structurée a tenté de corriger

La programmation structurée a promu une idée simple : le code doit avoir une forme claire. Plutôt que de sauter à des lignes arbitraires, les développeurs utilisèrent des blocs bien définis — if/else, while, for, switch — pour rendre le flux de contrôle prévisible.

Cette prévisibilité importait parce que le débogage consiste majoritairement à répondre à « comment l'exécution en est-elle arrivée là ? ». Quand le flux est visible dans la structure, moins de bugs se cachent dans les interstices.

L'essor des équipes et des bases de code durables

Quand le logiciel est devenu une activité d'équipe, la maintenabilité est devenue un problème social autant que technique. De nouveaux membres devaient comprendre du code qu'ils n'avaient pas écrit. Les managers voulaient des estimations de changements. Les entreprises avaient besoin de confiance que les mises à jour n'exploseraient pas tout.

Les langages ont répondu en encourageant des conventions extensibles : limites de fonctions cohérentes, durées de vie de variables plus claires, et moyens d'organiser le code en fichiers et bibliothèques séparés.

Pourquoi les types, modules et portées ont pris de la valeur

Les types ont pris de l'importance car ils servent de « documentation intégrée » et de détection d'erreurs précoce. Si une fonction attend un nombre mais reçoit du texte, un système de types strict peut l'attraper avant que ça n'atteigne les utilisateurs.

Les modules et les portées ont aidé à limiter la zone d'impact des changements. En gardant des détails privés et en exposant seulement des interfaces stables, les équipes peuvent refactorer l'intérieur sans réécrire tout le programme.

Mouvements de conception qui ont favorisé la composition

Les améliorations courantes incluaient :

- des fonctions plus petites et bien nommées qui font une seule tâche ;

- la portée lexicale pour éviter les interactions accidentelles entre variables ;

- de meilleurs patterns de composition (passer fonctions/données proprement plutôt que dépendre d'état global).

Ensemble, ces évolutions ont fait pencher les langages vers du code plus facile à lire, relire et faire évoluer en toute sécurité.

Objets et entreprise : pourquoi la POO est devenue dominante

Soyez récompensé pour vos parrainages

Invitez des collègues ou amis et gagnez des crédits lorsqu'ils commencent à utiliser Koder.ai.

La programmation orientée objet (POO) n'a pas « gagné » parce que c'était la seule bonne idée — elle a gagné parce qu'elle correspondait à ce que beaucoup d'équipes tentaient de construire : des logiciels métier durables maintenus par beaucoup de personnes.

Ce que la POO promettait

La POO offrait une histoire claire pour la complexité : représenter le programme comme un ensemble « d'objets » ayant des responsabilités distinctes.

L'encapsulation (masquer les détails internes) semblait pratique pour éviter les bris accidentels. L'héritage et le polymorphisme promettaient la réutilisation : écrire une version générale une fois, la spécialiser ensuite et brancher différentes implémentations sur la même interface.

Pourquoi les interfaces graphiques et les applications métier l'ont poussée

Avec l'essor des applications de bureau et des interfaces graphiques, les développeurs avaient besoin de gérer de nombreux composants interactifs : fenêtres, boutons, documents, menus et événements. Penser en objets et en messages correspondait naturellement à ces éléments interactifs.

Parallèlement, les systèmes d'entreprise croissaient autour de domaines comme la banque, l'assurance, les stocks et les RH. Ces environnements valorisaient la cohérence, la collaboration en équipe et des bases de code évoluant sur des années. La POO correspondait à un besoin organisationnel : diviser le travail en modules détenus par différentes équipes, faire respecter des frontières et standardiser la façon d'ajouter des fonctionnalités.

Là où elle aide — et là où elle complique

La POO excelle quand elle crée des frontières stables et des composants réutilisables. Elle devient pénible quand les développeurs surmodélisent tout, créent des hiérarchies de classes profondes, des « god objects » ou des patterns utilisés surtout par effet de mode. Trop de couches rendent les changements simples aussi lourds que de la paperasserie.

Influence durable

Même les langages qui ne sont pas « purement POO » ont emprunté ses defaults : structures de type classe, interfaces, modificateurs d'accès et patterns de conception. Une grande partie de la syntaxe moderne reflète encore cet accent sur l'organisation des équipes autour de grandes bases de code.

L'ère Java : portabilité, sécurité et échelle entreprise

Java est apparu avec un type de boom logiciel très spécifique : de larges systèmes d'entreprise durables déployés sur un mélange hétérogène de serveurs, systèmes d'exploitation et matériels vendeurs. Les entreprises voulaient des déploiements prévisibles, moins de plantages et des équipes capables de croître sans tout réécrire tous les quelques années.

Ce que la JVM a résolu : portabilité avec un runtime géré

Plutôt que de compiler directement vers les instructions d'une machine, Java compile en bytecode exécuté par la Java Virtual Machine (JVM). Cette JVM est devenue la couche standard sur laquelle les entreprises pouvaient s'appuyer : expédiez le même artefact applicatif et faites-le tourner sur Windows, Linux ou de grands Unix avec peu de modifications.

C'est le cœur du « write once, run anywhere » : pas une garantie d'absence totale de quirks, mais un moyen pratique de réduire le coût et le risque de supporter de nombreux environnements.

Défauts de sécurité par défaut qui ont réduit les pannes en production

Java a fait de la sécurité un attribut principal plutôt qu'une discipline optionnelle.

La collecte automatique de la mémoire (garbage collection) a réduit toute une catégorie de bugs mémoire (pointeurs pendants, double-free) fréquents dans les environnements non gérés. Les vérifications des bornes de tableaux ont aidé à prévenir l'accès hors structure. Combinées à un système de types plus strict, ces décisions visaient à transformer les défaillances catastrophiques en exceptions prévisibles — plus faciles à reproduire, journaliser et corriger.

Pourquoi cela collait à la réalité de l'entreprise

Les entreprises valorisaient la stabilité, l'outillage et la gouvernance : processus de build standardisés, fort support IDE, bibliothèques étendues et un runtime supervisable. La JVM a aussi permis un riche écosystème de serveurs d'applications et de frameworks rendant le développement en équipe plus cohérent.

Les compromis : overhead, réglage, complexité

Les bénéfices de Java n'étaient pas gratuits. Un runtime géré ajoute du temps au démarrage et une empreinte mémoire, et la garbage collection peut créer des pics de latence si elle n'est pas réglée. Avec le temps, l'écosystème a accumulé de la complexité — couches de frameworks, configuration et modèles de déploiement — qui exigent des compétences spécialisées.

Pourtant, pour beaucoup d'organisations, l'échange en valait la peine : moins de pannes bass-niveau, un déploiement multiplateforme simplifié et un runtime partagé qui a évolué avec la taille de l'entreprise et du code.

Langages script et poussée pour la productivité

Concevez le projet en amont

Utilisez le Mode Planification pour définir les fonctionnalités avant de générer le code.

À la fin des années 1990 et dans les années 2000, beaucoup d'équipes n'écrivaient plus d'OS — elles reliaient bases de données, créaient des sites web et automatis(ai)ent des workflows internes. Le goulot d'étranglement est passé de l'efficacité CPU brute au temps développeur. Des boucles de rétroaction plus courtes et des déploiements fréquents ont fait de « quelle vitesse pour modifier ? » une exigence de premier plan.

Pourquoi l'itération rapide est devenue prioritaire

Les applications web évoluaient en jours, pas en années. Les entreprises voulaient de nouvelles pages, rapports et intégrations rapidement, sans pipeline complet de compilation–link–déploiement. Les langages scripts correspondaient à ce rythme : modifiez un fichier, exécutez-le, voyez le résultat.

Cela a aussi changé qui pouvait construire du logiciel. Administrateurs système, analystes et petites équipes pouvaient livrer des outils utiles sans une connaissance approfondie de la gestion mémoire ou des systèmes de build.

Typage dynamique et écosystèmes batteries-included

Des langages comme Python et Ruby ont misé sur le typage dynamique : on peut exprimer une idée avec moins de déclarations et moins de cérémonial. Combiné à de solides bibliothèques standard, cela rendait les tâches courantes « à un import près » :

- traitement de texte et fichiers ;

- HTTP, e-mail et réseau basique ;

- accès aux bases et formats de données (CSV, JSON, XML).

Cette approche batteries-included récompensait l'expérimentation et laissait les scripts d'automatisation grandir naturellement en applications réelles.

Python, Ruby et PHP en tant que réponses pratiques

Python est devenu un choix pour l'automatisation et la programmation générale, Ruby a accéléré le développement web (notamment via des frameworks), et PHP a dominé le serveur web initial parce qu'il était facile à intégrer aux pages et à déployer partout.

Les compromis : vitesse, erreurs runtime, pratiques de montée en charge

Les mêmes caractéristiques qui rendaient les langages scripts productifs introduisaient aussi des coûts :

- exécution plus lente que les langages compilés ;

- davantage d'erreurs détectées à l'exécution ;

- l'échelle demandait de la discipline : tests, revue de code, linters et conventions.

Autrement dit, ces langages optimisaient pour le changement. Les équipes ont appris à « racheter » la fiabilité avec de l'outillage et des pratiques — préparant le terrain pour des écosystèmes modernes où vitesse développeur et qualité logicielle sont tous deux attendues.

JavaScript et le boom piloté par le navigateur

Le navigateur web est devenu un « ordinateur » distribué à des millions d'utilisateurs. Mais ce n'était pas un espace vierge : c'était un sandbox, il tournait sur du matériel imprévisible et devait rester réactif tout en dessinant l'interface et en attendant le réseau. Cet environnement a façonné le rôle de JavaScript bien plus que toute idée abstraite d'un langage parfait.

Une plateforme aux contraintes particulières

Les navigateurs exigeaient que le code soit livré instantanément, s'exécute en sécurité à côté de contenu non fiable et garde la page interactive. Tout cela a poussé JavaScript vers un démarrage rapide, un comportement dynamique et des API fortement liées à la page : clics, saisie, timers et, plus tard, requêtes réseau.

Pourquoi « partout » a surpassé « parfait »

JavaScript a gagné surtout parce qu'il était déjà présent. Si vous vouliez du comportement dans un navigateur, JavaScript était l'option par défaut — sans étape d'installation, sans permission, sans runtime séparé à faire télécharger aux utilisateurs. Des idées concurrentes pouvaient paraître plus propres sur le papier, mais ne pouvaient égaler l'avantage de distribution du « ça marche sur chaque site ».

Événementiel par nécessité

Le navigateur est fondamentalement réactif : les utilisateurs cliquent, la page défile, les requêtes reviennent quand elles reviennent. Le style événementiel de JavaScript (callbacks, événements, promises) reflète cette réalité. Plutôt qu'un programme qui s'exécute de A à Z, une grande partie du code web est « attendre quelque chose, puis répondre », ce qui convient naturellement à l'UI et au réseau.

Effets à long terme : écosystèmes et compatibilité

Le succès a créé un puits de gravité. D'immenses écosystèmes se sont formés autour de frameworks et bibliothèques, et la chaîne d'outils est devenue une catégorie produit : transpileurs, bundlers, minificateurs et gestionnaires de paquets. En même temps, la promesse de compatibilité ascendante du web a fait que les vieilles décisions persistent — ainsi le JavaScript moderne ressemble souvent à des couches d'outils ajoutées pour cohabiter avec des contraintes historiques.

Concurrence et la réalité multicœur

Pendant longtemps, un ordinateur plus rapide signifiait essentiellement que votre programme s'exécutait plus vite sans changer une ligne. Ce contrat a été rompu quand les puces ont atteint des limites thermiques et énergétiques et ont commencé à ajouter des cœurs plutôt qu'à augmenter la fréquence. Soudain, obtenir plus de performance nécessitait souvent de faire plusieurs choses à la fois.

Pourquoi le multicœur a rendu la concurrence inévitable

Les applications modernes accomplissent rarement une seule tâche isolée. Elles traitent de nombreuses requêtes, parlent aux bases, rendent l'UI, traitent des fichiers et attendent des réseaux — tout en offrant une réactivité instantanée aux utilisateurs. Le matériel multicœur permet d'exécuter du travail en parallèle, mais rend aussi pénible l'usage d'un langage ou runtime qui suppose « un seul thread principal ».

Ce que les langages ont ajouté pour aider

La concurrence précoce reposait sur des threads OS et des verrous. Beaucoup de langages les exposaient directement, ce qui fonctionnait mais mettait la complexité sur les développeurs.

Les conceptions plus récentes cherchent à faciliter les motifs courants :

- Threads avec primitives plus sûres : meilleurs mutex, pools de threads et modèles mémoire plus clairs ;

- async/await : une manière d'écrire du code non-bloquant qui ressemble pourtant à du code pas-à-pas ;

- Channels et passage de messages : « partager des données en communiquant » (style CSP) pour réduire les bugs d'état partagé.

Les serveurs et systèmes distribués ont changé les valeurs par défaut

Avec le logiciel devenu service toujours actif, le programme « normal » est devenu un serveur traitant des milliers de requêtes concurrentes. Les langages ont commencé à optimiser pour des charges I/O lourdes, l'annulation/timeouts et des performances prévisibles sous charge.

Pièges que les langages tentent d'éviter

Les défaillances concurrentes sont souvent rares et difficiles à reproduire. La conception des langages vise de plus en plus à prévenir :

- les conditions de course (deux tâches modifiant la même donnée de façon imprévisible) ;

- les interblocages (tâches qui attendent indéfiniment les unes sur les autres) ;

- la famine (certain travail qui ne reçoit jamais de CPU).

Le grand changement : la concurrence a cessé d'être un sujet avancé pour devenir une attente de base.

Priorités modernes : sécurité, simplicité et outillage (Go, Rust)

Itérez sans crainte

Sauvegardez vos progrès avec des instantanés et revenez en arrière en toute sécurité.

Dans les années 2010, beaucoup d'équipes n'avaient plus de mal à exprimer des algorithmes — elles avaient du mal à maintenir des services sûrs, stables et faciles à changer sous une pression de déploiement continu. Deux problèmes se démarquaient : les bugs de sécurité dus à des erreurs mémoire et le frein ingénierie causé par des piles complexes et un outillage incohérent.

Corriger les bugs qui se répètent

Une grande part des vulnérabilités critiques provient toujours d'erreurs de sécurité mémoire : débordements de tampon, use-after-free et comportements indéfinis qui n'apparaissent que sur certaines machines ou builds. La conception moderne des langages considère de plus en plus ces « pistolets brachiaux » comme inacceptables.

Rust est la réponse la plus claire. Ses règles d'ownership et d'emprunt sont en quelque sorte un marché : vous écrivez du code qui satisfait des vérifications strictes à la compilation, et en retour vous obtenez de fortes garanties de sécurité mémoire sans ramasse-miettes. Cela rend Rust attractif pour le code système historique en C/C++ — services réseau, composants embarqués, bibliothèques sensibles à la performance — où la sécurité et la vitesse comptent toutes deux.

Simplicité et services comme charge de travail par défaut

Go adopte presque l'approche opposée : limiter les features du langage pour garder les bases de code lisibles et prévisibles dans de grandes équipes. Son design reflète un monde de services longue durée, API et infrastructure cloud.

La bibliothèque standard de Go et ses primitives de concurrence intégrées (goroutines, channels) supportent directement le développement de services, tandis que son compilateur rapide et sa gestion des dépendances réduisent la friction au quotidien.

L'expérience développeur devient une feature

L'outillage est passé d'« extra optionnel » à promesse du langage. Go a normalisé cet état d'esprit avec gofmt et une forte culture de formatage standard. Rust a suivi avec rustfmt, clippy et un outil de build très intégré (cargo).

Dans l'environnement actuel de « livraison continue », cette histoire d'outillage dépasse les compilateurs et linters pour inclure des workflows de plus haut niveau : planification, scaffolding et boucles d'itération plus rapides. Des plateformes comme Koder.ai illustrent ce mouvement en laissant des équipes construire web, backend et mobile via une interface chat — puis exporter le code source, déployer et revenir en arrière avec des snapshots quand nécessaire. C'est un autre exemple du même schéma historique : les outils qui se diffusent rapidement sont ceux qui rendent le travail courant de l'époque moins coûteux et moins sujet aux erreurs.

Quand formateurs, linters et systèmes de build sont de première classe, les équipes passent moins de temps à débattre du style ou à combattre des environnements incohérents — et plus de temps à livrer du logiciel fiable.

Ce que les problèmes d'aujourd'hui suggèrent pour les langages de demain

Les langages de programmation ne « gagnent » pas parce qu'ils sont parfaits. Ils gagnent quand ils rendent le travail courant de l'époque moins coûteux, plus sûr ou plus rapide — surtout quand ils s'accompagnent des bonnes bibliothèques et habitudes de déploiement.

IA, données et la force des écosystèmes

Un moteur majeur de la popularité actuelle des langages est l'endroit où se trouve le travail : pipelines de données, analytics, machine learning et automatisation. Voilà pourquoi Python continue de croître — pas seulement pour la syntaxe, mais pour son écosystème : NumPy/Pandas pour les données, PyTorch/TensorFlow pour le ML, notebooks pour l'exploration, et une large communauté produisant des blocs réutilisables.

SQL est l'exemple plus discret du même effet. Ce n'est pas à la mode, mais c'est l'interface par défaut aux données métier parce qu'il correspond au travail : requêtes déclaratives, optimiseurs prévisibles et compatibilité large entre outils et fournisseurs. Les nouveaux langages intègrent souvent SQL plutôt que de le remplacer.

Pendant ce temps, l'IA gourmande en performances pousse l'outillage orienté GPU. On voit plus d'attention aux vectorisations, batchs et accélérations matérielles — que ce soit via les écosystèmes CUDA, MLIR et piles de compilateurs, ou des langages facilitant les bindings vers ces runtimes.

Ce qui pourrait façonner les futurs designs de langages

Plusieurs pressions influenceront probablement les prochains langages ou mises à jour majeures :

- Vérification et correction : types plus puissants, concurrence plus sûre et outils qui prouvent des propriétés plutôt que de simplement tester ;

- Confidentialité et politique : meilleur support pour la gouvernance des données, l'auditabilité et des contraintes sur les données sensibles ;

- Consommation d'énergie et efficacité : langages et runtimes qui facilitent l'écriture de code rapide sans micro-optimisations manuelles.

Bilan pratique

Quand vous choisissez un langage, faites-le correspondre à vos contraintes : expérience de l'équipe, vivier de recrutement, bibliothèques nécessaires, cibles de déploiement et exigences de fiabilité. Un langage « bon » est souvent celui qui rend vos tâches les plus fréquentes ennuyeuses — et vos pannes plus faciles à prévenir et diagnostiquer.

Si vous avez besoin d'un écosystème basé sur un framework, choisissez pour l'écosystème ; si vous avez besoin de correction et de contrôle, choisissez pour la sécurité et la performance. Pour une checklist de décision plus approfondie, voir /blog/how-to-choose-a-programming-language.