18 mai 2025·8 min

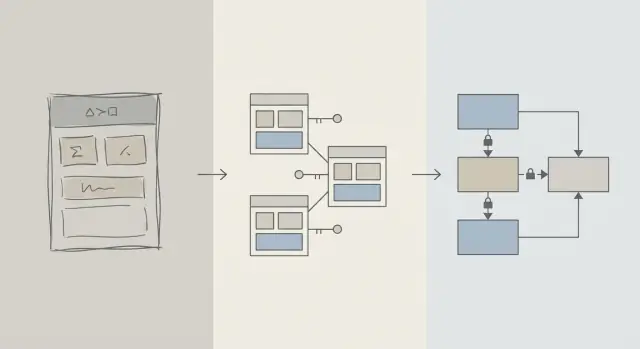

Conception du schéma d'abord : des apps plus rapides que l'optimisation précoce des requêtes

Les gains de performance initiaux proviennent généralement d'une meilleure conception du schéma : les bonnes tables, clés et contraintes évitent des requêtes lentes et des réécritures coûteuses plus tard.

Schéma vs optimisation des requêtes : ce que nous entendons

Quand une application semble lente, l'instinct premier est souvent de « réparer le SQL ». Cet réflexe se comprend : une requête unique est visible, mesurable et facile à incriminer. Vous pouvez lancer EXPLAIN, ajouter un index, ajuster un JOIN et parfois obtenir un gain immédiat.

Mais tôt dans la vie d'un produit, les problèmes de vitesse proviennent tout autant de la forme des données que du texte de la requête. Si le schéma vous oblige à lutter contre la base, l'optimisation des requêtes devient un jeu de whack-a-mole.

Conception de schéma (en clair)

La conception de schéma est la manière dont vous organisez vos données : tables, colonnes, relations et règles. Elle inclut des décisions telles que :

- Quels « objets » méritent leur propre table (utilisateurs, commandes, événements)

- Comment les tables se relient (un-à-plusieurs, plusieurs-à-plusieurs)

- Ce qui doit être unique ou obligatoire (contraintes)

- Comment représenter les états et l'historique (timestamps, champs de statut, journaux d'audit)

Un bon schéma fait en sorte que la manière naturelle de poser des questions soit aussi la manière rapide.

Optimisation des requêtes (en clair)

L'optimisation des requêtes consiste à améliorer la façon dont vous récupérez ou mettez à jour les données : réécrire les requêtes, ajouter des index, réduire le travail inutile et éviter les patterns qui déclenchent de vastes scans.

Les deux comptent — l'ordre importe davantage

Cet article ne dit pas « schéma bon, requêtes mauvaises ». Il parle d'ordre des opérations : mettez d'abord les fondamentaux du schéma en place, puis optimisez les requêtes qui en ont réellement besoin.

Vous verrez pourquoi les décisions de schéma dominent la performance initiale, comment repérer quand le schéma est le vrai goulot d'étranglement, et comment l'évoluer en toute sécurité à mesure que votre application grandit. C'est écrit pour les équipes produit, fondateurs et développeurs construisant des applications réelles — pas seulement pour des spécialistes de bases de données.

Pourquoi la conception du schéma pilote la plupart des performances initiales

Les problèmes de performance en phase initiale ne tiennent généralement pas à du SQL astucieux : ils tiennent à la quantité de données que la base est forcée de parcourir.

La structure détermine ce que vous scannez

Une requête ne peut être plus sélective que ce que permet le modèle de données. Si vous stockez « statut », « type » ou « propriétaire » dans des champs peu structurés (ou répartis dans des tables incohérentes), la base doit souvent scanner bien plus de lignes pour trouver les correspondances.

Un bon schéma réduit naturellement l'espace de recherche : colonnes claires, types cohérents et tables bien délimitées permettent aux requêtes de filtrer plus tôt et de lire moins de pages sur disque ou en mémoire.

L'absence de clés crée du travail coûteux

Quand les clés primaires et étrangères manquent (ou ne sont pas appliquées), les relations deviennent des suppositions. Cela pousse le travail dans la couche requête :

- Les jointures grossissent parce qu'il n'existe pas de chemin d'association indexé et fiable.

- Les filtres deviennent plus complexes car vous compensez les doublons, les nulls et les valeurs « presque identiques ».

Sans contraintes, les mauvaises données s'accumulent — et les requêtes continuent de ralentir au fur et à mesure que vous ajoutez des lignes.

Les index suivent le schéma (et ne peuvent pas tout réparer)

Les index sont les plus utiles lorsqu'ils correspondent à des chemins d'accès prévisibles : jointures sur clés étrangères, filtrage sur colonnes bien définies, tri sur champs courants. Si le schéma stocke des attributs critiques dans la mauvaise table, mélange les significations dans une seule colonne, ou s'appuie sur du parsing de texte, les index ne vous sauveront pas — vous scannerez et transformerez toujours trop de choses.

Rapide par défaut

Avec des relations propres, des identifiants stables et des limites de table sensées, beaucoup de requêtes quotidiennes deviennent « rapides par défaut » parce qu'elles touchent moins de données et utilisent des prédicats simples et favorables aux index. L'optimisation des requêtes devient alors une étape de finition — pas une lutte constante.

La réalité en phase initiale : le changement est constant

Les produits en phase initiale n'ont pas des « exigences stables » — ils ont des expérimentations. Les fonctionnalités sont lancées, réécrites ou disparaissent. Une petite équipe jongle entre feuille de route, support et infrastructure avec peu de temps pour revenir sur des décisions antérieures.

Ce qui change le plus souvent

Ce n'est généralement pas le texte SQL qui change en premier. C'est le sens des données : nouveaux états, nouvelles relations, nouveaux champs « ah, il faut aussi suivre… », et des workflows entiers non imaginés au lancement. Cette instabilité est normale — et c'est précisément pourquoi les choix de schéma comptent tant au début.

Pourquoi corriger le schéma plus tard est plus difficile que corriger une requête

Réécrire une requête est généralement réversible et locale : vous pouvez déployer une amélioration, la mesurer et revenir en arrière si nécessaire.

Réécrire un schéma, c'est différent. Une fois que vous avez stocké de vraies données client, chaque changement structurel devient un projet :

- Migrations qui verrouillent les tables ou ralentissent les écritures aux heures de pointe

- Backfills pour remplir de nouvelles colonnes ou reconstruire des données dérivées

- Double-écriture ou tables en shadow pour garder l'application opérationnelle pendant la transition

- Risque d'interruption si un changement ne peut pas être effectué en ligne

Même avec de bons outils, les changements de schéma introduisent des coûts de coordination : mises à jour du code applicatif, séquençage des déploiements et validation des données.

Comment les décisions initiales se cumulent

Quand la base est petite, un schéma maladroit peut sembler « acceptable ». À mesure que les lignes passent de milliers à millions, le même design provoque des scans plus larges, des index plus lourds et des jointures plus coûteuses — puis chaque nouvelle fonctionnalité vient s'appuyer sur cette base.

L'objectif en phase initiale n'est donc pas la perfection. C'est de choisir un schéma qui absorbe le changement sans forcer des migrations risquées à chaque apprentissage produit.

Principes de conception qui préviennent les requêtes lentes

La plupart des problèmes de « requêtes lentes » au début ne tiennent pas aux astuces SQL — ils tiennent à l'ambiguïté du modèle de données. Si le schéma rend flou ce qu'une ligne représente, ou comment les lignes se relient, chaque requête devient plus coûteuse à écrire, exécuter et maintenir.

Commencez avec un petit ensemble d'entités essentielles

Commencez par nommer les quelques éléments dont votre produit ne peut pas se passer : utilisateurs, comptes, commandes, abonnements, événements, factures — ce qui est vraiment central. Définissez ensuite explicitement les relations : un-à-plusieurs, plusieurs-à-plusieurs (généralement avec une table de jointure) et la propriété (qui « contient » quoi).

Un test pratique : pour chaque table, vous devriez pouvoir compléter la phrase « Une ligne dans cette table représente ___ ». Si vous ne le pouvez pas, la table mélange probablement des concepts, ce qui forcera plus tard des filtrages et des jointures complexes.

Rendre les noms et la propriété ennuyeusement cohérents

La cohérence évite les jointures accidentelles et les comportements API déroutants. Choisissez des conventions (snake_case vs camelCase, *_id, created_at/updated_at) et respectez-les.

Décidez aussi qui « possède » un champ. Par exemple, « billing_address » appartient-il à une commande (snapshot à un instant T) ou à un utilisateur (préférence courante) ? Les deux peuvent être valides — mais les mélanger sans intention claire crée des requêtes lentes et sujettes aux erreurs pour « déterminer la vérité ».

Choisissez des types qui correspondent à la réalité

Utilisez des types qui évitent les conversions à l'exécution :

- Utilisez des timestamps avec règles de fuseau horaire claires.

- Utilisez des décimales pour l'argent (pas des floats).

- Utilisez des enums ou des tables de référence pour les catégories connues.

Quand les types sont incorrects, les bases ne peuvent pas comparer efficacement, les index deviennent moins utiles et les requêtes nécessitent souvent des casts.

Ne dupliquez pas les faits sans plan

Stocker le même fait à plusieurs endroits (par ex. order_total et sum(line_items)) crée de la dérive. Si vous mettez en cache une valeur dérivée, documentez-la, définissez la source de vérité et garantissez les mises à jour de façon cohérente (souvent via la logique applicative + contraintes).

Clés et contraintes : la vitesse commence par l'intégrité des données

Une base rapide est généralement une base prévisible. Les clés et contraintes rendent vos données prévisibles en empêchant des états « impossibles » — relations manquantes, identités dupliquées ou valeurs qui ne signifient pas ce que l'app croit. Cette propreté impacte directement la performance car la base peut émettre de meilleures hypothèses lors de la planification des requêtes.

Clés primaires : chaque table a besoin d'un identifiant stable

Chaque table devrait avoir une clé primaire (PK) : une colonne (ou petit ensemble de colonnes) qui identifie de façon unique une ligne et ne change jamais. Ce n'est pas juste une règle théorique — c'est ce qui vous permet de faire des jointures efficacement, de mettre en cache en sécurité et de référencer des enregistrements sans deviner.

Une PK stable évite aussi des contournements coûteux. Si une table manque d'identifiant vrai, les applications commencent à « identifier » les lignes par email, nom, timestamp ou un bundle de colonnes — menant à des index larges, des jointures lentes et des cas limites quand ces valeurs changent.

Clés étrangères : une intégrité qui aide l'optimiseur

Les clés étrangères (FK) font respecter les relations : un orders.user_id doit pointer vers un users.id existant. Sans FK, des références invalides s'installent (commandes pour des utilisateurs supprimés, commentaires pour des posts manquants) et alors chaque requête doit filtrer défensivement, faire des left-join et gérer les nulls.

Avec des FK en place, le planificateur peut souvent optimiser les jointures plus sereinement parce que la relation est explicite et garantie. Vous accumulerez aussi moins d'orphelins qui alourdissent les tables et les index au fil du temps.

Les contraintes comme garde-fous pour des données propres et rapides

Les contraintes ne sont pas de la bureaucratie — ce sont des garde-fous :

- UNIQUE empêche les duplications qui forcent l'app à faire des recherches et nettoyages supplémentaires. Exemple : un seul

users.emailcanonique. - NOT NULL évite la logique tri-état et les branches surprises de gestion des nulls dans les requêtes.

- CHECK maintient les valeurs dans un ensemble connu (ex.

status IN ('pending','paid','canceled')).

Des données plus propres signifient des requêtes plus simples, moins de conditions de repli et moins de jointures « au cas où ».

Anti-patterns courants qui vous ralentissent

- Pas de clés étrangères : vous paierez plus tard avec des jobs de nettoyage d'orphelins et une logique de requête compliquée.

- Duplication de champs « email » (ex.

users.emailetcustomers.email) : vous obtenez des identités conflictuelles et des index en double. - Chaînes de statut libres : des fautes de frappe comme "Cancelled" vs "canceled" créent des segments cachés qui cassent les filtres et les rapports.

Si vous voulez de la vitesse tôt, rendez difficile le stockage de mauvaises données. La base vous récompensera par des plans plus simples, des index plus petits et moins de surprises de performance.

Normalisation vs dénormalisation : un équilibre pratique

Gagnez des crédits en apprenant

Obtenez des crédits en créant du contenu sur Koder.ai ou en parrainant de nouveaux utilisateurs.

La normalisation est une idée simple : stocker chaque « fait » en un seul endroit pour ne pas dupliquer les données dans toute la base. Quand la même valeur est copiée dans plusieurs tables ou colonnes, les mises à jour deviennent risquées — une copie change, une autre non, et votre appli commence à afficher des réponses contradictoires.

Normalisation (par défaut) : un fait, une maison

Concrètement, la normalisation signifie séparer les entités pour que les mises à jour soient propres et prévisibles. Par exemple, le nom et le prix d'un produit appartiennent à products, pas répétés dans chaque ligne de commande. Un nom de catégorie appartient à categories, référencé par un ID.

Cela réduit :

- les données dupliquées (moins de stockage, moins d'incohérences)

- les erreurs de mise à jour (changer une fois, reflété partout)

- les bugs « quelle valeur est correcte ? »

Quand la sur-normalisation fait du mal

La normalisation peut être poussée trop loin quand vous divisez les données en beaucoup de petites tables qui doivent être jointes constamment pour des écrans usuels. La base peut retourner des résultats corrects, mais les lectures courantes deviennent plus lentes et plus complexes car chaque requête nécessite plusieurs jointures.

Un symptôme typique en phase initiale : une page « simple » (comme l'historique des commandes) nécessite de joindre 6–10 tables, et la performance varie selon le trafic et la chaleur du cache.

Approche pratique : normaliser les faits centraux, dénormaliser les lectures chaudes

Un équilibre sensé :

- Normaliser les faits centraux et la propriété (source de vérité). Gardez les attributs produits dans

products, les noms de catégorie danscategories, et les relations via des clés étrangères. - Dénormaliser avec prudence pour les lectures les plus chaudes — mais seulement quand vous pouvez expliquer le bénéfice et comment maintenir la cohérence.

Dénormaliser signifie dupliquer intentionnellement un petit morceau de données pour rendre une requête fréquente moins coûteuse (moins de jointures, listes plus rapides). Le mot clé est prudence : chaque champ dupliqué nécessite un plan pour rester à jour.

Exemple : produits, catégories et lignes de commande

Une configuration normalisée pourrait ressembler à :

products(id, name, price, category_id)categories(id, name)orders(id, customer_id, created_at)order_items(id, order_id, product_id, quantity, unit_price_at_purchase)

Remarquez le gain subtil : order_items stocke unit_price_at_purchase (une forme de dénormalisation) car vous avez besoin d'exactitude historique même si le prix du produit change plus tard. Cette duplication est intentionnelle et stable.

Si votre écran le plus courant est « commandes avec récapitulatifs d'articles », vous pourriez aussi dénormaliser product_name dans order_items pour éviter de joindre products sur chaque liste — mais seulement si vous êtes prêt à le tenir à jour (ou accepter que ce soit un snapshot au moment de l'achat).

La stratégie d'index suit le schéma, pas l'inverse

Les index sont souvent traités comme un bouton magique « accélérer », mais ils ne fonctionnent bien que lorsque la structure de la table a du sens. Si vous renommez encore des colonnes, scindez des tables ou changez la manière dont les enregistrements se relient, votre jeu d'index tournera aussi. Les index fonctionnent mieux quand les colonnes (et la façon dont l'app filtre/trie dessus) sont suffisamment stables pour que vous ne les reconstruiiez pas chaque semaine.

Commencez par les questions que votre appli pose le plus

Vous n'avez pas besoin d'une prédiction parfaite, mais d'une courte liste des requêtes qui comptent le plus :

- « Trouver un utilisateur par email. »

- « Montrer les commandes récentes d'un client. »

- « Lister les factures par statut, du plus récent au plus ancien. »

Ces déclarations se traduisent directement en colonnes qui méritent un index. Si vous ne pouvez pas les énoncer clairement, c'est généralement un problème de clarté du schéma — pas d'indexation.

Index composites, expliqué simplement

Un index composite couvre plusieurs colonnes. L'ordre des colonnes compte parce que la base peut utiliser l'index efficacement de gauche à droite.

Par exemple, si vous filtrez souvent par customer_id puis triez par created_at, un index sur (customer_id, created_at) est typiquement utile. L'inverse (created_at, customer_id) peut ne pas aider la même requête autant.

N'indexez pas tout

Chaque index supplémentaire a un coût :

- Écritures plus lentes : les inserts/updates doivent mettre à jour chaque index.

- Plus de stockage : les index peuvent représenter une grande part de la taille de la base.

- Plus de complexité : des index en trop rendent la maintenance et l'optimisation plus difficiles.

Un schéma propre et cohérent réduit la liste « juste » d'index à un petit ensemble qui correspond aux vrais patterns d'accès — sans payer une taxe constante en écritures et stockage.

Performance des écritures : le coût caché d'un schéma désordonné

Travaillez avec toute votre équipe

Choisissez un plan adapté, du solo aux équipes professionnelles et d'entreprise.

Les applications lentes ne sont pas toujours ralenties par les lectures. Beaucoup de problèmes de performance précoces apparaissent lors des inserts et updates — inscriptions utilisateurs, paiements, jobs en arrière-plan — parce qu'un schéma désordonné multiplie le travail de chaque écriture.

Pourquoi les écritures deviennent chères

Quelques choix de schéma multiplient discrètement le coût de chaque changement :

- Lignes larges : bourrer des dizaines (ou centaines) de colonnes dans une table signifie souvent des lignes plus volumineuses, plus d'I/O et plus de churn de cache — même si la plupart des colonnes sont rarement utilisées.

- Trop d'index : les index accélèrent les lectures, mais chaque insert/update doit aussi mettre à jour chaque index.

- Triggers et cascades : les triggers peuvent cacher du travail (inserts/updates supplémentaires) derrière un simple

INSERT. Les cascades de clés étrangères peuvent être correctes et utiles, mais elles ajoutent du travail au temps d'écriture qui grandit avec les données liées.

Read-heavy vs write-heavy : choisissez votre douleur délibérément

Si votre charge est lecture-intensive (feeds, pages de recherche), vous pouvez tolérer plus d'indexation et parfois de la dénormalisation sélective. Si elle est écriture-intensive (ingestion d'événements, télémetrie, commandes à haut volume), priorisez un schéma qui garde les écritures simples et prévisibles, puis ajoutez des optimisations de lecture uniquement là où nécessaire.

Patterns précoces qui nuisent aux écritures

- Journaux d'audit : utiles pour la conformité, mais évitez de logger de gros snapshots à chaque mise à jour.

- Tables d'événements : append-only, elles montent bien en charge, mais peuvent devenir volumineuses si vous stockez des payloads redondants.

- Soft deletes : pratiques, mais augmentent la taille des index et peuvent ralentir updates et requêtes si mal planifiés.

Garder les écritures simples tout en conservant l'historique

Approche pratique :

- Stockez l'« état courant » dans une table, et l'historique dans une table append-only séparée.

- Gardez les lignes d'historique étroites (seulement ce dont vous avez vraiment besoin : qui/quand/quoi a changé).

- Ajoutez des index à l'historique selon les vrais patterns d'accès (habituellement

entity_id,created_at). - Évitez les triggers pour l'audit au départ ; préférez des écritures explicites côté application pour que le coût soit visible et testable.

Des chemins d'écriture propres vous donnent de la marge — et facilitent beaucoup l'optimisation des requêtes plus tard.

Comment les ORM et les API amplifient les décisions de schéma

Les ORM rendent le travail avec la base de données facile : vous définissez des modèles, appelez des méthodes, et les données apparaissent. Le piège est qu'un ORM peut aussi masquer des SQL coûteux jusqu'à ce que cela fâche.

ORM : une commodité qui peut masquer des patterns lents

Deux pièges fréquents :

- Jointures inefficaces : un

.include()apparemment simple ou un sérialiseur imbriqué peut se traduire par des jointures larges, des lignes dupliquées ou de grands tris — surtout si les relations ne sont pas clairement définies. - N+1 queries : vous récupérez 50 enregistrements, puis l'ORM lance discrètement 50 requêtes de plus pour charger les données liées. Ça marche en développement et s'effondre sous la vraie charge.

Un schéma bien conçu réduit la probabilité d'apparition de ces patterns et les rend plus faciles à détecter quand ils surviennent.

Des relations claires rendent l'usage des ORM plus sûr

Quand les tables ont des clés étrangères, des contraintes d'unicité et des NOT NULL, l'ORM peut générer des requêtes plus sûres et votre code peut se reposer sur des hypothèses cohérentes.

Par exemple, imposer que orders.user_id existe (FK) et que users.email est unique évite toute une classe de cas limites qui sinon se transforment en vérifications applicatives et en travail de requête supplémentaire.

Les API transforment les choix de schéma en comportements produit

Votre conception d'API découle du schéma :

- Des IDs stables (et des types de clés cohérents) simplifient les URLs, le caching et l'état côté client.

- La pagination fonctionne mieux quand vous pouvez ordonner par une colonne monotone indexée (souvent

created_at+id). - Le filtrage devient prévisible lorsque les colonnes représentent de vrais attributs (pas des chaînes surchargées ou des blobs JSON) et que les contraintes gardent les valeurs propres.

Faites-en un workflow, pas une mission de sauvetage

Traitez les décisions de schéma comme de l'ingénierie à part entière :

- Utilisez des migrations pour chaque changement, revues comme du code (/blog/migrations).

- Ajoutez de légères « revues de schéma » pour les nouveaux endpoints : quelles tables, quelles clés, quelles contraintes, quelle forme de requête.

- En staging, loggez les requêtes ORM et signalez les patterns N+1 avant la production (/blog/orm-performance-checks).

Si vous construisez vite avec un workflow conversationnel (par ex. génération d'une app React + backend Go/PostgreSQL avec Koder.ai), ça aide de faire de la « revue de schéma » une partie de la conversation tôt. Vous pouvez itérer vite, tout en gardant contraintes, clés et plan de migration délibérés — surtout avant l'arrivée du trafic.

Signes avant-coureurs que votre schéma est le goulot d'étranglement

Certaines problématiques de performance ne sont pas du « mauvais SQL » mais la base qui lutte contre la forme de vos données. Si vous voyez les mêmes problèmes sur de nombreux endpoints et rapports, c'est souvent un signal de schéma, pas une opportunité de réglage de requête.

Symptômes courants à surveiller

Les filtres lents sont un indicateur classique. Si des conditions simples comme « trouver les commandes d'un client » ou « filtrer par date de création » sont systématiquement lentes, le problème peut être l'absence de relations, des types mal assortis ou des colonnes qu'on ne peut pas indexer efficacement.

Un autre signal est l'explosion du nombre de jointures : une requête qui devrait joindre 2–3 tables enchaîne 6–10 tables juste pour répondre à une question basique (souvent à cause de lookups sur-normalisés, de patterns polymorphes ou d'un design « tout dans une table »).

Surveillez aussi les valeurs incohérentes dans des colonnes qui se comportent comme des enums — surtout les champs de statut (« active », « ACTIVE », « enabled », « on »). L'incohérence force des requêtes défensives (LOWER(), COALESCE(), chaînes d'OR) qui restent lentes malgré tout l'optimisation.

Checklist de schéma (vérifiable rapidement)

- Index manquants sur les clés étrangères (les jointures deviennent des scans complets à mesure que les tables grandissent).

- Types de données erronés (ex. IDs stockés en chaînes, dates stockées en texte, argent en float).

- Tables EAV (Entity–Attribute–Value) utilisées pour des données centrales : flexibles au départ, mais les filtres/tris deviennent des dizaines de jointures et des prédicats difficiles à indexer.

Diagnostics simples et indépendants d'outil

Commencez par des vérifications de réalité : nombre de lignes par table et cardinalité des colonnes clés (combien de valeurs distinctes). Si une colonne « status » devrait avoir 4 valeurs et que vous en trouvez 40, le schéma fuit déjà de la complexité.

Ensuite, regardez les plans d'exécution pour vos endpoints lents. Si vous voyez à répétition des sequential scans sur des colonnes de jointure ou de grands ensembles intermédiaires, le schéma et l'indexation sont probablement la cause.

Enfin, activez et examinez les logs de requêtes lentes. Quand de nombreuses requêtes différentes sont lentes de manière similaire (mêmes tables, mêmes prédicats), c'est généralement un problème structurel à corriger au niveau du modèle.

Faire évoluer le schéma en sécurité à mesure que vous grandissez

Concevez votre schéma dans le chat

Transformez entités, clés et contraintes en schéma PostgreSQL au fur et à mesure.

Les choix de schéma initiaux survivent rarement au premier contact avec de vrais utilisateurs. L'objectif n'est pas de « le faire parfaitement » — c'est de le changer sans casser la prod, perdre des données ou paralyser l'équipe pendant une semaine.

Un processus léger et répétable de changement

Un workflow pratique qui évolue d'une app mono-développeur à une équipe plus grande :

- Modéliser : écrivez la nouvelle forme (tables/colonnes, relations, et ce qui devient la source de vérité). Incluez des exemples d'enregistrements et des cas limites.

- Migrer : ajoutez les nouvelles structures de façon rétrocompatible (nouvelles colonnes/tables d'abord ; évitez de supprimer ou renommer immédiatement).

- Backfill : remplissez les nouveaux champs depuis les données existantes par lots. Suivez la progression pour pouvoir reprendre.

- Valider : n'ajoutez les contraintes qu'après nettoyage des données (ex. NOT NULL, clés étrangères). Exécutez des checks qui comparent les anciens et nouveaux résultats.

Feature flags et double-écriture (à utiliser avec parcimonie)

La plupart des changements de schéma n'ont pas besoin de patterns de déploiement complexes. Privilégiez « expand-and-contract » : code qui sait lire l'ancien et le nouveau, puis basculez les écritures quand vous êtes confiant.

Utilisez les feature flags ou la double-écriture seulement quand vous avez vraiment besoin d'une coupure progressive (trafic élevé, backfills longs, ou plusieurs services). Si vous double-écrivez, ajoutez du monitoring pour détecter les dérives et définissez quelle source prévaut en cas de conflit.

Rollbacks et tests de migration qui reflètent la réalité

Les rollbacks sûrs commencent par des migrations réversibles. Entraînez-vous sur le chemin d'annulation : supprimer une colonne est facile ; récupérer des données écrasées ne l'est pas.

Testez les migrations sur des volumes de données réalistes. Une migration qui prend 2 secondes sur un portable peut verrouiller des tables pendant des minutes en production. Utilisez des comptages de lignes et des index proches de la réalité et mesurez le temps d'exécution.

C'est là que les outils de plateforme réduisent le risque : disposer de déploiements fiables, snapshots/rollback (et la capacité d'exporter votre code si besoin) rend l'itération sur le schéma et la logique applicative plus sûre. Si vous utilisez Koder.ai, appuyez-vous sur les snapshots et le mode planning avant d'introduire des migrations qui nécessitent un séquençage soigné.

Documenter les décisions pour la personne suivante (y compris vous)

Tenez un court journal de schéma : ce qui a changé, pourquoi, et quels compromis ont été acceptés. Liez-le depuis /docs ou le README du repo. Incluez des notes comme « cette colonne est dénormalisée intentionnellement » ou « clé étrangère ajoutée après backfill le 2025-01-10 » pour que les changements futurs n'aient pas à répéter d'anciennes erreurs.

Quand optimiser les requêtes (et un ordre d'opérations sensé)

L'optimisation des requêtes compte — mais elle paie surtout quand votre schéma ne vous combat pas. Si les tables n'ont pas de clés claires, les relations sont incohérentes, ou la règle « une ligne = une chose » est violée, vous pouvez passer des heures à optimiser des requêtes qui seront réécrites la semaine suivante.

Un ordre pratique de priorités

-

Corrigez d'abord les blocages de schéma. Commencez par tout ce qui rend difficile l'interrogation correcte : clés primaires manquantes, clés étrangères incohérentes, colonnes aux sens multiples, source de vérité dupliquée, ou types non adaptés (ex. dates stockées en chaînes).

-

Stabilisez les patterns d'accès. Une fois que le modèle reflète le comportement de l'app (et ce qu'il sera probablement pour les prochains sprints), l'optimisation devient durable.

-

Optimisez les requêtes principales — pas toutes. Utilisez les logs/APM pour identifier les requêtes les plus lentes et les plus fréquentes. Un endpoint appelé 10 000 fois par jour l'emporte souvent sur un rapport d'admin rare.

Le 80/20 de l'optimisation précoce des requêtes

La plupart des gains précoces viennent d'un petit ensemble de mesures :

- Ajouter le bon index pour vos filtres et jointures les plus courants (et vérifier qu'il est bien utilisé).

- Retourner moins de colonnes (évitez

SELECT *, surtout sur des tables larges). - Éviter les jointures inutiles — parfois une jointure existe uniquement parce que le schéma vous force à « découvrir » des attributs de base.

Fixer les attentes : c'est un travail continu, mais les fondations d'abord

Le travail de performance ne s'arrête jamais, mais l'objectif est de le rendre prévisible. Avec un schéma propre, chaque nouvelle fonctionnalité ajoute une charge incrémentale ; avec un schéma désordonné, chaque fonctionnalité ajoute de la confusion en cascade.

Checklist pour cette semaine

- Listez les 5 requêtes les plus lentes et les 5 requêtes les plus fréquentes.

- Pour chacune, confirmez : clé primaire présente, les jointures sont clé-à-clé, et les types sont corrects.

- Ajoutez un index qui correspond au filtre/tri dominant.

- Remplacez

SELECT *sur un chemin chaud. - Re-mesurez et gardez une note simple « avant/après » pour le prochain sprint.