Définir les objectifs, les questions et les indicateurs de succès

Avant de tout suivre, décidez ce que « l’adoption d’une fonctionnalité » signifie réellement pour votre produit. Si vous sautez cette étape, vous collecterez plein de données — et continuerez à débattre en réunion de leur « signification ».

Définir “adoption” en termes simples

L’adoption n’est généralement pas un moment unique. Choisissez une ou plusieurs définitions qui correspondent à la façon dont la valeur est délivrée :

- Use : un utilisateur essaie la fonctionnalité au moins une fois (utile pour les lancements)

- Repeat use : l’utilisateur l’utilise à nouveau dans une fenêtre temporelle (utile pour les workflows qui forment une habitude)

- Value achieved : l’utilisateur atteint un résultat que la fonctionnalité est censée permettre (souvent le meilleur signal)

Exemple : pour « Saved Searches », l’adoption peut être créé une recherche sauvegardée (use), lancé 3+ fois en 14 jours (repeat), et reçu une alerte puis cliqué (value achieved).

Lister les décisions que votre suivi doit soutenir

Votre tracking doit répondre à des questions qui mènent à l’action, comme :

- Que devons‑nous améliorer parce que c’est utilisé mais n’apporte pas de valeur ?

- Que devons‑nous retirer parce que ça complique le produit et a peu d’adoption ?

- Que devons‑nous promouvoir parce que cela augmente la rétention ou les upgrades ?

Formulez ces points comme des énoncés de décision (par ex. « Si l’activation chute après la release X, nous annulons les changements d’onboarding. »).

Identifier les parties prenantes et l’usage des rapports

Différentes équipes ont besoin de vues différentes :

- Produit (PM) : adoption par segment, impact post‑release, jalons de valeur

- Growth/Marketing : lift de campagne, entonnoirs de conversion, ré‑engagement

- Support/Success : quelles fonctionnalités corrèlent avec moins de tickets ou plus de renouvellements

- Engineering : santé de l’instrumentation, variations de volume d’événements, marqueurs de release

Fixer des métriques de succès et une cadence

Choisissez un petit ensemble de métriques à revoir hebdomadairement, plus un contrôle léger après chaque déploiement. Définissez des seuils (ex. « Taux d’adoption ≥ 25 % parmi les utilisateurs actifs sur 30 jours ») pour que le reporting stimule des décisions, pas des débats.

Cartographier les données nécessaires : utilisateurs, fonctionnalités, événements, résultats

Avant d’instrumenter quoi que ce soit, décidez quelles “choses” votre système d’analytics doit décrire. Si vous définissez bien ces entités, vos rapports restent compréhensibles même si le produit évolue.

Commencez par les entités de base

Définissez chaque entité en langage clair, puis traduisez‑la en IDs que vous pouvez stocker :

- User : une personne qui utilise l’app (peut commencer anonyme, puis authentifiée)

- Account / workspace : le client payant ou le conteneur d’équipe auquel appartiennent plusieurs utilisateurs

- Session : une visite bornée dans le temps (utile pour l’engagement et le troubleshooting; optionnelle selon le produit)

- Feature : une capacité nommée pour laquelle vous voulez mesurer l’adoption (souvent un groupe d’événements, pas un seul clic)

- Event : une action ou un événement système que vous pouvez enregistrer (ex.

project_created, invite_sent)

- Outcome : le jalon de valeur que vous voulez que les utilisateurs/comptes atteignent (ex. « premier rapport partagé », « abonnement activé »)

Notez les propriétés minimales dont vous avez besoin pour chaque événement : user_id (ou anonymous ID), account_id, timestamp, et quelques attributs pertinents (plan, rôle, appareil, feature flag, etc.). Évitez de tout « dump er » “au cas où”.

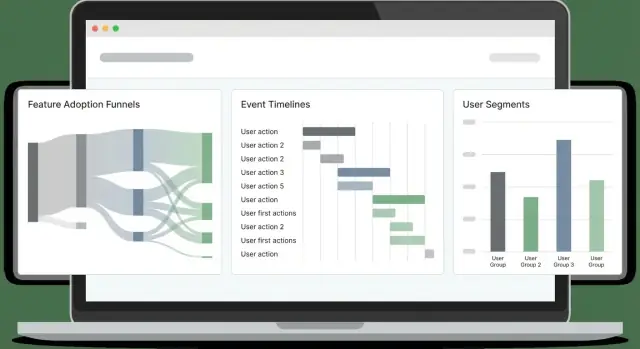

Choisir les vues d’adoption à supporter

Sélectionnez les angles de reporting qui correspondent à vos objectifs produit :

- Funnels (activation pas à pas)

- Cohorts (groupes par date d'inscription, plan, canal)

- Rétention (reviennent‑ils et répètent‑ils les actions clés ?)

- Paths (séquences communes avant/après un jalon)

- Time‑to‑first‑value (combien de temps jusqu’au premier résultat significatif)

Votre conception d’événements doit rendre ces calculs simples.

Soyez explicite sur la portée : web seulement d’abord, ou web + mobile dès le départ. Le suivi cross‑plateforme est plus simple si vous standardisez les noms d’événements et les propriétés tôt.

Enfin, définissez des cibles non négociables : impact acceptable sur la performance des pages, latence d’ingestion (à quel point les dashboards doivent être frais) et temps de chargement des dashboards. Ces contraintes orienteront les choix ultérieurs de tracking, stockage et requêtage.

Concevoir un schéma de tracking d’événements qui reste cohérent

Un bon schéma n’est pas « suivre tout », mais rendre les événements prévisibles. Si les noms et propriétés dérivent, les dashboards cassent, les analystes ne font plus confiance aux données, et les ingénieurs hésitent à instrumenter.

Commencez par une convention de nommage claire

Choisissez un motif simple et répétable et respectez‑le. Un choix courant est verb_noun :

viewed_pricing_pagestarted_trialenabled_featureexported_report

Utilisez le passé (ou le présent) de façon cohérente, et évitez les synonymes (clicked, pressed, tapped) sauf s’ils ont des sens différents.

Définir les propriétés requises (le “contrat”)

Chaque événement doit porter un petit ensemble de propriétés requises pour pouvoir segmenter, filtrer et joindre de façon fiable plus tard. Au minimum :

user_id (nullable pour les utilisateurs anonymes, mais présent quand connu)account_id (si produit B2B/multi‑seat)timestamp (généré côté serveur si possible)feature_key (identifiant stable comme "bulk_upload")plan (ex. free, pro, enterprise)

Ces propriétés rendent le suivi d’adoption et l’analytics comportemental beaucoup plus simples parce que vous n’aurez pas à deviner ce qui manque dans chaque événement.

Autoriser des propriétés optionnelles — avec modération

Les champs optionnels ajoutent du contexte, mais sont faciles à abuser. Exemples typiques :

device, os, browserpage, referrerexperiment_variant (ou ab_variant)

Gardez les propriétés optionnelles cohérentes entre événements (mêmes clés, mêmes formats de valeur) et documentez les « valeurs autorisées » quand c’est possible.

Versionner votre schéma et rédiger une spec d’instrumentation

Supposez que votre schéma va évoluer. Ajoutez un event_version (ex. 1, 2) et mettez‑le à jour quand vous changez le sens ou les champs requis.

Enfin, rédigez une spécification d’instrumentation qui liste chaque événement, quand il se déclenche, les propriétés requises/optionnelles et des exemples. Gardez ce doc dans le contrôle de version avec votre app pour que les changements de schéma soient revus comme du code.

Résoudre l’identité : vues anonymes, identifiées et au niveau du compte

Si votre modèle d’identité est instable, vos métriques d’adoption seront bruyantes : les entonnoirs ne correspondront pas, la rétention semblera pire, et les “utilisateurs actifs” seront gonflés par des duplicatas. L’objectif est de supporter trois vues en parallèle : visiteurs anonymes, utilisateurs connectés, et activité par compte/workspace.

Anonyme vs identifié (et quand lier)

Commencez chaque appareil/session avec un anonymous_id (cookie/localStorage). Au moment où un utilisateur s’authentifie, liez cet historique anonyme à un user_id identifié.

Liez les identités lorsque l’utilisateur a prouvé la propriété du compte (login réussi, vérification magic link, SSO). Évitez de lier sur des signaux faibles (email saisi dans un formulaire) sauf si vous le séparez clairement comme “pré‑auth”.

Login, logout et changement de compte sans casser les métriques

Traitez les transitions d’auth comme des événements :

login_success (inclut user_id, account_id et l’actuel anonymous_id)logoutaccount_switched (de account_id → account_id)

Important : ne changez pas le cookie anonyme au logout. Si vous le rotatiez, vous fragmenteriez les sessions et gonfleriez les utilisateurs uniques. Gardez le anonymous_id stable, mais cessez d’attacher user_id après le logout.

Règles de fusion d’identités (et éviter le double comptage)

Définissez explicitement les règles de fusion :

- User merge : préférez un

user_id interne stable. Si vous devez fusionner par email, faites‑le côté serveur et uniquement pour des emails vérifiés. Conservez une trace d’audit.

- Account merge : utilisez un

account_id/workspace_id stable généré par votre système, pas un nom mutable.

Lors de la fusion, écrivez une table de mapping (ancien → nouveau) et appliquez‑la systématiquement au moment de la requête ou via un job de backfill. Cela évite que « deux utilisateurs » apparaissent dans des cohortes.

Stocker des clés stables

Stockez et envoyez :

anonymous_id (stable par navigateur/appareil)user_id (stable par personne)account_id (stable par workspace)

Avec ces trois clés, vous pouvez mesurer le comportement avant login, l’adoption par utilisateur et l’adoption par compte sans double comptage.

Choisir tracking côté client vs côté serveur (et les combiner)

Où vous suivez les événements change ce que vous pouvez considérer comme fiable. Les événements navigateur vous disent ce que les gens ont tenté de faire ; les événements serveur indiquent ce qui s’est réellement produit.

Tracking côté client (navigateur)

Utilisez le tracking client pour les interactions UI et le contexte que vous n’avez qu’en navigateur. Exemples typiques :

- Vues de page/écran, clics de bouton, changements d’onglet, ouverture/fermeture de modaux

- « Vu une fonctionnalité » (ex. page de paramètres ouverte)

- Contexte client : URL, referrer, UTMs, type d’appareil, taille de viewport, langue

Batcher les événements pour réduire le trafic réseau : mettez en file en mémoire, envoyez toutes les N secondes ou à N événements, et flush aussi sur visibilitychange/cachet de page.

Tracking côté serveur (APIs et jobs)

Utilisez le tracking serveur pour tout événement représentant un résultat complété ou sensible à la facturation/sécurité :

- Fonctionnalité activée/désactivée sauvegardée avec succès

- Invitation acceptée, paiement réussi, export généré

- Jobs background : sync terminé, rapport délivré, email envoyé

Le tracking serveur est souvent plus précis car n’est pas bloqué par les bloqueurs de pubs, les reloads ou la connectivité instable.

Approche recommandée : hybride par défaut

Un pattern pratique : trackez l’intention côté client et le succès côté serveur.

Par exemple, émettez feature_x_clicked_enable (client) et feature_x_enabled (serveur). Ensuite, enrichissez les événements serveur avec le contexte client en passant un context_id (ou request ID) du navigateur vers l’API.

Fiabilité : retries, backoff, buffering offline

Ajoutez de la résilience là où les événements risquent le plus de disparaître :

- Client : persistez une petite file dans

localStorage/IndexedDB, réessayez avec backoff exponentiel, limitez les tentatives et dédupliquez avec event_id.

- Serveur : réessayez sur erreurs transitoires, utilisez une file interne, et assurez l’idempotence pour qu’un retry ne double pas le comptage.

Ce mélange vous donne du détail comportemental riche sans sacrifier des métriques d’adoption fiables.

Planifier l’architecture système : ingestion, stockage et requêtage

Réduisez vos coûts de développement

Obtenez des crédits en partageant ce que vous avez construit avec Koder.ai ou en recommandant des collègues.

Une app d’analytics d’adoption de fonctionnalités est surtout un pipeline : capter les événements de façon fiable, les stocker à moindre coût, et les requêter assez vite pour que les gens fassent confiance aux résultats.

Composants centraux (et pourquoi ils comptent)

Commencez par un ensemble simple et séparé de services :

- Collector endpoint : un petit service HTTP qui reçoit les événements (du navigateur, mobile, backend). Gardez‑le rapide et minimal — validez l’essentiel, ajoutez un timestamp serveur et répondez vite.

- Queue/stream : tamponne les pics de trafic et découple l’ingestion du traitement (Kafka, Kinesis, Pub/Sub, SQS).

- Workers : consomment le stream pour enrichir, dédupliquer, appliquer le schéma et router les données vers le stockage.

- Analytics store : optimisé pour des données d’événements append‑only volumineuses (ClickHouse, BigQuery, Snowflake, Redshift).

- API : expose des endpoints de requête cohérents pour les dashboards (entonnoirs, cohortes, rétention) et la gestion des permissions.

- UI : dashboards et outils d’exploration ; gardez‑la séparée pour pouvoir changer la logique de stockage/requête sans réécrire le frontend.

Si vous voulez prototyper rapidement une app d’analytics interne, une plateforme vibe‑coding comme Koder.ai peut vous aider à monter l’UI du dashboard (React) et un backend (Go + PostgreSQL) à partir d’un spec piloté par chat — utile pour obtenir une tranche fonctionnelle avant d’affermir le pipeline.

Stockage : événements bruts vs agrégats

Utilisez deux couches :

- Événements append‑only bruts pour l’auditabilité et le reprocessing. Considérez‑les comme la source de vérité.

- Agrégats/vues matérialisées pour la rapidité (DAU par fonctionnalité, étapes d’entonnoir, tables de cohortes). Les vues matérialisées sont particulièrement utiles quand les mêmes requêtes tournent constamment.

Temps réel vs batch (choisissez selon les décisions)

Adaptez la fraîcheur aux besoins réels de l’équipe :

- Near real‑time (secondes/minutes) si vous surveillez des lancements, des abandons d’onboarding ou des incidents.

- Batch journalier pour le reporting de tendance, l’adoption hebdomadaire et les résumés exécutifs — moins cher et souvent plus simple.

Beaucoup d’équipes font les deux : compteurs temps‑réel pour « ce qui se passe maintenant », plus jobs nocturnes qui recomputent les métriques canoniques.

Plan de montée en charge : partitionnement et croissance

Concevez pour la croissance tôt en partitionnant :

- Par temps (quotidien/mensuel) pour garder les requêtes bornées et les politiques de rétention simples

- Par compte/tenant pour supporter les permissions B2B et la performance

- Optionnellement par type d’événement si quelques événements à fort volume dominent

Planifiez aussi la rétention (ex. 13 mois pour les bruts, agrégats plus longs) et une voie de replay pour corriger des bugs en reprocessant les événements plutôt qu’en patchant les dashboards.

Modélisation des données pour les événements et les requêtes analytiques rapides

Une bonne analytics commence par un modèle qui répond aux questions courantes rapidement (entonnoirs, rétention, usage de fonctionnalités) sans transformer chaque requête en projet d’ingénierie.

Choisir une stratégie base de données à deux niveaux

La plupart des équipes s’en sortent mieux avec deux stores :

- Relational DB (Postgres/MySQL) pour les métadonnées « stables » qui changent lentement : users, accounts, définitions de features, ACLs, configuration.

- Columnar/warehouse (ClickHouse/BigQuery/Snowflake) pour les événements à fort volume, où il faut des scans et agrégations rapides.

Cette séparation maintient la base produit légère tout en rendant les requêtes analytiques plus rapides et moins coûteuses.

Définir les tables de base (et les garder simples)

Baseline pratique :

- raw_events : une ligne par événement (event_name, timestamp, user_id/anonymous_id, session_id, account_id, properties JSON, source)

- users : profil utilisateur + identifiants courants

- accounts : entité entreprise/organisation pour les rollups B2B

- feature_catalog : liste canonique des fonctionnalités (key, display_name, category, lifecycle status)

- sessions : bornes de session (start/end, device, referrer) pour l’analyse comportementale

- aggregates : métriques pré‑calculées quotidiennes/hebdo (ex. DAU, feature_active_users, compteurs d’étapes d’entonnoir)

Dans l’entrepôt, dénormalisez ce que vous requêtez souvent (ex. copier account_id sur les événements) pour éviter des joins coûteux.

Contrôler coûts et vitesse avec rétention + partitionnement

Partitionnez raw_events par temps (quotidien est courant) et éventuellement par workspace/app. Appliquez la rétention par type d’événement :

- Conservez les événements produit importants plus longtemps (mois/années).

- Expirez rapidement les événements de debug bruyants.

Cela empêche la « croissance infinie » de devenir votre plus gros problème analytique.

Intégrer des contrôles qualité dans le modèle

Considérez les checks qualité comme partie intégrante de la modélisation, pas un nettoyage ultérieur :

- Propriétés requises manquantes (ex. feature_key)

- Timestamps invalides (dates futures, problèmes de parsing de timezone)

- Événements dupliqués (retries, instrumentation double)

Stockez les résultats de validation (ou une table d’événements rejetés) pour surveiller la santé de l’instrumentation et corriger les problèmes avant que les dashboards ne dérivent.

Calculer les métriques d’adoption : entonnoirs, cohortes, rétention et chemins

Passez de la spécification au déploiement

Déployez et hébergez rapidement votre application web analytique, puis itérez au fur et à mesure que les équipes l'utilisent.

Une fois les événements en flux, transformez les clics bruts en métriques qui répondent : « Cette fonctionnalité est‑elle réellement adoptée, et par qui ? » Concentrez‑vous sur quatre vues complémentaires : entonnoirs, cohortes, rétention et chemins.

Entonnoirs : l’adoption comme une séquence (pas un seul clic)

Définissez un entonnoir par fonctionnalité pour voir où les utilisateurs abandonnent. Pattern pratique :

- Discovery → l’utilisateur voit le point d’entrée de la fonctionnalité (bouton, menu, banner)

- First use → la première interaction significative (ex.

feature_used)

- Repeat use → une seconde utilisation dans une fenêtre raisonnable (ex. 7 jours)

- Value action → le résultat qui prouve la valeur (export créé, automation activée, rapport partagé)

Garder les étapes d’entonnoir liées à des événements fiables et nommées de façon cohérente. Si la « première utilisation » peut se produire de plusieurs manières, traitez‑la comme une étape avec des conditions OR (ex. import_started OR integration_connected).

Cohortes : comparer ce qui est comparable

Les cohortes vous aident à mesurer l’amélioration dans le temps sans mélanger anciens et nouveaux utilisateurs. Cohortes communes :

- Nouveaux utilisateurs par semaine (semaine d’inscription)

- Utilisateurs activés (ayant atteint l’événement d’activation)

- Utilisateurs retenus (sont revenus et ont fait quelque chose de significatif)

- Power users (fréquence élevée ou actions avancées)

Suivez les taux d’adoption par cohorte pour voir si l’onboarding récent ou les changements UI aident.

Rétention : « reviennent‑ils et continuent‑ils à l’utiliser ? »

La rétention est la plus utile quand elle est liée à une fonctionnalité, pas juste aux “ouvertures d’app”. Définissez‑la comme la répétition de l’événement cœur de la fonctionnalité (ou l’action de valeur) au Jour 7/30. Suivez aussi le « temps jusqu’à la seconde utilisation » — souvent plus sensible que la rétention brute.

Découpez les métriques par dimensions explicatives : plan, rôle, industrie, appareil, canal d’acquisition. Les segments révèlent souvent qu’une fonctionnalité est forte pour un groupe et quasi inexistante pour un autre.

Ajoutez une analyse de chemins pour trouver les séquences communes avant et après l’adoption (ex. adopteurs visitent souvent pricing, puis docs, puis connectent une intégration). Servez‑vous‑en pour affiner l’onboarding et supprimer les impasses.

Construire des dashboards que les gens utiliseront vraiment

Les dashboards échouent quand ils essaient de servir tout le monde avec une vue « master ». Concevrez plutôt un petit ensemble de pages focalisées qui correspondent aux décisions des différentes personnes, et faites en sorte que chaque page réponde à une question claire.

Commencez par des pages spécifiques aux audiences

Un overview pour un dirigeant doit être un contrôle santé rapide : tendance d’adoption, utilisateurs actifs, fonctionnalités principales et changements notables depuis la dernière release. Une analyse approfondie d’une fonctionnalité doit servir PMs et ingés : où les utilisateurs commencent, où ils abandonnent et quels segments se comportent différemment.

Structure simple efficace :

- Overview : tendance d’adoption, tendance de rétention, quelques KPI clés

- Feature page : entonnoir, rétention par cohorte et fréquence d’utilisation pour une fonctionnalité

- Segment explorer : comparer plans, régions ou tailles de workspace côte‑à‑côte

Faciliter l’exploration (sans la rendre chaotique)

Incluez des graphiques de tendance pour le « quoi », des découpages par segment pour le « qui », et du drill‑down pour le « pourquoi ». Le drill‑down doit permettre de cliquer sur une barre/point et voir des utilisateurs ou workspaces exemples (avec permissions appropriées), afin que les équipes puissent valider des patterns et investiguer de vraies sessions.

Gardez les filtres cohérents entre pages pour éviter que les utilisateurs réapprennent les contrôles. Filtres les plus utiles pour le suivi d’adoption : plage de dates, plan/tiers, attributs du workspace (taille, industrie), région, version de l’app (ou canal de release).

Partage, exports et vues sauvegardées

Les dashboards font partie des workflows quand on peut partager exactement ce qu’on voit. Ajoutez :

- Export en CSV pour analyses rapides en tableur

- Share avec une vue sauvegardée (filtres + état des graphiques + segment sélectionné)

- Résumés programmés par email/Slack qui pointent vers la vue sauvegardée

Si vous construisez ceci dans une app d’analytics produit, pensez à une page /dashboards avec des vues « Épinglées » pour que les parties prenantes atterrissent toujours sur les quelques rapports qui comptent.

Ajouter alertes, détection d’anomalies et marqueurs de release

Les dashboards servent à l’exploration, mais les équipes remarquent souvent les problèmes quand un client se plaint. Les alertes inversent la logique : vous apprenez d’une panne quelques minutes après qu’elle survienne, et vous pouvez la rattacher à ce qui a changé.

Définir des règles d’alerte correspondant aux vrais modes de défaillance

Commencez par quelques alertes à fort signal qui protègent votre flux d’adoption central :

- Baisse soudaine de la première utilisation (ex. les events “Feature X: first_use” par heure en baisse de 40 % vs baseline). Indique souvent une régression UI, un changement de permissions ou un bug d’instrumentation.

- Pic d’erreurs (erreurs client, 4xx/5xx API, ou événements

feature_failed). Incluez des seuils absolus et des seuils relatifs (erreurs par 1 000 sessions).

- Événements manquants après une release (compte d’événements proche de zéro). Cela détecte l’instrumentation cassée rapidement — surtout après des refactors.

Gardez les définitions d’alerte lisibles et versionnées (même un YAML simple dans le repo) pour qu’elles ne deviennent pas du savoir tacite.

Détection d’anomalies : commencer simple

Une détection d’anomalie basique peut être très efficace sans ML sophistiqué :

- Comparez les valeurs actuelles à une moyenne glissante (ex. 7 derniers jours, même heure du jour)

- Ajoutez une prise en compte de la saisonnalité quand c’est pertinent (semaine vs weekend, heures ouvrables vs nuit)

- Utilisez une règle de volume minimum pour éviter les spams sur métriques à faible trafic

Marqueurs de release : une timeline de « qu’est‑ce qui a changé ? »

Ajoutez un flux de marqueurs de release directement dans les graphiques : déploiements, rollouts de feature flags, changements de pricing, modifications d’onboarding. Chaque marqueur doit inclure un timestamp, un propriétaire et une courte note. Quand les métriques bougent, vous verrez immédiatement les causes probables.

Routage, heures calmes et responsabilité

Envoyez les alertes par email et vers des canaux type Slack, mais supportez les heures calmes et l’escalade (warning → page) pour les incidents graves. Chaque alerte doit avoir un propriétaire et un lien vers un runbook (même court, ex. /docs/alerts) décrivant les premières vérifications.

Confidentialité, consentement et contrôle d’accès

Conservez la pleine propriété du code

Générez, révisez et exportez le code source pour que votre équipe puisse maîtriser la pipeline sur le long terme.

Les données analytiques deviennent vite des données personnelles si vous n’y prenez pas garde. Traitez la confidentialité comme partie intégrante de la conception du tracking, pas comme un ajout juridique après coup : ça réduit les risques, renforce la confiance et évite des révisions coûteuses.

Consentement : ne collecter que ce que les utilisateurs acceptent

Respectez les règles de consentement et permettez aux utilisateurs de se désactiver. Concrètement, votre couche de tracking doit vérifier un drapeau de consentement avant d’envoyer les événements, et pouvoir arrêter le suivi en cours de session si l’utilisateur change d’avis.

Pour les régions à règles strictes, pensez des fonctionnalités « consent‑gated » :

- Charger les librairies analytics seulement après consentement (pas seulement arrêter l’envoi)

- Stocker la décision de consentement avec un timestamp et une version pour prouver ce que l’utilisateur a accepté

- Fournir une UI de préférences simple dans les paramètres

Minimiser les données sensibles (et les exclure des événements)

Minimisez les données sensibles : évitez les emails en clair dans les événements ; utilisez des IDs hachés/opaques. Les payloads d’événements doivent décrire le comportement (ce qui s’est passé), pas l’identité (qui est la personne). Si vous devez relier des événements à un compte, envoyez un user_id/account_id interne et conservez le mapping dans votre DB avec des contrôles de sécurité appropriés.

Évitez aussi :

- Les champs texte libre (contiennent souvent des infos personnelles accidentelles)

- Les URLs complètes pouvant inclure tokens ou query params

- Tout ce que vous ne voudriez pas voir dans une capture d’écran

Transparence : documentation et page de confidentialité claire

Documentez ce que vous collectez et pourquoi ; pointez vers une page de confidentialité claire. Créez un « dictionnaire de tracking » léger qui explique chaque événement, son but et sa durée de rétention. Dans l’UI produit, liez vers /privacy et gardez le texte lisible : ce que vous collectez, ce que vous ne collectez pas et comment se désinscrire.

Contrôle d’accès : limiter qui voit les données au niveau utilisateur

Mettez en place un contrôle par rôles pour que seules les équipes autorisées puissent voir les données au niveau utilisateur. La plupart des gens n’ont besoin que des dashboards agrégés ; réservez les vues d’événements bruts à un petit groupe (ex. data/product ops). Ajoutez des logs d’audit pour les exports et recherches utilisateur, et appliquez des limites de rétention pour que les anciennes données expirent automatiquement.

Bien faits, les contrôles de confidentialité ne ralentiront pas l’analyse — ils rendront votre système plus sûr, plus clair et plus facile à maintenir.

Plan de déploiement, QA et maintenance à long terme

Livrer l’analytics ressemble à la livraison d’une fonctionnalité : commencez par une petite release vérifiable, puis itérez. Traitez le travail de tracking comme du code de production avec des propriétaires, des reviews et des tests.

Commencer petit avec les “golden events”

Démarrez avec un ensemble restreint de golden events pour une zone fonctionnelle (par ex. Feature Viewed, Feature Started, Feature Completed, Feature Error). Ils doivent se mapper directement aux questions que l’équipe posera chaque semaine.

Limitez volontairement la portée : moins d’événements signifie que vous pouvez valider la qualité rapidement et apprendre quelles propriétés sont réellement nécessaires avant d’étendre.

Valider le tracking en staging et production

Utilisez une checklist avant de déclarer le tracking « done » :

- L’événement se déclenche une fois (pas de double‑tracking sur refresh, retries ou changements de route SPA)

- Propriétés requises présentes et typées de façon cohérente

- PII exclue ou masquée correctement

- Événements reçus dans la latence attendue

- Identités liées correctement (anonymous → logged‑in)

Ajoutez des requêtes d’exemple à exécuter en staging et prod. Exemples :

- « Compter les événements par nom sur les 30 dernières minutes » (repérer événements manquants/extra)

- « Top 20 des valeurs de propriété pour

feature_name » (attraper les fautes comme Search vs search)

- « Taux de complétion = Completed / Started par version d’app » (détecter régressions de release)

Workflow QA d’instrumentation pour chaque release

Intégrez l’instrumentation au process de release :

- Changement de tracking dans le même PR que le changement UI/API

- Le relecteur vérifie noms/propriétés contre votre schéma

- QA vérifie les événements en staging avec un compte de test connu

- La note de release inclut les changements de tracking (nouveaux événements, renommage de propriétés)

Maintenance long terme (schéma, backfills, docs)

Planifiez le changement : dépréquez les événements plutôt que de les supprimer, versionnez les propriétés quand le sens change, et programmez des audits périodiques.

Quand vous ajoutez une propriété requise ou corrigez un bug, décidez si un backfill est nécessaire (et documentez la fenêtre temporelle où les données sont partielles).

Enfin, maintenez un guide d’instrumentation léger dans vos docs et liez‑le depuis les dashboards et les templates de PR. Un bon point de départ est une checklist courte comme /blog/event-tracking-checklist.