Ce que vous allez construire et pourquoi c'est important

Un feature flag (aussi appelé « feature toggle ») est un simple contrôle qui vous permet d'activer ou de désactiver une fonctionnalité sans déployer de nouveau code. Plutôt que de lier une release au déploiement, vous séparez « le code est déployé » de « le code est actif ». Ce petit changement modifie la manière dont vous pouvez livrer, en termes de sécurité et de rapidité.

Pourquoi les équipes s'appuient sur les feature flags

Les équipes utilisent des feature flags parce qu'ils réduisent le risque et augmentent la flexibilité :

- Releases par paliers : déployer une modification à 1% des utilisateurs, observer, puis étendre.

- Expériences : montrer la variante A vs B à des groupes différents et comparer les résultats.

- Arrêt d'urgence (kill switch) : désactiver instantanément une fonctionnalité problématique lorsqu'un incident survient.

La valeur opérationnelle est simple : les feature flags offrent un moyen rapide et contrôlé de réagir au comportement réel — erreurs, régressions de performance ou retours utilisateurs négatifs — sans attendre un cycle complet de redeploy.

Ce que ce guide vous aide à construire

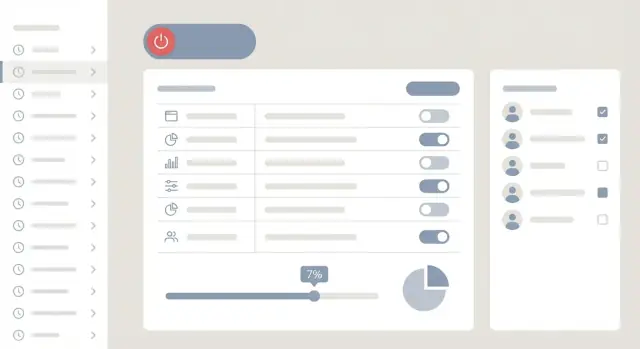

Ce guide vous accompagne pour construire une application web pratique de gestion des feature flags et des rollouts avec trois parties centrales :

- Un tableau d'administration où des membres non techniques peuvent créer des flags, définir des audiences et lancer/arrêter des rollouts.

- Une API backend pour stocker les configurations de flags, appliquer les permissions et fournir les valeurs aux applications.

- Un chemin d'évaluation léger (via SDK ou simple appel d'API) au sein de vos applications pour décider quel utilisateur voit quelle variante.

L'objectif n'est pas une plateforme d'entreprise massive ; c'est un système clair et maintenable que vous pouvez mettre entre les mains d'une équipe produit et faire confiance en production.

Si vous souhaitez prototyper rapidement cet outil interne, un workflow de prototypage peut aider. Par exemple, des équipes utilisent souvent Koder.ai pour générer une première version fonctionnelle du tableau de bord React et d'une API Go/PostgreSQL à partir d'un cahier des charges structuré, puis itèrent sur le moteur de règles, le RBAC et les exigences d'audit en mode planning avant d'exporter le code source.

Définir les exigences et les cas d'utilisation

Avant de concevoir des écrans ou d'écrire du code, clarifiez pour qui le système est conçu et ce que signifie « succès ». Les outils de feature flag échouent souvent non pas parce que le moteur de règles est mauvais, mais parce que le workflow ne correspond pas à la manière dont les équipes livrent et supportent le logiciel.

Qui l'utilisera (et ce dont ils ont besoin)

Les ingénieurs veulent des contrôles rapides et prévisibles : créer un flag, ajouter des règles de ciblage et livrer sans redeployer. Les chefs produit veulent la confiance que les releases peuvent être graduelles et planifiées, avec une visibilité claire sur qui est affecté. Le support et les opérations ont besoin d'un moyen sûr de répondre aux incidents — idéalement sans déranger l'équipe d'ingénierie — en désactivant rapidement une fonctionnalité risquée.

Un bon document d'exigences nomme ces personas et les actions qu'ils doivent pouvoir faire (et ne pas pouvoir faire).

Capacités indispensables

Concentrez-vous sur un noyau serré qui permet le déploiement progressif et le rollback :

- Créer et gérer des flags (on/off, variantes, descriptions, propriétaires)

- Définir des règles de ciblage (qui reçoit la fonctionnalité)

- Déploiements par pourcentage (ex. 1% → 10% → 50% → 100%)

- Planification (démarrer/arrêter à des heures précises, avec gestion des fuseaux)

Ce ne sont pas des « extras agréables » — ce sont ce qui rend un outil de rollout adoptable.

Capacités secondaires (prévoir, ne pas bloquer)

Capturez-les maintenant, mais ne les construisez pas en priorité :

- Expérimentations et A/B testing

- Modèles pour types de flags courants (kill switch, accès beta)

- Éditions en masse pour les grands lancements (nombreux flags, nombreux environnements)

Définir ce que "sûr" signifie

Rédigez les exigences de sécurité comme des règles explicites. Exemples courants : approbations pour les changements en production, audit complet (qui a changé quoi, quand et pourquoi), et un chemin de rollback rapide disponible même pendant un incident. Cette « définition du sûr » guidera les décisions ultérieures sur les permissions, la friction UI et l'historique des changements.

Architecture haut niveau (simple et pratique)

Un système de feature flags est plus facile à comprendre si vous séparez la gestion des flags de l'évaluation. Ainsi, l'expérience d'administration peut être sûre et agréable, tandis que vos applications obtiennent des réponses rapides et fiables.

Composants centraux

À un niveau élevé, vous aurez quatre blocs :

- UI d'administration (dashboard) : où les utilisateurs créent des flags, définissent des règles, planifient des rollouts et activent un kill switch.

- API de contrôle (Flag API) : endpoints authentifiés que le dashboard utilise pour lire/écrire flags, environnements, segments et approbations.

- Service d'évaluation + SDKs (plan de données) : la partie que vos apps interrogent (directement ou indirectement) pour décider « ce flag est-il actif pour cet utilisateur maintenant ? »

- Stockage de données : contient les définitions de flags, règles, segments et l'historique d'audit.

Un modèle mental simple : le dashboard met à jour les définitions ; les applications consomment un snapshot compilé de ces définitions pour une évaluation rapide.

Généralement, deux patterns :

Évaluation côté serveur (recommandée pour la plupart des flags). Votre backend interroge la couche d'évaluation/SDK avec un objet user/context, puis décide de l'action. Cela garde les règles et attributs sensibles hors du client et facilite un comportement cohérent.

Évaluation côté client (à utiliser sélectivement). Un client web/mobile récupère une configuration signée et pré-filtrée (seulement ce que le client est autorisé à connaître) et évalue localement. Cela peut réduire la charge backend et améliorer la réactivité UI, mais nécessite une hygiène stricte des données.

Monolithe vs petits services

Pour démarrer, un monolithe modulaire est généralement le plus pratique :

- Une application backend avec des modules clairs : Auth/RBAC, Flags, Segments, Audit et « Publish config ».

- Une base de données.

- Un déployable.

À mesure que l'usage grandit, la première séparation est souvent le chemin d'évaluation (lecture intensive) du chemin d'administration (écriture intensive). Vous pouvez conserver le même modèle de données tout en introduisant un service d'évaluation dédié plus tard.

Maintenir une latence basse : cache et évaluation locale

Les vérifications de flags sont sur des chemins chauds, optimisez les lectures :

- Pousser ou poller des snapshots : les SDK gardent un cache local de la config, rafraîchi toutes les N secondes ou via streaming.

- Évaluer localement : une fois la config en cache, la plupart des vérifications sont des appels en-process.

- Utiliser un CDN/edge pour la livraison de config (pour le client) et un cache rapide (pour le serveur) afin d'éviter d'interroger la base de données par requête.

L'objectif est un comportement cohérent même lors d'incidents partiels : si le dashboard est down, les applications doivent quand même évaluer avec la dernière configuration valide connue.

Modèle de données pour Flags, Segments et Environnements

Un système de feature flags réussit ou échoue selon son modèle de données. S'il est trop lâche, vous ne pouvez pas auditer ou rollbacker en toute sécurité. S'il est trop rigide, les équipes l'éviteront. Visez une structure qui supporte des valeurs par défaut claires, un ciblage prévisible et un historique fiable.

Entités principales

Flag est l'interrupteur au niveau produit. Gardez-le stable dans le temps en lui donnant :

key (unique, utilisé par les SDKs, ex. new_checkout)name et description (pour les humains)type (boolean, string, number, JSON)archived_at (suppression douce)

Variant représente la valeur que peut renvoyer un flag. Même les flags booléens gagnent à avoir des variantes explicites (on/off) car cela standardise le reporting et les rollouts.

Environment sépare le comportement par contexte : dev, staging, prod. Modélisez-le explicitement pour qu'un flag puisse avoir des règles et des valeurs par défaut différentes selon l'environnement.

Segment est une définition de groupe sauvegardée (ex. « Beta testers », « Utilisateurs internes », « Grands payeurs »). Les segments doivent être réutilisables sur plusieurs flags.

Règles, priorités et fallback

Les règles concentrent la complexité, faites-en des enregistrements de première classe.

Approche pratique :

FlagConfig (par flag + environnement) stocke default_variant_id, état enabled, et un pointeur vers la révision published actuelle.Rule appartient à une révision et inclut :

priority (le plus petit nombre gagne)conditions (tableau JSON d'expressions sur attributs)serve (variante fixe, ou rollout en pourcentage entre variantes)

fallback est toujours le default_variant_id dans FlagConfig quand aucune règle ne matche.

Cela simplifie l'évaluation : chargez la révision publiée, triez les règles par priorité, matchez la première, sinon valeur par défaut.

Versioning : draft vs published

Traitez chaque changement comme une nouvelle FlagRevision :

status : draft ou publishedcreated_by, created_at, commentaire optionnel

La publication est une action atomique : définir FlagConfig.published_revision_id à la révision choisie (par environnement). Les drafts permettent de préparer des changements sans impacter les utilisateurs.

Historique d'audit et rollback

Pour l'audit et les rollback, stockez un journal append-only :

AuditEvent : qui a changé quoi, quand, dans quel environnement- snapshots

before/after (ou un JSON patch) référencant les IDs de révision

Le rollback devient « re-publier une révision antérieure » plutôt que de tenter de reconstruire manuellement des réglages. C'est plus rapide, plus sûr et facile à expliquer aux parties prenantes non techniques via la vue historique du dashboard.

Ciblage et règles de segmentation

Le ciblage est la partie « qui reçoit quoi » des feature flags. Bien fait, il permet des déploiements sûrs : exposer une modification d'abord aux utilisateurs internes, puis à un niveau de client, puis à une région — sans redeployer.

Ce que vous pouvez cibler (attributs utilisateur)

Commencez avec un petit ensemble d'attributs cohérents que vos apps peuvent envoyer à chaque évaluation :

- Role : admin, staff, member (utile pour les rollouts internes d'abord)

- Plan : free, pro, enterprise (utile pour les fonctionnalités monétisées)

- Région : pays/marché, ou zone de résidence des données

- Version de l'app : pour éviter d'activer des fonctionnalités sur des clients obsolètes

Gardez les attributs simples et prévisibles. Si une app envoie plan=Pro et une autre plan=pro, vos règles se comporteront de façon inattendue.

Segments : groupes sauvegardés

Les segments sont des groupes réutilisables comme « Beta testers », « Clients EU » ou « Tous les admins enterprise ». Implémentez-les comme des définitions calculées (pas des listes statiques), pour que l'appartenance puisse être évaluée à la demande :

- Segments basés sur des règles : "plan = enterprise AND role = admin"

- Listes explicites allow/deny (optionnel) : utile pour des « clients VIP » ou des rollouts pilotés par le support

Pour garder l'évaluation rapide, cachez l'appartenance aux segments pendant un court laps de temps (secondes/minutes), indexée par environnement et utilisateur.

Logique des règles et précédence

Définissez un ordre d'évaluation clair pour que les résultats soient explicables dans le dashboard :

- Overrides stricts (ex. allow/deny list)

- Règles de ciblage (ordonnées, première correspondance gagne)

- Fall-through (désactivé par défaut, ou fallback vers un rollout)

Supportez des groupes AND/OR et les opérateurs courants : equals, not equals, contains, in list, greater/less than (pour versions ou attributs numériques).

Note confidentialité

Minimisez les données personnelles. Préférez des identifiants stables et non-PII (ex. un ID interne utilisateur). Quand vous devez stocker des identifiants pour des listes allow/deny, stockez des IDs hachés si possible, et évitez de copier emails, noms ou adresses IP brutes dans le système de flags.

Stratégies de rollout : pourcentages, variantes, scheduling, kill switch

Créez et soyez récompensé

Partagez ce que vous créez ou parrainez des collègues et gagnez des crédits pour votre utilisation de Koder.ai.

Les rollouts sont l'endroit où un système de feature flags apporte une réelle valeur : vous pouvez exposer des changements progressivement, comparer des options et arrêter des problèmes rapidement — sans redeployer.

Rollouts en pourcentage (et pourquoi le bucketing cohérent est important)

Un rollout en pourcentage signifie "activer pour 5% des utilisateurs", puis augmenter au fur et à mesure que la confiance monte. Le détail clé est le bucketing déterministe : un même utilisateur doit rester de façon fiable dans (ou en dehors) du rollout entre les sessions.

Utilisez un hash déterministe d'un identifiant stable (par exemple user_id ou account_id) pour assigner un bucket entre 0–99. Si vous choisissez des utilisateurs aléatoirement à chaque requête, les personnes "flip" entre expériences, les métriques deviennent bruyantes et le support ne peut pas reproduire les incidents.

Décidez aussi de l'unité de bucketing :

- Par utilisateur pour les applications grand public.

- Par compte/tenant pour éviter que différents utilisateurs d'une même entreprise voient des comportements contradictoires.

Variantes : booléen et multivarié

Commencez par des flags booléens (on/off), mais prévoyez des variantes multivariées (ex. control, new-checkout-a, new-checkout-b). Le multivarié est essentiel pour les A/B tests, les tests de copy et les modifications UX progressives.

Vos règles doivent toujours renvoyer une seule valeur résolue par évaluation, avec un ordre de priorité clair (ex. overrides explicites > règles de segment > rollout en pourcentage > défaut).

Scheduling : heures de début/fin, étapes de montée et fuseaux

Le scheduling permet aux équipes de coordonner les releases sans que quelqu'un reste éveillé pour basculer un interrupteur. Supportez :

- Heure de début / heure de fin (désactivation automatique après une date limite)

- Étapes de montée (ex. 1% → 10% → 25% → 50% sur des intervalles précis)

- Fuseaux horaires (stocker en UTC, mais afficher/éditer selon le fuseau choisi par l'utilisateur)

Considérez les schedules comme partie intégrante de la config du flag, pour que les changements soient audités et prévisualisables avant publication.

Comportement du kill switch (y compris en cas de panne)

Un kill switch est un "off" d'urgence qui outrepasse tout le reste. Faites-en un contrôle de première classe avec le chemin le plus rapide dans l'UI et l'API.

Décidez de ce qui se passe lors d'une panne :

- Si le service de flags est injoignable, les SDK doivent retomber sur la dernière config valide connue (en cache), puis sur une valeur par défaut sûre.

- Pour les fonctionnalités risquées, choisissez des valeurs par défaut qui échouent en « fermé » (off).

Documentez cela clairement pour que les équipes sachent ce que le client fera en cas de dégradation du système de flags. Pour plus d'informations opérationnelles, voir /blog/testing-deployment-and-governance.

APIs et intégration SDK pour vos applications

Votre application web n'est que la moitié du système. L'autre moitié est la façon dont votre code produit lit les flags de façon sûre et rapide. Une API claire plus un petit SDK par plateforme (Node, Python, mobile, etc.) maintiennent l'intégration cohérente et empêchent chaque équipe d'inventer sa propre méthode.

API de lecture (rapide, adaptée au cache)

Vos applications appelleront des endpoints en lecture bien plus souvent qu'en écriture, optimisez-les en premier.

Patterns courants :

GET /api/v1/environments/{env}/flags — lister tous les flags d'un environnement (souvent filtré sur "enabled" seulement)GET /api/v1/environments/{env}/flags/{key} — récupérer un flag par cléGET /api/v1/environments/{env}/bootstrap — récupérer flags + segments nécessaires pour l'évaluation locale

Rendez les réponses adaptées au cache (ETag ou updated_at), et gardez les payloads petits. Beaucoup d'équipes supportent aussi ?keys=a,b,c pour des fetchs groupés.

API d'écriture (validée, consciente du workflow)

Les endpoints d'écriture doivent être stricts et prédictibles :

POST /api/v1/flags — créer (valider unicité de la clé, règles de nommage)PUT /api/v1/flags/{id} — mettre à jour une config draft (validation du schéma)POST /api/v1/flags/{id}/publish — promouvoir une draft vers un environnementPOST /api/v1/flags/{id}/rollback — revenir à la dernière version saine

Retournez des erreurs de validation claires pour que le dashboard puisse expliquer ce qu'il faut corriger.

Responsabilités du SDK (rendre ça ennuyeux)

Le SDK doit gérer le cache avec TTL, les retries/backoff, les timeouts et un fallback offline (servir les dernières valeurs en cache). Il doit aussi exposer un appel unique « evaluate » pour que les équipes n'aient pas à comprendre votre modèle de données.

Empêcher la falsification côté client

Si les flags affectent la tarification, les droits ou des comportements sensibles, évitez de faire confiance au client navigateur/mobile. Préférez l'évaluation côté serveur, ou utilisez des tokens signés (le serveur émet un "snapshot" signé des flags que le client peut lire mais pas falsifier).

UX du tableau d'administration (convivial pour non techniques)

Gardez le contrôle avec l'export du code source

Exportez le code source quand vous êtes prêt à le réviser, l'étendre et le maîtriser sur le long terme.

Un système de feature flags ne fonctionne que si les gens lui font confiance en production. Le dashboard construit cette confiance : labels clairs, valeurs par défaut sûres et changements faciles à réviser.

Liste de flags : trouver vite la bonne chose

Commencez par une vue simple de la liste de flags qui supporte :

- Recherche par nom, clé, propriétaire ou tag

- Filtres par statut (on/off), type (boolean/multivariant) et « modifié récemment »

- Un sélecteur d'environnement visible (Dev / Staging / Prod)

Affichez l'état courant de façon lisible. Par exemple, montrer On pour 10%, Ciblage : segment Beta, ou Off (kill switch actif) plutôt qu'un simple point vert.

Éditeur de flag : guider l'utilisateur pour des changements sûrs

L'éditeur doit ressembler à un formulaire guidé, pas à une configuration technique.

Incluez :

- Un constructeur de règles en langage clair (ex. “Si country est US” ET “Plan est Pro”)

- Un curseur de rollout (0–100%) avec explication claire de l'impact

- Un panneau de prévisualisation montrant des exemples d'utilisateurs correspondant aux règles (ou un "Pourquoi cet utilisateur correspond" détaillé)

Si vous supportez des variantes, affichez-les comme des options lisibles (« Nouveau checkout », « Ancien checkout ») et validez que le trafic total est cohérent.

Actions en masse sans erreurs en masse

Les équipes auront besoin d'activer/désactiver en masse et de « copier les règles vers un autre environnement ». Ajoutez des garde-fous :

- Confirmations récapitulant l'impact ("Ceci activera 12 flags en Production")

- Prévisualisations en mode dry-run pour les opérations de copie

- Conseils clairs pour annuler quand c'est possible

Protections : rendre le chemin sûr le plus facile

Utilisez des avertissements et des notes obligatoires pour les actions risquées (modifs en Production, sauts de pourcentage importants, toggles du kill switch). Affichez un résumé des changements avant enregistrement — ce qui a changé, où et qui sera affecté — pour que les relecteurs non techniques approuvent en toute confiance.

Sécurité, rôles et approbations

La sécurité est l'endroit où les outils de feature flags gagnent rapidement la confiance — ou se font bloquer par votre équipe sécurité. Parce que les flags peuvent changer des expériences utilisateurs instantanément (et parfois casser la production), traitez le contrôle d'accès comme une partie intégrante du produit.

Commencez par email + mot de passe pour la simplicité, mais prévoyez les attentes enterprise.

- SSO/OAuth : supportez Google/Microsoft OAuth tôt, et laissez la porte ouverte pour SAML/SCIM si vous visez de plus grandes organisations.

- Email + mot de passe : si proposé, stockez les mots de passe avec un hachage moderne (ex. Argon2/bcrypt), imposez le MFA quand possible et ajoutez du rate limiting sur les connexions.

Autorisation : rôles et accès par environnement

Un modèle propre est RBAC plus permissions par environnement.

- Admin : gérer les paramètres org, utilisateurs, intégrations et permissions.

- Editor : créer et modifier flags, segments et règles (pas nécessairement en production).

- Viewer : accès lecture seule.

Puis scindez ce rôle par environnement (Dev/Staging/Prod). Par ex. quelqu'un peut être Editor en Staging mais seulement Viewer en Prod. Cela évite des basculements accidentels en production tout en gardant les équipes rapides ailleurs.

Approbations pour les changements en production (recommandé)

Ajoutez un workflow d'approbation optionnel pour les modifications Prod :

- Exiger une approbation quand un changement affecte le ciblage Prod, le pourcentage ou l'état du kill switch.

- Capturer qui a demandé, qui a approuvé, et ce qui a changé.

- Autoriser des dérogations d'urgence pour des admins on-call, mais les journaliser systématiquement.

Gestion des secrets et clés SDK

Vos SDKs auront besoin de clés pour récupérer les valeurs de flags. Traitez-les comme des API keys :

- Clés séparées par environnement (ne réutilisez jamais une clé Dev en Prod).

- Stockez seulement des valeurs hachées/partielles pour l'affichage ; montrez la clé complète une seule fois à la création.

- Supportez la rotation et la révocation immédiate.

- Scoppez les clés à la lecture seule d'évaluation quand c'est possible.

Pour la traçabilité, reliez cette section à votre conception du journal d'audit dans /blog/auditing-monitoring-alerts.

Audit, monitoring et alerting

Quand les feature flags contrôlent de vraies expériences utilisateurs, "qui a changé quoi ?" devient une question de production, pas de bureaucratie. L'audit et le monitoring transforment votre outil de rollout en un système opérationnel digne de confiance.

Journal d'audit : qui a changé quoi, quand et pourquoi

Chaque action d'écriture dans l'app admin doit émettre un événement d'audit. Traitez-le en append-only : ne modifiez jamais l'historique — ajoutez un nouvel événement.

Capturez l'essentiel :

- Acteur : ID utilisateur, email, rôle et (si pertinent) nom du token API

- Action : création/mise à jour/suppression de flag, changement de ciblage, démarrage de rollout, activation du kill switch

- Périmètre : clé du flag, environnement, segment et règles affectées

- Diff : valeurs avant/après (lisible)

- Raison : champ "note" requis pour les actions risquées (ex. activation en production)

- Contexte : horodatage, IP, user agent, request ID

Rendez ce journal facile à parcourir : filtres par flag, environnement, acteur et plage temporelle. Un lien profond "copier le lien vers ce changement" est inestimable pour les threads d'incident.

Métriques : prouver ce que vos flags font

Ajoutez une télémétrie légère autour des évaluations de flags (lectures SDK) et des résultats de décision (quelle variante a été servie). Au minimum, suivez :

- évaluations par flag/environnement

- distribution des variantes dans le temps

- compteurs d'activation/désactivation et de changement de règle

- taux d'erreur et latence pour les services derrière un flag

Cela aide pour le debug ("les utilisateurs reçoivent-ils bien la variante B ?") et la gouvernance ("quels flags sont morts et peuvent être supprimés ?").

Alerting : détecter rapidement les régressions

Les alertes doivent relier un événement de changement à un signal d'impact. Règle pratique : si un flag est activé (ou monté en charge) et que les erreurs augmentent peu après, alertez quelqu'un.

Exemples de conditions :

- Le taux d'erreur augmente de X% dans les 10 minutes suivant une étape de rollout

- L'un des variants voit son taux d'erreur diverger significativement des autres

- Les échecs d'évaluation (le SDK ne peut pas fetch la config) dépassent un seuil

Vues opérationnelles pour l'usage quotidien

Créez une zone “Ops” simple dans votre dashboard :

- Modifications récentes (depuis le journal d'audit)

- Rollouts actifs (pourcentage actuel, répartition des variantes, prochaine étape planifiée)

- Événements planifiés (paliers à venir, expirations, désactivations prévues)

Ces vues réduisent l'incertitude pendant les incidents et rendent les rollouts plus contrôlés que risqués.

Réduisez les changements risqués en production

Mettez en place des garde-fous en production comme les approbations et les notes de changement obligatoires, sans processus lourd.

Les feature flags sont sur le chemin critique de chaque requête, donc la fiabilité est une caractéristique produit, pas un détail infra. L'objectif : l'évaluation des flags doit être rapide, prévisible et sûre même quand des parties du système sont dégradées.

Couches de cache (et quand les utiliser)

Commencez par un cache en mémoire dans votre SDK ou service edge pour que la plupart des évaluations n'atteignent jamais le réseau. Gardez le cache petit et indexé par environnement + version du set de flags.

Ajoutez Redis quand vous avez besoin de lectures partagées et basses latences entre de nombreuses instances d'app (et pour diminuer la charge sur la base principale). Redis est aussi utile pour stocker un « snapshot courant de flags » par environnement.

Un CDN n'aide que si vous exposez un endpoint de flags en lecture seule qui est sûr à mettre en cache publiquement ou par-tenant (souvent ce n'est pas le cas). Si vous utilisez un CDN, préférez des réponses signées et de courte durée et évitez de cacher des données user-spécifiques.

Stratégie de cohérence : polling vs streaming

Le polling est plus simple : les SDKs récupèrent le dernier snapshot toutes les N secondes avec des checks ETag/version pour éviter de retélécharger des données inchangées.

Le streaming (SSE/WebSockets) offre une propagation plus rapide pour les rollouts et kill switches. C'est excellent pour de grandes équipes, mais demande plus de soin opérationnel (limites de connexions, logique de reconnexion, fanout régional). Un compromis pratique : polling par défaut avec streaming optionnel pour les environnements « instantanés ».

Limitation de débit et protection contre les boucles chaudes

Protégerez vos APIs contre des mauvais paramétrages SDK (ex. polling toutes les 100ms). Appliquez côté serveur des intervalles minimaux par clé SDK et renvoyez des erreurs explicites.

Protégez aussi votre base de données : assurez-vous que le chemin de lecture est basé sur un snapshot, pas sur "évaluer les règles en joignant les tables utilisateurs". L'évaluation de flags ne doit jamais déclencher des joins coûteux.

Reprise après sinistre et valeurs par défaut sûres

Sauvegardez votre datastore principal et faites des drills de restauration régulièrement (pas seulement des backups). Conservez un historique immuable des snapshots de flags pour un rollback rapide.

Définissez des valeurs par défaut sûres pour les pannes : si le service de flags est injoignable, les SDKs doivent retomber sur le dernier snapshot connu ; s'il n'en existe pas, par défaut mettre la fonctionnalité à "off" pour les features risquées et documenter les exceptions (ex. flags critiques pour la facturation).

Tests, déploiement et gouvernance continue

Déployer un système de feature flags n'est pas "déployer et oublier". Parce qu'il contrôle le comportement en production, vous voulez une forte confiance dans l'évaluation des règles, les workflows de changement et les chemins de rollback — et un processus de gouvernance léger pour que l'outil reste sûr au fur et à mesure de l'adoption.

Tests : se concentrer sur la justesse et la prévisibilité

Commencez par des tests qui protègent les promesses centrales :

- Tests unitaires pour l'évaluation des règles et la stabilité du bucketing : vérifiez la logique de ciblage (segments, opérateurs, précédence) et assurez-vous que les rollouts en pourcentage sont stables par utilisateur (même entrée → même variante), même quand vous ajoutez de nouveaux flags.

- Tests d'intégration pour publication/rollback et vérifications de permission : testez l'API réelle + DB : créer une draft, demander une approbation, publier, puis rollbacker. Confirmez que les rôles peuvent/ne peuvent pas effectuer certaines actions et que les entrées d'audit sont créées pour chaque changement.

Astuce pratique : ajoutez des cas tests "golden" pour les règles délicates (plusieurs segments, fallbacks, conditions conflictuelles) pour que les régressions soient évidentes.

Pratiques de staging qui reflètent l'usage réel

Faites du staging un environnement de répétition :

- Préseed des segments connus (ex. testeurs internes, clients beta) et gardez-les stables.

- Créez des utilisateurs synthétiques couvrant les cas limites (attributs manquants, locales inhabituelles, nouveaux comptes).

- Exécutez un canary du système de flags lui-même : activez l'évaluation via SDK pour un petit ensemble de services d'abord, puis étendez.

Checklist de déploiement et gouvernance continue

Avant les releases en production, utilisez une checklist courte :

- Les migrations de schéma sont rétrocompatibles (les anciens SDKs fonctionnent toujours).

- Les chemins du kill switch sont testés end-to-end.

- L'alerting est configuré pour les pics d'erreur et les échecs de fetch de config.

- La documentation est à jour (/docs) et les attentes support sont claires (/pricing).

Pour la gouvernance, restez simple : définissez qui peut publier en production, exigez une approbation pour les flags à fort impact, révisez les flags obsolètes chaque mois et ajoutez un champ « date d'expiration » pour éviter que des rollouts temporaires vivent indéfiniment.

Si vous construisez cela comme une plateforme interne, il peut être utile de standardiser la façon dont les équipes demandent des changements. Certaines organisations utilisent Koder.ai pour générer un dashboard initial et itérer sur les workflows (approbations, résumés d'audit, UX de rollback) avec les parties prenantes en conversation, puis exporter la base de code pour une revue de sécurité et une appropriation à long terme.