Définir le travail de l'assistant et la portée du MVP

Une « application d'assistant personnel » peut être n'importe quoi : d'une to-do list améliorée à un outil qui négocie des conflits d'agenda et rédige des e‑mails. Si vous ne définissez pas précisément le travail, vous finirez par construire une démo de chat qui impressionne mais n'aide personne le lundi matin.

Commencez par nommer votre public et sa douleur récurrente. Un fondateur pourra vouloir une préparation rapide aux réunions et des suivis ; un étudiant voudra des plans d'étude et la capture de notes ; un responsable opérationnel voudra une triage des tâches et des résumés quotidiens. Plus l'audience est claire, plus il est facile de décider quels outils votre assistant doit avoir — et lesquels il ne doit absolument pas avoir.

Choisir 1–2 parcours qui prouvent la valeur

Votre MVP doit délivrer un résultat utile en une seule courte session. Une règle pratique : l'utilisateur obtient de la valeur dans les 60–120 secondes après ouverture de l'app.

Deux premiers parcours fiables :

- Capture → organiser : Ajouter une tâche/une note avec contexte, confirmer qu'elle a bien été sauvegardée, puis la voir dans une liste simple.

- Résumer → décider : Générer un plan/synthèse quotidien à partir des éléments sauvegardés, puis permettre à l'utilisateur d'accepter, d'éditer ou de replanifier.

Remarquez ce qui manque : onboarding long, réglages compliqués ou intégrations profondes. Vous pouvez toujours simuler une expérience « assistant » en rendant l'interaction conversationnelle tout en gardant les actions sous-jacentes déterministes.

Définir les non-objectifs (et les écrire)

Beaucoup d'apps d'assistant échouent en voulant tout faire dès le jour 1 : voix, synchronisation e‑mail complète, accès en écriture au calendrier, actions autonomes multi‑étapes et configurations d'agents complexes. Écrivez des non-objectifs explicites pour le MVP — pas d'entrée vocale, pas d'intégration e‑mail bidirectionnelle, pas d'exécution autonome en arrière-plan, et pas de synchronisation multi‑appareils au-delà des comptes basiques. Cela maintient l'honnêteté du produit et réduit les risques de sécurité et de confidentialité tôt.

Choisir des métriques de succès adaptées au travail

Ne mesurez pas le MVP par le « nombre de chats ». Mesurez-le par résultats :

- Temps-jusqu-au-premier-résultat-utile : à quelle vitesse les utilisateurs obtiennent une tâche sauvegardée ou une synthèse utilisable.

- Qualité : à quelle fréquence les tâches/dates extraites sont correctes, et combien d'éditions sont nécessaires.

- Rétention : si les utilisateurs reviennent le lendemain pour capturer ou revoir.

Si vous faites du vibe-coding sur une plateforme comme Koder.ai, des parcours et des métriques clairs rendent aussi la vitesse de développement réelle : vous pouvez cadrer les premières écrans React/Flutter et les endpoints Go/PostgreSQL autour de deux boucles centrales, puis itérer avec snapshots et rollback quand les changements n'améliorent pas les résultats.

Conception produit : flux UX qui donnent l'impression d'un assistant

Une application d'assistant personnel réussit ou échoue selon la sensation de l'interaction. Les utilisateurs doivent sentir que l'app comprend l'intention, propose l'étape suivante utile et reste discrète quand ils veulent juste une réponse rapide.

Commencer par les actions quotidiennes de l'assistant

La plupart des assistants gagnent la confiance en exécutant quelques tâches clés de manière constante : comprendre les demandes, stocker une “mémoire” (préférences et faits de profil légers), gérer tâches et rappels, et générer des résumés rapides (notes, réunions, messages longs). Le design produit doit rendre ces capacités évidentes sans transformer l'app en labyrinthe.

Règle utile : chaque capacité d'assistant doit avoir à la fois (1) un chemin conversationnel (par ex. « rappelle‑moi demain à 9h ») et (2) une surface UI visible pour la revue et l'édition (une liste de rappels que l'on peut parcourir).

Choisir un style d'interaction : chat-first vs UI-first

Chat-first marche mieux quand votre audience valorise la vitesse et la flexibilité : un éditeur, un historique de messages et quelques raccourcis intelligents.

UI-first avec le chat en tant qu'aide fonctionne mieux quand les utilisateurs gèrent beaucoup d'éléments et ont besoin de structure. Dans ce modèle, l'app s'ouvre sur une vue « Tâches » ou « Aujourd'hui », et le chat est un outil contextuel pour des modifications (par ex. « déplacer tout ce qui est dû aujourd'hui à demain »).

Vous n'avez pas à choisir pour toujours, mais vous devriez définir un écran d'accueil par défaut et un modèle mental par défaut tôt.

Intégrer la sécurité dans le flux (confirmer + annuler)

Les assistants prennent souvent des actions qui paraissent irréversibles : supprimer une note, envoyer un message, annuler quelque chose, ou éditer de nombreuses tâches à la fois. Traitez ces actions comme risquées. L'UX doit prévoir une étape de confirmation claire avec un résumé en langage simple de ce qui va se passer, plus une annulation immédiate après exécution.

Un bon schéma est : prévisualiser → confirmer → exécuter → annuler. La prévisualisation permet à l'utilisateur de détecter les erreurs (« Envoyer à Alex ? » « Supprimer 12 tâches ? »).

Esquisser l'ensemble minimal d'écrans

Gardez la première version petite et cohérente. Un minimum pratique est : onboarding (ce qu'elle peut faire + permissions), chat, tâches/rappels, mémoire (ce qu'elle sait, avec édition/suppression), paramètres (notifications, tonalité, confidentialité), et une vue historique/audit légère.

Si vous faites du vibe-coding (par exemple, dans Koder.ai), ces écrans se mappent proprement à un MVP que vous pouvez générer rapidement puis affiner en testant des flux réels comme « capturer une tâche », « définir un rappel » et « annuler une erreur ».

Conception des prompts et du comportement (sans sur‑ingénierie)

Un bon assistant paraît cohérent, prévisible et sûr — plutôt un collègue utile qu'un générateur de texte aléatoire. Vous pouvez y parvenir plus vite en gardant les prompts simples, stratifiés et testables.

Utiliser une hiérarchie claire de messages

Traitez vos prompts comme trois couches, chacune avec un objectif différent :

- Instructions système : définissent l'identité et les non‑négociables (ton, sécurité, posture de confidentialité, comment gérer l'incertitude).

- Règles développeur : définissent le comportement produit (fonctionnalités supportées, règles d'utilisation des outils, contrats de format de sortie, ce qu'il faut logger).

- Messages utilisateur : sont les requêtes changeantes.

Cette séparation empêche une demande utilisateur (« ignorez les instructions précédentes ») de remplacer accidentellement le comportement obligatoire de l'assistant.

Définir les limites des outils (et les permissions)

Votre assistant sera plus digne de confiance s'il sait exactement quand il peut agir et quand il doit demander. Décidez quelles opérations sont en lecture seule (sûres à faire automatiquement, comme rechercher des notes), lesquelles sont des écritures (création/mise à jour de tâches, planifier des rappels), et lesquelles sont irréversibles ou coûteuses (supprimer des données, contacter des services externes, partager des informations).

Pour les écritures et les actions irréversibles, exigez une confirmation : le modèle propose un plan d'action, puis attend l'approbation explicite.

Préférer des sorties structurées pour les actions

Quand le modèle doit créer une tâche ou un rappel, le texte libre est fragile. Utilisez des objets d'action JSON et validez‑les avant exécution. Exigez des champs comme action, title, due_at, priority et timezone, et rejetez ou redemandez quand quelque chose manque. Cela garde votre backend déterministe même quand le langage du modèle varie.

Ajouter des garde‑fous légers

Les garde‑fous n'ont pas besoin d'être compliqués. Ajoutez une courte politique pour les demandes sensibles (automutilation, activité illégale, accès à des données privées) et définissez des schémas de refus qui restent utiles : reconnaître, refuser et proposer des alternatives sûres. Demandez aussi au modèle de dire « Je ne sais pas » quand il manque d'information, et de poser une seule question de clarification plutôt que de deviner.

Construire une petite bibliothèque de prompts

Au lieu d'un méga‑prompt, conservez un petit ensemble de comportements réutilisables que votre assistant peut « appeler » en interne : résumer une conversation en actions suivantes, rédiger un plan avec hypothèses et questions ouvertes, vérifier une requête pour détails manquants, réécrire un message dans un ton spécifique, et extraire tâches/événements en JSON. C'est le point idéal : comportement cohérent, tests faciles, et pas de spaghetti de prompts.

LLM + outils + agents : une architecture pratique

Un assistant personnel paraît « intelligent » quand il sait bien faire deux choses : converser naturellement et effectuer des actions fiables. Le chemin le plus rapide est de séparer la conversation (raisonnement LLM) de l'exécution (outils qui appellent vos systèmes réels).

Deux patterns exploitables

Pour un MVP, commencez par un LLM unique + outils : un modèle reçoit le message utilisateur, décide de répondre en texte ou d'appeler un outil, puis renvoie un résultat. C'est plus simple à déboguer et souvent suffisant pour la capture de tâches, la recherche de notes et les rappels.

Au fur et à mesure que les capacités augmentent, un pattern coordinateur + agents spécialistes devient utile. Un coordinateur interprète la demande et délègue à des spécialistes (par ex. un agent Tâches vs un agent Notes), chacun avec des instructions plus étroites et moins d'outils. Cela réduit les usages accidentels d'outils et améliore la cohérence quand vous ajoutez des intégrations.

Outils : les mains de l'assistant

Les outils sont de petites APIs déterministes que l'assistant peut invoquer. Gardez les entrées d'outil strictes et les sorties structurées pour pouvoir les valider et journaliser ce qui s'est passé.

Outils courants : création/mise à jour/complétion de tâches, recherche de notes (mot‑clé + filtres temporels), planification de rappels (heure, canal, récurrence), consultation de préférences (timezone, heures de travail), lecture d'agenda optionnelle (si vous avez intégration calendrier), et écritures d'événements d'audit.

Mode planification avant d'agir

Avant d'exécuter, ajoutez une étape explicite de mode planification : le modèle écrit un court plan, puis sélectionne les outils pour l'exécuter. La planification aide pour les demandes multi‑étapes comme « Déplacer mes tâches de projet à la semaine prochaine et me rappeler lundi », où l'assistant doit confirmer les hypothèses (timezone, ce qui compte comme « tâches de projet ») avant d'agir.

Approbation d'action pour éviter les surprises

Tout outil provoquant des effets de bord (création de tâches, envoi de rappels, modification de données) doit passer par une porte d'approbation d'action. En pratique, le modèle propose un brouillon d'action (nom de l'outil + paramètres + résultat attendu), et votre app demande à l'utilisateur de confirmer ou d'éditer. Ce point de contrôle unique réduit considérablement les changements involontaires et rend l'assistant plus digne de confiance.

Si vous utilisez une plateforme de vibe-coding comme Koder.ai, vous pouvez implémenter cette architecture rapidement en générant des interfaces d'outils, la logique du coordinateur et l'UI d'approbation comme composants séparés et testables — puis itérer via snapshots et rollback en affinant le comportement.

Mémoire et contexte : quoi sauvegarder, quoi récupérer

Un assistant personnel paraît « intelligent » quand il se souvient des bonnes choses et oublie le reste. L'astuce est de séparer ce dont le modèle a besoin pour la cohérence de ce que vous stockez pour l'utilisateur. Si vous tout stockez, vous augmentez le risque de confidentialité et le bruit de récupération. Si vous ne stockez rien, l'assistant devient répétitif et fragile.

Mémoire court terme vs long terme

Traitez la conversation récente comme mémoire court terme : une fenêtre roulante des derniers tours plus l'objectif utilisateur courant. Gardez‑la serrée — résumez agressivement — pour ne pas payer des tokens inutiles ou amplifier des erreurs antérieures.

La mémoire long terme sert aux faits qui doivent survivre aux sessions : préférences, détails stables de profil, tâches et notes que l'utilisateur s'attend à retrouver. Stockez-les d'abord comme données structurées (tables, champs, timestamps) et n'utilisez du texte libre que lorsque vous ne pouvez pas représenter quelque chose proprement.

Quoi vaut la peine d'être sauvegardé

Un point de départ pratique : sauvegarder les informations rédigées ou approuvées par l'utilisateur : profil et préférences (timezone, heures de travail, ton, rappels par défaut), tâches et projets (statut, dates d'échéance, récurrence, priorité), notes et extraits (décisions, engagements, contexte clé), et résultats d'outils plus une piste d'audit.

Les points saillants de la conversation importent plus que les transcriptions complètes. Au lieu de tout stocker, conservez des faits durables comme : « L'utilisateur préfère des synthèses concises », « Vol pour NYC vendredi », « Plafond budgétaire 2 000 $ ».

Récupération qui paraît instantanée (et prévisible)

Concevez la récupération autour de la façon dont les humains cherchent : mots‑clés, plages temporelles, tags et « récemment modifié ». Utilisez d'abord des filtres déterministes (dates, statut, tags), puis ajoutez une recherche sémantique sur le corps des notes quand la requête est floue.

Pour éviter les hallucinations, l'assistant doit se reposer uniquement sur ce qu'il a réellement récupéré (IDs d'enregistrement, timestamps) et poser une question de clarification quand rien de pertinent n'est trouvé.

Contrôles utilisateur et confiance

Rendez la mémoire transparente. Les utilisateurs doivent pouvoir voir ce qui est enregistré, l'éditer, l'exporter et le supprimer — surtout les faits long terme. Si vous construisez avec un workflow de vibe-coding comme Koder.ai, faire de « Memory Settings » un écran prioritaire façonne à la fois l'UX et votre modèle de données dès le début.

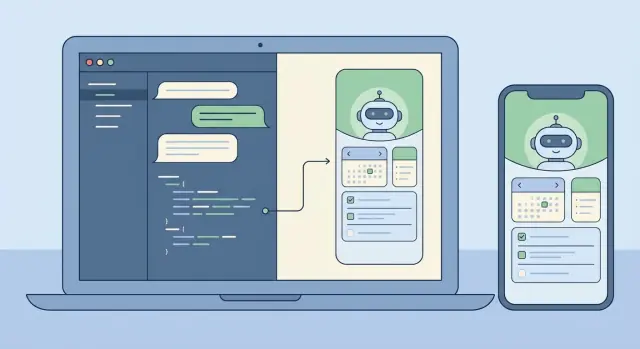

Frontend : Web (React) et Mobile (Flutter)

Un assistant personnel vit ou meurt par l'interface. Choisissez la stack selon où les gens l'utiliseront réellement : le web est souvent la voie la plus rapide vers l'utilité « quotidien », tandis que le mobile devient indispensable quand les notifications, la saisie vocale et la capture en mobilité comptent.

Une approche pratique est : commencer par React pour l'UI web (itération rapide, déploiement facile), puis reproduire le même modèle d'interaction en Flutter une fois que la boucle centrale fonctionne.

Une UI de chat qui se comporte comme un produit (pas une démo)

Traitez le chat comme une conversation structurée, pas seulement des bulles de texte. Gérez plusieurs formes de messages pour que les utilisateurs comprennent ce qui se passe et ce qu'on attend d'eux : messages utilisateur, réponses de l'assistant (y compris texte en streaming), actions d'outils (« Création de tâche… »), confirmations (approuver/refuser), erreurs (avec options de réessai) et avis système (hors ligne, limites de débit, capacité dégradée).

En React, les réponses en streaming peuvent rendre l'assistant réactif, mais gardez le rendu efficace : ajoutez les deltas, évitez de rerendre toute la transcription, et maintenez le comportement de scroll qui respecte la lecture de messages plus anciens.

États « en réflexion » sans divulguer les coulisses

Les utilisateurs ont besoin de retours, pas de vos prompts internes ou des détails de la chaîne d'outils. Utilisez des indicateurs neutres comme « En cours » ou « Vérification de vos notes », et montrez uniquement des jalons sûrs pour l'utilisateur (démarré, en attente de confirmation, terminé). Cela devient encore plus important quand vous ajoutez des workflows multi‑agent.

Paramètres qui rendent le comportement contrôlable

Ajoutez un écran de paramètres tôt, même s'il est simple. Laissez les gens contrôler la tonalité (professionnel vs décontracté), la verbosité (bref vs détaillé) et les options de confidentialité (stocker l'historique de chat, durée de rétention, activer/désactiver les fonctionnalités mémoire). Ces contrôles réduisent les surprises et aident pour la conformité.

Si vous faites du vibe-coding avec Koder.ai, vous pouvez générer à la fois l'UI web React et les écrans Flutter depuis la même intention produit, puis itérer rapidement sur les composants de conversation, le streaming et les paramètres sans vous enliser dans la plomberie UI.

Fondations backend : APIs, Auth et exécution déterministe

Un assistant personnel paraît magique dans l'UI, mais il devient digne de confiance dans le backend. L'objectif est de rendre le comportement piloté par le chat prévisible : le modèle peut proposer des actions, mais votre serveur décide de ce qui arrive réellement.

APIs qui mappent l'intention utilisateur

Traduisez les comportements de l'assistant en un petit ensemble d'endpoints stables. Gardez le chat comme point d'entrée, puis exposez des ressources explicites pour tout ce que l'assistant peut gérer. Par exemple, l'assistant peut rédiger une tâche, mais l'appel final create-task doit être une requête API normale avec un schéma strict.

Une surface compacte qui évolue bien inclut : chat (envoyer/recevoir plus requêtes d'outils optionnelles), exécution d'outils (exécuter des outils approuvés et renvoyer des résultats structurés), CRUD tâches (avec validation côté serveur), préférences, et endpoints job/status pour le travail long.

Auth et sessions : décider tôt

L'authentification est plus facile à ajouter tôt et pénible à refactorer. Définissez comment une session utilisateur est représentée (tokens ou sessions serveur) et comment les requêtes sont scoper (user ID, org ID pour les équipes). Décidez ce que l'assistant peut faire « silencieusement » vs ce qui nécessite ré-authentification ou confirmation.

Si vous prévoyez des paliers (free/pro/business/enterprise), appliquez les droits au niveau API dès le départ (limites de débit, disponibilité d'outils, permissions d'export), pas uniquement dans les prompts.

Jobs longue durée : queuez, ne bloquez pas

Les résumés de contenu volumineux, les imports, ou les workflows multi‑étapes d'agents doivent s'exécuter de façon asynchrone. Retournez rapidement un job ID et fournissez des mises à jour de progression (queued → running → partial results → completed/failed). Cela garde le chat réactif et évite les timeouts.

Exécution déterministe : les modèles proposent, les serveurs décident

Considérez les sorties du modèle comme des entrées non fiables. Validez et assainissez tout : schémas JSON stricts pour les appels d'outils, rejet des champs inconnus, enforcement de types/valeurs, normalisation côté serveur des dates/timezones, et journalisation des requêtes/résultats d'outils pour audit.

Des plateformes comme Koder.ai peuvent accélérer le scaffolding (APIs Go, backing PostgreSQL, snapshots/rollback), mais le principe reste : l'assistant peut être créatif en conversation pendant que le backend reste ennuyeux, strict et fiable.

Modèle de données en PostgreSQL : tâches, notes et auditabilité

Un assistant personnel paraît « intelligent » quand il se souvient de façon fiable, explique ce qu'il a fait et annule les erreurs. Votre schéma PostgreSQL doit supporter cela dès le jour 1 : entités claires, provenance explicite (d'où chaque élément provient) et timestamps favorables à l'audit.

Entités de base à modéliser (et pourquoi)

Commencez avec un petit ensemble de tables qui correspondent aux attentes utilisateur : users, conversations/messages, tasks/reminders, notes, et (optionnel) embeddings si vous faites de la récupération à l'échelle. Séparez tasks/notes des messages : les messages sont la transcription brute ; tasks/notes sont les résultats structurés.

Provenance : « Quel message a créé ceci ? »

Considérez la provenance comme une fonctionnalité de première classe. Quand le LLM transforme une requête en tâche, stockez un source_message_id sur tasks/notes, tracez qui l'a créée (user, assistant ou system), et attachez un tool_run_id si vous utilisez des outils/agents. Cela rend le comportement explicable (« Créé d'après votre message mardi à 10:14 ») et accélère le débogage.

Champs favorables à l'audit et suppression douce

Utilisez des colonnes cohérentes : created_at, updated_at, et souvent deleted_at pour suppression douce. La suppression douce est particulièrement utile car les utilisateurs veulent fréquemment annuler, et vous pouvez avoir besoin de conserver des enregistrements pour conformité ou dépannage.

Pensez à des identifiants immuables (uuid) et à une table d'audit append‑only pour les événements clés (tâche créée, date d'échéance modifiée, rappel déclenché). C'est plus simple que de tenter de reconstruire l'historique à partir de lignes mises à jour.

Migrations et évolution du schéma

Le comportement des assistants change vite. Planifiez les migrations tôt : versionnez votre schéma, évitez les changements destructifs et préférez les étapes additives (nouvelles colonnes, nouvelles tables). Si vous faites du vibe-coding avec Koder.ai, associez snapshots/rollback à une discipline de migration pour itérer sans perdre l'intégrité des données.

CREATE TABLE tasks (

id uuid PRIMARY KEY,

user_id uuid NOT NULL,

title text NOT NULL,

status text NOT NULL,

due_at timestamptz,

source_message_id uuid,

created_by text NOT NULL,

created_at timestamptz NOT NULL DEFAULT now(),

updated_at timestamptz NOT NULL DEFAULT now(),

deleted_at timestamptz

);

Tests et évaluation : rendre cela fiable

La fiabilité est la différence entre une démo cool et un assistant auquel on confie du vrai travail. La difficulté est que les requêtes d'assistant sont rarement nettes : les utilisateurs sont brefs, émotionnels, incohérents, et sautent souvent des détails clés. Votre stratégie de test doit refléter cette réalité.

Construire un jeu de tests qui ressemble à la vraie vie

Collectez (ou rédigez) un petit mais représentatif ensemble de requêtes : messages courts, instructions vagues, fautes de frappe, contraintes conflictuelles et changements de dernière minute. Incluez des chemins heureux (création claire de tâche, capture de note) et des chemins limites (dates manquantes, pronoms ambigus, plusieurs personnes avec le même nom, requêtes impliquant des permissions).

Conservez ces exemples comme votre ensemble d'or. Exécutez‑les à chaque modification des prompts, outils ou logique d'agents.

Définir ce que « bien » signifie (au‑delà des bonnes réponses)

Pour les apps assistant, la justesse ne se résume pas à la réponse textuelle finale. Évaluez si l'assistant a pris la bonne action, demandé confirmation quand nécessaire, et évité d'inventer des résultats d'outils.

Un rubrik pratique vérifie : correction de la tâche, comportement de confirmation (surtout avant suppression/envoi/dépense), hallucinations d'action (prétendre exécution sans run d'outil), discipline d'outil (utilise les outils quand il faut ; évite les appels inutiles), et récupération (gestion claire des échecs et réessais).

Vérifications de régression pour prompts et outils

Chaque tweak de prompt peut changer le comportement de façon surprenante. Traitez les prompts comme du code : versionnez‑les, exécutez l'ensemble d'or et comparez les résultats. Si vous utilisez plusieurs agents (planificateur/exécuteur), testez chaque étape — beaucoup d'échecs commencent par une planification qui se propage.

Lors de l'ajout d'un nouvel outil ou d'un changement de schéma d'outil, ajoutez des cas de régression ciblés (par ex. « créer une tâche pour vendredi prochain » doit toujours résoudre les dates de façon cohérente). Si votre workflow supporte snapshots et rollback, utilisez‑les pour revenir rapidement quand les évaluations chutent.

Instrumentation sans divulguer des secrets

Journalisez les appels d'outils, les arguments rédigés, les durées et les raisons d'échec pour pouvoir répondre : « Qu'a tenté de faire le modèle ? » et « Pourquoi a‑t‑il échoué ? ». Redigez tokens, données personnelles et contenu de messages par défaut, et stockez seulement ce qui est nécessaire pour le débogage — souvent un user ID haché, le nom de l'outil, l'intention générale et la classe d'erreur suffisent.

Bien fait, les tests transforment l'itération en boucle contrôlée : vous pouvez aller plus vite sans rompre la confiance.

Une application d'assistant personnel devient vite un conteneur pour du contenu sensible : calendriers, localisations, messages, documents et notes que les utilisateurs ne voulaient pas forcément partager. Considérez la confidentialité comme une fonctionnalité produit, pas une case à cocher. Minimisez ce que vous collectez et ce que vous envoyez à un LLM. Si une fonctionnalité n'exige pas l'historique complet, ne le stockez pas ; si une requête peut être traitée par un court résumé, envoyez seulement le résumé.

Minimisation des données, rétention et contrôles utilisateurs

Définissez la rétention dès le départ : ce que vous stockez (tâches, notes, préférences), pourquoi vous le stockez et combien de temps cela reste. Rendez la suppression réelle et vérifiable : les utilisateurs doivent pouvoir supprimer une note unique, un workspace entier et tout fichier téléchargé. Envisagez un « mode oublieux » pour les conversations sensibles où vous ne persistez pas le contenu — seulement des métadonnées minimales pour la facturation et la prévention d'abus.

Secrets, tokens et chiffrement

Ne jamais envoyer de clés API au client. Gardez les clés fournisseurs et les credentials d'outils sur le serveur, renouvelez‑les et scopez‑les par environnement. Chiffrez les données en transit (TLS) et au repos (base et backups). Pour les tokens de session, utilisez des durées courtes et des flows de rafraîchissement ; stockez des hashs quand possible et évitez de logger des prompts ou sorties d'outils en clair par défaut.

Certains utilisateurs exigeront la résidence des données (pays/régions spécifiques), surtout pour des assistants de travail. Planifiez un déploiement conscient des régions tôt : conservez les données utilisateur dans une base alignée régionnellement et évitez les pipelines inter‑région qui copient le contenu ailleurs. Koder.ai fonctionne sur AWS globalement et peut héberger des applications dans des pays spécifiques, ce qui peut simplifier les exigences de résidence et de transferts transfrontaliers quand nécessaire.

Protection contre les abus et défenses contre l'injection de prompt

Les assistants attirent abus : scraping, credential stuffing, attaques visant à faire « révéler des secrets » au modèle. Une base pratique inclut limites de débit et quotas, détection d'activités suspectes, permissions d'outil strictes (allow‑list + validation côté serveur), hygiène d'injection de prompt (traitez le texte externe comme non fiable ; isolez‑le des règles système), et logs d'audit pour l'exécution d'outils et l'accès aux données.

Le but : un comportement prévisible — le modèle peut proposer des actions, mais votre backend décide ce qui est permis.

Déploiement, surveillance et itération sûre

Livrer une application d'assistant personnel n'est pas un moment de lancement unique. C'est un cycle : sortir petit, observer l'usage réel, resserrer le comportement, et répéter — sans rompre la confiance. Parce que les assistants peuvent changer de comportement via un tweak de prompt ou une nouvelle intégration d'outil, vous avez besoin d'une discipline de déploiement qui traite la configuration et les prompts comme du code production.

Expédier progressivement avec des feature flags

Supposez que chaque nouvelle capacité peut échouer de façon surprenante : bugs de timezone, mémoire écrivant la mauvaise information, ou un modèle devenant plus créatif que souhaité. Les feature flags permettent d'exposer de nouveaux outils et comportements mémoire à une petite tranche d'utilisateurs (ou comptes internes) avant un déploiement large.

Stratégie simple : gatez chaque intégration d'outil, gatez séparément les écritures mémoire des lectures, activez le mode planification seulement pour les testeurs, ajoutez un « safe mode » qui désactive les appels d'outils (contexte en lecture seule), et utilisez des rollouts en pourcentage pour les changements risqués.

Le rollback n'est pas optionnel : snapshottez prompts et config

Les apps traditionnelles rollbackent des binaires ; les apps d'assistant doivent aussi rollbacker du comportement. Traitez les instructions système, schémas d'outils, règles de routage, politiques de sécurité et filtres mémoire comme des artefacts versionnés. Gardez des snapshots pour restaurer rapidement un comportement connu bon.

Ceci est particulièrement utile quand vous itérez rapidement en vibe-coding : Koder.ai supporte snapshots et rollback, ce qui convient aux assistants où de petites éditions textuelles peuvent avoir de grands impacts produit.

Stratégie de déploiement et domaines personnalisés

Si vous proposez un assistant en marque blanche (pour équipes ou clients), prévoyez les domaines personnalisés tôt. Cela affecte callbacks d'auth, réglages de cookies/sessions, limites de débit par tenant, et comment vous séparez logs et données. Même pour une marque unique, définissez des environnements (dev/staging/prod) pour tester permissions d'outils et paramètres de modèle en toute sécurité.

Surveillez ce qui compte : fiabilité, vitesse et coût

La surveillance d'un assistant est à la fois analytique produit et opérations. Suivez latence et erreurs, mais aussi signaux comportementaux comme coût par conversation, fréquence d'appels d'outil et taux d'échec d'outils. Associez ces métriques à des audits d'échantillons de conversations pour voir si les changements ont amélioré les résultats — pas seulement le débit.

Construire plus vite avec le Vibe Coding (exemple : workflow Koder.ai)

Le vibe coding est le plus utile quand vous avez besoin d'un prototype réel — pas d'un diaporama. Pour un assistant personnel, cela signifie habituellement une UI de chat, quelques actions centrales (capturer une tâche, sauvegarder une note, planifier un rappel), et un backend qui reste déterministe même si le LLM est créatif. Une plateforme de vibe-coding compresse le délai de mise en place en transformant votre description produit en écrans, routes et services exécutables que vous pouvez lancer et affiner.

Workflow pratique de type Koder.ai

Commencez par décrire l'assistant en langage clair dans le chat : pour qui il est, ce qu'il fait, et à quoi ressemble le « fait » pour le MVP. Itérez par petites étapes.

Générez d'abord une interface web React (vue conversation, composer de message, panneau léger « outils utilisés », et une page de paramètres simple), puis une version mobile Flutter une fois les flux stabilisés.

Ensuite, générez un backend Go avec PostgreSQL : authentification, API minimale pour conversations, et endpoints d'outils (create task, list tasks, update task). Gardez le comportement LLM comme une couche fine : instructions système, schéma d'outil et garde‑fous. À partir de là, itérez prompts et UI ensemble : quand l'assistant fait une mauvaise hypothèse, ajustez le texte de comportement et ajoutez une étape de confirmation dans l'UX.

Fonctionnalités utiles quand vous itérez vite

Priorisez les accélérateurs de workflow qui gardent l'expérimentation sûre : mode planification (proposer avant d'appliquer), snapshots et rollback (récupération rapide d'itérations mauvaises), déploiement et hébergement avec domaines personnalisés (accès rapide pour les parties prenantes), et export du code source (pour garder la propriété complète et migrer vers un pipeline long terme plus tard).

Checklist étapes suivantes

Avant de passer au‑delà du MVP, verrouillez :

- Une spec MVP d'une page (3–5 jobs utilisateurs, non-objectifs, critères de succès)

- Votre liste d'outils (ce que l'assistant est autorisé à faire via des APIs)

- Un petit ensemble d'évaluation (20–50 scénarios + résultats attendus)

- Un plan de déploiement (environnements, secrets, stratégie de rollback, monitoring)

Avec cette structure, Koder.ai (koder.ai) peut être une façon pratique de passer du concept à un assistant fonctionnel React/Go/PostgreSQL (puis Flutter) rapidement, tout en gardant le comportement testable et réversible.