Pourquoi cette histoire importe pour les équipes qui font tourner des logiciels

Les équipes ne peinent pas parce qu'elles ne savent pas démarrer un conteneur. Elles peinent parce qu'elles doivent en exploiter des centaines en toute sécurité, les mettre à jour sans interruption, récupérer quand quelque chose casse, et continuer à livrer des fonctionnalités dans les temps.

L'histoire « cloud-native » de Craig McLuckie importe parce qu'elle n'est pas une célébration de démos tape‑à‑l'œil. C'est le récit de la façon dont les conteneurs sont devenus opérables dans des environnements réels — là où surviennent des incidents, où il y a des contraintes de conformité, et où l'entreprise exige une livraison prévisible.

Cloud-native, en termes simples

« Cloud-native » n'est pas « exécuter dans le cloud ». C'est une approche pour construire et exploiter des logiciels afin qu'ils puissent être déployés fréquemment, mis à l'échelle quand la demande change, et réparés rapidement quand des parties tombent en panne.

En pratique, cela signifie généralement :

- Des applications empaquetées et livrées de manière cohérente (souvent via des conteneurs)

- Des systèmes conçus en petits services plutôt qu'en une seule grosse release

- De l'automatisation pour les déploiements, la mise à l'échelle et les rollbacks

- Des méthodes standard pour observer, sécuriser et gouverner ce qui tourne

L'adoption précoce des conteneurs ressemblait souvent à une boîte à outils : les équipes prenaient Docker, bricolaient des scripts, et espéraient que l'exploitation suive. La pensée plateforme inverse cela. Au lieu que chaque équipe invente son propre chemin vers la production, on construit des pistes pavées partagées — une plateforme qui rend la voie sûre, conforme et observable aussi la voie la plus simple.

Ce basculement est le pont entre « nous savons exécuter des conteneurs » et « nous pouvons faire fonctionner une activité dessus ».

À qui s'adresse cet article

Ceci est pour les personnes responsables des résultats, pas seulement des schémas d'architecture :

- Les dirigeants techniques qui équilibrent vitesse et fiabilité

- Les équipes produit qui veulent itérer plus vite sans pannes

- Les équipes plateforme, DevOps et SRE qui cherchent à réduire le travail répétitif et les frictions

- Les développeurs qui veulent que les déploiements deviennent ennuyeux et répétables

Si votre objectif est une livraison fiable à l'échelle, cette histoire contient des leçons pratiques.

Qui est Craig McLuckie (et pourquoi on le cite)

Craig McLuckie est l'un des noms les plus connus liés au mouvement cloud-native naissant. Vous le verrez évoqué dans les conversations sur Kubernetes, la Cloud Native Computing Foundation (CNCF), et l'idée que l'infrastructure doit être traitée comme un produit — pas comme une pile de tickets et de connaissances tribales.

Pas « l'inventeur », mais un bâtisseur clé

Il est important d'être précis. McLuckie n'a pas « inventé le cloud-native » tout seul, et Kubernetes n'a jamais été un projet d'une seule personne. Kubernetes a été créé par une équipe chez Google, et McLuckie faisait partie de cet effort initial.

On lui attribue souvent d'avoir aidé à transformer un concept d'ingénierie en quelque chose que l'industrie pouvait réellement adopter : un meilleur travail communautaire, un empaquetage plus clair, et une poussée vers des pratiques opérationnelles répétables.

Un thème constant : fiabilité par répétabilité

À travers Kubernetes et l'ère CNCF, le message de McLuckie a moins porté sur l'architecture à la mode que sur la prévisibilité en production. Cela signifie :

- Des façons standard de déployer et de revenir en arrière

- Des environnements cohérents du poste développeur à la production

- Des garde‑fous opérationnels qui réduisent les surprises

Si vous avez entendu des expressions comme « pistes pavées », « chemins dorés » ou « plateforme comme produit », vous tournez autour de la même idée : réduire la charge cognitive des équipes en rendant la bonne chose la chose la plus simple à faire.

Pourquoi il est mentionné ici

Ce billet n'est pas une biographie. McLuckie sert de point de référence utile parce que son travail se situe à l'intersection de trois forces qui ont changé la livraison logicielle : conteneurs, orchestration et construction d'écosystèmes. Les leçons ici ne portent pas sur la personnalité — elles expliquent pourquoi la pensée plateforme a été le déverrouillage pour exécuter des conteneurs en production réelle.

Avant le cloud-native : les conteneurs existaient, la production était difficile

Les conteneurs étaient une idée enthousiasmante bien avant que « cloud-native » ne devienne un label courant. Concrètement, un conteneur est un moyen d'empaqueter une application avec les fichiers et bibliothèques dont elle a besoin pour tourner de la même manière sur différentes machines — comme expédier un produit dans une boîte scellée avec toutes les pièces à l'intérieur.

Pourquoi l'usage initial des conteneurs est resté expérimental

Au début, de nombreuses équipes utilisaient les conteneurs pour des projets secondaires, des démos et des flux de travail développeur. Ils étaient parfaits pour essayer rapidement de nouveaux services, créer des environnements de test, et éviter les « ça marche sur ma machine » au moment du transfert.

Mais passer d'une poignée de conteneurs à un système de production qui tourne 24/7 est un autre travail. L'outillage existait, mais le récit opérationnel était incomplet.

Les blocages en production rencontrés par les équipes

Les problèmes courants sont apparus rapidement :

- Mises à niveau et rollbacks : comment mettre à jour des dizaines (ou centaines) de conteneurs en cours d'exécution de manière sûre, sans interruption ? Et comment revenir en arrière quand quelque chose casse ?

- Réseau : les conteneurs doivent se trouver de manière fiable. La découverte de service, le routage, l'équilibrage de charge et les règles « qui peut communiquer avec qui » n'étaient pas standardisés.

- Sécurité : provenance des images, gestion des secrets, contrôles d'accès et correction des vulnérabilités sont devenus un travail continu — pas une configuration unique.

- Monitoring et debug : une fois qu'un conteneur redémarre, les logs peuvent disparaître. Les métriques, le tracing et l'alerte devaient être conçus pour un monde où les processus sont de courte durée.

De « ça marche sur ma machine » à « tourne chaque jour à l'échelle »

Les conteneurs ont aidé à rendre le logiciel portable, mais la portabilité seule ne garantissait pas la fiabilité. Les équipes avaient toujours besoin de pratiques de déploiement cohérentes, d'une propriété claire et de garde‑fous opérationnels — pour que les applications conteneurisées ne tournent pas seulement une fois, mais tournent de manière prévisible chaque jour.

La pensée plateforme, c'est le moment où une entreprise cesse de traiter l'infrastructure comme un projet ponctuel et commence à la considérer comme un produit interne. Les « clients » sont vos développeurs, équipes data, et toute personne qui livre du logiciel. L'objectif produit n'est pas d'avoir plus de serveurs ou plus de YAML — c'est d'avoir un chemin plus fluide de l'idée à la production.

Une vraie plateforme a une promesse claire : « Si vous construisez et déployez en suivant ces chemins, vous obtiendrez fiabilité, sécurité et livraison prévisible. » Cette promesse exige des habitudes produit — documentation, support, gestion des versions et boucles de retour. Elle exige aussi une expérience utilisateur délibérée : valeurs par défaut sensées, pistes pavées, et une issue de secours quand une équipe a vraiment besoin de s'en écarter.

Pourquoi la standardisation accélère la livraison (et réduit le risque)

La standardisation supprime la fatigue décisionnelle et empêche la complexité accidentelle. Quand les équipes partagent les mêmes patterns de déploiement, de logging et de contrôles d'accès, les problèmes deviennent reproductibles — et donc résolubles. Les rotations d'astreinte s'améliorent parce que les incidents se ressemblent. Les revues de sécurité vont plus vite parce que la plateforme intègre des garde‑fous plutôt que chaque équipe ne les réinvente.

Il ne s'agit pas d'enfermer tout le monde dans la même boîte. Il s'agit de s'accorder sur les 80 % qui doivent être ennuyeux, pour que les équipes puissent consacrer leur énergie aux 20 % qui différencient le business.

Des serveurs artisanaux à des patterns répétables

Avant les approches plateformes, l'infrastructure reposait souvent sur un savoir-faire particulier : quelques personnes savaient quels serveurs étaient patchés, quelles configurations étaient sûres, et quels scripts étaient « les bons ». La pensée plateforme remplace cela par des patterns répétables : templates, provisionnement automatisé et environnements cohérents du développement à la production.

Gouvernance sans bureaucratie

Bien faite, une plateforme crée une meilleure gouvernance avec moins de paperasserie. Les politiques deviennent des contrôles automatisés, les approbations des workflows audités, et les preuves de conformité sont générées lors des déploiements — l'organisation gagne du contrôle sans ralentir tout le monde.

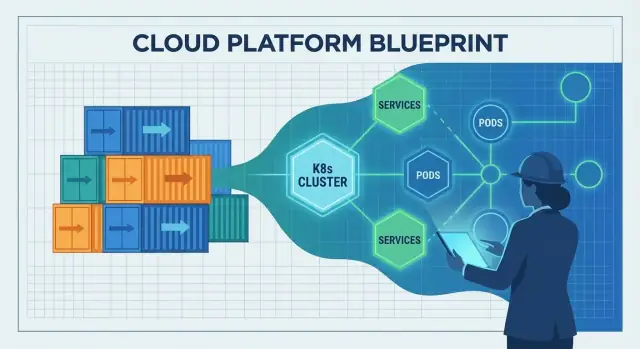

Kubernetes comme pont des conteneurs vers l'exploitation

Les conteneurs facilitaient l'empaquetage et la livraison d'une appli. La partie difficile arrivait après : choisir où elle doit tourner, la maintenir en bonne santé, et s'adapter quand le trafic ou l'infrastructure change. C'est le fossé que Kubernetes a comblé. Il a transformé « une pile de conteneurs » en quelque chose qu'on peut exploiter jour après jour, même quand des serveurs tombent, des releases arrivent, et la demande flambe.

Ce que l'orchestration résout réellement

Kubernetes est souvent décrit comme de l'« orchestration de conteneurs », mais les problèmes pratiques sont plus concrets :

- Ordonnancement : décider quelle machine doit exécuter chaque conteneur, selon CPU/mémoire disponibles et règles de placement.

- Auto-réparation : redémarrer les conteneurs plantés, les replanifier si un nœud meurt, et maintenir le nombre désiré d'instances.

- Mise à l'échelle : augmenter ou diminuer les réplicas selon la demande, et déployer de nouvelles versions sans tout arrêter.

Sans orchestrateur, les équipes finissent par écrire des scripts pour ces comportements et gérer les exceptions à la main — jusqu'à ce que les scripts ne correspondent plus à la réalité.

Un plan de contrôle commun

Kubernetes a popularisé l'idée d'un plan de contrôle partagé : un endroit où vous déclarez ce que vous voulez (« exécutez 3 copies de ce service ») et la plateforme travaille en continu pour aligner le monde réel sur cette intention.

C'est un grand changement de responsabilités :

- Les développeurs déploient : construisent une image, appliquent une ressource, définissent des requests, et des probes de santé.

- La plateforme maintient : place les charges, remplace les instances défaillantes, équilibre les déploiements et maintient la découverte de services.

Construit à partir de patterns opérationnels réels

Kubernetes n'est pas apparu parce que les conteneurs étaient à la mode. Il a grandi à partir des leçons tirées de l'exploitation de flottes larges : traiter l'infrastructure comme un système avec des boucles de rétroaction, pas comme un ensemble de tâches serveurs uniques. Cet état d'esprit opérationnel explique pourquoi il est devenu le pont entre « on sait exécuter des conteneurs » et « on peut les exécuter de façon fiable en production ».

Ce que le « cloud-native » a changé dans la livraison quotidienne

Gagnez des crédits en apprenant

Obtenez des crédits pour le contenu ou les parrainages pendant que vous explorez Koder.ai.

Cloud-native n'a pas seulement introduit de nouveaux outils — il a changé le rythme quotidien de la livraison. Les équipes sont passées des « serveurs artisanaux et runbooks manuels » à des systèmes conçus pour être pilotés par des API, de l'automatisation et de la configuration déclarative.

Des tickets et SSH aux API et à l'automatisation

Une configuration cloud-native suppose que l'infrastructure est programmable. Besoin d'une base de données, d'un load balancer ou d'un nouvel environnement ? Plutôt que d'attendre une configuration manuelle, les équipes décrivent ce qu'elles veulent et laissent l'automatisation le provisionner.

Le changement clé est la configuration déclarative : vous définissez l'état désiré (« exécutez 3 copies de ce service, exposez-le sur ce port, limitez la mémoire à X ») et la plateforme travaille continuellement pour atteindre cet état. Cela rend les changements relisables, répétables et plus faciles à annuler.

Les déploiements immutables réduisent la dérive

La livraison traditionnelle impliquait souvent de patcher des serveurs en production. Avec le temps, chaque machine devenait un peu différente — une dérive de configuration qui n'apparaît qu'en cas d'incident.

La livraison cloud-native pousse vers les déploiements immutables : construire un artefact une fois (souvent une image conteneur), le déployer, et pour tout changement livrer une nouvelle version plutôt que modifier ce qui tourne. Combiné à des rollouts automatisés et des checks de santé, cela réduit les « pannes mystères » causées par des correctifs ponctuels.

Microservices et conteneurs : une boucle d'accroissement (avec compromis)

Les conteneurs ont facilité l'empaquetage et l'exécution de nombreux petits services de façon cohérente, ce qui a encouragé les architectures microservices. Les microservices, à leur tour, augmentent le besoin de déploiement cohérent, de mise à l'échelle et de découverte de services — domaines où l'orchestration excelle.

Le compromis : plus de services entraîne plus de charges opérationnelles (monitoring, réseau, versioning, réponse aux incidents). Le cloud-native aide à gérer cette complexité, mais ne l'efface pas.

Portabilité : réelle, mais pas magique

La portabilité s'est améliorée parce que les équipes se sont standardisées sur des primitives et des API communes. Néanmoins, « exécuter n'importe où » demande du travail — différences de sécurité, stockage, réseau et services managés comptent. Cloud-native réduit le verrouillage et les frictions, il ne les élimine pas.

CNCF et l'effet écosystème : pourquoi cela a accéléré l'adoption

Kubernetes ne s'est pas diffusé uniquement parce qu'il était puissant. Il s'est diffusé parce qu'il a trouvé un foyer neutre, une gouvernance claire, et un lieu où des entreprises concurrentes pouvaient coopérer sans qu'un fournisseur unique « impose » les règles.

Un fond neutre rend la collaboration plus sûre

La Cloud Native Computing Foundation (CNCF) a instauré une gouvernance partagée : une prise de décision ouverte, des processus de projet prévisibles, et des roadmaps publiques. Cela compte pour les équipes qui misent sur une infrastructure centrale. Quand les règles sont transparentes et non liées au modèle économique d'une seule entreprise, l'adoption semble moins risquée — et les contributions deviennent plus attractives.

Le rôle de la CNCF : plus qu'un simple label

En hébergeant Kubernetes et des projets associés, la CNCF a aidé à transformer « un outil open source populaire » en une plateforme durable avec un soutien institutionnel. Elle a fourni :

- Une manière cohérente de gérer les mainteneurs, les releases et les pratiques de sécurité

- Un lieu de coordination inter‑entreprises

- Un signal au marché : ce projet est conçu pour survivre à un seul vendeur

Standards ouverts et contributeurs larges

Avec de nombreux contributeurs (cloud providers, startups, entreprises et ingénieurs indépendants), Kubernetes a évolué plus vite et dans des directions plus réalistes : réseau, stockage, sécurité et opérations de jour‑2. Les API ouvertes et les standards ont facilité l'intégration d'outils, réduisant le verrouillage et renforçant la confiance pour un usage en production.

L'effet écosystème (et son compromis)

La CNCF a aussi accéléré une explosion d'écosystèmes : service meshes, contrôleurs d'ingress, outils CI/CD, moteurs de politique, stacks d'observabilité, et plus encore. Cette abondance est une force — mais elle crée du recouvrement.

Pour la plupart des équipes, le succès vient du choix d'un petit ensemble de composants bien soutenus, en favorisant l'interopérabilité et en clarifiant la propriété. Une approche « le meilleur de tout » mène souvent à une charge de maintenance plutôt qu'à une meilleure livraison.

Des outils à la fiabilité : la couche opérationnelle manquante

Lancer un MVP de plateforme

Générez une application web fonctionnelle, un backend et une base PostgreSQL en une session.

Les conteneurs et Kubernetes ont résolu une grande partie de la question « comment exécuter du logiciel ? ». Ils n'ont pas automatiquement résolu la question plus difficile : « comment le maintenir en fonctionnement quand de vrais utilisateurs arrivent ? » La couche manquante, c'est la fiabilité opérationnelle — attentes claires, pratiques partagées, et un système qui rend les bons comportements par défaut.

Définir le référentiel de production

Une équipe peut livrer rapidement et rester à un déploiement de la catastrophe si le référentiel de production n'est pas défini. Au minimum, il faut :

- Observabilité : capacité à voir ce qui se passe et pourquoi (pas seulement si c'est « up »)

- Réponse aux incidents : rôles, astreintes, chemins d'escalade et revues post‑incident

- Planification de capacité : comprendre la charge, les limites et le comportement sous contrainte

Sans ce socle, chaque service invente ses propres règles, et la fiabilité devient une question de chance.

DevOps et SRE ont introduit des habitudes importantes : ownership, automatisation, fiabilité mesurée et apprentissage des incidents. Mais les habitudes seules ne montent pas à l'échelle sur des dizaines d'équipes et des centaines de services.

Les plateformes rendent ces pratiques répétables. SRE fixe des objectifs (par ex. SLOs) et des boucles de rétroaction ; la plateforme fournit des pistes pavées pour les atteindre.

Les composants « table stakes » de la fiabilité

La livraison fiable exige généralement un ensemble cohérent de capacités :

- Logging, métriques, tracing (pour déboguer et améliorer)

- Alerting lié à l'impact utilisateur (pour que l'astreinte ne soit pas du bruit)

- Rollbacks sûrs et patterns de déploiement progressifs (pour que les échecs ne soient pas catastrophiques)

Une bonne plateforme intègre ces valeurs par défaut dans des templates, pipelines et politiques runtime : dashboards standards, règles d'alerte communes, garde‑fous de déploiement et mécanismes de rollback. C'est ainsi que la fiabilité cesse d'être optionnelle et devient un résultat prévisible du fait de livrer du logiciel.

L'outillage cloud-native peut être puissant tout en semblant « trop » pour la plupart des équipes produit. L'ingénierie plateforme existe pour combler cet écart. La mission est simple : réduire la charge cognitive des équipes applicatives pour qu'elles livrent des fonctionnalités sans devenir des experts infrastructure à mi‑temps.

Une bonne équipe plateforme considère l'infrastructure interne comme un produit. Cela implique des utilisateurs clairs (les développeurs), des résultats clairs (livraison sûre et répétable) et une boucle de retour. Plutôt que de livrer une pile de primitives Kubernetes, la plateforme propose des manières opinionnées de construire, déployer et exploiter des services.

Une question pratique : « Un développeur peut‑il passer de l'idée à un service en fonctionnement sans ouvrir une douzaine de tickets ? » Les outils qui compressent ce flux — tout en préservant des garde‑fous — sont alignés avec l'objectif plateforme cloud‑native.

Briques pour rendre le cloud-native pratique

La plupart des plateformes sont un ensemble de « pistes pavées » réutilisables que les équipes peuvent choisir par défaut :

- Templates et scaffolding pour nouveaux services (structure de repo, CI, observabilité de base)

- Flux en libre-service (créer un environnement, demander une base de données, faire tourner la rotation des secrets)

- Patterns de déploiement standard (ingress, autoscaling, probes de santé, déploiements canari)

Le but n'est pas de cacher Kubernetes : c'est de l'emballer dans des valeurs par défaut sensées qui évitent la complexité accidentelle.

Dans cet esprit, Koder.ai peut servir de couche d'« accélérateur DX » pour les équipes qui veulent lancer rapidement des outils internes ou des fonctionnalités produit via le chat, puis exporter le code source quand il est temps d'intégrer une plateforme plus formelle. Pour les équipes plateforme, son mode planning et ses snapshots/rollback intégrés peuvent aussi refléter la posture orientée fiabilité souhaitée dans les flux de production.

Compromis : flexibilité vs cohérence

Chaque piste pavée est un compromis : plus de cohérence et d'opérations plus sûres, mais moins d'options ad hoc. Les équipes plateforme réussissent mieux quand elles proposent :

- un chemin doré pour 80 % des services

- une issue de secours pour les cas limites légitimes (avec une propriété explicite)

Signes que ça fonctionne

Le succès d'une plateforme se voit par des signes mesurables : intégration plus rapide des nouveaux ingénieurs, moins de scripts de déploiement sur mesure, moins de clusters « snowflake », et une propriété claire lors des incidents. Si les équipes peuvent répondre « qui possède ce service et comment on le déploie ? » sans réunion, la plateforme remplit son rôle.

Ce qui tourne mal : pièges qui freinent le progrès cloud-native

Cloud-native peut accélérer la livraison et calmer l'exploitation — mais seulement quand les équipes savent ce qu'elles cherchent à améliorer. Beaucoup de ralentissements arrivent quand Kubernetes et son écosystème sont traités comme la finalité, pas comme le moyen.

1) Kubernetes d'abord, objectifs ensuite

Une erreur courante est d'adopter Kubernetes parce que « c'est ce que font les équipes modernes », sans cible concrète comme un lead time plus court, moins d'incidents, ou une meilleure cohérence des environnements. Le résultat : beaucoup de travail de migration sans bénéfice visible.

Si les critères de réussite ne sont pas définis en amont, chaque décision devient subjective : quel outil choisir, combien standardiser, quand la plateforme est‑elle « prête ».

2) Accroissement de la complexité via l'écosystème

Kubernetes est une base, pas une plateforme complète. Les équipes ajoutent souvent des add-ons rapidement — service mesh, multiples contrôleurs d'ingress, opérateurs custom, moteurs de politique — sans frontières ou responsabilités claires.

La surpersonnalisation est un autre piège : patterns YAML sur mesure, templates bricolés, et exceptions que seules les personnes d'origine comprennent. La complexité augmente, l'onboarding ralentit, et les upgrades deviennent risqués.

3) Coût, dispersion et angles morts sécurité

Le cloud-native facilite la création de ressources — et facilite aussi leur oubli. La prolifération de clusters, les namespaces inutilisés et les workloads sur‑dimensionnés gonflent les coûts discrètement.

Les écueils sécurité sont tout aussi fréquents :

- Permissions qui s'élargissent avec le temps (RBAC trop larges, comptes partagés)

- Risque de chaîne d'approvisionnement (images non validées, trop de charts tiers)

- Politiques incohérentes entre clusters et environnements

Commencez petit avec un ou deux services bien cadrés. Définissez des standards tôt (chemins dorés, images de base approuvées, règles de mise à jour) et limitez volontairement la surface de la plateforme.

Mesurez des résultats comme fréquence de déploiement, temps moyen de récupération, et temps pour qu'un développeur fasse son premier déploiement — et traitez tout ce qui n'améliore pas ces indicateurs comme optionnel.

Une feuille de route pratique pour appliquer ces leçons

Publier en toute sécurité

Effectuez des modifications en toute sécurité grâce aux instantanés et aux itérations en étapes dans le chat.

On n'« adopte » pas le cloud-native en une seule fois. Les équipes qui réussissent suivent l'idée centrale associée à l'ère McLuckie : construire une plateforme qui rend la bonne voie la voie la plus simple.

Un parcours d'adoption simple

Commencez petit, puis codifiez ce qui marche.

- Pilote : choisissez un service suffisamment problématique pour justifier le changement, mais pas critique pour le business. Conteneurisez‑le, automatisez les builds, et déployez‑le à répétition jusqu'à ce que cela devienne routinier.

- MVP plateforme : transformez les apprentissages du pilote en une plateforme interne légère : templates standards, un chemin de déploiement pavé, observabilité basique, et un modèle de propriété clair.

- Étendre : onboardez plus d'équipes et de services en utilisant ces mêmes valeurs par défaut. Privilégiez la cohérence plutôt que la personnalisation.

- Optimiser : ajoutez des politiques, contrôles de coûts, workflows d'incidents et fonctionnalités en libre‑service une fois les bases stabilisées.

Si vous testez de nouveaux flux, un pattern utile est de prototyper l'expérience « chemin doré » de bout en bout avant de la standardiser. Par exemple, des équipes peuvent utiliser Koder.ai pour générer rapidement une appli web (React), un backend (Go) et une base (PostgreSQL) via le chat, puis prendre ce code comme point de départ pour les templates et conventions CI/CD de la plateforme.

Questions de décision pour rester honnête

Avant d'ajouter un outil, demandez :

- Pourquoi des conteneurs ? Quelle friction éliminez‑vous (dérive d'environnement, empaquetage, portabilité) et quel nouveau travail acceptez‑vous ?

- Pourquoi l'orchestration ? Avez‑vous vraiment besoin d'auto‑scaling, de rollouts automatisés et de résilience, ou une automatisation plus simple suffirait‑elle ?

- Pourquoi maintenant ? Est‑ce motivé par une douleur de livraison, un risque de fiabilité, ou un objectif produit clair (et non par la mode) ?

Mesures qui montrent un vrai progrès

Suivez des résultats, pas l'utilisation d'outils :

- Fréquence de déploiement et lead time (vitesse de livraison)

- Fiabilité (atteinte des SLO, taux d'incidents, MTTR)

- Satisfaction développeur (petits sondages, temps d'onboarding, « temps jusqu'au premier déploiement »)

Si vous voulez des exemples de ce à quoi ressemblent de bons packages « MVP plateforme », voyez /blog. Pour la budgétisation et la planification du déploiement, vous pouvez aussi consulter /pricing.

La grande leçon de la dernière décennie est simple : les conteneurs n'ont pas « gagné » parce qu'ils étaient un emballage astucieux. Ils ont gagné parce que la pensée plateforme les a rendus exploitables — déploiements répétables, rollouts sûrs, contrôles de sécurité cohérents et opérations prévisibles.

Le prochain chapitre ne portera pas sur un outil unique révolutionnaire. Il portera sur rendre le cloud-native ennuyeux dans le meilleur sens : moins de surprises, moins de solutions ponctuelles, et un chemin plus fluide du code à la production.

À surveiller

Policy-as-code devient la norme. Plutôt que de revoir chaque déploiement manuellement, les équipes codifient les règles de sécurité, réseau et conformité pour que les garde‑fous soient automatiques et audités.

L'expérience développeur (DX) est traitée comme un produit. Attendez‑vous à plus d'attention aux pistes pavées : templates, environnements en libre‑service, et chemins dorés qui réduisent la charge cognitive sans limiter l'autonomie.

Des opérations plus simples, pas plus de dashboards. Les meilleures plateformes masqueront la complexité : valeurs par défaut opinionnées, moins d'éléments en mouvement, et patterns de fiabilité intégrés plutôt que greffés.

Évitez la tentation de collectionner les outils

Le progrès cloud-native ralentit quand les équipes poursuivent des fonctionnalités plutôt que des résultats. Si vous ne pouvez pas expliquer comment un nouvel outil réduit le lead time, diminue le taux d'incidents ou améliore la posture de sécurité, ce n'est probablement pas une priorité.

Une prochaine étape claire

Évaluez vos douleurs actuelles en livraison et mappez‑les aux besoins de la plateforme :

- Où les déploiements échouent‑ils ou ralentissent‑ils le plus souvent ?

- Quelles approbations et vérifications devraient devenir des garde‑fous automatisés ?

- Qu'est‑ce que les développeurs reconstruisent sans cesse (et qui pourrait être standardisé) ?

Considérez ces réponses comme votre backlog plateforme — et mesurez le succès par les résultats que vos équipes ressentent chaque semaine.