Ce que vous construisez et pourquoi c’est important

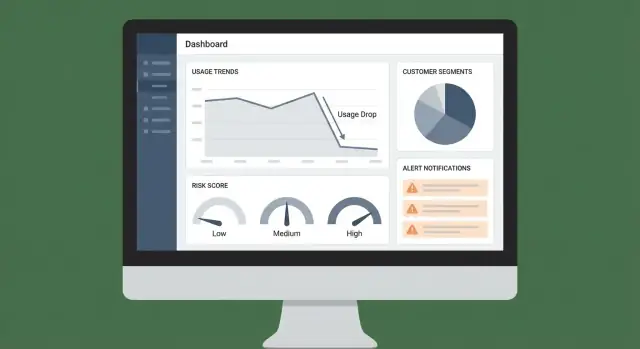

Ce projet est une application web qui vous aide à repérer tôt les baisses d’utilisation significatives d’un client — avant qu’elles ne se transforment en désabonnement. Plutôt que d’attendre une conversation de renouvellement pour découvrir un problème, l’application met en évidence un signal clair (ce qui a changé, quand et de combien) et invite la bonne équipe à réagir.

L’objectif : détection plus précoce, meilleure rétention

Les diminutions d’utilisation apparaissent souvent des semaines avant une demande d’annulation. Votre application doit rendre ces diminutions visibles, explicables et exploitables. Le but pratique est simple : réduire le churn en détectant le risque plus tôt et en répondant de façon cohérente.

Pour qui (et ce que chaque groupe attend)

Différentes équipes cherchent des « vérités » différentes dans les mêmes données. Concevoir avec ces utilisateurs en tête évite que l’app ne devienne juste un autre tableau de bord.

- Customer Success a besoin d’une vue priorisée des comptes nécessitant une attention, avec suffisamment de contexte pour initier un contact informé.

- Ventes (surtout les account managers) a besoin de flags orientés renouvellement et d’arguments pour soutenir une expansion ou une opération de sauvetage.

- Produit et analytics ont besoin de tendances agrégées qui mettent en avant les frictions, les lacunes d’adoption ou les fonctionnalités dont la valeur ne se matérialise pas.

Les résultats que vous délivrez

Au minimum, l’app doit produire :

- Un tableau de santé client avec tendances d’utilisation récentes et indicateurs de risque

- Des alertes quand un compte franchit un seuil significatif (baisse, inactivité ou changement de pattern)

- Des « prochaines meilleures actions » qui suggèrent quoi faire ensuite (message, appel, formation, correction, ou escalade interne)

C’est la différence entre « des données quelque part » et « un workflow que les gens suivent vraiment ».

Définissez le succès comme un produit : avec des métriques.

- Précision : parmi les comptes alertés, combien étaient réellement à risque ?

- Temps de réponse : à quelle vitesse l’équipe engage‑t‑elle après un signal ?

- Impact business : renouvellements sauvés, churn réduit, ou expansions protégées

Si l’app améliore les décisions et accélère l’action, elle gagnera de l’adoption — et s’autofinancera.

Définir les baisses d’utilisation et l’unité client

Avant de détecter une « baisse d’utilisation », vous devez définir précisément l’utilisation et une unité de mesure cohérente. Il s’agit moins d’un jargon analytique que d’éviter les faux positifs (ou de manquer de vrais risques de churn).

Ce que « utilisation » devrait signifier

Choisissez une métrique d’usage primaire qui reflète la valeur réelle délivrée. Les bonnes options dépendent de votre produit :

- Événements clés : ex. rapports créés, messages envoyés, déploiements complétés

- Sessions ou jours actifs : utile quand de nombreuses actions sont légères

- Minutes / consommation : courant pour la vidéo, la téléphonie, le calcul ou les outils API‑lourds

- Sièges actifs : nombre d’utilisateurs distincts ayant accompli un travail significatif

Visez une métrique difficile à « manipuler » et fortement liée à l’intention de renouvellement. Vous pouvez suivre plusieurs métriques plus tard, mais commencez par une que vous pouvez expliquer en une phrase.

L’unité client : qui « décroche » ?

Définissez l’entité que vous scorez et sur laquelle vous alertez :

- Compte/espace de travail (le plus courant en B2B)

- Abonnement (utile lorsqu’une entreprise a plusieurs plans)

- Cohorte au sein d’un compte (ex. un département) si l’adoption varie fortement

Ce choix affecte tout : agrégation, tableaux de bord, propriété et routage des alertes.

Ce qui compte comme une « baisse »

Fixez des seuils qui correspondent au comportement client :

- Changement semaine‑sur‑semaine (simple et explicable)

- Moyenne mobile vs moyenne mobile antérieure (réduit le bruit)

- Baselines conscientes de la saisonnalité (critique pour les motifs semaine/week‑end)

Décidez aussi de votre fenêtre temporelle (quotidienne vs hebdomadaire) et de la latence de reporting acceptable (ex. « alertes avant 9h le lendemain » vs temps réel). Des définitions claires ici évitent la fatigue d’alerte et rendent les scores fiables.

Choisir les sources de données et l’approche d’intégration

Votre app n’est fiable que si les entrées qu’elle observe le sont. Avant de construire des tableaux ou scorer le risque, décidez quels systèmes définissent « utilisation », « valeur » et « contexte client » pour votre activité.

Choisissez l’ensemble minimal de sources

Commencez avec un ensemble resserré de sources que vous pouvez maintenir exactes :

- Événements produit : connexions, actions clés, appels API, sièges utilisés, exports — tout ce qui corrèle avec la valeur

- Facturation/abonnements : plan, date de renouvellement, statut de paiement, expansions/déclassements, début/fin d’essai

- CRM : propriétaire du compte, segment, stade du cycle, termes contractuels

- Tickets de support : volume, sévérité, temps de réponse, problèmes non résolus

- Historique statut/incidents : pannes et périodes de dégradation qui peuvent expliquer des baisses d’utilisation

Si vous hésitez, priorisez événements produit + facturation ; ajoutez CRM/support une fois la surveillance de base opérationnelle.

Il existe trois méthodes d’ingestion courantes, et de nombreuses équipes utilisent un mix :

- Webhooks/streaming pour les événements produit et changements d’abonnement quasi‑temps réel

- Imports batch (quotidien/horaires) pour le CRM et les outils de support qui ne nécessitent pas d’updates seconde‑par‑seconde

- Connecteurs ETL/ELT quand vous voulez des syncs gérés depuis des outils comme Salesforce/Zendesk et préférez la consistance au code sur‑mesure

Adaptez la cadence aux décisions que vous automatiserez. Si vous prévoyez d’alerter les CSM sous une heure pour une chute soudaine, l’ingestion événementielle ne peut pas être « une fois par jour ».

Obtenez les identifiants corrects (sinon tout casse)

Les baisses d’utilisation sont détectées par unité client (compte/tenant). Définissez et persistez les mappings tôt :

- Account ID (tenant/workspace) comme clé de regroupement principale

- User IDs liés au compte (les utilisateurs peuvent changer de compte — suivez l’historique)

- Plan IDs / subscription IDs liés aux périodes de facturation

Créez une table/servcie d’identité unique pour que chaque intégration résolve vers le même compte.

Documentez la propriété et les accès en amont

Notez qui possède chaque jeu de données, comment il est mis à jour et qui peut le consulter. Cela évite des blocages au lancement lorsque vous ajoutez des champs sensibles (détails de facturation, notes support) ou devez expliquer des métriques aux parties prenantes.

Modéliser les données pour métriques, signaux et historique

Un bon modèle de données garde votre app rapide, explicable et facile à étendre. Vous ne stockez pas seulement des événements — vous stockez des décisions, des preuves et une trace de ce qui s’est passé.

Entités principales (la « source de vérité »)

Commencez par quelques tables stables que tout le reste référence :

- accounts : account_id, name, plan, status, timezone, CSM owner

- users : user_id, account_id, role, created_at, last_seen_at

- subscriptions : account_id, start/end dates, MRR, seats, renewal date

- events : event_id, occurred_at, user_id, account_id, event_name, properties (JSON)

Gardez les IDs cohérents entre systèmes (CRM, facturation, produit) pour pouvoir joindre sans approximations.

Agrégation pour la rapidité : métriques journalières et usage par fonctionnalité

Interroger les événements bruts pour chaque vue de tableau devient vite coûteux. Pré‑calculez des snapshots tels que :

- account_daily_metrics : account_id, date, active_users, sessions, key_actions, time_in_product

- account_feature_daily : account_id, date, feature_key, usage_count (ou minutes, sièges utilisés, etc.)

Cette structure prend en charge à la fois des vues santé haut‑niveau et des investigations par fonctionnalité (« l’utilisation a baissé — où exactement ? »).

Stockez les signaux de risque séparément (avec preuves)

Traitez la détection de risque comme un produit à part entière. Créez une table risk_signals avec :

- signal_type (ex.

usage_drop_30d, no_admin_activity)

- severity (low/med/high)

- timestamp et fenêtre de lookback

- evidence (chiffres, baselines, liens vers des lignes métriques)

Cela garde le scoring transparent : vous pouvez montrer pourquoi l’app a flagué un compte.

Suivez l’historique pour audits et apprentissage

Ajoutez des tables historiques append‑only :

- health_score_history : account_id, computed_at, score, contributing_signals

- alert_history : triggered_at, channel, recipients, dedupe_key

- actions_taken : created_by, action_type, notes, outcome

Avec l’historique, vous pouvez répondre : « Quand le risque a‑t‑il augmenté ? », « Quelles alertes ont été ignorées ? », et « Quels playbooks ont réellement réduit le churn ? »

Instrumenter les événements produit et les contrôles qualité des données

Votre app ne peut pas détecter des baisses si les événements sous‑jacents sont incohérents ou incomplets. Cette section porte sur la fiabilisation des données d’événements pour alimenter dashboards, alertes et signaux de risque.

Définissez un plan de tracking simple

Commencez par une courte liste de comportements qui représentent la valeur :

- Actions clés (ex. « projet créé », « coéquipier invité », « rapport publié »)

- Usage des fonctionnalités (quels modules sont utilisés, à quelle fréquence)

- Signaux de friction (erreurs, paiements échoués, refus de permission)

- Indicateurs de performance (temps de réponse API lent, latence de chargement, timeouts)

Restez pragmatique : si un événement ne servira pas une métrique, une alerte ou un workflow, ne le trackez pas encore.

Standardisez le schéma d’événement

La consistance vaut mieux que la créativité. Utilisez un schéma partagé pour chaque événement :

- event_name (verbe + objet, comme

report_exported)

- timestamp (UTC)

- account_id et user_id (requis si applicable)

- properties (feature, plan, environment, error_code, latency_ms, etc.)

Documentez les propriétés requises par événement dans une spec de tracking légère que l’équipe peut réviser via des pull requests.

Préférez le tracking côté serveur pour les événements critiques

Le tracking client peut être bloqué, perdu ou dupliqué. Pour les événements à forte valeur (changement de facturation, exports réussis, workflows complétés), émettez les événements depuis le backend une fois l’action confirmée.

Ajoutez des contrôles de qualité automatisés

Traitez les problèmes de données comme des bugs produit. Ajoutez des contrôles et alertes pour :

- account_id/user_id manquants ou nuls

- Duplicatas (même clé d’idempotence d’événement)

- Dérive d’horloge (timestamps très dans le futur/past)

- Changements de volume soudains par type d’événement (souvent une release cassée)

Un petit tableau de bord qualité des données et un rapport quotidien à l’équipe préviendront des pannes silencieuses qui saperaient la détection de risque de churn.

Concevoir un scoring de santé client et de risque

Prototypez le tableau de bord santé

Prototypez votre tableau de bord de risque de churn et vos alertes sur Koder.ai à partir d'une simple invite de chat.

Un bon score de santé vise moins à « prédire parfaitement le churn » qu’à aider des humains à décider quoi faire ensuite. Commencez simple, rendez‑le explicable, et faites‑le évoluer en apprenant quels signaux corrèlent vraiment avec la rétention.

Commencez volontairement par un score basé sur des règles

Démarrez avec un petit ensemble de règles claires que tout membre CS, Sales ou Support peut comprendre et déboguer.

Par exemple : « Si l’usage hebdomadaire baisse de 40% par rapport à la moyenne des 4 semaines précédentes, ajoutez des points de risque. » Cette approche rend les désaccords productifs car vous pouvez pointer la règle et le seuil exact.

Ajoutez des signaux pondérés qui reflètent le risque réel

Quand les règles de base fonctionnent, combinez plusieurs signaux avec des poids. Entrées courantes :

- Baisse d’utilisation (activité produit, adoption de fonctionnalités clés, appels API)

- Réduction de sièges (licences supprimées, sièges inactifs en hausse)

- Paiements échoués (factures impayées, refus de carte, statut en retard)

- Pics de tickets (volume support, sévérité, temps de résolution)

Les poids doivent refléter l’impact business et la confiance. Un échec de paiement peut peser plus qu’une légère baisse d’utilisation.

Séparez indicateurs leaders vs retardés

Traitez les indicateurs leaders (changement récent) différemment des indicateurs retardés (risque structurel) :

- Leaders : changement d’utilisation sur les 7–14 derniers jours, pics d’erreurs soudains

- Retardés : proximité de la date de renouvellement, faible adoption sur le long terme

Cela aide l’app à répondre à la fois « Qu’est‑ce qui a changé cette semaine ? » et « Qui est structurellement à risque ? »

Définissez des bandes de score avec actions

Convertissez le score numérique en paliers avec définitions en langage clair :

- Healthy : usage stable ou en croissance ; pas d’issues critiques

- Watch : tendance négative significative ; surveiller et inciter

- At risk : baisse soutenue ou signaux critiques ; outreach urgent

Attachez à chaque palier une action par défaut (propriétaire, SLA et playbook), pour que le score génère un suivi cohérent et non seulement un badge rouge sur un tableau.

Détecter les anomalies et changements d’utilisation significatifs

La détection d’anomalies n’est utile que si elle reflète la façon dont les clients utilisent vraiment votre produit. Le but n’est pas de signaler chaque oscillation — mais de repérer les changements qui prédisent un churn et méritent un suivi humain.

Construisez des baselines réalistes

Utilisez plus d’une baseline pour ne pas sur‑réagir :

- Historique propre au compte : comparez cette semaine aux 4–8 semaines précédentes pour le même compte

- Moyennes de segment : comparez à des clients similaires (tier, industrie, taille, région) pour détecter un « quiet quitting » masqué par une faible utilisation globale

- Saisonnalité : alignez les comparaisons par jour de la semaine ou par mois (ex. week‑end, fin de trimestre). Une approche simple est de comparer à la moyenne du même jour sur les N dernières semaines.

Ces baselines aident à séparer « normal pour eux » de « quelque chose a changé ».

Baisse abrupte vs déclin progressif

Traitez ces cas différemment car les corrections diffèrent :

- Baisses abruptes (ex. -70% semaine‑sur‑semaine, arrêt soudain des événements clés) indiquent souvent une rupture : panne, intégration déconnectée, changement de facturation, départ d’utilisateurs, ou problèmes de permissions.

- Déclin progressif (ex. -10% chaque semaine pendant un mois) pointe en général vers une érosion de valeur : baisse d’engagement, départ du champion, adoption d’un outil concurrent, ou déploiement incomplet.

Votre app devrait étiqueter le pattern, car les playbooks et les propriétaires diffèrent.

Réduire les faux positifs

Les faux positifs détruisent rapidement la confiance. Ajoutez des garde‑fous :

- Seuils d’activité minimum : n’alertez pas les comptes avec un baseline trop faible (ex. <20 événements clés/semaine)

- Périodes de grâce : ignorer les écarts courts après l’onboarding, changements de plan, jours fériés ou incidents connus

- Fenêtres de confirmation : exiger que la baisse persiste 2–3 jours (ou 1–2 semaines pour les produits à faible fréquence)

Rendre chaque flag explicable

Chaque signal de risque doit inclure une preuve : « pourquoi flagué » et « qu’est‑ce qui a changé ». Joignez :

- la baseline utilisée (historique/segment/saisonnalité)

- la métrique et la période (ex. « appels API, 7 derniers jours »)

- le delta et le seuil (ex. « -62% vs moyenne 4 semaines de même jour »)

- les principaux facteurs contributifs (ex. « 3/5 utilisateurs actifs ont arrêté », « l’intégration X a cessé d’envoyer des événements »)

Cela transforme les alertes en décisions, pas en bruit.

Construire l’UI de l’application web : tableaux et vues comptes

Compensez les coûts pendant le développement

Obtenez des crédits en partageant ce que vous avez construit sur Koder.ai ou en invitant des coéquipiers à l'essayer.

Une bonne UI transforme la télémétrie en un workflow quotidien : « Qui a besoin d’attention, pourquoi, et que fait‑on ensuite ? » Gardez les premières écrans opinionées et rapides — la plupart des équipes y vivront.

Essentiels du tableau de bord

Votre tableau doit répondre à trois questions en un coup d’œil :

- Tendances : un graphique simple de l’usage global (et optionnellement par fonctionnalité clé) avec variation semaine‑sur‑semaine

- Top comptes à risque : un tableau classé avec le health score actuel, les plus grands deltas négatifs et les signaux de churn les plus forts

- Alertes récentes : un fil compact montrant ce qui a déclenché, quand, et l’unité cliente affectée

Chaque ligne doit être cliquable vers la vue compte. Privilégiez des patterns de table familiers : colonnes triables, colonnes de risque épinglées et un timestamp clair du dernier état.

Page compte : toute l’histoire

Concevez la vue compte autour d’une timeline pour qu’un CSM comprenne le contexte en quelques secondes :

- Timeline d’utilisation avec annotations (déploiements, changements de plan, événements de facturation)

- Événements clés (jalons d’activation, adoption de fonctionnalités, escalades support)

- Journal des signaux montrant chaque signal de churn : valeur, seuil et moment d’évaluation

- Notes et tâches pour que le travail reste attaché au compte, pas dispersé entre outils

Incluez un pattern de deep link interne comme /accounts/{id} pour que les alertes mènent directement à la vue exacte.

Filtres, export et partage

Le filtrage est ce qui rend un tableau actionnable. Fournissez des filtres globaux pour plan, segment, industrie, propriétaire CSM, région et stade du cycle, et persistez les sélections dans l’URL pour des vues partageables.

Pour l’export, autorisez le téléchargement CSV depuis les tables (en respectant les filtres) et ajoutez un "Copier le lien" pour les partages internes — particulièrement depuis la liste des comptes à risque et le fil d’alertes.

Créer des alertes, notifications et routage

Les alertes ne sont utiles que si elles atteignent la bonne personne au bon moment — et n’habituent pas tout le monde à les ignorer. Traitez les notifications comme un produit, pas comme un après‑pensée.

Définir les déclencheurs d’alerte (ce qui mérite attention)

Commencez par un petit ensemble de déclencheurs qui se mappent à des actions claires :

- Seuils de score : ex. health score < 60, ou risque de churn > 80

- Baisses d’utilisation soudaines : ex. 40% de baisse semaine‑sur‑semaine sur un événement clé (connexions, appels API, sièges actifs)

- Patterns multi‑signaux : ex. baisse d’utilisation et pic de tickets, ou adoption d’une fonctionnalité clé à l’arrêt pendant 14 jours

Utilisez d’abord des règles simples, puis superposez de la logique plus intelligente (anomaly detection) une fois que vous avez confiance dans le socle.

Choisir des canaux qui correspondent aux habitudes de l’équipe

Choisissez un canal principal et un canal de secours :

- Email pour les synthèses, digests quotidiens et parties prenantes qui ne vivent pas dans le chat

- Slack pour les alertes sensibles au temps, routées vers

#cs-alerts ou une rotation on‑call dédiée

- Notifications in‑app pour les outils internes où les CSM travaillent (idéal pour les files de travail)

Si vous hésitez, commencez par Slack + in‑app tasks. L’email devient bruyant rapidement.

Ajoutez routage et déduplication pour éviter le spam

Routez les alertes selon la propriété du compte et le segment :

- Si le compte a un owner, notifiez le CSM

- Si c’est un compte à forte valeur, notifiez aussi la direction CS

- Si le signal est technique (erreurs API, ingestion), notifiez ingénierie/on‑call

Dédoublez en regroupant les alertes répétées dans un seul fil ou ticket (ex. « baisse persistante depuis 3 jours »). Ajoutez des fenêtres de cooldown pour ne pas envoyer la même alerte chaque heure.

Fournissez le contexte pour rendre l’alerte actionnable

Chaque alerte doit répondre : ce qui a changé, pourquoi c’est important, quoi faire ensuite. Incluez :

- La/les métrique(s) qui ont bougé et la comparaison baseline

- Le moteur suspect (fonctionnalité, groupe de sièges, intégration, région)

- Une action recommandée (ex. « envoyer un mail de prise de nouvelles » ou « vérifier la complétion de l’onboarding »)

- Un lien direct vers la vue compte :

/accounts/{account_id}

Quand les alertes mènent directement à une action claire, les équipes leur font confiance — et s’en servent.

Automatiser les workflows de suivi et les playbooks

La détection n’est utile que si elle déclenche de manière fiable la prochaine meilleure action. Automatiser les workflows transforme « on a vu une baisse » en une réponse cohérente et traçable qui améliore la rétention.

Commencez par mapper chaque signal à un playbook simple. Gardez les playbooks opinés et légers pour que les équipes les utilisent réellement.

Exemples :

- Baisse d’utilisation d’une fonctionnalité clé : email d’outreach + proposition d’une session de 15 minutes

- Nouvel admin mais pas de rollout : nudge d’onboarding + checklist

- Pic d’erreurs ou latence : check technique + demande de logs + ouverture d’un incident interne

Stockez les playbooks comme templates : étapes, messages recommandés, champs requis (ex. « root cause ») et critères de sortie (ex. « usage revenu à la baseline pendant 7 jours »).

Créez des tâches impossibles à ignorer

Quand un signal se déclenche, créez automatiquement une tâche avec :

- Propriétaire (CSM par compte, ou round‑robin dans une file)

- Date d’échéance (selon la sévérité ; ex. haut risque sous 4 heures ouvrées)

- Suivi de statut (Open → In progress → Blocked → Done)

Ajoutez un pack de contexte court à chaque tâche : métrique changée, début du signal, dernière période saine connue et événements produit récents. Cela réduit les allers‑retours et accélère le contact initial.

Intégrez là où les équipes travaillent déjà

Ne forcez pas tout le monde dans un nouvel onglet pour l’exécution. Poussez les tâches et notes vers les systèmes existants, et rapatriez les résultats dans votre app.

Destinations courantes : CRM et outils de support (voir /integrations/crm). Gardez le workflow bidirectionnel : si une tâche est marquée comme faite dans le CRM, reflétez‑le dans le tableau de santé.

Mesurez le suivi (et rendez‑le visible)

L’automatisation doit améliorer la qualité de la réponse, pas seulement le volume. Suivez :

- Time‑to‑contact depuis l’alerte jusqu’au premier outreach

- Notes de résolution (ce qui a été fait et pourquoi)

- Tags d’issue (Recovered, Ongoing risk, Product issue, Customer downsized)

Revuez ces métriques mensuellement pour affiner les playbooks, resserrer le routage et identifier quelles actions corrèlent vraiment avec la récupération d’usage.

Prototyper plus vite avec Koder.ai (optionnel)

Si vous voulez passer du spec à un outil interne fonctionnel rapidement, une plateforme vibe‑coding comme Koder.ai peut vous aider à prototyper le dashboard, les vues comptes et le workflow d’alertes via chat — puis itérer sur le comportement produit réel avec moins d’overhead. Parce que Koder.ai peut générer des apps full‑stack (React web, services Go avec PostgreSQL) et supporte snapshots/rollback plus export du code source, c’est un moyen pratique de valider votre modèle de données, vos règles de routage et le flow UI avant d’investir dans un cycle de build plus long.

Lancez un outil interne plus rapidement

Générez une interface React et une API Go pour les vues de compte, les journaux de signaux et le suivi des tâches.

Les décisions de sécurité et confidentialité sont plus faciles à bien faire tôt — surtout quand votre app agrège événements produit, contexte compte et alertes sur le risque de churn. L’objectif est simple : réduire le risque tout en donnant aux équipes assez de données pour agir.

Minimisation des données : ne collectez que l’essentiel

Commencez par définir ce que la surveillance requiert. Si votre détection fonctionne avec des comptes rendus, des tendances et des timestamps, vous n’avez probablement pas besoin du contenu brut des messages, des adresses IP complètes ou des notes libres.

Une approche pratique est de stocker :

- Identifiants de compte/espace (IDs internes)

- Type d’événement + timestamp

- Métriques agrégées (DAU, comptes d’usage par fonctionnalité, appels API)

- Références utilisateurs minimales uniquement si nécessaires pour le routage (ex. un ID utilisateur interne)

Réduire le jeu de données limite la charge de conformité, réduit le blast radius et simplifie les politiques de rétention.

Contrôle d’accès et auditabilité

Les tableaux de santé deviennent souvent un outil cross‑fonctionnel (CS, support, produit, direction). Tout le monde ne doit pas voir le même niveau de détail. Implémentez RBAC avec des règles claires :

- Direction : vues synthétiques et tendances

- CSMs : comptes qu’ils possèdent, avec drill‑down pertinent

- Support : signaux opérationnels, pas les métadonnées sensibles client

- Admins : intégrations et configuration uniquement

Ajoutez des journaux d’audit pour les actions sensibles (exports, changement de seuils, consultation de détails compte). Les logs aident aussi à déboguer « qui a modifié quoi » quand les alertes deviennent bruyantes.

Gestion des PII : hashage, chiffrement et rétention

Considérez la PII (noms, emails, téléphones) comme optionnelle. Si vous en avez besoin pour les notifications, préférez la récupérer à la demande depuis le CRM plutôt que de la copier dans la base de monitoring.

Si vous stockez de la PII :

- Chiffrez en transit (TLS) et au repos (encryption gérée)

- Envisagez le hashage des identifiants à joindre (ex. email hashé) pour ne pas conserver des valeurs lisibles

- Définissez des politiques de rétention (ex. événements bruts 30–90 jours, agrégats 12–24 mois)

- Assurez‑vous que les backups suivent les mêmes règles (rétention, contrôles d’accès)

Documentez ce que vous collectez, pourquoi (monitoring d’usage et support client) et combien de temps vous le conservez. Restez précis — évitez les formulations comme « totalement conforme » sauf après revue formelle.

Au minimum, soyez prêts à gérer :

- Demandes d’accès/suppression (supprimer ou anonymiser les données utilisateur)

- Limitation des finalités (ne pas réutiliser les données de monitoring pour du profiling non lié)

- Suivi des vendors et sous‑processeurs (outils d’analytics, fournisseurs email/SMS)

Si vous publiez de la doc côté client, liez‑la en interne (/privacy, /security) et gardez‑la alignée avec le fonctionnement réel du système.

Tests, déploiement et amélioration continue

Lancer une appli de churn‑risk n’est pas « est‑ce que ça tourne ? » mais « est‑ce que les équipes font confiance aux signaux et est‑ce que le système reste fiable à mesure que votre produit et vos données évoluent ? »

Valider avec des données historiques (backtesting)

Avant d’alerter qui que ce soit, rejouez les règles ou le modèle sur des périodes passées où vous connaissez déjà les issues (renouvelé, downgrade, churn). Cela vous aide à régler les seuils et éviter les alertes bruyantes.

Une façon simple d’évaluer est la matrice de confusion :

- Vrais positifs : comptes flagués qui ont ensuite churné/downgradé

- Faux positifs : comptes flagués qui allaient bien

- Faux négatifs : comptes manqués qui ont churné

- Vrais négatifs : comptes correctement ignorés

Concentrez‑vous ensuite sur ce qui compte opérationnellement : réduire les faux positifs pour que les CSM n’ignorent pas les alertes, tout en gardant les faux négatifs bas pour attraper les vrais risques tôt.

Surveillez la surveillance (contrôles pipeline)

Beaucoup de « baisses d’utilisation » sont en réalité des problèmes de données. Ajoutez un monitoring léger à chaque étape du pipeline :

- Actualité : quand cette table a‑t‑elle été mise à jour pour la dernière fois ?

- Données manquantes : chute soudaine à zéro d’événements, tenants manquants, ingestion partielle

- Échecs de jobs : retries, changements de schéma, limites d’API

Exposez ces problèmes dans une vue d’état interne pour que les utilisateurs puissent distinguer « le client a décroché » de « les données n’ont pas été ingérées ».

Déroulement par phases

Commencez par des utilisateurs internes (data/ops + quelques CSM) et comparez les alertes à ce qu’ils savent déjà. Étendez ensuite à un groupe plus large une fois la précision et le workflow stabilisés.

Pendant le rollout, mesurez les signaux d’adoption : alertes ouvertes, time‑to‑triage, et clics vers la vue compte.

Construisez des boucles de retour qui améliorent les résultats

Donnez aux utilisateurs un moyen en un clic de marquer une alerte comme faux positif, problème connu ou action réalisée. Stockez ce feedback et révisez‑le hebdomadairement pour affiner les règles, mettre à jour les poids du scoring ou ajouter des exclusions (ex. clients saisonniers, maintenances planifiées).

Avec le temps, cela fait de l’application un système qui apprend de la réalité de votre équipe, pas un tableau statique.