Objectifs et périmètre d'une application d'enquêtes interne

Une application d'enquêtes interne doit transformer les retours des employés en décisions — pas seulement « lancer des enquêtes ». Avant de choisir des fonctionnalités, définissez le problème que vous résolvez et à quoi ressemble le « terminé ».

Quels problèmes doit-elle couvrir ?

Commencez par nommer les types d'enquêtes que vous prévoyez d'exécuter régulièrement. Catégories courantes :

- Pulse checks (mesures rapides et récurrentes de moral, charge de travail, préparation au changement)

- Enquêtes d'engagement ou de culture (diagnostics plus profonds et périodiques)

- Suggestions et retours ouverts (canal toujours disponible avec triage léger)

- Feedback 360 (retours structurés de pairs, subordonnés et managers)

- Enquêtes post-événement ou formation (courtes, liées à un événement)

Chaque catégorie implique des besoins différents — fréquence, attentes d'anonymat, profondeur du reporting et workflows de suivi.

Qui sont les parties prenantes ?

Clarifiez qui possédera, opérera et fera confiance au système :

- RH / People Ops : lance les programmes, a besoin de segmentation et de tendances longitudinales\n- Managers : ont besoin d'insights exploitables pour leur équipe sans violer la confidentialité\n- Employés : veulent une expérience sans friction et la garantie que leurs retours sont traités de manière responsable\n- IT / Sécurité : a besoin d'identité, contrôle d'accès, règles de rétention et auditabilité

Notez tôt les objectifs des parties prenantes pour éviter le glissement de fonctionnalités et la construction de tableaux de bord inutilisés.

Définir des métriques de succès

Fixez des résultats mesurables pour juger la valeur après le déploiement :

- Taux de participation (global et par département/localisation)\n- Temps pour obtenir un insight (du lancement aux résultats exploitables)\n- Temps pour agir (de l'insight aux suivis assignés)\n- Temps de complétion (durée moyenne d'une réponse)\n- Suivi des actions (pourcentage d'enquêtes donnant lieu à des étapes suivantes documentées)

Contraintes et garde-fous

Soyez explicite sur les contraintes qui influent sur le périmètre et l'architecture :

- Exigences d'anonymat (anonymat réel vs. confidentiel avec accès restreint)\n- Conformité et rétention (minimisation des données, calendriers de suppression)\n- Budget et calendrier (MVP vs. besoin d'un programme complet)

Une première version serrée consiste généralement à : créer des enquêtes, les distribuer, collecter les réponses en sécurité et produire des synthèses claires qui entraînent des actions de suivi.

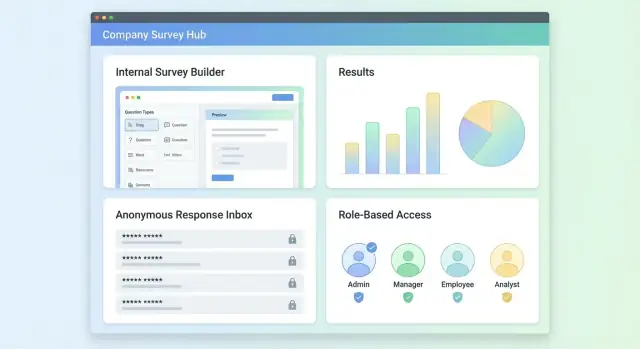

Utilisateurs, rôles et cas d'usage clés

Les rôles et permissions déterminent si l'outil est crédible — ou politiquement risqué. Commencez avec un petit ensemble de rôles, puis ajoutez de la nuance uniquement quand des besoins réels apparaissent.

Rôles principaux (et besoins associés)

Employé (répondant)

Les employés doivent pouvoir découvrir les enquêtes pour lesquelles ils sont éligibles, soumettre rapidement leurs réponses et (si c'est promis) avoir confiance que leurs réponses ne seront pas tracées jusqu'à eux.

Manager (visualiseur + propriétaire d'actions)

Les managers ont généralement besoin de résultats au niveau de l'équipe, de tendances et d'actions de suivi — pas des réponses détaillées. Leur expérience doit se concentrer sur la compréhension des thèmes et l'amélioration de l'équipe.

RH/Admin (propriétaire du programme)

Les utilisateurs RH/admin créent habituellement des enquêtes, gèrent des modèles, contrôlent les règles de distribution et consultent les rapports transverses. Ils gèrent aussi les exports (lorsque permis) et les demandes d'audit.

Admin système (propriétaire de la plateforme)

Ce rôle maintient les intégrations (SSO, synchronisation d'annuaire), les politiques d'accès, les paramètres de rétention et la configuration globale. Il ne doit pas voir automatiquement les résultats des enquêtes, sauf autorisation explicite.

Parcours utilisateur typiques

Créer enquête → distribuer : RH/admin choisit un modèle, ajuste les questions, définit les audiences éligibles (ex. département, localisation) et planifie des rappels.

Répondre : L'employé reçoit une invitation, s'authentifie (ou utilise un lien magique), complète l'enquête et voit une confirmation claire.

Consulter résultats : Les managers voient des résultats agrégés pour leur périmètre ; RH/admin voit des insights organisationnels et peut comparer des groupes.

Agir : Les équipes créent des actions de suivi (ex. « améliorer l'onboarding »), assignent des responsables, fixent des dates et suivent l'avancement.

Modèle d'accès : qui peut faire quoi

Définissez les permissions en langage clair :

- Créer : généralement RH/admin ; parfois managers pour les pulse checks.\n- Voir résultats : par périmètre (équipe, département, org) et selon une taille minimale de groupe.\n- Exporter : restreint aux RH/admin, souvent avec approbation ou enregistrement d'audit.

Pièges courants à éviter

Un échec fréquent est de laisser les managers voir des résultats trop granulaires (ex. fractionner jusqu'à un sous-groupe de 2–3 personnes). Appliquez des seuils minimaux de reporting et supprimez les filtres qui pourraient identifier des individus.

Autre problème : des permissions peu claires (« Qui peut voir ça ? »). Chaque page de résultats doit afficher une courte note d'accès explicite comme : « Vous consultez les résultats agrégés pour Engineering (n=42). Les réponses individuelles ne sont pas disponibles. »

Conception des enquêtes : types de questions, logique et modèles

Une bonne conception différencie des « données intéressantes » et des retours exploitables. Dans une application d'enquêtes interne, visez des enquêtes courtes, cohérentes et faciles à réutiliser.

Types d'enquêtes courants à supporter

Le constructeur devrait commencer avec quelques formats opinionnés couvrant la plupart des besoins RH et d'équipe :

- Pulse surveys (courts check-ins mensuels/bihebdomadaires)\n- eNPS (employee Net Promoter Score) pour le suivi d'engagement\n- Enquêtes d'onboarding (ex. après Semaine 2 et Semaine 6)\n- Enquêtes de sortie (raisons structurées + commentaires libres)\n- Feedback formation (contenu, formateur, applicabilité)\n- Suivis d'incident ou de projet (ce qui s'est passé, ce qui a changé, besoins)

Ces types bénéficient d'une structure cohérente pour comparer les résultats dans le temps.

Types de questions : garder la bibliothèque essentielle

Une bibliothèque de questions MVP inclut généralement :

- Choix unique (clair, rapide à répondre)\n- Choix multiple (lorsque plusieurs options peuvent être vraies)\n- Échelle de notation (ex. 1–5 accord/satisfaction/confiance)\n- Texte libre (contexte, suggestions, exemples)

Montrez en aperçu exactement ce que verront les répondants, y compris les marqueurs obligatoire/optionnel et les étiquettes d'échelle.

Logique conditionnelle : l'utiliser mais avec parcimonie

Supportez une logique conditionnelle basique : « Si quelqu'un répond Non, afficher une courte question de suivi. » Limitez-vous à des règles simples (afficher/masquer des questions ou sections). Une logique trop complexe complique les tests et l'analyse.

Modèles et versioning

Les équipes voudront réutiliser des enquêtes sans perdre l'historique. Traitez les modèles comme points de départ et créez des versions lors de la publication. Ainsi, vous pouvez modifier le pulse du mois prochain sans écraser le précédent, et l'analytics reste lié aux questions exactes posées.

Localisation (optionnelle)

Si vos équipes sont réparties, prévoyez des traductions optionnelles : stockez le texte de chaque question par locale et gardez les choix de réponse cohérents entre les langues pour préserver le reporting.

Anonymat et confiance : concevoir pour des retours honnêtes

La confiance est une fonctionnalité produit. Si les employés ne sont pas sûrs de qui peut voir leurs réponses, ils éviteront l'enquête ou « répondront prudemment » plutôt que franchement. Rendez les règles de visibilité explicites, appliquez-les aux rapports et évitez les fuites d'identité accidentelles.

Choisir des modes d'anonymat clairs

Supportez trois modes distincts et étiquetez-les uniformément dans le constructeur, l'invitation et l'interface répondant :

- Totalement anonyme : aucune identité n'est stockée avec les réponses. Évitez de collecter des identifiants indirects (email, IP, empreinte d'appareil). Si vous devez prévenir les doublons, utilisez un token à usage unique validé sans être stocké avec la réponse.\n- Confidentiel (RH seulement) : l'identité est stockée, mais l'accès est restreint à un petit ensemble de rôles (ex. admins RH). Les managers ne voient que des résultats agrégés.\n- Identifié : les répondants sont visibles pour les rôles autorisés (utile pour les suivis d'onboarding ou les enquêtes de service).

Prévenir la ré-identification dans les rapports

Même sans noms, de petits groupes peuvent « dénoncer » quelqu'un. Appliquez des seuils minimaux partout où les résultats sont détaillés (équipe, localisation, ancienneté, manager) :

- Fixez une taille minimale de groupe (couramment 5–10) avant d'afficher un découpage.\n- Si un filtre descend sous le seuil, affichez « Pas assez de réponses pour protéger l'anonymat » et désactivez les exports pour cette tranche.\n- Appliquez la même règle aux graphiques de tendance (ex. semaine par semaine pour un petit département).

Gérer le texte libre en toute sécurité

Les commentaires sont précieux — et risqués. Les gens peuvent inclure des noms, des détails de projets ou des données personnelles.

- Ajoutez un texte d'orientation au-dessus des champs commentés (« Évitez les noms ou détails identifiants »).\n- Proposez une file de modération optionnelle pour les enquêtes confidentielles/anonymes, où les RH peuvent expurger les détails identifiants avant que les managers voient les commentaires.\n- Envisagez des contrôles automatiques basiques (ex. repérer emails/téléphones) pour orienter les commentaires vers révision.

Journaliser les actions sans enregistrer les identités

Gardez des pistes d'audit pour la responsabilité, mais n'en faites pas des fuites de vie privée :

- Journalisez les actions admin (enquête créée/modifiée, paramètres de visibilité changés, rapport exporté, rappels envoyés).\n- En mode anonyme, évitez de journaliser « qui a répondu » ou de lier des IDs de réponse à des identités.\n- Si vous conservez des logs d'accès, séparez-les des données de réponse et limitez leur durée de rétention.

Utiliser un langage UX clair et frontal

Avant la soumission, affichez un court panneau « Qui peut voir quoi » qui correspond au mode sélectionné. Exemple :

Vos réponses sont anonymes. Les managers ne verront que des résultats pour des groupes de 7 personnes ou plus. Les commentaires peuvent être revus par les RH pour supprimer les éléments identifiants.

La clarté réduit la peur, augmente le taux de complétion et crédibilise votre programme de retours.

Distribution, authentification et rappels

Rendez le reporting fiable

Créez des vues de rapport sécurisées avec des seuils minimaux par groupe et des notes d'accès claires.

Mettre une enquête devant les bonnes personnes — et une seule fois — compte autant que les questions. Vos choix de distribution et de connexion influencent directement le taux de réponse, la qualité des données et la confiance.

Méthodes d'invitation (atteindre les gens là où ils travaillent)

Supportez plusieurs canaux pour que les admins choisissent ce qui convient :

- Invitations par email avec un CTA clair et la date de clôture\n- Messages Slack/Teams (DMs ou posts de canal) pour une mobilisation plus rapide\n- Liens intranet pour découverte permanente (utile pour les pulses always-on)

Garder les messages brefs, inclure le temps nécessaire et rendre le lien accessible en un clic.

Options d'authentification (équilibre friction / confidentialité)

Pour les enquêtes internes, approches courantes :

- SSO (SAML/OAuth) : idéal en entreprise ; réduit les besoins de support.\n- Liens magiques : faible friction, surtout pour les personnels de terrain sans poste fixe.\n- Accès par identifiant employé : envisageable si le SSO n'est pas disponible, mais nécessite une gestion soigneuse pour que les enquêtes « anonymes » ne paraissent pas identifiantes.

Indiquez clairement dans l'UI si l'enquête est anonyme ou identifiée. Si elle est anonyme, n'invitez pas les utilisateurs à « se connecter avec leur nom » sans expliquer comment l'anonymat est préservé.

Rappels utiles, pas spam

Traitez les rappels comme une fonctionnalité de premier plan :

- Permettez des nudges planifiés (ex. 3 jours après l'invite, puis hebdomadaire)\n- Ajoutez des plafonds de fréquence (pas plus de X rappels par enquête)\n- Fournissez des règles de désabonnement pour les enquêtes non obligatoires, tout en permettant aux enquêtes requises de forcer les rappels

Dates de clôture et soumissions tardives

Définissez le comportement à l'avance :

- Que se passe-t-il après la clôture : bloquer les nouvelles réponses, autoriser les modifications, ou accepter les soumissions tardives ?\n- Affichez un message clair (« Cette enquête a clos le… »), et liez vers /help si quelqu'un demande une exception

Empêcher les doublons

Combinez plusieurs méthodes :

- Liens tokenisés (à usage unique ou réutilisables par utilisateur)\n- Suivi de session pour que les rafraîchissements accidentels n'enregistrent pas plusieurs entrées\n- Un écran amical « Vous avez déjà répondu » avec l'option de revoir/modifier si l'enquête le permet

UX et UI : constructeur, parcours répondant et console admin

Une excellente UX compte surtout quand votre audience est occupée et peu motivée à « apprendre un outil ». Visez trois expériences qui semblent dédiées : le constructeur, le parcours répondant et la console admin.

UI du constructeur d'enquêtes (pour les créateurs)

Le constructeur doit ressembler à une checklist. Une liste de questions à gauche avec glisser-déposer pour ordonner fonctionne bien, la question sélectionnée s'ouvrant dans un panneau d'édition simple.

Incluez l'essentiel là où on l'attend : bascules obligatoire, texte d'aide (ce que signifie la question et comment les réponses seront utilisées), et contrôles rapides pour les labels d'échelle. Un bouton Aperçu persistant (ou vue scindée) aide à repérer tôt les formulations confuses.

Gardez les modèles légers : laissez les équipes partir d'un « Pulse check », « Onboarding » ou « Feedback manager » et éditer sur place — évitez les assistants multi-étapes sauf s'ils réduisent vraiment les erreurs.

Parcours répondant (pour les employés)

Les répondants veulent rapidité, clarté et confiance. Rendre l'UI mobile-friendly par défaut, avec une mise en page lisible et des cibles tactiles adaptées.

Un indicateur de progression simple réduit l'abandon (« 6 sur 12 »). Fournissez la sauvegarde et reprise sans conséquence : autosauvegarde après chaque réponse, et faites en sorte que le lien de reprise soit facile à retrouver depuis l'invitation.

Quand la logique masque/affiche des questions, évitez les sauts brusques. Utilisez de petites transitions ou des en-têtes de section pour garder un flux cohérent.

Console admin (pour propriétaires et admins)

Les admins ont besoin de contrôle sans chercher les paramètres. Organisez autour de tâches réelles : gérer enquêtes, sélectionner audiences, définir calendriers et assigner permissions.

Écrans clés :

- Liste des enquêtes (brouillon / planifié / en ligne / clos)\n- Gestion des audiences (groupes, filtres, imports)\n- Paramètres de planification et de rappel\n- Permissions (qui peut créer, publier, voir les résultats)

Accessibilité, erreurs et états vides

Couvrez le basique : navigation clavier complète, états de focus visibles, contraste suffisant, et labels compréhensibles hors contexte.

Pour les erreurs et états vides, supposez des utilisateurs non techniques. Expliquez ce qui s'est passé et quoi faire ensuite (« Aucune audience sélectionnée — choisissez au moins un groupe pour planifier »). Fournissez des valeurs par défaut sûres et des annulations quand c'est possible, surtout pour l'envoi d'invitations.

Un modèle de données propre maintient l'application flexible (nouveaux types de questions, nouvelles équipes, nouveaux besoins de reporting) sans transformer chaque changement en migration. Séparez clairement authoring, distribution et résultats.

Entités principales

Au minimum :

- Utilisateurs : profil, statut, identifiants d'auth, et rôle(s)\n- Groupes/Équipes : table des memberships pour que les utilisateurs appartiennent à plusieurs groupes\n- Enquêtes : titre, description, propriétaire, statut (brouillon/ouvert/clos), paramètres (anonyme, autoriser modifications, rétention)\n- Questions : appartenance à une enquête, type, ordre, métadonnées logiques\n- Invitations : qui a été invité, canal, token, timestamps d'envoi/rappel, état de complétion\n- Réponses : une « session de réponse » par invitation (ou par utilisateur) plus les enregistrements de réponses

L'architecture de l'information suit naturellement : une barre latérale avec Enquêtes et Analytics, et au sein d'une enquête : Constructeur → Distribution → Résultats → Paramètres. Gardez « Équipes » séparé des « Enquêtes » pour que le contrôle d'accès reste cohérent.

Réponses brutes vs reporting agrégé

Stockez les réponses brutes dans une structure append-friendly (ex. table answers avec response_id, question_id, champs typés). Puis construisez des tables agrégées/vues matérialisées pour le reporting (comptes, moyennes, tendances). Cela évite de recalculer chaque graphique à chaque chargement tout en préservant l'auditabilité.

Si l'anonymat est activé, séparez les identifiants :

responses ne contient aucune référence utilisateur\n- invitations garde le mapping, avec un accès plus strict et une rétention plus courte

Rétention, exports et pièces jointes

Rendez la rétention configurable par enquête : supprimer les liens d'invitation après N jours ; supprimer les réponses brutes après N mois ; ne conserver que des agrégats si nécessaire. Fournissez des exports (CSV/XLSX) conformes à ces règles (/help/data-export).

Pour les pièces jointes, par défaut refuser sauf cas d'usage fort. Si autorisées, stockez-les en stockage d'objets privé, scannez les uploads et n'enregistrez que les métadonnées en base.

Recherche et indexation (optionnel)

La recherche en texte libre est utile, mais peut miner la confidentialité. Si vous l'ajoutez, limitez l'indexation aux admins, permettez la redaction et documentez que la recherche peut augmenter le risque de ré-identification. Envisagez une « recherche dans une enquête » plutôt qu'une recherche globale.

Stack technique et architecture système

Définissez les règles de confidentialité en amont

Définissez permissions, seuils de rapports et exports avant d'écrire la moindre ligne de code.

Une application d'enquêtes n'a pas besoin d'une technologie exotique, mais doit avoir des frontières claires : une UI réactive pour la création et la réponse, une API fiable, une base qui supporte le reporting, et des workers pour les notifications.

Exemples de stack recommandés

Choisissez un stack que votre équipe peut opérer en confiance :

- Frontend : React ou Vue (les builders basés composants fonctionnent bien)\n- Backend : Node.js (Nest/Express), Django ou Rails\n- Base : Postgres (bonne pour les données relationnelles et requêtes analytiques)\n- Cache/queue (optionnel) : Redis

Si vous attendez de l'analytics lourd, Postgres tient souvent, et vous pouvez ajouter un entrepôt de données plus tard sans récrire l'application.

Si vous voulez prototyper rapidement l'ensemble (UI, API, DB, auth) à partir d'un cahier des charges, Koder.ai peut accélérer la construction via un workflow conversationnel. La plateforme peut générer des apps (souvent React + Go + PostgreSQL) avec planning, export du code source et snapshots/rollback — utile quand vous itérez sur un outil interne aux permissions et règles de confidentialité sensibles.

Architecture système (haut niveau)

Une base pratique : une architecture 3 tiers :

- Client web (admin + répondants)\n- Service API (règles métier, autorisation, validation)\n- Base de données (enquêtes, questions, attributions, réponses)

Ajoutez un service worker pour les tâches planifiées ou longues (invites, rappels, exports) afin de garder l'API réactive.

Conception API : REST vs GraphQL

REST est souvent le choix le plus simple pour les outils internes : endpoints prévisibles, mise en cache aisée, débogage simple.

Endpoints REST typiques :

POST /surveys, GET /surveys/:id, PATCH /surveys/:id\n- POST /surveys/:id/publish\n- POST /surveys/:id/invites (créer attributions/invitations)\n- POST /responses et GET /surveys/:id/responses (admin seulement)\n- GET /reports/:surveyId (agrégations, filtres)

GraphQL peut aider si votre UI de constructeur a besoin de nombreuses lectures imbriquées (survey → pages → questions → options) et que vous voulez moins d'allers-retours. Il ajoute cependant de la complexité opérationnelle : ne l'utilisez que si l'équipe maîtrise.

Jobs en arrière-plan et tâches planifiées

Utilisez une queue pour :

- Envoi d'invitations et rappels par email/Slack\n- Fermeture automatique des enquêtes à la date de fin\n- Génération d'exports (CSV/PDF) et pré-calcul des résumés de rapport

Stockage fichiers et CDN (exports/pièces jointes)

Si vous supportez uploads ou exports téléchargeables, stockez-les hors DB (ex. S3-compatible) et servez via CDN. Utilisez des URLs signées à durée limitée pour que seuls les utilisateurs autorisés téléchargent.

Environnements et configuration

Exécutez dev / staging / prod séparément. Gardez les secrets hors du code (variables d'environnement ou gestionnaire de secrets). Utilisez des migrations pour les schémas et ajoutez des health checks pour que les déploiements échouent rapidement sans casser les enquêtes actives.

Analytics, reporting et workflows d'action

L'analytics doit répondre à deux questions pratiques : « Avons-nous entendu assez de monde ? » et « Que devons-nous faire ensuite ? » L'objectif n'est pas des graphiques tape-à-l'œil mais des insights prêts à l'action que les dirigeants peuvent approuver.

Dashboards montrant la participation (sans sur-interpréter)

Commencez par une vue de participation facile à lire : taux de réponse, couverture des invitations et distribution dans le temps (tendance journalière/hebdomadaire). Cela aide les admins à repérer les chutes et ajuster les rappels.

Pour les « thèmes principaux », soyez prudent. Si vous résumez les commentaires libres (manuellement ou avec suggestions automatisées), indiquez que c'est indicatif et permettez d'accéder aux commentaires sources. N'affichez pas des « thèmes » comme des faits quand l'échantillon est petit.

Découpages sûrs par département ou localisation

Les découpages sont utiles mais peuvent exposer des individus. Réutilisez les mêmes seuils minimaux définis pour l'anonymat partout où vous tranchez les résultats. Si un sous-groupe est sous le seuil, regroupez-le dans « Autres » ou masquez-le.

Pour les petites organisations, envisagez un « mode confidentialité » qui augmente automatiquement les seuils et désactive les filtres trop granulaires.

Exports avec contrôles basés sur les rôles

Les exports sont souvent le point de fuite. Placez les exports CSV/PDF derrière des contrôles d'accès basés sur les rôles et journalisez qui a exporté quoi et quand. Pour les PDF, le filigrane optionnel (nom + horodatage) peut décourager le partage informel sans bloquer le reporting légitime.

Les réponses ouvertes ont besoin d'un workflow, pas d'un simple tableau. Fournissez des outils légers : étiquetage, groupement de thèmes et notes d'action attachées aux commentaires (avec permissions pour que les notes sensibles ne soient pas visibles de tous). Conservez le commentaire original immuable et stockez tags/notes séparément pour l'audit.

Suivi d'action et boucle de clôture

Fermez la boucle en permettant aux managers de créer des suivis à partir des insights : assigner un propriétaire, fixer une date d'échéance et suivre l'état (Prévu → En cours → Terminé). Une vue « Actions » qui renvoie à la question source et au segment facilite la revue en réunion.

Prototypez via le chat

Transformez votre MVP de sondage en une application React, Go et PostgreSQL grâce à un flux de travail en chat.

La sécurité et la confidentialité ne sont pas des options pour une app d'enquêtes internes — elles déterminent si les employés feront confiance à l'outil. Traitez cela comme une checklist à revoir avant le lancement et à chaque release.

Bases de la sécurité (incontournables)

Utilisez HTTPS partout et définissez des flags de cookie sécurisés (Secure, HttpOnly, et SameSite approprié). Appliquez une gestion de session solide (durée courte, logout au changement de mot de passe).

Protégez les requêtes modifiant l'état avec des défenses CSRF. Validez et assainissez les entrées côté serveur (pas seulement côté client), y compris les questions d'enquête, les réponses en texte libre et les uploads. Ajoutez un rate limiting pour les endpoints de login, d'invitation et de rappel.

Contrôle d'accès (RBAC + moindre privilège)

Implémentez un contrôle d'accès basé sur les rôles avec des frontières claires (ex. Admin, RH/Propriétaire de programme, Manager, Analyste, Répondant). Configurez par défaut chaque nouvelle fonctionnalité sur « refuser » jusqu'à autorisation explicite.

Appliquez le moindre privilège aussi dans la couche donnée — les propriétaires d'enquête ne devraient accéder qu'à leurs enquêtes, et les analystes n'auraient des vues agrégées que s'ils n'ont pas d'accès aux réponses brutes.

Si la culture l'exige, ajoutez des approbations pour des actions sensibles comme activer l'anonymat, exporter des réponses brutes ou ajouter de nouveaux propriétaires d'enquête.

Chiffrement et secrets

Chiffrez les données en transit (TLS) et au repos (base et backups). Pour les champs particulièrement sensibles (identifiants de répondants, tokens), envisagez un chiffrement côté application.

Stockez les secrets (identifiants DB, clés fournisseurs mail) dans un gestionnaire de secrets ; faites-les tourner régulièrement. Ne loggez jamais de tokens d'accès, liens d'invitation ou identifiants de réponse.

Décidez tôt de la résidence des données (où la base et les backups résident) et documentez-la pour les employés.

Définissez des règles de rétention : durée de conservation des invitations, réponses, logs d'audit et exports. Fournissez un workflow de suppression cohérent avec votre modèle d'anonymat.

Soyez prêt pour les DPA : maintenez la liste des sous-traitants (email/SMS, analytics, hébergement), documentez les finalités de traitement et un point de contact pour les demandes de confidentialité.

Tests et vérifications

Ajoutez des tests unitaires et d'intégration pour les permissions : « Qui peut voir quoi ? » et « Qui peut exporter quoi ? ». Couvrez les cas limites de confidentialité : seuils de petites équipes, liens d'invitation transférés, soumissions répétées et comportement d'export.

Effectuez des revues de sécurité périodiques et conservez un journal d'audit des actions admin et des accès sensibles.

Plan MVP, stratégie de déploiement et feuille de route d'itération

Une application d'enquêtes interne réussie n'est pas « terminée » au lancement. Traitez la première version comme un outil d'apprentissage : il doit résoudre un besoin réel, prouver la fiabilité et gagner la confiance — puis s'étendre selon l'utilisation.

Périmètre MVP (quoi livrer en premier)

Concentrez le MVP sur la boucle complète création → insight. Au minimum :

- Un constructeur simple (types de questions de base, branchement basique si disponible)\n- Distribution via lien partageable et/ou invitations par email\n- Collecte des réponses avec statut clair (ouvert/clos) et export basique\n- Reporting basique : taux de réponse, graphiques simples par question et vue commentaires

Visez « rapide à publier » et « facile à répondre ». Si les admins ont besoin d'une formation juste pour envoyer une enquête, l'adoption s'arrêtera.

Si vous êtes limité en ressources, des outils comme Koder.ai peuvent aider : décrivez rôles, modes d'anonymat, seuils de privacy et canaux de distribution en planning, générez une app initiale et itérez rapidement — tout en gardant l'option d'exporter le code source pour l'exécuter en interne.

Déploiement pilote (prouver la valeur avec une équipe)

Commencez par un pilote dans une équipe ou un département. Utilisez un pulse court (5–10 questions) et un calendrier serré (ex. une semaine ouverte, résultats revus la semaine suivante).

Incluez quelques questions sur l'outil lui-même : était-il facile d'accès ? Quelque chose était-il confus ? Les attentes d'anonymat correspondaient-elles à la réalité ? Ce méta-retour permet de corriger les frictions avant un déploiement plus large.

Même le meilleur produit nécessite de la clarté interne. Préparez :

- Une annonce courte décrivant le « pourquoi », quelles données sont collectées et qui peut voir quoi\n- Une FAQ interne expliquant anonymat, calendriers et utilisation des résultats\n- Un briefing léger pour managers : interpréter les résultats, communiquer les actions et ce qu'il ne faut pas faire (ex. essayer d'identifier des individus)

Si vous avez un intranet, publiez une source unique de vérité (ex. /help/surveys) et liez-la depuis les invitations.

Surveillance pendant le déploiement

Surveillez un petit ensemble de signaux opérationnels chaque jour lors des premières exécutions : délivrabilité (bounces/spam), taux de réponse par audience, erreurs applicatives et performance mobile. La plupart des abandons surviennent à l'authentification, à la compatibilité d'appareil ou à une copie d'anonymat peu claire.

Feuille de route d'itération (quoi ajouter ensuite)

Quand le MVP est stable, priorisez les améliorations qui réduisent l'effort admin et augmentent l'actionnabilité : intégrations (HRIS/SSO, Slack/Teams), bibliothèque de modèles, rappels plus intelligents et analytics avancés (tendances, segmentation avec seuils de privacy, suivi d'actions).

Gardez la roadmap liée à des résultats mesurables : création d'enquête plus rapide, taux de complétion plus élevé et meilleur suivi des actions.