Clarifier l'objectif et le périmètre de l'application

Avant de concevoir des écrans ou de choisir une stack technique, clarifiez ce que « risque opérationnel » signifie dans votre organisation. Certaines équipes l'utilisent pour couvrir des défaillances de processus et des erreurs humaines ; d'autres y incluent des pannes IT, des problèmes fournisseurs, la fraude ou des événements externes. Si la définition est floue, votre application deviendra une zone de stockage — et le reporting deviendra peu fiable.

Définir ce que vous allez suivre

Rédigez une déclaration claire de ce qui compte comme risque opérationnel et de ce qui n'en est pas. Vous pouvez le structurer en quatre seaux (processus, personnes, systèmes, événements externes) et ajouter 3 à 5 exemples pour chacun. Cette étape réduit les débats ultérieurs et maintient la cohérence des données.

S'accorder sur les résultats attendus

Soyez précis sur ce que l'application doit accomplir. Les résultats courants incluent :

- Visibilité : un endroit unique pour voir risques, contrôles, incidents et actions

- Responsabilisation : chaque élément a un propriétaire nommé et une date d'échéance

- Suivi de la remédiation : les actions passent de « ouverte » à « vérifiée » avec preuves

- Reporting et préparation à l'audit : pouvoir expliquer ce qui a changé, quand et pourquoi

Si vous ne pouvez pas décrire le résultat, il s'agit probablement d'une demande de fonctionnalité — pas d'une exigence.

Identifier les utilisateurs principaux

Listez les rôles qui utiliseront l'application et ce dont ils ont le plus besoin :

- Propriétaires de risques (identifier et mettre à jour les risques)

- Propriétaires de contrôles (attester des contrôles, joindre des preuves)

- Examinateurs (approuver les modifications, demander des mises à jour)

- Auditeurs (accès en lecture seule, traçabilité)

- Admins (accès utilisateurs, configuration)

Cela évite de construire pour « tout le monde » et de ne satisfaire personne.

Définir un périmètre v1 réaliste

Un v1 pratique pour le suivi des risques opérationnels se concentre généralement sur : un registre des risques, un scoring basique, le suivi des actions et des rapports simples. Réservez les capacités plus approfondies (intégrations avancées, gestion complexe de taxonomie, constructeurs de workflow personnalisés) pour les phases ultérieures.

Définir des métriques de succès

Choisissez des signaux mesurables tels que : pourcentage de risques avec propriétaires, complétude du registre, temps de clôture des actions, taux d'actions en retard, et achèvement des revues dans les délais. Ces métriques facilitent le jugement de l'efficacité de l'application et les améliorations à apporter.

Recueillir les besoins auprès des parties prenantes

Une application de registre des risques ne fonctionne que si elle correspond à la manière dont les personnes identifient, évaluent et suivent réellement les risques opérationnels. Avant de parler des fonctionnalités, échangez avec ceux qui utiliseront (ou seront évalués par) les sorties.

Qui impliquer (et pourquoi)

Commencez par un petit groupe représentatif :

- Responsables métiers qui remontent et gèrent les risques au quotidien

- Risque/Conformité qui définissent la terminologie, les attentes de scoring et les besoins de reporting

- Audit interne qui s'intéressent aux preuves, aux approbations et à l'exhaustivité de la piste d'audit

- IT/Sécurité qui examineront le contrôle d'accès, la rétention des données et les intégrations

- Exécutifs / liaisons du conseil qui consomment des synthèses et des rapports de tendance

Cartographier le processus actuel de bout en bout

Lors d'ateliers, cartographiez le flux de travail réel étape par étape : identification du risque → évaluation → traitement → surveillance → revue. Capturez où les décisions sont prises (qui approuve quoi), ce que signifie « fait », et ce qui déclenche une revue (basé sur le temps, un incident ou un seuil).

Recueillir les points de douleur à corriger

Demandez aux parties prenantes de montrer le tableur ou la chaîne d'e-mails actuelle. Documentez des problèmes concrets tels que :

- Absence de responsabilité (propriétaire du risque vs propriétaire du contrôle vs propriétaire de l'action peu clairs)

- Scoring incohérent (les équipes interprètent probabilité/impact différemment)

- Pistes d'audit faibles (aucune trace de qui a modifié quoi et pourquoi)

- Confusion des versions (multiples copies du « dernier » registre)

Documenter les workflows et événements requis

Écrivez les workflows minimum que votre application doit supporter :

- Créer un nouveau risque (avec champs obligatoires et règles d'approbation)

- Mettre à jour un risque (re-scoring, changement de statut, ajout de notes)

- Enregistrer des incidents et les lier aux risques/contrôles

- Enregistrer les résultats des tests de contrôles et les preuves

- Créer et suivre des plans d'action (dates d'échéance, rappels, escalades)

Définir les rapports dont les gens dépendent

Mettez-vous d'accord sur les livrables tôt pour éviter les reprises. Les besoins courants incluent synthèses pour le conseil, vues par unité métier, actions en retard, et principaux risques par score ou tendance.

Listez toute règle qui façonne les exigences — par ex. périodes de rétention des données, contraintes de confidentialité pour les données d'incident, séparation des tâches, preuve d'approbation, et restrictions d'accès par région ou entité. Restez factuel : vous recueillez des contraintes, vous ne garantissez pas la conformité par défaut.

Concevoir votre cadre de risque et la terminologie

Avant de construire des écrans ou des workflows, alignez-vous sur le vocabulaire que votre application de suivi des risques opérationnels imposera. Une terminologie claire empêche les problèmes du type « même risque, mots différents » et rend le reporting fiable.

Commencer par une taxonomie de risque pragmatique

Définissez comment les risques seront groupés et filtrés dans le registre. Gardez-la utile pour la gestion quotidienne ainsi que pour les tableaux de bord et les rapports.

Les niveaux typiques de taxonomie incluent catégorie → sous-catégorie, mappés aux unités métiers et (si utile) aux processus, produits ou sites. Évitez une taxonomie tellement détaillée que les utilisateurs ne peuvent pas choisir de façon cohérente ; vous pourrez affiner ultérieurement selon les patterns observés.

Standardiser l'énoncé du risque et les champs requis

Accordez-vous sur un format d'énoncé de risque cohérent (par ex. « En raison de cause, événement peut se produire, entraînant impact »). Puis décidez des champs obligatoires :

- Cause, événement, impact (pour une analyse significative)

- Propriétaire du risque et équipe responsable (pour piloter l'action)

- Statut (brouillon, actif, en revue, retiré)

- Dates (identifié, dernière évaluation, prochaine revue)

Cette structure relie contrôles et incidents à un seul récit plutôt qu'à des notes éparses.

Définir les dimensions d'évaluation et le scoring

Choisissez les dimensions d'évaluation que vous prendrez en charge dans votre modèle de scoring. Probabilité et impact sont le minimum ; vélocité et détectabilité peuvent ajouter de la valeur si les équipes peuvent les noter de façon cohérente.

Décidez comment traiter le risque inhérent vs résiduel. Une approche courante : le risque inhérent est noté avant contrôles ; le risque résiduel est le score après contrôles, avec les contrôles liés explicitement afin que la logique reste explicable lors des revues et audits.

Enfin, entendez-vous sur une échelle simple (souvent 1–5) et rédigez des définitions en langage clair pour chaque niveau. Si « 3 = moyen » signifie des choses différentes selon les équipes, votre workflow d'évaluation produira du bruit plutôt que des insights.

Créer le modèle de données (registre des risques, contrôles, actions)

Un modèle de données clair transforme un registre type tableur en un système de confiance. Visez un petit ensemble d'enregistrements centraux, des relations propres et des listes de référence cohérentes pour que le reporting reste fiable à mesure que l'utilisation croît.

Entités principales (votre schéma minimal viable)

Commencez avec quelques tables qui reflètent directement la façon dont les personnes travaillent :

- Utilisateurs et Rôles : qui est dans le système et ce qu'il peut faire

- Risques : l'entrée du registre (titre, description, propriétaire, domaine business, notations inhérente/résiduelle, statut)

- Évaluations : évaluations ponctuelles (date, évaluateur, saisies de scoring, notes). Séparer les évaluations évite d'écraser la « vue courante ».

- Contrôles : dispositifs liés aux risques (conception/efficacité opérationnelle, cadence de test, propriétaire du contrôle)

- Incidents/Événements : ce qui s'est produit (date, impact, cause racine, risque(s) lié(s), défaillances de contrôle liées)

- Actions : tâches de remédiation liées à un risque, contrôle ou incident

- Commentaires : discussions et décisions, idéalement avec mentions @ et horodatages

Relations importantes pour la traçabilité

Modélisez explicitement les liens many-to-many clés :

- Risque ↔ Contrôles (via une table de jonction) pour montrer quels contrôles atténuent quels risques

- Risque ↔ Incidents pour relier pertes/near-misses réels au registre

- Actions → Risque/Contrôle/Incident (lien polymorphe ou trois clés étrangères nullables) afin que la remédiation soit toujours ancrée

Cette structure répond à des questions du type « quels contrôles réduisent nos principaux risques ? » et « quels incidents ont provoqué un changement de notation ? »

Tables d'historique et « pourquoi ce changement ? »

Le suivi des risques opérationnels nécessite souvent un historique défendable. Ajoutez des tables d'historique pour Risques, Contrôles, Évaluations, Incidents et Actions avec :

- qui a modifié, quand, et quels champs ont changé

- raison du changement optionnelle (texte libre ou codes sélectionnables)

Évitez de ne conserver que « dernière mise à jour » si des approbations et des audits sont attendus.

Tables de référence pour la cohérence

Utilisez des tables de référence (pas des chaînes codées en dur) pour taxonomie, statuts, échelles de gravité/probabilité, types de contrôles, et états d'action. Cela évite que le reporting casse à cause de fautes de frappe (« High » vs « HIGH »).

Pièces jointes (preuves) avec rétention en tête

Traitez les preuves comme des données de première classe : une table Attachments avec les métadonnées de fichier (nom, type, taille, uploader, enregistrement lié, date d'upload), plus des champs pour date de rétention/suppression et classification d'accès. Stockez les fichiers dans un stockage d'objets, mais gardez les règles de gouvernance dans la base.

Planifier les workflows, approbations et responsabilités

Une application de risque échoue rapidement quand « qui fait quoi » est flou. Avant de construire des écrans, définissez les états de workflow, qui peut faire passer les éléments entre états, et ce qui doit être capturé à chaque étape.

Rôles et permissions (restez simple)

Commencez par un petit ensemble de rôles et étendez-les seulement si nécessaire :

- Créateur : peut rédiger de nouveaux risques, contrôles, incidents et actions

- Propriétaire du risque : responsable de l'exactitude et de la revue continue

- Approver : valide les entrées et peut les marquer comme « officielles »

- Auditeur / lecture seule : peut voir, exporter et (optionnellement) commenter, mais pas modifier

- Admin : gère la configuration, les utilisateurs et les permissions

Rendez les permissions explicites par type d'objet (risque, contrôle, action) et par capacité (création, édition, approbation, clôture, réouverture).

Flux d'approbation : brouillon → revue → approuvé → re-revue

Utilisez un cycle de vie clair avec des portes prévisibles :

- Brouillon : modifiable ; champs incomplets autorisés

- En revue : modifications restreintes ; commentaires du réviseur requis

- Approuvé : champs centraux verrouillés ; les changements exigent une demande de mise à jour formelle

- Revue périodique : points de contrôle programmés (ex. trimestriel) pour confirmer qu'il n'y a rien de changé

SLA, rappels et logique de retard

Associez des SLA aux cycles de revue, aux tests de contrôle et aux dates d'échéance des actions. Envoyez des rappels avant les échéances, escaladez après les SLA manqués et affichez les éléments en retard de façon visible (pour les propriétaires et leurs managers).

Délégation, réaffectation et responsabilité

Chaque élément doit avoir un propriétaire responsable plus des collaborateurs optionnels. Autorisez la délégation et la réaffectation, mais exigez une raison (et éventuellement une date d'effet) afin que les lecteurs comprennent pourquoi la responsabilité a changé et quand elle a été transférée.

Concevoir l'expérience utilisateur et les écrans clés

Transformez les exigences en plan de développement

Utilisez le mode Planification pour définir rôles, validations, règles de scoring et rapports avant de générer le code.

Une application de risque réussit quand les gens l'utilisent réellement. Pour des utilisateurs non techniques, la meilleure UX est prévisible, à faible friction et cohérente : libellés clairs, jargon minimal et aides suffisantes pour éviter des saisies vagues « divers ».

1) Saisie du risque : favoriser de bonnes données par défaut

Votre formulaire d'entrée doit ressembler à une conversation guidée. Ajoutez un court texte d'aide sous les champs (pas de longues instructions) et marquez comme requis seulement les champs vraiment indispensables.

Incluez l'essentiel : titre, catégorie, processus/zone, propriétaire, statut actuel, score initial et « pourquoi c'est important » (narratif d'impact). Si vous utilisez un scoring, intégrez des infobulles à côté de chaque facteur pour que les utilisateurs comprennent les définitions sans quitter la page.

2) Vue liste des risques : triage et suivi en un endroit

La plupart des utilisateurs vivront dans la vue liste ; rendez-la rapide pour répondre à : « Que faut-il traiter ? »

Fournissez des filtres et tris pour statut, propriétaire, catégorie, score, date de dernière revue et actions en retard. Mettez en avant les exceptions (revues en retard, actions échues) avec des badges subtils — pas des couleurs d'alerte partout — afin que l'attention se porte sur les éléments importants.

3) Page détail du risque : une histoire, des enregistrements liés

L'écran détail doit se lire comme un résumé en premier, puis les détails de support. Gardez la zone supérieure axée : description, score courant, dernière revue, prochaine date de revue, et propriétaire.

En dessous, affichez les contrôles liés, incidents et actions en sections séparées. Ajoutez des commentaires pour le contexte (« pourquoi nous avons changé la note ») et des pièces jointes pour les preuves.

Les actions nécessitent attribution, dates d'échéance, progression, uploads de preuves et critères de clôture explicites. Rendre la clôture explicite : qui approuve la clôture et quelles preuves sont requises.

Si vous avez besoin d'une mise en page de référence, gardez la navigation simple et cohérente entre les écrans (ex. /risks, /risks/new, /risks/{id}, /actions).

Implémenter le scoring et la logique de revue

Le scoring est l'endroit où votre application devient actionnable. L'objectif n'est pas de « noter » les équipes, mais de standardiser la comparaison des risques, décider ce qui nécessite priorisation, et empêcher que les items ne deviennent obsolètes.

Choisir (et documenter) un modèle de scoring

Commencez par un modèle simple et explicable qui fonctionne pour la plupart des équipes. Un défaut courant est une échelle 1–5 pour Probabilité et Impact, avec un score calculé :

- Score = Probabilité × Impact

Rédigez des définitions claires pour chaque valeur (ce que signifie « 3 », pas seulement le nombre). Placez cette documentation à côté des champs dans l'UI (infobulles ou tiroir « Comment fonctionne le scoring ») pour que les utilisateurs n'aient pas à la chercher.

Faire en sorte que les seuils aient du sens et déclenchent des actions

Les chiffres seuls ne génèrent pas de comportements — ce sont les seuils qui le font. Définissez les limites pour Bas / Moyen / Élevé (et éventuellement Critique) et décidez de ce que chaque niveau déclenche.

Exemples :

- Élevé : nécessite un propriétaire, une date cible et une approbation de la direction avant clôture

- Moyen : nécessite un plan d'atténuation mais peut ne pas exiger d'approbation

- Bas : suivre et revoir ; pas d'action immédiate requise

Gardez les seuils configurables, car ce qui compte comme « Élevé » diffère selon l'unité métier.

Suivre risque inhérent vs résiduel

Les discussions sur le risque opérationnel s'enlisent souvent quand les gens parlent de choses différentes. Résolvez cela en séparant :

- Risque inhérent : avant contrôles

- Risque résiduel : après prise en compte des contrôles

Dans l'UI, affichez les deux scores côte à côte et montrez comment les contrôles affectent le risque résiduel (par exemple, un contrôle peut réduire la Probabilité de 1 ou l'Impact de 1). Évitez de cacher la logique derrière des ajustements automatisés que les utilisateurs ne peuvent pas expliquer.

Construire des règles de revue configurables

Ajoutez une logique de revue basée sur le temps pour que les risques ne deviennent pas obsolètes. Une base pratique :

- Risques élevés : revue trimestrielle

- Risques moyens : revue semestrielle

- Risques faibles : revue annuelle

Rendez la fréquence de revue configurable par unité métier et autorisez des dérogations par risque. Automatisez ensuite les rappels et le statut « revue en retard » basé sur la date de dernière revue.

Éviter le scoring « boîte noire »

Rendez le calcul visible : affichez Probabilité, Impact, tout ajustement par les contrôles et le score résiduel final. Les utilisateurs doivent pouvoir répondre à « Pourquoi est-ce Élevé ? » en un coup d'œil.

Construire la piste d'audit, le versioning et la gestion des preuves

Lancez un pilote en toute sécurité

Déployez une bêta interne avec hébergement et déploiement intégrés, puis itérez avec les retours.

Un outil de suivi des risques opérationnels n'est crédible que par son historique. Si un score change, un contrôle est marqué « testé », ou un incident est reclassifié, il faut une trace répondant : qui a fait quoi, quand et pourquoi.

Décider de ce qu'il faut auditer (et l'expliciter)

Commencez par une liste claire d'événements pour ne pas manquer d'actions importantes ni noyer le journal de bruit. Événements d'audit courants :

- Création/mise à jour/suppression sur objets centraux (risques, contrôles, incidents, actions)

- Décisions d'approbation (soumis, approuvé, rejeté) et réaffectation de propriété

- Exports (CSV/PDF), surtout pour les équipes régulées

- Événements d'authentification (tentatives de connexion, réinitialisations de mot de passe) et changements de permissions

Capturer le « qui/quand/quoi » plus du contexte

Au minimum, stockez acteur, horodatage, type/ID de l'objet et les champs modifiés (ancienne valeur → nouvelle valeur). Ajoutez une note optionnelle « raison du changement » — elle évite des aller-retour confus plus tard (« changé le score résiduel après la revue trimestrielle »).

Gardez le journal d'audit append-only. Évitez d'autoriser des modifications, même par les admins ; si une correction est nécessaire, créez un nouvel événement qui référence le précédent.

Fournir une vue en lecture seule du journal d'audit

Les auditeurs et administrateurs ont généralement besoin d'une vue dédiée, filtrable : par plage de dates, objet, utilisateur et type d'événement. Facilitez l'export depuis cet écran tout en journalisant l'export lui-même. Si vous avez une zone admin, créez un lien depuis /admin/audit-log.

Versionner les preuves et empêcher les remplacements silencieux

Les fichiers de preuve (captures d'écran, résultats de tests, politiques) doivent être versionnés. Traitez chaque upload comme une nouvelle version avec son horodatage et son uploader, et conservez les versions antérieures. Si des remplacements sont autorisés, exigez une note de raison et conservez les deux versions.

Définir la rétention et l'accès pour les preuves sensibles

Mettez en place des règles de rétention (ex. conserver les événements d'audit pendant X années ; purger les preuves après Y sauf si elles sont en retenue légale). Verrouillez l'accès aux preuves avec des permissions plus strictes que l'enregistrement du risque lui-même lorsque cela contient des données personnelles ou des détails de sécurité.

Aborder la sécurité, la confidentialité et le contrôle d'accès

La sécurité et la confidentialité ne sont pas des « options » pour une application de suivi des risques opérationnels — elles déterminent la confiance des utilisateurs pour signaler des incidents, joindre des preuves et assigner des responsabilités. Commencez par cartographier qui doit y avoir accès, ce qu'ils doivent voir et ce qui doit être restreint.

Authentification : SSO vs email/mot de passe

Si votre organisation utilise déjà un fournisseur d'identité (Okta, Azure AD, Google Workspace), privilégiez le Single Sign-On via SAML ou OIDC. Cela réduit les risques liés aux mots de passe, simplifie l'onboarding/offboarding et s'aligne sur les politiques d'entreprise.

Si vous ciblez de petites équipes ou des utilisateurs externes, email/mot de passe peut convenir — mais associez-le à des règles de mot de passe robustes, une récupération sécurisée de compte et (lorsque possible) du MFA.

RBAC qui reflète la réalité du travail

Définissez des rôles qui reflètent les responsabilités réelles : admin, propriétaire du risque, réviseur/approuveur, contributeur, lecture seule, auditeur.

Le risque opérationnel nécessite souvent des limites plus strictes qu'un outil interne classique. Envisagez un RBAC pouvant restreindre l'accès :

- Par unité métier/département (ex. Finance ne peut pas voir les incidents RH)

- Par niveau d'enregistrement (ex. seule une équipe d'enquête spécifique peut accéder à un incident sensible)

Gardez les permissions compréhensibles — les utilisateurs doivent rapidement comprendre pourquoi ils voient ou non un enregistrement.

Principes de protection des données non négociables

Utilisez le chiffrement en transit (HTTPS/TLS) partout et appliquez le principe du moindre privilège pour les services applicatifs et bases de données. Les sessions doivent être protégées par des cookies sécurisés, des délais d'expiration courts en cas d'inactivité et une invalidation côté serveur à la déconnexion.

Sensibilité au niveau des champs et redaction

Tous les champs n'ont pas le même niveau de risque. Les narratifs d'incident, notes d'impact client ou détails d'employés peuvent nécessiter des contrôles plus stricts. Supportez la visibilité au niveau des champs (ou au moins la rédaction) afin que les utilisateurs puissent collaborer sans exposer largement des contenus sensibles.

Garde-fous administratifs

Ajoutez quelques garde-fous pratiques :

- Journaux d'activité admin (qui a changé les permissions, exports, configurations)

- Listes d'IP autorisées optionnelles pour les environnements à haut risque

- MFA obligatoire pour les admins (même si d'autres n'utilisent pas le MFA)

Bien conçus, ces contrôles protègent les données tout en conservant des workflows de reporting et de remédiation fluides.

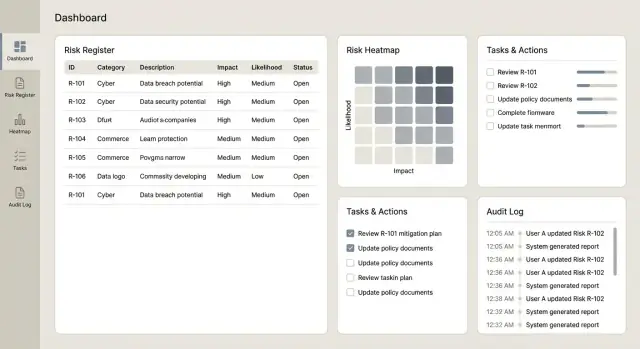

Livrer des tableaux de bord, rapports et exports

Les tableaux de bord et rapports sont l'endroit où une application de suivi des risques prouve sa valeur : ils transforment un long registre en décisions claires pour propriétaires, managers et comités. L'essentiel est de rendre les chiffres traçables jusqu'aux règles de scoring et aux enregistrements sous-jacents.

Tableaux de bord que les gens utiliseront

Commencez par un petit ensemble de vues à haute signalisation qui répondent rapidement aux questions courantes :

- Principaux risques par score résiduel (avec possibilité de basculer sur inhérent)

- Tendances dans le temps (ex. tendance du risque résiduel par mois/trimestre)

- Distribution résiduelle vs inhérente, incluant une vue simple « avant vs après contrôles »

- Une carte thermique (probabilité × impact) qui relie chaque case aux risques sous-jacents

Rendez chaque tuile cliquable pour permettre aux utilisateurs d'explorer la liste exacte des risques, contrôles, incidents et actions derrière le graphique.

Vues opérationnelles pour la gestion quotidienne

Les tableaux de décision diffèrent des vues opérationnelles. Ajoutez des écrans focalisés sur ce qui nécessite de l'attention cette semaine :

- Actions en retard (par propriétaire/équipe, avec jours de retard)

- Revues à venir (risques ou contrôles devant être revus)

- Tests de contrôles échoués (échecs récents, gravité et remédiations ouvertes)

- Fréquence des incidents (comptes et taux dans le temps, avec filtres par processus/catégorie)

Ces vues se marient bien avec les rappels et la responsabilité des tâches pour que l'application soit perçue comme un outil de workflow, pas seulement une base de données.

Exports utiles pour comités et audits

Planifiez les exports tôt, car les comités s'appuient souvent sur des packs hors ligne. Supportez CSV pour l'analyse et PDF pour la distribution en lecture seule, avec :

- Filtres (unité métier, catégorie, propriétaire, statut)

- Plages de dates (incidents sur la période, actions créées/fermées sur la période)

- Libellés clairs (inhérent vs résiduel, dates de version et filtres appliqués)

Si vous avez déjà un modèle de pack de gouvernance, faites-en un miroir pour faciliter l'adoption.

Assurez-vous que chaque définition de rapport correspond à vos règles de scoring. Par exemple, si le tableau classe les « principaux risques » par score résiduel, cela doit être aligné avec le même calcul utilisé sur la fiche et dans les exports.

Pour de grands registres, anticipez la performance : pagination sur les listes, caching pour les agrégats fréquents, et génération de rapports asynchrone (générer en arrière-plan et notifier quand prêt). Si vous ajoutez ultérieurement des rapports programmés, conservez des liens internes (ex. sauvegarder une configuration de rapport réouvrable depuis /reports).

Planifier les intégrations et la migration des données

Répondez aux contraintes de localisation des données

Choisissez où votre application s'exécute pour respecter les exigences internes de confidentialité et de transfert de données.

Les intégrations et la migration déterminent si votre application devient le système de référence — ou juste un autre endroit que l'on oublie de mettre à jour. Planifiez-les tôt, mais implémentez-les progressivement pour garder le produit central stable.

Partir des workflows déjà utilisés

La plupart des équipes ne veulent pas « une autre liste de tâches ». Elles veulent que l'application se connecte aux outils où le travail se passe :

- Jira ou ServiceNow pour créer et suivre les actions de remédiation (et synchroniser le statut)

- Slack ou Microsoft Teams pour les alertes lors d'une escalade, d'une revue due ou d'une demande de preuves

- E-mails pour les rappels périodiques et approbations (utile pour les utilisateurs occasionnels)

Approche pratique : garder l'app de risque comme propriétaire des données de risque, tandis que les outils externes gèrent l'exécution (tickets, assignés, échéances) et renvoient les mises à jour d'avancement.

Alimenter le registre depuis des tableurs — en toute sécurité

Beaucoup d'organisations commencent par Excel. Proposez un import acceptant les formats courants, mais ajoutez des garde-fous :

- Règles de validation (champs requis, formats de date, plages numériques)

- Détection des doublons (ex. même titre de risque + processus + propriétaire) avec option « fusionner/sauter »

- Application de la taxonomie (unité métier, processus, catégorie de risque) pour éviter un reporting chaotique

Affichez un aperçu de ce qui sera créé, rejeté et pourquoi. Cet écran peut vous faire gagner des heures de validation.

Bases d'API qui réduisent la douleur future

Même si vous commencez avec une seule intégration, concevez l'API comme si vous en auriez plusieurs :

- Conservez des endpoints cohérents et des noms clairs (ex. /risks, /controls, /actions)

- Assurez la journalisation d'audit sur les écritures (qui a changé quoi, quand et d'où)

- Ajoutez limitation de débit et codes d'erreur clairs pour que les intégrations échouent proprement

Gérer les échecs avec retries et statut visible

Les intégrations échouent pour des raisons normales : changements de permissions, timeouts réseau, tickets supprimés. Préparez-vous :

- Queuez les requêtes sortantes et retry avec backoff

- Enregistrez un statut d'intégration sur chaque élément lié (« Synced », « Pending », « Failed »)

- Fournissez des messages actionnables (« jeton ServiceNow expiré — reconnecter ») et un bouton manuel « Retry now »

Cela maintient la confiance et évite une dérive silencieuse entre le registre et les outils d'exécution.

Tester, lancer et améliorer dans le temps

Une application de suivi des risques devient précieuse quand les gens lui font confiance et l'utilisent régulièrement. Traitez les tests et le déploiement comme faisant partie du produit, pas comme la case finale à cocher.

Construire une stratégie de tests pragmatique

Commencez par des tests automatisés pour les parties qui doivent se comporter de la même façon à chaque fois — en particulier le scoring et les permissions :

- Tests unitaires pour le scoring : vérifier les calculs probabilité/impact, les seuils, l'arrondi et les cas limites (ex. « N/A », champs manquants, overrides)

- Tests de workflow pour les approbations : s'assurer que les changements d'état respectent les règles (brouillon → soumis → approuvé), incluant réaffectation et chemins de rejet

- Tests de permission : confirmer que les viewers ne peuvent pas éditer, que les propriétaires ne peuvent pas approuver leurs propres soumissions (si telle est la règle), et que les admins peuvent auditer sans briser la séparation des tâches

Faire de l'UAT avec des scénarios réels

L'UAT fonctionne mieux quand il reflète le travail réel. Demandez à chaque unité métier de fournir un petit ensemble de risques, contrôles, incidents et actions exemples, puis testez des scénarios typiques :

- créer un risque, lier des contrôles et soumettre pour approbation

- mettre à jour après un incident et joindre une preuve

- clôturer une action et vérifier l'impact sur le reporting

Recueillez non seulement les bugs, mais aussi les libellés confus, les statuts manquants et les champs qui ne correspondent pas au langage des équipes.

Déploiement pilote avant le lancement global

Lancez d'abord à une équipe (ou une région) pendant 2–4 semaines. Contrôlez la portée : un seul workflow, un petit nombre de champs et une métrique de succès claire (ex. % de risques revus à temps). Utilisez le retour pour ajuster :

- noms de champs et champs requis

- étapes d'approbation et règles de propriété

- timing des rappels et escalades

Fournissez des guides pratiques et un glossaire d'une page : ce que signifie chaque score, quand utiliser chaque statut et comment joindre des preuves. Une session live de 30 minutes plus des clips enregistrés vaut souvent mieux qu'un long manuel.

Accélérer avec Koder.ai (optionnel)

Si vous souhaitez atteindre un v1 crédible rapidement, une plateforme de type « vibe-coding » comme Koder.ai peut aider à prototyper et itérer les workflows sans un long temps de mise en place. Vous pouvez décrire les écrans et règles (saisie du risque, approbations, scoring, rappels, vues d'audit) en chat, puis affiner l'application générée au fil des retours.

Koder.ai prend en charge la livraison end-to-end : construction d'apps web (souvent React), services backend (Go + PostgreSQL), et inclut des fonctionnalités pratiques comme l'export du code source, le déploiement/hosting, domaines personnalisés et snapshots avec rollback — utile quand vous changez taxonomies, échelles de scoring ou flux d'approbation et avez besoin d'itérer en sécurité. Les équipes peuvent démarrer sur une offre gratuite et monter en gamme (pro, business, enterprise) selon les besoins de gouvernance et d'échelle.

Maintenir l'application saine après le lancement

Planifiez tôt l'exploitation continue : sauvegardes automatisées, surveillance basique de l'uptime/erreurs, et un processus léger de changement pour la taxonomie et les échelles de scoring afin que les mises à jour restent cohérentes et auditées dans le temps.