Pourquoi le C compte encore

Le C est une de ces technologies que peu de gens touchent directement, et pourtant presque tout le monde en dépend. Si vous utilisez un téléphone, un ordinateur portable, un routeur, une voiture, une montre connectée, ou même une machine à café avec écran, il y a de fortes chances que du C soit quelque part dans la pile — pour démarrer l'appareil, piloter le matériel ou rendre le logiciel assez rapide pour paraître « instantané ».

Pour les constructeurs, le C reste un outil pratique car il offre un mélange rare de contrôle et de portabilité. Il peut s'exécuter très près de la machine (on gère la mémoire et le matériel directement), tout en pouvant être déplacé entre différents CPU et systèmes d'exploitation avec relativement peu de réécritures. Cette combinaison est difficile à remplacer.

Les trois domaines où le C domine encore

La plus grande empreinte du C se voit dans trois domaines :

- Systèmes d'exploitation : noyaux, bibliothèques de base, pilotes et utilitaires bas niveau dont tout le reste dépend.

- Dispositifs embarqués : petits systèmes avec des limites strictes de mémoire, d'énergie et de stockage, où un comportement prévisible est essentiel.

- Points chauds de performance : parties sensibles à la vitesse au sein de programmes plus larges — des chemins où quelques millisecondes ou quelques watts comptent.

Même lorsqu'une application est écrite dans des langages de plus haut niveau, des morceaux de sa fondation (ou ses modules sensibles à la performance) renvoient souvent au C.

Ce que vous apprendrez dans cet article

Cet article relie Dennis Ritchie, les objectifs originels du C, et les raisons pour lesquelles il apparaît encore dans les produits modernes. Nous couvrirons :

- un bref aperçu historique (y compris l'influence d'Unix),

- les choix de conception qui rendent le C petit mais puissant,

- où s'intègre le C aujourd'hui — ses forces et ses défis en matière de sécurité.

Remarque sur le périmètre

Il s'agit du C spécifiquement, pas de « tous les langages bas‑niveau ». C++ et Rust peuvent apparaître pour comparaison, mais l'accent reste sur ce qu'est le C, pourquoi il a été conçu ainsi, et pourquoi les équipes continuent de le choisir pour des systèmes réels.

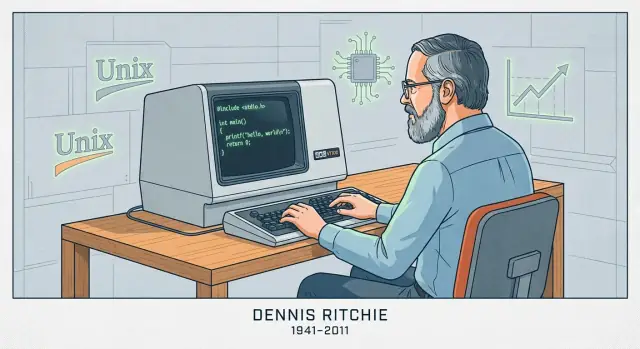

Dennis Ritchie en bref

Dennis Ritchie (1941–2011) était un informaticien américain surtout connu pour son travail aux Bell Labs d'AT&T, un centre de recherche qui a joué un rôle central dans l'informatique et les télécommunications naissantes.

Bell Labs, Unix et un nouveau type de logiciel système

Aux Bell Labs à la fin des années 1960 et dans les années 1970, Ritchie a travaillé avec Ken Thompson et d'autres sur la recherche en systèmes d'exploitation qui a abouti à Unix. Thompson a créé une première version d'Unix ; Ritchie est devenu un co‑créateur clé à mesure que le système évoluait en quelque chose de maintenable, améliorables et partageable largement en milieu universitaire et industriel.

Créer le C pour construire de vrais systèmes

Ritchie a aussi créé le langage C, en s'appuyant sur des idées issues de langages antérieurs utilisés aux Bell Labs. Le C a été conçu pour être pratique pour l'écriture de logiciels système : il donne aux programmeurs un contrôle direct sur la mémoire et la représentation des données, tout en restant plus lisible et portable que d'écrire tout en assembleur.

Cette combinaison a compté parce qu'Unix a finalement été réécrit en C. Ce n'était pas une réécriture cosmétique — elle a rendu Unix beaucoup plus facile à porter sur de nouveaux matériels et à étendre dans le temps. Le résultat a été une boucle de rétroaction puissante : Unix offrait un cas d'utilisation sérieux et exigeant pour le C, et le C a facilité l'adoption d'Unix au‑delà d'une seule machine.

Pourquoi l'association Unix + C est devenue influente

Ensemble, Unix et le C ont contribué à définir la « programmation système » telle que nous la connaissons : construire des systèmes d'exploitation, des bibliothèques de base et des outils dans un langage proche de la machine mais pas lié à un processeur unique. Leur influence se retrouve dans les systèmes ultérieurs, les outils pour développeurs et les conventions que beaucoup d'ingénieurs apprennent encore aujourd'hui — moins par mythologie que parce que l'approche fonctionnait à grande échelle.

Les premiers systèmes d'exploitation étaient principalement écrits en assembleur. Cela donnait aux ingénieurs un contrôle total sur le matériel, mais chaque changement était lent, sujet aux erreurs et fortement lié à un processeur spécifique. Même de petites fonctionnalités pouvaient nécessiter des pages de code bas niveau, et porter le système sur une autre machine signifiait souvent réécrire de larges portions.

De BCPL à B puis à C (en bref)

Dennis Ritchie n'a pas inventé le C dans un vide. Il a grandi à partir de langages systèmes plus anciens utilisés aux Bell Labs.

- BCPL proposait un style compact pour écrire des outils et des logiciels système.

- B (créé par Ken Thompson) a adapté les idées de BCPL pour les premiers travaux sur Unix, mais lui manquaient les types et la structure nécessaires pour des systèmes plus grands.

- C a conservé l'esprit d'un « petit langage », tout en ajoutant les fonctionnalités qui ont rendu Unix pratique à construire et maintenir sur du matériel réel.

L'objectif de conception : une fine couche au‑dessus de la machine

Le C a été construit pour se mapper proprement sur ce que font réellement les ordinateurs : des octets en mémoire, des opérations arithmétiques sur des registres et des sauts dans le code. C'est pourquoi des types simples, un accès explicite à la mémoire et des opérateurs proches des instructions CPU sont centraux. On peut écrire du code suffisamment haut niveau pour gérer une grande base de code, tout en restant assez direct pour contrôler la disposition en mémoire et les performances.

Que signifie « portable » en termes simples

« Portable » signifie que vous pouvez déplacer le même code source C sur un autre ordinateur et, avec des changements minimaux, le compiler là‑bas et obtenir le même comportement. Au lieu de réécrire le système d'exploitation pour chaque nouveau processeur, les équipes pouvaient conserver la majeure partie du code et ne remplacer que les petites parties dépendantes du matériel. Ce mélange — code partagé majoritaire et bords spécifiques à la machine limités — a été la percée qui a aidé Unix à se répandre.

Les idées centrales qui rendent le C rapide

La vitesse du C n'est pas magique — elle découle surtout de la proximité entre le langage et ce que fait la machine, et du peu d'« effort » supplémentaire inséré entre votre code et le CPU.

Ce que produit la compilation

Le C est généralement compilé. Vous écrivez du code lisible par l'humain, puis un compilateur le traduit en code machine : les instructions brutes exécutées par le processeur.

En pratique, le compilateur produit un exécutable (ou des fichiers objets ensuite liés). Le point clé est que le résultat final n'est pas interprété ligne par ligne à l'exécution — il est déjà sous une forme que le CPU comprend, ce qui réduit les surcoûts.

Contrôle prévisible, faible overhead

Le C fournit des blocs de construction simples : fonctions, boucles, entiers, tableaux et pointeurs. Parce que le langage est petit et explicite, le compilateur peut souvent générer un code machine direct.

Il n'y a généralement pas de runtime obligatoire qui fasse du travail d'arrière‑plan comme suivre chaque objet, insérer des vérifications cachées ou gérer des métadonnées complexes. Quand vous écrivez une boucle, vous obtenez généralement une boucle. Quand vous accédez à un élément de tableau, vous obtenez généralement un accès direct en mémoire. Cette prévisibilité explique en grande partie les bonnes performances du C dans les parties sensibles au temps.

Gestion manuelle de la mémoire : contrôle avec conséquences

Le C utilise la gestion manuelle de la mémoire, ce qui signifie que votre programme demande explicitement de la mémoire (par exemple malloc) et la libère explicitement (free). Cela existe parce que les logiciels système ont souvent besoin d'un contrôle fin sur quand la mémoire est allouée, combien et pour combien de temps — avec un minimum de surcoûts cachés.

Le compromis est simple : plus de contrôle peut signifier plus de vitesse et d'efficacité, mais aussi plus de responsabilité. Oublier de libérer la mémoire, la libérer deux fois ou utiliser de la mémoire après l'avoir libérée peut provoquer des bugs sévères — et parfois critiques pour la sécurité.

Le C dans les systèmes d'exploitation : noyaux, pilotes et bibliothèques de base

Les systèmes d'exploitation se situent à la frontière entre logiciel et matériel. Le noyau doit gérer la mémoire, ordonnancer le CPU, traiter les interruptions, dialoguer avec les périphériques et fournir des appels système sur lesquels tout le reste s'appuie. Ces tâches ne sont pas abstraites — elles consistent à lire et écrire des emplacements mémoire précis, travailler avec des registres CPU et réagir à des événements imprévus.

Pourquoi les noyaux et pilotes ont besoin d'un accès bas‑niveau

Les pilotes de périphériques et les noyaux ont besoin d'un langage qui exprime « fais exactement ceci » sans travail caché. Concrètement cela signifie :

- Contrôle précis de la disposition mémoire (structures correspondant aux formats définis par le matériel)

- Manipulation directe de pointeurs pour mapper la mémoire du périphérique ou construire des tables de pages

- Capacité à interagir avec les interruptions et les primitives de concurrence

- Conventions d'appel prévisibles et exigences minimales en matière de runtime

Le C convient car son modèle central est proche de la machine : octets, adresses et flux de contrôle simples. Il n'y a pas de runtime obligatoire, de ramasse‑miettes ou de système d'objets que le noyau devrait héberger avant de démarrer.

Le C comme choix par défaut pour les noyaux et les bibliothèques de base

Unix et les travaux systèmes initiaux ont popularisé l'approche que Ritchie a contribué à façonner : implémenter de larges parties de l'OS dans un langage portable, tout en gardant la « bordure matérielle » mince. Beaucoup de noyaux modernes suivent encore ce schéma. Même lorsqu'un assembleur est requis (code de bootstrap, changements de contexte), le C porte généralement la majeure partie de l'implémentation.

Le C domine également les bibliothèques système fondamentales — des composants comme la libc, le code réseau de base et les morceaux runtime bas niveau dont dépendent souvent les langages de plus haut niveau. Si vous avez utilisé Linux, BSD, macOS, Windows ou un RTOS, vous avez presque certainement utilisé du code C, que vous en ayez conscience ou non.

Pourquoi les équipes continuent de faire confiance au C ici

L'attrait du C en travail OS tient moins de la nostalgie que de l'économie d'ingénierie :

- Chaînes d'outils stables : compilateurs, linkers, débogueurs et profileurs matures et bien connus

- Portabilité : la même base de code C peut être portée sur de nouveaux CPU et cartes avec un effort maîtrisable

- Modèle mental matériel clair : il est plus facile de raisonner sur ce que générera le compilateur et comment le code se comportera sous contraintes strictes

D'autres langages existent — mais le C reste la base

Rust, C++ et d'autres langages sont utilisés dans des parties d'OS et peuvent apporter de réels avantages. Pourtant, le C reste le dénominateur commun : beaucoup de noyaux y sont écrits, de nombreuses interfaces bas‑niveau l'attendent, et il constitue la base avec laquelle d'autres langages doivent interopérer.

Le C dans les dispositifs embarqués : petite empreinte, contrôle prévisible

Conservez le code portable

Recevez l'export du code source lorsque vous êtes prêt à prendre en main la stack.

« Embarqué » désigne souvent des ordinateurs qu'on ne considère pas comme tels : microcontrôleurs dans thermostats, enceintes connectées, routeurs, voitures, dispositifs médicaux, capteurs industriels et innombrables appareils. Ces systèmes exécutent souvent une seule fonction pendant des années, discrètement, avec des contraintes étroites sur le coût, l'énergie et la mémoire.

Les contraintes des équipes embarquées

Beaucoup de cibles embarquées disposent de kilooctets (pas de gigaoctets) de RAM et d'un stockage flash limité pour le code. Certaines fonctionnent sur batterie et doivent dormir la majeure partie du temps. D'autres ont des deadlines temps réel — si une boucle de contrôle moteur arrive en retard de quelques millisecondes, le matériel peut mal se comporter.

Ces contraintes influencent chaque décision : la taille du programme, la fréquence d'activation et la prévisibilité temporelle.

Pourquoi le C convient si bien

Le C tend à produire des binaires petits avec un overhead runtime minime. Il n'y a pas de machine virtuelle obligatoire, et on peut souvent éviter l'allocation dynamique. Cela compte quand il faut faire tenir un firmware dans une taille flash fixe ou garantir que l'appareil ne « pause » pas de manière inattendue.

Tout aussi important, le C facilite la communication avec le matériel. Les puces embarquées exposent des périphériques — broches GPIO, timers, bus UART/SPI/I2C — via des registres mappés en mémoire. Le modèle du C s'y prête naturellement : on peut lire et écrire des adresses précises, contrôler des bits individuels et le faire avec très peu d'abstraction en travers.

Schémas courants dans les projets réels

Beaucoup de C embarqué est soit :

- Bare‑metal : pas de système d'exploitation, juste le code de démarrage, une boucle principale et des gestionnaires d'interruption.

- Basé sur RTOS : un petit OS temps réel où des tâches C coordonnent via files, sémaphores et timers.

Dans les deux cas, vous verrez du code centré sur des registres matériels (souvent marqués volatile), des tampons de taille fixe et un timing soigné. Ce style « proche de la machine » explique pourquoi le C reste le choix par défaut pour un firmware petit, économe en énergie et fiable.

« Critique pour la performance » désigne toute situation où le temps et les ressources font partie du produit : des millisecondes affectent l'expérience utilisateur, des cycles CPU pèsent sur le coût serveur et la mémoire détermine si un programme tient ou non. Dans ces domaines, le C reste un choix par défaut car il permet de contrôler la disposition des données en mémoire, la planification du travail et ce que le compilateur peut optimiser.

Où la vitesse du C compte dans la vraie vie

On trouve souvent du C au cœur de systèmes où le travail s'exécute en grand volume ou sous de fortes contraintes de latence :

- Bases de données et moteurs de stockage (indexation, cache, compression, exécution de requêtes)

- Codecs audio/vidéo et traitement d'image (boucles d'encodage/décodage exécutées des milliards de fois)

- Réseau (traitement de paquets, proxies, primitives TLS, boucles d'événements)

- Moteurs de jeu (budget de trame, physique, streaming d'actifs)

- Morceaux HPC (noyaux numériques, routines vectorisées, allocateurs mémoire sur mesure)

Ces domaines ne sont pas « rapides » partout : ils ont généralement des boucles internes spécifiques qui dominent le temps d'exécution.

Le « hot path » : optimiser les 5 % qui coûtent 95 %

Les équipes réécrivent rarement un produit entier en C pour le rendre plus rapide. Elles profilent, identifient le chemin chaud (la petite portion où le temps est majoritairement passé) et optimisent seulement ça.

Le C aide car les hot paths sont souvent limités par des détails bas‑niveau : motifs d'accès mémoire, comportement du cache, prédiction de branchement et overhead d'allocation. Quand on peut ajuster les structures de données, éviter les copies inutiles et contrôler l'allocation, les gains peuvent être spectaculaires — sans toucher au reste de l'application.

Travailler avec des langages de haut niveau : extensions et FFI

Les produits modernes sont fréquemment « multi‑langages » : Python, Java, JavaScript ou Rust pour la majorité, et C pour le cœur critique.

Les approches d'intégration communes incluent :

- Extensions natives (par exemple les extensions C pour Python, les addons Node‑API)

- FFI (Foreign Function Interface) où un langage appelle des fonctions C compilées via une ABI stable

- Bibliothèques C partagées utilisées par de nombreux runtimes (une implémentation rapide, de nombreux appelants)

Ce modèle rend le développement pratique : itération rapide en langage haut‑niveau, et performances prévisibles là où c'est important. Le compromis est la prudence aux frontières — conversions de données, règles de propriété et gestion d'erreur — car traverser la frontière FFI doit rester efficace et sûr.

Portabilité et standards : pourquoi le C voyage bien

Itérez sans crainte

Utilisez des instantanés et des rollbacks pour tester les modifications en toute sécurité pendant vos itérations.

Une des raisons pour lesquelles le C s'est répandu si rapidement est qu'il voyage : le même langage de base peut être implémenté sur des machines très différentes, des microcontrôleurs minuscules aux supercalculateurs. Cette portabilité n'est pas magique — elle résulte de standards partagés et d'une culture d'écriture conforme à ceux‑ci.

Les premières implémentations du C variaient selon les vendeurs, ce qui rendait le partage de code difficile. Le grand changement est venu avec ANSI C (souvent appelé C89/C90) puis ISO C (révisions ultérieures comme C99, C11, C17 et C23). Pas besoin de retenir les numéros ; l'important est qu'un standard est un accord public sur ce que fait le langage et la bibliothèque standard.

Ce qu'un standard apporte réellement

Un standard fournit :

- Règles cohérentes pour le langage (types, opérateurs, structures de contrôle)

- Une bibliothèque standard avec un comportement prévisible (E/S, chaînes, math, allocation mémoire)

- Une base sur laquelle les auteurs de compilateurs peuvent se caler et sur laquelle les équipes peuvent compter

C'est pourquoi un code écrit avec le standard en tête peut souvent être déplacé entre compilateurs et plateformes avec étonnamment peu de changements.

Où la portabilité casse en pratique

Les problèmes de portabilité viennent généralement de l'utilisation de choses que le standard ne garantit pas, notamment :

- Comportement indéfini : du code que le compilateur peut traiter de n'importe quelle façon (qui peut « sembler OK » jusqu'à ce qu'une compilation casse). Exemples classiques : lire au‑delà des bornes d'un tableau ou utiliser une valeur non initialisée.

- Hypothèses sur les tailles :

int n'est pas garanti 32 bits, et la taille des pointeurs varie. Si votre programme suppose des tailles exactes, il peut échouer en changeant de cible.

- APIs spécifiques à une plateforme : appeler des fonctions propres à un OS est parfois nécessaire, mais limite le lieu d'exécution.

Astuce pratique : écrire « standard d'abord », puis tuner

Un bon comportement par défaut est de privilégier la bibliothèque standard et de garder le code non‑portable derrière de petits wrappers nommés clairement.

Aussi, compilez avec des flags qui vous poussent vers un C portable et bien défini. Choix courants :

- Sélectionner un mode standard (par exemple :

-std=c11)

- Activer les warnings (

-Wall -Wextra) et les prendre au sérieux

Cette combinaison — code orienté standard plus builds stricts — fait plus pour la portabilité que n'importe quelle astuce complexe.

La partie difficile : pointeurs, mémoire et classes de bugs courantes

La puissance du C est aussi son tranchant : il permet de travailler près de la mémoire. C'est une grande raison pour laquelle le C est rapide et flexible — et aussi pourquoi débutants (et experts fatigués) peuvent commettre des erreurs que d'autres langages évitent.

Les pointeurs, expliqués avec « adresses et boîtes »

Imaginez la mémoire de votre programme comme une longue rue de boîtes numérotées. Une variable est une boîte qui contient quelque chose (comme un entier). Un pointeur n'est pas la chose — c'est l'adresse écrite sur un bout de papier qui indique quelle boîte ouvrir.

C'est utile : vous pouvez transmettre l'adresse au lieu de copier le contenu, et pointer vers des tableaux, tampons, structs ou même fonctions. Mais si l'adresse est fausse, vous ouvrez la mauvaise boîte.

Risques courants dont vous entendrez parler

- Débordements de tampon : écrire au‑delà de la fin d'un tampon (comme bourrer la boîte #10 et déborder dans la #11). Cela peut planter un programme ou être exploité.

- Use‑after‑free : libérer un bloc de mémoire, puis utiliser plus tard un pointeur qui « se souvient » de son ancienne adresse — alors que la boîte a été réaffectée.

- Débordements d'entiers : arithmétique qui déborde (par ex. un calcul de taille qui devient plus petit que prévu), menant à une allocation trop petite puis à un débordement.

Pourquoi ces bugs comptent

Ces problèmes entraînent des plantages, des corruptions silencieuses de données et des vulnérabilités de sécurité. Dans le code système — où le C est souvent utilisé — ces défaillances peuvent affecter l'ensemble de la pile logicielle qui s'appuie dessus.

Une vue équilibrée

Le C n'est pas « dangereux par défaut ». Il est permissif : le compilateur assume que vous savez ce que vous écrivez. C'est excellent pour la performance et le contrôle bas‑niveau, mais il est aussi facile à mal utiliser si vous n'adoptez pas des habitudes rigoureuses, des revues et de bons outils.

Rendre le C plus sûr dans la pratique

Le C donne un contrôle direct, mais pardonne rarement les erreurs. La bonne nouvelle : « C sûr » tient moins de tours magiques que d'habitudes disciplinées, d'interfaces claires et d'outils qui font les vérifications ennuyeuses.

Techniques défensives qui montent en échelle

Commencez par concevoir des API qui rendent l'usage incorrect difficile. Privilégiez les fonctions qui reçoivent les tailles des buffers avec les pointeurs, renvoient des codes d'état explicites et documentent qui possède la mémoire allouée.

La vérification des limites doit être routinière. Si une fonction écrit dans un buffer, elle doit valider les longueurs en amont et échouer rapidement. Pour la propriété mémoire, simplifiez : un allocateur, un chemin de libération correspondant, et une règle claire sur qui libère.

Outillage : attraper les bugs avant les utilisateurs

Les compilateurs modernes peuvent avertir de motifs risqués — traitez les warnings comme des erreurs en CI. Ajoutez des vérifications runtime pendant le développement avec les sanitizers (address, undefined behavior, leak) pour débusquer out‑of‑bounds, use‑after‑free, débordements d'entier et autres dangers spécifiques au C.

L'analyse statique et les linters aident à trouver des problèmes qui ne remontent pas forcément dans les tests. Le fuzzing est particulièrement efficace pour les parsers et les gestionnaires de protocoles : il génère des entrées inattendues qui révèlent souvent des bugs de tampon et d'état.

Pratiques de revue et de test

La revue de code doit explicitement rechercher les modes d'échec courants du C : indexation off‑by‑one, terminateurs NUL manquants, mélange signé/non signé, valeurs de retour non vérifiées et chemins d'erreur qui fuient de la mémoire.

Les tests comptent davantage lorsque le langage ne vous protège pas. Les tests unitaires sont bien ; les tests d'intégration sont mieux ; et les tests de régression pour les bugs déjà trouvés sont les meilleurs.

Sous‑ensembles plus sûrs et lignes directrices

Si votre projet exige une fiabilité ou une sûreté stricte, envisagez d'adopter un sous‑ensemble restreint du C et un ensemble de règles écrites (par ex. limiter l'arithmétique sur pointeurs, interdire certains appels de bibliothèque ou exiger des wrappers). La clé est la cohérence : choisissez des directives que votre équipe peut appliquer avec des outils et des revues, pas des idéaux qui restent théoriques.

C vs autres langages : pourquoi les équipes le choisissent encore

Invitez votre équipe

Invitez des coéquipiers ou des amis et obtenez des crédits lorsqu'ils commencent à construire eux aussi.

Le C se trouve à une intersection particulière : assez petit pour être compris de bout en bout, et assez proche du matériel et des frontières OS pour être la « colle » dont tout le reste dépend. C'est cette combinaison qui fait que les équipes y reviennent — même si de nouveaux langages paraissent plus agréables sur le papier.

C vs C++ : objectifs différents, compatibilité délicate, mélange pratique

C++ a été conçu pour ajouter des mécanismes d'abstraction plus puissants (classes, templates, RAII) tout en restant source‑compatible avec une grande partie du C. Mais « compatible » n'est pas « identique ». C++ a des règles différentes pour les conversions implicites, la résolution des surcharges et même ce qui constitue une déclaration valide dans des cas limites.

Dans les produits réels, il est courant de les mélanger :

- Les modules bas‑niveau restent en C pour des ABI stables et des conventions d'appel simples.

- Les couches supérieures utilisent C++ pour la structuration et la gestion plus sûre des ressources.

La jonction se fait souvent par une API C. Le code C++ exporte des fonctions avec extern "C" pour éviter le name mangling, et les deux côtés s'accordent sur des structures de données simples. Cela permet de moderniser progressivement sans tout réécrire.

C vs Rust (vue d'ensemble) : la sécurité gagne, mais les contraintes pèsent

La grande promesse de Rust est la sécurité mémoire sans ramasse‑miettes, soutenue par des outils et un écosystème robustes. Pour de nombreux projets systèmes neufs, Rust peut réduire des classes entières de bugs (use‑after‑free, races de données).

Mais adopter Rust n'est pas sans coût. Les équipes peuvent être contraintes par :

- Des bibliothèques C existantes, des pilotes ou des SDK fournisseurs

- Des compilateurs et débogueurs validés pour des cibles spécifiques

- Des régimes de certification où la maturité des outils et les preuves comptent

- Des ingénieurs qui doivent maintenir le code pendant des décennies

Rust peut interopérer avec le C, mais la frontière ajoute de la complexité, et toutes les cibles embarquées ou environnements de build ne sont pas également bien pris en charge.

Beaucoup du code fondamental mondial est en C, et le réécrire est risqué et coûteux. Le C convient aussi aux environnements où l'on a besoin de binaires prévisibles, d'hypothèses runtime minimales et d'une large disponibilité de compilateurs — des microcontrôleurs aux CPU classiques.

Choisir selon les contraintes, pas selon les tendances

Si vous avez besoin d'une portée maximale, d'interfaces stables et de chaînes d'outils éprouvées, le C reste un choix rationnel. Si vos contraintes le permettent et que la sécurité est prioritaire, un langage plus récent peut valoir le coup. La meilleure décision commence par le matériel cible, l'outillage et le plan de maintenance à long terme — pas par la popularité du moment.

Le C n'est pas "en train de disparaître", mais son centre de gravité devient plus clair. Il continuera à prospérer là où le contrôle direct de la mémoire, du timing et des binaires compte — et il cèdera du terrain là où la sécurité et la vitesse d'itération priment plus que l'optimisation du dernier microseconde.

Où le C restera fort

Le C restera probablement un choix par défaut pour :

- Noyaux et travaux OS bas‑niveau (ordonnanceurs, gestionnaires mémoire, systèmes de fichiers), où la performance prévisible et les hypothèses runtime minimales sont nécessaires.

- Pilotes et code face‑matériel, où l'on mappe des registres, gère des interruptions et opère sous fortes contraintes.

- Systèmes embarqués avec budgets RAM/flash serrés et besoins temps réel.

- Bibliothèques et runtimes de base (compression, primitives crypto, VMs de langages, codecs multimédia), où les ABI stables et la portabilité sont précieuses.

Ces domaines évoluent lentement, ont d'énormes bases de code héritées, et récompensent les ingénieurs capables de raisonner en octets, conventions d'appel et modes de défaillance.

Où le C peut reculer (et pourquoi)

Pour le développement d'applications nouvelles, beaucoup d'équipes préfèrent des langages avec de meilleures garanties de sécurité et des écosystèmes plus riches. Les bugs de sécurité mémoire sont coûteux, et les produits modernes privilégient souvent la livraison rapide, la concurrence et des comportements sécurisés par défaut. Même en programmation système, certains composants nouveaux migrent vers des langages plus sûrs — tandis que le C reste le « socle » avec lequel ils interfacent.

Note moderne sur le workflow : le C dans le produit global

Même quand le noyau bas‑niveau est en C, les équipes ont généralement besoin de logiciels périphériques : un tableau de bord web, un service API, un portail de gestion de dispositifs, des outils internes ou une petite appli mobile pour la diagnostic. Ces couches supérieures sont souvent celles où la vitesse d'itération compte le plus.

Si vous voulez avancer vite sur ces couches sans reconstruire toute la pipeline, Koder.ai peut aider : c'est une plateforme « vibe‑coding » où vous pouvez créer des applis web (React), backends (Go + PostgreSQL) et mobiles (Flutter) via du chat — utile pour prototyper un UI d'administration, un visualiseur de logs ou un service de gestion de flotte qui s'intègre à un système basé en C. Le mode planning et l'export du code source rendent pratique le prototypage avant de reprendre le code où vous le souhaitez.

Commencez par les fondamentaux, mais apprenez‑les comme les professionnels utilisent le C :

- Syntaxe et modèle mémoire : entiers, tableaux, structs, notions de pointeurs et leur mapping en mémoire.

- Outils de construction : compilation et linkage, organisation des headers, un Makefile simple (puis CMake).

- Débogage : pas à pas avec gdb/lldb ; apprendre à lire les backtraces.

- Bonnes habitudes de sécurité : compiler avec warnings, utiliser AddressSanitizer/UBSan, écrire de petits tests.

Si vous voulez plus d'articles et de parcours système, parcourez /blog.