10 nov. 2025·8 min

Changements de schéma et migrations dans les systèmes créés par l’IA : guide

Apprenez comment les systèmes créés par l’IA gèrent en sécurité les changements de schéma : versionnement, déploiements rétro-compatibles, migrations de données, tests, observabilité et stratégies de rollback.

Ce que signifie « schéma » dans les systèmes créés par l’IA

Un schéma est simplement l’accord partagé sur la forme des données et la signification de chaque champ. Dans les systèmes construits avec de l’IA, cet accord apparaît à plus d’endroits qu’un simple schéma de base de données — et il change plus souvent que les équipes ne l’anticipent.

Le schéma n’est pas qu’une affaire de base de données

Vous rencontrerez des schémas dans au moins quatre couches courantes :

- Bases de données : noms de tables/colonnes, types de données, contraintes, index et relations.

- APIs : forme JSON des requêtes/réponses, champs requis vs optionnels, énumérations, formats d’erreur, conventions de pagination.

- Événements et messages : payloads envoyés via streams, queues et webhooks (souvent versionnés implicitement via les consommateurs).

- Configs et contrats : feature flags, variables d’environnement, configs YAML/JSON, et « contrats cachés » comme les formats de fichiers et les conventions de nommage.

Si deux parties du système échangent des données, il y a un schéma — même si personne ne l’a formalisé.

Pourquoi les systèmes créés par l’IA voient plus de changements de schéma

Le code généré par l’IA accélère fortement le développement, mais il augmente aussi le turn-over :

- Le code généré reflète le prompt et le contexte actuels, donc un petit ajustement du prompt peut modifier des noms de champs, la profondeur d’imbrication, les valeurs par défaut ou les validations.

- Les exigences évoluent plus vite quand il est bon marché de livrer un nouvel endpoint ou une nouvelle étape de pipeline.

- Des conventions inconsistantes (snake_case vs camelCase,

idvsuserId) apparaissent lorsque plusieurs générations ou refactors interviennent entre équipes.

Le résultat est une « dérive du contrat » plus fréquente entre producteurs et consommateurs.

Si vous utilisez un workflow de type « vibe-coding » (par exemple, génération d’handlers, couches d’accès BD et intégrations via chat), il vaut la peine d’intégrer la discipline du schéma dès le départ. Des plateformes comme Koder.ai aident les équipes à aller vite en générant React/Go/PostgreSQL et Flutter depuis une interface de chat — mais plus vous livrez vite, plus il devient important de versionner les interfaces, valider les payloads et déployer les changements délibérément.

L’objectif de ce guide

Cet article se concentre sur des moyens pratiques de garder la production stable tout en itérant rapidement : maintenir la compatibilité ascendante, déployer des changements en sécurité et migrer les données sans mauvaises surprises.

Ce que nous n’aborderons pas

Nous n’entrerons pas en profondeur dans la modélisation théorique, les méthodes formelles ou les fonctionnalités spécifiques à un fournisseur. L’accent est mis sur des patterns applicables sur différents stacks — que votre système soit écrit à la main, assisté par l’IA, ou majoritairement généré par l’IA.

Pourquoi les changements de schéma sont plus fréquents avec du code généré par l’IA

Le code généré par l’IA tend à rendre les changements de schéma « normaux » — pas parce que les équipes sont négligentes, mais parce que les entrées du système changent plus souvent. Quand le comportement de votre application est partiellement dicté par des prompts, des versions de modèles et du glue code généré, la forme des données est plus susceptible de dériver avec le temps.

Déclencheurs courants en pratique

Quelques patterns provoquent régulièrement du churn de schéma :

- Nouvelles fonctionnalités produit : ajout d’un nouveau champ (ex.

risk_score,explanation,source_url) ou éclatement d’un concept en plusieurs (ex.addressenstreet,city,postal_code). - Changements de sortie du modèle : un modèle plus récent peut produire des structures plus détaillées, d’autres valeurs d’énumération, ou des noms légèrement différents (“confidence” vs “score”).

- Mises à jour de prompts : des ajustements de prompt pour améliorer la qualité peuvent involontairement changer le formatage, les champs requis ou l’imbrication.

Patterns risqués qui rendent les systèmes IA fragiles

Le code généré par l’IA fonctionne souvent vite, mais il peut encoder des hypothèses fragiles :

- Hypothèses implicites : le code suppose silencieusement qu’un champ est toujours présent, toujours numérique, ou toujours dans une certaine plage.

- Couplage caché : un service dépend des noms internes de champs ou de l’ordre d’un autre service plutôt que d’une interface définie.

- Champs non documentés : le modèle commence à émettre une nouvelle propriété et le code descendant s’y appuie sans qu’on ait explicitement convenu qu’elle fasse partie du contrat.

Pourquoi l’IA amplifie la fréquence des changements

La génération de code encourage l’itération rapide : vous régénérez handlers, parseurs et couches d’accès BD au gré des besoins. Cette vitesse est utile, mais elle facilite aussi la livraison répétée de petites modifications d’interface — parfois sans s’en apercevoir.

L’approche plus sûre est de traiter chaque schéma comme un contrat : tables de base de données, payloads d’API, événements et même réponses structurées d’un LLM. Si un consommateur en dépend, versionnez-le, validez-le et modifiez-le délibérément.

Types de changements de schéma : additif vs cassant

Les changements de schéma ne se valent pas. La question la plus utile est : les consommateurs existants fonctionneront-ils sans modification ? Si oui, c’est généralement additif. Si non, c’est cassant — et cela nécessite un plan de déploiement coordonné.

Changements additifs (généralement sûrs)

Les changements additifs étendent ce qui existe sans en modifier le sens.

Exemples courants en base de données :

- Ajouter une colonne avec une valeur par défaut ou autoriser NULL (ex.

preferred_language). - Ajouter une table ou un index.

- Ajouter un champ optionnel à un blob JSON stocké dans une colonne.

Exemples hors base :

- Ajouter une nouvelle propriété à une réponse d’API (les clients qui ignorent les champs inconnus continuent de fonctionner).

- Ajouter un nouveau champ d’événement dans un stream/queue.

- Ajouter une nouvelle valeur de feature flag tout en conservant le comportement existant comme défaut.

Additif est « sûr » seulement si les anciens consommateurs sont tolérants : ils doivent ignorer les champs inconnus et ne pas exiger les nouveaux.

Changements cassants (risqués)

Les changements cassants altèrent ou suppriment quelque chose dont les consommateurs dépendent déjà.

Changements cassants typiques en base :

- Changer le type d’une colonne (string → integer, précision de timestamp).

- Renommer un champ/une colonne (tout ce qui lit l’ancien nom échoue).

- Supprimer une colonne/table qui est encore interrogée.

Hors base :

- Renommer/supprimer des champs JSON dans les requêtes/réponses.

- Changer la sémantique d’un événement (même nom de champ, sens différent).

- Modifier la structure d’un webhook sans monter de version.

Documenter systématiquement l’impact sur les consommateurs

Avant de merger, documentez :

- Qui consomme (services, dashboards, pipelines de données, partenaires).

- Compatibilité (rétro/avant, et pour combien de temps).

- Mode d’échec (erreurs de parsing, corruption silencieuse des données, logique métier erronée).

Cette courte « note d’impact » force à la clarté — surtout quand du code généré par l’IA introduit des changements de schéma de façon implicite.

Stratégies de versionning pour schémas et interfaces

Le versionning indique aux autres systèmes (et à vous-même plus tard) « ceci a changé, et voici à quel point c’est risqué ». L’objectif n’est pas administratif — c’est d’éviter les ruptures silencieuses lorsque clients, services ou pipelines de données évoluent à des vitesses différentes.

Mentalité sémantique simple (major / minor / patch)

Pensez en termes major / minor / patch, même si vous ne publiez pas littéralement 1.2.3 :

- Major : changement cassant. Les anciens consommateurs peuvent échouer ou mal fonctionner sans changement.

- Minor : ajout sûr. Les anciens consommateurs fonctionnent toujours ; les nouveaux consommateurs peuvent exploiter les capacités supplémentaires.

- Patch : correction de bug ou clarification qui ne change pas le sens.

Une règle simple qui sauve des équipes : ne changez jamais silencieusement le sens d’un champ existant. Si status="active" signifiait « client payant », ne le réutilisez pas pour signifier « compte existant ». Ajoutez un nouveau champ ou une nouvelle version.

Endpoints versionnés vs champs versionnés

Vous avez généralement deux options pratiques :

- Endpoints versionnés (ex.

/api/v1/orderset/api/v2/orders) :

Bien quand les changements sont vraiment cassants ou étendus. C’est explicite, mais cela peut créer de la duplication et une maintenance longue si vous conservez plusieurs versions.

- Champs versionnés / évolution additive (ex. ajouter

new_field, conserverold_field) :

Bien quand vous pouvez effectuer des changements de manière additive. Les clients plus anciens ignorent ce qu’ils ne comprennent pas ; les clients plus récents lisent le nouveau champ. Au fil du temps, dépréciez et supprimez l’ancien champ selon un plan explicite.

Schémas d’événements et registres

Pour les streams, queues et webhooks, les consommateurs sont souvent hors de votre contrôle de déploiement. Un registre de schéma (ou tout catalogue centralisé de schémas avec contrôles de compatibilité) aide à faire respecter des règles comme « seuls les changements additifs sont autorisés » et à savoir quels producteurs et consommateurs dépendent de quelles versions.

Déploiements sûrs : Expand/Contract (le pattern le plus fiable)

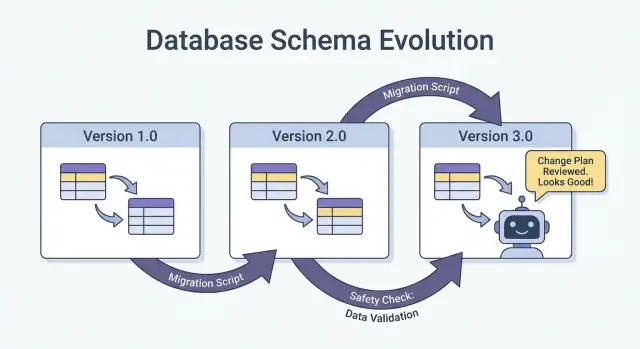

La façon la plus sûre de livrer des changements de schéma — surtout quand plusieurs services, jobs et composants générés par l’IA sont impliqués — est le pattern étendre → rétro-remplir → basculer → contracter (expand → backfill → switch → contract). Il minimise le downtime et évite les déploiements « tout ou rien » où un consommateur en retard casse la production.

Les quatre étapes (et pourquoi elles fonctionnent)

1) Étendre : Introduisez le nouveau schéma de manière rétro-compatible. Les lecteurs et écrivains existants doivent continuer de fonctionner sans changement.

2) Rétro-remplir (backfill) : Remplissez les nouveaux champs pour les données historiques (ou retraiter les messages) afin d’homogénéiser le système.

3) Basculer : Mettez à jour les writers et les readers pour utiliser le nouveau champ/format. Cela peut se faire progressivement (canary, rollout par pourcentage) parce que le schéma supporte les deux versions.

4) Contracter : Supprimez l’ancien champ/format seulement après vous être assuré que rien n’en dépend plus.

Les déploiements en deux phases (étendre → basculer) et trois phases (étendre → rétro-remplir → basculer) réduisent le downtime parce qu’ils évitent le couplage serré : les writers peuvent bouger en premier, les readers plus tard, et inversement.

Exemple : ajouter une colonne, backfill, puis la rendre requise

Supposons que vous vouliez ajouter customer_tier.

- Étendre : Ajouter

customer_tieren nullable avec une valeur par défautNULL. - Rétro-remplir : Lancer un job pour calculer les tiers pour les lignes existantes.

- Basculer : Mettre à jour l’app et les pipelines pour toujours écrire

customer_tier, et mettre à jour les lecteurs pour le préférer. - Contracter : Après surveillance, rendre le champ NOT NULL (et éventuellement supprimer la logique héritée).

Coordination : writers et readers doivent s’accorder

Traitez chaque schéma comme un contrat entre producteurs (writers) et consommateurs (readers). Dans les systèmes créés par l’IA, c’est facile à manquer car de nouveaux chemins de code apparaissent rapidement. Rendre les rollouts explicites : documenter quelle version écrit quoi, quels services peuvent lire les deux versions, et la date exacte à partir de laquelle les anciens champs peuvent être supprimés.

Migrations de base de données : comment changer les données sans casser la production

Planifiez votre prochain changement de schéma

Utilisez le mode de planification pour cartographier expand-backfill-switch-contract avant de générer le code.

Les migrations de base de données sont le « manuel d’instructions » pour faire passer les données et la structure de production d’un état sûr à un autre. Dans les systèmes IA, elles sont encore plus importantes car du code généré peut supposer qu’une colonne existe, renommer des champs de façon inconsistante ou changer des contraintes sans tenir compte des lignes existantes.

Fichiers de migration vs auto-migrations

Fichiers de migration (committés dans le contrôle de version) sont des étapes explicites comme « ajouter la colonne X », « créer l’index Y », ou « copier les données de A vers B ». Ils sont auditables, relisables et peuvent être rejoués en staging et production.

Auto-migrations (générées par un ORM/framework) sont pratiques en phase initiale et prototypage, mais elles peuvent produire des opérations risquées (suppression de colonnes, reconstruction de tables) ou réordonner des changements de manière inattendue.

Règle pratique : utilisez les auto-migrations pour ébaucher, puis convertissez-les en fichiers de migration revus pour toute modification touchant la production.

Idempotence et ordre

Rendez les migrations idempotentes quand c’est possible : les relancer ne devrait pas corrompre les données ou échouer en cours de route. Préférez « create if not exists », ajoutez d’abord des colonnes nullable, et protégez les transformations de données par des vérifications.

Conservez aussi un ordre clair. Chaque environnement (local, CI, staging, prod) doit appliquer la même séquence de migrations. N’« arrachez » pas la production avec du SQL manuel sans le capturer ensuite dans une migration.

Migrations longues sans verrouiller la table

Certaines modifications peuvent bloquer les écritures (ou même les lectures) si elles verrouillent une table volumineuse. Moyens de réduire le risque :

- Utiliser des opérations en ligne / minimisant les locks supportées par votre base (ex. construction d’index en concurrent).

- Scinder les changements en étapes : ajouter d’abord les nouvelles structures, rétro-remplir par lots, puis basculer l’app.

- Planifier les opérations lourdes pendant les fenêtres de faible trafic, avec timeouts et surveillance.

Configurations multi-tenant et sharding

Pour des bases multi-tenant, exécutez les migrations en boucle contrôlée par tenant, avec suivi de progression et retries sûrs. Pour des shards, traitez chaque shard comme un système de production séparé : déployez les migrations shard par shard, vérifiez la santé, puis continuez. Cela limite le blast radius et rend le rollback faisable.

Backfills et retraitement : mettre à jour les données existantes

Un backfill consiste à remplir les nouveaux champs (ou corriger des valeurs) pour les enregistrements existants. Le retraitement consiste à réinjecter des données historiques dans un pipeline — typiquement parce que les règles métier ont changé, un bug a été corrigé, ou le format de sortie d’un modèle a évolué.

Les deux sont courants après des changements de schéma : il est facile de commencer à écrire la nouvelle forme pour les « nouvelles données », mais les systèmes de production dépendent aussi souvent des données d’hier.

Approches courantes

Backfill en ligne (en production, graduellement). Vous lancez un job contrôlé qui met à jour les enregistrements par petits lots pendant que le système reste live. C’est plus sûr pour les services critiques car vous pouvez throttle, pause et reprendre.

Backfill par lot (offline ou jobs planifiés). Vous traitez de gros segments pendant des fenêtres de faible trafic. C’est opérationnellement plus simple, mais peut créer des pics de charge et il est plus coûteux de se remettre d’erreurs.

Backfill paresseux à la lecture. Lorsqu’un enregistrement ancien est lu, l’application calcule/peuple les champs manquants et les écrit. Cela étale le coût dans le temps et évite un gros job, mais ralentit la première lecture et peut laisser des données non converties longtemps.

En pratique, les équipes combinent souvent ces approches : backfill paresseux pour la longue traîne et job en ligne pour les données les plus accédées.

Comment valider un backfill

La validation doit être explicite et mesurable :

- Comptages : combien de lignes/événements devraient être mis à jour vs combien l’ont été.

- Checksums/agrégats : comparer des totaux (ex. somme des montants, IDs distincts) avant/après.

- Échantillonnage : vérification ponctuelle d’un échantillon statistiquement significatif, incluant les cas limites.

Validez aussi les effets en aval : tableaux de bord, index de recherche, caches et exports qui dépendent des champs mis à jour.

Coût, temps et critères d’acceptation

Les backfills échangent vitesse (terminer rapidement) contre risque et coût (charge, compute, overhead opérationnel). Définissez des critères d’acceptation en amont : ce que signifie « terminé », durée attendue, taux d’erreur maximal autorisé, et procédure en cas d’échec (pause, retry ou rollback).

Évolution des schémas d’événements et messages (streams, queues, webhooks)

Conservez la pleine propriété du code

Exportez le code source pour examiner les migrations, validations et modifications de contrat dans votre dépôt.

Les schémas n’habitent pas que les bases. Chaque fois qu’un système envoie des données à un autre — topics Kafka, SQS/RabbitMQ, payloads de webhook, ou même « événements » écrits en stockage objet — vous créez un contrat. Les producteurs et consommateurs évoluent indépendamment, donc ces contrats se cassent plus souvent que les tables internes d’une seule app.

Par défaut, évoluez les événements rétro-compatiblement

Pour les streams d’événements et les webhooks, privilégiez des changements que les anciens consommateurs peuvent ignorer et que les nouveaux peuvent adopter.

Règle pratique : ajoutez des champs, ne supprimez pas et ne renommez pas. Si vous devez déprécier, continuez à l’envoyer un temps et documentez-le comme déprécié.

Exemple : étendre un événement OrderCreated en ajoutant des champs optionnels.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

Les consommateurs anciens lisent order_id et created_at et ignorent le reste.

Contrats pilotés par les consommateurs (version en langage simple)

Plutôt que le producteur qui devine ce qui pourrait casser les autres, les consommateurs publient ce dont ils dépendent (champs, types, règles required/optional). Le producteur valide ensuite les changements par rapport à ces attentes avant de livrer. C’est particulièrement utile dans les codebases générées par l’IA, où un modèle peut « aider » en renommant un champ ou en changeant un type.

Gérer les « champs inconnus » en sécurité

Rendez les parseurs tolérants :

- Ignorez les champs inconnus par défaut (ne pas échouer parce qu’une nouvelle clé apparaît).

- Traitez les nouveaux champs comme optionnels tant que vous n’en avez pas réellement besoin.

- Logguez les champs inattendus discrètement pour repérer l’adoption sans déclencher d’alerte.

Quand un changement cassant est nécessaire, utilisez un nouveau type d’événement ou un nom versionné (par ex. OrderCreated.v2) et faites tourner les deux en parallèle jusqu’à migration complète.

Les sorties IA comme schéma : prompts, modèles et réponses structurées

Quand vous ajoutez un LLM à un système, ses sorties deviennent vite un schéma de facto — même si personne n’a écrit une spec formelle. Le code descendant finit par supposer « il y aura un champ summary », « la première ligne est le titre », ou « les puces sont séparées par des tirets ». Ces hypothèses se figent, et un petit changement de comportement du modèle peut les casser comme un renommage de colonne.

Préférez la structure explicite (et validez-la)

Plutôt que de parser du « texte joli », demandez des sorties structurées (typiquement JSON) et validez-les avant qu’elles n’entrent dans le reste du système. Considérez cela comme le passage du « best effort » à un contrat.

Approche pratique :

- Définissez un schéma JSON (ou une interface typée) pour la réponse du modèle.

- Rejetez ou mettez en quarantaine les réponses invalides (ne les convertissez pas silencieusement).

- Logguez les erreurs de validation pour voir ce qui évolue.

C’est particulièrement important quand les réponses LLM alimentent des pipelines de données, de l’automatisation ou du contenu destiné aux utilisateurs.

Prévoyez la dérive des modèles

Même avec le même prompt, les sorties peuvent évoluer : des champs peuvent être omis, des clés supplémentaires apparaître, et les types changer ("42" vs 42, tableaux vs chaînes). Traitez ces événements comme de l’évolution de schéma.

Atténuations efficaces :

- Rendre les champs optionnels lorsque raisonnable et définir explicitement des valeurs par défaut.

- Autoriser les clés inconnues mais les ignorer en sécurité (sauf si vous êtes strict pour des raisons de conformité).

- Ajouter des contrôles « garde-fous » (ex. champs requis, longueurs max, valeurs d’énumération).

Traitez les changements de prompt comme des changements d’API

Un prompt est une interface. Si vous l’éditez, versionnez-le. Conservez prompt_v1, prompt_v2, et déployez progressivement (feature flags, canaries ou toggles par tenant). Testez sur un jeu d’évaluation fixe avant promotion, et gardez les anciennes versions en service jusqu’à ce que les consommateurs en aval se soient adaptés. Pour plus de détails sur les mécaniques de déploiement sécurisé, reliez votre approche à /blog/safe-rollouts-expand-contract.

Tests et validation pour les changements de schéma

Les changements de schéma échouent habituellement de façons ennuyeuses et coûteuses : une nouvelle colonne manque dans un environnement, un consommateur attend encore un ancien champ, ou une migration fonctionne sur données vides mais timeoute en production. Les tests transforment ces « surprises » en travaux prévisibles et réparables.

Trois niveaux de tests (et ce qu’ils détectent)

Tests unitaires protègent la logique locale : fonctions de mapping, sérialiseurs/désérialiseurs, validateurs et builders de requêtes. Si un champ est renommé ou un type change, les tests unitaires doivent échouer près du code à mettre à jour.

Tests d’intégration garantissent que votre app fonctionne avec de vraies dépendances : le moteur de DB réel, l’outil de migration réel et les formats de message réels. C’est là que vous détectez des problèmes du type « le modèle ORM a changé mais la migration ne l’a pas fait ».

Tests end-to-end simulent des parcours utilisateur ou des workflows inter-services : créez des données, migrez-les, relisez-les via des APIs et vérifiez que les consommateurs en aval se comportent correctement.

Tests de contrat pour producteurs et consommateurs

L’évolution du schéma casse souvent aux frontières : API service-à-service, streams, queues et webhooks. Ajoutez des tests de contrat qui s’exécutent des deux côtés :

- Les producteurs prouvent qu’ils peuvent émettre des événements/réponses conformes au contrat convenu.

- Les consommateurs prouvent qu’ils peuvent parser à la fois les anciennes et nouvelles versions durant un rollout.

Tester les migrations : appliquer et rollback sur environnements frais

Testez les migrations comme vous les déployez :

- Partir d’un snapshot de base propre.

- Appliquer toutes les migrations dans l’ordre.

- Vérifier que l’app peut lire/écrire.

- Exécuter un rollback (si supporté) ou une migration “down” et confirmer le retour à un état fonctionnel.

Fixtures pour anciennes et nouvelles versions de schéma

Conservez un petit jeu de fixtures représentant :

- Des données écrites sous l’ancien schéma (lignes/événements legacy).

- Des données écrites sous le nouveau schéma.

Ces fixtures rendent les régressions évidentes, surtout quand du code généré par l’IA change subtilement noms de champs, optionalité ou formatage.

Observabilité : détecter les ruptures tôt

Maintenez la stabilité des clients mobiles

Créez une application mobile Flutter qui reste compatible à mesure que le schéma backend évolue.

Les changements de schéma échouent rarement bruyamment au moment du déploiement. Le plus souvent, la rupture se manifeste par une montée lente d’erreurs de parsing, des warnings « champ inconnu », des données manquantes ou des jobs de fond qui prennent du retard. Une bonne observabilité transforme ces signaux faibles en retours actionnables tant que vous pouvez encore arrêter le rollout.

Que surveiller pendant un déploiement

Commencez par les bases (santé de l’app), puis ajoutez des signaux spécifiques au schéma :

- Erreurs : pics de 4xx/5xx, mais aussi erreurs « molles » comme échecs de parsing JSON, désérialisation, et retries.

- Latence : p95/p99 et temps de traitement de queue. Les changements de schéma peuvent ajouter des jointures, des payloads plus gros ou des validations.

- Signaux de qualité des données : augmentation du taux de NULL dans des colonnes importantes, chute soudaine du volume d’événements, nouvelles valeurs « par défaut » trop fréquentes, ou discordances entre anciennes et nouvelles représentations.

- Retard dans les pipelines : lag des consommateurs de streams/queues, backlog de delivery des webhooks, débit des jobs de migration.

L’important est de comparer avant vs après et de trancher par version client, version de schéma et segment de trafic (canary vs stable).

Dashboards utiles

Créez deux vues :

-

Tableau de bord comportement applicatif

- Taux de requêtes, taux d’erreurs, latence (RED)

- Exceptions principales (groupées par message)

- Comptes d’erreurs de validation/désérialisation et pourcentage

- Distribution de la taille des payloads (pour détecter des messages anormalement volumineux)

-

Tableau de bord migrations et jobs de fond

- Progression du job de migration (% terminé), lignes traitées/sec, ETA

- Taux d’échec et nombre de retries

- Profondeur des queues / lag des consommateurs

- Volume de dead-letter queue (si applicable)

Si vous exécutez un rollout expand/contract, incluez un panneau qui montre lectures/écritures scindées par ancien vs nouveau schéma pour voir quand il est safe de passer à la phase suivante.

Alertes pour échecs spécifiques au schéma

Pagez sur les problèmes indiquant que des données sont perdues ou mal lues :

- Taux d’erreurs de validation de schéma au-dessus d’un seuil bas (souvent <0,1 % est déjà significatif)

- Échecs de parsing/désérialisation (surtout si concentrés sur un producteur/consommateur)

- Warnings champ inattendu / champ requis manquant en hausse

- Job de migration bloqué (aucun progrès depuis N minutes) ou lag croissant plus vite que le débit

Évitez les alertes bruyantes sur de simples 500 sans contexte ; corrélez-les au rollout de schéma via des tags comme version de schéma et endpoint.

Logger la version pour déboguer rapidement

Pendant la transition, incluez et logguez :

- Version du schéma (ex. header

X-Schema-Version, champ metadata du message) - Version de l’app producteur et consommateur

- Version du modèle / version du prompt quand des sorties IA structurées alimentent des données

Ce petit détail rend la question « pourquoi ce payload a échoué ? » répondable en quelques minutes au lieu de jours — surtout quand différentes versions de services (ou de modèles IA) sont live simultanément.

Rollback, récupération et gestion du changement

Les changements de schéma échouent de deux manières : le changement lui-même est incorrect, ou l’écosystème autour se comporte différemment que prévu (surtout lorsqu’un code généré par l’IA introduit des hypothèses subtiles). Dans tous les cas, chaque migration a besoin d’une histoire de rollback avant d’être livrée — même si cette histoire est explicitement « pas de rollback ».

Choisir « pas de rollback » peut être valide quand le changement est irréversible (par ex. suppression de colonnes, réécriture d’identifiants, déduplication destructive). Mais « pas de rollback » n’est pas l’absence de plan ; c’est une décision qui oriente le plan vers corrections en avant, restauration et confinement.

Options de rollback pratiques qui fonctionnent réellement

Feature flags / verrous de config : Encapsulez les nouveaux readers, writers et champs d’API derrière un flag pour pouvoir couper le nouveau comportement sans redéployer. Utile quand du code généré par l’IA est syntaxiquement correct mais sémantiquement erroné.

Désactiver le dual-write : Si vous écrivez à la fois dans l’ancien et le nouveau schéma durant un rollout expand/contract, prévoyez un kill switch. Couper la nouvelle voie d’écriture arrête la divergence pendant l’investigation.

Revenir les readers (pas seulement les writers) : Beaucoup d’incidents surviennent parce que les consommateurs commencent à lire des champs/tables nouveaux trop tôt. Facilitez le fait de pointer les services vers la version précédente du schéma, ou de leur faire ignorer les nouveaux champs.

Connaître les limites de la réversibilité

Certaines migrations ne peuvent pas être propres à annuler :

- Transformations destructives (ex. hashing, normalisation perteuse).

- Suppressions/renommages sans copie préservée.

- Backfills qui écrasent une « source de vérité ».

Pour celles-ci, prévoyez restore from backup, replay depuis des événements, ou recalculer depuis des entrées brutes — et vérifiez que vous avez bien ces entrées.

Checklist pré-vol (avant la mise en production)

- Décision de rollback documentée (« revert », « forward fix », ou « pas de rollback + chemin de restauration »).

- Bouton d’arrêt clair : flags et/ou kill switch dual-write.

- Backups/snapshots vérifiés ; restauration testée au moins une fois.

- Migration idempotente ; les relances ne corrompent pas les données.

- Monitoring et alertes pour taux d’erreur, échecs de validation de schéma et lag.

- Responsabilités : qui approuve, qui exécute, qui est on-call pendant le rollout.

Une bonne gestion du changement rend les rollbacks rares — et la reprise en cas d’incident routinière.

Si votre équipe itère rapidement avec du développement assisté par l’IA, il est utile d’associer ces pratiques à des outils qui facilitent l’expérimentation sûre. Par exemple, Koder.ai inclut un planning mode pour concevoir les changements en amont et des snapshots/rollback pour une récupération rapide lorsqu’un changement généré déplace accidentellement un contrat. Utilisés ensemble, génération rapide de code et évolution disciplinée des schémas vous permettent d’aller plus vite sans traiter la production comme un environnement de test.