31 mai 2025·8 min

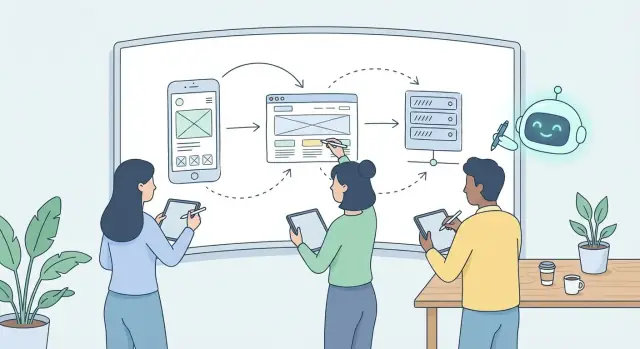

Pourquoi les frontières entre web, mobile et backend se floutent avec le développement assisté par IA

Les assistants IA génèrent UI, API et logique de données ensemble, faisant se chevaucher web, mobile et backend. Découvrez ce qui change et comment les équipes s’adaptent.

Ce que signifiaient autrefois "web", "mobile" et "backend"

Pendant des années, « web », « mobile » et « backend » n'étaient pas juste des étiquettes — ce sont des frontières qui ont structuré la manière de construire des logiciels.

La répartition traditionnelle

Web désignait généralement tout ce qui s'exécute dans un navigateur : pages, composants, gestion d'état et logique UI qui rend les écrans interactifs. Les équipes web optimisaient l'itération rapide, les layouts responsives et la compatibilité entre navigateurs.

Mobile signifiait des apps natives iOS et Android (puis des frameworks cross-platform). Les développeurs mobile se souciaient des sorties sur les stores, des performances sur appareil, du comportement hors-ligne, des notifications push et des patterns UI spécifiques aux plateformes.

Backend désignait les services en coulisse : bases de données, règles métier, authentification, intégrations, queues et APIs qui alimentent web et mobile. Le backend se concentrait souvent sur la fiabilité, la consistance des données, la scalabilité et la logique partagée.

Pourquoi les équipes s'organisaient ainsi

Cette séparation réduisait le coût de coordination parce que chaque couche avait ses outils, cycles de release et connaissances spécialisées. Les équipes reflétaient souvent cette réalité :

- Repos séparés (app web, iOS, Android, backend)

- Pipelines de déploiement différents (stores vs déploiements serveurs)

- Compétences distinctes (implémentation UI/UX vs systèmes distribués)

Cela clarifiait aussi la propriété : si l'écran de login cassait, c'était « web » ou « mobile » ; si l'API de login échouait, c'était « backend ».

Ce que signifie « frontières qui se floutent » au quotidien

Flouter ne veut pas dire que ces couches disparaissent. Cela signifie que le travail est moins proprement découpé.

Un seul changement produit — par exemple “améliorer l'onboarding” — couvre de plus en plus l'UI, la forme de l'API, le suivi de données et les expérimentations comme un seul paquet. Les frontières existent toujours, mais elles sont moins rigides : plus de code partagé, d'outils communs et davantage de personnes éditant des couches différentes.

Comment l'IA change l'unité de travail : des couches aux fonctionnalités

Pendant des années, les équipes organisaient le travail par couches : « le web construit la page », « le mobile construit l'écran », « le backend ajoute l'endpoint », « les données ajoutent la table ». Cette division avait du sens quand chaque couche demandait des outils différents, un contexte profond et beaucoup de colle manuelle.

Le développement assisté par IA pousse l'unité de travail vers le haut — des couches vers les fonctionnalités.

De « écrire un écran » à « construire la fonctionnalité complète »

Quand vous demandez à un outil IA « ajouter un écran de checkout », il s'arrête rarement à un seul fichier UI. Un bon prompt contient naturellement l'intention : ce que l'utilisateur veut faire, quelles données sont nécessaires, ce qui arrive en cas de succès ou d'échec, et comment c'est stocké.

Cela pousse vers des prompts comme :

- « Construis la fonctionnalité ‘Enregistrer pour plus tard’ de bout en bout, incluant UI, API et persistance. »

Des sorties mixtes par défaut

Les sorties IA arrivent souvent en bundle : un composant UI, une route API, une règle de validation et un changement de base de données — parfois même un script de migration et un test basique. Ce n'est pas de la « sur-intelligence » ; c'est la manière dont une fonctionnalité fonctionne réellement.

C'est pourquoi l'IA est naturellement orientée fonctionnalité, pas couches : elle génère en suivant une histoire utilisateur du clic → requête → logique → stockage → réponse → rendu.

Ce que cela change pour le périmètre et les transferts

La planification passe de « tickets par couche » à « une tranche de fonctionnalité avec critères d'acceptation ». Au lieu de trois transferts séparés (web → backend → données), les équipes visent un unique propriétaire qui conduit la fonctionnalité à travers les frontières, avec des spécialistes relisant les parties risquées.

Le résultat pratique : moins de délais de coordination — mais des attentes plus élevées en matière de clarté. Si la fonctionnalité n'est pas bien définie (cas limites, permissions, états d'erreur), l'IA générera volontiers du code qui a l'air complet mais ne répond pas aux vrais besoins.

Évolution du stack vers du code et des outils partagés

Le développement assisté par IA accélère la tendance à s'éloigner des « stacks séparés » (un pour le web, un pour le mobile, un pour le backend) vers des blocs de construction partagés. Quand le code peut être rédigé rapidement, le goulot devient la cohérence : tous les canaux utilisent-ils les mêmes règles, les mêmes shapes de données et les mêmes patterns UI ?

Une toolchain JavaScript/TypeScript unique front et back

Les équipes standardisent de plus en plus sur TypeScript, pas par effet de mode, mais parce que cela rend le partage plus sûr. Les mêmes types peuvent décrire une réponse API, piloter la validation côté serveur et alimenter les formulaires front.

Les outils convergent aussi : formatters, linters et tests tendent à s'unifier pour éviter qu'un changement casse une partie du produit tout en « passant » ailleurs.

Monorepos et paquets partagés comme comportement par défaut

Les monorepos rendent le code partagé pratique. Plutôt que de copier la logique entre apps, les équipes extraient des paquets réutilisables :

- Types et schémas (ce qu'est un « User » ou une « Order »)

- Validateurs (garantir que les entrées respectent les règles partout)

- Composants UI (boutons, contrôles de formulaire, primitives de layout)

Cela réduit la dérive — surtout quand l'IA génère du code à plusieurs endroits. Un paquet partagé maintient l'alignement.

Frameworks UI cross-platform et design systems

Les frameworks cross-platform et les design systems appliquent la même idée côté UI : définir les composants une fois, puis réutiliser sur web et mobile. Même si des apps séparées subsistent, des tokens partagés (couleurs, espacements, typographie) et des APIs de composants facilitent l'implémentation cohérente des fonctionnalités.

Clients API générés depuis une source de vérité

Autre changement majeur : générer automatiquement des clients API (souvent depuis OpenAPI ou des specs similaires). Au lieu d'écrire manuellement des appels réseau sur chaque plateforme, les équipes génèrent des clients typés pour synchroniser contrats web/mobile/backend.

Quand les frontières se floutent, le « stack » devient moins une question de technologies qu'une question de primitives partagées — types, schémas, composants et clients générés — qui permettent d'expédier une fonctionnalité de bout en bout avec moins de transferts et de surprises.

L'IA transforme tout le monde en développeur partiellement full-stack

Le développement assisté par IA pousse les gens hors de leur « couloir » parce qu'elle compense rapidement le contexte manquant.

Un dev front peut demander « ajoute le caching avec ETags et rate limiting » et obtenir un changement côté serveur exploitable, tandis qu'un dev backend peut suggérer « fais paraître cet écran plus rapide » et obtenir des propositions touchant le skeleton loading, l'UI optimiste et la stratégie de retry.

Les développeurs front touchent maintenant au caching, auth et rate limits

Quand l'IA peut rédiger un middleware ou une règle d'API gateway en quelques secondes, la friction de « je n'écris pas de code backend » diminue. Cela change la nature du travail front :

- Caching : ajouter

Cache-Control, ETags, ou invalidation côté client devient une tâche de perf UI, pas un ticket backend séparé. - Auth : implémenter le rafraîchissement de token, les réglages de cookie sécurisé et « que faire sur 401 » nécessite souvent des modifications côté client et serveur.

- Rate limits : si un infinite scroll surcharge l'API, la solution peut inclure throttling UI + limites serveur et réponses d'erreur conviviales.

Les développeurs backend influent davantage sur l'UX et les états de chargement

Les décisions backend façonnent l'expérience utilisateur : temps de réponse, échecs partiels, et ce qui peut être streamé tôt. L'IA facilite la proposition et l'implémentation de changements backend sensibles à l'UX, tels que :

- retourner des résultats partiels avec un champ

warnings - supporter la pagination par curseur pour un défilement fluide

- envoyer des réponses « résumé » légères pour le rendu initial, puis récupérer les détails

Une fonctionnalité, plusieurs couches : pagination, validation, gestion d'erreur

La pagination illustre le flou des frontières. L'API a besoin de curseurs stables et d'un ordre prévisible ; l'UI doit gérer le « plus de résultats », les retries et une navigation arrière/avant réactive.

La validation est similaire : les règles serveur doivent être autoritatives, mais l'UI devrait les refléter pour un retour instantané. L'IA génère souvent les deux côtés ensemble — schémas partagés, codes d'erreur cohérents et messages mappés aux champs de formulaire.

La gestion d'erreur devient aussi cross-layer : un 429 (rate limited) ne doit pas être juste un code de statut ; il doit piloter un état UI (« Réessayez dans 30 s ») et peut-être une stratégie de backoff.

Impact sur l'estimation et la propriété

Quand une tâche « front » inclut en douce des ajustements API, des en-têtes de cache et des cas d'edge auth, les estimations basées sur les anciennes frontières cassent.

Les équipes réussissent mieux quand la propriété est définie par les résultats fonctionnels (par ex. « la recherche est instantanée et fiable ») et que les checklists couvrent les considérations cross-layer, même si différentes personnes implémentent différentes parties.

Backend-for-Frontend et l'essor des APIs façonnées par l'UI

Accélérez les revues sur toute la pile

Faites intervenir les relecteurs tôt pour que les modifications multi-couches restent correctes, sécurisées et cohérentes.

Le Backend-for-Frontend (BFF) est une couche serveur fine conçue pour une expérience client unique — souvent une pour le web et une pour le mobile. Plutôt que chaque app appelle la même API « générique » puis reforme les données côté client, le BFF expose des endpoints qui correspondent directement aux besoins UI.

Pourquoi les BFF plaisent pour web + mobile

Web et mobile partagent fréquemment des concepts mais diffèrent sur les détails : règles de pagination, cache, comportement offline, et même la perception de la « rapidité ». Un BFF permet à chaque client de demander exactement ce dont il a besoin sans imposer des compromis à une API universelle.

Pour les équipes produit, cela simplifie les releases : des changements UI peuvent partir avec une petite mise à jour BFF, sans renégocier un contrat plateforme plus large à chaque fois.

Endpoints générés par l'IA, taillés pour un flux UI

Avec l'IA, les équipes génèrent de plus en plus d'endpoints directement à partir des besoins UI : « le résumé du checkout a besoin des totaux, des options de livraison et des méthodes de paiement en un seul appel. » Cela favorise les APIs façonnées par l'UI — des endpoints conçus autour d'un écran ou d'un parcours utilisateur plutôt que d'une entité métier.

C'est bénéfique quand ça réduit les allers-retours et garde le code client compact. Le risque : l'API devient le reflet du UI actuel, rendant les refontes futures coûteuses si le BFF grossit sans structure.

Arbitrage : vitesse vs duplication de logique

Les BFF accélèrent le développement, mais peuvent dupliquer la logique :

- Validation et formatage répétés entre BFF web et mobile

- Code d'agrégation similaire maintenu en plusieurs endroits

- Multiples « sources de vérité » si des règles métier fuient depuis les services centraux

Bonne pratique : le BFF orchestre et met en forme les données, il ne doit pas redéfinir le comportement métier central.

Quand ajouter (ou éviter) une couche BFF

Ajoutez un BFF si vous avez de la composition écran-spécifique complexe, de nombreux appels réseau par vue, ou des besoins clients divergents. Évitez-le (ou limitez-le) si le produit est petit, l'UI instable, ou si des APIs bien conçues et une composition légère côté client suffisent.

Si vous introduisez des BFFs, fixez tôt les frontières : les règles métier partagées résident dans les services cœur ; le BFF se concentre sur l'agrégation conviviale pour l'UI, le cache et la mise en forme aware des autorisations.

La revue de code devient la compétence principale sur toute la stack

Quand un assistant IA peut générer un composant React, un écran mobile et une requête DB en quelques minutes, « écrire du code » devient « relire du code ». Le débit augmente, mais le risque d'erreurs subtiles augmente aussi — surtout quand un changement traverse UI, API et données.

La revue porte désormais sur le comportement système, pas la syntaxe

L'IA produit généralement du code lisible. Les questions de revue à valeur ajoutée sont :

- Ce changement correspond-il à l'intention produit et aux cas limites ?

- Se comportera-t-il correctement avec des données réelles, de la latence et des utilisateurs réels ?

- Avons-nous créé une faille de sécurité ou de confidentialité ?

Un réviseur capable de relier les couches devient plus précieux qu'un simple expert en style.

Points à vérifier inter-couches

Concentrez-vous sur quelques échecs récurrents :

- Accès aux données : requêtes N+1, index manquants, over-fetching, payloads trop volumineux.

- Sécurité : vérifications d'auth aux bons endroits, checks de permission pour chaque opération, gestion sûre des tokens, validation des entrées et hypothèses sur les limites de débit.

- Cas limites UX : états de chargement/vides, comportement offline/réseau pauvre sur mobile, messages d'erreur aidant à la récupération, accessibilité de base.

- Contrats API : compatibilité ascendante, nommage cohérent et réponses adaptées à l'UI sans exposer les tables internes.

Checklists et tests pour suivre le rythme

Une production plus rapide exige des garde-fous plus serrés. Des checklists légères en PR aident les réviseurs à rester cohérents, tandis que des tests automatisés attrapent ce que l'humain manque.

Bonnes pratiques « vitesse-IA » :

- Tests de contrat pour APIs et changements de schéma

- Un petit ensemble de flux end-to-end critiques

- Linting/formatage et scan de sécurité en CI

Pairing : connaissance domaine humaine + rapidité IA

Un pattern pratique est d'apparier un expert domaine (produit, conformité, plateforme) avec un builder qui conduit l'IA. Le builder génère et itère vite ; l'expert pose les questions gênantes : « Que se passe-t-il si l'utilisateur est suspendu ? », « Quelles données sont sensibles ? », « Est-ce permis dans ce marché ? »

Cette combinaison transforme la revue de code en une pratique qualité cross-stack, plutôt qu'en un goulot.

Sécurité et gestion des données quand les frontières se floutent

Quand l'IA aide à livrer une « fonctionnalité » qui touche UI, API et stockage en une passe, la sécurité cesse d'être le problème de quelqu'un d'autre. Le risque n'est pas d'oublier la sécurité, mais que des petites erreurs passent parce qu'aucune couche unique ne « possède » la frontière.

Risques transverses courants à surveiller

Quelques problèmes reviennent quand des changements générés par l'IA couvrent plusieurs couches :

- Fuite de secrets : clés API copiées dans du code client,

.envd'exemple commités, tokens loggés. - Auth/authZ faibles : endpoints créés sans vérification d'identité, ou une protection UI prise pour un vrai contrôle d'accès.

- Bugs d'injection : injection SQL/NoSQL, interpolation de chaîne non sûre, SSRF quand des entrées sont relayées entre services.

Principes de gestion des données souvent oubliés

Les frontières floues brouillent aussi ce qui compte comme « donnée ». Traitez ces décisions comme de première importance :

- Données personnelles (PII) : définissez ce qui est concerné (email, téléphone, localisation précise, IDs d'appareil) et où elles peuvent apparaître.

- Logging : évitez de logger les payloads par défaut ; redigez identifiants et tokens ; définissez des niveaux de logs.

- Événements analytics : n'envoyez pas de contenu utilisateur brut comme propriétés d'événements ; gardez des schémas explicites.

- Rétention : décidez combien de temps les données sont conservées, backups inclus, et qui y a accès.

Paramètres sûrs par défaut qui évoluent bien avec le travail assisté par IA

Rendez le « chemin par défaut » sécurisé pour que le code généré par l'IA soit moins susceptible d'erreurs :

- Moindre privilège : tokens scoped, rôles IAM minimaux, read-only quand possible.

- Validation d'entrée : validez au périmètre API ; rejetez les champs inconnus ; imposez des limites de taille.

- Hygiène des dépendances : lockfiles, audits automatisés et politique d'ajout de paquets.

Un prompt prêt pour la sécurité + checklist de revue

Utilisez un prompt standard quand vous demandez à l'IA de générer des changements cross-layer :

Before generating code: list required authZ checks, input validation rules, sensitive data fields, logging/redaction rules, and any new dependencies. Do not place secrets in client code. Ensure APIs enforce permissions server-side.

Puis révisez avec une checklist courte : authZ enforced on the server, secrets not exposed, inputs validated and encoded, logs/events redacted, and new dependencies justified.

(Note : le bloc ci‑dessus est un bloc de code et ne doit pas être traduit.)

Gestion de projet : estimation, propriété et releases

Modifiez sans crainte

Utilisez des snapshots et des rollback pour itérer rapidement tout en restant sûr sur toutes les couches.

Le développement assisté par IA change la manière dont le travail apparaît sur le tableau. Une seule fonctionnalité peut toucher un écran mobile, un flux web, un endpoint API, des events analytics et une règle de permission — souvent dans la même PR.

Cela complique le suivi du temps, car les tâches « frontend » et « backend » ne sont plus séparables.

Estimer quand les fonctionnalités traversent les couches

Les estimations basées sur « combien d'endpoints » ou « combien d'écrans » ratent souvent l'effort réel : intégration, cas limites et validation. Une approche plus fiable estime par impact utilisateur et risque.

Pattern pratique :

- Découpez le travail en tranches livrant une étape complète du parcours utilisateur (pas un composant partiel).

- Ajoutez du temps explicite pour l'intégration et le déploiement (feature flags, migrations, review stores).

- Traitez les « inconnues » comme des tâches à part : prototypez la partie la plus difficile tôt, puis ré-estimez.

Propriété définie par les résultats

Au lieu d'assigner la propriété par composants (web possède le web, backend possède le backend), définissez-la par résultats : un parcours utilisateur ou un objectif produit. Une équipe (ou une personne responsable directe) possède l'expérience bout en bout, y compris les métriques de succès, la gestion d'erreur et la préparation du support.

Cela n'efface pas les rôles de spécialistes — cela clarifie la responsabilité. Les spécialistes relisent et guident, mais le propriétaire de la fonctionnalité s'assure que toutes les pièces sont livrées.

Meilleures issues : ce que « terminé » signifie réellement

À mesure que les frontières se floutent, les tickets ont besoin de définitions plus nettes. Un bon ticket contient :

- Critères d'acceptation écrits comme comportements visibles par l'utilisateur

- États d'erreur (sur réseaux lents, entrées invalides, échecs partiels)

- Objectifs de performance (temps de chargement, latence API, impact batterie)

- Attentes de logging/analytics (événements, tableaux de bord, alertes)

Releases et versioning web, mobile, backend

Les travaux cross-layer échouent souvent au moment des releases. Communiquez le versioning et les étapes de release explicitement : quelles modifications backend doivent déployer en premier, l'API est-elle rétrocompatible, quelle est la version mobile minimale.

Une checklist simple aide : plan de feature flag, ordre de rollout, signaux de monitoring et étapes de rollback — partagés entre web, mobile et backend pour éviter les surprises en production.

Tests et observabilité pour les changements cross-layer

Quand l'IA vous aide à assembler UI, écrans mobiles et endpoints backend, il est facile d'expédier quelque chose qui a l'air fini mais qui casse dans les raccords.

Les équipes rapides traitent tests et observabilité comme un seul système : les tests attrapent les régressions prévisibles ; l'observabilité explique les régressions surprenantes.

Où se cachent les bugs quand l'IA génère la « colle »

L'IA est excellente pour produire des adaptateurs — mapper des champs, reshaper du JSON, convertir des dates, brancher des callbacks. C'est exactement là que résident les défauts subtils :

- Un champ est renommé côté client, l'API renvoie encore l'ancien nom.

- Le traitement des nulls/vides diverge entre web et mobile.

- Fuseaux horaires, formatage monétaire et arrondis diffèrent selon les couches.

- Les états d'erreur ne sont pas cohérents (par ex. mobile attend un code, backend envoie un message).

Ces problèmes échappent souvent aux tests unitaires parce que chaque couche passe ses propres tests pendant que l'intégration dérive silencieusement.

Ajouter des tests de contrat entre client et API

Les tests de contrat sont des tests de « poignée de main » : ils vérifient que client et API s'accordent toujours sur les shapes des requêtes/réponses et les comportements essentiels.

Concentrez-les :

- Validez les champs requis, les types et les réponses d'erreur communes.

- Couvrez les règles de versioning (ce qui peut changer sans casser les clients).

- Lancez les contrats en CI pour chaque changement de part et d'autre.

C'est d'autant plus important quand l'IA refactore ou génère de nouveaux endpoints à partir de prompts ambigus.

Tests end-to-end pour les flux critiques

Sélectionnez un petit ensemble de flux critiques pour le revenu ou la confiance (signup, checkout, reset) et testez-les E2E across web/mobile + backend + base de données.

Ne visez pas 100% de couverture E2E — visez une haute confiance là où les échecs coûtent le plus.

Observabilité : logs, metrics, traces liés à une fonctionnalité

Quand les frontières se floutent, déboguer par « quelle équipe en est responsable » ne marche plus. Instrumentez par fonctionnalité :

- Logs avec identifiants cohérents (user/session/request/feature flag)

- Metrics pour taux de succès, latence et taux d'erreur par endpoint et par flux

- Traces montrant une action utilisateur unique client → API → services

Si vous pouvez répondre « qu'est-ce qui a changé, qui est affecté et où ça échoue » en quelques minutes, le développement cross-layer reste rapide sans devenir approximatif.

Patterns d'architecture qui fonctionnent avec des équipes assistées par IA

Livrez des fonctionnalités de bout en bout

Créez une fonctionnalité complète (interface, API et données) à partir d'une seule conversation.

Les outils IA facilitent les changements multi-couches, ce qui est excellent pour la vitesse — et risqué pour la cohérence. Les meilleurs patterns d'architecture ne combattent pas cela ; ils canalisent l'efficacité dans des joints clairs où les humains peuvent encore raisonner sur le système.

API-first vs schema-first vs feature-first

API-first commence par les endpoints et contrats, puis implémente clients et serveurs autour d'eux. Efficace quand vous avez de nombreux consommateurs (web, mobile, partenaires) et besoin d'intégrations prévisibles.

Schema-first commence au niveau des données : définissez le modèle et les opérations dans un schéma partagé (OpenAPI ou GraphQL), puis générez clients, stubs et docs. C'est souvent le meilleur compromis pour les équipes assistées par IA parce que le schéma devient une source de vérité que l'IA peut suivre.

Feature-first organise le travail par résultats utilisateur (par ex. « checkout » ou « édition de profil ») et regroupe les changements cross-layer derrière une seule surface propriétaire. Cela correspond à la façon dont l'IA « pense » : une demande de fonctionnalité couvre naturellement UI, API et données.

Une approche pratique : delivery feature-first avec contracts schema-first en dessous.

Des schémas partagés réduisent la friction

Quand tout le monde cible le même contrat, les débats « que signifie ce champ ? » diminuent. Les schémas OpenAPI/GraphQL facilitent aussi :

- la génération de clients typés pour web et mobile

- la validation automatique des requêtes/réponses

- la tenue à jour de la doc sans réécriture manuelle

Le schéma doit être traité comme une surface produit versionnée, pas comme un artéfact secondaire.

Si vous voulez un primer, gardez-le léger et interne : /blog/api-design-basics.

Garder des frontières claires avec modules, domaines et interfaces

Des lignes d'équipe floues n'impliquent pas du code flou. Maintenez la clarté en :

- Modules par domaine : grouper le code par capacité métier (Payments, Catalog), pas par « frontend/backend ».

- Interfaces explicites : exposer des capacités via des interfaces de service et des contrats API bien nommés.

- Direction des dépendances : les domaines ne doivent pas dépendre des détails UI ; l'UI dépend des services domaine.

Cela aide les changements générés par l'IA à rester dans une « boîte », rendant les revues plus rapides et les régressions plus rares.

Aller vite sans couplage fort

Pour éviter que le travail feature-first devienne un bazar :

- préférez la composition aux utilitaires globaux partagés

- gardez les API façonnées pour l'UI en bordure (BFF/gateway), pas au cœur des domaines

- appliquez des tests de contrat pour que les changements inter-couches échouent tôt

Le but n'est pas une séparation stricte, mais des points de connexion prévisibles que l'IA peut suivre et les humains faire confiance.

Comment adapter votre équipe sans perdre en qualité

L'IA peut aider les équipes à aller plus vite, mais la vitesse sans garde-fous devient retouches. L'objectif n'est pas de transformer tout le monde en expert de tout. C'est de rendre les changements cross-layer sûrs, relisables et répétables — qu'une fonctionnalité touche UI, API et données ou juste une petite bordure.

Compétences à développer (celles qui montent en puissance)

Quand les frontières se floutent, les spécialistes comptent toujours, mais quelques compétences partagées facilitent la collaboration :

- Pensée produit : comprendre l'objectif utilisateur et les compromis (latence, fiabilité, accessibilité) avant d'écrire du code.

- Débogage cross-layer : suivre une requête UI → API → DB et savoir isoler la régression.

- Lire du code inconnu : interpréter vite des patterns dans un autre repo ou une autre plateforme et faire des modifications minimales et sûres.

Ce sont des compétences "transversales" qui réduisent les transferts et rendent les suggestions IA plus faciles à valider.

Habitudes d'équipe pour éviter la dérive qualité

L'IA augmente la production ; vos habitudes décident si la production est cohérente.

Commencez par vous aligner sur une Definition of Done partagée qui couvre :

- tests (types, emplacement, couverture minimale)

- gestion des erreurs et logging

- mises à jour de documentation (même petites)

- vérifs de performance et d'accessibilité quand pertinent

Ajoutez des templates légers : checklist PR, fiche de spécification de fonctionnalité et manière standard de décrire les changements API. Une structure cohérente accélère la revue et réduit les malentendus.

Outils à standardiser (pour que la qualité ne soit pas optionnelle)

La standardisation ne doit pas reposer sur la mémoire. Automatisez :

- Linters et formatters cohérents entre repos

- Checks CI qui lancent tests, vérifs de types et builds à chaque changement

- Scan dépendances et secrets pour attraper paquets risqués et leaks de credentials tôt

Si vous avez déjà ces outils, renforcez-les progressivement — évitez d'activer des règles strictes partout d'un coup.

Une raison pour laquelle des plateformes émergent autour des workflows assistés par IA est de rendre ces changements « feature-first » cohérents de bout en bout. Par exemple, Koder.ai est construit pour générer et itérer des fonctionnalités complètes via chat (pas seulement des snippets), tout en supportant des pratiques d'équipe — mode planification, déploiement/hébergement et export de code source. En pratique, cela correspond à la réalité du flou des frontières : vous voudrez souvent un flux unique pouvant toucher React web, services backend et changements de données sans que la coordination devienne le goulot.

Plan d'adoption pragmatique : commencer petit, mesurer, itérer

Choisissez une fonctionnalité qui touche plusieurs couches (par ex. un nouveau toggle de paramètres nécessitant UI, un champ API et stockage). Définissez les métriques de succès : temps de cycle, taux de défauts et fréquence des corrections après livraison.

Conduisez l'expérience pendant un sprint, puis ajustez standards, templates et CI en fonction de ce qui a cassé ou ralenti. Répétez avec la fonctionnalité suivante.

Ainsi l'adoption de l'IA reste ancrée dans les résultats, pas dans le battage médiatique — et protège la qualité au fur et à mesure que votre workflow évolue.

FAQ

Que signifie concrètement que les frontières entre web, mobile et backend se « floutent » ?

Les couches existent toujours techniquement (navigateur, appareil, serveur, base de données), mais le travail quotidien est moins strictement compartimenté. Les outils IA ont tendance à générer des changements qui suivent une histoire utilisateur de bout en bout — UI → API → logique → stockage — donc une seule tâche « fonctionnalité » traverse souvent plusieurs couches dans une même PR.

Comment l'IA transforme-t-elle l'« unité de travail » des couches vers les fonctionnalités ?

Parce que les prompts de fonctionnalité incluent naturellement l'intention et les résultats (« que se passe-t-il en cas de succès/échec », « quelles données sont nécessaires », « comment c'est stocké »). L'IA répond en produisant le code de liaison entre les couches — composants UI, endpoints, validation, migrations — donc la planification passe de « tickets par couche » à « une tranche de fonctionnalité avec critères d'acceptation ».

Quels types de livrables attendre de l'IA quand on construit une fonctionnalité de bout en bout ?

Vous recevrez souvent un bundle comme :

- Un composant UI/écran et la gestion d'état

- Une route/API ou un contrôleur et la validation de la requête

- Un changement de modèle de données + migration

- Un test basique ou un stub de contrat

Considérez cela comme un point de départ : il faut toujours vérifier les cas limites, la sécurité, la performance et la compatibilité entre clients.

Comment cadrer et assigner le travail quand une fonctionnalité couvre UI, API et données ?

Découpez en tranches de fonctionnalité avec des critères "done" clairs au lieu de multiples transferts :

- Un·e propriétaire pilote le changement bout en bout

- Les spécialistes relisent les parties à risque (auth, BD, perf)

- Les critères d'acceptation incluent les cas limites (401/403, retries, états vides)

Cela réduit les délais de coordination, à condition que la fonctionnalité soit bien définie dès le départ.

Quels changements de tech stack aident les équipes quand les frontières se floutent ?

Les évolutions typiques :

- Standardiser sur une chaîne d'outils JavaScript/TypeScript commune front/back

- Monorepos avec paquets partagés (types, schémas, validateurs, composants UI)

- Clients API générés à partir d'une source de vérité (OpenAPI/GraphQL)

L'objectif est la cohérence pour éviter que le code généré par l'IA diverge entre applications et services.

Quand un Backend-for-Frontend (BFF) a-t-il du sens, et quels sont les risques ?

Un BFF est une couche serveur fine adaptée à l'expérience d'un client (web ou mobile). Il est utile quand :

- les écrans nécessitent de la composition complexe

- il y a trop d'appels réseau par vue

- les besoins clients divergent (pagination, cache, offline)

Discipline recommandée :

- Le BFF orchestre et met en forme les données

- Les services cœur gardent les règles métier

Sinon vous risquez la duplication de logique et plusieurs « sources de vérité ».

Sur quoi doit porter la revue de code pour des changements multi-couches assistés par IA ?

Concentrez la revue moins sur la syntaxe et plus sur le comportement système :

- Exactitude en conditions réelles (latence, données, pagination, retries, échecs partiels)

- Frontières de sécurité (authZ côté serveur, validation des entrées, limites de débit)

- Contrats API (compatibilité ascendante, erreurs cohérentes)

- Coutures UX (états de chargement/vides/offline, accessibilité de base)

Des checklists légères en PR et quelques flux E2E critiques aident les réviseurs à suivre le rythme.

Quels problèmes de sécurité et de gestion des données s'aggravent quand les frontières se floutent ?

Les échecs les plus courants, souvent discrets et transverses :

- Secrets qui fuient dans le code client ou les logs

- Le fait d'utiliser un contrôle UI comme substitution d'une vraie autorisation (authZ manquante côté serveur)

- Risques d'injection liés à des interpolations de chaînes non sécurisées ou à la transmission d'entrées

- Mauvaise gestion des PII dans les logs/événements analytics

Rendez les choix sécurisés faciles : validez au périmètre API, masquez les logs, appliquez le principe du moindre privilège, et standardisez un prompt + checklist orientés sécurité.

Comment tester et observer des fonctionnalités multi-couches pour que la vitesse IA ne crée pas de glue fragile ?

Priorisez deux types de tests :

- Tests de contrat pour garantir que client et API s'accordent toujours sur les formes et réponses d'erreur

- Un petit ensemble de tests end-to-end pour les flux critiques (inscription, paiement, réinitialisation)

Puis instrumentez par fonctionnalité :

- Logs avec identifiants cohérents (request/session/feature flag)

- Metrics pour taux de succès, latence et taux d'erreur par endpoint et par flux

Quelle méthode pragmatique pour adapter une équipe au développement assisté par IA sans perdre en qualité ?

Commencez petit et standardisez les garde-fous :

- Choisir une fonctionnalité cross-layer et mesurer cycle time + taux de défauts

- Ajouter une Definition of Done partagée (tests, gestion des erreurs, docs, performance)

- Introduire des templates de PR et des checklists (changement API, ordre de déploiement, rollback)

- Renforcer progressivement la CI (vérifs de types, scans de sécurité, tests de contrat)

L'objectif est de rendre la livraison de fonctionnalités répétable sans transformer tout le monde en spécialiste de tout.