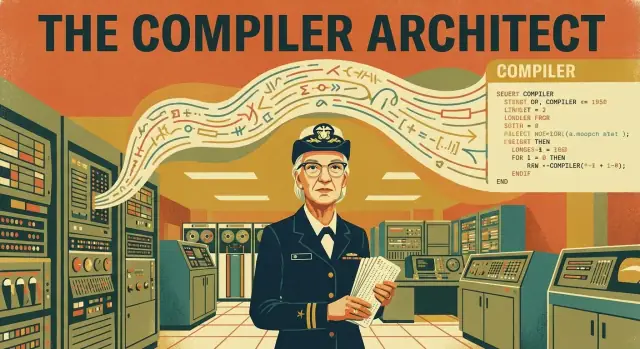

Pourquoi Grace Hopper compte encore pour notre façon de programmer

La plupart d’entre nous écrivent du code en s’attendant à ce qu’il soit lisible, réutilisable et relativement portable. Nous nommons des variables, appelons des bibliothèques et supposons que notre programme s’exécutera sur des machines que nous n’avons jamais vues. Cette attente n’est pas arrivée par hasard. Elle résulte d’un changement majeur dans la façon dont humains et machines se partagent le travail — et les compilateurs sont le pont.

La question centrale : qu’est-ce qui a changé, et pourquoi cela importait‑il ?

Les premiers programmeurs ne « tapaient » pas du code comme on l’imagine aujourd’hui. Ils manipulaient les ordinateurs à un niveau si détaillé et fragile que chaque instruction ressemblait à une fabrication artisanale de la machine. La question clé est la suivante :

Comment la programmation est-elle passée d’un savoir-faire dépendant du matériel à une pratique centrée sur l’humain, maintenable par des équipes dans le temps ?

Le rôle de Hopper : faire en sorte que la machine s’adapte à l’humain

Grace Hopper est au cœur de ce changement parce qu’elle a défendu une idée radicale pour son époque : l’ordinateur devait faire davantage le travail de traduction. Au lieu d’obliger les gens à écrire de longues suites d’instructions propices aux erreurs et adaptées à une seule machine, Hopper a contribué à pionnier des outils proches des compilateurs — des systèmes capables de transformer des instructions plus proches de l’humain en étapes basses que la machine exécute réellement.

Son travail a montré que la « traduction » n’était pas un luxe, mais une avancée de productivité. Une fois que l’on peut exprimer l’intention plus clairement, on peut :

- écrire des programmes plus rapidement,

- repérer les erreurs plus facilement,

- partager le code avec d’autres,

- et mettre à jour le logiciel sans tout réécrire depuis zéro.

Ce que vous apprendrez dans cet article

Nous verrons à quoi ressemblait la programmation avant les compilateurs, ce qu’un compilateur fait réellement (sans jargon), et comment le travail A-0 de Hopper et l’émergence de COBOL ont orienté le logiciel vers des langages lisibles et standardisés. En chemin, vous verrez des conséquences pratiques qui influencent encore le développement moderne : portabilité, travail en équipe, maintenance sur le long terme, et l’idée quotidienne que le code doit être compréhensible par des humains — pas seulement par des machines.

Si vous avez déjà profité d’un message d’erreur clair, d’un code portable ou d’un langage conçu pour se lire comme des instructions, vous vivez dans le monde que Hopper a aidé à construire.

La programmation avant les compilateurs : la méthode difficile

Grace Hopper n’a pas commencé en cherchant à « faciliter » la programmation. Elle a commencé là où l’informatique précoce l’imposait : par les limites de la machine. Formée en mathématiques, elle rejoignit la marine américaine pendant la Seconde Guerre mondiale et fut affectée au Harvard Mark I, l’un des premiers grands ordinateurs électromécaniques.

Le Mark I n’était pas un portable que l’on pouvait redémarrer après une erreur : c’était une ressource de la taille d’une pièce partagée par une équipe, planifiée avec soin et traitée comme un équipement de laboratoire coûteux.

À quoi ressemblait la programmation sans compilateurs

Avant les compilateurs, programmer ressemblait davantage à câbler un panneau de contrôle qu’à écrire ce que nous reconnaîtrions comme du code. Les instructions devaient correspondre exactement aux besoins du matériel, souvent sous forme de codes numériques ou d’opérations très bas niveau. Si vous vouliez que la machine additionne, compare ou déplace des valeurs, vous l’exprimiez dans le vocabulaire propre à la machine — étape par étape.

Ce travail était :

- manuel : vous traduisiez vous‑même votre logique en petites opérations.

- sujet aux erreurs : un seul mauvais chiffre ou une adresse erronée pouvait tout casser.

- lent à modifier : même de petites mises à jour nécessitaient une vérification de longues chaînes d’instructions.

La vraie contrainte : le temps coûtait cher

Les premiers ordinateurs étaient rares, et le « temps machine » était un poste budgétaire. On ne pouvait pas exécuter un programme sans réfléchir dix fois pour voir ce qui se passait. Les équipes se préparaient soigneusement, revérifiaient tout, puis attendaient leur tour pour lancer des jobs. Chaque minute perdue sur des erreurs évitables était du temps retiré à la résolution réelle du problème.

Cette contrainte a façonné la pensée de Hopper : si les humains passaient plus de temps à parler la langue de la machine qu’à résoudre la tâche, le goulet d’étranglement n’était pas seulement matériel, mais méthodologique.

Code machine, assembleur et le problème du temps humain

Avant les compilateurs, les programmeurs s’adressaient aux ordinateurs dans la « langue » native de la machine.

Le code machine, en termes simples

Le code machine est une suite de 0 et 1 que le processeur peut exécuter directement. Chaque motif signifie quelque chose comme « additionne ces deux nombres », « déplace cette valeur », ou « saute à une autre étape ». C’est précis — et terriblement difficile à lire, écrire et déboguer pour un humain.

L’assembleur : un petit pas vers la lisibilité

L’assembleur est du code machine avec des surnoms. Au lieu d’écrire des bits bruts, vous utilisez des mots courts comme LOAD, ADD ou JUMP, plus des adresses mémoire. Un assembleur traduit ensuite ces mots en 0 et 1 exacts pour cette machine spécifique.

L’assembleur était plus facile que le code machine pur, mais il obligeait encore les gens à penser comme le matériel : registres, emplacements mémoire et ordre exact des opérations.

Pourquoi les premiers programmes étaient liés au matériel

Les premiers ordinateurs n’étaient pas interchangeables. Différentes machines avaient des jeux d’instructions, des dispositions mémoire et même des représentations de nombres différentes. Un programme écrit pour les instructions d’un processeur ne pouvait souvent pas tourner sur un autre.

Le logiciel ressemblait moins à une « recette » et plus à une clé fabriquée sur mesure pour une serrure unique.

Quand de petits changements provoquaient de vastes réécritures

Parce que les programmes étaient construits à partir d’étapes bas niveau, une requête « simple » — ajouter une colonne à un rapport, changer le format d’un fichier ou ajuster l’arrondi d’un calcul — pouvait se répercuter sur tout le programme.

Si une nouvelle fonctionnalité nécessitait des instructions supplémentaires, il fallait parfois réorganiser les adresses mémoire, mettre à jour les cibles de saut et revérifier chaque endroit qui supposait l’ancienne disposition. Le temps machine était précieux, mais le temps humain était le vrai goulet d’étranglement — et il était brûlé sur des détails qui avaient peu à voir avec le problème métier.

La grande idée : ce qu’un compilateur fait

Les premiers ordinateurs étaient puissants mais douloureusement littéraux. Ils ne pouvaient suivre que des instructions exprimées dans l’ensemble restreint d’opérations comprises par leur matériel. Programmer ressemblait donc souvent à écrire directement pour la machine, étape par étape.

Un compilateur a renversé ce modèle : au lieu que les humains « parlent machine », on pouvait écrire des instructions dans une forme plus conviviale — et laisser un logiciel gérer la traduction. Concrètement, c’est un programme qui aide à produire des programmes.

Ce que signifie vraiment « compiler »

Compiler, c’est transformer du code que les humains peuvent lire et écrire en instructions machines que l’ordinateur peut exécuter. On peut l’imaginer comme traduire une recette en appuis sur les boutons exactement nécessaires pour un robot de cuisine.

À un niveau élevé, un compilateur :

- lit votre code source (le texte que vous avez écrit),

- vérifie s’il contient des erreurs ou des incohérences,

- le traduit en une forme plus basse que la machine peut exécuter (souvent en créant un exécutable ou un fichier de sortie).

La magie n’est pas que l’ordinateur « comprenne l’anglais ». La magie est que le compilateur fait le travail fastidieux et sujet aux erreurs, rapidement et de façon cohérente.

Compilateur vs interpréteur (confusion courante)

Les gens confondent souvent compilateurs et interprètes parce que les deux aident à exécuter du code lisible par l’humain.

Une séparation simple :

- Un compilateur traduit l’ensemble du programme (ou de larges portions) à l’avance, produisant quelque chose que la machine peut exécuter.

- Un interpréteur exécute votre programme en le traduisant et en l’exécutant pas à pas pendant l’exécution.

Les deux approches peuvent paraître similaires de l’extérieur (« j’écris du code et ça tourne »), mais le flux de travail et les compromis de performance diffèrent. Le point clé pour l’histoire de Hopper est que la compilation a rendu l’écriture de code moins dépendante des détails matériels et plus orientée sur l’expression d’intention.

A-0 de Hopper et les premiers pas vers les compilateurs

Le système A-0 de Grace Hopper (souvent daté de 1952) est l’un des premiers outils « semblables à un compilateur » — même s’il ne ressemblait pas aux compilateurs modernes qui traduisent un langage entièrement lisible par l’humain.

Ce que faisait A-0 (en termes simples)

Au lieu d’écrire chaque instruction à la main, un programmeur pouvait écrire un programme qui référençait des routines préconstruites par identifiant. A-0 pouvait alors :

- rechercher les routines demandées dans un catalogue (une liste de bibliothèques),

- extraire les blocs de code machine corrects pour ces routines,

- les assembler en un programme exécutable complet (ce qu’on appellerait aujourd’hui l’édition de liens).

Le programmeur ne demandait pas encore à la machine de « comprendre un langage proche de l’anglais ». Il lui demandait d’automatiser une tâche répétitive et sujette aux erreurs : sélectionner et combiner des blocs de construction connus.

Sous‑programmes et bibliothèques : moins de répétition, moins d’erreurs

A-0 s’appuyait sur une idée puissante : les sous‑programmes. Si vous disposiez déjà d’une routine testée pour l’entrée/sortie, des opérations mathématiques ou le déplacement de données, vous n’aviez pas à la réécrire à chaque fois.

Cela a changé le travail quotidien de deux manières importantes :

- Vitesse : les équipes pouvaient construire de nouveaux programmes en réutilisant des pièces existantes.

- Fiabilité : la réutilisation de routines éprouvées réduisait le risque d’introduire de nouveaux bugs.

Le changement d’état d’esprit : programmation = réutilisation + automatisation

L’impact profond d’A-0 n’était pas seulement technique, mais culturel. L’outil suggérait que programmer pouvait consister à décrire ce que l’on voulait assembler à partir de composants fiables et à laisser des outils faire le travail mécanique.

Cette attitude — réutiliser des bibliothèques, standardiser des routines et automatiser la traduction — devint la base des compilateurs, des langages standards et des pratiques modernes de développement logiciel.

Du code convivial pour les humains : la poussée vers la lisibilité

Facilitez la maintenance

Utilisez le chat pour générer des modules lisibles et réutilisables, afin d'éviter l'archéologie du code.

Les premiers programmeurs se battaient non seulement avec les machines, mais aussi avec les idées des uns et des autres sur ce qu’était la « vraie » programmation. Pour beaucoup d’ingénieurs, le travail sérieux ressemblait au matériel : serré, numérique et explicite. Tout ce qui ressemblait à du langage naturel paraissait suspectement imprécis.

Pourquoi le code « anglophone » semblait mauvais

Grace Hopper soutenait que les ordinateurs devaient servir les humains, et non l’inverse. Sa défense d’une notation plus lisible — des instructions proches des termes métiers plutôt que des opérations machine — était controversée parce qu’elle remettait en cause une croyance centrale : l’efficacité exigeait que les humains pensent en pas façonnés pour la machine.

Les sceptiques craignaient que des commandes proches de l’anglais soient ambiguës, cachent des détails importants et encouragent la pensée négligente. Hopper répliquait de façon pragmatique : la majeure partie du temps de programmation n’est pas consacrée à taper des instructions, mais à les comprendre plus tard.

La lisibilité est une stratégie de maintenance

Le code lisible n’a pas pour but de rendre les programmes « faciles », mais de les rendre survivables. Quand le code communique l’intention, les équipes peuvent réviser les changements plus vite, intégrer de nouvelles personnes avec moins d’erreurs et diagnostiquer les problèmes sans rétro‑ingénierie complète.

Cela compte d’autant plus sur plusieurs années. Le logiciel survit aux rôles, aux départements et parfois au but initial pour lequel il a été construit. Une structure et des noms adaptés réduisent le coût du changement, qui est souvent le poste le plus important dans le coût total du logiciel.

L’approche de Hopper avait des limites. Les premiers compilateurs et outils étaient immatures, et le code de haut niveau pouvait produire des programmes plus lents ou plus volumineux que de l’assembleur optimisé à la main. Le débogage pouvait aussi sembler indirect : les erreurs apparaissaient parfois dans la sortie compilée plutôt que dans le texte source.

Pourtant, le bénéfice à long terme était clair : un code source lisible permettait de construire des systèmes plus vastes avec plus de personnes — et de les maintenir bien après la livraison initiale.

COBOL et la marche vers des langages standardisés

COBOL (Common Business-Oriented Language) a été conçu autour d’un objectif simple : rendre les programmes lisibles par les personnes qui gèrent les entreprises, pas seulement par celles qui câblent les machines. Grace Hopper a fortement soutenu cette idée : si le code devait survivre des années, être transféré entre équipes et résister aux changements de personnel, il devait être compréhensible.

Ce que COBOL cherchait à atteindre

COBOL a été pensé pour le traitement des données métier : paies, inventaires, facturation et autres travaux où la « forme » des données compte autant que les calculs. C’est pourquoi COBOL mettait l’accent sur les enregistrements, les champs et des descriptions claires de ce que le programme faisait.

Une grande part de l’ambition était la clarté. COBOL utilisait une structure proche de l’anglais pour qu’une personne parcourant le programme puisse suivre l’intention. Il ne s’agissait pas de rendre la programmation « facile », mais de la rendre lisible et maintenable lorsque le coût des erreurs dans les systèmes métiers pouvait être énorme.

Comités, normes et pourquoi cela importait

La vraie percée de COBOL ne fut pas seulement sa syntaxe. Ce fut le passage à la standardisation.

Plutôt que d’être lié au langage propre à un fabricant ou à une entreprise, COBOL a été façonné par des comités et des spécifications formelles. Ce processus pouvait être lent et politique, mais il a créé une cible commune que plusieurs vendeurs pouvaient implémenter.

En pratique, cela signifiait que les organisations pouvaient investir dans COBOL avec plus de confiance : les supports de formation duraient plus longtemps, le recrutement était plus facile et le code avait plus de chances de survivre à un changement de matériel.

La standardisation a aussi modifié les attentes. Les langages n’étaient plus que des outils « fournis avec la machine ». Ils devenaient des accords publics : des règles sur la façon dont les humains écrivent des instructions et comment les compilateurs les traduisent.

Un regard équilibré : forces et critiques

Les forces de COBOL sont faciles à expliquer : il est explicite, ses structures de données sont centrales et il prend en charge des systèmes métiers durables. Cette longévité n’est pas un accident ; elle résulte de choix de conception favorisant la clarté et la stabilité.

Les critiques sont tout aussi réelles. COBOL peut être verbeux, et sa lisibilité peut paraître rigide par rapport aux langages modernes. Mais la verbosité servait souvent un but : le code montre son fonctionnement, ce qui aide l’audit, la maintenance et les transferts de mains.

COBOL marque un tournant où les langages de programmation ont commencé à agir moins comme des raccourcis personnels et plus comme une infrastructure pilotée par des normes — partagée, enseignable et conçue pour durer.

D’une machine à plusieurs : portabilité et standardisation

Lancez un projet full‑stack

Créez une application React avec une API Go et PostgreSQL en un seul flux guidé.

Les premiers programmes étaient souvent mariés à une machine spécifique. Si vous changiez d’ordinateur, vous ne déplaciez pas juste des fichiers — il fallait souvent réécrire le programme, car les instructions et conventions étaient différentes. Cela rendait le logiciel fragile et coûteux, et freinait l’adoption de nouveau matériel.

Portabilité : le vrai « écrire une fois, exécuter (presque) partout »

Les compilateurs ont introduit une séparation puissante : vous écrivez votre programme dans un langage de haut niveau, et le compilateur le traduit en instructions natives d’un ordinateur particulier.

C’est ce que l’on entend par portabilité : le même code source peut être compilé pour différentes machines — tant qu’il existe un compilateur approprié (et que vous évitez des hypothèses dépendantes du matériel). Au lieu de réécrire un système de paie pour chaque nouvel ordinateur, les organisations pouvaient conserver la logique et simplement recompiler.

Du meilleur matériel sans réécrire le logiciel

Ce changement a bouleversé l’économie des améliorations matérielles. Les fabricants pouvaient sortir des machines plus rapides ou plus capables, et les clients n’avaient pas à jeter des années d’investissement logiciel.

Les compilateurs sont devenus une sorte de « couche adaptatrice » entre des besoins métiers stables et une technologie qui changeait rapidement. On pouvait mettre à niveau processeurs, modèles mémoire et périphériques tout en conservant l’intention de l’application. Certaines modifications demandaient des mises à jour — surtout autour de l’entrée/sortie — mais l’idée centrale n’était plus liée à un jeu d’opcodes.

Standardisation : langages partagés, écosystèmes partagés

La portabilité s’améliore fortement lorsque le langage est standardisé. Des règles communes font que le code écrit pour un compilateur a de fortes chances de se compiler sur un autre, réduisant le verrouillage fournisseur et facilitant le partage du logiciel.

Cet héritage est partout aujourd’hui :

- des applications multiplateformes construites à partir d’une base de code commune (bureau, mobile, web),

- des langages et des environnements d’exécution standardisés qui se comportent de façon prévisible sur différents systèmes,

- de grands écosystèmes — bibliothèques, outils et viviers de recrutement — qui existent parce que l’on fait confiance à ce que « le même code » signifie à peu près la même chose ailleurs.

La poussée de Grace Hopper vers une programmation conviviale et largement utilisable n’était pas seulement une question de confort. Elle a aidé à transformer le logiciel d’instructions spécifiques en un actif portable capable de traverser les générations matérielles.

Comment les compilateurs ont changé le travail logiciel et la maintenance

Les compilateurs n’ont pas seulement accéléré la programmation — ils ont remodelé l’organisation des équipes logicielles. Quand le code peut être écrit en termes de haut niveau (plus proches des règles métier que des instructions machine), différentes personnes peuvent contribuer plus efficacement.

Nouveaux rôles, transferts plus clairs

Les premiers projets séparaient souvent le travail en rôles comme analystes (qui définissaient ce que le système devait faire), programmeurs (qui traduisaient cela en code) et opérateurs (qui exécutaient les jobs et géraient le temps machine). Avec les compilateurs, les analystes pouvaient décrire les flux de travail de manière plus structurée et cohérente, tandis que les programmeurs passaient moins de temps à « assembler à la main » des instructions et plus de temps à concevoir une logique correspondant à ces flux.

Le résultat fut un transfert plus propre : exigences → code source lisible → programme compilé. Cela a rendu les grands projets moins dépendants de quelques spécialistes connaissant les subtilités d’une seule machine.

La maintenance est devenue la vraie facture

À mesure que le logiciel vivait des années — pas seulement des semaines — la maintenance est devenue un coût majeur. Correctifs, mises à jour et petits changements de politique s’accumulent. Un code source lisible rend cela soutenable : une personne nouvelle peut comprendre l’intention sans décoder des milliers d’instructions bas niveau.

Les compilateurs ont soutenu cela en encourageant la structure : variables nommées, routines réutilisables et flux de contrôle clair. Quand le code s’explique lui‑même, la maintenance cesse d’être de l’archéologie.

De meilleures pratiques de test et de débogage

Des abstractions plus claires ont aussi amélioré les tests et le débogage. Au lieu de traquer une instruction matérielle incorrecte, les équipes pouvaient raisonner en termes de fonctionnalités (« ce calcul est faux pour les remboursements ») et isoler les problèmes à un module ou une fonction.

Même lorsque les compilateurs affichaient des erreurs cryptiques au début, ils ont imposé une discipline précieuse : garder le code source organisé, vérifier le comportement étape par étape, et modifier là où l’intention est exprimée — pas là où le matériel stocke les bits.

Mythes courants sur les compilateurs et la programmation « facile »

Les compilateurs traduisent des instructions humaines en instructions machines. Ce changement a rendu le logiciel plus rapide à écrire et plus facile à partager — mais il a aussi généré quelques mythes qui persistent quand on parle de programmation.

Mythe 1 : « Le compilateur rend le programme correct »

Un compilateur vérifie surtout si votre code respecte les règles du langage et peut être traduit en quelque chose que la machine peut exécuter. Si votre logique est erronée, le compilateur produira souvent un programme valide qui fait néanmoins la mauvaise chose.

Par exemple, un calcul de paie peut se compiler sans erreur tout en versant un montant incorrect à cause d’une formule fausse, d’un cas limite oublié ou d’une hypothèse sur les fuseaux horaires.

Mythe 2 : « Les langages de haut niveau empêchent les bugs »

Les langages de haut niveau réduisent certaines classes d’erreurs — comme mélanger des instructions CPU ou gérer manuellement des détails de mémoire — mais ils n’éliminent pas les bugs. Vous pouvez encore :

- mal gérer des entrées et créer des failles de sécurité,

- écrire du code qui marche pour les cas « normaux » mais échoue pour les cas inhabituels,

- construire des systèmes difficiles à changer parce qu’ils sont confus ou incohérents.

Le code lisible est un grand avantage, mais lisibilité n’est pas synonyme de correction.

Mythe 3 : « Si c’est lisible, c’est forcément sûr et efficace »

Un code bien nommé et bien formaté peut être pourtant non sécurisé (par ex. en faisant confiance aux entrées utilisateur), lent (par ex. des appels répétés à la base dans une boucle) ou fragile (dépendances cachées).

La meilleure formulation est : le code lisible facilite la détection des problèmes et leur correction. Il ne garantit pas l’absence de problèmes.

Habitudes pratiques qui battent les mythes

Les compilateurs sont des outils, pas des nourrices. La fiabilité dépend toujours des pratiques humaines :

- Nommage : choisissez des noms qui expliquent l’intention, pas seulement la mécanique.

- Documentation : consignez les hypothèses (entrées, sorties, limites).

- Revues : demandez un second avis avant de publier des changements.

- Tests : validez automatiquement le comportement pour que les changements ne cassent pas d’anciennes promesses.

Grace Hopper a plaidé pour un code que les humains comprennent. Le meilleur prolongement de son action est d’associer cette lisibilité à des pratiques disciplinées qui empêchent que « facile » rime avec « négligent ».

L’héritage des compilateurs dans les langages et outils modernes

Modifiez sans crainte

Utilisez les instantanés et les retours en arrière pour expérimenter en toute sécurité lors de changements de fonctionnalités ou de refactorisation.

La conviction centrale de Hopper était simple : si nous pouvons décrire le travail en termes compréhensibles, les ordinateurs doivent prendre en charge la traduction. Cette idée est intégrée dans presque chaque expérience de programmation moderne — qu’il s’agisse d’écrire Python ou JavaScript, ou de déployer des apps avec des chaînes d’outils industrielles.

Aujourd’hui, un « compilateur » est rarement un seul programme. C’est une chaîne : parse, vérifier, transformer, optimiser et produire quelque chose d’exécutable (code machine, bytecode ou bundle optimisé). Que vous écriviez en Go, Rust, Swift ou C#, vous bénéficiez de la même promesse que celle portée par Hopper : réduire la corvée humaine, clarifier l’intention et laisser les machines faire la conversion répétitive.

C’est aussi pourquoi le développement moderne tend vers des interfaces de plus haut niveau qui produisent néanmoins des systèmes réellement déployables. Sur des plateformes comme Koder.ai, par exemple, vous décrivez ce que vous voulez via une interface de chat, et un flux de travail agent‑basé aide à générer et affiner une application (web, backend ou mobile) tout en produisant du code source exportable. De manière très hopperienne, l’objectif reste le même : déplacer l’effort de la traduction fastidieuse vers l’intention claire, des sorties révues et une itération plus rapide.

Les améliorations de confort que nous tenons pour acquises

Les compilateurs modernes n’effectuent pas seulement des traductions : ils enseignent et protègent.

Quand vous voyez un message d’erreur qui pointe la ligne exacte et suggère une correction, c’est un héritage du traitement de la programmation comme activité humaine, pas rituelle machine.

L’optimisation est une autre victoire discrète : les compilateurs peuvent rendre le code plus rapide ou plus petit sans forcer les développeurs à peaufiner chaque instruction.

L’analyse statique (intégrée aux compilateurs ou aux outils adjacents) détecte des problèmes tôt — incompatibilités de types, code inatteignable, erreurs potentielles de nullité — avant que le logiciel n’atteigne les utilisateurs.

Tout cela se traduit par des cycles de développement plus rapides : vous écrivez un code plus clair, les outils signalent les problèmes plus tôt, et les builds produisent des sorties fiables sur plusieurs environnements. Même si vous ne prononcez jamais le mot « compilateur », vous le ressentez à chaque fois que votre IDE souligne un bug, que votre CI échoue avec un diagnostic précis ou que votre release s’améliore après une mise à jour de la chaîne d’outils.

C’est la vision de Hopper répercutée dans la pratique quotidienne.

Le travail de Grace Hopper sur les compilateurs n’a pas seulement facilité la programmation : il a transformé ce que le logiciel pouvait être. Avant les compilateurs, chaque amélioration dépendait d’efforts minutieux et bas niveau. Après les compilateurs, une plus grande part du temps humain pouvait se consacrer aux idées, aux règles et au comportement plutôt qu’à la traduction instruction par instruction.

Ce qui a réellement changé — et pourquoi cela a duré

Deux changements ont fait la différence :

- Automatisation : le compilateur a pris en charge la tâche répétitive de transformer des instructions signifiantes en étapes prêtes pour la machine. Cela a réduit les erreurs manuelles et accéléré l’itération.

- Lisibilité : le code s’est rapproché du langage humain et de la logique métier. Les programmes sont devenus des documents que les équipes peuvent discuter, réviser et maintenir — pas seulement des énigmes réservées à leur auteur.

Ces bénéfices se renforcent mutuellement. Quand le code est plus facile à lire, il est plus facile à améliorer. Quand la traduction est automatisée, les équipes peuvent se permettre de refactorer et d’adapter le logiciel au fil des besoins. C’est pourquoi les compilateurs n’ont pas été un tour de passe‑passe ponctuel : ils sont devenus la fondation des langages, outils et pratiques collaboratives modernes.

Le principal enseignement : les compilateurs augmentent l’effort humain

Un compilateur n’a pas pour but de « rendre la programmation facile » mais plutôt de rendre la programmation scalable. Il permet à l’intention d’une personne de voyager plus loin : à travers des projets plus vastes, des équipes plus nombreuses, des durées plus longues et des machines multiples.

Une petite réflexion pour votre propre code

Si quelqu’un rejoignait votre équipe demain, quel changement simple pourriez‑vous faire pour qu’il comprenne votre code plus vite — meilleurs noms, structure plus claire ou un court commentaire expliquant le “pourquoi” ?