Pourquoi le déploiement et le SSR sont devenus des produits

Il n’y a pas si longtemps, mettre en ligne une application web signifiait généralement : la construire, trouver un hébergeur, la configurer et la maintenir. Même si votre code était simple, la rendre publique impliquait des décisions sur les serveurs, le cache, les pipelines de build, les certificats TLS et la supervision. Rien de glamour, mais inévitable — et cela détournait souvent des équipes du produit qu’elles tentaient de livrer.

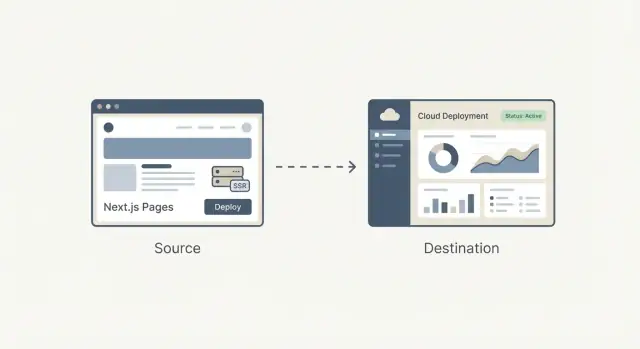

De « l’hébergement » à un flux de travail répétable

Le grand changement est que le déploiement a cessé d’être un projet technique ponctuel pour devenir un flux de travail qu’on répète quotidiennement. Les équipes voulaient des URL d’aperçu pour chaque pull request, des rollbacks qui ne demandent pas d’enquête, et un chemin fiable du code local à la production.

Une fois ces besoins devenus courants dans les startups, agences et entreprises, le déploiement a commencé à ressembler moins à de l’ingénierie sur-mesure et plus à quelque chose qui pouvait être empaqueté : un produit avec des valeurs par défaut claires, une UI, de l’automatisation sensée et des résultats prévisibles.

Pourquoi le déploiement et le SSR semblaient spécialisés

Le rendu côté serveur (SSR) ajoutait une couche de complexité. Ce n’est pas seulement « servir des fichiers » ; c’est « exécuter du code côté serveur pour générer du HTML, le mettre en cache de façon sûre et le mettre à jour sans perturber les utilisateurs ». Bien faire le SSR impliquait de comprendre :

- les environnements d’exécution (Node, fonctions serverless)

- les règles de mise en cache et l’invalidation

- les compromis de performance et les cold starts

- le routage, les réécritures et les headers

C’était gérable pour des spécialistes, mais facile à mal configurer — et difficile à maintenir à mesure que le projet grandissait.

La question centrale de cet article

Que signifie donc « productiser l’infrastructure frontend » ?

C’est transformer les parties bordéliques et sujettes aux erreurs du déploiement d’un frontend — builds, déploiements, aperçus, gestion SSR/SSG, cache et distribution edge — en un système standard, majoritairement automatique, qui fonctionne de la même manière à travers les projets.

Dans les sections qui suivent, l’objectif est pratique : comprendre ce qui est simplifié, ce qu’on gagne et quels compromis on accepte — sans devoir devenir un expert ops.

Le rôle de Guillermo Rauch dans la stack frontend moderne

Guillermo Rauch est aujourd’hui surtout connu comme CEO de Vercel et comme l’une des voix derrière Next.js. Son influence tient moins à une invention unique qu’à une obsession constante : rendre le développement web « évident » pour les personnes qui construisent des produits.

Bâtisseur + leader open-source (les faits)

Rauch a passé une grande partie de sa carrière à publier des outils développeur en public. Avant Vercel, il a créé et maintenu des projets open-source populaires (notamment Socket.IO) et contribué à une culture où documentation, exemples et valeurs par défaut sensées sont traités comme partie intégrante du produit — pas comme des rustines.

Il a ensuite fondé ZEIT (devenue Vercel), une entreprise centrée sur la transformation du déploiement en un flux de travail rationalisé. Next.js, initialement développé dans cet écosystème, est devenu le framework phare qui associe une expérience front moderne à des fonctionnalités adaptées à la production.

L’expérience développeur comme décision produit

Une façon utile de comprendre l’impact de Rauch est à travers des choix récurrents :

- réduire le nombre d’étapes « réservées aux experts » entre le code et une URL live

- rendre les options de performance et de rendu accessibles via des conventions

- privilégier des workflows de bout en bout (framework + hébergement) quand cela supprime des frictions

Cette focalisation a façonné à la fois le framework et la plateforme : Next.js a encouragé les équipes à adopter SSR et génération statique sans apprendre tout un nouveau playbook opérationnel, tandis que Vercel a poussé le déploiement vers un défaut prévisible et répétable.

Faits vs interprétation (sans mythes du héros)

Il est tentant de réduire cette histoire à un récit centré sur une seule personne. Une interprétation plus juste est que Rauch a aidé à aligner un mouvement plus large déjà en cours : les équipes frontend voulaient itérer plus vite, réduire les transferts de responsabilités et disposer d’une infrastructure qui ne nécessite pas un spécialiste ops dédié à chaque changement.

Vercel et Next.js servent d’étude de cas en pensée produit parce qu’ils ont empaqueté ces demandes en valeurs par défaut que les équipes grand public peuvent réellement utiliser.

Next.js en termes simples : ce qu’il résout

Next.js est un framework React qui vous fournit une « boîte à outils complète pour une application web » au-dessus de React. Vous continuez à construire des composants comme d’habitude, mais Next.js ajoute les pièces manquantes que la plupart des équipes finissent par assembler : pages, routage, façons de récupérer des données et valeurs par défaut orientées performance pour la production.

Les problèmes qu’il adresse

Routage et pages : dans une app React simple, vous ajoutez souvent une bibliothèque de routage, décidez des conventions d’URL et branchez tout. Next.js fait des URLs et des pages une fonctionnalité de première classe, de sorte que la structure de votre application se map naturellement aux routes.

Chargement des données : les vraies apps ont besoin de données — listes de produits, comptes utilisateur, contenu CMS. Next.js fournit des patterns communs pour charger des données côté serveur, au moment du build ou dans le navigateur, sans forcer chaque équipe à inventer une configuration sur-mesure.

Valeurs par défaut de performance : Next.js intègre des optimisations pratiques — découpage de code, gestion intelligente des assets et choix de rendu — pour obtenir de bonnes performances sans courir après une longue checklist de plugins.

En quoi il diffère d’une « app React basique »

Une app React basique est souvent « React + un tas de décisions » : bibliothèque de routage, configuration de build, outils SSR/SSG (si nécessaire) et conventions qui n’existent que dans votre repo.

Next.js est plus opiniâtre : il standardise les décisions communes pour que les nouveaux développeurs comprennent le projet plus vite et pour que les équipes passent moins de temps à maintenir la plomberie.

Quand Next.js peut être inutile

Next.js peut être disproportionné si vous construisez un petit site principalement statique avec quelques pages, ou un outil interne simple où le SEO et le premier rendu ne sont pas prioritaires.

Si vous n’avez pas besoin de multiples options de rendu, d’un routage structuré ou du chargement serveur de données, une configuration React légère (ou même pas de React) peut être plus simple et moins coûteuse.

SSR, SSG et rendu côté client : différences pratiques

Les applications modernes peuvent sembler mystérieuses parce que « l’endroit où la page est construite » change selon l’approche. Une façon simple de penser au SSR, SSG et au rendu côté client (CSR) est : quand et où le HTML est créé ?

SSR (rendu côté serveur)

Avec le SSR, le serveur génère le HTML pour chaque requête (ou pour plusieurs requêtes si un cache est utilisé). Cela aide le SEO et accélère la première vue — surtout sur des appareils lents — parce que le navigateur reçoit du contenu réel rapidement.

Une idée reçue courante : le SSR n’est pas automatiquement plus rapide. Si chaque requête déclenche des appels DB lents, le SSR peut paraître lent. La vraie rapidité vient souvent du cache (au serveur, CDN ou edge) pour que les visites répétées ne refassent pas le même travail.

SSG (génération statique)

Avec la SSG, les pages sont pré-générées à l’avance (pendant une étape de build) et servies comme fichiers statiques. C’est idéal pour la fiabilité et le coût, et souvent très rapide car la page est « prête » avant que l’utilisateur n’arrive.

La SSG brille pour les pages marketing, la documentation et le contenu qui ne change pas toutes les secondes. L’inconvénient est la fraîcheur : mettre à jour du contenu peut demander un rebuild ou une stratégie de mise à jour incrémentale.

CSR (rendu côté client)

Avec le CSR, le navigateur télécharge le JavaScript et construit l’UI sur l’appareil de l’utilisateur. Parfait pour des parties très interactives et personnalisées (dashboards, éditeurs), mais cela peut retarder la première vue significative et compliquer le SEO si le contenu n’est pas disponible en HTML dès le départ.

Pourquoi les équipes mélangent les trois

La plupart des produits réels combinent les modes : SSG pour les pages d’atterrissage (SEO et vitesse), SSR pour les pages dynamiques nécessitant du contenu indexable, et CSR pour les expériences connectées.

Bien choisir se relie directement aux résultats : SEO (découvrabilité), vitesse (conversion) et fiabilité (moins d’incidents, revenus plus stables).

Avant la productisation : à quoi ressemblait le déploiement d’apps web

Avant que les plateformes ne rendent le déploiement aussi simple qu’un clic, publier une application web signifiait souvent assembler votre propre mini « projet d’infrastructure ». Même un site marketing simple avec un formulaire dynamique pouvait devenir une chaîne de serveurs, scripts et services devant rester synchronisés.

Le flux de travail typique

On provisionnait un ou plusieurs serveurs (ou VM), on installait un serveur web et on câblait un pipeline CI qui buildait l’app et copiait les artefacts par SSH.

Ensuite, on configurait un reverse proxy (comme Nginx) pour router les requêtes, terminer le TLS et gérer la compression. Puis la mise en cache : peut-être une configuration CDN et des règles sur quelles pages sont sûres à mettre en cache et pour combien de temps.

Si vous aviez besoin de SSR, vous exploitiez un processus Node qu’il fallait démarrer, surveiller, redémarrer et scaler.

Points de douleur qui ralentissaient les équipes

Les problèmes n’étaient pas théoriques — ils apparaissaient à chaque release :

- Dérive de configuration : staging est « assez proche » de prod jusqu’à ce que ce ne soit plus le cas. Une petite différence de paquet OS pouvait casser des builds ou le runtime.

- Releases lentes : chaque déploiement demandait de coordonner scripts CI, état des serveurs, variables d’environnement et invalidation de cache.

- Rollbacks difficiles : revenir en arrière impliquait souvent redéployer un ancien build et espérer que l’état serveur (et les dépendances) correspondait encore.

Pourquoi « ça marche sur ma machine » était si courant

Le développement local masque les parties bordéliques : cache chaud, version Node différente, variable d’environnement autre, et pas de vrai trafic. Une fois déployé, ces différences surgissent — souvent sous forme de mismatches SSR subtils, secrets manquants ou règles de routage qui se comportent différemment derrière un proxy.

La taxe cachée pour les petites équipes

Les setups avancés (SSR, multi-région, environnements d’aperçu sûrs) étaient possibles, mais demandaient du temps opérationnel. Pour beaucoup de petites équipes, cela signifiait se contenter d’une architecture plus simple — pas parce qu’elle était optimale, mais parce que le coût de déploiement était trop élevé.

L’idée centrale de Vercel : le déploiement comme flux par défaut

Faites du déploiement la norme

Déployez et hébergez depuis un seul endroit, avec un chemin simplifié des changements vers la production.

Vercel n’a pas juste automatisé le déploiement — il l’a emballé en un flux par défaut qui fait partie intégrante de l’écriture du code. L’idée produit est simple : le déploiement ne devrait pas être une tâche ops séparée ; il devrait être l’issue normale du développement quotidien.

« Git push to deploy » comme promesse produit

« Git push to deploy » est souvent décrit comme un script pratique. Vercel le traite plutôt comme une promesse : si votre code est dans Git, il est déployable — de façon consistante, répétée et sans checklist d’étapes manuelles.

Cette différence compte parce qu’elle change qui se sent confiant pour livrer. Vous n’avez pas besoin d’un spécialiste pour interpréter les settings serveurs, règles de cache ou étapes de build à chaque fois. La plateforme transforme ces décisions en valeurs par défaut et garde-fous.

Les déploiements d’aperçu changent la collaboration

Les déploiements d’aperçu sont une grande partie de pourquoi cela ressemble à un flux, pas à un outil. Chaque pull request peut générer une URL partageable qui reflète fidèlement le comportement production.

Les designers valident espacements et interactions dans un vrai environnement. La QA teste le build exact qui serait déployé. Les PMs parcourent la fonctionnalité et laissent des retours concrets — sans attendre une « staging push » ou demander à quelqu’un d’exécuter la branche en local.

Rollbacks et parité d’environnement comme outils de sécurité

Quand le déploiement devient fréquent, la sécurité devient un besoin quotidien. Les rollbacks rapides transforment une mauvaise release en simple inconvénient, pas en incident majeur.

La parité d’environnement — garder previews, staging et production proches — réduit le problème « ça marche sur ma machine » qui ralentit les équipes.

Une histoire utilisateur simple : page marketing + mise à jour d’app

Imaginez que vous livrez une nouvelle page de tarification et un petit changement dans le flow d’inscription. Avec les déploiements d’aperçu, le marketing valide la page, la QA teste le flow et l’équipe merge en confiance.

Si l’analytics montre un problème après le lancement, vous effectuez un rollback en minutes pendant que vous corrigez — sans bloquer tout le reste du travail.

Du CDN à l’edge : infrastructure frontend sans équipe ops

Un CDN (Content Delivery Network) est un ensemble de serveurs répartis dans le monde qui stockent (et servent) des copies des fichiers de votre site — images, CSS, JavaScript et parfois HTML — pour que les utilisateurs les téléchargent depuis un emplacement proche.

La mise en cache est le règlement qui indique combien de temps ces copies peuvent être réutilisées. Une bonne mise en cache signifie pages plus rapides et moins de hits sur l’origine. Une mauvaise mise en cache signifie utilisateurs exposés à du contenu périmé — ou une équipe qui n’ose rien mettre en cache.

L’edge est l’étape suivante : au lieu de seulement servir des fichiers depuis des emplacements globaux, vous pouvez exécuter de petits morceaux de code près de l’utilisateur, au moment de la requête.

C’est là que « l’infrastructure frontend sans équipe ops » devient réel : beaucoup d’équipes obtiennent une distribution globale et une gestion intelligente des requêtes sans gérer des serveurs dans plusieurs régions.

À quoi servent les fonctions edge

Les fonctions edge sont utiles quand il faut prendre des décisions rapides avant de servir une page :

- Personnalisation : sélectionner du contenu selon la localisation, le device ou un segment d’utilisateurs.

- Vérifications d’auth : rediriger les non-authentifiés, valider une session ou définir des headers.

- A/B tests : acheminer les utilisateurs dans des expériences de façon cohérente (sans aller-retour supplémentaire).

Quand l’edge est inutile

Si votre site est majoritairement statique, a peu de trafic ou que vous avez des exigences strictes sur l’endroit exact où le code s’exécute (légal ou résidence des données), l’edge peut ajouter de la complexité sans gain clair.

Les compromis à connaître

Exécuter du code dans de nombreux emplacements peut rendre l’observabilité et le débogage plus difficiles : logs et traces sont plus distribués, et reproduire un bug « seulement dans une région » prend du temps.

Il existe aussi des comportements spécifiques au fournisseur (APIs, limites, différences de runtime) qui affectent la portabilité.

Utilisées judicieusement, les capacités edge permettent d’obtenir des performances et un contrôle « globaux par défaut » — sans recruter une équipe ops pour tout assembler.

Mettez en ligne sur votre domaine

Publiez votre app sur un domaine personnalisé quand vous êtes prêt à la partager avec vos clients.

Un framework et une plateforme « s’emboîtent » quand l’hébergeur comprend ce que le framework produit au moment du build — et ce dont il a besoin au moment de la requête.

Cela signifie que l’hébergeur peut interpréter la sortie du build (fichiers statiques vs fonctions serveur), appliquer les règles de routage adaptées (routes dynamiques, rewrites) et définir des comportements de cache sensés (ce qui peut être mis en cache à l’edge, ce qui doit rester frais).

Ce que l’intégration simplifie

Quand la plateforme connaît les conventions du framework, beaucoup de travail disparaît :

- Optimisation d’images automatique : le framework produit un pipeline d’image prévisible et la plateforme peut l’exécuter près des utilisateurs, mettre en cache les résultats et gérer les formats.

- Headers et redirects deviennent de la configuration plutôt que du code serveur personnalisé. Vous déclarez l’intention (headers de sécurité, cache, redirects canoniques) et la plateforme l’applique.

- Déploiements d’aperçu et paramètres d’environnement fonctionnent « out of the box » car la plateforme peut mapper branches, builds et settings runtime aux attentes du framework.

Le bénéfice net est moins de scripts bespoke et moins de surprises « ça marche sur ma machine » au moment du déploiement.

Les compromis d’un couplage étroit

Le revers de la commodité est l’enfermement. Si votre application dépend de fonctionnalités spécifiques à la plateforme (APIs de fonctions edge, règles de cache propriétaires, plugins de build), migrer plus tard peut nécessiter de réécrire une partie du routage, du middleware ou du pipeline de déploiement.

Pour préserver la portabilité : séparez les préoccupations : gardez la logique métier native au framework, documentez tout comportement spécifique à l’hébergeur et privilégiez les standards (headers HTTP, redirects, variables d’environnement).

Ne présumez pas qu’il existe une solution unique. Comparez les plateformes selon : flux de déploiement, modes de rendu supportés, contrôle du cache, support edge, observabilité, prévisibilité tarifaire et facilité de sortie.

Un petit proof-of-concept — déployer le même repo sur deux fournisseurs — révèle souvent les vraies différences plus vite que la lecture de la doc.

La performance n’est pas seulement un score à exhiber. C’est une fonctionnalité produit : des pages plus rapides réduisent le taux de rebond et améliorent les conversions, et des builds plus rapides permettent aux équipes de livrer plus souvent sans attendre.

Deux types de « rapide » qui comptent

Pour les utilisateurs, « rapide » signifie que la page devient utilisable vite — surtout sur des téléphones milieu de gamme et des réseaux lents. Pour les équipes, « rapide » signifie que les déploiements finissent en minutes (ou secondes) pour que les changements puissent être mis en production en confiance.

Vercel a popularisé l’idée que l’on peut optimiser les deux à la fois en faisant de la performance une partie du flux par défaut plutôt qu’un projet spécial.

Builds incrémentiels et cache (en clair)

Un build traditionnel reconstruit souvent tout, même si vous avez modifié une ligne sur une seule page. Les builds incrémentiels visent à reconstruire seulement ce qui a changé — comme réimprimer un chapitre au lieu de tout le livre.

La mise en cache aide en réutilisant des résultats préalablement calculés :

- Cache de build réutilise des parties des builds précédents pour accélérer les prochains déploiements.

- Cache de rendu conserve des pages pré-calculées proches des utilisateurs pour éviter de refaire le même travail.

Dans Next.js, des patterns comme l’incremental static regeneration (ISR) suivent cet état d’esprit : servir une page pré-construite et la rafraîchir en arrière-plan quand le contenu change.

Un budget de performance est une limite simple sur laquelle vous vous accordez — par exemple « garder la page d’accueil sous 200KB de JavaScript » ou « Largest Contentful Paint < 2,5s sur mobile typique ». L’objectif n’est pas la perfection ; c’est empêcher les lenteurs de s’installer discrètement.

Vérifications simples à ajouter au workflow

Gardez ça léger et cohérent :

- Exécuter Lighthouse dans le CI pour les pages clés et faire échouer le build si vous cassez le budget.

- Suivre les métriques réelles utilisateurs (RUM) pour mesurer l’expérience réelle, pas seulement les résultats de laboratoire.

- Revoir les changements de taille de bundle dans les PRs pour attraper tôt le « juste une dépendance de plus ».

Quand la vitesse est traitée comme une fonctionnalité, on obtient une meilleure expérience utilisateur — et un rythme d’équipe plus rapide — sans transformer chaque release en gestion de crise performance.

Rendre mainstream : valeurs par défaut, templates et courbe d’apprentissage

La plupart des outils ne deviennent mainstream pas parce qu’ils sont les plus flexibles, mais parce qu’un nouvel utilisateur peut réussir rapidement.

Comment choisissent les builders mainstream

Les builders mainstream (petites équipes, agences, développeurs produit sans expertise infra profonde) évaluent les plateformes avec des questions simples :

- Peut-on livrer un site réel cette semaine ?

- Sera-t-il rapide par défaut ?

- Peut-on le changer en toute sécurité plus tard ?

C’est là que templates, docs claires et workflows « happy path » comptent. Un template qui se déploie en minutes et montre routing, data fetching et authentification convainc souvent plus qu’une matrice de fonctionnalités.

Une documentation qui montre une approche recommandée (et explique quand s’en écarter) réduit le temps passé à tâtonner.

Pourquoi des valeurs par défaut sensées l’emportent sur une infinité d’options

Une longue liste d’options peut sembler puissante, mais elle force chaque équipe à devenir experte juste pour prendre des décisions basiques. Des valeurs par défaut sensées réduisent la charge cognitive :

- bon comportement de cache par défaut

- une approche de rendu recommandée par type de page

- gestion sûre des variables d’environnement

- étapes de build/déploiement standards qui demandent rarement une personnalisation

Quand les valeurs par défaut sont pertinentes, les équipes se concentrent sur le produit plutôt que la configuration.

Besoins courants que les templates devraient couvrir

Les builders réels commencent souvent par des patterns familiers :

- E‑commerce : pages produit, recherche, intégrations checkout, SEO

- Sites de contenu : pages pilotées par CMS, previews, optimisation d’images

- Dashboards : auth, accès par rôle, navigation rapide, pages riches en API

Les meilleurs templates n’« ont pas juste l’air bien » — ils encodent une structure éprouvée.

Pièges pour les débutants

Deux erreurs reviennent souvent :

- Sur‑ingénierie trop tôt : ajouter de la logique edge, du cache complexe ou des couches de données multiples avant que le trafic ne le justifie.

- Confusion sur les choix de rendu : mélanger SSR/SSG/CSR sans raison claire, menant à des pages lentes ou des builds fragiles.

Une bonne courbe d’apprentissage pousse les équipes vers un point de départ clair et rend les choix avancés des mises à niveau délibérées, pas du travail obligatoire.

Productisation au‑delà du déploiement : construire des apps à partir d’une intention

Les plateformes de déploiement ont productisé le chemin Git → production. Une tendance parallèle émerge en amont : productiser le chemin de l’idée au code fonctionnel.

Koder.ai est un exemple de cette direction « vibe‑coding » : vous décrivez ce que vous voulez via une interface de chat et la plateforme utilise des agents LLM pour générer et itérer une application réelle. Cible web, serveur et mobile (React en frontend, Go + PostgreSQL en backend, Flutter pour le mobile), avec des fonctionnalités pratiques comme export de code, déploiement/hébergement, domaines personnalisés, snapshots et rollback.

En pratique, cela s’accorde naturellement avec le flux décrit ici : resserrer la boucle intention → implémentation → URL d’aperçu → production, tout en gardant une porte de sortie (code exportable) quand vous dépassez les valeurs par défaut.

Gardez une voie de sortie

Conservez le contrôle en exportant le code source quand vous devez migrer ou personnaliser plus tard.

Choisir une plateforme frontend, ce n’est pas seulement choisir « où héberger ». C’est choisir le flux de travail par défaut dans lequel votre équipe vivra : comment le code devient une URL, comment les changements sont revus et comment les incidents sont gérés.

1) Modèle de coût : ce que vous payez réellement

La plupart des plateformes se ressemblent sur la page d’accueil, puis divergent dans les détails de facturation. Comparez les unités qui correspondent à votre usage réel :

- Modèle tarifaire : forfaitaire vs usage, et ce qui est inclus à chaque niveau.

- Minutes de build : comment le temps CI/CD est compté, si les previews consomment le même quota et ce qui se passe en dépassement.

- Bande passante et requêtes : comment l’egress est facturé, si le trafic CDN est inclus et comment les pics sont gérés.

- Places équipe : qui compte comme utilisateur facturable (dévs, designers, contractuels) et s’il existe des rôles en lecture seule.

Astuce pratique : estimez les coûts pour un mois normal et pour une « semaine de lancement ». Si vous ne pouvez pas simuler les deux, la surprise arrivera au pire moment.

2) Fiabilité, régions et montée en charge

Vous n’avez pas besoin d’être expert infra, mais posez quelques questions directes :

- Où pouvez‑vous déployer (régions/locations edge) et pouvez‑vous contrôler cela ?

- Que se passe‑t‑il lors de pics de trafic — la plateforme bride, met en file ou échoue ?

- Comment les incidents sont‑ils communiqués ? Une page d’état publique existe‑t‑elle ?

- Quelle est l’histoire du rollback : en un clic, automatique ou manuelle ?

Si vos clients sont globaux, la couverture régionale et le comportement du cache peuvent compter autant que la performance brute.

3) Bases de sécurité non négociables

Cherchez des garanties opérationnelles quotidiennes plutôt que des promesses vagues :

- Gestion des secrets : stockage, rotation et portée des variables d’environnement (prod vs preview).

- Contrôle d’accès : permissions basées sur les rôles, support SSO et séparation entre projets.

- Trails d’audit : visibilité des déploiements, changements de config et qui a fait quoi.

4) Checklist légère de sélection

Utilisez ceci comme filtre rapide avant une évaluation approfondie :

- Peut‑on créer des déploiements d’aperçu pour chaque PR avec un minimum de configuration ?

- Supporte‑t‑elle nos besoins de rendu (statique, server rendering, fonctions edge) sans colle supplémentaire ?

- Logs, métriques et traçage d’erreurs sont‑ils faciles à trouver quand ça casse ?

- Peut‑on exporter/migrer plus tard sans réécrire l’app ?

Choisissez la plateforme qui réduit les « décisions de déploiement » que votre équipe doit prendre chaque semaine — tout en vous laissant assez de contrôle quand ça compte.

Conclusions : un playbook simple pour les équipes qui livrent sur le web

La productisation transforme les décisions de déploiement et de rendu d’un travail d’ingénierie sur‑mesure en valeurs par défaut répétables. Cela réduit la friction à deux endroits qui ralentissent habituellement les équipes : mettre des changements en ligne et garder la performance prévisible.

Quand le chemin commit → aperçu → production est standardisé, l’itération s’accélère parce que moins de releases dépendent d’un spécialiste (ou d’un après‑midi chanceux de debug).

Un plan de migration pratique (commencer petit, mesurer, étendre)

Commencez par la plus petite surface qui vous donne des retours :

- Ajoutez d’abord les déploiements d’aperçu. Traitez chaque pull request comme quelque chose de cliquable et révocable.

- Migrez une page ou une route vers une valeur par défaut du framework (par exemple, une page marketing en generation statique, ou une page authentifiée en rendu serveur) et comparez les résultats.

- Mesurez l’essentiel : temps de build, fréquence des déploiements, temps de rollback, Core Web Vitals et « temps de revue » pour les parties prenantes.

Une fois que ça marche, étendez progressivement :

- consolidez les environnements (preview/staging/prod) et définissez qui peut promouvoir.

- introduisez l’edge ou des fonctions serverless uniquement quand la latence ou la personnalisation le justifie.

- standardisez des templates pour que les nouveaux projets démarrent avec auth, analytics et patterns de cache fonctionnels.

Garder les chemins d’apprentissage légers

Si vous voulez approfondir sans vous perdre, parcourez patterns et études de cas sur /blog, puis vérifiez coûts et limites sur /pricing.

Si vous expérimentez des façons plus rapides d’aller des exigences à une base fonctionnelle (surtout pour les petites équipes), Koder.ai peut être un outil compagnon utile : générez une première version via chat, itérez rapidement avec les parties prenantes, puis conservez le même chemin productisé vers les aperçus, rollbacks et production.

Les plateformes intégrées optimisent la vitesse de livraison et réduisent les décisions opérationnelles. Le compromis est moins de contrôle bas‑niveau (infrastructure personnalisée, conformité spécifique, réseau sur‑mesure).

Choisissez la configuration « la plus productisée » qui répond encore à vos contraintes — et conservez un plan de sortie (architecture portable, étapes de build claires) pour que votre décision soit fondée sur la force, pas sur l’enfermement.