Pourquoi le multi-régional est important pour la résidence des données

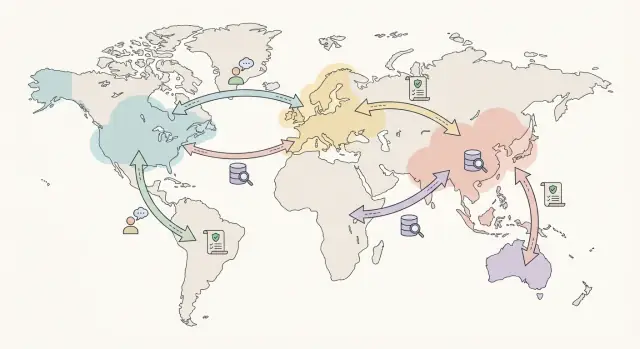

Les questions de résidence des données commencent souvent par une demande client simple : « Pouvez-vous garder nos données dans notre pays ? » Le problème, c’est que leurs utilisateurs, administrateurs et équipes de support peuvent être dispersés. L’hébergement multi-régional permet de répondre aux besoins locaux de stockage sans bloquer le travail quotidien.

Ce choix affecte trois décisions pratiques :

- Où les données sont stockées (bases de données, uploads, logs, sauvegardes)

- Où les données sont traitées (serveurs d’application, tâches en arrière-plan, analytics, fonctions IA)

- Qui peut y accéder (vos équipes, sous-traitants, opérateurs cloud) et depuis où

Si l’un de ces éléments se produit en dehors de la région convenue, vous pouvez encore avoir un transfert transfrontalier même si la base principale reste « locale ».

Les compromis à prévoir

Les architectures multi-régionales aident à la conformité, mais elles ont un coût. Vous échangez la simplicité contre le contrôle. Les coûts augmentent (plus d’infrastructure et de supervision). La complexité augmente aussi (réplication, basculement, configuration spécifique par région). Les performances peuvent aussi être affectées, car il faut parfois garder les requêtes et le traitement dans une région au lieu d’utiliser le serveur le plus proche dans le monde.

Un exemple courant : un client EU veut un stockage uniquement EU, mais la moitié de ses administrateurs est aux États-Unis. Si des admins US se connectent et exportent des données, cela pose des questions d’accès et de transfert. Une configuration propre précise ce qui reste dans l’UE, ce qui peut être accédé à distance et quelles protections s’appliquent.

Déclencheurs typiques qui lancent la discussion

La plupart des équipes revoient leurs régions d’hébergement quand l’un des éléments suivants apparaît :

- Les achats enterprise demandent un engagement de résidence dans les contrats et revues de sécurité

- Des industries régulées (santé, finance, éducation) exigent des contrôles et des pistes d’audit plus stricts

- Les charges du secteur public exigent un hébergement dans le pays ou des emplacements approuvés

- Des règles transfrontalières et politiques internes limitent où des données personnelles ou sensibles peuvent être stockées ou traitées

Termes clés : résidence, transferts, accès et traitement

La résidence des données est l’endroit où vos données sont stockées lorsqu’elles sont « au repos ». Pensez aux fichiers de base de données, au stockage objet et aux sauvegardes sur disques dans un pays ou une région cloud spécifique.

On confond souvent résidence, accès et transfert. L’accès concerne qui peut lire ou modifier les données (par exemple, un ingénieur support dans un autre pays). Le transfert concerne où les données voyagent (par exemple, un appel API traversant une frontière). Vous pouvez satisfaire des règles de résidence tout en violant des règles de transfert si des données sont régulièrement envoyées vers une autre région pour analytics, monitoring ou support.

Le traitement, c’est ce que vous faites avec les données : les stocker, les indexer, les rechercher, entraîner des modèles ou générer des rapports. Le traitement peut se dérouler ailleurs que le stockage, donc les équipes compliance demandent généralement les deux.

Pour rendre ces discussions concrètes, regroupez vos données en quelques catégories courantes : contenu client (fichiers, messages, uploads), données de compte et facturation, métadonnées (ID, timestamps, config), données opérationnelles (logs et événements de sécurité) et données de récupération (sauvegardes et réplicas).

Lors des revues, on vous demandera presque toujours deux choses : où chaque catégorie est stockée et où elle peut être envoyée. Les clients peuvent aussi demander comment l’accès humain est contrôlé.

Un exemple pratique : votre base principale est en Allemagne (stockage), mais votre suivi d’erreurs est aux États-Unis (transfert). Même si le contenu client ne quitte jamais l’Allemagne, les logs peuvent inclure des IDs utilisateurs ou des extraits de payloads qui partent. C’est pourquoi les logs et analytics méritent leur propre ligne dans la documentation.

Quand vous documentez cela, visez à répondre :

- Où se trouvent le stockage primaire et les sauvegardes ?

- Quels services reçoivent des copies (CDN, analytics, monitoring, email) ?

- Qui peut accéder aux données, depuis où et sous quelle approbation ?

- Quel traitement a lieu en dehors de la région de résidence, le cas échéant ?

- Quelle est la durée de rétention pour chaque type de données ?

Des termes clairs en amont font gagner du temps, surtout quand les clients veulent une explication simple et confiante.

Commencez par un inventaire simple des données et systèmes

Avant de choisir les régions, notez quelles données vous avez et où elles touchent votre stack. Cela paraît basique, mais c’est le moyen le plus rapide d’éviter les surprises du type « on pensait que c’était resté en région ».

Commencez par les types de données, pas par les lois. La plupart des produits gèrent un mélange : informations de compte client (PII), enregistrements de paiement (souvent tokenisés mais sensibles), conversations support, et télémétrie produit comme les logs et événements. Incluez aussi les données dérivées, comme les tableaux analytics et résumés générés par l’IA.

Ensuite, listez chaque système qui peut voir ou stocker ces données. Cela inclut généralement serveurs applicatifs, bases de données, stockage objet pour uploads, fournisseurs d’email/SMS, monitoring d’erreurs, outils support client et consoles CI/CD ou admin. Si vous utilisez des snapshots, sauvegardes ou exports, traitez-les comme des stockages séparés.

Capturez le cycle de vie en langage clair : comment les données sont collectées, où elles sont stockées, quel traitement a lieu (recherche, facturation, modération), avec qui elles sont partagées (fournisseurs, équipes internes), combien de temps elles sont conservées, et comment la suppression fonctionne réellement (y compris les sauvegardes).

Gardez l’inventaire utilisable. Une petite checklist suffit souvent : type de données, système, région (stockage et traitement), ce qui déclenche un mouvement (action utilisateur, job en arrière-plan, demande support) et rétention.

Cartographiez les flux de données avant de choisir les régions

Avant de choisir des emplacements, il vous faut une image simple d’où les données vont réellement. La planification des régions peut échouer sur la seule base de la paperasse si vous ne pouvez pas expliquer le chemin des données personnelles à un client ou un auditeur.

Commencez par un diagramme en langage clair. Une page suffit. Écrivez-le comme une histoire : un utilisateur se connecte, utilise l’app, les données sont stockées et les systèmes de support enregistrent ce qui s’est passé. Puis étiquetez chaque étape avec deux choses : où cela s’exécute (région ou pays) et si les données sont au repos (stockées) ou en transit (en mouvement).

Ne vous arrêtez pas au chemin heureux. Les flux qui surprennent sont opérationnels : un ingénieur support ouvrant un ticket avec une capture d’écran, une session de réponse à incident avec accès temporaire, une restauration de base depuis des sauvegardes, ou un export pour un client.

Une façon rapide de garder la carte honnête : couvrir :

- Le trafic applicatif et ce qui est loggé

- Le stockage primaire plus sauvegardes et snapshots

- L’observabilité (logs, traces, rapports d’erreurs) et la rétention

- L’accès humain (support, outils admin, réponse à incident) et les approbations

- Les mouvements de données (exports, imports, restaurations, réplication)

Ajoutez les tiers, même s’ils semblent mineurs. Paiements, envoi d’emails, analytics et outils de support traitent souvent des identifiants. Notez quelles données ils reçoivent, où ils les traitent et si vous pouvez choisir leur région.

Une fois la carte claire, le choix des régions devient un appariement, pas une conjecture.

Piloter le multi-régional plus vite

Lancez une application pilote et testez vos choix de régions sans gros développement en amont.

Commencez par la règle, pas par la carte cloud. Demandez ce que vos clients ou régulateurs exigent réellement : quel pays (ou ensemble de pays) doit voir les données rester, quels emplacements sont explicitement interdits, et s’il existe des exceptions étroites (par exemple, accès support depuis un autre pays).

Une décision clé est la stricteté de la frontière. Certains programmes exigent un pays unique : stockage, sauvegardes et accès admin restent dans ce pays. D’autres acceptent une zone plus large (par exemple une zone économique définie) tant que vous pouvez montrer où les données sont stockées et qui peut y accéder.

Checklist pratique

Avant de vous engager, validez chaque région candidate par rapport aux contraintes réelles :

- Adéquation résidence : la région est-elle dans la zone autorisée, et y a-t-il des dépendances hors de cette zone (monitoring, logging, email, analytics) ?

- Adéquation services : les services managés dont vous avez besoin sont-ils disponibles (base de données, stockage objet, load balancers, gestion de clés, réseau privé) ?

- Contrôles de données : pouvez-vous garder les clés de chiffrement en région, limiter l’accès admin et prouver où vivent les sauvegardes et snapshots ?

- Plan de résilience : pouvez-vous basculer sans sortir la frontière autorisée ?

- Réalité opérationnelle : votre équipe peut-elle l’opérer sans que « tout le monde ait besoin d’accès production depuis n’importe où » devienne la norme ?

La proximité compte toujours, mais elle vient en second. Choisissez la région conforme la plus proche de vos utilisateurs pour la performance. Gérez ensuite l’exploitation par des processus et contrôles d’accès (RBAC, approbations, comptes break-glass) plutôt qu’en déplaçant les données vers l’endroit le plus simple à gérer.

Enfin, consignez la décision : la frontière autorisée, les régions sélectionnées, le plan de basculement et quelles données peuvent sortir (si applicables). Cette page unique vous fera gagner des heures sur les questionnaires.

Garder la latence raisonnable sans violer la résidence

La latence dépend surtout de la physique et du nombre d’allers-retours. La distance compte, mais aussi les tours de base de données, le routage réseau et les démarrages lents quand des services s’échèlonnent.

Commencez par mesurer avant de tout changer. Choisissez 3 à 5 actions utilisateur clés (login, chargement du tableau de bord, création d’une commande, recherche, export) et suivez p50 et p95 depuis les géographies qui comptent. Conservez ces chiffres pour comparer entre versions.

Une règle simple : gardez les données protégées et les chemins qui les touchent locaux, puis rendez tout le reste convivial pour le monde entier. Les plus gros gains de performance viennent généralement de la réduction des échanges inter-régions.

Garder les chemins de lecture/écriture locaux

Si un utilisateur en Allemagne a des données qui doivent rester dans l’UE, visez à garder le serveur applicatif, la base de données primaire et les jobs en arrière-plan pour ce tenant dans l’UE. Évitez de renvoyer les contrôles d’auth/session vers une autre région à chaque requête. Réduisez les APIs bavardes en diminuant le nombre d’appels base de données par page.

Le cache aide, mais attention à son emplacement. Mettez en cache du contenu public ou non sensible globalement. Gardez le cache spécifique au tenant ou régulé dans la région autorisée. Le traitement par lots peut aussi aider : une mise à jour planifiée vaut mieux que des dizaines de petites requêtes inter-régions.

Fixer des cibles et séparer le « rapide » du « tolérable »

Tout n’a pas besoin de la même réactivité. Traitez la connexion et les actions de sauvegarde essentielles comme « doivent sembler instantanées ». Les rapports, exports et analytics peuvent être plus lents si vous l’avez défini ainsi.

Les assets statiques sont souvent la victoire la plus facile. Servez bundles JavaScript et images proches des utilisateurs via une distribution globale, tout en gardant les APIs et les données personnelles dans la région de résidence.

Modèles d’architecture efficaces pour les configurations multi-régionales

Le point de départ le plus sûr est une conception qui ancre clairement les données clients dans une région, tout en vous donnant un moyen de récupérer en cas de panne.

Active-passive vs active-active

L’active-passive est généralement plus simple à expliquer aux auditeurs et clients. Une région est primaire pour un tenant, et une région secondaire n’est utilisée qu’en basculement ou en DR contrôlée.

L’active-active peut réduire les temps d’indisponibilité et améliorer la latence locale, mais cela soulève des questions difficiles : quelle région est la source de vérité, comment empêcher la dérive, et la réplication elle-même compte-t-elle comme un transfert ?

Un moyen pratique de choisir :

- Utilisez active-passive quand les règles de résidence sont strictes, que votre équipe est petite ou que le volume d’écritures est élevé.

- Utilisez active-active seulement si vous en avez réellement besoin et si votre modèle de données peut gérer les conflits ou la forte cohérence.

- Si les clients sont répartis sur de nombreux pays, envisagez « active par tenant » (chaque tenant actif dans une région) au lieu d’un système global active-active.

Options de placement des données

Pour les bases, des bases régionales par tenant sont les plus simples à raisonner : les données d’un tenant vivent dans une instance Postgres régionale, avec des contrôles qui rendent difficiles les requêtes cross-tenant.

Si vous avez beaucoup de petits tenants, la partition peut fonctionner, mais seulement si vous pouvez garantir que les partitions ne quittent jamais la région et que vos outils ne lancent pas accidentellement de requêtes inter-régions. Le sharding par tenant ou géographie est souvent un compromis viable.

Les sauvegardes et DR nécessitent une règle explicite. Si les sauvegardes restent en région, les restaurations sont plus faciles à justifier. Si vous copiez des sauvegardes dans une autre région, documentez la base légale, le chiffrement, l’emplacement des clés et qui peut déclencher une restauration.

Les logs et l’observabilité sont là où les transferts accidentels arrivent le plus souvent. Les métriques peuvent souvent être centralisées si elles sont agrégées et à faible risque. Les logs bruts, traces et payloads d’erreur peuvent contenir des données personnelles : gardez-les régionaux ou redactez-les fortement.

Plan de déploiement étape par étape (du pilote à la production)

Faire participer votre équipe

Utilisez des parrainages pour intégrer vos coéquipiers et construire votre pilote de résidence ensemble.

Considérez un basculement multi-régional comme une sortie produit, pas comme un changement d’infrastructure en tâche de fond. Vous voulez des décisions écrites, un petit pilote et des preuves à montrer en revue.

1) Verrouiller les exigences par écrit

Capturez les règles à respecter : emplacements autorisés, types de données dans le périmètre et ce qu’est le « bon » résultat. Incluez des critères de succès comme la latence acceptable, les objectifs de reprise et ce qui compte comme accès transfrontalier approuvé (par exemple, connexions support).

2) Définir le choix de région et le routage des tenants

Décidez comment chaque client est placé dans une région et comment cette décision est appliquée. Gardez-le simple : nouveaux tenants par défaut, tenants existants avec une affectation explicite, exceptions sous approbation. Assurez-vous que le routage couvre le trafic applicatif, les jobs en arrière-plan et l’endroit où arrivent sauvegardes et logs.

3) Construire des environnements régionaux et migrer un pilote

Mettez en place la stack complète par région : app, base, secrets, monitoring et sauvegardes. Migrez ensuite un tenant pilote de bout en bout, y compris les données historiques. Prenez un snapshot avant la migration pour pouvoir revenir proprement.

Exécutez des tests reproduisant une utilisation réelle et conservez les résultats :

- Latence depuis les principaux emplacements utilisateurs

- Comportement de basculement et attentes de cohérence des données

- Revue des accès admin et support (qui peut accéder à quoi, depuis où)

- Alertes et journaux d’audit sur lesquels vous vous appuierez en incident

- Une courte checklist « questions clients » avec des réponses claires

5) Déployer progressivement avec un plan de rollback

Déplacez les tenants par petits lots, tenez un changelog et surveillez taux d’erreurs et volume de support. Pour chaque migration, ayez un déclencheur de rollback pré-approuvé (par exemple, augmentation d’erreurs pendant 15 minutes) et une procédure de retour pratiquée.

Documentation utile pour audits et questions clients

Une bonne conception d’hébergement peut encore échouer à une revue de conformité si vous ne savez pas l’expliquer clairement. Considérez la documentation comme partie du système : courte, précise et facile à tenir à jour.

Commencez par un résumé d’une page qu’un non-technique peut lire rapidement. Indiquez quelles données doivent rester en région, ce qui peut sortir et pourquoi (facturation, envoi d’emails, détection de menaces, etc.). Énoncez votre position par défaut clairement : le contenu client reste en région sauf exception documentée.

Ensuite, maintenez deux artefacts supports à jour :

- Un diagramme de flux de données montrant systèmes et flèches pour les mouvements, y compris accès admin et support

- Un tableau listant système, type de données, région, rétention, qui peut y accéder et si c’est chiffré

Ajoutez une note opérationnelle courte couvrant sauvegardes et restaurations (où vivent les sauvegardes, rétention, qui peut déclencher une restauration) et un processus d’accès incident/support (approbations, journalisation, accès limité dans le temps et notification client si nécessaire).

Formulez les réponses prêtes pour un client. Un bon modèle : « Stocké en X, traité en Y, transferts contrôlés par Z. » Par exemple : « Le contenu généré par l’utilisateur est stocké dans la région EU. L’accès support nécessite une approbation par ticket et est journalisé. Les métriques agrégées peuvent être traitées hors de l’UE mais ne contiennent pas de contenu client. »

Conservez les preuves à portée : captures d’écran de configuration régionale, paramètres clés d’environnement et un petit extrait des logs d’audit montrant approbations d’accès et contrôles de trafic inter-régions.

Erreurs courantes et pièges à éviter

Déployer avec une intention de région

Déployez votre stack et vérifiez en pratique où les données sont stockées et traitées.

La plupart des problèmes ne viennent pas de la base principale, mais des éléments autour : observabilité, sauvegardes et accès humain. Ces lacunes sont aussi ce que clients et auditeurs demandent en premier.

Un piège courant est de traiter logs, métriques et traces comme inoffensifs et de les laisser partir vers une région globale par défaut. Ces enregistrements contiennent souvent des IDs utilisateurs, des IP ou des extraits de requêtes. Si les données applicatives doivent rester dans le pays, vos données d’observabilité doivent généralement suivre la même règle ou être fortement redactées.

Un autre oubli fréquent concerne les sauvegardes et copies DR. Les équipes se basent sur l’endroit où tourne la production, puis oublient snapshots, réplicas et tests de restauration. Si vous gardez un primaire EU et une sauvegarde US « au cas où », vous avez créé un transfert. Assurez-vous que l’emplacement des sauvegardes, les durées de rétention et le processus de restauration correspondent à vos promesses.

L’accès est un point faible suivant. Des comptes admin globaux sans contrôles stricts peuvent briser la résidence en pratique, même si le stockage est correct. Utilisez le principe du moindre privilège, des accès limités par région quand c’est possible, et des journaux d’audit montrant qui a accédé à quoi et depuis où.

D’autres problèmes fréquents : mélanger des tenants avec des besoins de résidence différents dans la même base ou index de recherche, construire des architectures active-active trop tôt avant de pouvoir les opérer, et traiter le « multi-régional » comme un slogan plutôt que comme des règles appliquées.

Vérifications rapides et prochaines étapes

Avant de déclarer votre configuration « terminée », faites une passe rapide couvrant conformité et performances réelles. Vous devez pouvoir répondre à deux questions avec assurance : où vivent les données régulées et que se passe-t-il en cas d’incident.

Vérifications rapides

Assurez-vous que chaque décision renvoie à votre inventaire et à votre carte de flux :

- Vous pouvez pointer vers un inventaire clair : quelles données vous stockez, où et qui peut y accéder.

- Vos flux de données sont cartographiés bout à bout (app, base, logs, analytics, outils support) et vous pouvez expliquer chaque transfert inter-régions.

- Les régions sont choisies selon des critères écrits (exigence légale, contrat, besoin opérationnel), pas seulement la proximité.

- Les cibles de latence sont mesurées en usage réel, pas estimées.

- Le basculement est testé et vous avez confirmé où vivent sauvegardes et snapshots.

Si vous ne pouvez pas répondre à « le support consulte-t-il la production, et depuis où ? », vous n’êtes pas prêt pour un questionnaire client. Documentez le processus d’accès support (rôles, approbation, limites temporelles, journalisation) pour qu’il soit reproductible.

Prochaines étapes

Choisissez un profil client et lancez un petit pilote avant un déploiement large. Choisissez un profil courant avec des règles de résidence claires (par exemple « client EU avec stockage exclusivement EU »). Collectez des preuves réutilisables : réglages de région, logs d’accès et résultats de tests de basculement.

Si vous voulez itérer plus vite sur les déploiements et le choix des régions, Koder.ai (koder.ai) est une plateforme vibe-coding qui peut construire et déployer des apps depuis le chat et propose des fonctionnalités de déploiement/hébergement comme l’export du code source et des snapshots/rollback, utiles pour tester des changements et récupérer rapidement lors de mouvements de région.