12 nov. 2025·7 min

D'un laboratoire à but non lucratif au leader de l'IA : l'histoire d'OpenAI

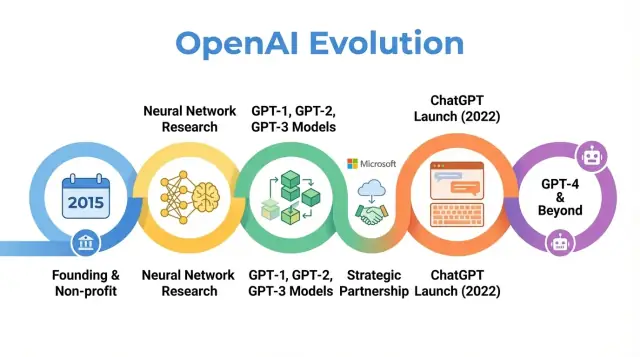

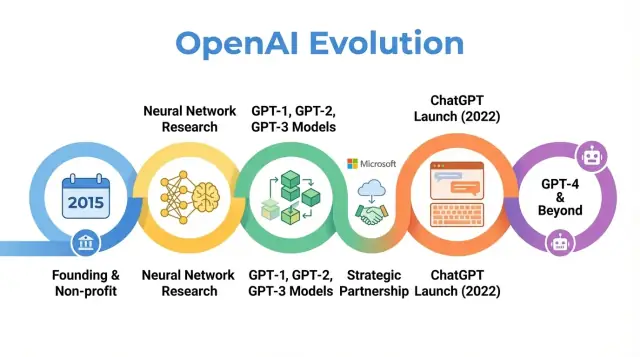

Explorez l'histoire d'OpenAI, de ses origines non lucratives et ses jalons de recherche à la mise en ligne de ChatGPT, GPT‑4 et l'évolution de sa mission.

Explorez l'histoire d'OpenAI, de ses origines non lucratives et ses jalons de recherche à la mise en ligne de ChatGPT, GPT‑4 et l'évolution de sa mission.

OpenAI est une entreprise de recherche et de déploiement en IA dont le travail a façonné la manière dont on pense l'intelligence artificielle, des premiers articles de recherche aux produits comme ChatGPT. Comprendre comment OpenAI a évolué — d'un petit laboratoire à but non lucratif en 2015 à un acteur central de l'IA — aide à expliquer pourquoi l'IA moderne prend la forme qu'on connaît aujourd'hui.

L'histoire d'OpenAI n'est pas seulement une suite de sorties de modèles. C'est une étude de cas sur la façon dont mission, incitations, percées techniques et pression publique interagissent. L'organisation a démarré avec un fort accent sur la recherche ouverte et le bénéfice large, puis s'est restructurée pour attirer des capitaux, a formé un partenariat profond avec Microsoft et a lancé des produits utilisés par des centaines de millions de personnes.

Retracer l'histoire d'OpenAI éclaire plusieurs tendances plus larges dans l'IA :

Mission et valeurs : OpenAI a été fondée avec l'objectif déclaré de s'assurer que l'AGI bénéficie à toute l'humanité. La manière dont cette mission a été interprétée et révisée au fil du temps révèle les tensions entre objectifs idéalistes et réalités commerciales.

Percées de recherche : la progression des premiers projets à des systèmes comme GPT‑3, GPT‑4, DALL·E et Codex suit un mouvement plus large vers des modèles fondamentaux à grande échelle qui alimentent de nombreuses applications actuelles.

Gouvernance et structure : le passage d'une organisation purement à but non lucratif à une entité à profit plafonné, et la création de mécanismes de gouvernance complexes, montrent comment de nouvelles formes organisationnelles sont testées pour gérer des technologies puissantes.

Impact public et contrôle : avec ChatGPT et d'autres sorties, OpenAI est passée d'un laboratoire connu principalement dans les cercles de l'IA à un nom familier, attirant l'attention sur la sécurité, l'alignement et la régulation — des débats qui orientent désormais les politiques dans le monde entier.

Cet article suit le parcours d'OpenAI de 2015 à ses développements récents, montrant comment chaque phase reflète des changements plus larges en matière de recherche, d'économie et de gouvernance de l'IA — et ce que cela peut signifier pour l'avenir du domaine.

OpenAI a été fondée en décembre 2015, à un moment où l'apprentissage automatique — et en particulier le deep learning — progressait rapidement mais restait loin d'une intelligence générale. Les benchmarks de reconnaissance d'images tombaient, les systèmes vocaux s'amélioraient et des entreprises comme Google, Facebook et Baidu investissaient massivement dans l'IA.

Une inquiétude croissante parmi chercheurs et dirigeants tech était que des IA avancées puissent finir contrôlées par une poignée de grandes entreprises ou d'États. OpenAI a été conçue comme un contrepoids : une organisation de recherche axée sur la sécurité à long terme et la large distribution des bénéfices de l'IA, plutôt que sur un avantage commercial étroit.

Dès le départ, OpenAI a défini sa mission en termes d'intelligence générale artificielle (AGI), pas seulement de progrès incrémental en apprentissage automatique. L'énoncé de base était qu'OpenAI travaillerait pour s'assurer que l'AGI, si elle est créée, « bénéficie à toute l'humanité ».

Cette mission impliquait plusieurs conséquences concrètes :

Les premiers billets de blog publics et la charte fondatrice insistaient à la fois sur l'ouverture et la prudence : OpenAI publierait une grande partie de son travail, mais se réserverait aussi la possibilité d'évaluer l'impact sociétal avant de diffuser des capacités puissantes.

OpenAI a commencé comme un laboratoire à but non lucratif. Les engagements de financement initiaux annoncés représentaient environ 1 milliard de dollars en promesses, bien qu'il s'agisse d'un engagement à long terme plutôt que d'une somme immédiatement disponible. Parmi les premiers soutiens figuraient Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston et YC Research, ainsi que le soutien de sociétés comme Amazon Web Services et Infosys.

L'équipe dirigeante initiale combinait expérience de startup, de recherche et d'exploitation :

Ce mélange d'entrepreneuriat de la Silicon Valley et de recherche de haut niveau a façonné la culture initiale d'OpenAI : très ambitieuse pour repousser la frontière des capacités IA, mais organisée comme un organisme à mission visant un impact mondial à long terme plutôt qu'une commercialisation à court terme.

À son lancement en 2015, la promesse publique d'OpenAI était simple mais ambitieuse : faire progresser l'intelligence artificielle tout en partageant autant que possible avec la communauté.

Les premières années ont été marquées par une philosophie « ouvert par défaut ». Les articles de recherche étaient publiés rapidement, le code était généralement rendu public et des outils internes devenaient des projets publics. L'idée était que l'accélération du progrès scientifique et la possibilité d'un examen large seraient plus sûres et plus bénéfiques que la concentration des capacités au sein d'une seule entreprise.

En même temps, la sécurité faisait déjà partie de la conversation. L'équipe discutait des moments où l'ouverture pourrait augmenter les risques d'abus et commençait à esquisser des idées de diffusion échelonnée et de revues politiques, même si ces idées restaient alors plus informelles qu'ultérieurement.

Les premiers travaux scientifiques d'OpenAI couvraient plusieurs domaines :

Ces projets visaient moins des produits polis que la vérification de ce qui était possible avec le deep learning, la puissance de calcul et des régimes d'entraînement ingénieux.

Deux des sorties les plus influentes de cette époque furent OpenAI Gym et Universe.

Les deux projets reflétaient un engagement envers une infrastructure partagée plutôt que pour un avantage propriétaire.

Pendant cette période non lucrative, OpenAI était souvent présentée comme un contrepoids guidé par une mission face aux grands laboratoires d'entreprises. Les pairs appréciaient la qualité de sa recherche, la disponibilité du code et des environnements, et la volonté d'engager le débat sur la sécurité.

La couverture médiatique mettait en avant la combinaison inhabituelle de bailleurs de fonds de premier plan, d'une structure non commerciale et d'une promesse de publication ouverte. Cette réputation — en tant que laboratoire influent, ouvert et soucieux des conséquences à long terme — a créé des attentes qui allaient ensuite orienter les réactions à chaque changement stratégique de l'organisation.

Le tournant dans l'histoire d'OpenAI a été la décision de se concentrer sur de grands modèles de langage basés sur des transformers. Ce virage a transformé OpenAI d'un laboratoire principalement axé sur la recherche en une entreprise reconnue pour ses modèles fondamentaux sur lesquels d'autres construisent.

GPT‑1 était modeste par rapport aux standards ultérieurs — 117 millions de paramètres, entraîné sur BookCorpus — mais il a offert une preuve de concept cruciale.

Plutôt que d'entraîner des modèles séparés pour chaque tâche de PNL, GPT‑1 a montré qu'un seul modèle transformer, entraîné avec un objectif simple (prédire le mot suivant), pouvait être adapté avec un minimum d'ajustement pour des tâches comme la question‑réponse, l'analyse de sentiment et l'inférence textuelle.

Pour la feuille de route interne d'OpenAI, GPT‑1 a validé trois idées :

GPT‑2 a poussé la même recette beaucoup plus loin : 1,5 milliard de paramètres et un corpus web nettement plus vaste. Ses sorties étaient souvent étonnamment cohérentes : articles de plusieurs paragraphes, fictions et résumés ressemblant à du texte humain.

Ces capacités ont soulevé des alarmes sur les usages potentiellement malveillants : propagande automatisée, spam, harcèlement et fausses nouvelles à grande échelle. Plutôt que de publier immédiatement le modèle complet, OpenAI a adopté une stratégie de diffusion échelonnée :

Ce fut l'un des premiers exemples publics d'OpenAI liant explicitement les décisions de déploiement à la sécurité et à l'impact social, et cela a façonné la manière dont l'organisation envisage diffusion, ouverture et responsabilité.

GPT‑3 a encore augmenté l'échelle — cette fois à 175 milliards de paramètres. Plutôt que de s'appuyer principalement sur le fine‑tuning pour chaque tâche, GPT‑3 a démontré le « few‑shot » et même le « zero‑shot » : le modèle pouvait souvent accomplir une nouvelle tâche simplement à partir d'instructions et de quelques exemples dans le prompt.

Ce niveau de généralité a changé la façon dont OpenAI et l'industrie envisageaient les systèmes IA. Plutôt que de construire de nombreux modèles étroits, un grand modèle pouvait servir de moteur polyvalent pour :

Crucialement, OpenAI a choisi de ne pas open‑sourcer GPT‑3. L'accès a été proposé via une API commerciale. Cette décision a marqué un pivot stratégique :

GPT‑1, GPT‑2 et GPT‑3 tracent un arc clair dans l'histoire d'OpenAI : montée en puissance des transformers, découverte de capacités émergentes, lutte avec la sécurité et les abus, et établissement des bases commerciales qui soutiendraient ensuite des produits comme ChatGPT et le développement continu de GPT‑4 et au‑delà.

Dès 2018, les dirigeants d'OpenAI étaient convaincus que rester un petit laboratoire financé par des dons ne suffirait pas pour construire et encadrer en toute sécurité des systèmes d'IA très larges. L'entraînement de modèles de pointe nécessitait déjà des dizaines de millions de dollars de calcul et de talent, avec des courbes de coûts pointant nettement plus haut. Pour attirer les meilleurs chercheurs, mener des expériences à grande échelle et garantir un accès à long terme aux infrastructures cloud, OpenAI avait besoin d'une structure capable d'attirer des capitaux sérieux sans abandonner sa mission d'origine.

En 2019, OpenAI a lancé OpenAI LP, un nouveau partenariat limité à « profit plafonné ». L'objectif était de débloquer des investissements externes importants tout en gardant l'organisme à but non lucratif — chargé d'assurer que l'AGI bénéficie à l'humanité — au sommet de la hiérarchie décisionnelle.

Les startups traditionnelles soutenues par du capital‑risque sont ultimement redevables à des actionnaires recherchant des rendements illimités. Les fondateurs d'OpenAI craignaient que cela n'exerce une forte pression pour privilégier le profit au détriment de la sécurité, de l'ouverture ou d'un déploiement prudent. La structure LP était un compromis : elle pouvait émettre des intérêts semblables à des actions et lever des fonds à grande échelle, mais sous des règles différentes.

Dans ce modèle, les investisseurs et employés peuvent obtenir des rendements sur leurs participations, mais seulement jusqu'à un multiple fixe de leur investissement initial (pour les premiers investisseurs, souvent cité jusqu'à 100x, avec des plafonds plus faibles pour les tranches ultérieures). Une fois ce plafond atteint, toute valeur supplémentaire créée est censée revenir à l'entité à but non lucratif pour être utilisée conformément à sa mission.

Cela contraste fortement avec les startups classiques, où la valeur des actions peut croître sans limite et où la maximisation de la valeur pour les actionnaires est la norme légale et culturelle.

La structure conserve le contrôle formel :

Ce design de gouvernance vise à donner à OpenAI la flexibilité de financement et d'embauche d'une organisation commerciale tout en maintenant un contrôle axé sur la mission.

La restructuration a suscité des débats internes et externes. Les partisans ont soutenu que c'était la seule manière pratique d'obtenir les milliards nécessaires pour la recherche de pointe tout en restreignant les incitations au profit. Les critiques ont remis en question si une structure offrant de larges rendements pouvait vraiment résister à la pression commerciale, et si les plafonds étaient suffisamment bas ou correctement appliqués.

Pratiquement, OpenAI LP a ouvert la porte à d'importants investissements stratégiques, notamment de Microsoft, et a permis à l'entreprise d'offrir des packages de rémunération compétitifs liés au potentiel de rendement. Cela a permis d'agrandir les équipes de recherche, d'étendre les entraînements de modèles comme GPT‑3 et GPT‑4, et de construire l'infrastructure nécessaire pour déployer des systèmes tels que ChatGPT à l'échelle mondiale — tout en maintenant un lien formel de gouvernance vers ses origines non lucratives.

En 2019, OpenAI et Microsoft ont annoncé un partenariat pluriannuel qui a remodelé le rôle des deux entreprises dans l'IA. Microsoft a investi un montant rapporté d'environ 1 milliard de dollars, combinant liquidités et crédits Azure, en échange du statut de partenaire commercial privilégié.

L'accord répondait au besoin d'OpenAI de ressources massives de calcul pour entraîner des modèles de plus en plus grands, tout en donnant à Microsoft l'accès à une IA de pointe susceptible de différencier ses produits et sa plateforme cloud. Au fil des années, la relation s'est approfondie via des financements supplémentaires et une collaboration technique accrue.

OpenAI a choisi Microsoft Azure comme plateforme cloud principale pour plusieurs raisons :

Cela a fait d'Azure l'environnement par défaut pour l'entraînement et la mise en service de modèles comme GPT‑3, Codex et plus tard GPT‑4.

Le partenariat a conduit à l'un des plus grands systèmes superinformatiques au monde, construit sur Azure pour les charges d'OpenAI. Microsoft a mis en avant ces clusters comme exemples phares des capacités IA d'Azure, tandis qu'OpenAI s'en est appuyé pour pousser la taille des modèles, les données d'entraînement et la vitesse d'expérimentation.

Cet effort d'infrastructure conjoint a estompé la ligne entre « client » et « partenaire » : OpenAI a influencé la feuille de route IA d'Azure, et Azure a été adapté aux besoins d'OpenAI.

Microsoft a obtenu des droits de licence exclusifs sur certaines technologies d'OpenAI, notamment GPT‑3. Cela a permis à Microsoft d'intégrer les modèles d'OpenAI dans ses produits — Bing, Office, GitHub Copilot, Azure OpenAI Service — tandis que d'autres entreprises y avaient accès via l'API d'OpenAI.

Cette exclusivité a alimenté le débat : certains y ont vu le financement et la distribution nécessaires pour développer l'IA de manière sûre ; d'autres ont craint que cela concentre l'influence sur les modèles de pointe entre les mains d'une seule grande entreprise.

Parallèlement, le partenariat a donné à OpenAI une visibilité grand public. Le branding de Microsoft, les intégrations produit et les canaux de vente entreprise ont aidé à faire passer les systèmes d'OpenAI de démonstrations de recherche à des outils quotidiens utilisés par des millions de personnes, façonnant la perception publique d'OpenAI comme un laboratoire indépendant et un partenaire clé de Microsoft.

OpenAI a été fondée en 2015 en tant que laboratoire de recherche à but non lucratif avec pour mission de s'assurer que l'intelligence générale artificielle (AGI), si elle est créée, bénéficie à toute l'humanité.

Plusieurs facteurs ont façonné sa création :

Cette genèse continue d'influencer la structure, les partenariats et les engagements publics d'OpenAI aujourd'hui.

AGI (artificial general intelligence) désigne des systèmes d'IA capables d'exécuter une large gamme de tâches cognitives à un niveau égal ou supérieur à celui des humains, et non de simples outils spécialisés.

La mission d'OpenAI est de :

Cette mission est formalisée dans la et guide les décisions majeures sur les orientations de recherche et le déploiement.

OpenAI est passée d'une organisation purement à but non lucratif à une structure en « partenariat à profit plafonné » (OpenAI LP) pour lever les capitaux importants nécessaires à la recherche de pointe en IA tout en essayant de maintenir sa mission au sommet de la hiérarchie.

Points clés :

C'est une expérimentation de gouvernance dont l'efficacité fait toujours débat.

Microsoft fournit à OpenAI une capacité de calcul massive via Azure et a investi des milliards de dollars dans l'entreprise.

Le partenariat inclut :

En retour, OpenAI obtient les ressources nécessaires pour entraîner et déployer des modèles de pointe à l'échelle mondiale, tandis que Microsoft accède à des capacités IA différenciées pour son écosystème.

La série GPT illustre une progression en termes d'échelle, de capacités et de stratégie de déploiement :

OpenAI a commencé avec une approche « ouverte par défaut » — publications, code et outils comme OpenAI Gym largement diffusés. À mesure que les modèles devenaient plus puissants, l'organisation a évolué vers :

OpenAI affirme que ces mesures sont nécessaires pour réduire les risques d'abus et gérer la sécurité. Les critiques estiment que cela contredit la promesse originelle implicite dans le nom « OpenAI » et concentre le pouvoir au sein d'une seule entreprise.

OpenAI utilise un mélange de structures organisationnelles et de méthodes techniques pour gérer la sécurité et les abus :

Ces mesures réduisent les risques mais n'éliminent pas des problèmes persistants comme les hallucinations, les biais ou les usages malveillants, qui restent des défis de recherche et de gouvernance.

ChatGPT, lancé fin 2022, a rendu les grands modèles de langage immédiatement accessibles au grand public via une interface de chat simple.

Il a transformé l'adoption de l'IA en :

Cette visibilité publique a aussi intensifié le contrôle et le débat sur la gouvernance, le modèle économique et les pratiques de sécurité d'OpenAI.

Les modèles d'OpenAI, en particulier Codex et GPT‑4, modifient déjà des pans du travail de la connaissance et de la création.

Bénéfices potentiels :

Risques et préoccupations :

Vous pouvez vous engager avec l'écosystème d'OpenAI de plusieurs manières :

Chaque étape a repoussé les limites techniques tout en imposant de nouvelles décisions sur la sécurité, l'accès et la commercialisation.

L'impact net dépendra largement des politiques publiques, des choix organisationnels et de la manière dont individus et entreprises intègrent l'IA à leur travail.

Dans tous les cas, il est utile de s'informer sur la formation et la gouvernance des modèles, et de demander plus de transparence, de responsabilité et d'accès équitable à mesure que ces systèmes gagnent en capacité.