Ce que signifie la rencontre des données et de l'économie physique

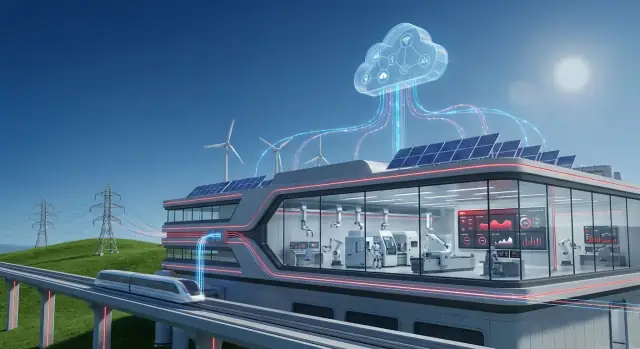

L’« économie physique » désigne la partie de l’activité qui déplace des atomes, pas seulement de l’information. C’est la centrale électrique qui équilibre l’offre et la demande, le réseau ferroviaire qui maintient les trains à l’heure, l’usine qui transforme des matières premières en produits finis, et la régie des eaux qui maintient pression et qualité dans une ville.

Dans ces environnements, le logiciel ne se contente pas de mesurer des clics ou des conversions : il influence du véritable équipement, de vraies personnes et de vrais coûts. Une décision de maintenance trop tardive peut devenir une panne. Une dérive de procédé mineure peut se transformer en rebut, arrêt de production ou incident de sécurité.

C’est pourquoi les données y ont une portée différente : elles doivent être opportunes, dignes de confiance et liées à ce qui se passe sur le terrain.

Pourquoi les données sont différentes quand on exploite des actifs

Quand votre « produit » est la disponibilité, le débit et la fiabilité, les données deviennent un outil pratique :

- Pour voir ce qui se passe réellement (vibrations, température, consommation d’énergie, temps de cycle)

- Pour prédire ce qui va probablement se produire (signes précoces de panne, formation de goulots d’étranglement)

- Pour choisir la meilleure action (envoyer une équipe, ralentir une ligne, rerouter l’énergie, recommander des pièces)

Mais il y a de véritables compromis. Vous ne pouvez pas arrêter une usine pour « mettre à jour plus tard ». Les capteurs peuvent être bruités. La connectivité n’est pas garantie. Et les décisions doivent souvent être explicables aux opérateurs, ingénieurs et régulateurs.

OT + IT : deux mondes qui doivent coopérer

C’est là que la convergence OT–IT prend tout son sens.

- OT (technologie opérationnelle) est le monde des machines : systèmes de contrôle, PLC, SCADA, instrumentation, et les pratiques de sécurité et de fiabilité qui stabilisent les opérations.

- IT (technologie de l’information) est le monde des systèmes métiers : ERP, registres d’actifs, gestion des services, analytics, gestion des identités et cybersécurité d’entreprise.

Quand OT et IT travaillent ensemble, les signaux opérationnels peuvent déclencher des workflows métiers — comme créer un ordre de travail, vérifier un stock, planifier des équipes et suivre les résultats.

Ce que couvre ce guide

Vous verrez où la valeur apparaît généralement (disponibilité, maintenance, efficacité énergétique), ce qu’il faut au niveau architectural (patterns edge-to-cloud) et ce à quoi il faut faire attention (sécurité, gouvernance et gestion du changement). L’objectif est une image claire et réaliste de la façon dont les données industrielles deviennent de meilleures décisions — pas seulement davantage de tableaux de bord.

Hitachi dans son contexte : racines industrielles et capacités logicielles

Hitachi se situe à une intersection de plus en plus importante pour les organisations modernes : les systèmes qui font fonctionner les opérations physiques (trains, réseaux électriques, usines, stations d’épuration) et les logiciels qui planifient, mesurent et améliorent ces opérations.

Ce background compte parce que les environnements industriels récompensent souvent l’ingénierie éprouvée, la longue durée de vie des actifs et les améliorations incrémentales stables — pas les changements rapides de plateforme.

Ce que recouvre la « technologie industrielle »

Quand on parle ici de « technologie industrielle », il s’agit généralement de la pile qui maintient les processus réels stables et sûrs :

- Équipements et actifs : moteurs, variateurs, matériel roulant, transformateurs, pompes, turbines et autres machines à longue durée de vie.

- Contrôles et automatisation : capteurs, contrôles de type PLC/SCADA, systèmes de sécurité et instrumentation qui informent les opérateurs.

- Pratiques d’ingénierie et d’exploitation : routines de maintenance, méthodes de fiabilité, mise en service et normes gouvernant la disponibilité et la sécurité.

Ce pan est lié à la physique, aux contraintes et aux conditions d’exploitation — chaleur, vibration, charge, usure et réalités du travail sur le terrain.

Ce que recouvre le « logiciel d’entreprise »

Le « logiciel d’entreprise » regroupe les systèmes qui transforment l’exploitation en décisions coordonnées et actions auditées à travers les équipes :

- Planification et finance (ERP) : budgets, achats, inventaire et visibilité des coûts.

- Gestion des actifs et de la maintenance (EAM/CMMS) : ordres de travail, pièces, inspections et historique du cycle de vie.

- Analytics et reporting : tableaux de bord, KPI et tendances de performance.

- Flux de travail et collaboration : approbations, suivi d’incidents et coordination interfonctionnelle.

L’histoire de Hitachi est pertinente car elle reflète un déplacement plus large : les entreprises industrielles veulent que les données opérationnelles circulent vers les workflows métiers sans perdre le contexte ni le contrôle. L’objectif n’est pas d’avoir « plus de données » pour elles-mêmes, mais un meilleur alignement entre ce qui se passe sur le terrain et la façon dont l’organisation planifie, maintient et améliore ses actifs dans le temps.

Des machines à l’insight : le parcours des données opérationnelles

Les sites industriels sont pleins de signaux décrivant ce qui se passe maintenant : températures qui dérivent, vibration qui augmente, qualité d’alimentation qui fluctue, débit qui ralentit, alarmes qui s’enchaînent. Usines, réseaux ferroviaires, mines et services publics génèrent ces signaux en continu parce que l’équipement physique doit être surveillé pour rester sûr, efficace et conforme.

Le défi n’est pas d’obtenir plus de données brutes, mais de transformer ces mesures en décisions auxquelles les gens font confiance.

D’où viennent réellement les données

La plupart des exploitations tirent d’un mélange de systèmes de contrôle temps réel et d’enregistrements métiers :

- Capteurs et compteurs sur pompes, turbines, moteurs, lignes et postes (pression, débit, courant, vibration, etc.)

- Systèmes PLC et SCADA qui commandent et supervisent les processus, souvent historisés dans un historian

- Journaux de maintenance et ordres de travail provenant d’outils EAM/CMMS (quoi est tombé en panne, quoi a été remplacé, combien de temps cela a pris)

- Données ERP comme ordres de production, inventaire, achats et centres de coût — utiles pour relier la performance à l’argent

Pris isolément, chaque source raconte une histoire partielle. Ensemble, elles peuvent expliquer pourquoi la performance change et quoi faire ensuite.

Ce qui foire sur le chemin de l’« insight »

Les données opérationnelles sont brouillonnes pour des raisons prévisibles. Les capteurs sont remplacés, les tags sont renommés et les réseaux perdent des paquets. Les problèmes courants incluent :

- Valeurs manquantes ou dupliquées (trous pendant les pannes, échantillons répétés après reconnexion)

- Tags et unités incohérents ("Temp_1" vs "TMP-01", °C vs °F, kW vs MW)

- Problèmes de synchronisation temporelle entre appareils et systèmes (une dérive de cinq minutes peut casser l’analyse cause-effet)

Si vous vous êtes déjà demandé pourquoi des tableaux de bord divergent, c’est souvent parce que les horodatages, les noms ou les unités ne correspondent pas.

Pourquoi le contexte prime sur le volume

Une mesure n’a de sens que si vous pouvez répondre : quel actif est-ce, où est-il, et dans quel état était-il ?

“Vibration = 8 mm/s” est bien plus exploitable lorsqu’elle est liée à la pompe P-204, sur la ligne 3, fonctionnant à 80 % de charge, après un changement de palier le mois dernier, pendant une production particulière.

Ce contexte — hiérarchie d’actifs, emplacement, mode d’exploitation et historique de maintenance — permet aux analytics de distinguer la variation normale des signes précurseurs.

Le parcours des données opérationnelles est essentiellement un mouvement de signaux → séries temporelles nettoyées → événements contextualisés → décisions, pour que les équipes passent de la réaction aux alarmes à la gestion délibérée de la performance.

Convergence OT–IT : relier deux mondes sans casser l’un ou l’autre

La technologie opérationnelle (OT) est ce qui fait tourner une opération physique : machines, capteurs, systèmes de contrôle et procédures qui maintiennent une usine, un réseau ferroviaire ou un poste électrique en fonctionnement sûr.

La technologie de l'information (IT) est ce qui fait fonctionner l’entreprise : ERP, finance, RH, achats, systèmes clients et réseaux/applications utilisés quotidiennement.

La convergence OT–IT consiste simplement à faire partager ces deux mondes les bonnes données au bon moment — sans mettre la production, la sécurité ou la conformité en péril.

Où la friction apparaît généralement

La plupart des problèmes ne sont pas d’abord techniques ; ils sont opérationnels.

- Propriété et incitations : les équipes OT sont mesurées sur la disponibilité et la sécurité. Les équipes IT sont mesurées sur la standardisation, le contrôle des coûts et la cybersécurité.

- Contrôle du changement : en OT, une « petite mise à jour » peut arrêter une ligne. En IT, des patchs fréquents sont la norme.

- Exigences de disponibilité : les systèmes OT peuvent tourner des années avec un minimum d’arrêt ; les fenêtres de maintenance sont rares et planifiées.

- Vocabulaires différents : OT parle d’alarmes, de PLC et de consignes ; IT parle de tickets, d’APIs et de gestion des identités.

Ce que l’intégration nécessite réellement

Pour rendre la convergence pratique, il vous faut typiquement quelques briques :

- Connecteurs et protocoles capables de lire les signaux OT en sécurité (souvent via des passerelles) et de les mapper en formats compatibles IT.

- APIs pour déplacer les données vers les applications d’entreprise (maintenance, inventaire, finance) et dans l’autre sens.

- Flux d’événements pour les moments « quelque chose vient de se produire » — par exemple un pic de vibration déclenchant un ordre de travail.

- Alignement des données de référence pour que tout le monde s’accorde sur ce qu’est un « actif », un « site » ou un « ordre de travail » entre systèmes.

Une voie plus sûre : commencer petit, prouver la valeur, puis étendre

Une approche pratique consiste à choisir un cas d’usage à forte valeur (par ex. maintenance prédictive d’un actif critique), connecter un jeu de données limité et se mettre d’accord sur des métriques de succès claires.

Quand le workflow est stable — qualité des données, alertes, approbations et sécurité — étendez aux autres actifs, puis aux autres sites. Cela rassure l’OT sur la fiabilité et le contrôle des changements tout en donnant à l’IT les standards et la visibilité nécessaires pour monter en charge.

Architecture edge-to-cloud en langage clair

Prototyper un tri de maintenance

Prototipez une file de tri de maintenance qui relie les alertes aux actions que votre équipe peut suivre.

Les systèmes industriels génèrent des signaux précieux — températures, vibration, consommation, débit — mais ils n’ont pas tous leur place au même endroit. “Edge-to-cloud” signifie simplement répartir le travail entre des calculateurs proches de l’équipement (edge) et des plateformes centralisées (cloud ou datacenter), en fonction des besoins opérationnels.

Pourquoi une partie du traitement reste près de l’équipement

Certaines décisions doivent se prendre en millisecondes ou secondes. Si un moteur surchauffe ou qu’un verrouillage de sécurité se déclenche, on ne peut pas attendre un aller-retour vers un serveur distant.

Le traitement en edge aide pour :

- Contrôle et alerting à faible latence : réponses rapides pour les alarmes, contrôles qualité et optimisation locale.

- Fiabilité en cas de coupure réseau : l’usine continue de tourner même si la connectivité est perdue.

- Économie de bande passante : filtrer et compresser des flux de capteurs haute fréquence avant d’envoyer des résumés en amont.

Les plateformes centralisées sont utiles quand la valeur dépend de la combinaison de données entre lignes, usines ou régions.

Les travaux typiques côté cloud comprennent :

- Analyses cross-site : comparaison de performance entre sites, identification des bonnes pratiques.

- Modèles au niveau flotte : améliorer la maintenance prédictive en apprenant de nombreux actifs similaires.

- Reporting et conformité : tableaux de bord standardisés pour dirigeants, auditeurs et équipes développement durable.

Un flux de référence simple (collecter → nettoyer → analyser → agir)

- Collecter : capteurs/PLC/SCADA envoient des données à une passerelle edge.

- Nettoyer : l’edge normalise unités, horodatages et tags ; il peut éliminer le bruit évident.

- Analyser : règles ou modèles rapides exécutés localement ; analyses plus lourdes centralement où plus de calcul et d’historique existent.

- Agir : les actions retournent sous forme d’alertes, d’ordres de travail ou de recommandations de consignes — souvent intégrées aux outils de maintenance et d’entreprise (par exemple via /blog/ot-it-convergence).

Principes de gouvernance : qui peut accéder à quelles données — et pourquoi

L’architecture, c’est aussi de la confiance. Une bonne gouvernance définit :

- Rôles et permissions : les opérateurs voient les données process en direct ; les ingénieurs fiabilité voient la santé des actifs ; les dirigeants voient les KPI.

- Propriété des données : qui approuve le partage de données entre sites ou avec des fournisseurs.

- Auditabilité : journaux de qui a accédé aux données et ce qui a changé.

Quand edge et cloud sont conçus ensemble, on obtient de la rapidité sur le plancher et de la cohérence à l’échelle de l’entreprise — sans forcer chaque décision à vivre au même endroit.

Le logiciel industriel crée la valeur la plus visible quand il relie le comportement des actifs à la réponse de l’organisation. Il ne suffit pas de savoir qu’une pompe se dégrade — il faut s’assurer que le bon travail soit planifié, approuvé, exécuté et capitalisé.

APM vs EAM (et pourquoi les deux comptent)

Asset Performance Management (APM) cible les résultats de fiabilité : surveiller l’état, détecter les anomalies, comprendre le risque et recommander des actions qui réduisent les pannes. Il répond à « Qu’est‑ce qui va probablement tomber en panne, quand, et que doit‑on faire ? »

Enterprise Asset Management (EAM) est le système de référence pour les opérations d’actifs et de maintenance : hiérarchies d’actifs, ordres de travail, main-d’œuvre, permis, inventaire et historique de conformité. Il répond à « Comment planifie‑t‑on, suive‑t‑on et contrôle‑t‑on le travail et les coûts ? »

Utilisés ensemble, l’APM peut prioriser les interventions justes, tandis que l’EAM s’assure qu’elles sont réalisées avec les contrôles appropriés — soutenant la fiabilité et un meilleur contrôle des coûts.

Maintenance prédictive qui se traduit sur le bilan

La maintenance prédictive devient significative quand elle produit des résultats mesurables tels que :

- Réduction des arrêts non planifiés (moins d’arrêts de ligne, moins d’appels d’urgence)

- Réduction des dépenses pièces de rechange (moins de stocks « au cas où », moins de commandes urgentes)

- Opérations plus sûres (détection précoce réduisant les pannes catastrophiques et les interventions risquées)

- Meilleure utilisation des actifs (maintenance alignée sur l’état, pas sur des conjectures)

Ce qu’il faut pour réussir

Les programmes qui fonctionnent démarrent généralement par des fondamentaux :

- Une liste claire de modes de défaillance pour les actifs critiques (ce qui casse réellement et comment)

- Baselines de performance et historique de maintenance (pour prouver l’amélioration)

- Processus de travail définis qui relient les alertes à l’action (triage, approbation, planification, clôture)

- Propriété : qui examine les insights, qui décide et qui exécute

Éviter le piège « seulement IA »

Analytics sans exécution reste un tableau de bord que personne ne croit. Si un modèle signale une usure de palier mais que personne ne crée d’ordre de travail, ne réserve pas de pièces ou ne capture les constats après réparation, le système ne peut pas apprendre — et l’entreprise ne verra pas le bénéfice.

Jumeaux numériques et simulation pour la prise de décision réelle

Un jumeau numérique se comprend mieux comme un modèle opérationnel d’un actif ou d’un procédé — construit pour répondre à des questions « et si ? » avant de modifier la réalité. Ce n’est pas une animation 3D pour la présentation (même si elle peut inclure des vues). C’est un outil de décision qui combine le comportement conçu avec le comportement réel.

Ce que vous pouvez simuler (et pourquoi c’est important)

Une fois le jumeau suffisamment fidèle, les équipes peuvent tester des options en sécurité :

- Débit et goulots d’étranglement : « Si on change la vitesse de ligne ou la taille des lots, où se déplacent les congestions ? »

- Consommation énergétique : « Quel est l’impact énergétique de faire fonctionner les pompes différemment, de décaler les plages ou de modifier les consignes ? »

- Usure et durée de vie restante : « Comment une charge plus élevée affecte‑t‑elle l’usure des paliers ou les intervalles de maintenance ? »

- Contraintes et arbitrages : « Peut‑on atteindre les objectifs de production sans dépasser des limites de température, seuils de vibration ou marges de sécurité ? »

C’est là que la simulation prend toute sa valeur : comparer des scénarios et choisir celui qui optimise production, coût, risque et conformité.

Ce dont un jumeau a besoin pour être crédible

Les jumeaux utiles combinent deux types de données :

- Données d’ingénierie : spécifications de conception, logique de contrôle, courbes d’équipement, modèles CAD/BIM, manuels de maintenance et contraintes de procédé.

- Données opérationnelles en direct : relevés de capteurs, tags PLC/SCADA, tendances historisées, ordres de travail, conditions environnementales et saisies opérateur.

Les programmes logiciels industriels (y compris les architectures edge-to-cloud) aident à synchroniser ces sources pour que le jumeau reflète les opérations quotidiennes plutôt que les hypothèses « tel que conçu ».

Limitations à anticiper

Les jumeaux numériques ne sont pas « installés et oubliés ». Les problèmes courants incluent :

- Dérive du modèle : le monde réel change — les composants vieillissent, les conditions de procédé évoluent — et les prédictions deviennent moins précises.

- Lacunes et qualité des capteurs : tags manquants, étalonnage insuffisant ou échantillonnage incohérent affaiblissent le jumeau.

- Maintenance continue : mise à jour des paramètres, validation des sorties et maîtrise des versions nécessitent une gouvernance et une routine.

Une bonne approche est de commencer par une décision étroitement définie (une ligne, une classe d’actifs, un KPI), prouver la valeur, puis étendre.

Sécurité, sûreté et fiabilité dans l’industrie connectée

Rédiger un copilote d'incident

Créez un copilote qui résume les incidents pour aider opérateurs et ingénieurs à s'aligner plus rapidement.

Connecter usines, réseaux ferroviaires, actifs énergétiques et bâtiments crée de la valeur — mais modifie aussi le profil de risque. Quand le logiciel impacte des opérations physiques, la sécurité n’est plus seulement la protection des données ; il s’agit de maintenir la stabilité des systèmes, la sécurité des personnes et la continuité de service.

Pourquoi la cybersécurité industrielle diffère de l’IT de bureau

Dans l’IT de bureau, une intrusion se mesure souvent en perte d’informations ou en indisponibilité pour des travailleurs du savoir. En OT, les interruptions peuvent arrêter des lignes, endommager des équipements ou créer des conditions dangereuses.

Les environnements OT font aussi tourner des systèmes anciens sur de longues durées, ne peuvent pas toujours redémarrer à volonté et doivent prioriser le comportement prévisible plutôt que le changement rapide.

Contrôles essentiels qui réduisent réellement le risque

Commencez par des fondamentaux adaptés aux réalités industrielles :

- Segmentation réseau : séparer réseaux métiers et opérationnels, puis segmenter les zones critiques (systèmes de sûreté, contrôleurs, historian/plateformes de données). Limiter les chemins entre les zones et documenter le trafic « autorisé ».

- Identité et accès : utiliser des comptes nominatifs, un accès basé sur les rôles et une authentification multi‑facteurs quand c’est pratique — en particulier pour l’accès distant. Restreindre l’accès fournisseur par des approbations limitées dans le temps.

- Stratégie de patching : traiter le patching comme un changement d’ingénierie. Tester les mises à jour, planifier des fenêtres de maintenance et utiliser des contrôles compensatoires (segmentation, allowlists) si le patch n’est pas possible.

- Surveillance et détection : collecter les logs des appareils edge, des passerelles, des serveurs et des points réseau clés. Se concentrer sur les comportements inhabituels (nouvelles connexions, commandes inattendues), pas seulement sur des signatures de malware.

Exigences de sûreté et réglementation

Les programmes industriels doivent aligner les actions de sécurité sur la sûreté opérationnelle et les besoins de conformité : contrôle clair des changements, traçabilité de qui a fait quoi, et preuves que les systèmes critiques restent dans des limites sûres.

Préparation aux incidents : planifier la reprise, pas seulement la prévention

Partons du principe qu’un incident surviendra — qu’il s’agisse d’un événement cyber, d’une mauvaise configuration ou d’une défaillance matérielle. Maintenez des sauvegardes hors ligne, répétez les procédures de restauration, définissez des priorités de rétablissement et attribuez des responsabilités claires entre IT, OT et la direction des opérations.

La fiabilité s’améliore quand chacun sait quoi faire avant qu’un incident n’arrive.

Résultats de durabilité pilotés par l’intelligence opérationnelle

La durabilité dans l’industrie lourde n’est pas principalement une question d’image — c’est un problème d’exploitation. Quand vous voyez ce que font réellement machines, usines, flottes et réseaux d’approvisionnement (en quasi‑temps réel), vous pouvez cibler les sources spécifiques de gaspillage d’énergie, d’arrêts imprévus, de rebut et de retouches qui génèrent coûts et émissions.

L’intelligence opérationnelle transforme « on pense que cette ligne est inefficace » en preuve : quels actifs consomment trop d’énergie, quelles étapes de procédé sont hors spécification, quels arrêts forcés obligent des redémarrages énergivores.

Même de petites améliorations — temps de montée en température plus courts, moins d’heures d’inactivité au ralenti, consignes plus serrées — s’additionnent sur des milliers d’heures d’exploitation.

Leviers pratiques qui produisent des résultats

Trois leviers reviennent fréquemment :

- Optimisation : ajuster planning, consignes et débit en fonction des contraintes (santé des équipements, prix de l’énergie, demande) pour éviter des fonctionnements gaspillants.

- Maintenance basée sur l’état : utiliser vibration, température, consommation et alarmes pour intervenir quand les indicateurs changent — prévenir des pannes qui entraînent des cycles d’arrêt/redémarrage énergivores et du rebut.

- Reporting : automatiser la collecte des KPI énergie, matière et opérationnels afin que les équipes passent moins de temps à compiler des tableaux et plus de temps à corriger les causes profondes.

Mesure vs attribution vs réduction

Il est utile de séparer trois concepts :

- Mesure : capturer des données précises (comptage, intégrité des capteurs, horodatages cohérents).

- Attribution : relier consommation et émissions à un procédé, produit, ligne ou site (pour savoir où agir).

- Réduction : mettre en œuvre des changements qui réduisent durablement la consommation ou les émissions (et maintenir les gains).

Des métriques transparentes comptent. Utilisez des baselines claires, documentez les hypothèses et appuyez les déclarations par des preuves auditable. Cette discipline évite la surfacturation des résultats et facilite la montée en charge réelle sur plusieurs sites.

Corrigez les tags et unités

Créez un outil léger de normalisation des tags et unités pour réduire les « tableaux de bord discordants ».

Choisir un logiciel industriel n’est pas qu’une comparaison de fonctionnalités — c’est un engagement sur la manière dont le travail se fait dans les opérations, la maintenance, l’ingénierie et l’IT.

Une évaluation pratique commence par l’alignement sur les décisions que vous voulez améliorer (par ex. moins d’arrêts non planifiés, ordres de travail plus rapides, meilleure performance énergétique) et sur les sites où vous prouverez la valeur en premier.

Critères d’évaluation importants

Utilisez une feuille de score reflétant à la fois l’atelier et l’échelle entreprise :

- Adéquation d’intégration : peut‑il se connecter à vos PLC/SCADA, historians, CMMS/EAM, ERP et plateformes de données sans travaux personnalisés fragiles ?

- Scalabilité : la même approche fonctionnera‑t‑elle pour une ligne, un site puis des dizaines — sans perte de performance ni refonte ?

- Support fournisseur : recherchez des services de déploiement éprouvés, des SLA clairs, des parcours de mise à jour et un écosystème partenaire sectoriel.

- Coût total de possession : la licence n’est qu’une part — incluez connectivité, hardware edge, mise en œuvre, cybersécurité, formation et administration continue.

Plan de déploiement en phases (avec gains mesurables)

Évitez les déploiements « big bang ». Une approche par phases réduit les risques et construit la crédibilité :

- Pilote (4–12 semaines) : choisir une classe d’actifs ou un goulet d’étranglement. Définir les métriques de succès (par ex. % de réduction d’arrêt, temps de réponse maintenance, énergie par unité).

- Étendre au site : standardiser tags, conventions de nommage et workflows. Documenter ce qui a changé et pourquoi.

- Répliquer sur d’autres sites : créer des modèles (dashboards, alertes, déclencheurs d’ordres de travail) et un modèle de gouvernance pour éviter que chaque site ne réinvente la roue.

En pratique, les équipes sous‑estimeraient souvent le nombre d’outils internes « petits » nécessaires pendant le déploiement — files de triage, revues d’exception, formulaires d’enrichissement d’ordres de travail, workflows d’approbation et portails simples qui connectent signaux OT et systèmes IT. Des plateformes comme Koder.ai peuvent aider en permettant aux équipes de construire et itérer rapidement ces applications web d’accompagnement via le chat, puis de les intégrer aux APIs existantes — sans attendre un cycle complet de développement sur mesure.

Gestion du changement : l’élément décisif pour l’adoption

Le logiciel industriel réussit quand les équipes de première ligne lui font confiance. Prévoyez du temps pour des formations par rôle, des procédures mises à jour (qui accuse réception des alertes, qui approuve les ordres de travail) et des incitations qui récompensent les comportements basés sur les données — pas seulement la gestion des incidents.

Si vous comparez des options, il peut être utile de revoir les cas d’usage packagés du fournisseur sur /solutions, comprendre les modèles commerciaux sur /pricing et discuter de votre environnement via /contact.

Ce qui attend la technologie industrielle et les logiciels d’entreprise

La tech industrielle évolue de « équipements connectés » vers « résultats connectés ». La direction est claire : plus d’automatisation sur le plancher, davantage de données opérationnelles accessibles aux équipes métiers et des boucles de rétroaction plus rapides entre planification et exécution.

Au lieu d’attendre des rapports hebdomadaires, les organisations s’attendront à une visibilité quasi‑temps réel sur la production, la consommation d’énergie, la qualité et la santé des actifs — puis à agir avec un minimum de manipulations manuelles.

Tendance du marché : automatisation + partage de données plus sûr

L’automatisation dépassera les systèmes de contrôle pour inclure des workflows décisionnels : planification, planification de la maintenance, réapprovisionnement d’inventaire et gestion des exceptions.

En parallèle, le partage de données s’élargit — mais devient aussi plus sélectif. Les entreprises veulent partager les bonnes données avec les bons partenaires (OEM, sous‑traitants, fournisseurs d’énergie, logisticiens) sans exposer les détails sensibles du procédé.

Cela pousse fournisseurs et opérateurs à traiter les données comme un produit : bien définies, permissionnées et traçables. Le succès dépendra d’une gouvernance pragmatique pour les opérations, pas seulement d’une conformité pilotée par l’IT.

L’interopérabilité décidera de la rapidité (et du coût)

À mesure que les organisations mixent équipements legacy et nouveaux capteurs/logiciels, l’interopérabilité fait la différence entre monter en charge et stagner. Les standards ouverts et des APIs bien supportées réduisent le verrouillage, raccourcissent les délais d’intégration et permettent de moderniser une partie de la pile sans tout réécrire.

En clair : si vous ne pouvez pas facilement connecter actifs, historians, ERP/EAM et outils d’analytics, vous dépenserez votre budget en plomberie plutôt qu’en performance.

Les prochaines étapes probables : copilotes et optimisation autonome

Attendez‑vous à des « copilotes IA » conçus pour des rôles industriels spécifiques — planificateurs de maintenance, ingénieurs fiabilité, opérateurs de salle de contrôle et techniciens de terrain. Ces outils ne remplaceront pas l’expertise ; ils résumeront les alarmes, recommanderont des actions, rédigeront des ordres de travail et aideront les équipes à expliquer pourquoi une modification est suggérée.

C’est aussi là que des plateformes de type “vibe-coding” comme Koder.ai s’intègrent naturellement : elles accélèrent la création de copilotes internes et d’apps workflow (par ex. un synthétiseur d’incident ou un assistant de planification de maintenance) tout en permettant aux équipes d’exporter le code source, déployer et itérer avec snapshots et rollback.

Ensuite, plus de sites adopteront l’optimisation autonome dans des zones bornées : réglage automatique des consignes dans des limites sûres, arbitrage débit vs coût énergétique, et ajustement des fenêtres de maintenance en fonction de données de condition réelles.

Checklist interne simple pour démarrer la conversation

- Quelles décisions voulons‑nous accélérer (maintenance, qualité, énergie, planning) ?

- Quelles données manquent — ou sont enfermées dans des silos — pour soutenir ces décisions ?

- Quels systèmes doivent d’abord interopérer (sources OT, EAM/ERP, analytics, reporting) ?

- Quelles exigences d’API ou de standards ouverts devons‑nous imposer aux futurs achats ?

- Où pouvons‑nous piloter en sécurité (une ligne, un site, une classe d’actifs) et mesurer le ROI ?

- Qui est responsable de la sécurité, de l’accès et de la gestion du changement entre OT et IT ?