Ce que signifie vraiment « expérimenter de façon peu coûteuse et rapide »

« Expérimenter des idées » veut dire exécuter un petit test à faible engagement avant d'investir lourdement. Au lieu de débattre pour savoir si un concept est bon, vous lancez une vérification rapide pour apprendre ce que les gens font réellement : cliquer, s'inscrire, répondre, ou ignorer.

Expérimenter des idées, en clair

Une expérience d'idée est une mini version de la chose réelle—juste ce qu'il faut pour répondre à une question.

Par exemple :

- Si vous doutez du message, testez deux titres et voyez lequel obtient le plus d'inscriptions.

- Si vous doutez de l'ensemble des fonctionnalités, montrez une démo simple et demandez aux utilisateurs ce qu'ils attendaient.

- Si vous doutez que quelqu'un en ait besoin, publiez une page « coming soon » et mesurez l'intérêt.

L'objectif n'est pas de construire ; c'est de réduire l'incertitude.

Pourquoi les expériences coûtaient cher

Traditionnellement, même les petits tests nécessitaient une coordination entre plusieurs rôles et outils :

- Temps : rédiger des textes, concevoir des écrans, construire des pages, configurer l'analytics, planifier des entretiens.

- Personnes : marketeurs, designers, ingénieurs et chercheurs.

- Frais annexes : constructeurs de landing pages, outils d'enquête, budget pub, logiciels de prototype, plus les révisions et l'alignement.

Ce coût pousse les équipes vers des « gros paris » : construire d'abord, apprendre ensuite.

À quoi ressemble « peu coûteux et rapide » avec l'IA

L'IA réduit l'effort nécessaire pour produire des éléments de test—brouillons, variantes, scripts, résumés—de sorte que vous pouvez exécuter plus d'expériences avec moins de friction.

- Peu coûteux signifie souvent valider une hypothèse sans mobiliser plusieurs rôles pendant des jours.

- Rapide signifie passer de la question → au matériel de test → au premier signal en heures, pas en semaines.

Fixer les attentes : apprentissage plus rapide, pas de gains garantis

L'IA ne rend pas automatiquement bonnes les idées, et elle ne remplace pas le comportement réel des utilisateurs. Ce qu'elle peut bien faire, c'est vous aider à :

- générer des options rapidement (messages, flux, questions)

- affiner la conception d'expérience (hypothèse claire, métrique de succès claire)

- analyser les retours plus vite (thèmes, objections, points confus)

Vous devez toujours choisir la bonne question, collecter des signaux honnêtes et prendre des décisions basées sur des preuves—pas sur l'apparence soignée de l'expérience.

Pourquoi les tests d'idées traditionnels sont lents et coûteux

Les tests traditionnels échouent rarement parce que les équipes ne s'en soucient pas. Ils échouent parce que le « test simple » est en réalité une chaîne de travail entre plusieurs rôles—chacun avec des coûts réels et du temps de calendrier.

La vraie pile des coûts (même pour une petite expérience)

Un sprint de validation basique inclut typiquement :

- Recherche : concurrents, citations clients, hypothèses, recrutement.

- Rédaction : copy de landing page, propositions de valeur, messages, scripts d'entretien, questions d'enquête.

- Design : wireframes, visuels, mises en page, prototypes.

- Code : une page de test, événements analytics, flags d'expérience, formulaires.

- Analyse : nettoyage des résultats, synthèse des notes, accord sur la définition du « succès ».

Même si chaque élément est « léger », l'effort combiné s'accumule—surtout avec les cycles de révision.

Les délais multiplient le coût plus que le travail lui-même

La dépense cachée la plus importante est l'attente :

- Attendre les relais entre produit, design, ingénierie, marketing et juridique

- Attendre des réunions pour s'aligner sur ce qu'il faut tester

- Attendre des relectures, des validations et d'autres modifications

Ces délais étirent un test de 2 jours en un cycle de 2–3 semaines. Quand les retours arrivent tard, les équipes relancent souvent parce que les hypothèses ont changé.

Le coût d'opportunité : deviner plus longtemps

Quand les tests sont lents, les équipes compensent en débattant et en s'engageant sur la base de preuves incomplètes. Vous continuez à construire, communiquer ou vendre autour d'une idée non testée plus longtemps que nécessaire—verrouillant des décisions plus difficiles (et plus coûteuses) à inverser.

Le testing traditionnel n'est pas « trop cher » isolément ; il est cher parce qu'il ralentit l'apprentissage.

L'IA ne rend pas seulement les équipes « plus rapides ». Elle change ce que coûtent les expérimentations—en particulier le coût de produire une première version crédible de quelque chose.

Le changement central : les premières versions deviennent bon marché

Traditionnellement, la partie coûteuse de la validation d'idée est de rendre quelque chose suffisamment réel pour être testé : une landing page, un email de vente, un script de démo, un prototype cliquable, une enquête, ou même une déclaration de positionnement claire.

Les outils IA réduisent drastiquement le temps (et l'effort de spécialistes) nécessaire pour créer ces artefacts initiaux. Quand le coût de mise en place baisse, vous pouvez vous permettre de :

- tester davantage d'idées avant de vous engager

- explorer plus de variantes (audiences, prix, messages)

- impliquer les parties prenantes plus tôt (parce qu'il y a quelque chose de concret à réagir)

Le résultat est plus de « tirs au but » sans embaucher plus ou attendre des semaines.

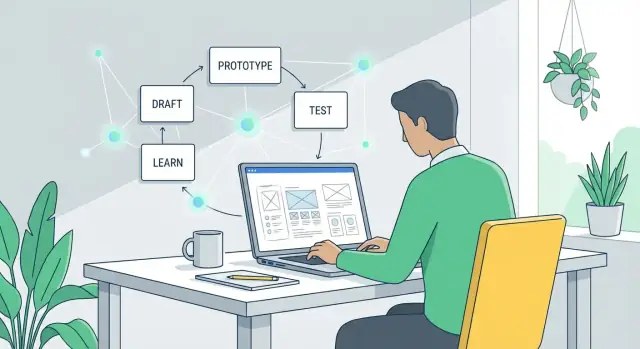

Cycles compressés : brouillon → retour → révision

L'IA compresse la boucle entre pensée et apprentissage :

- Brouillon : générer plusieurs options (texte, flux, descriptions de fonctionnalités, FAQ, propositions de valeur).

- Retour : partager avec des utilisateurs/prospects/collègues, ou effectuer des critiques structurées avec une checklist.

- Révision : itérer immédiatement pendant que les objections et les questions sont fraîches.

Quand cette boucle tourne en heures au lieu de semaines, les équipes passent moins de temps à défendre des solutions à moitié construites et plus de temps à réagir aux preuves.

Vitesse ≠ meilleures décisions

La rapidité de production peut créer une fausse impression de progrès. L'IA facilite la production de matériaux plausibles, mais la plausibilité n'est pas validation.

La qualité des décisions dépend toujours de :

- poser les bonnes questions (quel risque réduisez-vous ?)

- tester avec les bonnes personnes

- mesurer des signaux qui prédisent des résultats (pas seulement « ça a l'air bien »)

Bien utilisée, l'IA réduit le coût de l'apprentissage. Mal utilisée, elle réduit juste le coût de faire plus d'hypothèses, plus vite.

Brouillons de contenu rapides : tester le message en quelques minutes

Quand vous validez une idée, vous n'avez pas besoin d'un texte parfait—vous avez besoin d'options crédibles à présenter rapidement. L'IA générative excelle à produire des premiers brouillons suffisamment bons pour tester, puis affiner en fonction des apprentissages.

Ce qu'il faut rédiger vite (et pourquoi c'est important)

Vous pouvez produire des éléments de message en quelques minutes qui prendraient normalement des jours :

- Titres et sous-titres pour différentes propositions de valeur

- Copy de page d'atterrissage (hero, bénéfices, objections, call-to-action)

- Séquences email (accueil, relance, rappel)

- FAQ qui répondent aux objections et réduisent la friction

L'objectif est la vitesse : mettre plusieurs versions plausibles en ligne, puis laisser le comportement réel (clics, réponses, inscriptions) vous dire ce qui résonne.

Générer plusieurs angles sans repartir de zéro

Demandez à l'IA des approches distinctes pour la même offre :

- Axé sur les bénéfices : « Obtenez X résultat sans Y contrainte. »

- Axé sur le problème : « Toujours confronté à X ? Voici une façon plus simple. »

- Axé sur l'histoire : une courte narration avant/après.

Comme chaque angle se rédige rapidement, vous pouvez tester l'étendue des messages tôt—avant d'investir dans le design, le produit ou de longs cycles de copywriting.

Adapter le ton selon les audiences

Vous pouvez adapter la même idée principale pour des lecteurs différents (fondateurs vs équipes opérations) en spécifiant le ton et le contexte : « confiant et concis », « amical et clair », ou « formel et conforme ». Cela permet des expériences ciblées sans réécrire depuis le début.

Astuce : conservez un message « source de vérité »

La rapidité peut créer de l'incohérence. Maintenez un court document-message (1–2 paragraphes) : pour qui c'est, la promesse principale, preuves clés et exclusions importantes. Servez-vous-en comme entrée pour chaque brouillon IA afin que les variantes restent alignées—et que vous testiez des angles, pas des revendications contradictoires.

Prototypes sans lourd travail de design

Vous n'avez pas besoin d'un sprint de design complet pour savoir si une idée « clique ». Avec l'IA, vous pouvez créer un prototype crédible suffisant pour obtenir des retours—sans des semaines de maquettes, de boucles de validation et de débats sur les pixels.

Commencez avec une trousse de prototype, pas une toile blanche

Donnez à l'IA un bref produit et demandez les éléments de construction :

- Une liste de fonctionnalités (indispensables vs agréables à avoir)

- Un flux utilisateur simple (ce qui se passe d'abord, ensuite, enfin)

- Écrans suggérés (accueil, onboarding, paramètres, checkout, etc.)

- Texte UI pour boutons, infobulles, états vides et messages d'erreur

Ensuite, transformez le flux en wireframes rapides avec des outils simples (Figma, Framer, ou même des slides). Le texte généré par l'IA aide à rendre les écrans crédibles, ce qui rend les retours bien plus précis que « ça a l'air bien ».

Créez des prototypes cliquables en quelques heures

Une fois les écrans prêts, liez-les en une démo cliquable et testez l'action centrale : inscription, recherche, réservation, paiement ou partage.

L'IA peut aussi générer du contenu factice réaliste—listings d'exemple, messages, descriptions de produit—pour que les testeurs ne soient pas déroutés par du « Lorem ipsum ».

Produisez des variantes pour différents utilisateurs

Au lieu d'un seul prototype, créez 2–3 versions :

- Nouveaux utilisateurs : plus d'aide, moins de choix, libellés plus clairs

- Utilisateurs avancés : raccourcis, actions en masse, filtres avancés

Cela aide à valider si votre idée nécessite des parcours différents, pas seulement un libellé différent.

Vérifications rapides d'accessibilité et de clarté

L'IA peut analyser le texte UI pour jargon confus, libellés incohérents, manque de guidance pour les états vides et phrases trop longues. Elle peut aussi signaler des problèmes d'accessibilité courants à vérifier (contraste, texte de lien ambigu, messages d'erreur peu clairs) pour éliminer les frictions évitables avant de montrer quoi que ce soit aux utilisateurs.

MVPs rapides : du concept à la démo rapidement

Faites entrer d'autres personnes dans la boucle

Parrainez des coéquipiers ou amis sur Koder.ai et collaborez pour tester des idées plus rapidement.

Un MVP rapide n'est pas une version réduite du produit final—c'est une démo qui prouve (ou infirme) une hypothèse clé. Avec l'IA, vous pouvez atteindre cette démo en jours (voire heures) en sautant la perfection et en vous concentrant sur une chose : montrer la valeur centrale suffisamment clairement pour qu'on réagisse.

Ce que l'IA accélère

L'IA est utile quand le MVP a juste besoin d'assez de structure pour paraître réel :

- Scripts simples et pseudo-code pour transformer un concept en flux cliquable ou fonctionnel.

- Exemples d'API pour simuler une « intégration » (même si le backend réel n'existe pas encore).

- Échafaudage pour petits outils comme calculateurs, estimateurs, assistants d'onboarding, tableaux de bord internes, ou une extension Chrome légère.

Par exemple, si votre idée est « un vérificateur d'éligibilité aux remboursements », le MVP peut être une page unique avec quelques questions et un résultat généré—pas de comptes, pas de facturation, pas de gestion des cas limites.

answers = collect_form_inputs()

score = rules_engine(answers)

result = generate_explanation(score, answers)

return result

Si vous voulez aller au-delà d'un mock cliquable et démontrer quelque chose qui ressemble à une vraie appli, une plateforme « vibe-coding » comme Koder.ai peut être une solution pratique : vous décrivez le flux en chat, générez une application web fonctionnelle (souvent React en frontend avec Go + PostgreSQL en backend) et itérez rapidement—tout en gardant l'option d'exporter le code source plus tard si l'expérience évolue en produit.

Gardez la portée sûre : qualité prototype vs qualité production

L'IA peut générer du code fonctionnel rapidement, mais cette vitesse peut brouiller la frontière entre prototype et quelque chose qu'on est tenté de livrer. Fixez les attentes dès le départ :

- Qualité prototype : prouve la désirabilité, l'utilisabilité et la faisabilité de base.

- Qualité production : gère l'échelle, la sécurité, le monitoring, les cas limites, la conformité et la maintenance long terme.

Une bonne règle : si la démo sert principalement à apprendre, elle peut faire des raccourcis—tant que ces raccourcis n'introduisent pas de risques.

Ne sautez pas l'étape de la relecture : sécurité, confidentialité, fiabilité

Même les démos MVP nécessitent un contrôle de sanity rapide. Avant de montrer aux utilisateurs ou de connecter des données réelles :

- Sécurité : pas de clés exposées, dépendances non sûres, ou endpoints admin ouverts.

- Confidentialité : évitez les données personnelles sauf si nécessaire ; anonymisez et minimisez.

- Fiabilité : gérez les échecs évidents (entrées vides, timeouts d'API) pour que le test mesure l'idée—et non une démo cassée.

Bien fait, l'IA transforme « concept → démo » en une habitude répétable : construire, montrer, apprendre, itérer—sans sur-investir au départ.

Recherche utilisateur moins coûteuse grâce à une meilleure préparation

La recherche utilisateur devient coûteuse quand vous « improvisez » : objectifs flous, recrutement faible et notes désordonnées qui prennent des heures à interpréter. L'IA peut diminuer le coût en vous aidant à bien préparer—avant même de programmer un appel.

Créez de bons matériaux en une session

Commencez par demander à l'IA de rédiger votre guide d'entretien, puis affinez-le avec votre objectif spécifique (quelle décision cette recherche doit-elle informer ?). Vous pouvez aussi générer :

- Questions de présélection pour trouver les bons participants (et exclure les mauvais)

- Messages d'approche pour email, LinkedIn, ou prompts in-product

- Un bref document de recherche à partager avec les collègues pour que tout le monde sache ce qui est testé

Cela réduit le temps de préparation de jours à une heure, rendant les petites études fréquentes plus réalistes.

Notes plus cohérentes et synthèse plus rapide

Après les entretiens, collez les notes d'appel (ou une transcription) dans votre outil IA et demandez un résumé structuré : points de douleur clés, alternatives actuelles, moments d'enchantement, et citations directes.

Vous pouvez aussi lui demander d'étiqueter les retours par thème afin que chaque entretien soit traité de la même manière—quelle que soit la personne qui a mené l'appel.

Puis demandez-lui de proposer hypothèses basées sur ce qu'il a entendu, clairement étiquetées comme hypothèses (pas des faits). Exemple : « Hypothèse : les utilisateurs churnent parce que l'onboarding ne montre pas la valeur lors de la première session. »

Garder la recherche honnête (éviter les questions suggestives)

Faites relire vos questions par l'IA pour détecter les biais. Remplacez des formulations comme « Utiliseriez-vous ce workflow plus rapide ? » par des questions neutres telles que « Comment faites-vous cela aujourd'hui ? » et « Qu'est-ce qui vous ferait changer ? »

Si vous voulez une checklist rapide pour cette étape, liez-la dans votre wiki d'équipe (par ex., /blog/questions-entretien-utilisateur).

Expériences rapides : enquêtes, A/B tests et smoke tests

Prototyper sans lourdeurs

Créez une interface et un flux convaincants sans semaines de design ni de passations.

Les expériences rapides vous aident à orienter une décision sans vous engager sur une construction complète. L'IA vous aide à les mettre en place plus vite—surtout lorsque vous avez besoin de multiples variantes et de contenus cohérents.

Enquêtes : retours rapides, meilleures questions

L'IA excelle à rédiger des enquêtes, mais le vrai gain est d'améliorer la qualité des questions. Demandez-lui de créer un libellé neutre (sans langage suggestif), des choix de réponses clairs et un déroulé logique.

Une invite simple comme « Réécris ces questions pour qu'elles soient neutres et ajoute des choix de réponses qui n'influencent pas les résultats » peut supprimer la persuasion accidentelle.

Avant d'envoyer quoi que ce soit, définissez ce que vous ferez avec les résultats : « Si moins de 20% choisissent l'option A, nous n'explorerons pas ce positionnement. »

A/B tests : générer des variantes sans perdre de temps

Pour les A/B tests, l'IA peut produire rapidement plusieurs variantes—titres, sections hero, objets d'email, copy de page de prix et appels à l'action.

Restez discipliné : changez un élément à la fois pour savoir ce qui a causé la différence.

Planifiez les métriques de succès à l'avance : taux de clic, inscriptions, demandes de démo, ou conversion « page prix → checkout ». Liez la métrique à la décision à prendre.

Smoke tests : valider la demande avant de construire

Un smoke test est une expérience légère « faire comme si » : une landing page, un bouton de checkout, ou un formulaire d'attente. L'IA peut rédiger la copy de la page, les FAQ et des propositions de valeur alternatives pour tester ce qui résonne.

Garde-fous contre la fausse confiance

Les petits échantillons peuvent tromper. L'IA peut aider à interpréter les résultats, mais elle ne peut pas corriger des données faibles. Traitez les premiers résultats comme des signaux, pas des preuves, et surveillez :

- Échantillons trop petits (faciles à sur-interpréter)

- Sources de trafic biaisées (amis, équipes internes)

- Métriques qui ne reflètent pas l'intention réelle (clics vs inscriptions)

Utilisez les expériences rapides pour réduire les options—puis confirmez avec un test plus solide.

Analyse plus rapide et décisions plus claires

Expérimenter vite n'aide que si vous pouvez transformer des entrées brouillonnes en une décision fiable. L'IA est utile ici car elle peut résumer, comparer et faire émerger des motifs à partir de notes, retours et résultats—sans des heures dans des feuilles de calcul.

Après un appel, une enquête ou un petit test, collez des notes brutes et demandez à l'IA de produire une page « brief de décision » :

- Ce que nous avons testé (hypothèse, audience, canal)

- Ce qui s'est passé (signaux principaux, citations notables, chiffres)

- Ce que cela signifie (interprétation + confiance)

- Étape recommandée (continuer, modifier, ou arrêter)

Cela empêche les insights de rester dans la tête de quelqu'un ou d'être enfouis dans un doc que personne n'ouvre.

Comparer des options avec pour/contre et hypothèses

Quand vous avez plusieurs directions, demandez à l'IA une comparaison côte-à-côte :

- Option A vs B : avantages, inconvénients, risques

- Hypothèses qui doivent être vraies

- L'expérience la moins chère pour tester chaque hypothèse

Vous ne demandez pas à l'IA de « choisir le gagnant ». Vous l'utilisez pour expliciter le raisonnement et le rendre plus facile à challenger.

Définir « ce qui me ferait changer d'avis »

Avant de lancer le prochain test, rédigez des règles de décision. Exemple : « Si moins de 5% des visiteurs cliquent sur ‘Demander l'accès’, nous arrêtons cet angle de message. » L'IA peut vous aider à formuler des critères mesurables liés à l'hypothèse.

Tenir un journal d'expériences léger

Un simple journal (date, hypothèse, méthode, résultats, décision, lien vers le brief) empêche de refaire le même travail et rend l'apprentissage cumulatif.

Gardez-le là où votre équipe consulte déjà (doc partagé, wiki interne ou dossier avec liens).

Risques et garde-fous : rester exact et éthique

Aller vite avec l'IA est une superpuissance—mais elle peut aussi amplifier les erreurs. Quand vous pouvez générer dix concepts en dix minutes, il est facile de confondre « beaucoup de production » avec « bonnes preuves ».

Où ça dérape

Les hallucinations sont le risque évident : une IA peut inventer des « faits », des citations, ou des chiffres de marché avec assurance. Dans une expérimentation rapide, des détails inventés peuvent devenir silencieusement la base d'un MVP ou d'un pitch.

Un autre piège est de trop s'adapter aux suggestions de l'IA. Si vous demandez constamment au modèle « la meilleure idée », vous pouvez courir après ce qui sonne plausible en texte plutôt que ce que veulent les clients. Le modèle optimise la cohérence—pas la vérité.

Enfin, l'IA facilite le plagiat involontaire des concurrents. Quand vous invitez « des exemples du marché », vous pouvez dériver vers des clones proches du positionnement ou des fonctionnalités existantes—risqué pour la différenciation et potentiellement pour la PI.

Garde-fous simples pour rester honnête

Demandez à l'IA d'exposer son incertitude :

- « Liste les hypothèses que tu fais et indique le niveau de confiance (faible/moyen/élevé). »

- « Qu'est-ce qui changerait ta réponse ? Quelles données faudrait-il ? »

Pour toute affirmation qui touche à l'argent, la sécurité ou la réputation, vérifiez les points critiques. Traitez la sortie IA comme un draft de brief de recherche, pas comme la recherche elle-même.

Si le modèle cite des statistiques, exigez des sources traçables (puis vérifiez-les) : « Fournis des liens et des citations de la source originale. »

Contrôlez aussi les entrées pour réduire les biais : réutilisez un template d'invite cohérent, conservez un document versionné des « faits que nous croyons », et lancez de petits tests avec des hypothèses variées pour éviter qu'une seule invite dicte l'issue.

Bases de confidentialité et d'éthique

Ne collez pas de données sensibles (infos clients, revenus internes, code propriétaire, docs juridiques) dans des outils non approuvés. Utilisez des exemples anonymisés, des données synthétiques ou des environnements d'entreprise sécurisés.

Si vous testez des messages, divulguez l'implication de l'IA quand c'est approprié et évitez de fabriquer des témoignages ou citations utilisateurs.

Un workflow pratique pour l'itération rapide

Planifiez d'abord l'expérience

Définissez votre hypothèse, l'indicateur de succès et les écrans avant de générer du code.

La vitesse n'est pas seulement « travailler plus vite »—c'est exécuter une boucle répétable qui vous empêche de polir la mauvaise chose.

Un workflow simple :

Hypothèse → Construire → Tester → Apprendre → Itérer

1) Commencez par une hypothèse nette

Écrivez-la en une phrase :

« Nous pensons que [audience] fera [action] parce que [raison]. Nous saurons que nous avons raison si [métrique] atteint [seuil]. »

L'IA peut vous aider à transformer des idées vagues en affirmations testables et à proposer des critères de succès mesurables.

2) Définissez ce qui est « assez bon pour tester »

Avant de créer quoi que ce soit, fixez une barre minimale de qualité :

- Promesse claire (une phrase)

- Un call-to-action principal

- Un scénario utilisateur réaliste

- Pas besoin de visuels parfaits

Si cela la respecte, publiez pour un test. Sinon, corrigez uniquement ce qui empêche la compréhension.

3) Faites des cycles limités dans le temps (choisissez-en un)

Cycle 2 heures : Rédigez une landing page + 2 variantes d'annonces, lancez une dépense minime ou partagez avec un petit public, collectez clics + réponses.

Cycle 1 jour : Créez un prototype cliquable (UI brute acceptable), faites 5 courts entretiens utilisateurs, notez où ils hésitent et ce qu'ils attendent ensuite.

Cycle 1 semaine : Construisez une démo MVP légère (ou une version concierge), recrutez 15–30 utilisateurs cibles, mesurez l'activation et la volonté de continuer.

4) Assignez des rôles—même si c'est une seule personne

- Fondateur : choisit l'hypothèse et la décision de « publier ».

- Marketeur : définit l'audience, les canaux et les métriques de succès.

- Designer : s'assure que le flux est compréhensible (pas nécessairement beau).

- Analyste : configure le suivi, journalise les résultats, résume les apprentissages.

5) Fermez la boucle par une décision

Après chaque test, rédigez un « mémo d'apprentissage » d'un paragraphe : ce qui s'est passé, pourquoi, et ce que vous changerez ensuite. Puis décidez : itérer, pivoter l'hypothèse, ou arrêter.

Conserver ces mémos dans un même document rend le progrès visible—et répétable.

Mesurer l'impact : apprenons-nous vraiment plus vite ?

La vitesse n'a d'utilité que si elle produit des décisions plus claires. L'IA peut vous aider à exécuter plus d'expériences, mais il vous faut un tableau de bord simple pour savoir si vous apprenez plus vite—ou si vous générez juste plus d'activité.

Les métriques de base à suivre

Commencez avec un petit ensemble de mesures comparables entre expériences :

- Temps jusqu'au premier test : jours (ou heures) entre l'idée et quelque chose de réel devant des utilisateurs.

- Coût par apprentissage : dépenses totales (outils, pub, incitations, temps) divisées par le nombre d'insights exploitables.

- Amélioration de conversion : gain par rapport à la baseline (ex. taux d'inscription de 2,0% → 2,6%).

- Signaux de rétention : indicateurs précoces comme retours, utilisations répétées, ou réponses « je serais déçu si ceci disparaissait ».

Indicateurs avancés vs qualité d'apprentissage

L'IA facilite la chasse aux clics et aux inscriptions. La vraie question est : chaque test se termine-t-il par un résultat net ?

- Avez-vous confirmé ou rejeté une hypothèse précise ?

- Pouvez-vous résumer le résultat en une phrase (ex. « Prix à 19€ convertit 30% mieux que 29€ pour les freelances ») ?

- Savez-vous quoi faire ensuite—construire, changer, ou arrêter ?

Si les résultats sont flous, resserrez la conception : hypothèses plus claires, critères de succès plus nets, ou audience mieux ciblée.

Règles d'arrêt : décidez avant de lancer

Engagez-vous sur ce qui se passera quand les données arriveront :

- Tuer si la métrique clé est sous un seuil minimum (ex. <1% d'inscriptions après 500 visites qualifiées).

- Pivoter si l'intérêt existe mais que le message, l'audience ou le cas d'usage diffèrent de votre hypothèse.

- Intensifier si vous atteignez le seuil et pouvez expliquer pourquoi cela a fonctionné.

Prochaine étape

Choisissez une idée et planifiez un premier petit test aujourd'hui : définissez une hypothèse, une métrique, une audience et une règle d'arrêt.

Puis visez à réduire de moitié votre temps jusqu'au premier test sur l'expérience suivante.