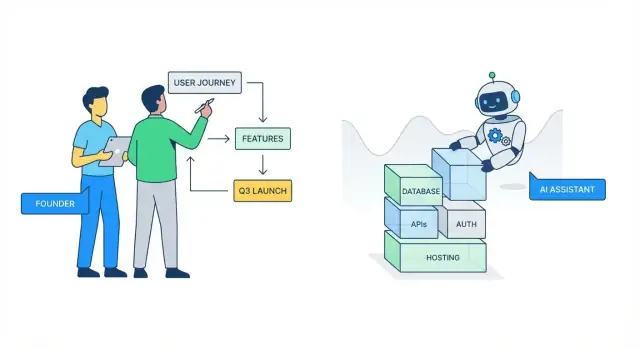

Pourquoi la complexité du backend freine les fondateurs

« La complexité du backend » regroupe tout le travail invisible nécessaire pour qu’un produit paraisse simple : stocker les données de façon sûre, les exposer via des API, gérer les connexions, envoyer des e‑mails, traiter les paiements, exécuter des tâches en arrière‑plan, surveiller les erreurs et maintenir la stabilité à mesure de l’usage.

Pour les fondateurs et les petites équipes, ce travail ralenti l’élan parce qu’il implique un coût d’installation élevé avant que les utilisateurs ne voient de la valeur. On peut passer des jours à débattre d’un schéma de base de données, à câbler l’authentification ou à configurer des environnements — pour découvrir ensuite via les premiers clients que la fonctionnalité doit changer.

Le backend est aussi très interconnecté : une petite décision produit (« les utilisateurs peuvent appartenir à plusieurs équipes ») peut entraîner des changements de schéma, des règles de permissions, des mises à jour d’API et des migrations.

À quoi ressemble « abstrait par l'IA »

En pratique, l’abstraction par l’IA signifie que vous décrivez ce que vous voulez, et l’outil génère ou orchestre les parties fastidieuses :

- Rédaction d’endpoints CRUD, validation des entrées et gestion d’erreurs basique

- Proposition de modèles de données et de relations selon vos fonctionnalités

- Génération des flux d’authentification (sessions, tokens) et échafaudages de permissions

- Création du code d’intégration pour des services courants (email, paiements, analytics)

L’avantage clé n’est pas la perfection, mais la vitesse pour atteindre une base de travail fonctionnelle que vous pouvez itérer.

Des plateformes comme Koder.ai vont plus loin en combinant un workflow par chat avec une architecture basée sur des agents : vous décrivez le résultat (web, backend ou mobile) et le système échafaude l’application de bout en bout (par exemple React sur le web, Go + PostgreSQL côté backend, et Flutter pour le mobile), vous permettant de passer d’une idée à une base déployable sans passer une semaine sur la plomberie.

Ce que ça ne veut pas dire

L’IA ne supprime pas le besoin de prendre des décisions produit et de gestion des risques. Elle ne saura pas vos règles métier exactes, quelles données vous devez conserver, à quel degré les permissions doivent être strictes, ni ce que signifie « suffisamment sécurisé » pour votre domaine. Elle ne préviendra pas non plus tous les problèmes de montée en charge ou de maintenance si les choix d’architecture sous-jacents sont fragiles.

Ajustez vos attentes : l’IA vous aide à itérer plus vite et à éviter la page blanche, mais vous gardez la responsabilité de la logique produit, des arbitrages et du niveau de qualité final.

Le vrai coût du travail backend pour les équipes early‑stage

Les équipes early‑stage ne « choisissent » rarement le travail backend — il apparaît comme un tas de corvées nécessaires entre une idée et quelque chose que les utilisateurs peuvent toucher. Le temps perdu n’est pas seulement l’écriture de code ; c’est la surcharge mentale de prendre des dizaines de petites décisions à forts enjeux avant d’avoir validé le produit.

Où le temps des fondateurs disparaît silencieusement

Quelques tâches mangent disproportionnellement des heures :

- Authentification et permissions : flux de connexion, réinitialisation de mot de passe, rôles, cas limites et scénarios « que se passe‑t‑il si… ».

- Modèles de données : définir tables/collections, relations, migrations et comment changer les choses plus tard sans tout casser.

- Déploiements : environnements, secrets, configuration CI/CD et le premier incident « pourquoi la prod est différente du local ? ».

- Intégrations : webhooks, retries, idempotence, validation de signatures et adaptation aux bizarreries des tiers.

Le coût caché est le context switching constant entre réflexion produit (« que doivent faire les utilisateurs ? ») et réflexion infrastructure (« comment stocker et exposer ça en sécurité ? »). Ce va‑et‑vient ralentit, augmente les erreurs et transforme le debug en détour de plusieurs heures — surtout quand vous gérez aussi les ventes, le support et la levée de fonds.

Chaque jour passé à câbler des basiques backend est un jour non consacré à parler aux utilisateurs et itérer. Cela allonge le cycle construire–mesurer–apprendre : vous livrez plus tard, apprenez plus tard et risquez de construire la mauvaise chose avec plus de finition.

Une semaine perdue à « juste se mettre en place »

Un scénario courant : lundi–mardi sur l’auth et les tables utilisateurs, mercredi sur les déploiements et variables d’environnement, jeudi sur une intégration de paiement ou d’email, vendredi à courir après un bug de webhook et écrire un petit panneau d’administration. Vous terminez la semaine avec de la « plomberie », pas une fonctionnalité pour laquelle les utilisateurs paieraient.

L’abstraction backend assistée par l’IA n’élimine pas la responsabilité, mais elle peut récupérer cette semaine pour que vous livriez des expériences plus vite et gardiez l’élan.

Ce que l'« abstraction » par l'IA signifie en pratique

Ce n’est pas de la magie — c’est une façon d’élever le travail backend d’un niveau. Au lieu de penser en termes de frameworks, fichiers et code de colle, vous décrivez le résultat voulu (« les utilisateurs peuvent s’inscrire », « stocker des commandes », « envoyer un webhook au paiement ») et l’IA aide à traduire cette intention en éléments concrets.

L'IA comme copilote pour les tâches répétitives d'ingénierie

Une grande partie de l’effort backend est prévisible : câbler des routes, définir des DTO, mettre en place des endpoints CRUD, valider les entrées, générer des migrations et écrire sans cesse les mêmes adaptateurs d’intégration. L’IA est la plus efficace quand le travail suit des modèles établis et des bonnes pratiques.

C’est l’« abstraction » pratique : réduire le temps passé à se souvenir des conventions et à chercher dans la doc, tout en vous laissant le contrôle de ce qui est construit.

Un bon prompt agit comme une mini‑spécification. Par exemple : « Crée un service Orders avec endpoints pour créer, lister et annuler des commandes. Utilise des transitions d’état. Ajoute des champs d’audit. Retourne une pagination. » À partir de là, l’IA peut proposer :

- Une structure de module échafaudée (controllers/services/models)

- Des mises à jour de config (vars env, CORS, queues, rate limits)

- Des migrations et modèles de données alignés sur la fonctionnalité

- Des exemples de tests et des extraits de docs API

Vous révisez, ajustez les noms et décidez des frontières — mais le coût de la page blanche chute fortement.

Où l'IA aide le plus — et où elle peine

L’IA brille pour les composants standards : flux d’auth, conventions REST, jobs en arrière‑plan, cache basique et intégrations courantes.

Elle rencontre des difficultés quand les exigences sont floues (« rendez‑le scalable »), lorsque les règles métier sont nuancées (« la logique de remboursement dépend du type de contrat et des dates ») et sur les cas limites impliquant concurrence, argent ou permissions. Dans ces situations, le chemin le plus rapide est souvent de clarifier d’abord les règles (même en langage simple), puis de demander à l’IA d’implémenter exactement ce contrat — et de le vérifier avec des tests.

Scaffolding et boilerplate : le gain le plus rapide

Les fondateurs perdent des jours sur du travail qui n’avance pas le produit : organiser des dossiers, copier les mêmes patterns et rendre « hello world » déployable. L’abstraction backend par l’IA est surtout précieuse ici parce que la sortie est prévisible et répétable — parfaite pour l’automatisation.

Générer un squelette de projet qui correspond à votre intention

Au lieu de partir d’un repo vide, vous pouvez décrire ce que vous construisez (« un SaaS multi‑tenant avec API REST, Postgres, jobs en arrière‑plan ») et générer une structure cohérente : services/modules, routage, couche d’accès aux données, logging et conventions de gestion d’erreurs.

Cela donne à l’équipe un point de départ partagé et élimine l’agitation initiale du « où doit vivre ce fichier ? ».

Endpoints CRUD sans marathon de copier/coller

La plupart des MVP ont besoin des mêmes basiques : endpoints create/read/update/delete plus validation simple. L’IA peut échafauder ces endpoints de façon cohérente — parsing des requêtes, codes de statut et règles de validation — pour que vous consacriez votre temps à la logique produit (règles de tarification, étapes d’onboarding, permissions), pas au glue répétitif.

Un bénéfice pratique : des patterns cohérents rendent les refactors ultérieurs moins coûteux. Quand chaque endpoint suit les mêmes conventions, vous pouvez modifier un comportement (comme la pagination ou le format des erreurs) en un seul endroit.

Config et variables d’environnement correctement configurées

Des environnements mal configurés causent des retards cachés : secrets manquants, mauvaises URLs de base de données, paramètres dev/prod incohérents. L’IA peut générer une approche de config sensée dès le départ — templates d’env, fichiers de config et une doc claire « quoi définir où » — pour que vos coéquipiers puissent lancer le projet localement avec moins d’interruptions.

Réduire le boilerplate entre services et modules

À mesure que vous ajoutez des fonctionnalités, la duplication augmente : middlewares répétés, DTO répétés, pattern « service + controller » répétés. L’IA peut extraire les pièces partagées en helpers et templates réutilisables, gardant votre codebase plus petite et plus facile à naviguer.

Le meilleur résultat n’est pas seulement la vitesse aujourd’hui, mais une base de code compréhensible quand le MVP devient un vrai produit.

Aide à la modélisation des données sans devenir expert en BD

La modélisation des données est souvent un point de blocage : vous savez ce que doit faire le produit, mais transformer cela en tables, relations et contraintes ressemble à l’apprentissage d’une seconde langue.

Les outils IA peuvent combler cet écart en traduisant les exigences produit en un schéma « première ébauche » que vous pouvez valider rapidement — ainsi vous passez du temps à décider des choix produit, pas à mémoriser les règles de la BD.

Des exigences produit aux entités et relations

Si vous décrivez vos objets centraux (« les utilisateurs peuvent créer des projets ; les projets ont des tâches ; les tâches peuvent être assignées à des utilisateurs »), l’IA peut proposer un modèle structuré : entités, champs et relations (one‑to‑many vs many‑to‑many).

Le gain n’est pas que l’IA ait raison magiquement — c’est que vous commencez avec une proposition concrète à valider :

- Une « Tâche » appartient‑elle à un seul « Projet » ou peut‑elle être partagée ?

- Avez‑vous besoin d’« Organisations » maintenant, ou les « Projets » peuvent‑ils être possédés par un seul utilisateur pour le MVP ?

Migrations et données de seed — générées puis revues

Une fois le modèle convenu, l’IA peut générer des migrations et des données d’exemple pour rendre l’application utilisable en dev. Cela inclut souvent :

- création de tables et d’index

- ajout de clés étrangères

- insertion de quelques enregistrements réalistes

La revue humaine est importante : vérifiez les migrations destructrices par défaut, les contraintes manquantes ou des index placés au mauvais endroit.

Cohérence de nommage entre schéma et code

La dérive de nommage est une source silencieuse de bugs (« customer » dans le code, « client » dans la BD). L’IA peut aider à garder des noms cohérents dans les modèles, migrations, payloads API et documentation — particulièrement quand les fonctionnalités évoluent en cours de développement.

La mise en garde : le schéma ne peut pas décider de votre stratégie produit

L’IA peut suggérer une structure, mais elle ne peut pas décider ce que vous devez optimiser : flexibilité vs simplicité, auditabilité vs rapidité, ou si vous aurez besoin de multi‑tenancy plus tard. Ce sont des choix produit.

Une règle utile : modélisez ce que vous devez prouver pour le MVP et laissez de la place pour étendre — sans surconception dès le jour 1.

Authentification et autorisation sans prises de tête

Maintenez l'élan grâce au rollback

Modifiez en toute confiance avec snapshots et rollback quand une itération dérape.

Authentification (qui est l’utilisateur) et autorisation (ce qu’il peut faire) sont deux des domaines où les produits early‑stage perdent le plus de temps. Les outils IA aident en générant rapidement les parties « standard » — mais la valeur n’est pas une sécurité magique. C’est de partir de modèles éprouvés au lieu de les réinventer.

La plupart des MVP ont besoin d’un ou plusieurs de ces flux :

- Email + mot de passe avec réinitialisation, vérification d’email et limitation de débit.

- OAuth (Google, Apple, GitHub) avec lien de compte sécurisé.

- Onboarding par invitation pour les équipes (accepter l’invitation → définir un mot de passe ou OAuth).

L’IA peut générer routes, controllers, formulaires UI et la colle entre eux (envoi d’e‑mails de reset, gestion des callbacks, persistance des utilisateurs). Le gain est la rapidité et l’exhaustivité : moins d’endpoints oubliés et moins de demi‑fins.

RBAC : simple, mais facile à rater

Le RBAC suffit souvent au départ : admin, member, peut‑être viewer. Les erreurs surviennent quand :

- Les rôles sont contrôlés sur certains endpoints mais pas d’autres.

- La logique « propriétaire » est mêlée aux rôles (l’ownership est généralement une règle séparée).

- Le masquage côté frontend est pris pour de la sécurité (l’autorisation doit être appliquée côté serveur).

Une bonne baseline générée par l’IA inclut une couche unique d’autorisation (middleware/policies) pour éviter de parsemer des checks partout.

Sessions vs tokens (haut niveau)

- Sessions (cookies) sont généralement les plus simples pour les web apps : le serveur peut révoquer, faire tourner et protéger via des cookies

HttpOnly.

- Tokens (JWTs) sont pratiques pour mobile/clients API, mais la révocation et la stratégie d’expiration doivent être pensées.

Si vous n’êtes pas sûr, démarrez par les sessions pour un MVP orienté navigateur et ajoutez le support token quand un client réel l’exige.

Checklist : revoir le code d’auth généré par l’IA en toute sécurité

- Les mots de passe sont hashés avec un algorithme moderne (bcrypt/argon2), jamais stockés ni loggés.

- Les vérifications d’auth ont lieu côté serveur pour chaque route protégée.

- Les paramètres de cookie sont corrects (

HttpOnly, Secure, SameSite).

- Les callbacks OAuth valident le

state et les redirect URLs autorisées.

- Il existe une limitation de débit pour les endpoints login/reset.

- Aucuns secrets ne sont hardcodés ; la configuration vient des variables d’environnement.

- Il existe un chemin clair pour révoquer sessions/tokens et pour faire tourner les clés.

Intégrations et webhooks : moins de glue, plus d’élan

Les intégrations sont souvent l’endroit où les timelines de MVP meurent : Stripe pour les paiements, Postmark pour l’email, Segment pour l’analytics, HubSpot pour le CRM. Chacun est « juste une API » — jusqu’à ce que vous jongliez avec des schémas d’auth, des retries, des limits, des formats d’erreur et des cas mal documentés.

L’abstraction backend alimentée par l’IA aide en transformant ces tâches ponctuelles en patterns répétables — pour que vous perdiez moins de temps à câbler et plus à décider ce que doit faire le produit.

Connecter les services courants sans une semaine de mise en place

Les gains les plus rapides viennent généralement des intégrations standard :

- Paiements : création de clients, démarrage d’abonnements, gestion des échecs de paiement

- Email : templates transactionnels, événements de délivrabilité, listes de suppression

- Analytics : nommage d’événements cohérent, linkage d’identité utilisateur

- CRM : synchronisation des comptes et contacts sans tout dupliquer

Au lieu d’assembler manuellement les SDKs, l’IA peut échafauder les pièces nécessaires : variables d’environnement, clients HTTP partagés, modèles typés req/resp et des valeurs par défaut sensées pour timeouts et retries.

Webhooks : handlers auto‑générés, moins d’événements manqués

Les webhooks sont l’autre moitié des intégrations — invoice.paid de Stripe, événements de livraison d’email, mises à jour CRM. Les outils d’abstraction peuvent générer des endpoints de webhook, la vérification de signature et produire un événement interne clair à traiter (ex. PaymentSucceeded).

Un détail clé : le traitement des webhooks doit être idempotent. Si Stripe renvoie le même événement, votre système ne doit pas provisionner deux fois un plan. L’échafaudage IA peut vous pousser à stocker un ID d’événement et ignorer les duplicatas.

Cartographier les données entre systèmes (et où les équipes se brûlent)

La plupart des bugs d’intégration sont des bugs de forme de données : IDs non correspondants, fuseaux horaires, argent en float, ou champs « optionnels » absents en production.

Traitez les IDs externes comme des champs de première classe, stockez les payloads bruts de webhook pour audit/debug et évitez de synchroniser plus de champs que ce que vous utilisez réellement.

Tester en staging avant production

Utilisez des comptes sandbox, des clés API séparées et un endpoint webhook de staging. Rejouez des payloads webhook enregistrés pour confirmer que votre handler fonctionne, et validez le workflow complet (paiement → webhook → base → e‑mail) avant de passer en live.

Conception d’API qui reste alignée avec le produit

Construisez et gagnez en cours de route

Obtenez des crédits en partageant ce que vous construisez ou en invitant d'autres personnes à essayer Koder.ai.

Quand les fondateurs disent « le backend nous ralentit », c’est souvent un problème d’API : le frontend veut une forme de données, le backend en renvoie une autre, et tout le monde perd des heures en allers‑retours.

L’IA peut réduire cette friction en traitant l’API comme un contrat vivant — quelque chose que vous générez, validez et faites évoluer intentionnellement au fil du produit.

Commencer par des contrats, pas des suppositions

Un workflow pratique est de demander à l’IA d’ébaucher un contrat API basique pour une fonctionnalité (endpoints, paramètres et cas d’erreur), avec des exemples concrets de requête/réponse. Ces exemples deviennent votre référence partagée dans les tickets et PRs, et limitent les risques d’interprétation divergente.

OpenAPI dans les deux sens

Si vous avez déjà des endpoints, l’IA peut aider à dériver une spec OpenAPI depuis les routes et payloads réels, pour que la doc reflète la réalité. Si vous préférez concevoir d’abord, l’IA peut échafauder routes, controllers et validateurs à partir d’un fichier OpenAPI. Dans les deux cas, vous obtenez une source unique de vérité qui alimente docs, mocks et génération de clients.

Garder frontend et backend alignés avec des contrats typés

Les contrats typés (types TypeScript, modèles Kotlin/Swift, etc.) évitent la dérive subtile. L’IA peut :

- Générer des types client depuis OpenAPI

- Proposer des DTOs partagés ou des définitions de schéma

- Signaler les endroits où le frontend attend des champs que le backend ne retourne pas (et vice‑versa)

C’est là que « livrer plus vite » devient concret : moins de surprises d’intégration, moins de câblage manuel.

Éviter les breaking changes au fil de l’évolution

À mesure que le produit itère, l’IA peut analyser les diffs et avertir quand un changement est breaking (champs supprimés, significations modifiées, changement de codes de statut). Elle peut aussi proposer des patterns plus sûrs : changements additifs, versioning explicite, fenêtres de dépréciation et couches de compatibilité.

Le résultat : une API qui évolue avec le produit au lieu de constamment lui faire obstacle.

Tests et debug : confiance plus rapide, moins de paniques nocturnes

Quand on va vite, le moment le plus effrayant est de déployer un changement et de réaliser qu’on a cassé autre chose. Les tests et le debug sont ce qui achète de la confiance — mais écrire des tests depuis zéro peut sembler une taxe qu’on « ne peut pas se permettre » au début.

L’IA peut réduire cette taxe en transformant ce que vous savez déjà du produit en un filet de sécurité répétable.

Rédiger des tests pour les parcours qui comptent

Plutôt que viser une couverture parfaite, commencez par quelques parcours utilisateurs essentiels qui ne doivent jamais échouer : inscription, check‑out, création d’un enregistrement, invitation d’un coéquipier.

L’IA est utile pour rédiger :

- Le happy path (flux normal et réussi)

- Un petit ensemble de cas limites (entrée invalide, permissions manquantes, requêtes dupliquées)

Vous définissez toujours le « comportement correct », mais vous n’avez pas à écrire chaque assertion à la main.

Générer rapidement des données de mock et fixtures

Beaucoup de suites de test stagnent parce que créer des données de test réalistes est fastidieux. L’IA peut générer des fixtures conformes à votre modèle (utilisateurs, plans, factures) et produire des variantes — abonnement expiré, compte verrouillé, projet archivé — pour tester sans bricoler des dizaines d’enregistrements.

Utiliser l'IA comme partenaire de debug

Quand un test échoue, l’IA peut résumer des logs bruyants, traduire des stack traces en langage simple et suggérer des corrections probables (« cet endpoint renvoie 403 parce que l’utilisateur de test n’a pas le rôle »). C’est particulièrement utile pour repérer des discordances entre ce que le test suppose et ce que l’API renvoie réellement.

Garde‑fous qualité qui vous maintiennent honnêtes

L’IA accélère la sortie, mais elle ne doit pas être le seul mécanisme de sécurité. Maintenez des garde‑fous légers :

- Revue de code (même un check teammate de 10 minutes)

- CI qui exécute les tests à chaque PR

- Un objectif de couverture minimal pour les modules critiques, pas pour tout le code

Si vous voulez une étape pratique, créez un dossier de tests « core flows » et faites en sorte que la CI bloque les merges quand ces tests échouent. Cela évite la plupart des paniques nocturnes.

Automatisation DevOps sans recruter un ops à temps plein

Le DevOps est l’endroit où « juste livrer » se transforme souvent en nuits blanches : déploiements fragiles, environnements incohérents et bugs mystérieux qui n’arrivent qu’en production.

Les outils IA ne remplacent pas le bon sens d’ingénierie, mais ils peuvent mâcher une grande partie du travail répétitif qui ralenti les fondateurs.

Un piège courant est une qualité de code incohérente parce que personne n’a eu le temps de configurer les bases. Les assistants IA peuvent générer un point de départ propre pour CI (GitHub Actions/GitLab CI), ajouter des règles de lint/format et s’assurer qu’elles s’exécutent à chaque PR.

Moins de débats « style », des revues plus rapides et moins de petites régressions sur la branche principale.

Pipelines de déploiement avec séparation claire des environnements

Les fondateurs déploient souvent directement en production jusqu’à ce que ça fasse mal. L’IA peut échafauder un pipeline simple supportant dev → staging → prod, incluant :

- Variables d’environnement et secrets séparés par environnement

- Une étape de build répétable (pour que staging corresponde à prod)

- Une étape d’approbation manuelle avant la production

L’objectif n’est pas la complexité, mais réduire les « ça marche chez moi » et rendre les releases routinières.

Observabilité basique : logs, métriques et alertes

Vous n’avez pas besoin d’un setup enterprise pour être en sécurité. L’IA peut proposer une baseline minimale d’observabilité :

- Logs structurés (pour rechercher par requête/utilisateur)

- Quelques métriques clés (taux d’erreur, latence, profondeur des queues)

- Alertes sur seuils « quelque chose est cassé »

Cela vous donne des réponses plus rapides quand les clients remontent un problème.

Ce qu’il faut garder manuel au départ pour réduire le risque

Automatisez les parties répétitives, mais gardez le contrôle sur les décisions à fort impact : accès production, rotation des secrets, migrations de base de données et seuils d’alerte. L’IA peut rédiger le playbook, mais vous devez posséder les règles « qui peut faire quoi » et « quand on pousse ».

Transformez vos prompts en un vrai cahier des charges

Utilisez le mode Planification pour clarifier entités, permissions et cas limites avant de modifier le code.

L’IA peut générer du code qui a l’air sécurisé et mettre en place des protections courantes, mais la sécurité et la conformité sont au final des décisions produit. Elles dépendent de ce que vous construisez, de qui l’utilise et des risques que vous acceptez.

Considérez l’IA comme un accélérateur — pas comme votre propriétaire sécurité.

Notions de sécurité que vous gardez

Gestion des secrets est une responsabilité fondateur. Clés API, credentials BD, clés de signature JWT et secrets webhook ne doivent jamais se trouver dans le code source ou les logs de chat. Utilisez des variables d’environnement et un store de secrets géré quand c’est possible, et faites tourner les clés quand des gens partent ou qu’une fuite est suspectée.

Least privilege est l’autre non‑négociable. L’IA peut générer des rôles et politiques, mais vous devez décider qui doit accéder à quoi. Règle simple : si un service ou un utilisateur n’a pas besoin d’une permission, ne la donnez pas. Cela s’applique à :

- Comptes BD (read vs write)

- Services cloud (stockage, email, queues)

- Dashboards admin (évitez « tout le monde est admin » en prod)

Traitement des données personnelles et décisions d'accès

Si vous stockez des données personnelles (emails, téléphones, adresses, identifiants de paiement, données de santé), la conformité n’est pas une case à cocher — elle influence l’architecture.

À haut niveau, définissez :

- Ce qui compte comme PII dans votre app et où c’est stocké

- Qui peut voir/exporter ces données (agents support, admins, utilisateurs)

- Comment c’est loggé (évitez d’imprimer la PII dans les logs et outils d’erreur)

- Règles de rétention (quand vous supprimez des données et comment)

L’IA peut implémenter des contrôles d’accès aux données, mais elle ne peut pas dire ce qui est « approprié » pour vos utilisateurs ou requis par la réglementation de votre marché.

Dépendances et scan de vulnérabilités

Les backends modernes dépendent de paquets, images conteneurisées et services tiers. Faites des checks de vulnérabilités routine :

- Activez les alertes de dépendances dans votre repo

- Scannez les images containers dans la CI

- Patchez régulièrement, surtout les libs d’auth et de crypto

Un avertissement clair

Ne déployez pas du code backend généré par l’IA sans revue. Faites vérifier manuellement les flux d’auth, les contrôles d’autorisation, la validation des entrées et tout code manipulant de l’argent ou de la PII avant qu’il n’atteigne la production.

Arbitrages, garde‑fous et quand creuser plus profondément

L’abstraction backend par l’IA peut sembler magique — jusqu’à ce que vous atteigniez les limites. L’objectif n’est pas d’éviter « le vrai ingénierie » pour toujours ; c’est de repousser les parties coûteuses jusqu’à ce qu’elles soient justifiées par la traction.

Les vrais risques à surveiller

Verrouillage fournisseur est évident : si votre modèle de données, auth et workflows sont liés aux conventions d’une plateforme, changer plus tard peut être coûteux.

Architecture floue est le risque discret : quand l’IA génère services, politiques et intégrations, les équipes ont parfois du mal à expliquer le flux des requêtes, où les données sont stockées ou quoi se passe en cas d’échec.

Complexité cachée réapparaît à l’échelle, lors d’audits ou pour les cas limites — rate limits, retries, idempotence, permissions et migrations ne disparaissent pas ; elles attendent juste leur heure.

Garde‑fous pour rester rapide et en sécurité

Gardez une « trappe de sortie » dès le début :

- Données portables : assurez‑vous de pouvoir exporter tables/collections et fichiers à la demande.

- APIs documentées : traitez l’API comme un contrat produit — documentez endpoints, règles d’auth et cas d’erreur clés.

- Posséder votre modèle de domaine : même si l’IA l’échafaude, c’est vous qui décidez noms, relations et source de vérité.

Si vous utilisez une plateforme native IA, priorisez les fonctionnalités qui facilitent ces garde‑fous — export de code, hébergement/déploiement que vous pouvez contrôler, snapshots/rollback quand un changement automatisé part en vrille. (Koder.ai, par exemple, supporte l’export de code et les snapshots pour aider les équipes à garder une trappe de secours.)

Une habitude simple qui aide : une fois par semaine, écrivez une courte « carte backend » (quels services existent, ce qu’ils touchent et comment lancer localement).

Quand faire appel à un ingénieur ou consultant

Faites‑le quand : vous gérez des paiements ou des données sensibles, l’uptime impacte le chiffre d’affaires, vous avez besoin de permissions complexes, les migrations sont fréquentes ou des problèmes de performance se répètent.

Prochaines étapes pratiques

Commencez petit : définissez vos entités centrales, listez les intégrations requises et décidez ce qui doit être traçable. Ensuite, comparez les options et niveaux de support sur /pricing, et plongez dans des guides tactiques et exemples sur /blog.