Ce que signifient « coûts, temps et friction » dans le travail logiciel

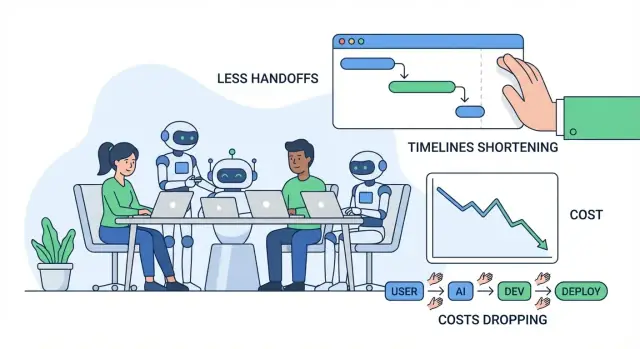

Quand on parle d'améliorer la livraison logicielle, on pense généralement à trois choses : coût, temps, et friction. Elles sont liées, mais distinctes — il est utile de les définir clairement avant d'aborder l'IA.

Coût : ce que vous payez pour les résultats

Le coût est la dépense totale nécessaire pour livrer et maintenir une fonctionnalité : salaires et heures des sous-traitants, factures cloud, outils, et les coûts « cachés » des réunions, de la coordination et de la correction d'erreurs. Une fonctionnalité qui prend deux semaines de plus ne coûte pas seulement plus d'ingénierie : elle peut retarder des revenus, augmenter la charge support, ou vous forcer à maintenir des systèmes anciens plus longtemps.

Temps : combien de temps pour passer de l'idée à la valeur livrée

Le temps est le délai calendaire depuis « on devrait construire ça » jusqu'à « les clients peuvent l'utiliser de manière fiable ». Il inclut le développement, mais aussi les décisions, les validations, l'attente des revues, l'attente d'environnements, les résultats QA, et l'attente d'une personne ayant le bon contexte.

Friction : l'effort perdu à cause des frictions, confusions et interruptions

La friction est la traînée quotidienne qui fait que le travail semble plus lent qu'il ne devrait : exigences floues, allers-retours, changements de contexte, travail dupliqué, ou longs transferts entre rôles/équipes.

La plupart du gaspillage dans les projets logiciels apparaît comme transferts, retravaillages et attentes. Un petit malentendu au départ peut se transformer en refontes, chasses aux bugs, ou réunions répétées plus tard. Une file de revue lente ou une documentation manquante peut bloquer l'avancement même lorsque tout le monde est « occupé ».

Ce que « outils IA » inclut (et ce que ça n'inclut pas)

Dans cet article, les outils IA comprennent les copilotes de code, assistants de chat pour la recherche et les explications, l'analyse automatisée des exigences et tickets, les aides à la génération de tests, et l'automatisation des workflows en QA/DevOps.

L'IA peut réduire l'effort et accélérer les cycles — mais elle n'enlève pas la responsabilité. Les équipes ont toujours besoin d'une propriété claire, d'un bon jugement, de contrôles de sécurité et de validations humaines sur ce qui est livré.

Où les projets logiciels perdent typiquement du temps et de l'argent

La plupart des dépassements ne viennent pas du « codage difficile ». Ils viennent de goulets d'étranglement quotidiens qui se cumulent : exigences floues, changement de contexte constant, boucles de revue lentes, et tests manuels réalisés trop tard.

Les goulots d'étranglement courants (et pourquoi ils coûtent cher)

Les exigences floues créent le coût le plus important en aval. Un petit malentendu tôt peut se transformer en une semaine de retravail plus tard — surtout quand plusieurs personnes interprètent différemment une même fonctionnalité.

Le changement de contexte est le tueur silencieux de productivité. Les ingénieurs basculent entre tickets, questions chat, réunions et incidents de production. Chaque bascule a un coût de reprise : recharger la base de code, l'historique des décisions et le « pourquoi ».

Les revues lentes ne retardent pas seulement les merges — elles retardent l'apprentissage. Si le feedback arrive quelques jours plus tard, l'auteur est déjà passé à autre chose et la correction prend plus de temps.

Les tests manuels et QA tardive font souvent remonter les problèmes au moment où ils coûtent le plus à corriger : après l'accumulation de plusieurs fonctionnalités, ou juste avant la release.

Les coûts cachés que l'on ne budgète pas

Les coûts évidents sont salaires et factures fournisseurs. Les coûts cachés frappent souvent plus fort :

- Retravail : réécrire du code et repenser des flux parce que les exigences ont changé ou ont été mal comprises.

- Retards : attente de décisions, approbations, environnements de test, ou d'une « personne clé ».

- Surenchère de coordination : synchronisation entre produit, design, ingénierie, QA, sécurité et parties prenantes.

Un flux simple idée → release (avec points douloureux)

Idée → exigences → design → build → revue → test → release → monitor

Points douloureux typiques : exigences (ambiguïté), développement (interruptions), revue (temps en file), test (effort manuel), release (transferts), monitor (diagnostic lent).

Diagnostic rapide : cartographie de la friction

Essayez une « carte de friction » en 30 minutes : listez chaque étape puis marquez (1) où le travail attend, (2) où les décisions stagnent, et (3) où le retravail a lieu. Ces zones marquées sont souvent celles où les outils IA créent les économies les plus rapides — en réduisant les malentendus, en accélérant le feedback et en coupant le travail manuel répétitif.

Découverte et exigences assistées par l'IA : moins de malentendus

La découverte est là où beaucoup de projets dérivent silencieusement : notes éparpillées, retours contradictoires, décisions dans la tête des gens. L'IA ne remplace pas les entretiens utilisateurs, mais elle peut réduire la « perte à la traduction » entre conversations, documents et ce que les ingénieurs construisent réellement.

Les équipes collectent souvent un tas de notes de recherche — transcriptions d'entretiens, tickets support, extraits d'appels commerciaux, réponses à des sondages — puis peinent à en extraire rapidement des motifs. Les outils IA peuvent accélérer cette étape en :

- Résumant de longues notes de recherche en conclusions cohérentes (points de douleur, objectifs, objections)

- Regroupant les retours par thèmes (ex. confusion à l'onboarding vs intégrations manquantes)

- Rédigeant des user stories initiales et des énoncés jobs-to-be-done à partir des entrées brutes

Cela ne crée pas la vérité automatiquement, mais fournit un point de départ clair, plus facile à critiquer, affiner et aligner.

Définir le périmètre et les critères d'acceptation plus tôt

Les malentendus apparaissent souvent plus tard sous forme de « ce n'est pas ce que je voulais ». L'IA aide en produisant rapidement des premiers jets de :

- Limites du périmètre (ce qui est inclus vs exclu pour cette release)

- Cas limites et scénarios « et si… » basés sur des schémas similaires

- Critères d'acceptation suffisamment spécifiques pour tester

Par exemple, si une exigence dit « les utilisateurs peuvent exporter des rapports », l'IA peut pousser l'équipe à préciser : formats (CSV/PDF), permissions, plages de dates, comportement des fuseaux horaires, et si les exports sont envoyés par email ou téléchargés. Obtenir ces réponses tôt réduit le churn pendant le développement et la QA.

Documentation cohérente et réellement utilisée

Quand les exigences vivent dans des docs, fils de chat et tickets, les équipes paient une « taxe de changement de contexte » constante. L'IA peut aider à maintenir un récit unique et lisible en rédigeant et en tenant à jour :

- Comptes rendus de réunions avec décisions et questions ouvertes

- Docs d'exigences et descriptions de tickets selon un template cohérent

- Glossaires pour les termes du domaine (afin que « compte », « workspace » et « org » ne se mélangent pas)

Le bénéfice est moins d'interruptions (« qu'avons-nous décidé ? ») et des transferts plus fluides entre produit, design, ingénierie et QA.

Gardes-fous : valider les hypothèses, ne pas les externaliser

Les sorties IA doivent être considérées comme des hypothèses, pas des exigences finales. Quelques gardes-fous simples :

- Toujours vérifier les résumés par rapport aux sources originales (surtout pour les citations et les chiffres)

- Marquer les éléments incertains comme questions, puis confirmer avec les utilisateurs et parties prenantes

- Garder la propriété des décisions au sein de l'équipe : l'IA rédige, les humains valident

Utilisée ainsi, la découverte assistée par l'IA réduit les malentendus sans affaiblir la responsabilité — en coupant coût, temps et friction avant qu'une seule ligne de code ne soit écrite.

Prototypage et itération de design plus rapides avec l'IA

Le prototypage est l'étape où de nombreuses équipes économisent des semaines — ou les gaspillent. L'IA rend moins coûteux l'exploration rapide d'idées, pour valider ce que veulent réellement les utilisateurs avant d'engager un cycle d'ingénierie complet.

Premiers jets rapides d'écrans et de parcours

Au lieu de partir d'une page blanche, vous pouvez demander à l'IA de générer :

- Des textes UI pour boutons, messages d'erreur, étapes d'onboarding et états vides (avec des options de ton : « convivial » vs « formel »)

- Des idées de wireframes sous forme de descriptions d'écran simples (ce qui est affiché, priorités)

- Des parcours utilisateurs types : « nouvel utilisateur s'inscrit → importe des données → définit un objectif → reçoit un rappel »

Ces brouillons ne sont pas le design final, mais donnent quelque chose de concret sur lequel réagir. Cela réduit les allers-retours du type « je pensais que tu voulais X » ou « nous ne sommes toujours pas alignés sur le flow ».

Applications de démonstration et POC rapides

Pour beaucoup de décisions produit, il n'est pas nécessaire d'avoir du code production pour apprendre. L'IA peut aider à assembler une application de démonstration ou un proof-of-concept qui montre :

- L'interaction centrale (ce que l'utilisateur clique et ce qu'il voit ensuite)

- Des données exemple et des cas limites réalistes

- Un « happy path » simple suffisant pour une revue interne ou des entretiens utilisateurs

Si vous voulez aller plus loin que des maquettes statiques, des plateformes de « vibe-coding » comme Koder.ai peuvent être utiles pour des itérations rapides : vous décrivez la fonctionnalité dans une interface de chat, générez un draft d'application web ou mobile fonctionnelle (souvent React pour le web et Flutter pour le mobile), puis l'affinez avec les parties prenantes avant d'engager un cycle d'ingénierie complet.

Où proviennent vraiment les économies de temps

Les économies les plus importantes ne viennent généralement pas du « temps de design ». Elles viennent d'éviter de construire intégralement la mauvaise chose. Lorsqu'un prototype révèle une confusion, des étapes manquantes ou une valeur incertaine, on peut ajuster la direction tant que les changements sont peu coûteux.

Précaution clé : ne pas livrer par erreur du code prototype

Les prototypes générés par l'IA sautent souvent des étapes importantes : contrôles de sécurité, accessibilité, performance, gestion d'erreurs appropriée, et structure maintenable. Traitez le code prototype comme jetable sauf si vous le renforcez délibérément — sinon vous risquez de transformer une expérimentation rapide en retravail long terme.

Si vous convertissez un prototype en fonctionnalité réelle, recherchez des workflows qui rendent cette transition explicite (par ex. : mode planning, snapshots, rollback). Cela aide les équipes à aller vite sans perdre la traçabilité.

Développement accéléré avec des assistants IA (et où ils aident le plus)

Les assistants de codage sont les plus utiles sur les tâches peu glamours : passer de « rien » à un point de départ fonctionnel, et éliminer le travail répétitif qui ralentit les équipes. Ils ne remplacent pas le jugement d'ingénieur — mais ils réduisent le temps entre une idée et une pull request prête à être revue.

Quand vous démarrez un nouvel endpoint, job ou flux UI, la première heure sert souvent à câbler, nommer et copier des patterns existants. Les assistants peuvent générer rapidement cette structure initiale : dossiers, fonctions basiques, gestion d'erreurs, logging et tests placeholders. Les ingénieurs passent ainsi plus de temps sur la logique produit et les cas limites, et moins sur le boilerplate.

Pour des équipes qui veulent aller au-delà de l'assistance dans l'éditeur, des plateformes comme Koder.ai emballent cela dans un workflow complet : depuis une spécification en chat jusqu'à une application exécutable avec des parties backend (souvent Go + PostgreSQL), plus des options d'export de code source et de déploiement/hosting. Le bénéfice pratique est de réduire le coût de coordination nécessaire pour « arriver à quelque chose qu'on peut revoir ».

Tâches où ils sont le plus adaptés

Ils performent mieux sur des travaux contenus et basés sur des patterns, surtout si votre base de code a des conventions claires :

- Scaffolding : nouvelles routes/controllers, écrans CRUD, commandes CLI, jobs en arrière-plan, wrappers SDK.

- Refactorings : renommage et réorganisation de modules, extraction de fonctions, gestion d'erreurs cohérente, mise à jour d'APIs dépréciées.

- Traductions : porter de petits composants entre langues/frameworks (ex. Python → TypeScript) avec des tests pour confirmer le comportement.

- Petites fonctionnalités : ajouts bien cadrés comme un filtre, export, webhook handler ou règle de validation.

- Outils internes : pages admin, scripts, correctifs de données, générateurs de rapports — forte valeur, faible polish UX.

Schémas de prompt qui produisent du code réutilisable

De bons prompts ressemblent moins à « écris la fonctionnalité X » et plus à une mini-spec. Incluez :

- Contexte : ce que fait le module, où il vit, APIs environnantes.

- Contraintes : librairies, règles de style, exigences de sécurité/perf.

- Exemples : fichiers similaires existants ou un exemple entrée/sortie.

- Tests d'acceptation : cas limites et vérifications « done means… » (même en langage naturel).

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

La revue est non négociable

Le code généré par l'IA nécessite toujours les mêmes standards : revue de code, revue sécurité et tests. Les développeurs restent responsables de la justesse, du traitement des données et de la conformité — considérez l'assistant comme un brouillon rapide, pas comme une autorité.

Réduction des cycles de revue et du retravail avec l'IA

La revue de code concentre beaucoup de coûts cachés : attente de feedback, réexpliquer l'intention, corriger les mêmes catégories de problèmes. L'IA ne remplace pas le jugement du relecteur, mais elle peut réduire le temps passé sur les vérifications mécaniques et les malentendus.

Un bon workflow IA assiste les relecteurs avant qu'ils n'ouvrent le PR :

- Résumer les changements : générer un résumé en langage clair de ce que fait le PR, quels fichiers ont changé et quel comportement est attendu. Cela aide les relecteurs à se concentrer plus vite et réduit les commentaires « mais qu'est-ce que je regarde ? ».

- Détecter des motifs risqués : signaler sources courantes de bugs — vérifs null manquantes, parsing de string unsafe, logique temporelle instable, erreurs non gérées, ou changements suspects de permissions.

- Suggérer des tests : proposer des cas de test spécifiques basés sur le diff (« ajouter un test pour entrée invalide », « asserter l'accès pour le rôle X », « couvrir le nouveau cas limite de pagination »).

Moins d'allers-retours

L'IA peut aussi améliorer clarté et cohérence, qui sont souvent la cause des ping-pong en review :

- Rédiger de meilleures descriptions de PR (motivation, approche, compromis)

- Faire appliquer la cohérence de nommage/formatage pour éviter des débats subjectifs

- Proposer de petits refactors qui rendent le code plus lisible, évitant de demander des réécritures majeures plus tard

Règles pratiques pour rester sûr

Utilisez l'IA pour accélérer la revue sans baisser les standards :

- Approbation humaine obligatoire pour chaque PR.

- Aligner les suggestions IA avec votre guide de style et vos règles de lint.

- Garder les PR petits et ciblés pour que les humains et l'IA puissent les comprendre.

Là où l'IA est encore faible

L'IA est la plus faible sur la logique métier et l'architecture : règles métier, cas limites liés aux utilisateurs réels, et compromis système demandent toujours du jugement expérimenté. Traitez l'IA comme l'assistant du relecteur — pas comme le relecteur.

IA dans les tests et la QA : déceler les problèmes plus tôt avec moins de travail manuel

Les tests sont l'endroit où de petits malentendus deviennent des surprises coûteuses. L'IA ne garantit pas la qualité, mais elle peut éliminer beaucoup de travail répétitif — pour que les humains se concentrent sur les cas qui cassent réellement le produit.

Génération automatique de tests : partir de chemins de code réels

Les outils IA peuvent proposer des tests unitaires en lisant le code existant et en identifiant les chemins d'exécution courants (le « happy path »), plus les branches faciles à oublier (gestion d'erreur, entrées null/vides, retries, timeouts). Si vous fournissez aussi une courte spec ou des critères d'acceptation, l'IA peut suggérer des cas limites directement tirés des exigences — par ex. valeurs aux frontières, formats invalides, vérif permissions, et « et si le service en amont est down ? ».

La meilleure utilisation est l'accélération : obtenir un premier brouillon de tests rapidement, puis laisser les ingénieurs ajuster les assertions pour coller aux règles métiers réelles.

Jeu de données de test, mocks et fixtures plus rapides

Un poste de temps surprenant en QA est la création de données réalistes et le câblage des mocks. L'IA peut aider à :

- Générer des enregistrements représentatifs (y compris des cas « bizarres ») qui respectent les règles de validation

- Écrire des mocks/stubs pour services externes avec des réponses prévisibles

- Créer des fixtures réutilisables qui raccourcissent et clarifient les tests

Cela accélère les tests unitaires écrits par les devs et les tests d'intégration, surtout quand de nombreuses APIs sont impliquées.

Meilleurs rapports de bugs : corrections plus claires et plus rapides

Quand un problème arrive en QA ou production, l'IA peut améliorer le rapport de bug en transformant des notes désordonnées en étapes de reproduction structurées, et en séparant clairement attendu vs constaté. Avec des logs ou une sortie console, elle peut résumer les motifs (ce qui a échoué en premier, ce qui s'est répété, ce qui corrèle avec la défaillance) pour que les ingénieurs ne passent pas la première heure à comprendre le rapport.

Contrôles qualité (non négociables)

Les tests générés par l'IA doivent rester :

- Significatifs : assertions liées à de vraies exigences, pas « ça ne plante pas »

- Déterministes : pas de temporisation aléatoire, graines pseudo-aléatoires non contrôlées, ou dépendances externes instables

- Maintenus : traités comme du code production — revus, bien nommés, et mis à jour quand le comportement change

Utilisée ainsi, l'IA réduit l'effort manuel tout en aidant les équipes à détecter les problèmes plus tôt — quand les corrections sont les moins chères.

Release et exploitation : moins d'attente, diagnostic plus rapide

Le travail de release est l'endroit où les « petits retards » se cumulent : pipeline instable, erreur peu claire, variable de config manquante, ou transfert lent entre dev et ops. Les outils IA aident à réduire le temps entre « quelque chose a cassé » et « nous savons quoi faire ensuite ».

IA pour CI/CD et DevOps

Les systèmes CI/CD modernes produisent beaucoup de signaux (logs de builds, sorties de tests, événements de déploiement). L'IA peut résumer ce bruit en une vue courte et actionnable : ce qui a échoué, où cela est apparu en premier, et ce qui a changé récemment.

Elle peut aussi suggérer des corrections probables en contexte — par ex. signaler un mismatch de version dans une image Docker, une étape mal ordonnée dans un workflow, ou une variable d'environnement manquante — sans que vous n'ayez à parcourir des centaines de lignes.

Si vous utilisez une plateforme end-to-end comme Koder.ai pour construire et héberger, des fonctionnalités opérationnelles comme les snapshots et rollback peuvent aussi réduire le risque de release : les équipes peuvent expérimenter, déployer et revenir en arrière rapidement quand la réalité diverge du plan.

Support d'incident : hypothèses et checklists plus rapides

Pendant un incident, la vitesse compte surtout dans les 15–30 premières minutes. L'IA peut :

- Rédiger des hypothèses de cause racine à partir des logs, alertes et déploiements récents

- Générer une checklist de remédiation (rollback, désactiver feature-flag, augmenter la capacité, vider une file, valider les connexions DB)

- Proposer des commandes/requêtes ciblées pour confirmer ou éliminer chaque hypothèse

Cela réduit la charge d'astreinte en accélérant le triage — sans remplacer les humains responsables du service. La propriété et l'accountability restent avec l'équipe.

Notes de sécurité (à ne pas négliger)

L'IA n'est utile que si elle est utilisée de manière sûre :

- Ne collez pas de secrets (API keys, tokens, données clients) dans les prompts — utilisez la redaction et le principe du moindre privilège.

- Traitez les sorties IA comme des suggestions, pas comme des changements automatiques. Revue de code, approbations et gestion des changements restent applicables.

- Privilégiez des outils qui peuvent travailler sur des logs sanitizés et qui conservent des pistes d'audit pour la conformité.

Documentation et partage de connaissances : moins d'interruptions et de transferts

Une bonne documentation est l'un des moyens les moins coûteux de réduire la friction — pourtant elle est souvent délaissée quand les délais se resserrent. Les outils IA aident en transformant la doc de « tâche à faire plus tard » en partie légère et répétable du travail quotidien.

Ce que l'IA peut accélérer (sans remplacer la responsabilité)

Les gains rapides se trouvent dans la documentation qui suit des patrons clairs :

- Docs API : générer descriptions d'endpoints, exemples requête/réponse et tableaux d'erreurs à partir de specs ou commentaires de code.

- Runbooks : rédiger des playbooks d'incident étape-par-étape à partir de tickets passés et de postmortems.

- Changelogs et notes de release : résumer les PR mergés en versions destinées aux clients et en internes.

- Guides d'onboarding : créer des checklists pour la première semaine, des vues d'ensemble des services et des glossaires à partir de la structure du repo et des docs existantes.

L'IA produit un bon premier jet ; les humains confirment ce qui est vrai, ce qui est sûr à partager et ce qui est important.

Moins d'interruptions, moins de goulets

Quand la doc est recherchable et à jour, l'équipe répond moins aux questions répétées comme « où est la config ? » ou « comment lancer ça en local ? ». Cela réduit le changement de contexte, protège le temps de concentration et empêche la connaissance de rester collée à une seule personne.

Des docs bien maintenues réduisent aussi les transferts : les nouvelles recrues, la QA, le support et les stakeholders non techniques peuvent s'auto-servir au lieu d'attendre un ingénieur.

Un workflow pratique qui tient

Un pattern simple marche pour beaucoup d'équipes :

- Générer des mises à jour de doc depuis les PRs (résumé + ce qui a changé + comment tester)

- Édition et vérification humaines (exactitude, sécurité, adéquation audience)

- Versionner les docs dans le repo aux côtés du code, pour que les changements soient revus et livrés ensemble

Accessibilité pour lecteurs non techniques

L'IA peut réécrire des notes denses dans un langage plus clair, ajouter des titres cohérents et standardiser la structure des pages. Cela rend la documentation utilisable au-delà de l'ingénierie — sans demander aux ingénieurs de devenir des rédacteurs professionnels.

Le ROI devient flou si vous ne demandez que « avons-nous livré plus vite ? ». Une approche plus claire consiste à tarifer les leviers concrets touchés par l'IA, puis à comparer une base de référence à une exécution « avec IA » du même workflow.

Cartographier vos vrais moteurs de coût

Commencez par lister les catégories qui bougent réellement pour votre équipe :

- Heures d'ingénierie : build, revue, test, correction, retravail.

- Dépenses cloud : environnements laissés actifs, pipelines lents, exécutions de tests répétées.

- Abonnements outils : licences IA, outils de test, monitoring, design.

- Charge support : réponse aux incidents, triage de bugs, tickets clients.

- Coût du retard : revenus reportés, pénalités contractuelles, coût d'opportunité.

Une estimation baseline vs avec-IA simple

Choisissez une feature ou un sprint et décomposez le temps par phase. Ensuite mesurez deux chiffres par phase : heures moyennes sans IA vs avec IA, plus tout nouveau coût d'outil.

Une formule légère :

Savings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost

ROI % = Savings / Tool_cost × 100

Vous n'avez pas besoin d'un suivi parfait — utilisez des journaux de temps, temps de cycle PR, nombre de rounds de revue, taux de flakiness des tests et lead time to deploy comme proxys.

N'ignorez pas le « coût du risque »

L'IA peut aussi introduire des coûts si elle est mal gérée : exposition de sécurité, problèmes de licence/IP, lacunes de conformité, ou baisse de qualité du code. Estimez-les comme un coût attendu :

- Risk cost = Probability × Impact (ex. retravail après une faille sécurité, temps de remédiation pour un audit).

Commencez petit, puis montez en échelle

Démarrez par un workflow (par ex. génération de tests ou clarification des exigences). Exécutez-le 2–4 semaines, enregistrez les métriques avant/après, puis étendez. Cela transforme l'adoption IA en cycle d'amélioration mesurable, pas en achat basé sur la foi.

L'IA peut enlever beaucoup de travail répétitif, mais elle introduit aussi de nouveaux modes de défaillance. Traitez la sortie IA comme un fort autocomplete : utile pour accélérer, pas source de vérité.

Principaux risques à anticiper

D'abord, sorties incorrectes ou incomplètes. Les modèles peuvent paraître convaincants tout en omettant des cas limites, en inventant des APIs, ou en produisant du code qui passe un test happy-path mais échoue en production.

Ensuite, fuites de sécurité. Coller des secrets, des données clients, des logs d'incidents ou du code propriétaire dans des outils non approuvés peut créer des expositions accidentelles. Il y a aussi le risque de générer des patterns de code insecure (auth fragile, désérialisation unsafe, requêtes sujettes à injection).

Troisièmement, licences/IP. Le code généré peut rappeler des extraits protégés par le droit d'auteur ou introduire des dépendances avec des licences incompatibles si les développeurs copient sans vigilance.

Quatrièmement, décisions biaisées ou inconsistantes. L'IA peut orienter la priorisation, la formulation ou l'évaluation d'une manière qui exclut involontairement des utilisateurs ou viole des politiques internes.

Garde-fous pratiques pour préserver la vélocité

Faites de la revue humaine une règle, pas une suggestion : exigez la revue de code pour les changements générés par l'IA, et demandez aux relecteurs de vérifier sécurité, gestion d'erreurs et tests — pas seulement le style.

Ajoutez une politique d'accès légère : outils approuvés uniquement, SSO, permissions basées sur les rôles, et règles claires sur quelles données peuvent être partagées.

Conservez des pistes d'audit : logguez les prompts et sorties dans des environnements approuvés quand c'est possible, et notez quand l'IA a été utilisée pour exigences, code ou tests.

Principes de base pour la gestion des données

Évitez d'envoyer des données sensibles (PII, identifiants, logs de production, contrats clients) vers des outils généralistes. Préférez des environnements approuvés, la redaction et des exemples synthétiques.

En résumé

Les sorties IA sont des suggestions, pas des garanties. Avec des gardes-fous — revue, politique, contrôle d'accès et traçabilité — vous pouvez capter des gains de vitesse sans sacrifier la sécurité, la qualité ou la conformité.

Une feuille de route d'adoption pratique pour des équipes de toute taille

Adopter des outils IA fonctionne mieux si vous le traitez comme tout changement de processus : commencer petit, standardiser ce qui marche, et étendre avec des gardes-fous clairs. L'objectif n'est pas « utiliser l'IA partout » mais supprimer les allers-retours évitables, le retravail et les attentes.

Phase 1 : Pilote (1–2 semaines)

Choisissez une équipe et un workflow où l'erreur est peu risquée mais les gains en temps visibles (ex. rédiger des user stories, générer des cas de test, refactorer un petit module). Limitez le périmètre et comparez au baseline habituel.

Phase 2 : Standards (légers, pas bureaucratiques)

Rédigez ce que « bon usage de l'IA » signifie pour votre équipe :

- Templates de prompt : prompts courts et réutilisables pour tâches courantes (clarification d'exigences, notes de revue, ébauches de tests).

- Checklist de revue : ce que les humains doivent vérifier (exactitude, sécurité, cas limites, alignement).

- Liste Do/Don't :

- Do : fournir contexte, contraintes, critères d'acceptation et exemples.

- Don't : coller des secrets, credentials de prod, ou données propriétaires non autorisées.

Apprenez aux gens à poser de meilleures questions et à valider les sorties. Concentrez-vous sur des scénarios pratiques : « transformer une exigence vague en critères d'acceptation testables » ou « générer un plan de migration puis vérifier les risques ».

Phase 4 : Automatisation (là où la répétition fait mal)

Quand l'équipe fait confiance au workflow, automatisez les parties répétitives : brouillons de descriptions de PR, scaffolding de tests, release notes, triage de tickets. Gardez une étape d'approbation humaine pour tout ce qui est livré.

Si vous évaluez des plateformes, voyez si elles supportent des fonctions d'itération sûre (par ex. mode planning, snapshots, rollback) et des options pratiques d'adoption (comme l'export du code source). C'est un domaine où Koder.ai se positionne pour s'intégrer aux attentes d'ingénierie : aller vite, tout en gardant le contrôle.

Phase 5 : Amélioration continue

Révisez templates et règles chaque mois. Retirez les prompts qui n'aident pas, et n'étendez les standards que quand vous voyez des modes de défaillance récurrents.

Métriques à suivre (pour que le ROI ne soit pas du domaine de l'approximation)

Suivez quelques indicateurs de façon cohérente :

- Cycle time (idée → déployé)

- Temps de revue (PR ouvert → mergé)

- Taux de défauts (bugs en production + bugs détectés en QA)

- % de retravail (tickets rouverts, churn, changements répétés)

- Satisfaction de l'équipe (sondage rapide)

Checklist à utiliser sur votre prochain projet

Si vous publiez les apprentissages de votre pilote, cela vaut souvent la peine de formaliser cela en guidance interne ou en article public — beaucoup d'équipes trouvent que documenter les métriques avant/après transforme l'adoption IA d'une expérimentation en une pratique reproductible. (Certaines plateformes, y compris Koder.ai, proposent aussi des programmes où les équipes peuvent gagner des crédits en partageant du contenu pratique ou en parrainant d'autres utilisateurs, ce qui peut compenser les coûts outils au démarrage.)