Ce que signifie « dominance x86 » dans cet article

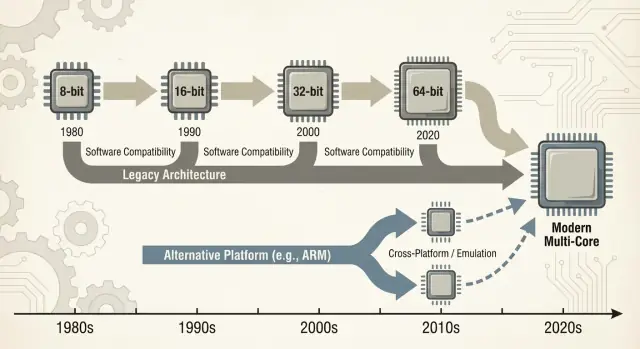

Quand on parle de « x86 », on entend généralement une famille d'instructions CPU qui a commencé avec la puce 8086 d'Intel et a évolué pendant des décennies. Ces instructions sont les verbes de base qu'un processeur comprend — additionner, comparer, déplacer des données, etc. Cet ensemble d'instructions s'appelle une ISA (instruction set architecture). On peut voir l'ISA comme le « langage » que le logiciel doit parler pour s'exécuter sur un type de CPU donné.

Définitions en langage courant

x86 : L'ISA la plus répandue sur les PC pendant la majeure partie des 40 dernières années, mise en œuvre principalement par Intel et aussi par AMD.

Compatibilité ascendante : La capacité des ordinateurs récents à continuer d'exécuter des logiciels plus anciens (parfois vieux de décennies) sans réécritures majeures. Ce n'est pas parfait dans tous les cas, mais c'est la promesse directrice du monde PC : « Vos trucs doivent continuer à fonctionner. »

Ce que « dominance » signifie ici

« Dominance » n'est pas juste une revendication de performance. C'est un avantage pratique et cumulatif sur plusieurs dimensions :

- Volume : d'énormes quantités de puces x86 expédiées dans les desktops, laptops et serveurs.

- Support logiciel : l'un des plus grands catalogues d'apps, jeux, logiciels d'entreprise et outils pour développeurs, écrits d'abord (ou mieux) pour x86.

- Notoriété : l'hypothèse par défaut — pour acheteurs, départements IT et développeurs — qu'un « ordinateur normal » est x86 sauf indication contraire.

Cette combinaison compte parce que chaque couche renforce les autres. Plus de machines encourage plus de logiciels ; plus de logiciels encouragent plus de machines.

Remplacer une ISA dominante n'est pas comme changer un composant. Cela peut casser — ou au moins compliquer — les applications, les pilotes (imprimantes, GPU, audio, périphériques niche), les chaînes d'outils pour développeurs, et même les habitudes quotidiennes (images système, scripts IT, agents de sécurité, pipelines de déploiement). Beaucoup de ces dépendances restent invisibles jusqu'à ce que quelque chose échoue.

Portée de la discussion

Cet article se concentre principalement sur les PC et serveurs, où x86 a longtemps été la norme. Nous ferons aussi référence à des transitions récentes — en particulier les transitions ARM — car elles offrent des leçons modernes faciles à comparer sur ce qui change en douceur, ce qui ne change pas, et pourquoi « il suffit de recompiler » est rarement toute l'histoire.

Le marché PC naissant n'a pas commencé avec un grand plan architectural : il a commencé avec des contraintes pratiques. Les entreprises voulaient des machines abordables, disponibles en volume et faciles à réparer. Cela a poussé les vendeurs vers des CPUs et des composants pouvant être sourcés de manière fiable, associés à des périphériques standards, et assemblés sans ingénierie sur mesure.

CPUs abordables + composants standards

Le design original du PC d'IBM s'appuyait fortement sur des composants standard et un processeur Intel de type 8088 relativement peu coûteux. Ce choix importait parce qu'il faisait du « PC » moins un produit unique qu'une recette : une famille de CPU, un ensemble d'emplacements d'extension, une approche clavier/écran et une pile logicielle reproductible.

Clones, seconds sources et marché plus large

Une fois que l'IBM PC a prouvé l'existence d'une demande, le marché s'est étendu via le clonage. Des compagnies comme Compaq ont montré qu'on pouvait construire des machines compatibles qui exécutaient les mêmes logiciels — et les vendre à différents prix.

Tout aussi important fut la fabrication en seconde source : plusieurs fournisseurs pouvaient fournir des processeurs ou composants compatibles. Pour les acheteurs, cela réduisait le risque de parier sur un seul fournisseur. Pour les OEM, cela augmentait l'offre et la concurrence, accélérant l'adoption.

« Il exécute les mêmes programmes » est devenu la règle d'achat

Dans cet environnement, la compatibilité est devenue la caractéristique que les gens comprenaient et appréciaient. Les acheteurs n'avaient pas besoin de savoir ce qu'était un jeu d'instructions ; ils devaient seulement savoir si Lotus 1-2-3 (puis les applications Windows) fonctionneraient.

La disponibilité logicielle est rapidement devenue un heuristique d'achat simple : si ça exécute les mêmes programmes que les autres PC, c'est un choix sûr.

Les standards ont silencieusement renforcé l'élan

Les conventions matérielles et firmware ont fait beaucoup de travail invisible. Bus communs et approches d'extension — ainsi que les attentes BIOS/firmware et comportements système partagés — ont rendu plus facile pour les fabricants hardware et les développeurs logiciels de cibler « le PC » comme plateforme stable.

Cette stabilité a contribué à ancrer x86 comme la base par défaut sous un écosystème en croissance.

Le volant d'inertie de l'écosystème logiciel

x86 n'a pas gagné uniquement grâce à des vitesses d'horloge ou des puces ingénieuses. Il a gagné parce que le logiciel a suivi les utilisateurs, et les utilisateurs ont suivi le logiciel — un « effet de réseau » économique qui se cumule dans le temps.

L'effet de réseau : plus d'utilisateurs → plus d'apps → plus d'utilisateurs

Quand une plateforme prend une avance précoce, les développeurs voient un public plus large et une voie plus claire vers des revenus. Cela produit plus d'applications, un meilleur support et plus d'extensions tierces. Ces améliorations rendent la plateforme encore plus attractive pour la vague suivante d'acheteurs.

Répétez cette boucle pendant des années et la plateforme « par défaut » devient difficile à déloger — même si des alternatives sont techniquement séduisantes.

C'est pourquoi les transitions de plateforme ne concernent pas seulement la construction d'un CPU. Elles concernent la recréation d'un écosystème entier : apps, installateurs, canaux de mise à jour, périphériques, processus IT et le savoir‑faire collectif de millions d'utilisateurs.

Les entreprises conservent souvent des applications critiques longtemps : bases de données internes, outils maison, add‑ons ERP, logiciels spécifiques à un secteur et macros de flux de travail que personne ne veut toucher parce qu'elles « fonctionnent ». Une cible x86 stable signifiait :

- Mises à niveau prévisibles (les nouveaux PC exécutaient encore les anciens logiciels)

- Cycles de vie matériels plus longs

- Moins de surprises pour les help desks et les budgets de formation

Même si une nouvelle plateforme promettait des coûts plus faibles ou de meilleures performances, le risque de casser un flux de revenus existant l'emportait souvent sur l'avantage.

Les développeurs n'optimisent rarement pour la « meilleure » plateforme en théorie. Ils optimisent pour la plateforme qui minimise la charge de support et maximise la portée.

Si 90 % de vos clients sont sur x86 Windows, c'est là que vous testez en premier, expédiez en premier et corrigez les bugs le plus vite. Supporter une seconde architecture signifie des pipelines de build supplémentaires, plus de matrices QA, plus de débogage « ça marche sur ma machine » et plus de scripts de support client.

Le résultat : un fossé auto‑renforçant — la plateforme leader reçoit en général de meilleurs logiciels, plus rapidement.

Un exemple simple : logiciel de comptabilité et pilotes d'imprimante

Imaginez une petite entreprise. Son logiciel de comptabilité est uniquement x86, intégré avec une décennie de modèles et un plugin pour la paie. Elle dépend aussi d'une imprimante d'étiquettes spécifique et d'un scanner documentaire aux pilotes capricieux.

Proposez maintenant un changement de plateforme. Même si le cœur des applis existe, les pièces périphériques comptent : le pilote d'imprimante, l'utilitaire du scanner, le plugin PDF, le module d'import bancaire. Ces dépendances « ennuyeuses » deviennent indispensables — et quand elles manquent ou sont instables, la migration cale.

C'est le volant d'inertie en action : la plateforme gagnante accumule la longue traîne de compatibilités dont tout le monde dépend silencieusement.

La compatibilité ascendante comme stratégie produit

La compatibilité ascendante n'a pas été juste une heureuse caractéristique du x86 — elle est devenue une stratégie produit délibérée. Intel a maintenu l'ISA x86 suffisamment stable pour que le logiciel écrit des années plus tôt puisse toujours s'exécuter, tout en changeant presque tout dessous.

La microarchitecture évolue ; l'ISA reste surtout

La distinction clé est ce qui est resté compatible. L'ISA définit les instructions machine sur lesquelles les programmes comptent ; la microarchitecture est la manière dont une puce les exécute.

Intel a pu passer de pipelines simples à l'exécution out‑of‑order, ajouter de plus grands caches, améliorer la prédiction de branchement ou introduire de nouvelles technologies de fabrication — sans demander aux développeurs de réécrire leurs applis.

Cette stabilité a créé une attente puissante : les nouveaux PC doivent exécuter les logiciels anciens dès le premier jour.

Ajouter de la puissance sans casser l'ancien code

x86 a accumulé de nouvelles capacités par couches. Des extensions d'instructions comme MMX, SSE, AVX et des fonctionnalités ultérieures ont été additives : les anciens binaires fonctionnaient toujours, et les applis plus récentes pouvaient détecter et utiliser ces nouvelles instructions quand elles étaient disponibles.

Même des transitions majeures ont été lissées par des mécanismes de compatibilité :

- Modes legacy qui préservent d'anciens environnements d'exécution (par ex. compatibilité 16‑bits et 32‑bits sur des processeurs ultérieurs).

- Protected et long mode qui permettent aux OS modernes d'utiliser plus de mémoire et des fonctions de sécurité tout en supportant des applis anciennes.

- Extensions de virtualisation (comme Intel VT‑x) qui facilitent l'exécution d'anciens OS ou de workloads isolés efficacement.

Le compromis : le legacy devient une contrainte

L'inconvénient est la complexité. Supporter des comportements datant de décennies implique plus de modes CPU, plus de cas limites et une charge de validation plus lourde. Chaque nouvelle génération doit prouver qu'elle exécute encore les applications, pilotes ou installateurs d'hier.

Avec le temps, « ne pas casser les applis existantes » cesse d'être une simple directive et devient une contrainte stratégique : elle protège la base installée, mais rend aussi les changements radicaux — nouvelles ISA, nouveaux designs système, nouvelles hypothèses — beaucoup plus difficiles à justifier.

La boucle Wintel : OS, hardware et incitations OEM

« Wintel » n'était pas juste un label accrocheur pour Windows et les puces Intel. Il décrivait une boucle auto‑renforçante où chaque partie de l'industrie PC bénéficiait de s'en tenir à la même cible par défaut : Windows sur x86.

Pourquoi Windows + x86 est devenu la cible applicative par défaut

Pour la plupart des éditeurs grand public et entreprises, la question pratique n'était pas « quelle est la meilleure architecture ? » mais « où sont les clients, et à quoi ressembleront les appels de support ? »

Les PCs Windows étaient largement déployés dans les foyers, bureaux et écoles, et ils étaient majoritairement basés sur x86. Expédier pour cette combinaison maximisait la portée tout en minimisant les surprises.

Une fois qu'une masse critique d'applications supposait Windows + x86, les nouveaux acheteurs avaient une autre raison de le choisir : leurs logiciels indispensables fonctionnaient déjà là. Cela rendait la plateforme encore plus attractive pour les développeurs suivants.

OEMs, périphériques et le volant d'inertie des pilotes

Les fabricants de PC réussissent lorsqu'ils peuvent construire de nombreux modèles rapidement, sourcer des composants auprès de multiples fournisseurs et expédier des machines qui « fonctionnent tout de suite ». Une base commune Windows + x86 simplifiait cela.

Les fabricants de périphériques ont suivi le volume. Si la plupart des acheteurs utilisaient des PC Windows, alors imprimantes, scanners, interfaces audio, puces Wi‑Fi et autres devices privilégieraient d'abord les pilotes Windows. Une meilleure disponibilité des pilotes améliorait l'expérience Windows PC, ce qui aidait les OEM à vendre davantage d'unités, maintenant ainsi un volume élevé.

Réalité des achats : le risque le plus faible gagne souvent

Les achats d'entreprise et gouvernementaux favorisent la prévisibilité : compatibilité avec les applis existantes, coûts de support gérables, garanties fournisseurs et outils de déploiement éprouvés.

Même lorsque des alternatives semblaient séduisantes, le choix à moindre risque gagnait souvent parce qu'il réduisait la formation, évitait les échecs de cas limites et s'intégrait aux processus IT établis.

Le résultat n'était pas une conspiration mais un ensemble d'incitations alignées — chaque participant choisissant le chemin qui réduisait les frictions — créant un momentum qui rendait le changement de plateforme extraordinairement difficile.

Ciblez la longue traîne

Utilisez le Planning Mode pour cartographier fonctionnalités, risques et dépendances avant de reconstruire.

Une « transition de plateforme » n'est pas seulement le remplacement d'un CPU par un autre. C'est un déménagement en bundle : l'ISA du CPU, le système d'exploitation, le compilateur/chaîne d'outils qui construit les applis et la pile de pilotes qui fait fonctionner le hardware. Changer l'un d'eux dérange souvent les autres.

Les dépendances cachées que vous ne voyez pas avant qu'elles n'échouent

La plupart des cassures ne sont pas des échecs dramatiques « l'application ne se lance pas ». C'est la mort par mille coupures :

- Installateurs et updaters qui supposent une certaine version de Windows, une disposition du registre ou un runtime x86.

- Protection anticopie et gestionnaires de licence liés à des IDs hardware spécifiques, des pilotes noyau ou des hypothèses de temporisation bas‑niveau.

- Plug‑ins, add‑ins et extensions (pensez aux plugins CAD, VST audio, helpers de navigateur) compilés pour une architecture.

- Macros et automatisations dans Office, écrans ERP ou applications internes qui reposent sur des chemins de fichiers exacts, des objets COM ou des API dépréciées.

Même si le cœur de l'application a une nouvelle build, sa « colle » périphérique peut ne pas en avoir.

Périphériques : le bloqueur de montée de version que personne ne budgète

Imprimantes, scanners, imprimantes d'étiquettes, cartes PCIe/USB spécialisées, dispositifs médicaux, équipements de point de vente et dongles USB vivent et meurent par les pilotes. Si le fournisseur a disparu — ou est simplement désintéressé — il n'y aura peut‑être pas de pilote pour le nouvel OS ou la nouvelle architecture.

Dans beaucoup d'entreprises, un périphérique à 200 $ peut immobiliser une flotte d'ordinateurs à 2 000 $.

Le problème de la longue traîne logicielle

Le plus gros obstacle est souvent les outils internes « petits » : une base Access personnalisée, un classeur Excel avec macros, une appli VB écrite en 2009, un utilitaire de production niche utilisé par trois personnes.

Ce ne sont pas des éléments sur la feuille de route produit, mais ils sont critiques. Les transitions échouent lorsque la longue traîne n'est pas migrée, testée et prise en charge par quelqu'un.

L'économie réelle du changement

Une transition de plateforme ne se juge pas seulement aux benchmarks. Elle se mesure à la facture totale — argent, temps, risque et perte d'élan — qui doit rester inférieure au bénéfice perçu. Pour la plupart, cette facture est plus élevée qu'on ne le croit depuis l'extérieur.

La facture utilisateur : temps, habitudes et petites cassures

Pour les utilisateurs, le coût de changement commence par l'évidence (nouveau matériel, nouveaux périphériques, nouvelles garanties) et glisse vite vers le désordonné : réapprendre des gestes, reconfigurer des workflows et revalider les outils quotidiens.

Même quand une appli « fonctionne », les détails peuvent changer : un plugin ne se charge plus, un pilote d'imprimante manque, une macro se comporte différemment, un anti‑cheat de jeu signale quelque chose, ou un accessoire niche cesse de marcher. Chacun est mineur ; tous ensemble ils effacent la valeur de la mise à niveau.

La facture du fournisseur : explosion de la QA et charge de support

Les éditeurs paient la transition par une matrice de test qui explose. Ce n'est pas seulement « ça se lance ? » mais :

- différentes versions d'OS et canaux de mise à jour

- différentes générations et jeux de fonctionnalités CPU

- pilotes, firmwares et outils de sécurité

- politiques d'entreprise et modes de verrouillage

Chaque combinaison ajoute du temps QA, plus de documentation à maintenir et plus de tickets de support. Une transition peut transformer une cadence de release prévisible en un cycle permanent de gestion d'incidents.

La facture du développeur : ports, perf et confiance

Les développeurs absorbent le coût des ports de bibliothèques, de la réécriture de code critique pour la perf (souvent optimisé à la main pour une ISA), et de la reconstruction des tests automatisés. Le plus dur est de restaurer la confiance : prouver que la nouvelle build est correcte, suffisamment rapide et stable sous des charges réelles.

Le tueur caché : le coût d'opportunité

Le travail de migration entre en concurrence directe avec les nouvelles fonctionnalités. Si une équipe passe deux trimestres à remettre les choses « en état de marche », ce sont deux trimestres où elle n'améliore pas le produit.

Beaucoup d'organisations ne basculent que lorsque l'ancienne plateforme les bloque — ou quand la nouvelle est si convaincante qu'elle justifie ce coût d'opportunité.

Ponts : émulation, traduction et virtualisation

Gardez le contrôle du code

Obtenez l'export du code source pour que votre équipe garde tout dans votre dépôt.

Quand une nouvelle architecture CPU arrive, les utilisateurs ne demandent pas l'ISA ; ils demandent si leurs applis s'ouvrent encore. C'est pourquoi les « ponts » comptent : ils permettent aux nouvelles machines d'exécuter les vieux logiciels le temps que l'écosystème rattrape.

Émulation vs traduction : maintenir les anciennes applis en vie

Émulation imite tout un CPU en logiciel. C'est l'option la plus compatible, mais généralement la plus lente car chaque instruction est « mimée » plutôt qu'exécutée directement.

La traduction binaire (souvent dynamique) réécrit des blocs de code x86 en instructions natives de la nouvelle CPU pendant l'exécution. C'est souvent ainsi que de nombreuses transitions modernes offrent une histoire « jour un » : installez vos applis existantes, et une couche de compatibilité les traduit silencieusement.

La valeur est simple : on peut acheter du nouveau matériel sans attendre que tous les fournisseurs recompilent.

Pourquoi ce n'est jamais parfait

Les couches de compatibilité marchent mieux pour les applications grand public et bien‑comportées — et peinent sur les bords :

- Falaises de performance : une charge peut être acceptable jusqu'à ce qu'elle rencontre du SIMD intensif, des compilateurs JIT ou des boucles serrées qui traduisent mal.

- Cas limites : protection anticopie, hypothèses de temporisation bas‑niveau ou code auto‑modifiant peuvent casser.

- Pilotes et composants noyau : on peut traduire une appli, mais on ne peut pas « traduire » un pilote d'imprimante manquant ou une extension noyau legacy.

Souvent le support matériel est le vrai blocage.

Virtualisation : un pont partiel pour le logiciel métier

La virtualisation aide quand on a besoin d'un environnement legacy complet (une version Windows spécifique, une ancienne pile Java, une appli métier). C'est propre opérationnellement — snapshots, isolation, rollback facile — mais cela dépend de ce que vous virtualisez.

Les VMs sur la même architecture peuvent être quasi‑natives ; les VMs inter‑architectures retombent souvent sur l'émulation et ralentissent.

Quand « assez bon » est‑il vraiment suffisant ?

Un pont suffit généralement pour les applis bureautiques, navigateurs et la productivité quotidienne — là où « assez rapide » l'emporte. C'est plus risqué pour :

- périphériques et pilotes spécialisés

- pipelines audio/vidéo à faible latence

- calcul haute performance ou graphismes lourds

En pratique, les ponts achètent du temps — mais éliminent rarement tout le travail de migration.

Les arguments sur les CPU ressemblent souvent à un seul tableau de scores : « le plus rapide gagne ». En réalité, les plateformes gagnent quand elles correspondent aux contraintes des appareils et des charges que les gens exécutent.

x86 est devenu la norme pour les PC en partie parce qu'il offrait de solides performances pics sur l'alimentation secteur, et parce que l'industrie a tout construit autour de cette hypothèse.

Les acheteurs desktop/laptop ont historiquement récompensé la réactivité interactive : lancement d'apps, compilations, jeux, grands tableurs. Cela pousse les vendeurs vers de hauts clocks, des cœurs larges et des comportements turbo agressifs — excellents quand on peut dépenser des watts.

L'efficacité énergétique est un jeu différent. Si votre produit est limité par la batterie, la chaleur, le bruit de ventilateur ou un châssis fin, le meilleur CPU est celui qui fait « assez » par watt, de manière constante, sans throttling.

L'efficacité n'est pas seulement économie d'énergie ; c'est rester dans les limites thermiques pour que les performances ne s'effondrent pas après une minute.

Pourquoi le mobile a favorisé d'autres architectures

Téléphones et tablettes vivent dans des enveloppes de puissance serrées et ont toujours été sensibles aux coûts à grande échelle. Cet environnement a récompensé les designs optimisés pour l'efficacité, des composants intégrés et un comportement thermique prévisible.

Il a aussi créé un écosystème où OS, applis et silicium ont évolué ensemble sous des hypothèses « mobile‑first ».

Serveurs : maturité et fiabilité avant la vitesse brute

Dans les centres de données, le choix CPU est rarement une décision basée uniquement sur les benchmarks. Les opérateurs se soucient des fonctionnalités de fiabilité, des fenêtres de support longues, des firmwares stables, du monitoring et d'un écosystème mature de pilotes, hyperviseurs et outils de gestion.

Même quand une nouvelle architecture est séduisante en perf/watt, le risque de surprises opérationnelles peut l'emporter sur l'avantage.

Les charges serveurs modernes sont diverses : le web favorise un haut débit et une scalabilité efficace ; les bases de données récompensent la bande passante mémoire, la consistance des latences et les pratiques de tuning éprouvées ; l'IA déplace de plus en plus la valeur vers des accélérateurs et des stacks logiciels.

À mesure que le mix change, la plateforme gagnante peut changer aussi — mais seulement si l'écosystème autour peut suivre.

Outils et distribution : les gardiens discrets

Une nouvelle architecture CPU peut être techniquement excellente et quand même échouer si les outils du quotidien ne facilitent pas la construction, la livraison et le support du logiciel. Pour la plupart des équipes, la « plateforme » n'est pas seulement l'ISA — c'est toute la chaîne de livraison.

Compilateurs, débogueurs, profileurs et bibliothèques de base façonnent silencieusement le comportement des développeurs. Si les meilleurs flags du compilateur, les traces de pile, les sanitizers ou les outils de perf arrivent tard (ou se comportent différemment), les équipes hésitent à parier leurs releases dessus.

Même de petits manques comptent : une bibliothèque absente, un plugin de débogueur instable ou un build CI plus lent peuvent transformer « on pourrait porter » en « on ne le fera pas ce trimestre ». Quand la toolchain x86 est le défaut dans les IDE, systèmes de build et templates CI, le chemin de moindre résistance ramène les développeurs en arrière.

La distribution est de la friction, pas de la théorie

Le logiciel atteint les utilisateurs via des conventions de packaging : installateurs, updaters, dépôts, app stores, conteneurs et binaires signés. Un changement de plateforme force des questions inconfortables :

- Faut‑il livrer des builds séparés (x86 et ARM), un paquet « universel » ou compter sur la traduction ?

- Les plug‑ins/pilotes existants s'installent‑ils proprement ?

- La signature du code, la notarisation et les mises à jour automatiques sont‑elles cohérentes entre architectures ?

Si la distribution devient compliquée, les coûts de support augmentent — et beaucoup d'éditeurs l'éviteront.

La gestion d'entreprise est une barrière difficile

Les entreprises achètent des plateformes qu'elles peuvent gérer à grande échelle : imaging, enrollment des devices, politiques, sécurité endpoint, agents EDR, clients VPN et reporting de conformité. Si un de ces outils accuse du retard sur une nouvelle architecture, les pilotes s'arrêtent.

« Ça marche sur ma machine » est hors sujet si l'IT ne peut pas le déployer et le sécuriser.

La métrique réelle : la vitesse d'expédition

Développeurs et IT convergent vers une question pratique : à quelle vitesse pouvons‑nous expédier et supporter ? L'outillage et la distribution répondent souvent plus décisivement que les benchmarks bruts.

Une façon pratique de réduire la friction de migration est de raccourcir le temps entre une idée et une build testable — surtout pour valider la même application sur différents environnements (x86 vs ARM, images OS différentes ou cibles de déploiement variées).

Des plateformes comme Koder.ai s'insèrent dans ce flux en permettant aux équipes de générer et itérer des applications réelles via une interface chat — produisant souvent des frontends web React, des backends Go et des bases PostgreSQL (et Flutter pour le mobile). Pour le travail de transition de plateforme, deux capacités sont particulièrement pertinentes :

- Prototypage rapide et rebuilds quand il faut recréer des outils internes, panneaux d'administration ou utilitaires de la « longue traîne » qui n'ont pas de propriétaire clair.

- Snapshots et rollback pour tester en toute sécurité pendant qu'on jongle avec plusieurs architectures, toolchains et environnements de déploiement.

Comme Koder.ai supporte l'export de code source, il peut aussi servir de pont entre l'expérimentation et un pipeline d'ingénierie conventionnel — utile quand il faut aller vite, tout en gardant du code maintenable sous votre contrôle.

Leçons récentes des transitions ARM

Vérifiez si Koder.ai vous convient

Utilisez le plan gratuit pour évaluer Koder.ai sur votre prochain prototype ou pilote.

La poussée d'ARM vers les laptops et desktops est un bon contrôle de réalité sur la difficulté des transitions. Sur le papier, l'argument est simple : meilleure perf/watt, machines plus silencieuses, autonomie plus longue.

En pratique, le succès dépend moins du cœur CPU et plus de tout ce qui l'entoure — applis, pilotes, distribution et qui a le pouvoir d'aligner les incitations.

Apple : le contrôle réduit les inconnues

La transition d'Apple de Intel vers Apple Silicon a bien fonctionné surtout parce qu'Apple contrôle la pile entière : design hardware, firmware, OS, outils développeurs et canaux de distribution principaux.

Ce contrôle a permis à l'entreprise d'opérer une rupture propre sans attendre que des dizaines de partenaires se coordonnent. Il a aussi rendu possible une période de « pont » coordonnée : les développeurs ont obtenu des cibles claires, les utilisateurs des chemins de compatibilité, et Apple a pu pousser les fournisseurs clés à livrer des builds natives. Même quand certaines applis n'étaient pas natives, l'expérience utilisateur restait souvent acceptable parce que le plan de transition avait été conçu comme un produit, pas juste un échange de processeur.

Windows sur ARM : partenaires, timing et lacunes

Windows sur ARM montre l'autre face. Microsoft ne contrôle pas complètement l'écosystème matériel, et les PCs Windows dépendent fortement des choix OEM et d'une longue traîne de pilotes.

Cela crée des points de rupture courants :

- Pilotes : imprimantes, interfaces audio, périphériques d'entreprise et devices « one‑off » peuvent bloquer l'adoption.

- Manques applicatifs : certains outils professionnels arrivent en retard (ou jamais), et les plug‑ins/add‑ons peuvent être le blocage caché.

- Timing des incitations : les OEM ne vont pas parier gros sans demande, mais les utilisateurs ne vont pas exiger les appareils tant que la compatibilité ne paraît pas sûre.

Leçon : réussir une transition est organisationnel, pas seulement technique

Les progrès récents d'ARM renforcent une leçon centrale : contrôler plus de la pile rend les transitions plus rapides et moins fragmentées.

Quand vous dépendez de partenaires, il faut une coordination exceptionnellement forte, des parcours de mise à niveau clairs et une raison pour chaque participant — vendeur de puces, OEM, développeur et acheteur IT — de prioriser la migration en même temps.

Les transitions échouent pour des raisons ennuyeuses : l'ancienne plateforme fonctionne encore, tout le monde y a déjà investi (en argent et en habitudes), et les « cas limites » sont là où les vraies entreprises vivent.

Signaux qu'une transition a des chances de tenir

Une nouvelle plateforme gagne seulement quand trois choses s'alignent :

D'abord, le bénéfice est évident pour les acheteurs normaux — pas seulement les ingénieurs : meilleure autonomie, coûts nettement inférieurs, nouveaux facteurs de forme ou un bond de performance pour les tâches courantes.

Ensuite, il existe un plan de compatibilité crédible : excellente émulation/traduction, builds « universels » simples et parcours clairs pour pilotes, périphériques et outillage enterprise.

Enfin, les incitations s'alignent dans la chaîne : l'éditeur d'OS, le fabricant de puces, les OEM et les développeurs voient tous un avantage et ont une raison de prioriser la migration.

Les transitions réussies ressemblent moins à un interrupteur qu'à un chevauchement contrôlé. Déploiements par phases (groupes pilotes d'abord), builds doubles (ancien + nouveau) et télémétrie (taux de crash, performances, usage des fonctionnalités) permettent de détecter les problèmes tôt.

Tout aussi important : une fenêtre de support publiée pour l'ancienne plateforme, des échéances internes claires et un plan pour les utilisateurs « qui ne peuvent pas bouger ».

Checklist pratique avant de basculer

- Testez vos applis critiques (incluant plugs et macros), pas juste le logiciel vedette.

- Validez périphériques et pilotes : docks, imprimantes, scanners, interfaces audio, clés de sécurité.

- Confirmez la sécurité et la gestion : chiffrement disque, EDR, VPN, gestion des endpoints, politiques de conformité.

- Exécutez des tests de perf qui correspondent à vos charges (temps de build, exports vidéo, analyses de données), plus autonomie et aspects thermiques.

Vue équilibrée

x86 conserve encore un immense momentum : décennies de compatibilité, workflows d'entreprise enracinés et larges options matérielles.

Mais la pression monte depuis de nouveaux besoins — efficacité énergétique, intégration plus forte, calcul orienté IA et parcs d'appareils simplifiés. Les batailles les plus dures ne portent pas sur la vitesse brute ; elles portent sur rendre la migration sûre, prévisible et rentable.