15 déc. 2025·8 min

James Gosling, Java et l'essor du « Écrire une fois, exécuter partout »

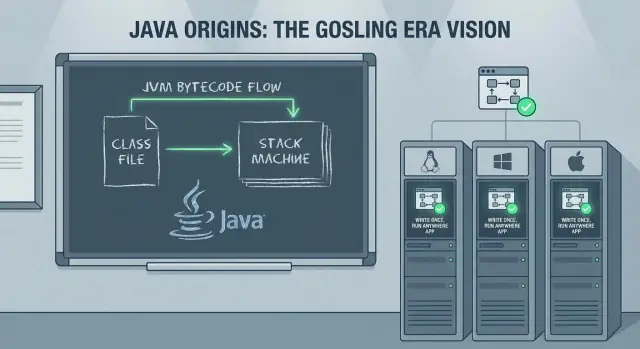

Comment Java de James Gosling et le principe « Écrire une fois, exécuter partout » ont influencé les systèmes d'entreprise, l'outillage et les pratiques backend actuelles — de la JVM au cloud.

Ce que couvre ce billet (et pourquoi cela reste important)

La promesse la plus célèbre de Java — « Écrire une fois, exécuter partout » (WORA) — n'était pas du simple marketing pour les équipes backend. C'était un pari pratique : construire un système sérieux une fois, le déployer sur différents systèmes d'exploitation et architectures, et le maintenir à mesure que l'entreprise grandit.

Cet article explique comment ce pari fonctionnait, pourquoi les entreprises ont adopté Java si rapidement, et comment les décisions prises dans les années 1990 façonnent encore aujourd'hui le développement backend — frameworks, outils de build, modèles de déploiement et systèmes de production de longue durée que beaucoup d'équipes continuent d'exploiter.

Ce que vous retirerez de cette histoire

Nous commencerons par les objectifs initiaux de James Gosling pour Java et la manière dont le langage et le runtime ont été conçus pour réduire les douleurs de portabilité sans sacrifier trop de performance.

Ensuite, nous suivrons l'histoire côté entreprise : pourquoi Java est devenu un choix sûr pour les grandes organisations, comment les serveurs d'applications et les standards d'entreprise ont émergé, et pourquoi l'outillage (IDE, automatisation des builds, tests) est devenu un multiplicateur de force.

Enfin, nous relierons le monde « classique » de Java aux réalités actuelles — l'ascension de Spring, les déploiements dans le cloud, les conteneurs, Kubernetes, et ce que « exécuter partout » signifie vraiment quand votre runtime comprend des dizaines de services et de dépendances tierces.

Termes clés (utilisés tout au long de l'article)

Portabilité : la capacité à exécuter le même programme sur des environnements différents (Windows/Linux/macOS, différents types de CPU) avec peu ou pas de modifications.

JVM (Java Virtual Machine) : le runtime qui exécute les programmes Java. Plutôt que compiler directement en code machine spécifique, Java cible la JVM.

Bytecode : le format intermédiaire produit par le compilateur Java. Le bytecode est ce que la JVM exécute, et c'est le mécanisme central derrière WORA.

WORA reste pertinent parce que beaucoup d'équipes backend équilibrent aujourd'hui les mêmes compromis : runtimes stables, déploiements prévisibles, productivité des équipes et systèmes qui doivent survivre pendant une décennie ou plus.

James Gosling et les objectifs originaux de Java

Java est étroitement associé à James Gosling, mais ce n'était jamais un effort solitaire. Chez Sun Microsystems au début des années 1990, Gosling travaillait avec une petite équipe (souvent appelée le projet « Green ») visant à construire un langage et un runtime capables de se déplacer entre différents appareils et systèmes d'exploitation sans être réécrits à chaque fois.

Le résultat n'était pas seulement une nouvelle syntaxe — c'était une idée de « plateforme » complète : un langage, un compilateur et une machine virtuelle conçus ensemble de sorte que le logiciel puisse être livré avec moins de surprises.

Les objectifs : sécurité, portabilité, productivité

Quelques objectifs pratiques ont façonné Java dès le départ :

- Sécurité et fiabilité : Java a supprimé ou contraint des sources courantes de plantages observés en C/C++ — notamment la manipulation directe de pointeurs — et a ajouté des vérifications au runtime qui favorisent les défaillances prévisibles plutôt que la corruption silencieuse.

- Portabilité : Au lieu de compiler en code machine spécifique au CPU, Java compile en bytecode exécutable sur une JVM compatible. Cette décision a rendu le « multi-plateforme » moins une question de compilation conditionnelle et davantage une affaire d'un contrat runtime cohérent.

- Productivité des développeurs : Java visait à rendre la programmation quotidienne plus rapide et moins sujette aux erreurs grâce à une bibliothèque standard, des attentes d'outillage cohérentes et la gestion automatique de la mémoire.

Ce n'étaient pas des objectifs purement académiques. Ils répondaient à des coûts réels : déboguer des problèmes de mémoire, maintenir plusieurs builds spécifiques à chaque plateforme, et intégrer des équipes sur des bases de code complexes.

Ce que « Écrire une fois, exécuter partout » signifiait (et ne signifiait pas)

En pratique, WORA signifiait :

- Si vous ciblez la JVM, vous pouvez généralement livrer le même bytecode sur différents systèmes d'exploitation.

- Vous devez quand même gérer des différences d'environnement : chemins de fichiers, comportement des locales, particularités réseau, caractéristiques de performance, intégrations natives et packaging de déploiement.

Donc le slogan n'était pas une « portabilité magique ». C'était un déplacement du travail de portabilité : loin des réécritures par plateforme et vers un runtime et des bibliothèques standardisés.

Comment fonctionne WORA : bytecode et JVM

WORA est un modèle de compilation et d'exécution qui sépare la construction du logiciel de son exécution.

Source → bytecode → exécution JVM

Les fichiers source Java (.java) sont compilés par javac en bytecode (.class). Le bytecode est un jeu d'instructions compact et standardisé identique que vous ayez compilé sur Windows, Linux ou macOS.

Au runtime, la JVM charge ce bytecode, le vérifie et l'exécute. L'exécution peut être interprétée, compilée à la volée, ou un mélange des deux selon la JVM et la charge de travail.

La JVM comme « adaptateur » OS/CPU

Au lieu de générer du code machine pour chaque CPU et système d'exploitation cible au moment de la compilation, Java cible la JVM. Chaque plateforme fournit sa propre implémentation de JVM qui sait :

- traduire le bytecode en instructions natives pour le CPU local

- interagir avec le système d'exploitation local (fichiers, réseau, threads)

Cette abstraction est le compromis central : votre application parle à un runtime cohérent, et le runtime parle à la machine.

Vérifications au runtime et gestion de la mémoire

La portabilité dépend aussi de garanties appliquées au runtime. La JVM effectue une vérification du bytecode et d'autres contrôles qui aident à prévenir les opérations non sûres.

Et plutôt que d'obliger les développeurs à allouer et libérer manuellement la mémoire, la JVM fournit une gestion automatique de la mémoire (garbage collection), réduisant toute une catégorie de plantages spécifiques à la plateforme et de bugs du type « marche sur ma machine ».

Pourquoi cela simplifiait le déploiement sur des flottes hétérogènes

Pour les entreprises exploitant du matériel et des systèmes d'exploitation mixtes, le gain était opérationnel : livrer les mêmes artefacts (JAR/WAR) sur différents serveurs, standardiser une version de JVM et attendre un comportement globalement cohérent. WORA n'a pas éliminé tous les problèmes de portabilité, mais il les a réduits — facilitant l'automatisation et la maintenance à grande échelle.

Pourquoi les entreprises ont adopté Java si vite

À la fin des années 1990 et au début des années 2000, les entreprises cherchaient des systèmes capables de fonctionner pendant des années, survivre au turnover du personnel et être déployés sur un mélange hétérogène de machines UNIX, serveurs Windows et le matériel négocié ce trimestre-là.

Java est arrivé avec un récit particulièrement adapté aux entreprises : les équipes pouvaient construire une fois et s'attendre à un comportement cohérent sur des environnements hétérogènes, sans maintenir de bases de code séparées pour chaque système d'exploitation.

Moins de réécritures, moins de churn QA

Avant Java, déplacer une application entre plateformes signifiait souvent réécrire des portions spécifiques à la plateforme (threads, réseau, chemins de fichiers, bibliothèques UI, différences de compilateur). Chaque réécriture multipliait l'effort de tests — et les tests d'entreprise sont coûteux car ils incluent suites de régression, contrôles de conformité et l'approche « il ne faut pas casser la paie ».

Java a réduit ce churn. Plutôt que de valider plusieurs builds natifs, de nombreuses organisations pouvaient standardiser sur un seul artefact de build et un runtime cohérent, réduisant les coûts QA et rendant la planification sur le long terme plus réaliste.

Une bibliothèque standard qui se comportait de la même façon

La portabilité ne consiste pas seulement à exécuter le même code ; il s'agit aussi de s'appuyer sur un même comportement. Les bibliothèques standard Java offraient une base cohérente pour les besoins essentiels comme :

- Réseau et protocoles web

- Connectivité base de données (via JDBC et les drivers fournisseurs)

- Primitives de sécurité

- Briques de threading et de concurrence

Cette cohérence facilitait la formation de pratiques partagées entre équipes, l'intégration des développeurs et l'adoption de bibliothèques tierces avec moins de surprises.

Où la portabilité pouvait encore se casser

L'histoire « écrire une fois » n'était pas parfaite. La portabilité pouvait tomber à l'eau quand les équipes dépendaient de :

- Bibliothèques natives (JNI) pour l'intégration matérielle ou du code legacy

- Particularités du système de fichiers, polices ou comportements de locale

- Fonctionnalités spécifiques d'un fournisseur de base de données ou d'un serveur d'applications

Même dans ces cas, Java réduisait souvent le problème à un petit périmètre bien défini — plutôt que de rendre l'ensemble de l'application dépendante d'une plateforme.

Plateformes d'entreprise : serveurs d'applications et Jakarta EE

À mesure que Java est passé des postes de travail aux centres de données corporatifs, les équipes ont eu besoin de plus qu'un langage et une JVM — elles ont voulu un moyen prévisible de déployer et d'exploiter des capacités backend partagées. Cette demande a aidé à l'essor des serveurs d'applications comme WebLogic, WebSphere et JBoss (et, à l'extrémité plus légère, des conteneurs de servlets comme Tomcat).

Déploiement standardisé (WAR/EAR)

Une raison de la diffusion rapide des serveurs d'applications était la promesse d'un packaging et d'un déploiement standardisés. Plutôt que de livrer un script d'installation personnalisé pour chaque environnement, les équipes pouvaient empaqueter une application en WAR (web archive) ou EAR (enterprise archive) et la déployer dans un serveur avec un modèle d'exécution cohérent.

Ce modèle importait pour les entreprises car il séparait les responsabilités : les développeurs se concentraient sur le code métier, tandis que l'exploitation s'appuyait sur le serveur d'applications pour la configuration, l'intégration sécurité et la gestion du cycle de vie.

Patterns d'entreprise indispensables

Les serveurs d'applications ont popularisé un ensemble de patterns présents dans presque tous les systèmes critiques :

- Transactions : coordination d'opérations en plusieurs étapes (souvent à travers bases de données et services) pour que les échecs n'entraînent pas des données partiellement écrites.

- Messagerie : travail asynchrone via files d'attente et topics, lissant les pics de trafic et découplant les systèmes.

- Pool de connexions : réutilisation de connexions coûteuses à la base de données plutôt que d'en ouvrir une par requête.

Ce n'étaient pas des « gadgets » — c'était la plomberie nécessaire pour des flux de paiement fiables, le traitement des commandes, la mise à jour des stocks et les workflows internes.

Des servlets/JSP aux backends web modernes

L'ère des servlet/JSP a constitué un pont important. Les servlets ont établi un modèle de requête/réponse standard, tandis que JSP a rendu la génération HTML côté serveur plus accessible.

Même si l'industrie s'est ensuite tournée vers les API et les frameworks front-end, les servlets ont posé les bases des backends web d'aujourd'hui : routage, filtres, sessions et déploiement cohérent.

Jakarta EE comme effort de standardisation

Au fil du temps, ces capacités ont été formalisées en J2EE, puis Java EE, et maintenant Jakarta EE : un ensemble de spécifications pour les API Java d'entreprise. La valeur de Jakarta EE réside dans la standardisation des interfaces et du comportement entre implémentations, de sorte que les équipes puissent développer contre des contrats connus plutôt que contre la pile propriétaire d'un seul fournisseur.

Performance : JIT, GC et le coût de la portabilité

Rassemblez votre équipe

Invitez des coéquipiers et commencez à développer des applications ensemble, avec un élan commun.

La portabilité de Java soulève une question évidente : si le même programme peut tourner sur des machines très différentes, peut‑il aussi être rapide ? La réponse se trouve dans un ensemble de technologies runtime qui ont rendu la portabilité praticable pour des charges réelles — surtout côté serveur.

Garbage Collection : moins de temps à gérer la mémoire, moins de bugs en production

La GC importait parce que les grandes applications serveur créent et détruisent d'énormes quantités d'objets : requêtes, sessions, données en cache, payloads parsés, etc. Dans des langages où la mémoire est gérée manuellement, ces schémas mènent souvent à des fuites, des plantages ou des corruptions difficiles à déboguer.

Avec la GC, les équipes peuvent se concentrer sur la logique métier plutôt que sur « qui libère quoi, et quand ». Pour beaucoup d'entreprises, cet avantage en fiabilité compensait les micro-optimisations perdues.

Compilation JIT : le pont de performance pour la portabilité

Java exécute du bytecode sur la JVM, et la JVM utilise la compilation Just-In-Time (JIT) pour traduire les parties chaudes de votre programme en code machine optimisé pour le CPU courant.

C'est le pont : votre code reste portable, tandis que le runtime s'adapte à l'environnement où il tourne — souvent en améliorant les performances avec le temps quand il apprend quelles méthodes sont utilisées le plus.

Les compromis : warm-up, tuning et sensibilité à la latence

Ces astuces runtime ne sont pas gratuites. Le JIT introduit un temps de warm-up, où la performance peut être moins bonne jusqu'à ce que la JVM ait observé suffisamment de trafic pour optimiser.

La GC peut aussi provoquer des pauses. Les collecteurs modernes les réduisent fortement, mais les systèmes sensibles à la latence nécessitent encore des choix et du tuning (taille du heap, sélection du collecteur, patterns d'allocation).

Le profilage comme partie normale du travail Java

Parce qu'une grande partie des performances dépend du comportement runtime, le profilage est devenu routinier. Les équipes Java mesurent couramment le CPU, les taux d'allocation et l'activité GC pour trouver des goulots d'étranglement — traitant la JVM comme quelque chose qu'on observe et qu'on ajuste, pas comme une boîte noire.

Outillage qui a changé la productivité des équipes

Java n'a pas séduit les équipes uniquement par la portabilité. Il a aussi apporté un récit d'outillage qui rendait les grandes bases de code soutenables — et faisait du développement à l'échelle entreprise un travail moins hasardeux.

IDE : passer de l'édition de fichiers à la compréhension du système

Les IDE Java modernes (et les fonctionnalités du langage qu'ils exploitent) ont transformé le travail quotidien : navigation précise entre paquets, refactorings sûrs et analyses statiques toujours actives.

Renommer une méthode, extraire une interface ou déplacer une classe entre modules — puis voir les imports, les points d'appel et les tests se mettre à jour automatiquement. Pour les équipes, cela signifiait moins de zones « ne touchez pas », des revues de code plus rapides et une structure plus cohérente quand les projets grossissaient.

Builds et dépendances : Ant → Maven/Gradle

Les premiers builds Java utilisaient souvent Ant : flexible, mais facile à rendre en un script personnalisé que seul une personne comprenait. Maven a poussé une approche par convention avec une disposition de projet standard et un modèle de dépendances reproductible sur n'importe quelle machine. Gradle a ensuite apporté des builds plus expressifs et des itérations plus rapides tout en gardant la gestion des dépendances au centre.

Le grand basculement a été la répétabilité : la même commande, le même résultat, sur les postes des développeurs et dans la CI.

Pourquoi l'outillage standard a aidé à monter en échelle

Les structures de projet standard, les coordonnées de dépendances et les étapes de build prévisibles ont réduit le savoir tribal. L'intégration de nouveaux arrivants s'est faite plus vite, les releases sont devenues moins manuelles, et il est devenu pratique d'imposer des règles de qualité partagées (formatage, vérifications, gates de test) sur de nombreux services.

Checklist pratique pour un projet Java moderne

- Utiliser un JDK LTS à jour (et le pinner en CI).

- Choisir Maven ou Gradle ; garder le build minimal et documenté.

- Centraliser les versions des dépendances (BOM ou catalogue de versions).

- Ajouter formatage + vérifications statiques (par ex. Checkstyle/SpotBugs) dans les étapes de build.

- Exiger des tests unitaires et générer des rapports de couverture.

- Utiliser une pipeline CI reproductible qui exécute build + tests à chaque changement.

- Documenter « comment lancer localement » dans un README court.

Tests et livraison : de JUnit au CI/CD

Déployez en toute confiance

Déployez et hébergez votre appli avec un workflow reproductible, facile à annuler.

Les équipes Java n'ont pas seulement obtenu un runtime portable — elles ont connu un changement culturel : les tests et la livraison sont devenus des choses qu'on peut standardiser, automatiser et répéter.

Comment JUnit a normalisé les tests unitaires

Avant JUnit, les tests étaient souvent ad hoc (ou manuels) et vivotaient en dehors du flux principal de développement. JUnit a changé cela en faisant des tests du code de première classe : écrire une petite classe de test, l'exécuter dans son IDE et obtenir un retour immédiat.

Cette boucle courte importait pour les systèmes d'entreprise où les régressions coûtent cher. Avec le temps, « pas de tests » a cessé d'être l'exception et a commencé à ressembler à un risque.

Les avantages de la CI : un build, plusieurs environnements

Un grand avantage de la livraison Java est que les builds sont typiquement pilotés par les mêmes commandes partout — postes des développeurs, agents de build, serveurs Linux, runners Windows — parce que la JVM et les outils de build se comportent de façon cohérente.

Dans la pratique, cette cohérence a réduit le classique problème du « ça marche chez moi ». Si votre serveur CI peut exécuter mvn test ou gradle test, la plupart du temps vous obtenez les mêmes résultats que ceux vus par toute l'équipe.

Outils de qualité qui s'intègrent dans la pipeline

Les écosystèmes Java ont rendu les « gates de qualité » faciles à automatiser :

- Formatage : Spotless ou une config de formatage IDE partagée pour garder les diffs propres

- Linting/analyses statiques : Checkstyle, PMD, SpotBugs pour les erreurs courantes

- Scans de sécurité : OWASP Dependency-Check (ou un outil hébergé comme Snyk) pour signaler les bibliothèques vulnérables

Ces outils sont plus efficaces quand ils sont prévisibles : mêmes règles pour chaque repo, appliquées en CI, avec des messages d'échec clairs.

Une pipeline CI simple pour un service Java

Garder ça ennuyeux et reproductible :

- Checkout + définir la version de Java (pinner votre JDK)

- Build + tests unitaires (

mvn test/gradle test) - Vérifications statiques (format, lint, scan sécurité)

- Packager l'artefact (JAR) et le stocker

- Tests d'intégration (optionnel mais précieux)

- Déployer en staging, puis en production avec approbations

Cette structure s'étend d'un service à plusieurs — et reflète le même thème : un runtime cohérent et des étapes cohérentes accélèrent les équipes.

Spring et la transition vers le développement backend moderne

Java a gagné la confiance des entreprises tôt, mais construire des applications métier réelles signifiait souvent lutter avec des serveurs lourds, du XML verbeux et des conventions spécifiques aux conteneurs. Spring a changé l'expérience quotidienne en faisant du Java « pur » le centre du développement backend.

Inversion de contrôle : pourquoi cela convenait aux besoins d'entreprise

Spring a popularisé l'inversion de contrôle (IoC) : au lieu que votre code crée et câble tout manuellement, le framework assemble l'application à partir de composants réutilisables.

Avec l'injection de dépendances (DI), les classes déclarent ce dont elles ont besoin, et Spring le fournit. Cela améliore la testabilité et facilite le remplacement d'implémentations (par exemple, une passerelle de paiement réelle vs un stub en test) sans réécrire la logique métier.

Configuration et intégration simplifiées

Spring a réduit les frictions en standardisant les intégrations courantes : JDBC templates, puis le support ORM, transactions déclaratives, planification et sécurité. La configuration est passée du XML long et fragile vers des annotations et des propriétés externalisées.

Ce virage s'est aussi bien aligné avec la livraison moderne : le même build peut tourner localement, en staging ou en production en changeant la configuration d'environnement plutôt que le code.

WORA, portabilité et patterns de services modernes

Les services basés sur Spring ont maintenu la promesse « exécuter partout » : une API REST construite avec Spring peut s'exécuter sans changement sur un laptop de développeur, une VM ou un conteneur — parce que le bytecode cible la JVM et que le framework masque beaucoup de détails de plate-forme.

Les modèles courants d'aujourd'hui — endpoints REST, injection de dépendances et configuration via propriétés/variables d'environnement — reflètent essentiellement le modèle mental par défaut de Spring pour le développement backend. Pour plus de réalités de déploiement, voir /blog/java-in-the-cloud-containers-kubernetes-and-reality.

Java dans le cloud : conteneurs, Kubernetes et réalité

Java n'a pas nécessité une « réécriture cloud » pour fonctionner dans des conteneurs. Un service Java typique est toujours empaqueté en JAR (ou WAR), lancé avec java -jar et placé dans une image de conteneur. Kubernetes orchestre ensuite ce conteneur comme n'importe quel processus : le démarrer, le surveiller, le redémarrer et le scaler.

Ce qui change avec les conteneurs (même si votre code ne change pas)

Le grand changement est l'environnement autour de la JVM. Les conteneurs introduisent des limites de ressources plus strictes et des cycles de vie plus rapides que les serveurs traditionnels.

Les limites de mémoire sont le premier piège pratique. Dans Kubernetes, vous définissez une limite mémoire et la JVM doit y être compatible — sinon le pod peut être tué. Les JVM modernes sont conscientes des conteneurs, mais les équipes règlent encore la taille du heap pour laisser de la place au metaspace, aux threads et à la mémoire native. Un service qui « marche sur une VM » peut encore planter dans un conteneur si le heap est trop agressivement dimensionné.

Le temps de démarrage prend aussi plus d'importance. Les orchestrateurs scale up/down fréquemment, et des cold starts lents peuvent affecter l'auto-scaling, les rollouts et la récupération d'incident. La taille de l'image devient une friction opérationnelle : les images volumineuses se téléchargent plus lentement, rallongent les déploiements et consomment de la bande passante/répertoire de registre.

Rendre Java plus adapté : plus petit, plus rapide, plus prévisible

Plusieurs approches ont aidé Java à mieux s'intégrer aux déploiements cloud :

- Runtimes plus légers : images de base slim et réduction du runtime avec des outils comme

jlink(lorsque c'est pertinent) pour réduire la taille de l'image. - Démarrage plus rapide : class data sharing (CDS) et hygiène des dépendances pour réduire le cold-start.

- Packaging alternatif : compilation ahead-of-time (pour certains services) pour améliorer drastiquement le démarrage et le profil mémoire, au prix de compromis différents en build/débogage.

Pour un guide pratique sur le tuning du comportement JVM et les compromis de performance, voir /blog/java-performance-basics.

Compatibilité ascendante et systèmes de longue durée

Prototyper rapidement un service

Créez un service compatible Java ou un outil interne depuis le chat, puis exportez le code source.

Une des raisons pour lesquelles Java a gagné la confiance des entreprises est simple : le code tend à survivre aux équipes, aux fournisseurs et même aux stratégies métiers. La culture Java de stabilité des API et de compatibilité ascendante signifiait qu'une application écrite il y a des années pouvait souvent continuer à fonctionner après des mises à jour d'OS, des renouvellements matériels et de nouvelles versions de Java — sans réécriture totale.

Pourquoi les API stables importent en entreprise

Les entreprises optimisent pour la prévisibilité. Quand les API centrales restent compatibles, le coût du changement baisse : les supports de formation restent pertinents, les runbooks opérationnels n'ont pas besoin d'être réécrits constamment, et les systèmes critiques peuvent être améliorés par petites étapes plutôt que par des migrations « big-bang ».

Cette stabilité a aussi influencé les choix d'architecture. Les équipes acceptaient de construire de grandes plateformes partagées et des bibliothèques internes parce qu'elles s'attendaient à ce qu'elles continuent de fonctionner longtemps.

Bibliothèques, maintenance et l'attente « pour toujours »

L'écosystème de bibliothèques Java (du logging à l'accès aux bases jusqu'aux frameworks web) a renforcé l'idée que les dépendances sont des engagements à long terme. L'envers de la médaille est la maintenance : les systèmes de longue durée accumulent des versions anciennes, des dépendances transitives et des contournements « temporaires » qui deviennent permanents.

Les mises à jour de sécurité et l'hygiène des dépendances sont un travail continu, pas un projet ponctuel. PatchER régulièrement le JDK, mettre à jour les bibliothèques et suivre les CVE réduit le risque sans déstabiliser la production — surtout quand les upgrades sont incrémentaux.

Mettre à jour de vieilles applis Java en sécurité

Une approche pratique consiste à traiter les upgrades comme du travail produit :

- Commencer par ajouter ou améliorer les tests automatisés autour des workflows critiques.

- Monter par petits sauts (par ex. une version LTS à la fois) et mesurer performance et mémoire, pas seulement la compilation.

- Faire tourner l'ancienne et la nouvelle version côte à côte en staging, et garder des plans de rollback explicites.

- Inventorier les dépendances tôt ; beaucoup de « migrations Java » échouent parce qu'une bibliothèque clé est abandonnée.

La compatibilité ascendante n'est pas une garantie d'absence de douleur — mais c'est une base qui rend la modernisation prudente et à faible risque possible.

Leçons clés pour les équipes backend aujourd'hui

Ce que WORA a réellement apporté (et ce qu'il n'a pas apporté)

WORA a le mieux fonctionné au niveau promis : le même bytecode compilé pouvait s'exécuter sur n'importe quelle plateforme disposant d'une JVM compatible. Cela a rendu les déploiements serveur multi-plateformes et le packaging indépendant du fournisseur bien plus simples que dans de nombreux écosystèmes natifs.

Là où cela a montré ses limites, c'est tout ce qui se passe à la frontière de la JVM. Les différences d'OS, systèmes de fichiers, comportements réseau, architectures CPU, flags JVM et dépendances natives tierces comptent toujours. Et la portabilité des performances n'a jamais été automatique — vous pouvez « exécuter partout », mais il faut observer et ajuster la manière dont ça tourne.

Enseignements pratiques pour les équipes qui choisissent Java aujourd'hui

L'avantage majeur de Java n'est pas une fonctionnalité unique ; c'est la combinaison de runtimes stables, d'outillage mature et d'un vaste vivier de talents.

Quelques leçons pour les équipes :

- Traitez la JVM comme une plateforme : choisissez une distribution JDK supportée, standardisez les versions et effectuez des upgrades délibérés.

- Privilégiez des choix ennuyeux : gardez builds, logging, métriques et gestion des dépendances cohérents entre services.

- Concevez pour l'opérabilité : investissez tôt dans le monitoring, la configuration sûre et un comportement mémoire/GC prévisible.

- Appuyez-vous sur l'écosystème : frameworks et bibliothèques font gagner du temps, mais auditez la prolifération des dépendances et les mises à jour de sécurité.

Facteurs de décision : quand Java est le bon choix

Choisissez Java lorsque votre équipe valorise la maintenance à long terme, un support de bibliothèques mature et des opérations de production prévisibles.

Points à vérifier :

- Compétences de l'équipe : avez‑vous déjà de l'expérience Java/Spring ou faudra‑t‑il former ?

- Contraintes runtime : le temps de démarrage et l'empreinte mémoire sont-ils critiques (certaines charges favorisent Go/Node), ou la priorité est‑elle le débit et la stabilité ?

- Besoins écosystémiques : avez‑vous besoin de messaging mature, de drivers DB, d'observabilité ou d'intégrations d'entreprise ?

- Longévité : ce système vivra‑t‑il des années avec peu de réécritures ?

Prochaines étapes

Si vous évaluez Java pour un nouveau backend ou un projet de modernisation, commencez par un service pilote, définissez une politique d'upgrade/patching et convenez d'une base de framework. Si vous voulez de l'aide pour cadrer ces choix, contactez-nous via /contact.

Si vous expérimentez aussi des moyens rapides de monter des services « sidecar » ou des outils internes autour d'un patrimoine Java existant, des plateformes comme Koder.ai peuvent vous aider à passer d'une idée à une app web/serveur/mobile fonctionnelle via le chat — utile pour prototyper des services compagnons, des tableaux de bord ou des utilitaires de migration. Koder.ai prend en charge l'export de code, le déploiement/l'hébergement, les domaines personnalisés et les snapshots/rollback, ce qui s'accorde bien avec le même état d'esprit opérationnel que valorisent les équipes Java : builds reproductibles, environnements prévisibles et itération sûre.