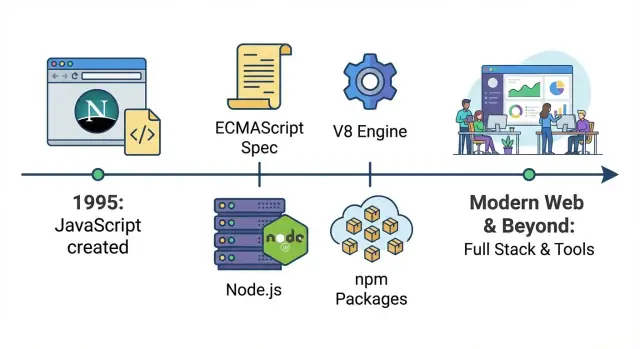

Une carte rapide de la conquête de JavaScript

JavaScript a commencé comme un moyen d'ajouter un peu d'interactivité aux pages web — de petits scripts qui validaient un formulaire, remplaçaient une image ou affichaient un menu déroulant. Ce guide retrace comment ce « petit langage d'aide » s'est transformé en plateforme pour toute une entreprise : la même technologie de base fait désormais tourner les interfaces utilisateur, les serveurs, les systèmes de build, l'automatisation et les outils internes.

Ce que signifie « langage par défaut du web »

Concrètement, JavaScript est le seul langage que chaque navigateur grand public peut exécuter directement. Si vous envoyez du code aux utilisateurs sans exiger qu'ils installent quoi que ce soit, JavaScript est l'option universelle. D'autres langages peuvent participer — mais généralement en compilant vers JavaScript ou en s'exécutant sur un serveur — tandis que JavaScript s'exécute par défaut à destination.

Les trois ères que vous verrez

La première est l'ère du navigateur, où JavaScript est devenu la façon standard de contrôler la page : réagir aux clics, manipuler le DOM et finalement alimenter des expériences plus riches à mesure que le web dépassait les documents statiques.

La deuxième est l'ère backend, où des moteurs plus rapides et Node.js ont rendu pratique l'exécution de JavaScript sur des serveurs. Cela a débloqué un langage partagé entre frontend et backend, plus un écosystème de paquets qui a accéléré la réutilisation.

La troisième est l'ère des opérations métiers, où les outils JavaScript sont devenus « la colle » : pipelines de build, tests, design systems, tableaux de bord, scripts d'automatisation et intégrations. Même des équipes qui ne se voient pas comme des « équipes JavaScript » dépendent souvent quotidiennement d'outils basés sur JavaScript.

À quoi s'attendre dans ce guide

Nous nous concentrerons sur les points de bascule majeurs — normalisation, sauts de performance, Node.js, npm et le passage aux apps guidées par des frameworks — plutôt que d'énumérer chaque librairie ou tendance.

L'origine : scripting dans le navigateur

JavaScript a été créé en 1995 chez Netscape comme un moyen simple d'ajouter de l'interactivité aux pages web sans nécessiter un aller-retour serveur ou une « installation » complète. Brendan Eich a construit la première version rapidement, et son objectif initial était modeste : permettre aux auteurs web de valider des formulaires, réagir aux clics et rendre les pages moins statiques.

Un web fait de petites pages et de machines lentes

Les contraintes du web primitif ont façonné ce que JavaScript pouvait être. Les ordinateurs étaient plus lents, les navigateurs rudimentaires et la plupart des sites étaient majoritairement du texte avec quelques images. Les scripts devaient être légers et tolérants — de petits fragments pouvant s'exécuter sans bloquer la page.

Parce que les pages étaient simples, le JavaScript précoce ressemblait souvent à « un peu de logique » saupoudrée dans le HTML : vérifier si un champ email contenait un @, afficher une alerte ou changer une image au survol d'un lien.

« Écrire du code dans la page » était un grand changement

Avant cela, une page web affichait surtout du contenu. Avec JavaScript intégré directement dans la page, elle pouvait répondre immédiatement aux actions de l'utilisateur. Même un tout petit script pouvait :

- Empêcher l'envoi d'un formulaire tant que des champs obligatoires manquaient

- Mettre à jour du texte sur la page après un clic

- Effectuer de petits calculs sans contacter un serveur

C'était le début du navigateur devenant un runtime d'application — pas seulement un visionneur de documents.

Les douleurs initiales : comportements incohérents

Le revers de la médaille était l'imprévisibilité. Les navigateurs n'interprétaient pas toujours JavaScript de la même façon, et les APIs pour interagir avec la page (comportement DOM précoce, modèles d'événements et méthodes d'éléments) variaient largement. Les développeurs devaient écrire des chemins de code différents selon le navigateur, tester constamment et accepter que quelque chose qui marche sur une machine puisse casser sur une autre.

La compétition des navigateurs et la poussée vers la standardisation (ECMAScript)

Les « guerres des navigateurs » en clair

À la fin des années 1990 et au début des années 2000, les navigateurs se concurrençaient en publiant des nouveautés aussi vite que possible. Netscape et Internet Explorer ne couraient pas seulement sur la vitesse — ils rivalisaient sur les comportements JavaScript, les APIs DOM et les extensions propriétaires.

Pour les développeurs, cela signifiait qu'un même script pouvait fonctionner dans un navigateur et casser dans un autre. On voyait des bugs qui n'étaient pas « votre faute » : modèles d'événements différents, méthodes manquantes et cas limites incohérents. Livrer un site nécessitait souvent d'écrire deux versions de la même logique, plus des astuces de détection de navigateur.

ECMAScript : le contrat derrière JavaScript

Pour réduire le chaos, JavaScript avait besoin d'une définition commune qui ne soit pas contrôlée par un seul fournisseur de navigateur. Cette définition est devenue ECMAScript — la norme qui décrit le noyau du langage (syntaxe, types, fonctions, objets, etc.).

Un modèle mental utile :

- JavaScript est ce que les navigateurs (et plus tard les serveurs) exécutent.

- ECMAScript est le cahier des charges que les moteurs JavaScript s'efforcent de suivre.

Une fois que les fournisseurs se sont alignés sur des versions d'ECMAScript, le langage est devenu plus prévisible entre navigateurs. Les incompatibilités n'ont pas disparu du jour au lendemain — les APIs hors noyau du langage (comme des parties du DOM) variaient encore — mais la fondation s'est stabilisée. Avec le temps, de meilleurs jeux de tests et des attentes partagées ont rendu le « ça marche sur mon navigateur » moins acceptable.

Pourquoi les vieux schémas n'ont jamais totalement disparu

Même avec l'évolution d'ECMAScript, la compatibilité ascendante est devenue une promesse non négociable : les anciens sites doivent continuer de fonctionner. C'est pourquoi des patrons hérités — var, des règles d'égalité étranges et des contournements pré-modules — sont restés dans l'écosystème. Le web ne pouvait pas se permettre un reset brutal, donc JavaScript a grandi en ajoutant des fonctionnalités plutôt qu'en supprimant les anciennes.

Ajax et l'essor des vraies applications web

Avant Ajax, la plupart des sites fonctionnaient comme des formulaires papier : vous cliquez sur un lien ou soumettez un formulaire, le navigateur recharge la page entière et vous attendez que le serveur renvoie un nouveau document HTML.

Ajax (pour « Asynchronous JavaScript and XML », bien que JSON soit rapidement devenu la vraie star) a changé ce modèle. Avec JavaScript, une page pouvait demander des données au serveur en arrière-plan et mettre à jour seulement la partie qui en avait besoin — sans rechargement complet.

Mettre à jour des parties d'une page sans recharger

Ajax a rendu le web plus proche d'un programme interactif. Une boîte de recherche pouvait afficher des suggestions au fur et à mesure de la frappe. Le total d'un panier pouvait se mettre à jour instantanément. Les commentaires pouvaient apparaître après publication sans vous renvoyer en haut de la page.

Ce n'était pas seulement une interface plus agréable — cela réduisait la friction. Les gens ont moins toléré le « clic → attente → rechargement » pour chaque petite action.

Les expériences à la Gmail ont réinitialisé les attentes

Des produits comme Gmail ont montré que le navigateur pouvait gérer des interactions proches d'une application : mise à jour rapide de la boîte de réception, étiquetage instantané, navigation fluide et moins d'interruptions. Une fois les utilisateurs habitués à cette réactivité, cela est devenu l'attente par défaut pour d'autres sites.

APIs + JSON : le navigateur devient un client sérieux

Ajax a poussé les équipes à séparer « données » et « page ». Plutôt que d'envoyer un HTML complet à chaque fois, les serveurs ont de plus en plus exposé des APIs renvoyant des données structurées (souvent JSON). Le navigateur — propulsé par JavaScript — est devenu un vrai client responsable du rendu, des interactions et de l'état.

Le compromis : plus de logique déplacée vers le frontend

Le revers a été la complexité. Plus de logique applicative a migré dans le navigateur : validation, état UI, cache, gestion d'erreurs et performances. Cela a préparé le terrain pour des outils frontend plus lourds et, finalement, pour des applications mono-page complètes où le serveur fournit surtout des APIs et le frontend se comporte comme une vraie application.

jQuery, le DOM et rendre JavaScript accessible

Le JavaScript précoce n'était pas difficile parce que le langage était impossible — il était difficile à cause de l'environnement navigateur chaotique. Le scripting DOM impliquait de jongler avec des modèles d'événements différents, des APIs d'éléments incohérentes et des bizarreries de rendu qui changeaient selon le navigateur. Même des tâches basiques comme « trouver cet élément et le cacher quand un bouton est cliqué » pouvaient se transformer en une pile de conditionnels et de contournements spécifiques au navigateur.

Pourquoi le scripting DOM était pénible

Les développeurs passaient beaucoup de temps à combattre la compatibilité au lieu de construire des fonctionnalités. La sélection d'éléments différait selon les navigateurs, l'attachement d'événements n'était pas cohérent et la manipulation des styles pouvait se comporter de façon inattendue. Le résultat : de nombreuses équipes evitaient un code client lourd ou tournaient les utilisateurs vers des solutions non-JS comme Flash et autres plugins pour des expériences plus riches.

L'astuce majeure de jQuery était simple : proposer une petite API lisible et gérer les différences inter-navigateurs en coulisses. Une seule syntaxe de sélecteur fonctionnait presque partout, la gestion des événements est devenue prévisible et les effets UI courants étaient accessibles en un appel de fonction. Au lieu d'apprendre dix règles spécifiques aux navigateurs, on apprenait « la façon jQuery » et on livrait rapidement des résultats.

Cette simplicité a compté culturellement. JavaScript est devenu la première langue que beaucoup de développeurs web ont apprise parce que c'était le chemin vers un progrès visible. Tutoriels, extraits et plugins se sont répandus rapidement ; on pouvait copier quelques lignes et livrer quelque chose qui avait l'air moderne.

Quand l'ère des plugins a décliné, JavaScript a gagné par défaut

À mesure que les navigateurs s'amélioraient et que les plugins devenaient moins acceptables (problèmes de sécurité, manque de support mobile et soucis de performance), les équipes ont de plus en plus choisi les technologies web natives. jQuery a servi de pont : il a abaissé la barrière du scripting DOM, et au moment où la plateforme a mûri, une génération connaissait déjà suffisamment JavaScript pour construire la vague suivante.

Planifiez avant de coder

Utilisez le mode Planification pour esquisser pages, données et flux avant de générer le code.

Pendant des années, la plus grande limite de JavaScript n'était pas la syntaxe ou les fonctionnalités — c'était la vitesse. Les premières pages toléraient l'exécution lente parce que les scripts étaient petits : valider un formulaire, basculer un menu, ajouter un peu d'interactivité. Quand les développeurs ont essayé de construire des applications complètes dans le navigateur, la performance est devenue le plafond.

Qu'est-ce que V8 (et pourquoi ça compte)

V8 est le moteur JavaScript de Google, créé pour Chrome. Un « moteur » est la partie du navigateur qui lit votre JavaScript et l'exécute. L'innovation de V8 a été de traiter JavaScript moins comme un langage interprété lent et plus comme du code pouvant être optimisé agressivement à l'exécution.

En termes simples : V8 est devenu beaucoup meilleur pour transformer rapidement JavaScript en instructions machine, puis pour ré‑optimiser les chemins chauds à mesure qu'il apprenait le comportement de votre programme. Cela a réduit les latences, rendu les animations plus fluides et raccourci le délai entre un clic utilisateur et une réponse à l'écran.

Une exécution plus rapide a rendu possibles des apps plus grosses et des UIs plus riches

Quand JavaScript est devenu plus rapide, les équipes ont pu déplacer davantage de logique dans le navigateur sans que l'expérience ne s'effondre. Cela a changé ce qu'il était raisonnable de construire :

- Interfaces complexes (boîtes de réception, tableaux de bord, éditeurs) qui se comportent comme des logiciels de bureau

- Mises à jour DOM lourdes sans gel fréquent de la page

- Plus de calcul côté client (filtrage, tri, rendu) plutôt que des allers-retours serveurs

La performance n'a pas seulement embellit les sites existants — elle a élargi la catégorie de logiciels que le web pouvait héberger.

La boucle de rétroaction qui a tout accéléré

Une dynamique clé s'est déclenchée :

Meilleurs moteurs → plus de JS écrit par les développeurs → les utilisateurs passent plus de temps dans des apps lourdes en JS → les navigateurs investissent encore plus dans les moteurs.

Les entreprises se battant pour les parts de marché des navigateurs mettaient la vitesse en avant. Les vraies applications web servaient aussi de benchmarks, et chaque amélioration encourageait les développeurs à aller plus loin.

Contexte : ce n'était pas seulement V8

V8 n'était pas seul. SpiderMonkey (Mozilla/Firefox) et JavaScriptCore (Apple/Safari) se sont également améliorés rapidement, chacun avec ses stratégies d'optimisation. L'important n'est pas quel moteur a « gagné » — c'est que la concurrence a fait de JavaScript rapide une attente de base.

Une fois que JavaScript s'est exécuté assez vite pour alimenter des interfaces exigeantes de façon fiable, il a cessé d'être « juste un langage de scripting de navigateur » et a commencé à ressembler à une plateforme sur laquelle les équipes pouvaient parier.

Node.js : JavaScript passe au backend

Node.js est un runtime qui vous permet d'exécuter JavaScript en dehors du navigateur. Au lieu d'écrire JavaScript seulement pour les boutons, formulaires et interactions de page, les développeurs pouvaient utiliser le même langage pour construire des serveurs, des outils en ligne de commande et des jobs en arrière-plan.

Pourquoi la boucle d'événements convient aux serveurs

Node.js repose sur une boucle d'événements : une façon de gérer beaucoup d'attentes — requêtes réseau, requêtes base de données et lectures de fichiers — sans créer un thread séparé par connexion.

Pour beaucoup de charges web, les serveurs passent plus de temps à attendre qu'à calculer. Le modèle de boucle d'événements rendait possible de gérer de nombreux utilisateurs concurrents avec un code relativement simple, particulièrement pour des applications qui doivent se sentir « en direct », où les mises à jour doivent être poussées rapidement et fréquemment.

Cas d'usage initiaux qui ont fait leurs preuves

Node.js a d'abord gagné du terrain là où la réactivité comptait :

- Chat en temps réel et apps collaboratives (messages et mises à jour continues)

- APIs légères servant d'interface entre frontend et base de données

- Outils de développement (scripts de build, serveurs locaux, automatisation) qui bénéficiaient d'un JavaScript « partout »

Même lorsque des équipes conservaient des systèmes cœur dans d'autres langages, Node.js devenait souvent le service « glue » : gérer des requêtes, orchestrer des appels à d'autres systèmes ou alimenter des utilitaires internes.

Un langage de bout en bout

Un grand changement fut autant culturel que technique. Quand frontend et backend utilisent JavaScript, les équipes peuvent partager règles de validation, modèles de données et parfois des parties de la logique métier. Les développeurs changent moins de contexte entre écosystèmes, ce qui aide les petites équipes à aller plus vite et les grandes équipes à standardiser leurs pratiques de construction et de revue de code.

npm et l'écosystème qui a étendu la portée de JavaScript

Itérez en toute sécurité avec rollback

Créez des instantanés et revenez rapidement en cas d'échec d'une expérience.

npm (le Node Package Manager) est « l'app store » du code JavaScript. Plutôt que d'écrire tout de zéro — gestion des dates, routage, tests, widgets UI — les équipes pouvaient installer un paquet et passer à autre chose. Ce flux (« install, import, ship ») a accéléré le développement et donné à JavaScript l'apparence d'une boîte à outils partagée.

Pourquoi le partage de paquets a accéléré l'adoption

Une fois Node.js utile hors du navigateur, npm a donné aux développeurs une manière standard de publier et réutiliser des modules. Une petite librairie créée pour un projet pouvait profiter soudainement à des milliers d'autres. Le progrès a ainsi composé : chaque nouveau paquet a rendu le prochain projet plus rapide à construire.

Les librairies open source ont aussi abaissé le coût d'expérimentation. Une startup pouvait assembler un produit crédible avec une petite équipe en s'appuyant sur des paquets maintenus par la communauté pour le logging, l'authentification, les outils de build, etc.

Semver et lockfiles (sans le jargon)

La plupart des paquets npm suivent le versionnage sémantique (semver), une version en trois parties comme 2.4.1 :

- Major (

2) : changements potentiellement incompatibles.

- Minor (

4) : nouvelles fonctionnalités compatibles.

- Patch (

1) : corrections de bugs.

Les lockfiles (comme package-lock.json) enregistrent les versions exactes installées pour que tout le monde dans l'équipe — et votre CI — obtienne le même ensemble de dépendances. Cela évite les surprises du type « ça marche sur ma machine » causées par de petites différences de versions.

Les compromis : prolifération de dépendances et maintenance

L'inconvénient des installations faciles est la surutilisation facile. Les projets peuvent accumuler des centaines de dépendances indirectes, augmentant le travail de mise à jour et le risque au niveau de la chaîne d'approvisionnement. Certains paquets deviennent non maintenus, forçant les équipes à pinner des versions anciennes, remplacer des librairies ou en prendre la maintenance. L'écosystème a permis la vitesse — mais a aussi fait de l'hygiène des dépendances une partie réelle du déploiement logiciel.

Les frontends mûrissent : SPAs, frameworks et code partagé

Les premiers sites assemblaient surtout des pages côté serveur. Puis les Single-Page Applications (SPAs) ont inversé le modèle : le navigateur est devenu le « runtime » de l'application, récupérant des données et rendant l'UI sans rechargements complets.

Ce changement n'a pas seulement modifié le code — il a déplacé des responsabilités. Le travail frontend est passé de « faire en sorte que cette page ait l'air bien » à prendre en charge le routage, l'état, le cache, l'accessibilité et les budgets de performance. Designers, ingénieurs backend et équipes produit ont commencé à collaborer autour de composants et de parcours utilisateurs, pas seulement de templates.

Les frameworks ont rendu la complexité gérable

À mesure que les SPAs grandissaient, le JavaScript ad‑hoc devenait vite difficile à maintenir. React, Angular et Vue ont aidé en offrant des patrons pour organiser la complexité UI :

- Structure basée sur des composants (UI comme blocs réutilisables)

- Gestion d'état plus prévisible (moins de « où cette valeur a-t-elle changé ? »)

- Flux de données clair entre UI et APIs

Chaque écosystème fait des compromis différents, mais le grand bénéfice est l'émergence de conventions partagées. Lorsqu'un nouvel ingénieur arrive, il reconnaît souvent le même modèle mental à travers les écrans et les fonctionnalités.

SSR et apps « universelles » : le pont vers des sites plus rapides et mieux référencés

Les SPAs peinaient parfois sur la rapidité du premier affichage et le SEO, car le navigateur devait télécharger et exécuter beaucoup de JavaScript avant d'afficher le contenu.

Le rendu côté serveur (SSR) et les apps « universelles » ont comblé ce fossé : rendre la première vue sur le serveur pour un affichage et une indexation rapides, puis « hydrater » côté client pour l'interactivité. Cette approche est devenue courante avec des frameworks comme Next.js (React) et Nuxt (Vue), surtout pour les pages riches en contenu et l'e‑commerce.

Le code partagé a changé la façon dont les entreprises construisent des produits

Quand frontend et backend sont tous deux à l'aise avec JavaScript, les équipes commencent à partager la logique à travers la pile :

- Règles de validation utilisées dans les formulaires et sur le serveur

- Types/interfaces (souvent via TypeScript) pour réduire les désaccords d'API

- Clients API partagés et gestion d'erreurs

Résultat : moins de règles dupliquées, livraison de fonctionnalités plus rapide et une tendance vers la pensée « base de code produit unique » à travers les équipes.

TypeScript et le JavaScript moderne pour les grandes équipes

À mesure que JavaScript passait de « un peu de scripting navigateur » à des apps critiques, les équipes ont commencé à entendre « JavaScript » pour désigner tout un ensemble d'outils liés : caractéristiques ECMAScript modernes, pipelines de build et souvent TypeScript.

Pourquoi TypeScript est devenu courant (même quand on dit « JavaScript »)

TypeScript reste JavaScript au fond — il ajoute juste un système de types et une étape de compilation. Cela le rend facile à adopter progressivement : vous pouvez commencer par typer quelques fichiers, garder le reste en .js et produire une seule application bundleée.

C'est pourquoi beaucoup d'équipes disent qu'elles « écrivent JavaScript » même si la base de code est majoritairement en .ts : le runtime est JavaScript, l'écosystème est JavaScript (paquets npm, APIs navigateur, Node.js) et la sortie de TypeScript est JavaScript.

Quand une base de code grossit, la difficulté n'est pas d'écrire de nouvelles fonctionnalités — c'est de changer les anciennes en toute sécurité. Les types servent de contrats légers :

- Si vous renommez une propriété ou changez l'entrée d'une fonction, votre éditeur et la compilation signaleront les endroits manquants

- L'autocomplétion devient plus précise, les développeurs passent moins de temps à chercher dans la doc ou le code

- Les revues sont plus faciles parce que beaucoup d'erreurs « évidentes » sont détectées avant la fusion

Le bénéfice clé est la confiance : les équipes peuvent refactorer et livrer des changements avec moins de régressions.

Transpilation, expliquée simplement

Le JavaScript moderne évolue vite, mais tous les environnements ne supportent pas immédiatement chaque nouvelle fonctionnalité. La transpilation consiste simplement à :

- Écrire du code moderne (et TypeScript)

- Le compiler en JavaScript compatible largement pour qu'il s'exécute partout

Cela permet d'utiliser une syntaxe neuve sans attendre que chaque appareil dans la nature soit à jour.

Normes modernes qui ont changé le JavaScript au quotidien

Beaucoup de ce qui rend le « JavaScript moderne » mature sont des fonctionnalités standardisées qui améliorent la structure et la lisibilité :

- Modules ES (

import/export) pour un code propre et réutilisable

- async/await pour une logique asynchrone plus claire que des callbacks imbriqués

- Mises à jour continues d'ECMAScript (utilitaires objets/tableaux, opérateurs plus sûrs, itération améliorée)

Combinés, TypeScript et ECMAScript moderne ont transformé les projets JavaScript en quelque chose d'évolutif : plus facile à maintenir, plus facile à onboarder et moins risqué à changer.

Les outils ont fait de JavaScript la colle des entreprises

Accélérez votre pipeline de build

Passez des transferts lents à un workflow de build unique piloté par chat pour le web, le serveur et le mobile.

JavaScript n'est pas devenu « omniprésent en entreprise » seulement parce qu'il s'exécutait dans les navigateurs et sur les serveurs. Il est aussi devenu le langage que nombreuses d'équipes utilisent pour faire tourner le travail : construire, tester, publier et automatiser les tâches quotidiennes. Une fois cela en place, JavaScript a cessé d'être juste un langage d'app et est devenu une couche opérationnelle interne.

Outils de build, tests et automatisation

À mesure que les frontends se complexifiaient, les équipes avaient besoin de builds reproductibles et de contrôles fiables. Les outils basés sur JavaScript rendaient cela naturel parce qu'ils résident dans le même repo et utilisent le même écosystème de paquets.

Une configuration typique peut inclure :

- Scripts de build et bundling pour produire des assets prêts pour la production

- Linting et formatage pour garder le code lisible entre équipes

- Tests unitaires et end-to-end pour attraper les régressions avant la sortie

- Petits scripts d'automatisation pour migrations, traitement de contenu ou notes de release

Parce que ces outils s'exécutent sur toute machine dev et en CI, ils réduisent le problème du « ça marche sur mon laptop ». En pratique, cette chaîne d'outils « JavaScript partout » rend aussi possibles les workflows modernes : quand UI, build et déploiement sont standardisés, on peut générer et itérer des applications réelles rapidement. Des plateformes comme Koder.ai s'inscrivent dans cette réalité — permettant aux équipes de décrire une app en chat et de produire des projets prêts pour la production (souvent React côté frontend) avec export de code source, déploiement/hébergement, domaines personnalisés et snapshots/rollback pour itérer en sécurité.

Code partagé à l'échelle : monorepos et design systems

Les entreprises en croissance tendent vers des monorepos pour que plusieurs apps partagent un ensemble unique de dépendances, configs et conventions. Cela facilite la maintenance de bibliothèques de composants partagées, SDK internes et design systems — sans copier le code entre projets.

Quand un bouton du design system reçoit une correction d'accessibilité, chaque produit peut l'adopter via une simple montée de version ou un paquet partagé. JavaScript (et de plus en plus TypeScript) rend ce partage pratique parce que les mêmes composants peuvent alimenter prototypes, UI de production et documentation.

Les gates qualité CI/CD comme standard

Une fois linting, tests et builds standardisés, ils deviennent des garde-fous dans les pipelines CI/CD : les merges sont bloqués si les checks échouent, les releases sont automatisées et les handoffs entre équipes sont plus fluides. Résultat : moins de savoir tribal, moins de processus one-off et un chemin plus rapide de l'idée à la fonctionnalité livrée.

Ce que JavaScript ne sait pas bien faire (et où il va)

JavaScript s'exécute presque partout désormais — dans des containers sur Kubernetes, comme fonctions serverless et de plus en plus à la périphérie (CDNs et runtimes edge). Cette flexibilité est une grande raison pour laquelle les équipes le standardisent : un langage, de nombreuses options de déploiement.

Où JavaScript atteint ses limites

JavaScript est excellent pour le travail I/O‑intensif (APIs, serveurs web, gestion d'événements), mais il peut peiner quand on le pousse dans le domaine du « calcul lourd » :

- Plafonds de performance : le JS compilé JIT peut être rapide, mais il ne remplace pas des performances bas‑niveau et prévisibles. Les services sensibles à la latence peuvent subir des pauses liées au GC.

- Usage mémoire : de gros processus Node.js peuvent consommer plus de mémoire que des services équivalents dans des langages optimisés pour les backends longue durée.

- Travail CPU prolongé : traitement vidéo, crunching de gros volumes de données, entraînement ML et autres tâches CPU soutenues appartiennent souvent à des services spécialisés (ou modules natifs), JS orchestrant plutôt que s'exécutant.

La sécurité est un poste de coût réel

L'écosystème npm est une force — et un risque pour la chaîne d'approvisionnement. Les équipes mûres traitent les dépendances comme des fournisseurs tiers : pinner les versions, automatiser les audits, minimiser le nombre de dépendances et imposer des gates de revue pour les nouveaux paquets. « Rapide à ajouter » doit être équilibré avec « sûr à exécuter ».

Pourquoi cela compte pour startups et entreprises

Pour les startups, JavaScript réduit le time-to-market : compétences partagées entre frontend et backend, recrutement simplifié et déploiement direct en serverless ou containers à mesure que le trafic croît. Pour les entreprises, il offre la standardisation — plus un besoin clair de gouvernance (hygiène des dépendances, pipelines de build, politiques runtime).

Un pattern pratique courant est de concentrer JavaScript/TypeScript sur la logique produit et l'expérience utilisateur, tout en déléguant les parties sensibles en performance ou gouvernance à des services écrits en Go ou Rust. C'est pourquoi les stacks hybrides sont de plus en plus normaux — par exemple, frontends React avec backends en Go et PostgreSQL pour des performances et une simplicité opérationnelle prévisibles.

Vers quoi va-t-on

WebAssembly continuera d'étendre ce qui est pratique dans les runtimes web et serveur, permettant d'exécuter du code presque natif aux côtés de JavaScript. L'avenir probable n'est pas « JS remplace tout », mais JS reste la colle : coordonnant des services qui mélangent de plus en plus TypeScript/JS avec Rust/Go/Python là où cela a du sens.

Au niveau des workflows, la prochaine étape porte souvent moins sur une nouvelle fonctionnalité de syntaxe que sur des boucles de rétroaction plus courtes : planifier, générer, revoir et déployer plus vite sans perdre le contrôle. C'est la niche où des outils comme Koder.ai s'insèrent naturellement dans un monde dominé par JavaScript — aidant les équipes à passer de l'idée à une app web/serveur/mobile fonctionnelle via le chat, tout en conservant l'option d'exporter et de posséder le code quand il faut durcir et monter en charge.