Ce que cette histoire explique (au‑delà du portrait du fondateur)

Ceci n’est pas une biographie de Jay Chaudhry. C’est une histoire pratique sur la manière dont Zscaler a aidé à remodeler la sécurité d’entreprise — et pourquoi ses choix (techniques et commerciaux) ont compté.

Vous apprendrez deux choses en parallèle :

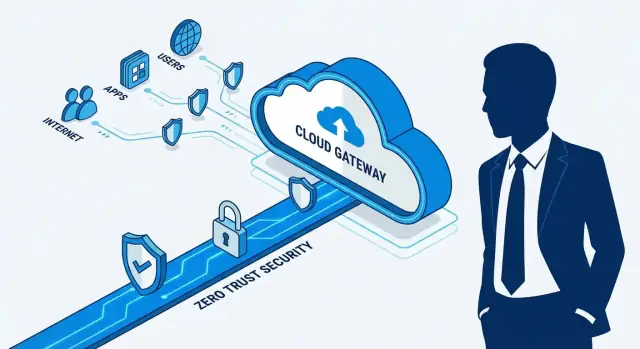

- Un modèle de sécurité : comment le « zero trust » fonctionne quand vos applications et vos utilisateurs sont répartis entre services cloud, bureaux et domiciles.

- Un modèle économique : comment une entreprise de sécurité est adoptée par de grandes entreprises qui bougent lentement, achètent via des partenaires et évitent des migrations risquées.

Ce que « sécurité d’entreprise moderne » veut dire (en clair)

La sécurité d’entreprise moderne est l’ensemble des contrôles qui permet aux employés d’utiliser Internet et les applications internes en toute sécurité, sans supposer qu’une ressource est sûre simplement parce qu’elle se trouve « à l’intérieur » d’un réseau d’entreprise. Il s’agit moins de construire un mur plus grand autour d’un centre de données que de vérifier qui se connecte, à quoi il se connecte, et si la connexion doit être autorisée — à chaque fois.

Les trois piliers auxquels nous reviendrons

- Délivrance cloud : les fonctions de sécurité passent des boîtiers on‑premise à un service capable de monter en charge globalement.

- Zero trust : l’accès repose sur l’identité, le contexte et la politique — pas sur l’emplacement réseau.

- Distribution : la sécurité d’entreprise se diffuse via la réalité des achats : partenaires channel, acteurs en place, et déploiements répétables.

Ce que vous retirerez

À la fin, vous pourrez expliquer le pari central de Zscaler en une phrase, reconnaître où le zero trust remplace la pensée de l’ère VPN, et voir pourquoi la stratégie de distribution peut compter autant que la conception du produit.

Jay Chaudhry en une page : le regard du fondateur

Jay Chaudhry est un entrepreneur en série surtout connu comme fondateur et CEO de Zscaler, une société qui a contribué à faire évoluer la sécurité d’entreprise de « protéger le réseau d’entreprise » vers « sécuriser les utilisateurs et les applications où qu’ils soient ». Avant Zscaler, il a fondé et vendu plusieurs startups de sécurité, ce qui lui a donné une vision directe de l’évolution rapide des comportements des attaquants et de l’IT d’entreprise.

Le problème qu’il a choisi de poursuivre

Le focus de Chaudhry avec Zscaler était simple : à mesure que le travail et les applications quittaient le réseau d’entreprise (vers Internet public et les services cloud), l’ancien modèle consistant à router tout via un data center central pour inspection a commencé à s’effondrer.

Ce changement a créé un compromis douloureux pour les équipes IT :

- Si vous forciez tout le trafic à repasser par le siège, les performances souffraient et les utilisateurs contournaient les contrôles.

- Si vous laissiez les utilisateurs aller directement vers les applications cloud, la visibilité et l’application des politiques s’affaiblissaient.

La prémisse fondatrice de Zscaler était que la sécurité devait suivre l’utilisateur, pas le bâtiment.

Une vision portée par le fondateur qui a façonné une catégorie

Ce qui ressort, c’est la manière dont la vision produit portée par le fondateur a influencé la stratégie dès le départ :

- Délivrance cloud en priorité plutôt que d’envoyer des appliances que les clients doivent maintenir.

- Application des politiques à grande échelle en rapprochant l’inspection de l’endroit où les utilisateurs se connectent.

- Un point de vue architectural clair : réduire la confiance implicite, valider l’accès en continu, et considérer Internet et le cloud comme l’environnement par défaut.

Ce n’était pas un simple ajustement marketing ; cela a orienté les décisions produit, les partenariats et la manière dont Zscaler expliquait le « pourquoi » aux acheteurs d’entreprise conservateurs. Avec le temps, cette clarté a aidé à transformer « sécurité cloud‑délivrée » et « zero trust » en lignes budgétaires — quelque chose que les grandes entreprises pouvaient acheter, déployer et standardiser.

Pourquoi l’ancien modèle périmétrique a commencé à échouer

Pendant des années, la sécurité d’entreprise s’est construite autour d’une idée simple : garder « les choses importantes » à l’intérieur du réseau d’entreprise, et dresser un mur autour. Ce mur était généralement une pile d’appliances on‑premise — pare‑feux, proxys web, prévention d’intrusion — situées dans quelques data centers. Les employés distants accédaient via un VPN, qui « étendait » effectivement le réseau interne où qu’ils soient.

Le modèle pré‑cloud en pratique

Quand la plupart des applications vivaient dans les centres de données de l’entreprise, cela fonctionnait raisonnablement bien. Le trafic web et applicatif passait par les mêmes points de passage, où les équipes de sécurité pouvaient inspecter, journaliser et bloquer.

Mais le modèle supposait deux choses qui sont devenues fausses :

- Les utilisateurs étaient principalement au bureau, sur des réseaux gérés.

- Les applications étaient majoritairement à l’intérieur du périmètre.

Pourquoi ça a craqué : utilisateurs nomades, SaaS et web ouvert

À mesure que les employés sont devenus plus mobiles et que l’adoption du SaaS a accéléré, les schémas de trafic ont basculé. Des personnes dans des cafés ont besoin d’un accès rapide à Office 365, Salesforce et des dizaines d’outils basés sur le navigateur — souvent sans jamais toucher un data center d’entreprise.

Pour continuer à appliquer des politiques, de nombreuses entreprises ont « backhaulé » le trafic : envoyer les requêtes Internet et SaaS d’un utilisateur via le siège d’abord, les inspecter, puis les renvoyer. Le résultat était prévisible : performances lentes, utilisateurs mécontents et pression croissante pour ouvrir des trous dans les contrôles.

Les points de douleur ressentis en premier par les équipes de sécurité

La complexité a explosé (plus d’appliances, plus de règles, plus d’exceptions). Les VPN sont devenus saturés et risqués quand ils accordaient un large accès réseau. Et chaque nouvelle agence ou acquisition signifiait un nouveau déploiement matériel, plus de planification de capacité, et une architecture plus fragile.

Ce besoin d’une sécurité cohérente sans forcer tout à passer par un périmètre physique a créé l’ouverture pour une sécurité cloud‑délivrée qui suit l’utilisateur et l’application, pas le bâtiment.

Sécurité cloud‑délivrée : le pari central

Le pari définissant Zscaler était simple à énoncer mais difficile à exécuter : délivrer la sécurité comme un service cloud, positionné près des utilisateurs, plutôt que sous forme de boîtiers à l’intérieur du réseau de l’entreprise.

Ici, « sécurité cloud » ne signifie pas protéger seulement des serveurs cloud. Cela veut dire que la sécurité elle‑même s’exécute dans le cloud : un utilisateur en agence, à la maison ou sur mobile se connecte à un point de présence (PoP) proche, et la politique est appliquée là.

Ce que signifie l’inspection « inline » (sans jargon)

« Inliner » revient à faire passer le trafic par un point de contrôle avant d’atteindre sa destination.

Quand un employé va sur un site web ou une application cloud, sa connexion est dirigée via le service d’abord. Le service inspecte ce qu’il peut (selon la politique), bloque les destinations risquées, scanne les menaces, puis transmet le trafic autorisé. L’objectif est que les utilisateurs n’aient pas besoin « d’être sur le réseau interne » pour bénéficier d’une protection de niveau entreprise : la sécurité suit l’utilisateur.

Pourquoi cela attire les entreprises

La sécurité cloud‑délivrée change la réalité quotidienne des équipes IT et sécurité :

- Déploiement simplifié : moins d’appliances à expédier, monter en rack et maintenir à chaque emplacement.

- Mises à jour plus rapides : les protections se mettent à jour centralement, sans cycles d’upgrade on‑prem.

- Politique cohérente : un jeu de règles unique pour bureaux, télétravailleurs et environnements multi‑cloud.

Ce modèle s’aligne également sur la manière dont les entreprises travaillent aujourd’hui : le trafic va souvent directement vers le SaaS et Internet public, pas « retourner au siège » d’abord.

Les compromis (sans l’hyperbole)

Plaquer un tiers inline soulève de vraies préoccupations à évaluer :

- Confiance et gestion des données : qu’est‑ce qui est inspecté, journalisé, déchiffré (le cas échéant), et comment est‑il conservé.

- Différences de visibilité : certaines équipes regrettent la visibilité « au niveau du boîtier », même si les tableaux de bord s’améliorent.

- Dépendance au service : les pannes ou problèmes de performance régionaux peuvent rapidement devenir des problèmes métier.

Le pari central n’est donc pas que technique uniquement : il s’agit d’avoir confiance opérationnelle qu’un fournisseur cloud peut appliquer les politiques de manière fiable, transparente et à l’échelle mondiale.

Zero Trust, expliqué pour les non‑techniques

Le Zero Trust est un principe simple : ne jamais supposer qu’une ressource est sûre simplement parce qu’elle est “dans le réseau de l’entreprise”. Au lieu de cela, vérifier toujours qui est l’utilisateur, quel appareil il utilise, et s’il doit accéder à une application ou une donnée spécifique — à chaque fois que c’est pertinent.

Le changement : de « l’accès réseau » à « l’accès applicatif »

La pensée traditionnelle du VPN revient à donner à quelqu’un un badge qui ouvre tout un bâtiment une fois passé la porte. Après la connexion VPN, de nombreux systèmes traitent cet utilisateur comme « interne », ce qui peut exposer plus que nécessaire.

Le Zero Trust inverse ce modèle. C’est plutôt donner à quelqu’un l’accès à une seule pièce pour une tâche. Vous ne « rejoignez pas le réseau » largement ; vous êtes autorisé à atteindre seulement l’application pour laquelle vous êtes approuvé.

Exemples simples du quotidien

Un sous‑traitant a besoin d’accéder à un outil de gestion de projet pendant deux mois. Avec le Zero Trust, il peut être autorisé dans cette seule application — sans créer accidentellement un chemin vers les systèmes de paie ou les outils d’administration interne.

Un employé utilise son propre ordinateur (BYOD) en voyage. Les politiques Zero Trust peuvent exiger des contrôles d’authentification renforcés ou bloquer l’accès si l’appareil est obsolète, non chiffré ou montre des signes de compromission.

Le travail à distance devient plus facile à sécuriser parce que la décision de sécurité suit l’utilisateur et l’application, pas un réseau de bureau physique.

Ce que le Zero Trust n’est pas

Le Zero Trust n’est pas un produit unique que vous achetez et « activez ». C’est une approche de sécurité mise en œuvre via des outils et des politiques.

Ce n’est pas non plus « ne faire confiance à personne » de manière hostile. En pratique, cela signifie que la confiance se gagne en continu via des vérifications d’identité, l’état des appareils et le principe du moindre privilège — de sorte que les erreurs et les brèches ne se propagent pas automatiquement.

Carte générale de l’approche Zscaler

Organisez les applications pour la migration

Constituez un inventaire léger des applications et un registre des responsables pour soutenir des migrations par phases.

Zscaler se comprend le plus simplement comme un « point de contrôle » cloud placé entre les personnes et ce qu’elles essaient d’atteindre. Plutôt que de faire confiance à une frontière réseau d’entreprise, il évalue chaque connexion selon qui est l’utilisateur et quel est le contexte, puis applique la bonne politique.

Les blocs de construction principaux

La plupart des déploiements se décrivent avec quatre éléments simples :

- Utilisateurs : employés, sous‑traitants, partenaires — toute identité se connectant.

- Applications & destinations : sites Internet publics (SaaS, web) et applications privées (systèmes internes).

- Politiques : règles comme « les finances peuvent accéder à la paie », « bloquer les uploads risqués », ou « exiger des contrôles renforcés hors réseau ».

- Application cloud : un service de sécurité cloud applique ces politiques proche de là où les utilisateurs se connectent, plutôt que de renvoyer le trafic vers un data center unique.

Deux voies : sécurité Internet vs accès aux applis privées

Conceptuellement, Zscaler divise le trafic en deux voies :

- Sécurité Internet/SaaS (secure web gateway) : protège la navigation et l’usage des applications cloud — filtrage, inspection et contrôle de ce qui quitte/entre la session utilisateur.

- Accès aux applications privées : fournit une connectivité spécifique aux applications internes sans mettre l’utilisateur « sur le réseau » comme un VPN traditionnel.

Cette séparation compte : une voie concerne l’usage sûr d’Internet ; l’autre concerne l’accès précis aux systèmes internes.

« Identité + contexte » sans les mots à la mode

Les décisions ne reposent pas sur une adresse IP de bureau de confiance. Elles reposent sur des signaux tels que qui est l’utilisateur, la santé de l’appareil (géré vs non géré, patché vs obsolète), et où/comment il se connecte.

Ce que cela donne en termes de résultats

Bien exécutée, cette approche réduit la surface d’attaque exposée, limite les mouvements latéraux en cas de problème, et transforme le contrôle d’accès en un modèle de politique plus simple et cohérent — particulièrement pertinent avec le travail à distance et les piles applicatives cloud‑first.

Secure Web Gateway : le côté Internet de l’histoire

Quand on parle de « sécurité d’entreprise », on imagine souvent des applications privées et des réseaux internes. Mais une grande part du risque se trouve côté Internet ouvert : employés qui consultent des sites d’actualité, cliquent sur des liens dans des e‑mails, utilisent des outils navigateur ou uploadent des fichiers vers des apps web.

Une Secure Web Gateway (SWG) est la catégorie qui rend cet accès Internet quotidien plus sûr — sans forcer tout le trafic des utilisateurs à rebondir via un bureau central.

Quel problème une SWG résout

Simplement, une SWG agit comme un point de contrôle entre les utilisateurs et le web public. Plutôt que de faire confiance à ce qu’un appareil atteint, la gateway applique des politiques et de l’inspection pour réduire l’exposition à des sites malveillants, des téléchargements risqués et des fuites de données accidentelles.

Les protections typiques incluent :

- Filtrage d’URL : autoriser/refuser par catégorie, réputation ou politique

- Blocage de malwares : stopper les fichiers connus comme malveillants, les scripts suspects et les destinations de phishing

- Contrôles de données : détecter et prévenir l’envoi de données sensibles vers des destinations non approuvées

Pourquoi la SWG cloud a accéléré avec le SaaS et les utilisateurs mobiles

L’accélération est survenue quand le travail s’est déplacé hors des bureaux fixes vers le SaaS, les navigateurs et les mobiles. Si les utilisateurs et les applications sont partout, renvoyer tout le trafic vers un périmètre unique ajoute de la latence et crée des angles morts.

La SWG cloud‑délivrée correspond à la nouvelle réalité : la politique suit l’utilisateur, le trafic peut être inspecté près du point de connexion, et les équipes sécurité obtiennent un contrôle cohérent sur sièges, succursales et télétravail — sans traiter Internet comme une exception.

Remplacer la pensée VPN par l’accès centré sur l’application

Les VPN ont été conçus quand « être sur le réseau » signifiait pouvoir atteindre les applications. Ce modèle mental se casse quand les applications se répartissent sur plusieurs clouds, SaaS, et qu’il reste peu de systèmes on‑prem.

Accès aux applications privées sans exposer le réseau

L’accès centré sur l’application inverse le défaut. Plutôt que de déposer un utilisateur sur le réseau interne (en espérant que la segmentation tienne), l’utilisateur est connecté uniquement à une application spécifique.

Conceptuellement, cela fonctionne comme une connexion brokerisée : l’utilisateur prouve qui il est et ce à quoi il a droit, puis un chemin court et contrôlé est créé vers cette application — sans publier des plages IP internes sur Internet et sans donner une visibilité interne large à l’utilisateur.

Pourquoi la segmentation par application surclasse la segmentation réseau (la plupart du temps)

La segmentation réseau est puissante, mais fragile dans les organisations réelles : fusions, VLAN plats, applications legacy et exceptions s’accumulent. La segmentation par application est plus facile à comprendre car elle se rapproche de l’intention métier :

- Les utilisateurs finance peuvent atteindre l’application finance.

- Les sous‑traitants peuvent atteindre un seul outil de projet.

- Les administrateurs peuvent atteindre des consoles privilégiées — avec des contrôles renforcés.

Cela réduit la confiance implicite et rend les politiques d’accès auditable : vous pouvez les vérifier par application et groupe d’utilisateurs plutôt qu’en retraçant des routes et des sous‑réseaux.

Un chemin d’adoption commun

La plupart des équipes ne remplacent pas le VPN du jour au lendemain. Un déploiement pratique ressemble souvent à :

- Commencer par une application interne qui crée une douleur VPN (help desk, portail dev, outil RH).

- Étendre à un département, puis répéter pour l’ensemble des applications.

- Garder le VPN comme solution de secours pendant la transition, puis réduire son utilisation progressivement.

Résultats mesurables pour l’entreprise

Quand l’accès centré sur l’application est bien fait, les gains se voient vite : moins de tickets liés au VPN, des règles d’accès plus claires que sécurité et IT peuvent expliquer, et une expérience utilisateur plus fluide — surtout pour les employés distants et hybrides qui veulent simplement que l’application fonctionne sans « se connecter au réseau » d’abord.

Créez un portail de demandes d'exception

Prototypez un portail de demandes d'accès pour exceptions, approbations et traces d'audit en quelques jours.

De bons produits de sécurité ne deviennent pas automatiquement des standards d’entreprise. En pratique, la « distribution » en sécurité d’entreprise désigne l’ensemble des voies qu’un fournisseur utilise pour atteindre, gagner et déployer avec succès au sein de grandes organisations — souvent via d’autres entreprises.

Ce que « distribution » inclut réellement

En sécurité, la distribution couvre typiquement :

- Partenaires channel et revendeurs qui présentent le produit, le packagent avec d’autres outils et aident à naviguer les achats.

- Intégrateurs systèmes (SIs) et fournisseurs de services managés (MSPs) qui conçoivent les déploiements, relient l’identité et le réseau, et gèrent les opérations day‑2.

- Alliances technologiques (fournisseurs d’identité, éditeurs d’endpoint, plateformes cloud) qui facilitent les déploiements et renforcent la confiance des acheteurs.

Ce ne sont pas des options. Ce sont les tuyaux qui relient un fournisseur aux budgets, aux décideurs et à la capacité d’implémentation.

Pourquoi le channel compte plus qu’on ne le croit

Les grandes entreprises achètent prudemment. Les partenaires apportent :

- Confiance et validation (« nous l’avons déjà implémenté »)

- Aide à l’implémentation quand les équipes internes sont débordées

- Portée procurement via des listes de fournisseurs approuvés et contrats existants

- Couverture géographique et sectorielle sans bâtir une énorme force de vente directe partout

Pour une plateforme comme Zscaler, l’adoption dépend souvent du travail réel de migration : déplacer les utilisateurs hors des modèles VPN legacy, intégrer l’identité et affiner les politiques. Les partenaires rendent ce changement gérable.

La délivrance cloud transforme l’activité d’installations ponctuelles en abonnement, expansion et renouvellements. Cela change la distribution : les partenaires ne sont pas seulement des « clôtureurs de contrats ». Ils peuvent être des partenaires de déploiement continus dont les incitations s’alignent sur les résultats clients — si le programme est bien conçu.

À surveiller (pour les équipes qui évaluent des fournisseurs)

Examinez attentivement les incitations partenaires, la qualité de l’habilitation des partenaires (formation, playbooks, support co‑selling), et la fluidité des rapports de réussite client après signature du contrat. Beaucoup de déploiements échouent non pas parce que le produit est faible, mais parce que la responsabilité entre fournisseur, partenaire et client devient floue.

Timing de la catégorie : cloud, travail à distance et SASE/SSE

L’achat en sécurité commence rarement par « nous avons besoin de meilleure sécurité ». Il commence habituellement par un changement réseau qui casse les anciennes hypothèses : des applications migrent vers le SaaS, des sites adoptent SD‑WAN, ou le travail à distance devient permanent. Quand le trafic ne passe plus par un bureau central, le modèle de protection au siège crée latence, exceptions et angles morts.

Pourquoi le timing de la catégorie a compté

Zscaler est souvent cité dans les mêmes conversations que SASE et SSE parce que ces étiquettes décrivent un changement dans la manière dont la sécurité est délivrée :

- SSE (Security Service Edge), en clair : des contrôles de sécurité fournis depuis le cloud pour que les utilisateurs obtiennent une protection cohérente où qu’ils soient.

- SASE (Secure Access Service Edge) : la même idée, plus l’aspect réseau (souvent SD‑WAN) pour que connectivité et sécurité soient conçues ensemble.

Le vrai « gain traduit » n’est pas l’acronyme : c’est la simplification opérationnelle : moins de boîtiers on‑prem, des mises à jour de politique plus simples, et un accès direct aux applications sans renvoyer le trafic par un data center.

Checklist pratique : quand évaluer ces solutions

Une société évalue généralement les approches de type SSE/SASE quand :

- Une migration cloud augmente significativement le trafic Internet/SaaS

- Un déploiement SD‑WAN change le routage des succursales et révèle des lacunes dans les contrôles existants

- La capacité VPN et l’expérience utilisateur deviennent des problèmes chroniques (surtout pour les sous‑traitants)

- Les politiques de sécurité diffèrent selon les bureaux parce que les outils sont déployés site‑par‑site

- L’équipe a besoin d’un onboarding plus rapide pour de nouveaux sites, acquisitions ou télétravailleurs

- Les audits exigent une visibilité claire sur qui a accédé à quelle application et depuis où

Quand ces déclencheurs apparaissent, la catégorie « arrive » naturellement — parce que le réseau a déjà changé.

Réalités d’implémentation : ce qui fait réussir ou échouer un déploiement

Itérez sans crainte

Expérimentez des workflows en toute sécurité grâce aux snapshots et aux retours en arrière pendant que vous affinez les besoins.

Acheter une plateforme Zero Trust est généralement la partie facile. La faire fonctionner à travers des réseaux compliqués, des applications héritées et des personnes réelles est là où les projets réussissent — ou s’enlisent.

Les obstacles d’adoption les plus fréquents

Les applications legacy sont le récidiviste. Les anciens systèmes supposent souvent que « être sur le réseau = digne de confiance », s’appuient sur des allowlists IP codées en dur, ou cassent quand le trafic est inspecté.

Les autres frictions sont humaines : gestion du changement, refonte des politiques, et débats sur « qui possède quoi ». Passer d’un large accès réseau à des règles applicatives précises force les équipes à documenter comment le travail se fait réellement — et cela peut révéler des lacunes longtemps ignorées.

Parties prenantes à impliquer tôt

Les déploiements se passent mieux quand la sécurité n’agit pas seule. Attendez‑vous à coordonner avec :

- Les équipes sécurité et réseau (routage du trafic, décisions de segmentation)

- IT/help desk (posture des appareils, onboarding, support utilisateur)

- Conformité/risque (journalisation, gestion des données, attentes d’audit)

- Propriétaires d’applications métier (quoi est critique, quoi peut casser, ce qui change bientôt)

Une stratégie pilote qui réduit le risque

Commencez par un groupe à faible risque (par ex. un département ou un sous‑ensemble de sous‑traitants) et définissez les métriques de succès dès le départ : moins de tickets VPN, accès aux applications plus rapides, réduction mesurable de la surface d’attaque exposée, ou meilleure visibilité.

Menez le pilote par itérations : migrez une catégorie d’apps à la fois, ajustez les politiques, puis étendez. L’objectif est d’apprendre vite sans transformer toute l’entreprise en environnement de test.

Réalités opérationnelles : le travail day‑2

Planifiez la journalisation et le dépannage dès le jour 1 : où les logs résident, qui peut les interroger, combien de temps ils sont conservés, et comment les alertes s’intègrent à la réponse aux incidents. Si les utilisateurs ne peuvent pas obtenir d’aide quand « l’app est bloquée », la confiance chute vite — même si le modèle de sécurité est pertinent.

Un accélérateur pratique (et souvent négligé) est l’outillage interne : portails simples pour demandes d’exception, revues d’accès, inventaires d’apps, suivi des déploiements et reporting. Les équipes construisent de plus en plus ces « apps glue » légères elles‑mêmes plutôt que d’attendre la feuille de route du fournisseur. Des plateformes comme Koder.ai peuvent aider les équipes à prototyper et livrer rapidement ces outils internes via un flux de travail piloté par chat — utile quand vous avez besoin d’un dashboard React avec un backend Go/PostgreSQL, plus des itérations rapides à mesure que les politiques et processus mûrissent.

Risques et compromis à considérer (sans l’hyperbole)

Déplacer des contrôles de sécurité d’appliances que vous possédez vers une plateforme cloud‑délivrée peut simplifier les opérations — mais cela change les modes de défaillance possibles. Une bonne décision n’est pas « Zero Trust vs legacy », mais plutôt comprendre ces nouveaux risques.

Risque de concentration (un fournisseur, de nombreuses fonctions)

Si une seule plateforme fournit la sécurité web, l’accès aux applis privées, l’application des politiques et la journalisation, vous réduisez l’étalement des outils — mais vous concentrez aussi le risque. Un différend contractuel, un changement de tarification, ou un manque fonctionnel peut avoir un impact bien plus large que lorsque ces pièces étaient réparties.

La sécurité cloud ajoute un saut supplémentaire entre les utilisateurs et les apps. Quand tout fonctionne, les utilisateurs ne remarquent presque rien. Quand une région subit une panne, un problème de routage ou de capacité, la « sécurité » peut ressembler à « Internet est en panne ». Ce n’est pas spécifique à un fournisseur, mais c’est le coût d’une dépendance à une connectivité toujours‑disponible.

La mauvaise configuration reste le risque n°1

Le Zero Trust n’est pas une barrière magique. Des politiques mal dimensionnées (trop permissives, trop restrictives, ou incohérentes) peuvent soit augmenter l’exposition, soit interrompre le travail. Plus le moteur de politique est flexible, plus il faut de discipline.

Les déploiements par phases aident : commencer par un cas d’usage clair (par ex. un sous‑ensemble d’utilisateurs ou une catégorie d’apps), mesurer latence et accès, puis étendre. Définissez les politiques en langage clair, mettez en place la supervision et les alertes tôt, et planifiez la redondance (routage multi‑régions, accès de secours « break‑glass », et chemins de repli documentés).

Gouvernance qui compte vraiment

Sachez quels types de données vous protégez (réglementées vs générales), alignez les contrôles sur les exigences de conformité, et planifiez des revues d’accès récurrentes. L’objectif n’est pas d’acheter par peur — c’est de s’assurer que le nouveau modèle échoue de façon sûre et prévisible.

Points clés : ce que les équipes et fondateurs peuvent copier

1) Une thèse produit claire bat une longue liste de fonctionnalités

La leçon répétée de Zscaler est la focalisation : déplacer l’application des politiques de sécurité vers le cloud et rendre l’accès piloté par l’identité. En évaluant des fournisseurs (ou en construisant), posez une question simple : « Quel est le pari architectural unique qui rend tout le reste plus simple ? » Si la réponse est « ça dépend », attendez‑vous à voir la complexité revenir plus tard en coûts, temps de déploiement et exceptions.

2) La clarté de catégorie est une stratégie de croissance

« Zero trust » a fonctionné parce que cela s’est transformé en une promesse pratique : moins de confiance implicite, moins de plomberie réseau, et un meilleur contrôle à mesure que les applications quittaient l’on‑prem. Pour les équipes, cela signifie acheter des résultats, pas des mots à la mode. Écrivez vos résultats souhaités (par ex. « aucun accès entrant », « moindre privilège aux applis », « politique cohérente pour les utilisateurs distants ») et mappez chacun à des capacités concrètes à tester.

3) Les partenaires font évoluer la sécurité d’entreprise plus vite que la vente directe seule

La sécurité d’entreprise se diffuse via des réseaux de confiance : revendeurs, GSIs, MSPs et marketplaces cloud. Les fondateurs peuvent en tirer parti en rendant leur produit prêt pour les partenaires tôt : packaging clair, marges prévisibles, playbooks de déploiement, et métriques partagées. Les responsables sécurité peuvent aussi utiliser les partenaires : les employer pour la gestion du changement, l’intégration d’identité et les migrations par phases plutôt que d’essayer de monter en compétence toutes les équipes internes en même temps.

4) Conseils pratiques pour les responsables sécurité qui envisagent le cloud/zero trust

Commencez par un cas d’usage à fort volume (souvent l’accès Internet ou une application critique), mesurez avant/après, puis étendez.

Questions clés de déploiement :

- Quelle est la « source de vérité » pour l’identité (et l’appartenance aux groupes) ?

- Comment traiterez‑vous les applications legacy, les sous‑traitants et le BYOD ?

- Quel est le plan de gouvernance des politiques : sécurité, réseau ou partagé ?

5) Conseils pratiques pour les fondateurs sur la distribution et la création de catégorie

Ne vous contentez pas de « vendre de la sécurité » — vendez un chemin de migration. L’histoire gagnante est souvent : douleur → première étape la plus simple → gain mesurable → expansion. Construisez l’onboarding et le reporting qui rendent la valeur visible en 30–60 jours.

Un modèle ami des fondateurs est de compléter le produit central par des apps complémentaires rapides à construire (workflows d’évaluation, trackers de migration, calculateurs ROI, portails partenaires). Si vous voulez créer ces outils sans reconstruire une grosse chaîne de dev héritée, Koder.ai est conçu pour « vibe‑coder » des apps full‑stack depuis le chat — utile pour mettre en production rapidement des outils internes ou orientés client, puis itérer à mesure que votre motion de distribution évolue.

Si vous voulez approfondir, voyez /blog/zero-trust-basics et /blog/sase-vs-sse-overview. Pour des idées de packaging, visitez /pricing.