Ce que signifie vraiment la mentalité « ruban adhésif »

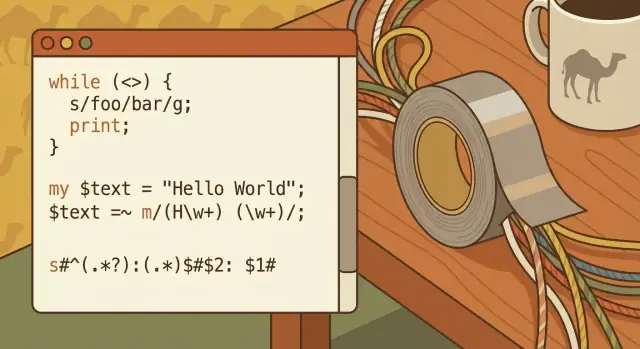

La « programmation ruban adhésif » est l’idée que le meilleur outil est souvent celui qui résout rapidement votre vrai problème — même si la solution n’est pas jolie, n’est pas permanente, et n’a pas été conçue comme un grand système.

Il ne s’agit pas de faire du travail bâclé. Il s’agit de privilégier l’élan quand vous faites face à des entrées sales, des spécifications incomplètes et une date butoir qui se fiche de la beauté de votre diagramme d’architecture.

Pragmatique, pas précieux

La mentalité ruban adhésif commence par une question simple : Quel est le plus petit changement qui fait disparaître la douleur ? Cela peut être un court script pour renommer 10 000 fichiers, un filtre rapide pour extraire les lignes d’erreur d’un log, ou une transformation ponctuelle qui transforme un export chaotique en quelque chose qu’un tableur peut lire.

Cet article utilise Larry Wall et Perl comme une histoire historique de cette attitude en action — mais le but n’est pas la nostalgie. Il s’agit d’en extraire des leçons pratiques qui s’appliquent encore chaque fois que vous travaillez avec du texte, des logs, des CSV, des extraits HTML, ou des « données » qui ne sont en réalité qu’un tas de chaînes incohérentes.

Pour qui est‑il destiné

Si vous n’êtes pas un programmeur professionnel mais que vous manipulez régulièrement :

- des fichiers de logs, rapports, exports et vidages de données ad hoc

- du contenu de site web, des soumissions de formulaires, ou de l’automatisation autour de fichiers

- du texte copié‑collé qui ne reste jamais propre

…vous êtes exactement le public visé.

Ce que vous en retirerez

À la fin, vous devriez avoir quatre enseignements clairs :

- Un état d’esprit pour choisir des outils pratiques plutôt que parfaits.

- Des compétences de traitement de texte qui s’étendent des petites corrections aux flux de travail répétables.

- Une vue réaliste de la maintenabilité : quand « rapide » devient « pour toujours ».

- Une façon d’équilibrer vitesse et clarté pour que votre futur vous (ou un coéquipier) ne doive pas décoller de vieux bouts de ruban.

La motivation de Larry Wall : rendre le travail désordonné moins pénible

Larry Wall ne cherchait pas à inventer un langage « astucieux ». Il était ingénieur et administrateur système qui passait ses journées à dompter du texte indiscipliné : fichiers de logs, rapports, extraits de configuration, en‑têtes mail, et vidages de données ad hoc qui ne respectaient jamais le format promis par la doc.

Le problème qu’il essayait de résoudre

Au milieu des années 1980, Unix avait déjà d’excellents outils — sh, grep, sed, awk, les pipes et les filtres. Mais les vrais travaux rentrent rarement dans une seule commande propre. On commençait avec une pipeline, puis on découvrait qu’il fallait une petite machine d’état, une meilleure manipulation de chaînes, un script réutilisable, et un moyen de garder tout cela lisible pour pouvoir le corriger la semaine suivante.

La motivation de Larry était pratique : réduire la friction du « travail de colle », cette tâche ingrate mais constante de connecter des outils et de transformer du texte jusqu’à obtenir quelque chose d’utile.

« Rendre la manipulation de texte plus facile que shell + awk + sed »

L’objectif original de Perl n’était pas de remplacer les outils Unix — c’était de les rendre plus simples à orchestrer quand une pipeline one‑liner devenait un mini programme. Au lieu de sauter entre plusieurs utilitaires (chacun avec ses règles d’quote et ses cas limites), Perl offrait un endroit pour :

- lire des fichiers ligne par ligne,

- découper et remodeler des chaînes,

- appliquer de la recherche par motifs,

- écrire le résultat—rapidement et de façon prévisible.

C’est la mentalité « ruban adhésif » : pas la perfection, mais une réparation rapide et durable qui maintient les choses ensemble.

La culture : pragmatisme et expressivité

La culture Perl adoptait quelques valeurs qui correspondaient à cette réalité quotidienne : le pragmatisme plutôt que la pureté, l’expressivité plutôt que la cérémonie, et le fameux « Il n’y a pas qu’une seule façon de le faire. » Ce n’étaient pas des slogans pour faire joli — c’étaient des permissions pour résoudre le problème devant vous avec le moins de douleur possible.

Éviter le mythe : Perl n’était pas magique

La popularité initiale de Perl peut paraître mystérieuse rétrospectivement. Ce n’était pas le cas. Il répondait simplement à ce dont les équipes avaient besoin à l’époque : un langage capable de survivre à des entrées sales, de s’intégrer aux systèmes existants, et de permettre à une personne fatiguée d’expédier un script fonctionnel avant la prochaine alerte du pager.

Pourquoi l’automatisation web précoce avait besoin d’un langage de colle

Les premiers sites web n’étaient pas alimentés par des frameworks applicatifs et des services managés. Beaucoup étaient un serveur web plus un répertoire de scripts CGI, quelques fichiers plats, et peut‑être une base de données simple qui ne semblait pas encore « centrale ».

Les opérations étaient riches en logs : logs d’accès, logs d’erreur, dossiers d’uploads, boîtes mail recevant des formulaires, et fichiers texte qui devenaient silencieusement des bases de données. Quand quelque chose cassait, on le diagnostiquait souvent en greppant les logs d’hier et en ajustant un script.

Ce que « automatiser » voulait dire à l’époque (en termes simples)

Automatiser, c’était simplement : une tâche répétable qui s’exécute sans intervention manuelle à chaque fois.

Cette tâche pouvait être déclenchée par une requête web (quelqu’un soumet un formulaire, clique sur « recherche », télécharge un rapport), ou par un job planifié (cron qui tourne toutes les heures pour faire la rotation des logs, regénérer des pages, envoyer des résumés).

Pourquoi c’était important

Même les petits sites avaient besoin de :

- Mettre à jour du contenu sur de nombreuses pages sans édit manuel

- Traiter des formulaires : valider les champs, envoyer des e‑mails, stocker les résultats

- Générer des pages : listes quotidiennes, résultats de recherche, sections « dernières mises à jour »

- Parser les logs : trouver des liens cassés, repérer des pics de trafic, détecter des abus

Le faire manuellement ne faisait pas que perdre du temps — cela introduisait des erreurs et des retards.

Où Perl s’insérait

Perl se plaçait idéalement entre tout ce qui existait déjà :

- le serveur web qui lançait des scripts CGI

- les outils Unix (

grep, sed, awk, sort) excellents pour des étapes individuelles

- des sources de données comme des fichiers plats et des bases primitives

Perl pouvait lire une requête, exécuter des commandes système, transformer du texte désordonné, et écrire du HTML ou mettre à jour un fichier — le tout dans un seul script. Ce rôle de « langage de colle » rendait l’automatisation web précoce pratique : il connectait des pièces individuellement utiles mais difficiles à chaîner de manière sûre et répétable.

Perl comme pont entre outils Unix et scripts web

Perl a gagné sa réputation de « ruban adhésif » parce qu’il se plaçait confortablement entre les outils classiques en ligne de commande Unix et le nouveau monde du scripting web. Si vos données commençaient comme fichiers de logs, emails, exports CSV ou extraits HTML, Perl pouvait les saisir, les remodeler, et les transmettre — sans vous forcer à adopter tout un nouvel environnement.

Des « batteries » pour le travail sur texte

Dès l’installation, Perl rendait la manipulation de texte étonnamment directe :

- Expressions régulières intégrées au langage pour trouver et réécrire des motifs

- Opérations de chaînes pratiques (

split, join, replace) adaptées aux tâches de nettoyage

- Gestion de fichiers simple pour lire ligne par ligne et écrire les résultats

Cette combinaison faisait qu’on n’avait pas besoin d’une longue chaîne d’outils pour parser et éditer au quotidien.

Correspond au principe Unix (et joue bien avec les pipes)

Unix encourage des programmes petits et ciblés reliés ensemble. Perl pouvait être une de ces pièces : lire depuis l’entrée standard, transformer le texte, et imprimer le résultat pour l’outil suivant.

Un modèle mental courant était :

read → transform → write

Par exemple : lire les logs serveur, normaliser un format de date, enlever le bruit, puis écrire un fichier nettoyé — éventuellement piping vers sort, uniq ou grep avant ou après. Perl ne remplaçait pas les outils Unix ; il les collait quand la combinaison « awk + sed + shell » devenait gênante.

Du terminal au CGI

Cette approche axée script a aussi servi le développement web précoce. Un script Perl pouvait accepter l’entrée d’un formulaire, la traiter comme n’importe quel autre flux de texte, et imprimer du HTML en sortie — faisant de Perl un pont pratique entre utilitaires système et pages web.

La portabilité importait

Parce que Perl tournait sur de nombreux systèmes de type Unix, les équipes pouvaient souvent déplacer le même script entre machines avec peu de changements — précieux quand les déploiements étaient simples, manuels et fréquents.

Expressions régulières : la superpuissance derrière le parsing pratique

Les expressions régulières (ou « regex ») sont un moyen de décrire des motifs de texte — comme une recherche‑remplacement, mais avec des règles plutôt que des mots exacts. Au lieu de chercher la chaîne littérale [email protected], la regex permet de dire « trouve tout ce qui ressemble à une adresse email ». Ce passage de la correspondance exacte à la correspondance par motif est ce qui a rendu possible tant d’automatisations précoces.

Regex en langage courant

Pensez à la regex comme à un mini‑langage pour répondre à des questions comme :

- « Cette entrée semble‑t‑elle valide ? »

- « Puis‑je extraire la partie dont j’ai besoin ? »

- « Puis‑je réécrire ce texte dans un format plus propre ? »

Si vous avez déjà collé du texte dans un tableur en souhaitant qu’il se divise magiquement en colonnes, vous avez voulu une regex.

Pourquoi c’était une percée pour l’automatisation

Les scripts web précoces vivaient sur des entrées désordonnées : champs de formulaires tapés par des humains, logs produits par des serveurs, fichiers assemblés par différents systèmes. La regex permettait de faire trois tâches de grande valeur rapidement :

-

Valider des entrées (ex. « ceci ressemble à une URL », « ceci ressemble à une date »).

-

Extraire des champs (ex. extraire le code de statut et le chemin de requête d’une ligne de log).

-

Réécrire du contenu (ex. normaliser des numéros de téléphone, remplacer d’anciens liens, assainir une entrée utilisateur avant enregistrement).

Le support des regex dans Perl n’était pas seulement présent — il était conçu pour être utilisé constamment. Cela s’accordait parfaitement à la mentalité « ruban adhésif » : prendre un texte incohérent, appliquer quelques règles ciblées, et obtenir quelque chose d’assez fiable pour être livré.

Cas d’usage concrets que vous avez probablement rencontrés

Les regex excellent sur le type de texte « presque structuré » que l’on croise tous les jours :

- Emails : trouver des adresses dans un bloc de texte ou signaler celles visiblement incorrectes.

- URLs : extraire domaines, chemins ou paramètres de requête.

- Dates : convertir

12/26/25 en 2025-12-26, ou reconnaître plusieurs styles de date.

- Lignes de log : extraire adresse IP, timestamp, requête et code de réponse.

- Données de type CSV : gérer des fichiers essentiellement séparés par des virgules — jusqu’à ce qu’un champ contienne des espaces étranges, des quotes ou des valeurs manquantes.

Le compromis : puissance vs lisibilité

La regex est assez puissante pour devenir cryptique. Un motif court et astucieux peut être difficile à relire, à déboguer et facile à casser plus tard si le format d’entrée change.

Une approche maintenable consiste à garder les motifs petits, ajouter des commentaires (quand le langage le permet), et préférer deux étapes claires plutôt qu’une expression « géniale » quand quelqu’un d’autre devra y toucher le mois prochain.

One‑liners Perl : gains rapides pour le nettoyage de texte quotidien

Créez un outil de nettoyage rapide

Transformez votre prochain nettoyage de texte en un petit outil réutilisable à tout moment.

Les one‑liners Perl sont mieux vus comme des scripts minuscules : de petites commandes à usage unique que vous exécutez directement dans le terminal pour transformer du texte. Ils brillent quand vous avez besoin d’un nettoyage rapide, d’une migration ponctuelle, ou d’une vérification avant de vous lancer dans un programme complet.

À quoi ressemblent ces « scripts minuscules »

Un one‑liner lit généralement depuis l’entrée standard, effectue une modification, et imprime le résultat. Par exemple, supprimer les lignes vides d’un fichier :

perl -ne 'print if /\S/' input.txt > output.txt

Ou extraire des « colonnes » spécifiques depuis un texte séparé par des espaces :

perl -lane 'print "$F[0]\t$F[2]"' data.txt

Et pour le renommage par lot, Perl peut piloter des opérations sur fichiers avec un peu plus de contrôle qu’un outil de renommage basique :

perl -e 'for (@ARGV){(my $n=$_)=~s/\s+/_/g; rename $_,$n}' *

(Ce dernier remplace les espaces par des underscores.)

Quand un one‑liner suffit — et quand il ne suffit pas

Les one‑liners conviennent quand :

- La transformation est simple et facile à expliquer en une phrase.

- Vous pouvez la tester sur un petit échantillon d’abord.

- Vous ne créez pas un outil réutilisable pour d’autres.

Écrivez un vrai script quand :

- La commande devient longue ou vous enchaînez plusieurs étapes.

- Vous avez besoin d’une gestion d’erreurs claire (fichiers manquants, formats inattendus).

- Le travail sera répété, audité ou transmis.

Rendre les correctifs rapides reproductibles

« Rapide » ne doit pas rimer avec « introuvable ». Sauvegardez votre ligne d’historique shell (ou collez‑la dans un fichier de notes dans le repo), incluez un exemple avant/après, et notez ce qui a changé et pourquoi.

Si vous exécutez le même one‑liner deux fois, c’est le signe qu’il faut l’emballer dans un petit script avec un nom de fichier, des commentaires et des chemins d’entrée/sortie prévisibles.

CPAN : la réutilisation qui faisait gagner du temps aux petites équipes

CPAN (Comprehensive Perl Archive Network) est, en termes simples, une étagère de bibliothèques partagées pour Perl : une collection publique de modules réutilisables que chacun peut télécharger et utiliser.

Plutôt que d’écrire chaque fonctionnalité depuis zéro, les petites équipes pouvaient prendre un module éprouvé et se concentrer sur leur vrai problème — expédier un script qui fonctionnait aujourd’hui.

Le « boost de vitesse » pour le travail web précoce

Beaucoup de tâches web quotidiennes sont devenues accessibles à un seul développeur parce que CPAN offrait des blocs de construction qu’il aurait fallu des jours ou des semaines à réinventer. Exemples courants :

- Templating : séparer le HTML de la logique pour que les pages ne deviennent pas des affichages illisibles.

- Clients/serveurs HTTP : récupérer des données depuis d’autres services, gérer des requêtes et manipuler les en‑têtes.

- Email : envoyer des notifications, parser les mails entrants, gérer les pièces jointes MIME.

- Connecteurs de bases : communiquer avec MySQL/PostgreSQL sans code réseau bricolé.

C’était important parce que l’automatisation web précoce était souvent « un script de plus » ajouté à un système déjà chargé. CPAN permettait d’assembler ce script rapidement — et souvent plus sûrement — en s’appuyant sur du code déjà utilisé en production.

Commodité vs gestion des dépendances

Le compromis est réel : les dépendances sont une forme d’engagement.

Importer des modules peut faire gagner du temps immédiatement, mais cela signifie aussi penser à la compatibilité des versions, aux correctifs de sécurité, et à ce qui se passe si un module n’est plus maintenu. Un gain rapide aujourd’hui peut devenir une mise à jour déroutante demain.

Avant de dépendre d’un module CPAN, préférez ceux clairement entretenus :

- lisez la documentation et survolez le changelog/les notes de version

- vérifiez l’activité récente (mises à jour, réponses aux issues)

- cherchez une base d’utilisateurs saine et des exemples clairs

Quand CPAN est utilisé avec prudence, c’est une des meilleures expressions de la mentalité « ruban adhésif » : réutilisez ce qui marche, continuez d’avancer, et ne construisez pas l’infrastructure dont vous n’avez pas besoin.

Les patterns de l’ère CGI : scripts rapides, conséquences réelles

Déployez une interface d'administration interne

Passez de l'idée à une app web fonctionnelle sans mettre en place toute la chaîne au préalable.

CGI (Common Gateway Interface) était la phase « lance simplement un programme » du web. Une requête touchait le serveur, le serveur lançait votre script Perl, votre script lisait les entrées (souvent depuis les variables d’environnement et STDIN), puis imprimait une réponse — généralement un en‑tête HTTP et un blob HTML.

Le flux CGI typique

Au plus simple, le script :

- reçoit des paramètres (comme

name=Sam&age=42)

- fait un petit travail (lookup, calcul, lecture de fichier)

- imprime des en‑têtes (ex.

Content-Type: text/html) puis du HTML

Ce modèle permettait d’expédier des choses utiles rapidement. Il permettait aussi d’expédier des choses risquées rapidement.

Ce que les gens automatisaient avec des scripts CGI

Perl CGI est devenu le raccourci pour l’automatisation web pratique :

- gestion de formulaires : emails « contactez‑nous », inscriptions, demandes internes

- dashboards simples : une page qui lit un log et résume des comptes

- rapports batch : générer les stats de ventes/trafic d’hier à la demande

- visionneuses de logs : rechercher et filtrer les logs serveur via des paramètres de requête

Ceux‑ci étaient souvent des gains pour de petites équipes : un script, une URL, une valeur immédiate.

Les pièges courants (et pourquoi ils importaient)

Parce que les scripts CGI s’exécutaient par requête, les petites erreurs se multipliaient :

- Traitement des entrées : faire confiance aux paramètres menait à des pages cassées — ou pire, des vulnérabilités d’injection.

- Quoting et appels système : construire des commandes shell avec du texte utilisateur est un piège classique.

- Encodage : jeux de caractères incompatibles créaient des sorties corrompues et des bugs confus.

- Concurrence : deux requêtes écrivant le même fichier temporaire ou magasin pouvaient entrer en collision.

La leçon à retenir

La vitesse est une fonctionnalité, mais seulement si elle est accompagnée de limites. Même les petits scripts ont besoin de validation claire, d’un quoting soigneux et de règles de sortie prévisibles — des habitudes qui paient encore, que vous écriviez un petit outil d’administration ou un point de terminaison web moderne.

Lisibilité vs astuce : la leçon de maintenabilité

Perl a gagné la réputation d’être difficile à lire parce qu’il rendait les solutions astucieuses faciles. Une syntaxe dense et ponctuée, beaucoup de comportements dépendant du contexte, et une culture du « il y a plus d’une façon de faire » encourageaient du code compact et impressionnant. C’est parfait pour un correctif à 2 h du matin — mais six mois plus tard, même l’auteur peut avoir du mal à se rappeler ce qu’un one‑liner faisait réellement.

Pourquoi l’astuce nuit avec le temps

Le problème de maintenabilité n’est pas que Perl soit unique à cet égard — c’est que Perl permet de compresser l’intention jusqu’à ce qu’elle disparaisse. Les coupables habituels incluent des expressions régulières très tassées sans commentaires, l’utilisation intensive de variables implicites comme $_, et des astuces élégantes (effets de bord, ternaires imbriqués, valeurs magiques) qui économisent des lignes mais coûtent en compréhension.

Conseils de style pratiques qui fonctionnent encore

Quelques habitudes améliorent énormément la lisibilité sans vous ralentir :

- Utilisez un formatage et une indentation cohérents, même dans les petits scripts.

- Choisissez des noms de variables et de sous‑routines signifiants ; évitez les noms d’une lettre hors des boucles minuscules.

- Préférez des étapes claires plutôt que des expressions « tout en un » ; décomposez le travail regex complexe en étapes.

- Limitez les raccourcis astucieux sauf s’ils rendent le code plus évident.

Pratiques communautaires : garde‑fous pour des projets réels

La communauté Perl a normalisé des garde‑fous simples que beaucoup de langages ont ensuite adoptés : activez use strict; et use warnings;, écrivez des tests basiques (même quelques vérifications de sanity), et documentez les hypothèses avec des commentaires inline ou du POD.

Ces pratiques ne rendent pas le code « entreprise » — elles le rendent survivable.

La leçon générale vaut pour tout langage : écrivez pour votre futur vous et pour vos coéquipiers. Le script le plus rapide est celui qu’on peut changer en toute sécurité quand les exigences évoluent.

Compétences de traitement de texte qui rapportent encore

Le travail sur le texte n’est pas devenu plus propre — il a juste changé de place. Vous ne maintenez peut‑être plus de scripts CGI, mais vous traitez toujours des exports CSV, des webhooks SaaS, des logs d’application et des flux d’intégration « temporaires » qui deviennent permanents. Les mêmes compétences pratiques qui rendaient Perl utile font encore gagner du temps (et évitent la corruption silencieuse des données).

Les pièges textuels que vous rencontrez encore

La plupart des problèmes ne sont pas du « parsing difficile », mais des entrées incohérentes :

- Encodages : UTF‑8 mélangé à des encodages Windows legacy, ou fichiers qui prétendent une chose et en contiennent une autre.

- Sauts de ligne : fins de ligne Windows vs Unix, ou données collées avec des retours chariot parasites.

- Séparateurs : virgules vs points‑virgules, tabulations, espaces multiples, ou « CSV » qui casse quand un champ contient une virgule.

- Échappement et quoting : backslashes, quotes embarquées, JSON dans CSV, entités HTML dans des exports.

- Problèmes de locale :

1,234 vs 1.234, dates comme 03/04/05, noms de mois en différentes langues.

Habitudes défensives : petites règles, grands gains

Traitez chaque entrée comme non fiable, même si elle vient de « notre système ». Normalisez tôt : choisissez un encodage (généralement UTF‑8), standardisez les sauts de ligne, éliminez le bruit évident, et convertissez vers un schéma cohérent.

Validez ensuite explicitement les hypothèses : « ce fichier a 7 colonnes », « les IDs sont numériques », « les timestamps sont en ISO‑8601 ». Quand quelque chose casse, échouez bruyamment et enregistrez ce que vous avez vu (ligne d’exemple, numéro de ligne, fichier source).

Parser, ne pas deviner

Quand c’est possible, préferez des formats clairs et de vrais parseurs plutôt que des splits astucieux. Si on vous donne du JSON, parsez le JSON. Si on vous donne du CSV, utilisez un parseur CSV qui comprend le quoting. Deviner marche jusqu’au moment où un nom client contient une virgule.

Où cela apparaît aujourd’hui

Ces compétences servent au quotidien : filtrer des logs d’application pendant un incident, nettoyer des exports financiers, transformer des imports CRM, relier des intégrations d’API, et réaliser des migrations de données ponctuelles où « presque correct » est encore faux.

L’héritage de Perl face aux langages de script modernes

Faites évoluer vos scripts en workflows

Arrêtez de relancer des commandes une par une et encapsulez le workflow dans une application.

La réputation « ruban adhésif » de Perl n’était pas synonyme de précipitation — c’était synonyme d’utilité. Cet héritage réapparaît chaque fois qu’une équipe a besoin d’un petit script pour concilier des exports, normaliser des logs, ou transformer un tas de texte semi‑structuré en quelque chose qu’un tableur ou une base de données peut digérer.

Perl vs choix de scripting d’aujourd’hui

Aujourd’hui, on utilise souvent Python, Ruby ou JavaScript (Node.js) pour du scripting. Leurs rôles se chevauchent : automatisation rapide, intégration, et code de colle entre outils.

Les forces classiques de Perl étaient (et sont encore) l’accès direct au système d’exploitation, la manipulation de texte expressive, et une culture du « fais‑le, maintenant ». Python met l’accent sur la lisibilité et une large bibliothèque standard ; Ruby privilégie l’ergonomie développeur et des conventions web ; JavaScript offre l’ubiquité et un déploiement facile partout où Node fonctionne.

Ce qui a changé depuis l’apogée de Perl

Beaucoup de travail moderne est guidé par des frameworks, des API stables, des services cloud et un meilleur outillage. Des tâches qui demandaient autrefois des scripts sur mesure disposent aujourd’hui de services managés, de connecteurs prêts à l’emploi et de queues hébergées.

Le déploiement a aussi changé : conteneurs, pipelines CI, et verrouillage des dépendances sont attendus, pas optionnels.

Ce qui n’a pas changé

Le texte du monde réel reste désordonné. Les logs réservent des surprises, les exports ont des formats « créatifs », et les données nécessitent toujours des transformations soignées pour être fiables.

C’est la leçon durable de Perl : les 80 % peu flatteurs de l’automatisation consistent à parser, nettoyer, valider et produire une sortie prévisible.

Choisir l’outil adapté aujourd’hui

Le meilleur choix est généralement celui que votre équipe peut maintenir : confort avec le langage, écosystème adapté à la tâche, et contraintes de déploiement réalistes (ce qui est installé, ce que la sécurité autorise, ce que les ops peuvent supporter). L’héritage de Perl n’est pas « utilisez toujours Perl » — c’est « choisissez l’outil qui convient réellement au désordre que vous avez ».

Il vaut aussi la peine de noter que l’instinct « ruban adhésif » réapparaît dans les flux de travail assistés par IA. Par exemple, une plateforme vibe‑coding comme Koder.ai peut être utile quand vous avez besoin d’un outil interne rapide (un visionneur de logs, un normaliseur CSV, ou une petite UI admin) et que vous préférez itérer via chat plutôt que tout assembler manuellement. La même prudence s’applique : livrez vite, mais gardez le résultat lisible, testable et facile à annuler si le « temporaire » d’aujourd’hui devient critique demain.

Checklist pratique pour votre prochaine automatisation

Le plus beau cadeau de Perl n’est pas une syntaxe précise — c’est une attitude de travail face aux problèmes textuels désordonnés. Quand vous vous apprêtez à automatiser quelque chose (un renommage, un nettoyage de logs, un import de données), utilisez cette checklist « ruban adhésif » pour rester pragmatique sans créer un casse‑tête futur.

Checklist ruban adhésif (axée sur le problème, pas le chaos)

- Résoudre le vrai problème : notez ce que signifie « fini » (format de fichier, rapport, colonne nettoyée).

- Sécuriser : faites une copie, exécutez à blanc, et limitez la portée (un dossier, une plage de dates, un échantillon d’entrée).

- Rester lisible : choisissez des noms banals, évitez les astuces, et ajoutez un commentaire quand l’intention n’est pas évidente.

- Rendre réversible : écrivez dans un nouveau fichier, gardez les originaux, et enregistrez ce qui a changé.

- Gérer les cas moches : vides, caractères bizarres, lignes inattendues, champs manquants.

Plan de pratique simple (30–60 minutes à la fois)

Commencez petit :

- Apprenez les bases des regex : ancres (

^ / $), groupes, classes de caractères, et correspondance « gourmande » vs « non gourmande ».

- Écrivez des petits scripts qui effectuent bien une transformation (ex. normaliser des dates, extraire des ID, supprimer des doublons).

- Ajoutez des tests pour les transformations délicates : gardez un petit jeu d’exemples d’entrées « vilaines » et vérifiez que la sortie reste correcte.

Documentez chaque automatisation comme si vous l’oublierez la semaine prochaine

Incluez : entrées, sorties, quelques exemples avant/après, hypothèses (encodage, séparateurs), et un plan de rollback (« restaurer depuis la sauvegarde X » ou « relancer avec la version précédente »).

Perl est à la fois un pilier historique du travail textuel de l’ère web et un enseignant permanent : soyez pragmatique, soyez prudent, et laissez un script que quelqu’un d’autre pourra faire confiance.