Clarifier l’objectif et l’audience

Une matrice de comparaison n’est utile que dans la mesure où elle aide à prendre une décision. Avant de concevoir des tableaux, des filtres ou des règles de notation, précisez qui utilisera le site et quelle décision il cherche à prendre. Cela évite un échec fréquent : construire une grille esthétique qui répond à des questions que personne ne se pose.

Identifier les utilisateurs principaux (et leurs contraintes)

Différentes audiences interprètent la même “comparaison de fonctionnalités” de façon très différente :

- Acheteurs / responsables produit veulent de la clarté, une shortlist rapide et une justification défendable.

- Ingénieurs veulent des détails d’implémentation : API, SDK, effort d’intégration, limites, performances et pièges.

- Achats / sécurité se préoccupent des risques : conformité, certifications, résidence des données, contrats et stabilité du fournisseur.

Choisissez une audience principale pour la première version. Vous pouvez toujours soutenir des utilisateurs secondaires, mais les vues par défaut, la terminologie et les priorités du site doivent refléter le groupe principal.

Lister les décisions que le site doit soutenir

Écrivez les décisions concrètes que la matrice doit permettre. Exemples :

- Choisir un outil pour un nouveau projet

- Constituer une shortlist de fournisseurs pour un RFP

- Remplacer un système existant avec un risque de migration minimal

- Valider qu’une solution satisfait des exigences non négociables

Ces décisions indiquent quels critères deviennent des filtres de premier niveau, lesquels deviennent des « détails », et lesquels peuvent être omis.

Définir des métriques de succès qui correspondent à ces décisions

Évitez des objectifs vagues comme « augmenter l’engagement ». Choisissez des métriques qui reflètent l’avancement vers la décision :

- Temps pour une shortlist (ex. du landing à une comparaison sauvegardée)

- Actions de conversion (demandes de démo, inscriptions, téléchargements)

- Taux de complétion pour les flux clés (filtrer → comparer → exporter)

- Signaux de qualité (moins de questions au support, notes de confiance plus élevées)

Décider ce que « technique » signifie pour votre audience

L’« évaluation technique » peut couvrir de nombreuses dimensions. Alignez-vous sur ce qui importe le plus pour vos utilisateurs, par exemple :

- API et intégrations (couverture, limites de débit, webhooks, connecteurs)

- Sécurité et conformité (SSO, journaux d’audit, SOC 2, chiffrement)

- Tarification et packaging (paliers, coûts basés sur l’usage, frais cachés)

- Opérations (mode de déploiement, monitoring, SLA, support)

Documentez ces priorités en langage clair. Elles seront votre étoile du nord pour les choix ultérieurs : modèle de données, règles de notation, UX et référencement.

Concevoir le modèle de données pour les comparaisons

Votre modèle de données détermine si la matrice reste cohérente, interrogeable et facile à mettre à jour. Avant de dessiner des écrans, décidez quelles « choses » vous comparez, ce que vous mesurez et comment vous stockez la preuve.

Commencer par les entités centrales

La plupart des sites de comparaison technique nécessitent un petit ensemble de briques de base :

- Fournisseurs/Produits : les éléments comparés (souvent les deux : un fournisseur peut proposer plusieurs produits).

- Catégories : regroupements comme « Sécurité », « Intégrations », ou « Tarification ».

- Critères : lignes individuelles de la matrice (ex. « SAML SSO », « formats d’export », « SLA de disponibilité »).

- Preuves : éléments qui étayent une valeur (extrait de doc, référence de capture d’écran, note de contrat, résultat de test).

- Sources : d’où provient la preuve (doc publique, email commercial, entretien client, test interne).

Modélisez les critères comme des objets réutilisables et stockez la valeur de chaque fournisseur/produit comme un enregistrement distinct (souvent appelé « évaluation » ou « résultat de critère »). Cela vous permet d’ajouter de nouveaux fournisseurs sans dupliquer la liste de critères.

Choisir le bon type de données par critère

Évitez de tout forcer en texte brut. Choisissez un type qui correspond à la manière dont les gens filtreront et compareront :

- Booléen (Oui/Non) pour la disponibilité

- Numérique pour les limites et performances (et stockez les unités)

- Texte pour la nuance (gardez-le court ; ajoutez des notes longues ailleurs)

- Sélection multiple pour des listes comme plateformes supportées ou standards de conformité

Décidez aussi comment représenter « Inconnu », « Non applicable » et « Planifié », afin que les blancs ne soient pas lus comme « Non ».

Prévoir le changement : versions et horodatages

Les critères évoluent. Stockez :

- Dates d’effet (quand une valeur a été vérifiée)

- Dernière révision par critère

- Versions de critères optionnelles pour que renommer ou scinder un critère ne brise pas l’historique

Séparer les faits publics des notes internes

Créez des champs (ou une table séparée) pour commentaires internes, détails de négociation et niveau de confiance du relecteur. Les pages publiques doivent afficher la valeur et la preuve ; les vues internes peuvent inclure un contexte franc et des tâches de suivi.

Planifier la structure du site et les URL

Un site de matrice de comparaison réussit quand les visiteurs peuvent prédire où se trouvent les informations et comment y accéder. Choisissez une architecture de l’information qui reflète la façon dont les gens évaluent les options.

Créer un arbre de catégories cohérent

Commencez avec une taxonomie simple et stable qui ne changera pas chaque trimestre. Pensez en « zones de problème » plutôt qu’en noms de fournisseurs.

Exemples :

- Monitoring

- CI/CD

- IAM

- Entrepôts de données

- Passerelles API

Gardez l’arborescence peu profonde (généralement 2 niveaux suffisent). Si vous avez besoin de plus de nuance, utilisez des tags ou des filtres (ex. « Open-source », « SOC 2 », « Auto-hébergé ») plutôt que des imbrications profondes. Cela aide les utilisateurs à parcourir en confiance et évite le contenu dupliqué plus tard.

Planifier vos types de pages principaux

Concevez le site autour de quelques modèles répétables :

- Hub de catégorie : explique la catégorie, liste les produits, met en avant les critères communs et propose des points d’entrée « comparer ».

- Page produit : profil d’un seul fournisseur/outil avec capacités, limites, notes tarifaires, intégrations et conseils « idéal pour ».

- Page de comparaison : vue côte à côte pour deux ou plusieurs produits, avec lignes de critères, notation (si utilisée) et notes.

Ajoutez des pages de support qui réduisent la confusion et renforcent la crédibilité :

- Méthodologie (comment vous notez, ce que vous testez, fréquence de mise à jour)

- Glossaire (définir critères et acronymes)

- Contact (corrections, partenariats, sources de données)

Choisir des patterns d’URL qui montent en charge

Définissez les règles d’URL tôt pour éviter des redirections désordonnées plus tard. Deux patterns courants :

- Comparaisons :

/compare/a-vs-b (ou /compare/a-vs-b-vs-c pour multi-éléments)

- Catégories :

/category/ci-cd

Gardez les URL courtes, en minuscules et cohérentes. Utilisez le nom canonique du produit (ou un slug stable) pour éviter qu’un même outil n’apparaisse à la fois comme /product/okta et /product/okta-iam.

Enfin, décidez comment les filtres et le tri affectent les URL. Si vous voulez des vues filtrées partageables, prévoyez une approche propre par query string (ex. ?deployment=saas&compliance=soc2) et gardez la page de base utilisable sans paramètres.

Définir les critères, la notation et les règles de pondération

Une matrice de comparaison n’aide que si les règles sont cohérentes. Avant d’ajouter des vendeurs ou des critères, verrouillez la « mathématique » et le sens derrière chaque champ. Cela évite des débats sans fin plus tard (« Que signifiait le support SSO ? ») et rend vos résultats défendables.

Standardiser les noms et définitions des critères

Commencez avec une liste canonique de critères et traitez-la comme une spécification produit. Chaque critère doit avoir :

- Un nom clair (court, scannable et unique)

- Une définition qui enlève toute ambiguïté

- Le périmètre (ce qui est inclus/exclu)

- Les preuves attendues pour étayer une note (docs, captures d’écran, résultats de tests)

Évitez les quasi-duplications comme « Conformité » vs « Certifications » sauf si la distinction est explicite. Si vous avez besoin de variantes (ex. « Chiffrement au repos » et « Chiffrement en transit »), faites-en des critères séparés avec des définitions distinctes.

Ajouter des consignes de notation que les gens peuvent suivre

Les notes ne sont comparables que si tout le monde utilise la même échelle. Rédigez des rubriques de notation adaptées au critère :

- Échelle 1–5 quand le soutien partiel compte (usabilité, maturité, intégrations)

- Réussite/Échec quand c’est binaire (supporte SAML ? oui/non)

- Valeurs numériques quand la mesure est directe (prix, latence, rétention max)

Définissez ce que signifie chaque point. Par exemple, « 3 » peut être « répond au besoin avec des limitations », tandis que « 5 » est « répond au besoin avec des options avancées et des déploiements éprouvés ». Précisez aussi si « N/A » est autorisé et quand.

Choisir des pondérations (ou décider de les éviter)

La pondération change le récit que raconte votre matrice, choisissez-la intentionnellement :

- Poids par défaut : utile pour un classement « éditorial » ; documentez la raison.

- Poids personnalisés par l’utilisateur : adapté aux audiences diverses ; laissez les utilisateurs ajuster et voir les totaux se recalculer.

- Pas de poids : solution la plus neutre ; concentrez-vous sur les différences côte à côte.

Si vous prenez en charge des poids personnalisés, définissez des garde-fous (par ex. les poids doivent totaliser 100, ou proposer des presets faible/moyen/élevé).

Gérer les inconnus et les données manquantes

Les données manquantes sont inévitables. Documentez votre règle et appliquez-la partout :

- Utilisez « Inconnu » quand vous n’avez pas pu confirmer (et gardez-le distinct de « Non »).

- Décidez si les inconnus comptent comme 0, neutre, ou exclus des totaux.

- Enregistrez pourquoi c’est inconnu (le fournisseur n’a pas répondu, fonctionnalité peu claire, non testée).

Ces politiques maintiennent votre matrice juste, reproductible et digne de confiance au fur et à mesure de sa croissance.

Créer un pattern UX qui rend les différences évidentes

Définissez le modèle de données

Utilisez Planning Mode pour cartographier les entités, les règles de scoring et les modèles de page avant de générer le code.

L’interface de comparaison réussira ou échouera sur une chose : si le lecteur peut rapidement voir ce qui est réellement différent. Choisissez une vue principale et des indices visuels qui font ressortir les contrastes.

Choisir votre vue principale (et vous y tenir)

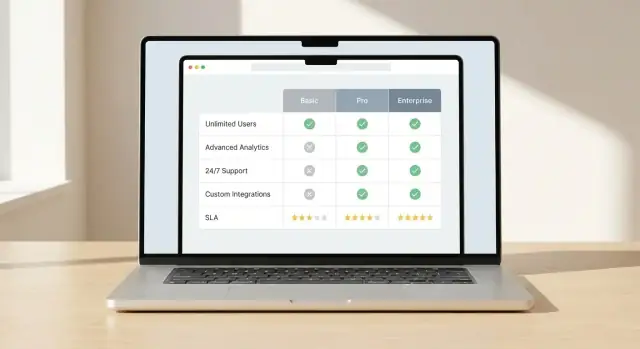

Choisissez un pattern principal et concevez tout autour :

- Tableau matriciel pour des comparaisons détaillées, ligne par ligne, sur plusieurs options.

- Cartes pour résumer quelques options avec avantages/inconvénients et spécifications clés.

- Hybride quand vous avez besoin des deux : cartes pour la synthèse et une matrice en dessous pour les détails.

La cohérence compte. Si les utilisateurs apprennent comment les différences sont affichées dans une zone, les mêmes règles doivent s’appliquer partout.

Rendre les différences visuelles évidentes

Ne forcez pas les gens à lire chaque cellule. Utilisez des mises en évidence délibérées :

- Mettez en avant les deltas, pas la similarité (ex. mettez en gras les valeurs qui diffèrent).

- Ajoutez des indicateurs « seulement dans A » ou « manquant dans B » pour les fonctionnalités présentes dans une option mais pas une autre.

- Utilisez un léger fond sur les critères « les plus importants » pour attirer l’œil.

Gardez la signification des couleurs simple et accessible : une couleur pour « mieux », une pour « moins bien », et une neutre. Ne vous fiez pas uniquement à la couleur : incluez icônes ou labels courts.

Gérer les tableaux longs sans perdre le contexte

Les longues matrices sont normales en évaluation technique. Rendez-les utilisables :

- En-têtes fixes pour que les noms de colonnes restent visibles

- Première colonne fixe pour que les labels de critères ne disparaissent pas

- Épinglage de colonnes pour verrouiller un fournisseur et faire défiler les autres

Concevoir pour le mobile dès le départ

Les utilisateurs mobiles ne tolèrent pas de grilles trop petites. Proposez :

- Défilement horizontal avec indications claires (bords dégradés, « glisser pour comparer »)

- Regroupement par ligne (Performance, Sécurité, Tarification) avec sections repliables

- « Instantanés de comparaison » qui montrent d’abord 5–8 critères clés, avec « voir la matrice complète » pour le détail

Quand les différences sont faciles à repérer, les lecteurs font confiance à la matrice — et la réutilisent.

Construire filtrage, tri et comparaison côte à côte

Une matrice de comparaison semble « rapide » quand les gens peuvent réduire la liste et voir des différences significatives sans scroller des minutes. Le filtrage, le tri et les vues côte à côte sont les outils d’interaction centraux qui permettent cela.

Filtres qui correspondent à la façon de décider

Commencez avec un petit ensemble de filtres qui reflètent de vraies questions d’évaluation, pas seulement ce qui est facile à stocker. Filtres utiles :

- Catégorie (ex. monitoring, CI/CD, entrepôt de données)

- Plateforme (web, mobile, desktop, API-only)

- Niveau tarifaire (gratuit, starter, entreprise)

- Mode de déploiement (SaaS, auto-hébergé, hybride)

Concevez les filtres pour que les utilisateurs puissent les combiner. Affichez combien d’éléments correspondent à mesure qu’ils filtrent, et rendez clair comment effacer les filtres. Si certains filtres sont mutuellement exclusifs, empêchez les combinaisons invalides au lieu d’afficher « 0 résultats » sans explication.

Tri qui répond à « par quoi dois-je commencer ? »

Le tri doit refléter des priorités objectives et spécifiques à l’audience. Proposez quelques options claires comme :

- Meilleur score (basé sur vos règles de notation)

- Plus de fonctionnalités (nombre de critères supportés)

- Mise à jour la plus récente (dernière vérification ou mise à jour produit)

Si vous affichez un « meilleur score », montrez ce qu’il représente (score global vs score de catégorie) et laissez l’utilisateur changer la vue de notation. Évitez les valeurs par défaut cachées.

Comparaison côte à côte (2–5 éléments)

Permettez à l’utilisateur de sélectionner un petit ensemble (généralement 2–5) et de les comparer dans une mise en colonnes fixe. Gardez les critères les plus importants épinglés en haut et regroupez le reste en sections repliables pour réduire la surcharge.

Rendez la comparaison partageable via un lien qui préserve sélections, filtres et ordre de tri. Cela permet aux équipes de revoir la même shortlist sans la recréer.

Options d’export si elles répondent au besoin

Les exports sont utiles pour la revue interne, les achats et les discussions hors ligne. Si votre audience en a besoin, proposez CSV (pour l’analyse) et PDF (pour le partage). Gardez les exports concentrés : incluez éléments sélectionnés, critères choisis, horodatages et notes de notation pour que le fichier ne soit pas trompeur ultérieurement.

Ajouter preuves, transparence et signaux de confiance

Les lecteurs n’utiliseront votre matrice pour décider que si elle est digne de confiance. Si vos pages avancent des affirmations sans montrer d’où viennent les données — ou quand elles ont été vérifiées — les utilisateurs supposeront un biais ou un contenu obsolète.

Associer une source à chaque affirmation

Traitez chaque cellule comme une affirmation nécessitant une preuve. Pour tout élément factuel (limites de paliers tarifaires, disponibilité d’une API, certifications), stockez un champ « source » avec la valeur :

- Référence à la documentation fournisseur (titre ou section de la page)

- Référence à une note de version (version/date)

- Résultat de votre test interne (nom du test, environnement, horodatage)

Dans l’interface, rendez la source visible sans encombrer : une petite étiquette « Source » en infobulle ou une ligne extensible fonctionne bien.

Afficher « dernière vérification » et responsabilité

Ajoutez des métadonnées qui répondent à deux questions : « À quel point c’est récent ? » et « Qui en est responsable ? »

Incluez une date « Dernière vérification » pour chaque produit (et éventuellement pour chaque critère), plus un « Responsable » (équipe ou personne) chargé de la relecture. C’est particulièrement important pour les éléments en évolution rapide comme les flags de fonctionnalité, intégrations et termes de SLA.

Utiliser des indicateurs de confiance pour les zones grises

Tout n’est pas binaire. Pour les critères subjectifs (facilité d’installation, qualité du support) ou les éléments incomplets (fournisseur n’a pas publié de détails), affichez des niveaux de confiance tels que :

- Élevé : mesuré ou clairement documenté

- Moyen : partiellement documenté ou inféré

- Faible : anecdotique ou non vérifié

Cela prévient une fausse précision et encourage les lecteurs à consulter les notes.

Fournir un journal des changements pour les mises à jour significatives

Sur chaque page produit, incluez un petit journal des changements quand des champs clés évoluent (tarification, fonctionnalités majeures, posture de sécurité). Les lecteurs voient rapidement les nouveautés, et les parties prenantes récurrentes savent qu’elles ne comparent pas des informations obsolètes.

Mettre en place la gestion de contenu et les workflows de mise à jour

Conservez la pleine propriété

Exportez le code source à tout moment pour que votre équipe puisse étendre ou gérer le projet en interne.

Une matrice n’est utile que si elle est à jour. Avant de publier la première page, décidez qui peut modifier les données, comment les changements sont relus, et comment maintenir la cohérence des notations à travers des dizaines (ou milliers) de lignes.

Choisir où résident les données de comparaison

Commencez par choisir la « source de vérité » pour vos données :

- CMS : idéal quand des éditeurs non techniques gèrent fournisseurs, fonctionnalités, notes et preuves. Un CMS structuré (avec champs personnalisés) maintient la cohérence.

- Base de données : idéal quand la matrice est interactive et fréquemment interrogée (filtres, tris, vues personnalisées). Elle peut être éditée via une interface admin.

- Fichiers statiques + étape de build (CSV/JSON dans un repo) : adapté aux petites équipes qui veulent un fort versioning et des releases prévisibles. Les changements sont deployés au build.

L’important n’est pas la technologie mais la capacité de l’équipe à mettre à jour de façon fiable sans casser la matrice.

Définir des workflows de mise à jour (revue, approbations, historique)

Traitez les changements comme des releases produit, pas comme des modifications occasionnelles.

Un workflow pratique :

- Brouillon : un rédacteur ajoute ou met à jour les détails, notes et scores d’un fournisseur.

- Revue : un relecteur expert vérifie l’exactitude et confirme l’application correcte des critères.

- Approbation & publication : un responsable final approuve et publie le changement.

- Traçabilité : enregistrez qui a changé quoi et pourquoi (avec une brève justification).

Si vous attendez des mises à jour fréquentes, ajoutez des conventions légères : demandes de changement, champ standard « raison de la mise à jour », cycles de révision planifiés (mensuel/trimestriel).

Créer des règles de validation pour éviter des notations incohérentes

La validation empêche une dérive silencieuse dans la matrice :

- Limitez les scores aux valeurs autorisées (ex. 0–5 ou « Oui/Non/Partiel »)

- Exigez une note ou une référence de preuve quand un score change

- Verrouillez les champs calculés (totaux pondérés) pour empêcher les overrides manuels

- Signalez les conflits, par ex. « Non supporté » avec un score élevé

Prévoir des pipelines d’import pour de grands jeux de données

L’édition manuelle ne scale pas. Si vous avez beaucoup de fournisseurs ou des flux fréquents, prévoyez :

- Import CSV pour mises à jour en masse (nouveaux fournisseurs, nouvelles colonnes de critères, rafraîchissement de scores)

- Synchronisation API quand les données proviennent d’ailleurs (tableaux de prix, catalogues produits, outils internes)

- Exécutions de test qui prévisualisent les changements et signalent les erreurs de validation avant publication

Quand le workflow est clair et appliqué, votre matrice reste fiable — et la confiance incite les gens à s’en servir.

Mettre en œuvre l’architecture technique

Une matrice paraît simple mais l’expérience dépend de la façon dont vous récupérez, rendez et mettez à jour beaucoup de données structurées sans latence. L’objectif est de garder les pages rapides et de faciliter les publications pour votre équipe.

Choisir une approche de rendu

Sélectionnez un modèle selon la fréquence de changement des données et l’interactivité :

- Génération statique : préconstruire les pages depuis vos données. Idéal pour la vitesse et la stabilité quand les mises à jour sont planifiées (quotidiennes/hebdomadaires).

- Rendu côté serveur (SSR) : construire la page à la demande. Utile quand les données changent fréquemment ou dépendent du contexte utilisateur.

- Hybride : préconstruire les pages stables et charger les données interactives via une API. Souvent le meilleur choix pour les comparaisons de fournisseurs.

Les tableaux s’alourdissent vite (nombreux fournisseurs × nombreux critères). Planifiez la performance tôt :

- Pagination ou « charger plus » pour longues listes

- Virtualisation des lignes/colonnes pour ne rendre que les cellules visibles

- Caching à plusieurs niveaux (réponses API, sortie serveur, cache navigateur)

- Agrégats pré-calculés (scores globaux, totaux par catégorie) pour éviter que l’UI recalculer tout en temps réel

Implémenter la recherche sur fournisseurs et critères

La recherche doit couvrir le nom du fournisseur, ses synonymes et les libellés de critères clés. Pour la pertinence, indexez :

- nom du fournisseur + synonymes

- noms de critères + courtes descriptions

- tags/catégories (ex. « sécurité », « tarification », « open source »)

Retournez des résultats qui amènent directement l’utilisateur à une ligne fournisseur ou une section de critère, pas seulement une page de résultats générique.

Instrumenter l’analytics pour des décisions réelles

Suivez des événements qui montrent l’intention et les frictions :

- actions de comparaison (ajout/suppression, ouverture côte à côte)

- changements de filtres et de tri

- exports (CSV/PDF) et actions de copie

- clics sortants (demande de démo, documentation, contact)

Incluez les filtres actifs et les IDs comparés dans la charge d’événement pour apprendre quels critères poussent les décisions.

Si vous voulez lancer un site de comparaison rapidement — sans passer des semaines sur la base, les écrans CRUD et l’UX des tableaux — une plateforme générative peut être un raccourci pratique. Vous décrivez vos entités (produits, critères, preuves), workflows (revue/approbation) et pages clés (hub de catégorie, page produit, page compare) en conversation, puis vous itérez sur l’application générée.

Ces plateformes sont particulièrement utiles si votre stack cible correspond à leurs défauts (ex. React sur le web, backend en Go avec PostgreSQL). Vous pouvez aussi exporter le code source, utiliser snapshots/rollback pendant que vous ajustez la logique de notation, et déployer avec des domaines personnalisés quand vous êtes prêt.

Rendre les pages de comparaison optimisées pour le SEO

Déployez où vous opérez

Exécutez votre application dans le pays nécessaire pour répondre aux exigences de résidence des données.

Les pages de comparaison sont souvent le premier point de contact pour des visiteurs à forte intention (« X vs Y », « meilleurs outils pour… », « comparaison de fonctionnalités »). Le SEO fonctionne mieux quand chaque page a un but clair, une URL stable et un contenu véritablement distinct.

Rédiger des titres, intros et résumés uniques

Donnez à chaque page de comparaison son propre titre et H1 qui correspondent à l’intention :

- « Fournisseur A vs Fournisseur B : API, sécurité, tarification et support »

- « Meilleurs outils ETL pour la santé : conformité, connecteurs et coût »

Ouvrez avec un court résumé qui répond : pour qui est cette comparaison, ce qui est comparé, et quelles sont les différences principales. Incluez ensuite une mini-conclusion (même succincte : “idéal pour X, idéal pour Y”) pour éviter que la page ne ressemble à un tableau générique.

Utiliser les données structurées avec prudence

Les données structurées peuvent améliorer l’apparence dans les résultats quand elles reflètent le contenu visible.

- Utilisez le balisage Product pour les pages produit individuelles (nom, marque, offres là où c’est exact).

- Utilisez le balisage FAQ uniquement si vous incluez une vraie section FAQ avec questions et réponses que les utilisateurs poseraient.

Évitez de surcharger chaque page avec des types de schéma ou d’ajouter des champs que vous ne pouvez pas étayer par des preuves. La cohérence et l’exactitude comptent plus que la quantité.

Prévenir le contenu dupliqué dans les grandes matrices

Le filtrage et le tri peuvent générer de nombreuses URL très similaires. Décidez ce qui doit être indexé et ce qui ne doit pas l’être :

- Définissez des URL canoniques pour la version “principale” de chaque comparaison.

- Gérez les paramètres d’URL (filtres/tri) pour qu’ils ne créent pas de pages indexables dupliquées.

- Si vous avez des variantes par localisation ou segment, assurez-vous que chacune apporte un contexte unique significatif.

Construire un maillage interne qui reflète les décisions

Aidez les moteurs et les utilisateurs à naviguer comme ils évaluent :

- Hubs de catégorie → pages produit → pages de comparaison

- Pages de comparaison → pages produit référencées et comparaisons associées (ex. “fournisseurs similaires”, “alternatives”)

Utilisez un texte d’ancrage descriptif (« comparer le modèle de tarification », « fonctionnalités de sécurité ») plutôt que des « cliquez ici » répétitifs.

Planifier le sitemap et les règles d’indexation

Pour de grandes matrices, le succès SEO dépend de ce que vous n’indexez pas.

Incluez uniquement les pages à forte valeur dans votre sitemap (hubs, produits clés, comparaisons éditoriales). Gardez les combinaisons fines et auto-générées hors indexation, et surveillez les statistiques de crawl pour que les moteurs consacrent leur budget aux pages qui aident réellement les décideurs.

Tester, lancer et maintenir la matrice

Une matrice fonctionne si elle reste exacte, facile à utiliser et digne de confiance. Traitez le lancement comme le début d’un cycle continu : tester, publier, apprendre et mettre à jour.

Tester pour la vitesse de décision (pas seulement les clics)

Faites des tests utilisateurs qui se concentrent sur le résultat réel : les utilisateurs décident-ils plus vite et avec plus de confiance ? Proposez des scénarios réalistes (ex. « choisir la meilleure option pour une équipe de 50 personnes aux besoins de sécurité stricts ») et mesurez :

- Temps pour atteindre une shortlist

- S’ils comprennent pourquoi une option gagne

- Où ils hésitent (filtres, notation, données manquantes)

Valider l’accessibilité et le comportement des tableaux

Les interfaces de comparaison échouent souvent aux contrôles d’accessibilité. Avant le lancement, vérifiez :

- La navigation au clavier sur les filtres, onglets et cellules

- Les contrastes qui respectent les directives pour le texte, badges et mises en avant

- La sémantique des tableaux (en-têtes, labels de lignes/colonnes) pour que les lecteurs d’écran puissent interpréter la matrice

Vérifier la précision des données et les cas limites

Contrôlez d’abord les fournisseurs/produits les plus consultés et les critères les plus importants. Testez ensuite les cas limites :

- Gestion « N/A » vs « Non » vs « Inconnu »

- Égalités de score et leur explication

- Filtres qui renvoient zéro résultat (guidez-vous l’utilisateur pour en sortir ?)

Lancer avec un plan de maintenance

Fixez des attentes en interne et publiquement : les données changent.

- Vérification mensuelle pour tarification, disponibilité et affirmations clés

- Revue trimestrielle des critères et pondérations pour rester aligné sur la façon dont les gens décident

Créer une boucle de retour

Définissez comment les utilisateurs peuvent signaler des erreurs ou proposer des mises à jour. Offrez un formulaire simple avec catégories (erreur de donnée, fonctionnalité manquante, problème UX) et engagez-vous sur des délais de réponse (ex. accuser réception sous 2 jours ouvrés). Avec le temps, cela devient votre meilleure source pour savoir quoi corriger ensuite.