La question n’est pas « lequel est le meilleur ? » — c’est « quel système convient le mieux à cette charge de travail et à cette équipe ? » MongoDB et PostgreSQL sont tous deux matures et largement adoptés, mais ils optimisent pour des valeurs par défaut différentes : MongoDB pour des données documentaires flexibles et une itération rapide, PostgreSQL pour la modélisation relationnelle, l'expressivité SQL et des garanties d'intégrité fortes.

Le choix importe surtout lorsque votre charge penche nettement dans une direction :

- Contenus et catalogues produits (attributs imbriqués, champs évolutifs, formes d'enregistrement variées)

- Données cœur de SaaS (comptes, facturation, permissions, journaux d’audit, relations plusieurs-à-plusieurs)

- Analytics et reporting (filtres complexes, regroupements, requêtes ad hoc)

- Flux d’événements et d’activité (taux d'écriture élevé, requêtes temporelles, politiques de rétention)

Un modèle mental utile : si vos données sont naturellement un ensemble d'entités avec des relations, PostgreSQL est souvent le choix le plus simple. Si vos données sont naturellement une collection d'enregistrements autonomes qui changent de forme, MongoDB peut réduire les frictions — surtout au début.

Utilisez des critères d’évaluation cohérents

Pour garder la comparaison pratique, évaluez les deux options selon les mêmes questions :

- Adéquation du modèle de données : documents vs tables ; fréquence des changements de forme

- Besoins de requêtage : jointures, agrégations, recherche, reporting

- Intégrité : contraintes, règles référentielles et attentes en matière de validation

- Consistance/transactions : quelles défaillances vous pouvez tolérer — et lesquelles non

- Facteurs de performance : schémas de lecture/écriture, index, points chauds

- Scalabilité/disponibilité : réplication, comportement de basculement, complexité opérationnelle

- Compétences de l’équipe : maîtrise du SQL, outils, discipline des migrations

Supposez que « les deux » sont possibles

Beaucoup d’équipes pratiquent la persistence polyglotte : PostgreSQL pour les données de référence et MongoDB pour le contenu, des modèles de lecture proches du cache, ou des fonctionnalités à base d’événements. L’objectif est de faire moins de compromis sur les parties du système qui comptent le plus — pas la pureté idéologique.

Si vous créez rapidement des services, il peut aussi être judicieux de choisir une plateforme et une architecture qui ne vous verrouillent pas prématurément. Par exemple, Koder.ai (une plateforme vibe-coding qui génère des apps full-stack à partir de chat) parie par défaut sur React + Go + PostgreSQL, un bon « choix sûr » pour les systèmes transactionnels, tout en autorisant des champs semi-structurés via JSONB quand les besoins sont fluides.

Modèle de données : documents vs tables

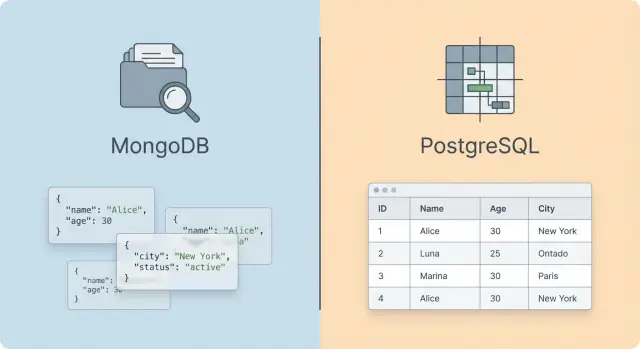

Au niveau du modèle de données, MongoDB et PostgreSQL encouragent des façons de penser différentes sur la « forme » de l’application. MongoDB est une base documentaire : vous stockez des documents de type JSON dans des collections. PostgreSQL est une base relationnelle : vous stockez des lignes dans des tables, les reliez par des clés et interrogez ces relations.

Dans MongoDB, un enregistrement typique peut embarquer des données liées directement :

- collection

orders

- un document contient la commande, un tableau de lignes de commande et l'adresse de livraison

Ceci convient bien aux données hiérarchiques ou « agrégées » que vous récupérez généralement en entier.

Dans PostgreSQL, vous normalisez typiquement en plusieurs tables :

orders (une ligne par commande)order_items (plusieurs lignes par commande)addresses (table optionnelle séparée)

Cette structure brille quand vous avez besoin de relations cohérentes et de jointures fréquentes — par exemple pour du reporting croisant clients, produits et commandes.

Flexibilité du schéma vs application

MongoDB est flexible par défaut : les documents d'une même collection peuvent avoir des champs différents. Cela accélère l'itération, mais laisse aussi plus de place à des formes inconsistantes à moins d'ajouter des règles de validation et de la discipline.

PostgreSQL impose une structure avec des types de colonnes, des contraintes et des clés étrangères. Les changements nécessitent des migrations, mais vous bénéficiez de garde-fous forts pour l'intégrité des données.

Un chemin médian existe : JSONB de PostgreSQL permet de stocker des données semi-structurées dans une table relationnelle. Beaucoup d'équipes utilisent des colonnes pour les champs stables (IDs, timestamps, status) et un JSONB pour les attributs évolutifs — conservant l'intégrité relationnelle tout en autorisant le changement.

Là où chaque modèle excelle

MongoDB est fréquemment naturel pour les objets imbriqués, les payloads d'événements et les données de type contenu que vous lisez en bloc. PostgreSQL excelle quand les relations sont de première classe, les jointures sont courantes et les règles de consistance (contraintes) font partie du modèle — pas seulement du code applicatif.

Requêtage : SQL, agrégations et jointures

Le ressenti quotidien entre MongoDB et PostgreSQL devient le plus évident au niveau des requêtes : PostgreSQL optimise les opérations ensemblistes sur des tables, tandis que MongoDB optimise le travail sur des documents imbriqués en forme d'objet applicatif.

SQL vs modèle find + Aggregation de MongoDB

SQL de PostgreSQL est déclaratif et composable : vous décrivez le jeu de résultats, et le planner décide comment l'obtenir. Cela rend naturelles les filtrations complexes, les groupements, les fonctions fenêtre, les CTE et les transformations multi-étapes — surtout quand les exigences évoluent.

MongoDB utilise typiquement find pour les récupérations simples et le pipeline d'agrégation pour les transformations (filter → project → group → sort, etc.). Le pipeline peut être expressif, mais il est plus procédural — l'ordre compte — et des pipelines très complexes sont parfois plus difficiles à raisonner qu'une instruction SQL unique.

Jointures : jointures relationnelles vs embedding et $lookup

PostgreSQL considère les jointures comme un outil de première classe. Vous pouvez normaliser les données et joindre des tables sans changer la façon de requêter ; le compromis est de penser à la cardinalité des jointures, aux index et parfois au réglage des requêtes.

MongoDB encourage l'embed des données liées quand elles sont souvent lues ensemble (par ex. une commande avec ses lignes). Cela peut éliminer les jointures et simplifier les lectures. L'inconvénient : duplication et mises à jour plus compliquées.

Quand des relations inter-collections sont nécessaires, MongoDB propose $lookup dans les agrégations. Ça marche, mais ce n'est généralement pas aussi ergonomique — ni aussi prévisible en performance à grande échelle — que des jointures relationnelles bien indexées, et cela peut pousser vers des pipelines plus lourds.

Reporting et analyse ad hoc

PostgreSQL tend à l'emporter pour les charges BI : requêtes ad hoc, jointures exploratoires et reporting sur de nombreuses entités sont simples, et la plupart des outils analytiques parlent SQL nativement.

MongoDB peut supporter le reporting, surtout si vos rapports s'alignent sur les frontières des documents, mais l'analyse multi-entité demande souvent plus de travail de pipeline (ou de l'ETL vers un entrepôt colonne).

Support des drivers et expérience développeur

Les deux ont des drivers matures, mais l'ergonomie diffère. PostgreSQL profite d'un vaste écosystème d'outils SQL, d'ORM et d'analyseurs de requêtes. MongoDB peut sembler plus naturel dans le code quand vos objets de domaine sont déjà de type JSON — jusqu'à ce que les relations et les besoins de reporting croissent.

Conception de schéma et intégrité des données

La conception du schéma est l'endroit où MongoDB et PostgreSQL diffèrent le plus au quotidien : MongoDB optimise pour façonner les données comme vos objets applicatifs, tandis que PostgreSQL optimise pour façonner des faits reliés.

Normalisation vs embedding (et pourquoi ça compte)

Dans PostgreSQL, la normalisation est la valeur par défaut : vous scindez les entités en tables et les connectez par des clés étrangères. Cela réduit la duplication et rend les mises à jour cross-entité plus sûres (modifier un nom de client une seule fois).

Dans MongoDB, l'embedding est courant : vous stockez des données liées à l'intérieur d'un même document pour les lire en un seul aller-retour. Par exemple, un document de commande peut embarquer ses lignes.

Le compromis est le coût des mises à jour et de la cohérence. L'embed peut dupliquer des données de référence (titre du produit, snapshot du prix), tandis qu'une normalisation poussée peut entraîner beaucoup de jointures et des APIs bavardes.

Évolution des exigences et changements de schéma

Quand les exigences évoluent — ajouter plusieurs adresses de livraison, introduire des champs de taxe optionnels, ou supporter de nouveaux attributs produit — la flexibilité des documents MongoDB absorbe plus facilement de nouveaux champs sans migration lourde.

PostgreSQL peut aussi évoluer en douceur, mais les changements sont explicites : ALTER TABLE, rétro-remplissage, et resserrement progressif des contraintes. Beaucoup d'équipes adoptent une approche « nullable d'abord, contraindre plus tard » pour livrer vite sans perdre l'intégrité à long terme.

Contraintes vs validation applicative

Les garde-fous natifs de PostgreSQL (clés étrangères, CHECK, contraintes d'unicité) empêchent des états invalides d'entrer dans la base.

MongoDB repose souvent davantage sur la validation côté application, bien qu'un schéma JSON Schema existe. La différence clef est culturelle : PostgreSQL encourage l'application centrale des invariants ; dans MongoDB, les équipes les implémentent souvent dans les chemins applicatifs et les tests.

Pièges de modélisation fréquents

Trop d'embed conduit à des documents très volumineux, des points chauds (beaucoup d'écritures sur un seul document) et des mises à jour partielles délicates. Trop de normalisation entraîne des jointures excessives, des APIs bavardes et des surprises de performance.

Règle pratique : embeddez les données qui changent ensemble ; référencez les données qui changent indépendamment.

Indexation et capacités de recherche

Les index sont souvent le point où le débat devient concret : la « meilleure » base est fréquemment celle qui peut répondre à vos requêtes les plus courantes avec une latence prévisible.

Types d'index de base et leurs usages

PostgreSQL utilise par défaut des index B-tree, couvrant de nombreux cas (égalité, intervalles, tri). Quand les patterns d'accès changent, vous disposez aussi d'options spécialisées : GIN (excellent pour les tableaux et la recherche full-text, souvent utilisé avec JSONB), GiST/SP-GiST (géospatial et types personnalisés), et BRIN (tables volumineuses naturellement ordonnées, ex. séries temporelles).

MongoDB s'appuie aussi sur des index de type B-tree pour les recherches et tris courants, avec des types additionnels : multikey pour les tableaux, 2dsphere pour le géospatial, et text pour une recherche textuelle basique.

Cadre pratique : PostgreSQL a plus de primitives d'index pour différents types et opérateurs, tandis que MongoDB met l'accent sur l'accès flexible aux documents et un bon support des champs imbriqués.

Les deux systèmes dépendent fortement des index composés. L'idée centrale est la même : indexer ensemble les champs filtrés pour que le moteur réduise vite l'espace de recherche.

- Dans PostgreSQL, l'ordre des colonnes compte ; placez en tête la colonne la plus sélective quand c'est possible. Les index partiels sont puissants quand vous filtrez souvent sur une condition (

WHERE status = 'active').

- Dans MongoDB, l'ordre des champs composés importe aussi, surtout quand vous mélangez égalités, plages et tris. Piège fréquent : indexer des champs non sélectifs — un index couvrant la moitié de la collection ne sera pas « rapide ».

Recherche textuelle : basiques intégrés vs moteurs dédiés

Les deux bases offrent des capacités full-text intégrées, mais elles conviennent mieux à des expériences de recherche simples.

- PostgreSQL full-text search est mature et s'associe bien avec des index GIN.

- Les index textuels de MongoDB conviennent pour une recherche par mots-clés simple, mais peuvent être limités pour le ranking, le traitement linguistique et les analyseurs avancés.

Si la recherche est une fonctionnalité produit majeure (pertinence complexe, autocomplete, faceting lourd), il est souvent plus propre d'utiliser un moteur de recherche dédié plutôt que d'étirer l'une ou l'autre base hors de son domaine de confort.

Mesurez avec vos requêtes réelles (ne devinez pas)

Pour les considérations de performance, validez les stratégies d'index avec des plans réels :

- PostgreSQL :

EXPLAIN (ANALYZE, BUFFERS) et surveillez les scans séquentiels, estimations erronées et tris coûteux.

- MongoDB :

explain() et analysez les étapes (usage d'index, docs examinés vs retournés).

C'est là que les débats « SQL vs MongoDB query language » se calment : l'index gagnant est celui qui réduit le travail sur le chemin que votre application exécute réellement.

Transactions et garanties de consistance

Réduisez les risques liés aux modifications du schéma

Testez des modifications de schéma, puis revenez en arrière rapidement si une migration tourne mal.

Les transactions ne sont pas qu'une case à cocher — elles déterminent les défaillances que votre application peut encaisser sans corrompre les données. ACID signifie généralement : opérations atomiques, validité des données, isolation face aux accès concurrents, et durabilité après crash.

PostgreSQL : « transactions d'abord »

PostgreSQL est construit autour de transactions multi-instructions et multi-tables. Vous pouvez modéliser des workflows comme « créer commande → réserver inventaire → débiter paiement → écrire journal » en une unité, en vous appuyant sur des garanties solides et des fonctionnalités mûres (contraintes, clés étrangères, triggers).

Pour la concurrence, PostgreSQL utilise MVCC : les lecteurs ne bloquent pas les écrivains et vice versa, et les niveaux d'isolation (Read Committed, Repeatable Read, Serializable) permettent de choisir le degré de prévention des anomalies.

MongoDB : bonnes options, implications de conception

MongoDB fournit l'atomicité au niveau du document unique par défaut, idéal quand vous embeddez et pouvez garder les mises à jour dans un seul document. Il supporte aussi les transactions multi-documents (réplica sets et clusters sharded), ce qui permet des workflows de style relationnel — mais avec plus d'overhead et des contraintes pratiques (taille/temps de transaction, coordination).

La consistance dans MongoDB se configure via read concern et write concern. Beaucoup d'applications utilisent des writes en majority et des lectures adaptées pour éviter des rollbacks après un failover.

Cas limites à prévoir

Les opérations multi-entité font ressortir les différences :

- MongoDB : les mises à jour cross-document sont possibles, mais de nombreuses équipes préfèrent des patterns comme l'embed, des écritures idempotentes et des actions compensatrices.

- PostgreSQL : les invariants multi-tables et les mises à jour complexes sont courants, et les contraintes aident à attraper les erreurs tôt.

Si vos workflows critiques dépendent d'invariants stricts multi-enregistrements sous concurrence, PostgreSQL paraît souvent plus simple. Si vous pouvez garder les mises à jour critiques dans un document (ou tolérer une réconciliation éventuelle), MongoDB peut être un bon choix.

Les différences de performance tiennent moins au « moteur » qu'à l'adéquation du modèle de données aux patterns d'accès — et à la quantité de travail que la base de données doit faire par requête.

Les systèmes lecture-lourde récompensent les designs qui minimisent les allers-retours et le travail côté serveur. MongoDB peut être très rapide quand une requête mappe sur une seule lecture de document (ou un scan d'index étroit) et que le document n'est pas surdimensionné.

Les systèmes écriture-lourde bottleneck souvent sur la maintenance des index, l'amplification d'écriture et les réglages de durabilité. PostgreSQL peut très bien performer avec des lignes étroites, des index choisis et des écritures en batch ; MongoDB peut aussi exceller avec des patterns append-only, mais les gros documents mis à jour fréquemment peuvent coûter cher.

Les charges mixtes exposent la contention : mises à jour touchant des index chauds, pression de verrouillage et churn cache. Là encore, les deux bases bénéficient de réduire le « travail extra par requête » (index inutiles, projections larges, requêtes trop bavardes).

Latence vs débit (et benchmark équitable)

La latence p99 est souvent dominée par les requêtes les plus lentes, pas la moyenne. Le débit dépend de l'utilisation efficiente du CPU, de la mémoire et de l'I/O en concurrence.

Benchmarkez équitablement en conservant :

- La même taille de jeu de données (y compris index) relative à la RAM

- Des paramètres durabilité/consistance comparables (fsync, journaling, réplication synchrone)

- Une sémantique de requête équivalente (notamment pour joins vs lectures imbriquées)

Jointures vs lectures de document : les jointures PostgreSQL sont puissantes mais peuvent devenir coûteuses à grande échelle sans clés de jointure efficaces et prédicats sélectifs. MongoDB évite les jointures quand les données sont embedded, mais paie parfois en documents plus volumineux et données dupliquées.

Taille document/ligne : les performances MongoDB chutent quand les documents grossissent et que la plupart des requêtes n'ont besoin que d'un petit sous-ensemble de champs. Dans PostgreSQL, des lignes larges et de gros blobs JSONB augmentent aussi I/O et pression mémoire.

Maintenance d'index : plus d'index améliorent les lectures — jusqu'à ce qu'ils écrasent les écritures. Les deux systèmes paient un coût par écrit pour mettre à jour chaque index, donc gardez les index alignés sur les vrais patterns de requête.

Construisez un test de charge minimal représentatif

Créez un petit harness qui rejoue vos 5–10 endpoints ou requêtes principaux avec une concurrence et des distributions de données réalistes. Commencez par un baseline, puis variez un élément à la fois (jeu d'index, embedding, JSONB vs tables normalisées). Conservez la checklist dans un repo et itérez — ne vous fiez pas aux benchmarks synthétiques mono-requête.

Scalabilité et haute disponibilité

Construisez avec des garde-fous Postgres

Générez un service sur Postgres et voyez comment contraintes et migrations s'intègrent à votre flux de travail.

La HA et la montée en charge ne se réduisent pas à « activer la réplication » — ce sont des choix de conception affectant le schéma, les patterns de requête et la charge opérationnelle. Le chemin le plus rapide vers la croissance est d'aligner les mécanismes de scalabilité sur vos patterns d'accès dominants (lecture-lourde, écriture-lourde, séries temporelles, multi-tenant, etc.).

Réplication et attentes de basculement

MongoDB utilise couramment des replica sets : un primaire accepte les écritures, les secondaires répliquent l'oplog, et une élection promeut un nouveau primaire en cas de panne. Ce modèle est simple pour la HA, mais prévoyez :

- Temps d'élection et erreurs d'écriture transitoires pendant le failover

- Choix du write concern (p.ex. majority) qui échange latence et durabilité

- Read preferences pouvant servir des données légèrement obsolètes

PostgreSQL s'appuie typiquement sur la réplication en streaming (physique), souvent avec un primaire et des standbys. Le basculement est généralement orchestré par des outils (services managés, Patroni, etc.) et les compromis incluent :

- Réplication synchrone vs asynchrone (latence de commit vs risque de perte de données au basculement)

- RPO/RTO dépendant fortement de l'automatisation du basculement et de la fréquence des tests

Scalabilité horizontale : sharding vs partitionnement

Sharding MongoDB est natif et peut répartir lectures et écritures sur des shards. Le prix à payer est la complexité opérationnelle : choix de la clé de shard, éviter les hotspots, migrations de chunks, et coûts des requêtes cross-shard.

PostgreSQL scale verticalement très bien, et horizontalement de façon plus sélective. Patterns courants : read scaling via replicas et write scaling via :

- Partitioning natif : excellent pour les données temporelles ou par locataire, mais ne répartit pas automatiquement la charge d'écriture

- Solutions de sharding : efficaces mais ajoutent des pièces mobiles et contraignent souvent joins/transactions multi-shards

Préparez la croissance selon les patterns d'accès

Avant de vous engager, modélisez vos requêtes futures : quels champs sont filtrés le plus, quels tris sont requis, et ce qui doit être transactionnel. Un design adapté aujourd'hui mais qui force des fan-outs cross-shard, des partitions chaudes ou une réplication trop synchrone va se retrouver bottlenecké plus tôt que prévu.

Opérations : sauvegardes, monitoring et maintenance

Le travail opérationnel est l'endroit où « MongoDB vs PostgreSQL » cesse d'être seulement une question de fonctionnalités et devient une question d'habitudes : comment vous sauvegardez, à quelle vitesse vous restaurez, et avec quelle confiance vous changez de version.

Sauvegardes, restaurations et RPO/RTO

PostgreSQL utilise un mix de sauvegardes logiques et physiques :

- Logique :

pg_dump/pg_restore sont flexibles (restauration par table, portabilité) mais peuvent être lents sur de grands jeux.

- Physique + PITR : backups de base (souvent via

pg_basebackup) + archivage WAL permettent une récupération point-in-time. C'est la voie habituelle pour obtenir un RPO faible (minutes ou moins) et un RTO prévisible.

MongoDB aborde cela via des outils et des snapshots :

- Logique :

mongodump/mongorestore sont simples mais peuvent peiner à l'échelle ou avec des RTO serrés.

- Snapshots + oplog : snapshots filesystem ou managés combinés à la relecture de l'oplog permettent une récupération point-in-time si bien configurés.

Pour les deux systèmes, définissez RPO/RTO explicitement, puis testez régulièrement les restaurations. Une « sauvegarde » jamais restaurée n'est que des données stockées.

Signaux de monitoring importants

Surveillez les symptômes corrélant fortement à la douleur utilisateur :

- Requêtes lentes :

pg_stat_statements, auto_explain et logs de requêtes lentes pour Postgres ; profiler et logs lents pour MongoDB.

- Verrous et contention : attentes de verrous, deadlocks, transactions longues côté Postgres ; métriques de lock et conflits d'écriture côté MongoDB.

- Lag de réplication : critique pour le scaling en lecture et la correction des basculements dans les deux systèmes.

Suivez aussi la santé du stockage : progression du vacuum et bloat pour PostgreSQL ; évictions de cache, défauts de page et impact des builds d'index pour MongoDB.

Mises à niveau, migrations et maintenance routinière

Les montées de version majeures PostgreSQL impliquent souvent pg_upgrade ou des cutovers par réplication logique ; planifiez la compatibilité des extensions et des fenêtres d'indisponibilité. Les upgrades MongoDB suivent généralement des procédures rolling, en surveillant le Feature Compatibility Version (FCV), la construction d'index et (si sharded) l'équilibrage des chunks.

Outils et automatisation

En pratique, les équipes s'appuient sur des services managés (Atlas, Postgres managés cloud) ou sur l'automatisation via Terraform/Ansible et opérateurs Kubernetes. La question clé n'est pas « peut-on automatiser ? » mais si votre équipe est prête à posséder les runbooks, les signaux on-call et les drills de restauration.

Si vous générez des services rapidement (par ex. via Koder.ai pour déployer plusieurs environnements), standardisez tôt les choix opérationnels — stratégie de sauvegarde, workflow de migration, approche de rollback — pour que la vitesse ne devienne pas fragilité.

Sécurité et gouvernance

La sécurité n'est pas simplement « activer l'authentification ». Pour MongoDB comme pour PostgreSQL, la question pratique est : comment appliquer le principe du moindre privilège, faire tourner les identifiants, et prouver (à vous-même ou à un auditeur) qui a accédé à quelles données et quand.

Authentification, rôles et contrôle d'accès quotidien

Les deux bases supportent une authentification forte et un contrôle d'accès basé sur les rôles (RBAC), mais l'ergonomie diffère.

Le modèle PostgreSQL s'articule autour d'utilisateurs/roles, de grants sur schémas/tables/vues et de privilèges SQL prévisibles. Il mappe bien à des rôles séparés pour applications (écriture) et analystes (lecture), souvent via des replicas en lecture.

Le RBAC de MongoDB est mature aussi, avec des privilèges scindés par base et collection, et des options plus fines selon le déploiement. Il convient quand on raisonne déjà en termes « le service X peut lire/écrire la collection Y ».

Pattern least-privilege utile dans les deux cas :

- Créer un rôle par charge de travail (app-write, app-read, analyst-read, admin-breakglass)

- Préférer l'accès en lecture seule pour les outils BI, restreindre les écritures ad hoc

- Donner accès via des vues (Postgres) ou des collections curatées (MongoDB) plutôt qu'aux données opérationnelles brutes

Chiffrement en transit et au repos

Traitez TLS comme obligatoire. Imposer au niveau driver et serveur, et désactiver les versions de protocole anciennes.

Pour le chiffrement au repos, les capacités varient selon le modèle de déploiement :

- En self-hosted, combinez fonctions DB et chiffrement disque (avec gestion de clés rigoureuse).

- En service managé, vérifiez la portée du « chiffrement au repos », la gestion des clés et le support des clés gérées par le client.

Pour SOC 2, ISO 27001, HIPAA, PCI, vous aurez besoin d’une histoire claire d'audit et de rétention : logs de connexions, changements DDL, modifications de privilèges et accès aux tables/collections sensibles. La gouvernance inclut aussi la classification des données (PII ?), les politiques de rétention et des process documentés de réponse aux incidents.

Approche pragmatique : décidez tôt quels événements capturer (auth, actions admin, accès datasets sensibles) et centralisez les logs dans un SIEM.

Gestion des secrets et hygiène des connexions

La plupart des failles réelles concernent les identifiants et la connectivité, pas la syntaxe des requêtes.

- Stockez les identifiants dans un gestionnaire de secrets (pas de fichiers de conf, pas de variables CI immuables)

- Faites pivoter les credentials régulièrement et lors de changements de personnel

- Utilisez tokens short-lived ou auth IAM quand disponible

- Restreignez l'accès réseau (réseaux privés, allowlists IP, pas d'exposition publique)

- Maintenez les drivers à jour et fixez des limites/timeout de connexion raisonnables pour éviter des modes de défaillance bruyants

Bien fait, MongoDB et PostgreSQL peuvent satisfaire des exigences de sécurité strictes — la différence est plutôt dans le modèle qui correspond le mieux aux patterns d'accès et aux attentes d'audit de votre organisation.

Coût et facteurs de coût total de possession

Partagez un prototype fonctionnel

Hébergez votre appli sur un domaine personnalisé pour que les parties prenantes puissent consulter les flux de données dès le début.

Le coût n'est rarement « juste la base ». Pour MongoDB vs PostgreSQL, le TCO se répartit typiquement entre consommation de ressources, overhead de durabilité et temps des personnes nécessaires pour garder le système sain.

Principaux facteurs de coût

Compute est souvent la variable la plus importante. Les charges basées sur des jointures, du reporting complexe ou une consistance stricte sollicitent différemment CPU et mémoire que des lectures/écritures orientées document. Stockage dépend non seulement de la taille des données brutes, mais aussi de l'empreinte des index et de toute duplication due à la dénormalisation.

IOPS et latence deviennent un poste quand le working set ne tient pas en mémoire ou que les index sont gros. Des taux d'écriture élevés amplifient aussi l'overhead de sauvegarde (fréquence des snapshots, rétention WAL/oplog, tests de restauration). Enfin, réplicas multiplient les coûts : une configuration HA à 3 nœuds multiplie approximativement compute+stockage, et des replicas cross-region ajoutent réseau et classes de stockage plus élevées.

Licences et support

PostgreSQL est typiquement utilisé en open-source, tandis que les déploiements MongoDB varient entre builds communautaires et offres commerciales. Les services managés pour l'un ou l'autre peuvent transférer du temps d'opération vers un prix unitaire plus élevé. Le support payant a de la valeur pour la réponse aux incidents et le tuning, mais le ROI dépend de l'expérience et de la tolérance au risque de votre équipe.

Complexité opérationnelle = argent réel

L'effort opérationnel se traduit en salaire et coût d'opportunité : migrations de schéma, tuning d'index, régressions de requêtes, capacity planning, fatigue on-call et travail de conformité. Si votre organisation maîtrise déjà bien PostgreSQL, changer de moteur peut coûter plus cher que la facture infra (et inversement).

Checklist rapide coûts

- Throughput lecture/écriture attendu et ratio pic/moyenne

- Taille des données maintenant vs 12–24 mois ; hypothèses de croissance des index

- Nombre d'environnements (dev/stage/prod) et compte de replicas

- Objectifs sauvegarde/restauration : RPO/RTO, rétention, fréquence des tests

- Exigences cross-region et estimation d'egress réseau

- Géré vs auto-hébergé : staffing, on-call, patching, upgrades

- Conformité : audit, chiffrement, contrôle d'accès

Guide d'usage et matrice de décision

Choisir entre une base documentaire et relationnelle porte moins sur la vitesse brute que sur le comportement des données face au changement, le degré d'intégrité à faire appliquer, et la façon dont l'équipe veut interroger.

Quand MongoDB est un bon choix

MongoDB brille souvent dans les domaines centrés sur les documents où « l'objet » ressemble naturellement à un JSON imbriqué et évolue souvent :

- Catalogues produits, gestion de contenu, profils utilisateurs, payloads d'événements, télémétrie IoT, données de session/état

- Charges avec beaucoup de champs optionnels, changements fréquents de schéma, ou attributs spécifiques par locataire

- Applications qui gagnent à embedder des données liées pour éviter des lectures join-heavy

Quand PostgreSQL est un bon choix

PostgreSQL est généralement plus sûr quand l'intégrité relationnelle et SQL expressif sont essentiels :

- Systèmes d'enregistrement : commandes, facturation, inventaire, RH, finance, registres comptables

- Relations plusieurs-à-plusieurs et analytics/reporting reposant sur jointures, fonctions fenêtre et outils SQL

- Contraintes et besoins forts de consistance (clés étrangères, unicité,

CHECK), plus transactions ACID

- Charges mixtes où des tables relationnelles coexistent avec des données semi-structurées via

JSONB

Quand une approche hybride est pertinente

Une séparation pragmatique : gardez les entités autoritatives et lourdes en contraintes dans PostgreSQL, et stockez les documents flexibles d'interaction ou de contenu dans MongoDB.

Exemples : commandes/paiements en Postgres ; descriptions produit, blobs de personnalisation, événements clickstream ou projections mises en cache dans MongoDB. Utilisez des IDs immuables et un pattern outbox/event pour synchroniser, et traitez chaque système comme source de vérité d’un type d’entité.

Matrice de décision rapide

| Besoin | Préfère MongoDB | Préfère PostgreSQL |

|---|

| Forme des données change souvent | ✅ | ➖ |

| Jointures complexes & reporting SQL | ➖ | ✅ |

| Intégrité relationnelle stricte | ➖ | ✅ |

| Stocker des documents imbriqués tels quels | ✅ | ✅ (JSONB) |

| Équipe/outils centrés SQL | ➖ | ✅ |

Si vous voulez réduire la charge décisionnelle tout en livrant vite, choisissez un bon défaut et gardez une porte de sortie : commencez par Postgres pour les entités cœur, réservez MongoDB aux domaines clairement documentaires, et validez avec des plans de requêtes réels.

Pour planifier une migration (ou l'ajout d'un second store), voyez /blog/database-migration-checklist.