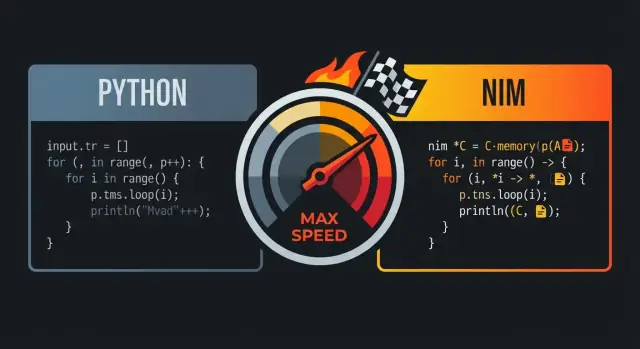

Pourquoi on compare souvent Nim à Python et à C

Nim est souvent comparé à Python et à C parce qu’il vise le juste milieu : du code qui se lit comme un langage de haut niveau, mais qui se compile en exécutables natifs rapides.

La promesse centrale : lisibilité et vitesse

À première vue, Nim donne souvent une impression « pythonique » : indentation claire, contrôle de flux simple, et des fonctionnalités de bibliothèque standard qui encouragent un code lisible et compact. La différence clé est ce qui se passe après l’écriture — Nim est conçu pour se compiler en code machine efficace plutôt que d’être exécuté sur un runtime lourd.

Pour beaucoup d’équipes, cette combinaison est l’essentiel : écrire du code proche de ce que l’on prototyperait en Python, tout en livrant un binaire natif unique.

Pour qui cela compte

Cette comparaison parle surtout aux :

- développeurs Python atteignant des limites de performance (tâches CPU-intensives, boucles serrées, traitement de données)

- équipes produits voulant une itération rapide sans dépendre d’un runtime lent

- ingénieurs qui aiment la vitesse du C mais veulent éviter la cérémonie bas niveau pour le code courant

« Performance de niveau C » ne veut pas dire que chaque programme Nim égalera automatiquement un C optimisé à la main. Cela signifie que Nim peut générer un code compétitif avec C pour beaucoup de charges — surtout là où l’overhead compte : boucles numériques, parsing, algorithmes, services nécessitant une latence prévisible.

Les plus gros gains apparaissent généralement quand on élimine l’overhead d’un interprète, minimise les allocations et garde les chemins chauds simples.

Attentes : la vitesse dépend toujours des choix

Nim ne sauvera pas un algorithme inefficace, et on peut écrire du code lent en allouant excessivement, en copiant de grandes structures, ou en ignorant le profilage. La promesse est que le langage vous offre un chemin du code lisible au code rapide sans tout réécrire dans un autre écosystème.

Le résultat : un langage qui se sent accueillant comme Python, mais qui sait se rapprocher du métal quand la performance compte.

Syntaxe proche de Python : du code lisible sans l’overhead

Nim est souvent décrit comme « proche de Python » car le code ressemble et coule de manière familière : blocs par indentation, ponctuation minimale, et préférence pour des constructions lisibles et de haut niveau. La différence est que Nim reste statiquement typé et compilé — vous avez donc cette surface propre sans payer la « taxe » d’un runtime.

Blocs par indentation et structure claire

Comme Python, Nim utilise l’indentation pour définir les blocs, ce qui rend le flux de contrôle facile à parcourir dans les revues ou les diffs. On n’a pas besoin d’accolades partout, et les parenthèses ne sont nécessaires que quand elles améliorent la clarté.

let limit = 10

for i in 0..<limit:

if i mod 2 == 0:

echo i

Cette simplicité visuelle compte quand on écrit du code sensible aux performances : on passe moins de temps à se battre contre la syntaxe et plus de temps à exprimer l’intention.

Blocs familiers : boucles, slices, chaînes

Beaucoup de constructions quotidiennes correspondent à ce que les utilisateurs Python attendent.

- Boucles : les

for sur plages et collections sont naturels.

- Slicing : les séquences et chaînes supportent des opérations de type slice.

- Chaînes : la manipulation des chaînes est simple, avec une bibliothèque standard pensée pour du travail pratique.

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

La différence clé avec Python est ce qui se passe en coulisses : ces constructions se compilent en code natif efficace plutôt qu’être interprétées par une VM.

Typage statique qui ne gêne pas

Nim est fortement statiquement typé, mais il mise aussi beaucoup sur l’inférence de type, donc vous n’êtes pas forcé d’écrire des annotations verbeuses pour avancer.

var total = 0 # inféré comme int

let name = "Nim" # inféré comme string

Quand vous voulez des types explicites (API publiques, clarté, ou limites sensibles aux performances), Nim les prend en charge proprement — sans les imposer partout.

Erreurs et avertissements utiles du compilateur

Une grande partie de la lisibilité tient au fait de pouvoir maintenir le code en toute sécurité. Le compilateur Nim est strict de manière utile : il remonte les incompatibilités de type, les variables inutilisées et les conversions douteuses tôt, souvent avec des messages exploitables. Ce retour aide à garder un code simple comme en Python tout en bénéficiant de vérifications à la compilation.

Si vous aimez la lisibilité de Python, la syntaxe de Nim vous semblera familière. La différence est que le compilateur Nim peut valider vos hypothèses puis produire des binaires natifs rapides et prévisibles — sans transformer votre code en boilerplate.

Nim est un langage compilé : vous écrivez des fichiers .nim, et le compilateur les transforme en un exécutable natif que vous pouvez lancer directement. La voie la plus courante passe par le backend C de Nim (il peut aussi cibler C++ ou Objective-C), où le code Nim est traduit en code backend puis compilé par un compilateur système comme GCC ou Clang.

Ce que « binaire natif » signifie vraiment

Un binaire natif s’exécute sans machine virtuelle ni interprète parcourant votre code ligne par ligne. C’est une grande partie de la raison pour laquelle Nim peut paraître de haut niveau tout en évitant bon nombre des coûts d’un runtime : le démarrage est généralement rapide, les appels de fonctions sont directs et les boucles chaudes peuvent exécuter près du matériel.

Opportunités d’optimisation sur l’ensemble du programme

Parce que Nim compile ahead-of-time, la chaîne d’outils peut optimiser à l’échelle du programme. En pratique cela permet une meilleure inlining, l’élimination de code mort et l’optimisation au moment de l’édition des liens (selon les flags et le compilateur C/C++). Le résultat est souvent des exécutables plus petits et plus rapides — comparés à la distribution d’un runtime plus le code source.

Flux de travail typique : compiler, exécuter, livrer

Pendant le développement, vous itérez généralement avec des commandes comme nim c -r yourfile.nim (compiler et exécuter) ou utilisez différents modes de build pour debug vs release. Lorsqu’il est temps de livrer, vous distribuez l’exécutable produit (et les bibliothèques dynamiques requises, si vous en liez). Il n’y a pas d’étape distincte « déployer l’interprète » — votre sortie est déjà un programme que l’OS peut exécuter.

Puissance à la compilation : faire du travail avant l’exécution

Un des gros avantages de Nim est la capacité à faire du travail à la compilation (CTFE). Autrement dit : plutôt que de calculer quelque chose à chaque exécution, vous demandez au compilateur de le calculer une fois lors de la construction puis d’insérer le résultat dans le binaire final.

Pourquoi le travail à la compilation compte

Les performances à l’exécution sont souvent mangées par les « coûts d’amorçage » : construire des tables, parser des formats connus, vérifier des invariants ou pré-calculer des valeurs constantes. Si ces résultats sont prévisibles à partir de constantes, Nim peut déplacer cet effort vers la compilation.

Cela se traduit par :

- moins de temps de démarrage (pas d’étape de « warm-up »)

- moins d’allocations et de branches à l’exécution

- des chemins d’exécution plus simples (souvent plus faciles à optimiser pour le compilateur)

Exemples pratiques

Génération de tables de consultation. Si vous avez besoin d’une table pour un mapping rapide (classes de caractères ASCII, petite table de hachage de chaînes connues), vous pouvez la générer à la compilation et la stocker en tant que tableau constant. Le programme fait alors des accès O(1) sans configuration.

Validation des constantes tôt. Si une constante est hors plage (numéro de port, taille de buffer fixe, version de protocole), vous pouvez échouer la compilation plutôt que d’expédier un binaire qui découvre le problème plus tard.

Précalcul de constantes dérivées. Masques, motifs de bits ou valeurs par défaut normalisées peuvent être calculés une fois et réutilisés partout.

Note de prudence : garder la lisibilité

La logique à la compilation est puissante, mais c’est toujours du code que quelqu’un doit comprendre. Préférez de petits helpers bien nommés ; ajoutez des commentaires expliquant le « pourquoi maintenant » (compilation) vs le « pourquoi plus tard » (runtime). Et testez les helpers CTFE comme vous testez les fonctions ordinaires — pour éviter que des optimisations ne deviennent des erreurs de build difficiles à déboguer.

Macros et méta-programmation sans perdre en clarté

Les macros de Nim s’entendent mieux comme du « code qui écrit du code » pendant la compilation. Plutôt que d’exécuter de la logique réflexive à l’exécution (et d’en payer le coût à chaque exécution), vous pouvez générer du code Nim spécialisé une fois, puis livrer le binaire rapide résultant.

Supprimer le boilerplate (et les vérifications à l’exécution)

Un usage courant est de remplacer des motifs répétitifs qui gonfleraient autrement votre base de code ou ajouteraient un overhead par appel. Par exemple, vous pouvez :

- générer des fonctions de sérialisation/désérialisation pour un type au lieu d’écrire champ par champ

- produire du code de validation d’entrée à partir d’un schéma compact, au lieu d’accumuler des

if dans tout le programme

- construire des dispatchs optimisés (mapper commandes vers handlers) sans tables de recherche à l’exécution

Comme la macro s’expande en code Nim normal, le compilateur peut toujours inliner, optimiser et supprimer des branches mortes — l’abstraction disparaît souvent dans l’exécutable final.

Syntaxe spécifique au domaine (sans compilateur personnalisé)

Les macros permettent aussi une syntaxe DSL légère. Les équipes s’en servent pour clarifier l’intention :

- parseurs rapides : écrire une description déclarative, la macro émet du code de parsing serré

- serializers : spécifier balises/champs, générer le packing/unpacking

- mini-DSL pour routage, construction de requêtes SQL ou mappings de configuration

Bien fait, cela rend le call site lisible comme en Python — propre et direct — tout en compilant en boucles efficaces et opérations sûres vis-à-vis des pointeurs.

Rendre les macros maintenables

La méta-programmation peut devenir confuse si elle se transforme en langue cachée du projet. Quelques garde-fous :

- documenter ce que la macro génère et montrer un petit exemple du code développé

- garder les macros ciblées : résoudre un problème clair plutôt que devenir un « framework »

- préférer generics/templates quand ils suffisent ; utiliser les macros pour les transformations AST nécessaires

Contrôlez votre base de code

Exportez le code source complet pour continuer à l'améliorer en dehors de la plateforme.

La gestion mémoire par défaut de Nim est une grosse raison pour laquelle il peut sembler « pythonique » tout en se comportant comme un langage système. Plutôt qu’un GC de type tracing qui parcourt périodiquement la mémoire, Nim utilise souvent ARC (Automatic Reference Counting) ou ORC (Optimized Reference Counting).

ARC/ORC vs GC par tracing (haut niveau)

Un GC par tracing fonctionne par salves : il interrompt le travail normal pour parcourir les objets et décider de ce qui peut être libéré. Ce modèle est agréable pour l’ergonomie développeur, mais les pauses peuvent être difficiles à prévoir.

Avec ARC/ORC, la plupart de la mémoire est libérée lorsque la dernière référence disparaît. En pratique, cela tend à produire une latence plus cohérente et facilite le raisonnement sur le moment où les ressources sont libérées (mémoire, fichiers, sockets).

Un comportement mémoire prévisible réduit les ralentissements surprises. Si les allocations et libérations se produisent de manière continue et locale — plutôt que lors de cycles globaux —, le timing de votre programme est plus facile à contrôler. Cela compte pour les jeux, serveurs, outils CLI et tout ce qui doit rester réactif.

Cela aide aussi le compilateur : quand les durées de vie sont plus claires, le compilateur peut parfois garder des données en registres ou sur la pile, et éviter de la comptabilité supplémentaire.

Pile vs tas, durées de vie, copier vs déplacer

Pour simplifier :

- Valeurs sur la pile : de courte durée, économiques à créer ; elles disparaissent à la fin d’un scope.

- Valeurs sur le tas : vivent plus longtemps et peuvent être partagées entre scopes ; les allouer coûte plus cher.

Nim vous permet d’écrire du code de haut niveau tout en restant attentif aux durées de vie. Faites attention à copier de grandes structures (duplication) vs les déplacer (transfert d’ownership sans duplication). Évitez les copies accidentelles dans les boucles serrées.

Astuces pratiques pour éviter des allocations inutiles

Si vous voulez une vitesse « à la C », la meilleure allocation est celle que vous n’effectuez pas :

- réutilisez des buffers (chaînes, séquences, IO) au lieu de les recréer

- préférez les mises à jour in-place dans les chemins chauds

- construisez des données de manière incrémentale avec une capacité préallouée quand c’est possible

Ces habitudes se marient bien avec ARC/ORC : moins d’objets sur le tas signifie moins de trafic de comptage de références et plus de temps pour faire le vrai travail.

Structures de données et layout : tirer la vitesse de la simplicité

Nim peut paraître de haut niveau, mais sa performance dépend souvent d’un détail bas niveau : ce qui est alloué, où cela vit et comment c’est agencé en mémoire. Si vous choisissez la bonne forme pour vos données, vous obtenez de la vitesse « gratuitement » sans écrire du code illisible.

Types par valeur vs ref : où se font les allocations

La plupart des types Nim sont par valeur par défaut : int, float, bool, enum, et aussi des object simples. Les types par valeur vivent typiquement inline (souvent sur la pile ou embedés dans d’autres structures), ce qui maintient l’accès mémoire serré et prévisible.

Quand vous utilisez ref (par ex. ref object), vous ajoutez un niveau d’indirection : la valeur vit généralement sur le tas et vous manipulez un pointeur. Utile pour les données partagées, longues ou optionnelles, mais cela peut ajouter de l’overhead dans les boucles chaudes car le CPU doit suivre des pointeurs.

Règle pratique : privilégiez les object simples pour les données critiques ; utilisez ref quand vous avez vraiment besoin d’une sémantique par référence.

seq et string : pratiques, mais connaître les coûts

seq[T] et string sont des conteneurs dynamiques redimensionnables. Parfaits pour le quotidien, mais ils peuvent allouer/reallouer en grandissant. Les motifs de coût à surveiller :

- l’ajout peut déclencher une redimension occasionnelle (copie des éléments)

- beaucoup de petits

seq ou chaînes créent de nombreux blocs sur le tas

Si vous connaissez les tailles à l’avance, pré-dimensionnez (newSeq, setLen) et réutilisez les buffers pour réduire le churn.

Pourquoi le layout importe : modèle mental simple du cache CPU

Les CPU sont plus rapides quand ils lisent de la mémoire contiguë. Un seq[MyObj] où MyObj est un objet valeur est typiquement cache-friendly : les éléments sont côte à côte.

Mais un seq[ref MyObj] est une liste de pointeurs dispersés sur le tas ; l’itération implique des sauts mémoire, ce qui est plus lent.

Conseils pratiques pour les chemins chauds

Pour les boucles serrées et le code sensible aux performances :

- préférez

array (taille fixe) ou seq d’objets valeur

- gardez les champs fréquemment accédés proches dans un même

object

- évitez les « chaînes de pointeurs » (

ref dans ref) sauf si nécessaire

Ces choix gardent les données compactes et locales — exactement ce que les CPU modernes apprécient.

Abstractions qui se compilent

Construisez et gagnez des crédits

Gagnez des crédits en partageant vos créations sur Koder.ai ou en invitant des coéquipiers.

Une raison pour laquelle Nim est haut niveau sans payer un lourd coût d’exécution est que beaucoup de fonctionnalités sont conçues pour se transformer en code machine simple. Vous écrivez du code expressif ; le compilateur l’abaisse en boucles serrées et appels directs.

Ce que signifie « abstraction zéro-coût » en Nim

Une abstraction zéro-coût rend le code plus lisible ou réutilisable, mais n’ajoute pas de travail supplémentaire à l’exécution comparé à la version bas niveau écrite à la main.

Un exemple intuitif : utiliser une API de style itérateur pour filtrer des valeurs, tout en obtenant une boucle simple dans le binaire final.

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

Même si openArray paraît flexible et haut niveau, cela compile typiquement en une simple itération indexée sur la mémoire (sans l’overhead objet à la Python). L’API est agréable, mais le code généré est proche d’une boucle C évidente.

Inlining, generics et spécialisation (version simple)

Nim inlines souvent de petites procédures quand cela aide, ce qui fait disparaître l’appel ; le corps est collé dans l’appelant.

Avec les generics, vous écrivez une fonction qui marche pour plusieurs types. Le compilateur spécialise ensuite : il crée une version adaptée pour chaque type concret utilisé. Cela donne souvent un code aussi efficace que des fonctions écrites pour chaque type sans dupliquer la logique.

API agréables qui deviennent des boucles serrées

Des motifs comme de petits helpers (mapIt, filterIt), des types distinct et des vérifications de plage peuvent être optimisés quand le compilateur peut les voir. Le résultat final peut être une seule boucle avec peu de branchements.

Le grand avertissement : abstractions qui forcent des allocations

Les abstractions cessent d’être « gratuites » quand elles créent des allocations ou des copies cachées. Retourner de nouvelles séquences à chaque itération, construire des chaînes temporaires dans des boucles internes, ou capturer de larges closures peuvent introduire de l’overhead.

Règle : si une abstraction alloue par itération, elle peut dominer le temps d’exécution. Préférez des données adaptées à la pile, réutilisez des buffers et surveillez les APIs qui créent silencieusement des seq ou des string dans les chemins chauds.

Interopérabilité avec C : réutiliser la vitesse et l’écosystème

Une raison pratique pour laquelle Nim peut paraître haut niveau tout en restant rapide est sa capacité à appeler directement du C. Plutôt que de réécrire une bibliothèque C éprouvée en Nim, vous pouvez importer ses déclarations d’en-tête, lier la bibliothèque compilée et appeler les fonctions presque comme si c’étaient des procs Nim.

À quoi ressemble l’FFI C de Nim (haut niveau)

L’interface étrangère de Nim repose sur la description des fonctions et types C que vous voulez utiliser. Dans de nombreux cas, vous :

- déclarez les symboles C en Nim avec

importc (en donnant le nom C exact), ou

- utilisez des outils pour générer des déclarations Nim à partir des headers C.

Ensuite, le compilateur Nim lie tout dans le même binaire natif, donc l’overhead d’appel est minimal.

Pourquoi cela compte : réutiliser sans réécrire

Cela vous donne un accès immédiat à des écosystèmes mûrs : compression (zlib), primitives crypto, codecs image/audio, clients de DB, APIs OS et utilitaires critiques pour les performances. Vous conservez la structure lisible de Nim pour la logique applicative tout en vous appuyant sur du C éprouvé pour le travail lourd.

Pièges à surveiller : ownership et conversions

Les bogues FFI viennent souvent d’attentes mal alignées :

- règles d’ownership : qui alloue et qui libère ? Si une fonction C retourne un pointeur que vous devez free, il faut un chemin clair de libération en Nim. Si C garde un pointeur que vous avez passé, vous devez assurer la durée de vie en conséquence.

- chaînes et buffers : les

string Nim ne sont pas des cstring. La conversion en cstring est simple, mais assurez-vous de la terminaison nulle et de la durée de vie. Pour les données binaires, préférez des paires ptr uint8/longueur explicites.

Enrober les APIs C de manière sûre (testable)

Un bon modèle est d’écrire une petite couche wrapper Nim qui :

- expose des procs et types idiomatiques Nim,

- centralise les conversions et la gestion des erreurs,

- cache les pointeurs bruts derrière des helpers RAII-like (

defer, destructeurs) si approprié.

Cela facilite les tests unitaires et réduit les fuites de détails bas niveau dans le reste de la base de code.

Nim peut paraître rapide « par défaut », mais les derniers 20–50% dépendent souvent de comment vous construisez et comment vous mesurez. La bonne nouvelle : le compilateur Nim expose des contrôles de performance accessibles même si vous n’êtes pas un expert système.

Modes de build importants

Pour des chiffres réalistes, évitez les builds de debug. Commencez par un build de release et n’ajoutez des vérifications qu’en chassant des bugs.

nim c -d:release --opt:speed myapp.nim

nim c -d:danger --opt:speed myapp.nim

nim c -d:release --opt:speed --passC:-march=native myapp.nim

Règle simple : utilisez -d:release pour les benchmarks et la production, et réservez -d:danger aux cas où vous avez déjà une bonne couverture de tests.

Profilage : mesurer d’abord, optimiser ensuite

Un flux pratique :

- Mesurez bout-en-bout d’abord (temps mur, mémoire, débit). Des outils comme

hyperfine ou time suffisent souvent.

- Localisez les hotspots ensuite. Nim propose un profilage intégré (

--profiler:on) et fonctionne bien avec des profileurs externes (Linux perf, Instruments macOS, outils Windows) car vous produisez des binaires natifs.

- Optimisez les 1–2 fonctions les plus chaudes, puis mesurez à nouveau.

Pour utiliser des profileurs externes, compilez avec des infos de debug pour obtenir des traces et des symboles lisibles :

nim c -d:release --opt:speed --debuginfo myapp.nim

Micro-optimisations à éviter

Il est tentant d’ajuster des détails minuscules (déroulement manuel de boucles, réarrangement d’expressions, astuces « clever ») avant d’avoir des données. En Nim, les gains majeurs viennent généralement de :

- choisir un meilleur algorithme,

- réduire les allocations et les copies,

- améliorer le layout des données (par ex. utiliser des séquences contiguës),

- alléger l’overhead dans les boucles critiques.

Benchmarks CI-friendly et contrôles de régression

Les régressions de perf se corrigent plus facilement quand elles sont détectées tôt. Une approche légère : ajouter une petite suite de benchmarks (via une tâche Nimble comme nimble bench) et l’exécuter en CI sur un runner stable. Conservez des baselines (même en JSON simple) et échouez la build si les métriques clés dérivent au-delà d’un seuil autorisé. Cela évite qu’un code « rapide aujourd’hui » devienne « lent le mois suivant » sans que personne ne le remarque.

Là où Nim brille (et là où il peut moins convenir)

Ajoutez un client mobile

Créez une application compagnon Flutter pour votre service Nim, à partir d'une spécification via le chat.

Nim est un très bon choix quand vous voulez du code qui se lit comme un langage de haut niveau mais qui s’expédie comme un exécutable natif rapide. Il récompense les équipes qui tiennent à la performance, à la simplicité du déploiement et au contrôle des dépendances.

Bonnes adéquations

Nim excelle souvent pour des logiciels « produit » — des choses que vous compilez, testez et distribuez :

- CLIs et outils dev : livrez un binaire natif, démarrez vite, gardez un faible overhead de démarrage.

- Outils et services réseau : bon débit et latence prévisible, tout en gardant le code lisible.

- Outils et pipelines pour jeux : convertisseurs d’assets, outils de build, éditeurs et automatisation où la vitesse compte sans la complexité C/C++.

Cas où la prudence est de mise

Nim peut être moins adapté quand le succès dépend davantage du dynamisme à l’exécution que de la performance compilée :

- systèmes de plugins très dynamiques : si vous chargez/déchargez beaucoup d’extensions tierces à chaud, le modèle compilé de Nim peut ajouter de la friction.

- scripts rapides et ponctuels : pour des workflows « éditer, exécuter immédiatement, jeter », Python (ou un script shell) peut être plus rapide pour de petites tâches.

Considérations d’équipe

Nim est abordable, mais il a une courbe d’apprentissage :

- Convenir tôt de conventions de style (layout des modules, gestion des erreurs, nommage) pour éviter que « chacun code Nim à sa façon ».

- Prévoir un onboarding : du pair programming et un petit guide interne valent souvent mieux que de longs docs.

- Être réaliste sur l’écosystème : certaines bibliothèques existent, mais vous ne trouverez pas forcément un paquet pour tout comme en Python.

Approche projet pilote

Choisissez un petit projet mesurable — réécrire une étape de CLI lente ou un utilitaire réseau. Définissez des métriques de succès (temps d’exécution, mémoire, temps de build, taille du déploiement), livrez à un petit public interne et décidez sur la base des résultats plutôt que du battage médiatique.

Si votre travail Nim nécessite une surface produit autour (dashboard admin, runner de benchmarks, gateway API), des outils comme Koder.ai peuvent aider à bâcler ces pièces rapidement. Vous pouvez coder une UI React et un backend Go + PostgreSQL, puis intégrer votre binaire Nim comme service HTTP, gardant le cœur critique en Nim tout en accélérant le reste.

Checklist pratique pour obtenir du code Python-like à la vitesse du C

Nim gagne sa réputation « Python-like mais rapide » en combinant syntaxe lisible, compilateur optimisant, gestion mémoire prévisible (ARC/ORC) et une culture d’attention au layout des données et aux allocations. Si vous voulez les bénéfices de vitesse sans transformer la base en spaghetti bas niveau, suivez cette checklist.

- Compilez sérieusement : utilisez un build release pour des mesures réalistes.

- Commencez par

-d:release et envisagez --opt:speed.

- Activez les LTO quand pertinent (

--passC:-flto --passL:-flto).

- Choisissez les structures de données consciemment : préférez des représentations simples et contiguës.

seq[T] est pratique, mais les boucles serrées bénéficient souvent d’array, openArray et d’éviter les redimensionnements inutiles.- Gardez les données chaudes petites et proches ; moins de pointeurs = moins de cache misses.

- Soyez conscient des allocations : ARC/ORC aide, mais il ne supprime pas le travail que vous créez.

- Réutilisez les buffers, préallouez (

newSeqOfCap) et évitez de construire des chaînes temporaires en boucle.

- Surveillez les copies cachées lors du slicing ou de la concaténation.

- Laissez les abstractions se compiler : écrivez du code propre, puis vérifiez-le.

- Préférez itérateurs/templates pour l’expressivité, mais confirmez qu’ils s’inlinent en build release.

- Mesurez avant d’optimiser : profilez pour trouver les vrais hotspots.

- Si vous débutez en profilage, voir /blog/performance-profiling-basics.

Prochaines étapes : prouver sur votre machine

- Essayez un petit benchmark : prenez une fonction qui fait du vrai travail (parsing, filtrage, calcul) et comparez debug vs release.

- Livrez une vraie fonctionnalité : implémentez un module de bout en bout, puis optimisez seulement le chemin chaud (pas toute la base de code).

Si vous hésitez encore entre langages, /blog/nim-vs-python peut aider à cadrer les compromis. Pour les équipes évaluant outils ou support, vous pouvez aussi consulter /pricing.