Pourquoi le choix du runtime a façonné le backend JavaScript

Un runtime JavaScript est plus qu’un moyen d’exécuter du code. C’est un ensemble de décisions concernant les caractéristiques de performance, les API intégrées, les valeurs par défaut de sécurité, le packaging et la distribution, et les outils quotidiens auxquels les développeurs s’appuient. Ces décisions déterminent ce que ressent le développement backend JavaScript : comment vous structurez les services, comment vous déboguez les incidents en production, et à quel point vous pouvez livrer avec confiance.

Les runtimes influencent le travail, pas seulement la vitesse

La performance est la partie évidente — comment un serveur gère efficacement l’I/O, la concurrence et les tâches CPU-intensives. Mais les runtimes décident aussi de ce que vous obtenez “gratuitement”. Avez-vous une manière standard d’aller chercher des URLs, lire des fichiers, démarrer des serveurs, exécuter des tests, linter le code ou bundler une app ? Ou assemblez-vous ces pièces vous‑même ?

Même quand deux runtimes exécutent un JavaScript similaire, l’expérience développeur peut être radicalement différente. Le packaging compte aussi : systèmes de modules, résolution de dépendances, lockfiles et façon dont les bibliothèques sont publiées affectent la fiabilité des builds et le risque sécuritaire. Les choix d’outillage influencent le temps d’onboarding et le coût de maintenance de nombreux services sur des années.

Des décisions et des compromis — pas de l’idolâtrie

On raconte souvent cette histoire autour de personnes, mais il est plus utile de se concentrer sur les contraintes et les compromis. Node.js et Deno représentent des réponses différentes aux mêmes questions pratiques : comment exécuter JavaScript hors du navigateur, comment gérer les dépendances, et comment équilibrer flexibilité, sécurité et cohérence.

Vous verrez pourquoi certains choix initiaux de Node.js ont débloqué un immense écosystème — et ce que cet écosystème a exigé en retour. Vous verrez aussi ce que Deno a tenté de changer, et quelles nouvelles contraintes accompagnent ces changements.

Ce que vous apprendrez, et pour qui c’est écrit

Cet article couvre :

- Les origines de Node.js et pourquoi son modèle événementiel était important pour le backend

- Les effets d’écosystème provoqués par npm, et comment ils ont façonné les workflows et les risques

- Les objectifs de Deno (sécurité, ergonomie TypeScript-first, etc.)

- Comment ces différences de runtime se manifestent dans le quotidien de livraison et de maintenance

Il s’adresse aux développeurs, tech leads et équipes qui choisissent un runtime pour de nouveaux services — ou qui maintiennent du code Node.js existant et évaluent si Deno peut convenir à une partie de leur stack.

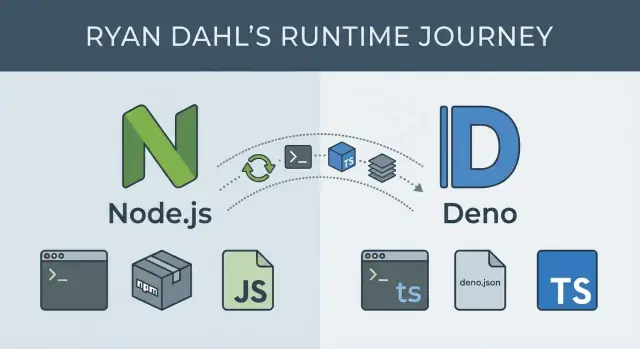

Ryan Dahl en contexte : deux runtimes, deux ensembles d’objectifs

Ryan Dahl est surtout connu pour avoir créé Node.js (publié en 2009) puis lancé Deno (annoncé en 2018). Ensemble, ces deux projets forment une sorte de registre public de l’évolution du backend JavaScript — et montrent comment les priorités changent quand l’usage réel révèle des compromis.

Node.js : rendre JavaScript viable côté serveur

À l’arrivée de Node.js, le développement serveur était dominé par des modèles thread-per-request qui peinaient sous de nombreuses connexions concurrentes. L’objectif initial de Dahl était simple : rendre pratique la construction de serveurs réseau lourds en I/O en JavaScript, en associant le moteur V8 de Google à une approche événementielle et à de l’I/O non bloquante.

Les objectifs de Node étaient pragmatiques : livrer vite, garder le runtime petit et laisser la communauté combler les manques. Cette approche a permis à Node de se répandre rapidement, mais elle a aussi posé des patterns difficiles à changer par la suite — notamment autour de la culture des dépendances et des valeurs par défaut.

Deno : revisiter les hypothèses après une décennie d’enseignements

Près de dix ans plus tard, Dahl a présenté les “10 choses que je regrette à propos de Node.js”, mettant en lumière des problèmes qu’il estimait inscrits dans le design initial. Deno est ce “second jet” façonné par ces regrets, avec des valeurs par défaut plus claires et une expérience développeur plus opinionnée.

Plutôt que de maximiser d’abord la flexibilité, Deno vise une exécution plus sûre, un support moderne du langage (TypeScript) et un outillage intégré pour que les équipes aient besoin de moins de briques tierces pour démarrer.

Le thème commun aux deux runtimes n’est pas qu’un des deux ait “raison” — c’est que les contraintes, l’adoption et le recul peuvent pousser la même personne à optimiser pour des résultats très différents.

Fondamentaux de Node.js : boucle d’événements, I/O non bloquante, impact réel

Node.js exécute du JavaScript sur un serveur, mais l’idée centrale porte moins sur le “JavaScript partout” que sur la manière dont il gère l’attente.

La boucle d’événements, en clair

La plupart du travail backend consiste à attendre : une requête base de données, une lecture de fichier, un appel réseau vers un autre service. Dans Node.js, la boucle d’événements est comme un coordinateur qui suit ces tâches. Quand votre code lance une opération longue (comme une requête HTTP), Node délègue ce travail d’attente au système, puis passe immédiatement à autre chose.

Quand le résultat est prêt, la boucle d’événements place un callback dans la file (ou résout une Promise) pour que votre JavaScript puisse reprendre avec la réponse.

I/O non bloquante et concurrence “single-threaded”

Le JavaScript de Node s’exécute dans un thread principal unique, ce qui signifie qu’une seule portion de JS s’exécute à la fois. Ça paraît limitant jusqu’à ce qu’on réalise que le design évite de faire des « attentes » dans ce thread.

L’I/O non bloquante permet au serveur d’accepter de nouvelles requêtes pendant que d’autres attendent toujours la base de données ou le réseau. La concurrence s’obtient en :

- laissant l’OS gérer de nombreuses opérations d’I/O en parallèle

- utilisant la boucle d’événements pour reprendre la bonne requête quand son I/O est terminée

C’est pourquoi Node peut paraître « rapide » sous de nombreuses connexions simultanées, même si votre JS ne s’exécute pas en parallèle dans le thread principal.

Implications pratiques : travaux CPU-bound et déchargement

Node excelle quand la majorité du temps est passée à attendre. Il montre ses limites quand l’application effectue beaucoup de calculs (traitement d’images, cryptographie à grande échelle, grosses transformations JSON), car le travail CPU bloque le thread unique et retarde tout.

Options typiques :

- Worker threads pour les tâches CPU-intensives devant rester in-process

- Externaliser le calcul vers des services séparés (queues, workers dédiés)

- Utiliser des modules natifs ou des outils externes quand c’est pertinent

Où Node.js est généralement un excellent choix

Node brille souvent pour les APIs et backend-for-frontend, les proxys et gateways, les applications temps réel (WebSockets) et les CLI orientées développeur où le démarrage rapide et l’écosystème riche comptent.

Ce que Node.js a optimisé — et ce qu’il a compromis

Node.js a été conçu pour rendre JavaScript pratique côté serveur, surtout pour des applications passant beaucoup de temps en attente réseau : requêtes HTTP, bases de données, lectures de fichiers et APIs. Son pari central était que la débit et la réactivité importent plus que « un thread par requête ».

Le design central : V8 + libuv + une librairie standard réduite

Node assemble le moteur V8 (exécution JavaScript rapide) avec libuv, une bibliothèque C qui gère la boucle d’événements et l’I/O non bloquante sur différents OS. Cette combinaison a permis à Node de rester mono-process et événementiel tout en offrant de bonnes performances sous de nombreuses connexions.

Node a aussi livré des modules cœur pragmatiques — notamment http, fs, net, crypto et stream — permettant de construire de vrais serveurs sans attendre des paquets tiers.

Compromis : une librairie standard réduite a gardé Node léger, mais elle a aussi poussé les développeurs vers des dépendances externes plus tôt que dans d’autres écosystèmes.

Des callbacks à async/await : puissance avec quelques cicatrices

Node utilisait massivement les callbacks pour exprimer « faire ceci quand l’I/O est terminée ». C’était naturel pour de l’I/O non bloquante, mais cela menait à du code imbriqué et à des schémas de gestion d’erreurs confus.

Avec le temps, l’écosystème a basculé vers les Promises, puis async/await, rendant le code plus lisible tout en conservant le comportement non bloquant.

Compromis : la plateforme a dû supporter plusieurs générations de patterns, et tutoriels, bibliothèques et bases de code d’équipe mélangent souvent les styles.

Compatibilité ascendante : stabilité qui ralentit les grandes refontes

L’engagement de Node à la compatibilité ascendante a rendu la plateforme sûre pour les entreprises : les mises à jour cassent rarement tout du jour au lendemain, et les API cœur restent stables.

Compromis : cette stabilité peut retarder ou compliquer des améliorations radicales. Certaines incohérences et API héritées subsistent parce que les supprimer nuirait à des applications existantes.

Addons natifs : portée écosystémique étendue, complexité en plus

La capacité de Node à appeler des bindings C/C++ a permis des bibliothèques performantes et l’accès à des fonctionnalités système via des native addons.

Compromis : les addons natifs introduisent des étapes de build spécifiques à la plateforme, des échecs d’installation difficiles et des charges de mise à jour/sécurité — surtout quand les dépendances se compilent différemment selon les environnements.

Globalement, Node a optimisé la livraison rapide de services réseau et la gestion efficace de l’I/O — tout en acceptant la complexité liée à la compatibilité, à la culture des dépendances et à l’évolution des API sur le long terme.

npm et l’écosystème Node : puissance, complexité et risques

npm est une grande raison de la diffusion rapide de Node.js. Il a transformé « j’ai besoin d’un serveur web + logging + driver BD » en quelques commandes, avec des millions de paquets prêts à brancher. Pour les équipes, cela signifiait des prototypes plus rapides, des solutions partagées et une langue commune de réutilisation.

Pourquoi npm a rendu Node productif

npm a abaissé le coût de construction de backends en standardisant l’installation et la publication de code. Besoin d’une validation JSON, d’un helper date ou d’un client HTTP ? Il existe probablement un paquet — avec exemples, issues et savoir communautaire. Cela accélère la livraison, surtout quand il faut assembler de nombreuses petites fonctionnalités rapidement.

Arbres de dépendances : où commence la douleur

Le compromis est qu’une dépendance directe peut tirer des dizaines (ou centaines) de dépendances indirectes. Avec le temps, les équipes rencontrent souvent :

- Taille et duplication : plusieurs versions d’une même librairie sont installées parce que des paquets exigent des plages différentes.

- Traînée opérationnelle : les installations ralentissent, les caches CI grossissent, et le « ça marche sur ma machine » se produit plus souvent.

- Risque supply-chain : plus votre arbre est grand, plus vous dépendez de mainteneurs inconnus — et plus le vecteur est attractif pour les prises de contrôle de comptes ou les mises à jour malveillantes.

SemVer : attentes vs réalité

Semantic Versioning (SemVer) rassure en théorie : les patches sont sûrs, les mineures ajoutent des fonctionnalités sans casser, et les majeures peuvent casser. En pratique, les grands graphes de dépendances mettent cette promesse à l’épreuve.

Des mainteneurs peuvent publier des changements cassants dans des versions mineures, des paquets peuvent être abandonnés, ou une mise à jour “sûre” peut altérer le comportement via une dépendance transitive. Quand vous mettez à jour une chose, vous en mettez souvent beaucoup d’autres.

Garde-fous pratiques qui fonctionnent

Quelques habitudes réduisent le risque sans ralentir le développement :

- Utiliser des lockfiles (

package-lock.json, npm-shrinkwrap.json ou yarn.lock) et les committer.

- Verrouiller ou restreindre les dépendances critiques, surtout celles sensibles à la sécurité.

- Auditer régulièrement :

npm audit est basique ; envisagez des revues régulières.

- Préférer moins de paquets bien connus plutôt que beaucoup de micro-paquets ; supprimer les dépendances non utilisées.

- Automatiser les mises à jour prudemment (par ex. PR groupées avec tests obligatoires avant merge).

npm est à la fois un accélérateur et une responsabilité : il rend la construction rapide, et fait de l’hygiène des dépendances une part réelle du travail backend.

Outillage et workflows dans Node : flexibilité avec configuration supplémentaire

Construisez la stack complète

Créez une app web React, un backend Go et PostgreSQL dans un seul workflow.

Node.js est célèbre pour son absence d’opinions. C’est une force — les équipes assemblent exactement le workflow qu’elles souhaitent — mais cela signifie aussi qu’un projet Node “typique” est une convention forgée par les habitudes communautaires.

La plupart des dépôts Node se centrent autour d’un fichier package.json avec des scripts qui agissent comme un panneau de contrôle :

dev / start pour lancer l’appbuild pour compiler ou bundler (si nécessaire)test pour exécuter le test runnerlint et format pour appliquer le style- parfois

typecheck lorsqu’on utilise TypeScript

Ce pattern fonctionne bien parce que chaque outil peut s’y brancher, et les systèmes CI/CD peuvent exécuter les mêmes commandes.

Les couches d’outillage que vous empilez souvent

Un workflow Node devient fréquemment un ensemble d’outils séparés, chacun résolvant une problématique :

- Transpileurs (compilateur TypeScript, Babel) pour transformer une syntaxe moderne

- Bundlers (Webpack, Rollup, esbuild, Vite) pour empaqueter le code

- Linters/formatters (ESLint, Prettier) pour la cohérence

- Test runners (Jest, Mocha, Vitest) plus bibliothèques d’assertion et de mock

Aucun de ces choix n’est « mauvais » — ils sont puissants, mais vous assemblez une chaîne d’outils, pas seulement du code applicatif.

Où la friction apparaît

Parce que les outils évoluent indépendamment, les projets Node rencontrent des accrocs pratiques :

- Prolifération de configurations : plusieurs fichiers de config (ou options imbriquées) à apprendre pour un nouveau venu

- Incompatibilités de versions : un plugin attend une autre major du linter, bundler ou TypeScript

- Dérive d’environnement : les versions locales de Node diffèrent de CI ou prod, provoquant des bugs “ça marche chez moi”

Avec le temps, ces points douloureux ont influencé les runtimes plus récents — notamment Deno — pour livrer davantage de valeurs par défaut (formatter, linter, test runner, support TypeScript) afin que les équipes commencent avec moins de pièces mobiles et n’ajoutent de complexité que lorsque c’est clairement justifié.

Pourquoi Deno a été créé : revisiter des hypothèses antérieures

Deno a été créé comme une seconde tentative de runtime JavaScript/TypeScript — une tentative qui reconsidère certaines décisions initiales de Node après des années d’usage réel.

Ryan Dahl a publiquement réfléchi à ce qu’il changerait en repartant de zéro : la friction causée par les arbres de dépendances complexes, l’absence d’un modèle de sécurité natif, et la nature « bolt-on » des commodités développeur devenues essentielles. Les motivations de Deno se résument à : simplifier le workflow par défaut, faire de la sécurité une partie explicite du runtime, et moderniser la plateforme autour des standards et de TypeScript.

« Sécurisé par défaut » en pratique

Dans Node.js, un script peut généralement accéder au réseau, au système de fichiers et aux variables d’environnement sans autorisation. Deno inverse cette valeur par défaut. Par défaut, un programme Deno s’exécute sans aucune permission pour les capacités sensibles.

Au quotidien, cela signifie que vous accordez des permissions intentionnellement au moment de l’exécution :

- Autoriser la lecture d’un répertoire :

--allow-read=./data

- Autoriser les appels réseau vers un hôte :

--allow-net=api.example.com

- Autoriser les variables d’environnement :

--allow-env

Cela change les habitudes : vous réfléchissez à ce que votre programme doit pouvoir faire, vous maintenez des permissions strictes en production et vous obtenez un signal clair lorsqu’un code tente une action inattendue. Ce n’est pas une solution de sécurité complète (la revue de code et l’hygiène de la supply chain restent nécessaires), mais c’est une façon d’encourager le principe du moindre privilège.

Imports par URL et mentalité différente sur les dépendances

Deno supporte l’import de modules via des URLs, ce qui change la manière de penser les dépendances. Au lieu d’installer des paquets dans un arbre node_modules, vous pouvez référencer du code directement :

import { serve } from "https://deno.land/std/http/server.ts";

Ceci pousse les équipes à être plus explicites sur d’où provient le code et quelle version est utilisée (souvent en épinglant les URLs). Deno met également en cache les modules distants, donc vous ne les retéléchargez pas à chaque exécution — mais vous avez toujours besoin d’une stratégie claire pour le versioning et les mises à jour, similaire à la gestion des paquets npm.

Une alternative, pas un remplacement universel

Deno n’est pas « Node.js, mais meilleur pour tous les projets ». C’est un runtime avec des valeurs par défaut différentes. Node reste un bon choix quand vous dépendez de l’écosystème npm, d’une infrastructure établie ou de patterns éprouvés.

Deno est séduisant quand vous privilégiez un outillage intégré, un modèle de permissions, et une approche ESM/URL plus standardisée — surtout pour des services neufs où ces hypothèses conviennent dès le départ.

Modèle de sécurité : permissions Deno vs comportements par défaut de Node

Choisissez Node ou Deno en connaissance de cause

Utilisez le mode Planification pour cartographier les endpoints, les données et les tâches avant d'écrire quoi que ce soit.

Une différence clé entre Deno et Node.js est ce qu’un programme est autorisé à faire “par défaut”. Node suppose que si vous pouvez lancer le script, il peut accéder à tout ce que votre compte utilisateur peut atteindre : réseau, fichiers, variables d’environnement, etc. Deno inverse cette hypothèse : les scripts démarrent sans aucune permission et doivent demander explicitement l’accès.

Le modèle de permissions de Deno, en clair

Deno considère les capacités sensibles comme des fonctionnalités verrouillées. Vous les accordez à l’exécution (et vous pouvez les restreindre) :

- Network (

--allow-net) : Permet les requêtes HTTP ou l’ouverture de sockets. Vous pouvez le restreindre à des hôtes spécifiques (par ex. api.example.com).

- Filesystem (

--allow-read, --allow-write) : Permet de lire ou écrire des fichiers. Vous pouvez limiter cela à certains dossiers (comme ./data).

- Environment (

--allow-env) : Permet la lecture de secrets et configs depuis les variables d’environnement.

Cela réduit le « rayon d’impact » d’une dépendance ou d’un bout de code copié, puisqu’il ne peut pas automatiquement accéder à des ressources sensibles.

Valeurs par défaut plus sûres : scripts et petits services

Pour des scripts ponctuels, les valeurs par défaut de Deno réduisent les expositions accidentelles. Un script de parsing CSV peut s’exécuter avec --allow-read=./input et rien d’autre — donc même si une dépendance est compromise, elle ne peut pas « phoner home » sans --allow-net.

Pour de petits services, vous pouvez être explicite sur ce dont le service a besoin. Un listener de webhook pourrait obtenir --allow-net=:8080,api.payment.com et --allow-env=PAYMENT_TOKEN, mais pas d’accès au système de fichiers, rendant l’exfiltration de données plus difficile en cas de problème.

Le compromis : commodité vs accès explicite

L’approche de Node est pratique : moins de flags, moins de moments « pourquoi ça échoue ? ». L’approche Deno ajoute de la friction — surtout au début — car vous devez décider et déclarer ce que le programme est autorisé à faire.

Cette friction peut devenir une fonctionnalité : elle force les équipes à documenter l’intention. Mais elle implique aussi plus de configuration et du debug occasionnel quand une permission manquante bloque une lecture ou une requête.

Intégrer les permissions dans le CI et la revue de code

Les équipes peuvent traiter les permissions comme un contrat de l’application :

- Committer la commande exacte d’exécution (ou la tâche) incluant les permissions, pour réduire les problèmes “ça marche chez moi”.

- Revoir les changements de permissions comme des changements d’API : si une PR ajoute

--allow-env ou élargit --allow-read, demandez pourquoi.

- Checks CI : exécuter les tests avec les permissions minimales, et échouer si un test requiert un accès inattendu.

Utilisées de façon cohérente, les permissions Deno deviennent une checklist de sécurité légère qui vit proche de la manière dont vous lancez le code.

TypeScript et outils intégrés : différences de workflow avec Deno

Deno considère TypeScript comme une citoyenneté de première classe. Vous pouvez exécuter directement un fichier .ts, et Deno gère la compilation en arrière-plan. Pour beaucoup d’équipes, cela change la « forme » d’un projet : moins de décisions de setup, moins de pièces mobiles et un chemin plus direct d’un nouveau repo au code fonctionnel.

TypeScript first : ce que ça change

Avec Deno, TypeScript n’est pas un ajout optionnel nécessitant une chaîne de build séparée dès le premier jour. Vous ne commencez pas forcément par choisir un bundler, câbler tsc, et configurer plusieurs scripts juste pour exécuter du code localement.

Cela ne signifie pas que les types disparaissent — ils restent importants. Cela signifie plutôt que le runtime prend en charge des points de friction courants (exécution, cache du code compilé, alignement du comportement runtime avec la vérification de types) pour que les projets se standardisent plus vite.

Outils intégrés : moins de choix, plus de cohérence

Deno inclut des outils couvrant les besoins basiques que la plupart des équipes adoptent immédiatement :

- Formatter (

deno fmt) pour un style de code cohérent

- Linter (

deno lint) pour des vérifications de qualité et de correction

- Test runner (

deno test) pour tests unitaires et d’intégration

Parce que ces outils sont intégrés, une équipe peut adopter des conventions partagées sans débattre « Prettier vs X » ou « Jest vs Y » au départ. La configuration se centralise typiquement dans deno.json, ce qui aide à garder les projets prévisibles.

Par rapport à Node : flexibilité avec montage d’outils

Les projets Node peuvent évidemment supporter TypeScript et de bons outils — mais vous assemblez généralement le workflow vous‑même : typescript, ts-node ou étapes de build, ESLint, Prettier et un framework de tests. Cette flexibilité est précieuse, mais elle peut mener à des setups inconsistants entre dépôts.

Points d’intégration : support éditeur et conventions

Le language server et les intégrations éditeur de Deno visent à rendre le formatage, le linting et le feedback TypeScript uniformes sur les machines. Quand tout le monde exécute les mêmes commandes intégrées, les problèmes “ça marche chez moi” diminuent — notamment pour le formatage et les règles de lint.

Modules et gestion des dépendances : différentes voies vers la mise en production

La façon dont vous importez du code affecte tout ce qui suit : structure de dossiers, outillage, publication et rapidité de revue.

Node.js : CommonJS d’abord, ESM ensuite

Node a grandi avec CommonJS (require, module.exports). C’est simple et adapté aux premiers paquets npm, mais ce n’est pas le même système que celui standardisé par les navigateurs.

Node supporte désormais ES modules (ESM) (import/export), mais de nombreux projets vivent dans un monde mixte : certains paquets sont CJS-only, d’autres ESM-only, et les apps parfois ont besoin d’adaptateurs. Cela se traduit par des flags de build, des extensions de fichiers (.mjs/.cjs) ou des réglages dans package.json ("type": "module").

Le modèle de dépendance est typiquement basé sur les importations par nom de paquet résolues via node_modules, avec le versioning contrôlé par un lockfile. C’est puissant, mais cela rend l’étape d’installation et l’arbre de dépendances parties intégrantes du debug quotidien.

Deno : ESM-first avec imports style URL

Deno est parti du postulat que l’ESM est la norme. Les imports sont explicites et ressemblent souvent à des URLs ou des chemins absolus, ce qui rend plus clair d’où provient le code et réduit la « résolution magique ».

Pour les équipes, le changement majeur est que les décisions de dépendance sont plus visibles dans les revues de code : une ligne d’import indique souvent la source exacte et la version.

Import maps : rendre les imports lisibles et stables

Les import maps permettent de définir des alias comme @lib/ ou d’épingler une URL longue à un nom court. Les équipes les utilisent pour :

- éviter de répéter des URLs versionnées partout

- centraliser les upgrades (changer la map une seule fois)

- garder des frontières de modules internes propres

Elles sont particulièrement utiles dans les bases de code avec de nombreux modules partagés ou quand on veut des noms cohérents entre apps et scripts.

Packaging et distribution : librairies vs apps vs scripts

Dans Node, les librairies sont publiées sur npm ; les apps sont déployées avec leur node_modules (ou bundlées) ; les scripts reposent souvent sur une installation locale.

Deno rend les scripts et petits outils plus légers (exécution directe avec imports), tandis que les librairies insistent sur la compatibilité ESM et des points d’entrée clairs.

Un guide de décision simple

Si vous maintenez une base Node legacy, restez sur Node et migrez vers ESM progressivement là où cela réduit la friction.

Pour un nouveau projet, choisissez Deno si vous voulez une structure ESM-first et le contrôle par import-map dès le départ ; choisissez Node si vous dépendez fortement de paquets npm matures et d’un outillage Node éprouvé.

Choisir Node.js vs Deno : checklist pratique pour les équipes

Créez un backend via le chat

Transformez une idée de backend en service fonctionnel en discutant avec Koder.ai.

Choisir un runtime n’est pas une question de « meilleur » mais d’adéquation. Le moyen le plus rapide de décider est de s’accorder sur ce que votre équipe doit livrer dans les 3–12 prochains mois : où ça tourne, de quelles bibliothèques vous dépendez, et quel changement opérationnel vous pouvez absorber.

Checklist de décision rapide

Posez ces questions dans l’ordre :

- Expérience de l’équipe : Avez-vous déjà des compétences Node.js fortes et des patterns établis (frameworks, tests, templates CI) ? Si oui, switcher a un coût réel.

- Cible de déploiement : Déployez-vous sur serverless, containers, runtimes edge ou serveurs on‑prem ? Vérifiez le support natif et la parité local→prod.

- Besoins d’écosystème : Dépend‑vous de paquets spécifiques (ORMs, SDKs auth, agents observabilité, intégrations enterprise) ? Vérifiez leur maturité et maintenance.

- Posture sécurité : Avez-vous besoin de garde‑fous forts pour les scripts et services accédant aux fichiers, réseau et variables d’environnement ?

- Attentes d’outillage : Préférez-vous « apporter vos outils » ou un runtime qui livre davantage d’outils intégrés (formatage, linting, tests) pour réduire la dérive de setup ?

- Contraintes opérationnelles : Quels workflows de monitoring, debug et incident response utilisez-vous déjà ? Changer de runtime peut modifier la façon dont vous diagnostiquez les problèmes.

Si vous évaluez des runtimes tout en compressant le temps de livraison, séparez le choix du runtime de l’effort d’implémentation. Par exemple, des plateformes peuvent permettre de prototyper et livrer plus vite via des workflows guidés, facilitant un pilote Node vs Deno sans engager des semaines de scaffolding.

Scénarios courants où Node est le choix sûr

Node gagne quand vous avez des services Node existants, besoin de bibliothèques et intégrations matures, ou quand il faut suivre un playbook de production connu. C’est aussi un bon choix pour accélérer le recrutement et l’onboarding, car beaucoup de développeurs ont déjà de l’exposition.

Scénarios courants où Deno est pertinent

Deno convient souvent aux scripts d’automatisation sécurisés, outils internes et nouveaux services où vous voulez un développement TypeScript-first et une toolchain intégrée avec peu de dépendances tierces.

Réduire le risque avec un petit pilote

Au lieu d’une réécriture massive, choisissez un cas d’usage limité (un worker, un handler de webhook, une tâche planifiée). Définissez les critères de succès à l’avance — temps de build, taux d’erreur, cold-start, effort de revue sécurité — et limitez le pilote dans le temps. S’il réussit, vous aurez un template réplicable.

Adoption et migration : minimiser le risque en modernisant les workflows

La migration est rarement un big-bang. La plupart des équipes adoptent Deno par tranches — là où le gain est clair et le rayon d’impact faible.

À quoi ressemble l’adoption en pratique

Les points de départ courants sont l’outillage interne (scripts de release, automatisation de dépôts), utilitaires CLI et services edge (APIs légères proches des utilisateurs). Ces zones ont moins de dépendances, des frontières plus nettes et des profils de performance simples.

En production, l’adoption partielle est normale : garder l’API centrale sur Node.js tout en introduisant Deno pour un nouveau service, un handler de webhook ou un job planifié. Avec le temps, vous apprenez ce qui colle sans forcer une migration organisationnelle complète.

Vérifications de compatibilité à faire tôt

Avant de vous engager, validez :

- Librairies : Dépend‑vous de paquets Node-only, d’addons natifs ou d’outils npm profonds ?

- APIs runtime : Les globals et modules Node ne correspondent pas toujours 1:1 à Deno (et inversement).

- Plateforme de déploiement : Certains hébergeurs supposent des conventions Node ; confirmez le support Deno, containers ou runtimes edge.

- Observabilité : Logging, tracing et reporting d’erreurs doivent fonctionner de manière cohérente entre services.

Approche par phases pour réduire le risque

Commencez par l’une des voies :

- Construisez un CLI Deno qui lit/écrit des fichiers et appelle des APIs internes.

- Déployez un service isolé avec un contrat étroit (un endpoint, un consumer de queue).

- Ajoutez des conventions partagées : formatage, linting, politiques de dépendances et revues sécurité.

Conclusion

Les choix de runtime ne changent pas seulement la syntaxe — ils façonnent les habitudes de sécurité, les attentes d’outillage, les profils de recrutement et la façon dont votre équipe maintient les systèmes sur le long terme. Traitez l’adoption comme une évolution de workflow, pas comme un projet de réécriture.