Ce que signifie « itération » — et où l’IA intervient

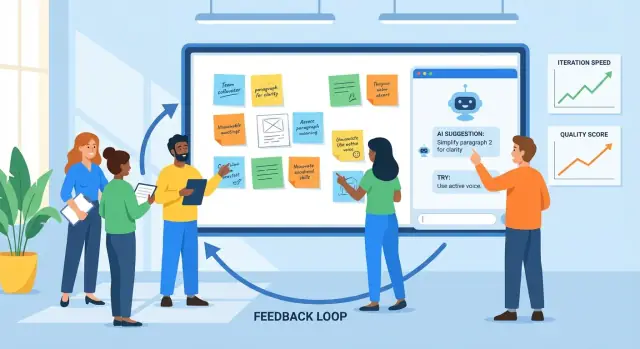

L’itération consiste à créer quelque chose, recueillir des retours, l’améliorer, puis répéter le cycle. On la retrouve en conception produit (livrer une fonctionnalité, observer l’usage, affiner), en marketing (tester un message, apprendre, réécrire) et en rédaction (brouillon, relecture, édition).

Le feedback est tout signal qui vous dit ce qui marche ou non : commentaires utilisateurs, tickets de support, rapports de bugs, réponses d’enquête, métriques de performance, notes des parties prenantes — même votre impression après avoir utilisé le produit vous‑même. L’amélioration est ce que vous modifiez à partir de ces signaux, d’ajustements mineurs à des refontes plus importantes.

Pourquoi des cycles plus courts comptent

Des cycles de retour plus courts conduisent généralement à de meilleurs résultats pour deux raisons :

- La qualité s’améliore plus vite : vous détectez les malentendus et défauts tôt, avant qu’ils ne se propagent sur d’autres pages, écrans ou versions.

- La vitesse augmente sans deviner : vous passez moins de temps à débattre en abstraction et plus de temps à apprendre à partir de preuves réelles.

Un bon rythme d’itération n’est pas « avancer vite et casser les choses ». C’est « avancer par petites étapes et apprendre rapidement ».

Où l’IA aide (et où elle n’aide pas)

L’IA est utile dans la boucle quand il y a beaucoup d’informations et que vous avez besoin d’aide pour les traiter. Elle peut :

- résumer les retours provenant de multiples sources en thèmes

- repérer les plaintes récurrentes, les formulations confuses ou les détails manquants

- proposer des versions alternatives (textes, mises en page, formulations de tâches) à considérer

- servir de seconde paire d’yeux pour la clarté, le ton et la cohérence

Mais l’IA ne peut pas remplacer les décisions centrales. Elle ne connaît pas vos objectifs business, vos contraintes juridiques, ni ce que « bon » signifie pour vos utilisateurs à moins que vous le définissiez. Elle peut proposer en toute confiance des modifications hors‑marque, risquées ou basées sur de mauvaises hypothèses.

Fixez des attentes claires : l’IA soutient le jugement. Votre équipe choisit toujours ce qu’il faut prioriser, ce qu’il faut changer, ce que signifie le succès — et valide les améliorations avec de vrais utilisateurs et de vraies données.

La boucle de feedback basique : un modèle pratique

L’itération est plus simple quand tout le monde suit la même boucle et sait ce que signifie « terminé ». Un modèle pratique :

brouillon → retours → révision → vérification → publication

Les équipes se bloquent souvent parce qu’une étape est lente (relectures), désordonnée (retours dispersés entre outils) ou ambiguë (quoi modifier exactement ?). Utilisée délibérément, l’IA peut réduire les frictions à chaque étape.

Étape 1 : Brouillon (arriver à quelque chose de relisable)

L’objectif n’est pas la perfection ; c’est une première version solide sur laquelle les autres peuvent réagir. Un assistant IA peut vous aider à structurer, générer des alternatives ou combler des lacunes pour atteindre plus vite un état « relisable ».

Où ça aide le plus : transformer un brief approximatif en un brouillon structuré, et produire plusieurs options (par exemple trois titres, deux parcours d’onboarding) à comparer.

Étape 2 : Retours (capturer et condenser)

Les retours arrivent souvent sous forme de longs commentaires, fils de discussion, notes d’appel et tickets de support. L’IA est utile pour :

- résumer les thèmes répétés (ce que les gens mentionnent sans cesse)

- regrouper les retours par sujet (tarification, onboarding, ton, bugs)

- extraire les questions et éléments « à corriger impérativement » vs. « agréables à avoir »

Le goulot que vous éliminez : la lecture lente et l’interprétation incohérente de ce que les relecteurs voulaient dire.

C’est là que les équipes perdent du temps en retouches : des retours flous conduisent à des edits qui ne satisfont pas le relecteur, et la boucle recommence. L’IA peut suggérer des modifications concrètes, proposer du texte révisé ou générer une seconde version qui traite explicitement les thèmes de retour prioritaires.

Étape 4 : Vérification (qualité avant publication)

Avant la mise en production, utilisez l’IA comme seconde paire d’yeux : la nouvelle version introduit‑elle des contradictions, des étapes manquantes, des exigences brisées ou un décalage de ton ? L’objectif n’est pas « approuver » le travail ; c’est attraper les problèmes évidents tôt.

Étape 5 : Publier avec une source unique de vérité

L’itération s’accélère quand les changements vivent à un seul endroit : un ticket, un doc ou une description de PR qui enregistre (1) le résumé des retours, (2) les décisions, et (3) ce qui a changé.

L’IA peut aider à maintenir cette « source unique de vérité » en rédigeant les notes de mise à jour et en alignant les critères d’acceptation sur les dernières décisions. Dans les équipes qui développent et publient directement (pas seulement des docs), des plateformes comme Koder peuvent aussi raccourcir cette étape en gardant planification, implémentation et déploiement étroitement connectés — ainsi le récit « ce qui a changé » reste proche de la version publiée.

Collecter les retours : ce que l’IA sait bien traiter

L’IA ne peut améliorer que ce que vous lui fournissez. La bonne nouvelle : la plupart des équipes disposent déjà de beaucoup de retours — simplement répartis et rédigés de façons différentes. Votre travail est de les collecter de façon cohérente pour que l’IA puisse les résumer, repérer des motifs et vous aider à décider quoi changer ensuite.

Entrées de retours qui fonctionnent particulièrement bien

L’IA est la plus forte avec des entrées textuelles désordonnées, notamment :

- commentaires utilisateurs (in‑app, forums, chat)

- tickets de support et transcriptions de chat

- réponses ouvertes d’enquêtes

- avis d’app store et places de marché

- notes d’appel ventes/CS et comptes rendus de réunion

- rapports de bugs et demandes de fonctionnalités internes

Vous n’avez pas besoin d’un format parfait. L’important est de capturer les mots originaux et un petit nombre de métadonnées (date, zone produit, plan, etc.).

De « tas de citations » à thèmes et points de douleur

Une fois collectés, l’IA peut regrouper les retours en thèmes — confusion sur la facturation, friction à l’onboarding, intégrations manquantes, lenteur — et montrer ce qui revient le plus. Cela compte parce que le commentaire le plus bruyant n’est pas toujours le problème le plus fréquent.

Une approche pratique consiste à demander à l’IA :

- une liste de thèmes avec étiquettes courtes

- des citations représentatives par thème (pour vérifier)

- des signaux de fréquence (par ex. « mentionné dans 18 tickets cette semaine »)

- des indices d’impact (qui est affecté et ce que cela bloque)

Conserver le contexte pour que les insights restent pertinents

Des retours sans contexte conduisent à des conclusions génériques. Joignez un contexte léger à chaque élément, par exemple :

- persona ou type de client (nouvel utilisateur, admin, utilisateur avancé)

- objectif de l’utilisateur (« exporter un rapport », « inviter des coéquipiers »)

- contraintes (appareil, région, niveau d’abonnement, besoins de conformité)

Même quelques champs cohérents rendent les regroupements et résumés de l’IA beaucoup plus exploitables.

Confidentialité et gestion des données : principes de base

Avant l’analyse, redactez les informations sensibles : noms, emails, numéros de téléphone, adresses, détails de paiement et tout élément confidentiel dans les notes d’appel. Privilégiez la minimisation des données — partagez uniquement ce qui est nécessaire pour la tâche — et stockez les exports bruts en sécurité. Si vous utilisez des outils tiers, confirmez la politique de votre équipe sur la rétention et l’entraînement, et restreignez l’accès au jeu de données.

Les retours bruts forment souvent un tas d’entrées hétérogènes : tickets, avis d’app, commentaires d’enquête, notes de vente et fils Slack. L’IA est utile parce qu’elle peut lire un langage « désordonné » à grande échelle et vous aider à le transformer en une courte liste de thèmes sur lesquels vous pouvez réellement travailler.

Commencez par fournir à l’IA un lot de retours (données sensibles supprimées) et demandez‑lui de regrouper les éléments en catégories cohérentes comme onboarding, performance, tarification, confusion UI, bugs et demandes de fonctionnalités. Le but n’est pas une taxonomie parfaite, mais une carte partagée utilisable par l’équipe.

Une sortie pratique ressemble à :

- Catégorie : Confusion à l’onboarding

- Ce que les utilisateurs tentent de faire : Connecter un compte, importer des données

- Obstacles observés : « Je n’ai pas trouvé le bouton d’import », « Je ne suis pas sûr que ça ait fonctionné »

2) Ajouter des priorités avec un rubriq simple

Une fois les retours regroupés, demandez à l’IA de proposer un score de priorité selon un rubriq que vous pourrez réviser :

- Impact : Quelle incidence sur le succès utilisateur ou le revenu ?

- Fréquence : À quelle fréquence cela apparaît‑il dans les sources ?

- Effort : Quelle difficulté à corriger (temps, dépendances) ?

- Risque : Probabilité de casse ou d’enjeux conformité/support ?

Vous pouvez garder ça léger (Haut/Moyen/Bas) ou numérique (1–5). L’important est que l’IA fasse une première passe et que les humains confirment les hypothèses.

3) Résumer sans effacer la raison (garder les preuves)

Les résumés deviennent dangereux quand ils effacent le « pourquoi ». Un modèle utile : résumé du thème + 2–4 citations représentatives. Par exemple :

« J’ai connecté Stripe mais rien n’a changé — est‑ce que ça a synchronisé ? »

« L’assistant d’installation a sauté une étape et je ne savais pas quoi faire ensuite. »

Les citations préservent le ton émotionnel et le contexte — et empêchent l’équipe de traiter chaque problème comme identique.

4) Surveiller les biais : bruyant ≠ fréquent

L’IA peut surpondérer le langage dramatique ou les commentateurs répétés si vous ne la guidez pas. Demandez‑lui de séparer :

- Signaux basés sur le volume (combien d’utilisateurs uniques le mentionnent)

- Signaux basés sur la gravité (à quel point c’est problématique quand ça arrive)

Puis confrontez aux données d’usage et à la segmentation. Une plainte de power users peut être très importante — ou refléter un workflow de niche. L’IA aide à voir les motifs, mais ne peut décider ce qui « représente vos utilisateurs » sans votre contexte.

Utiliser l’IA pour générer des versions, pas seulement « la réponse »

Faites de l'itération une habitude

Allez plus vite en équipe en centralisant décisions, builds et livraisons au même endroit.

Pensez à l’outil IA comme un générateur de versions. Au lieu de demander une unique « meilleure » réponse, demandez plusieurs brouillons plausibles à comparer, mixer et affiner. Cette approche vous garde maître des décisions et accélère l’itération.

C’est particulièrement puissant quand vous itérez sur des surfaces produit (parcours d’onboarding, microcopy UI, libellé des specs). Par exemple, si vous construisez un outil interne ou une application client simple avec Koder, vous pouvez utiliser le même mode « générer plusieurs versions » pour explorer écrans, parcours et exigences en mode Planification avant de vous engager — puis vous appuyer sur des snapshots et rollback pour maintenir la sécurité des changements rapides.

Donnez des contraintes pour que les variantes soient comparables

Si vous demandez « écris‑moi ça », vous obtiendrez souvent du générique. Mieux : définissez des limites pour que l’IA explore à l’intérieur de celles‑ci.

Essayez de préciser :

- Audience + intention : « Nouveaux utilisateurs décidant de s’inscrire » vs « Clients existants qui ont besoin d’être rassurés ».

- Ton : amical, direct, formel, ludique (choisissez un seul).

- Longueur : par ex. « 120–150 mots » ou « 3 puces max. ».

- Format : email, accroche de landing, FAQ, note de version.

- Faits à garder : prix, dates, garanties, limitations produit.

- À éviter : allégations interdites, formulations sensibles, mentions de concurrents.

Avec des contraintes, vous pouvez générer « Version A : concise », « Version B : plus empathique », « Version C : plus spécifique » sans perdre en précision.

Générer plusieurs options, puis choisir (ou combiner)

Demandez 3–5 alternatives en une seule requête et précisez les différences : « chaque version doit utiliser une structure et une accroche différente. » Cela crée un véritable contraste et vous aide à repérer ce qui manque et ce qui résonne.

Workflow pratique :

- Générer 3–5 versions.

- Choisir les meilleures parties (accroche de A, preuves de C, CTA de B).

- Demander à l’IA de les fusionner en un brouillon unique, en conservant les faits impératifs.

Checklist rapide : ce qu’un « bon brouillon » contient

Avant d’envoyer un brouillon en relecture ou en test, vérifiez qu’il comporte :

- un objectif clair (ce que le lecteur doit faire/comprendre)

- les faits clés préservés et cohérents

- une raison spécifique et crédible de s’en soucier (bénéfice + preuve)

- un appel à l’action principal

- un langage simple et peu de jargon

- aucune promesse non soutenue ni superlatif vague

Utilisée ainsi, l’IA n’élimine pas le jugement — elle accélère la recherche d’une version meilleure.

L’IA comme relecteur : détecter les problèmes tôt

Avant de publier un brouillon — spec produit, note de version, article d’aide ou page marketing — un outil IA peut agir comme un relecteur rapide « de première passe ». L’objectif n’est pas de remplacer le jugement humain ; c’est de faire remonter les problèmes évidents pour que l’équipe consacre son temps aux décisions difficiles, pas au nettoyage de base.

Ce que les relectures assistées par IA font bien

Les relectures IA sont particulièrement utiles pour :

- Clarté : repérer les phrases longues, termes ambigus ou manque de contexte pour un lecteur non initié.

- Cohérence : vérifier les noms (libellés de fonctionnalités, capitalisation), les affirmations répétées et les contradictions.

- Ton : aligner la voix sur l’audience (amical, direct, formel) et signaler les formulations défensives ou vagues.

- Exhaustivité : pointer les étapes manquantes, cas limites, prérequis ou lacunes « ce qu’il se passe ensuite ».

Prompts de relecture pratiques à réutiliser

Collez votre brouillon et demandez une critique ciblée. Par exemple :

- « Relis pour lacunes : quelles questions un utilisateur néophyte se poserait‑il encore ? »

- « Signale les hypothèses : sur quoi je base mes affirmations produit/utilisateur/workflow ? »

- « Simplifie : réécris toute phrase de plus de 25 mots en gardant le sens. »

- « Vérifie les incohérences : liste les termes utilisés différemment. »

Critiques par rôle pour élargir la perspective

Demandez au modèle d’examiner le texte selon différents rôles :

- « En tant que client, qu’est‑ce qui paraît confus ou risqué ? »

- « En tant que support, quels tickets cela pourrait‑il générer ? »

- « En tant que PM, quels critères d’acceptation manquent ? »

- « En tant que juridique/conformité, quelles affirmations nécessitent un resserrement ? »

Vérification de sécurité : vérifier les faits

L’IA peut critiquer la formulation tout en se trompant sur des détails produit. Traitez les éléments factuels — prix, disponibilité, sécurité, délais — comme « à vérifier ». Prenez l’habitude d’annoter les affirmations avec des sources (liens vers docs, tickets ou décisions) pour que la version finale reflète la réalité et non une approximation plausible.

Convertir les retours en tâches, tâches en critères d’acceptation

Les retours bruts ne sont que rarement prêts à être implémentés. Ils sont souvent émotionnels (« ça sonne bizarre »), mixtes (« j’aime mais… ») ou sous‑spécifiés (« rends‑ça plus clair »). L’IA peut aider à traduire cela en éléments de travail concrets — tout en gardant l’original pour justifier les décisions ultérieures.

Un modèle simple que l’IA peut remplir

Demandez à l’outil IA de réécrire chaque retour selon cette structure :

Problème → Preuve → Changement proposé → Métrique de succès

- Problème : qu’est‑ce qui ne fonctionne pas ?

- Preuve : que l’utilisateur a dit/fait ? Inclure citation, référence de capture d’écran ou horodatage d’appel.

- Changement proposé : ce que vous allez modifier (une seule modification par élément).

- Métrique de succès : comment vous saurez que ça s’est amélioré (qualitatif ou quantitatif).

Cela force la clarté sans « inventer » de nouvelles exigences.

Exemple d’un retour :

« La page de paiement est confuse et prend trop de temps. »

Sortie assistée par IA (éditée par vous) :

- Problème : Les utilisateurs ne comprennent pas les étapes et abandonnent pendant le paiement.

- Preuve : 6/20 interviewés ont demandé « quelle est la prochaine étape ? » ; l’analytics montre une chute de 38 % entre Livraison → Paiement (10–20 déc.).

- Changement proposé : Ajouter un indicateur de progression en 3 étapes et renommer le bouton principal « Continuer » en « Continuer vers le paiement ».

- Métrique de succès : Réduire la chute Livraison → Paiement de 38 % à ≤30 % en 2 semaines.

Puis transformez cela en tâche avec périmètres :

Tâche : Ajouter l’indicateur de progression + mettre à jour le libellé du bouton sur la page de paiement.

Hors périmètre : Changer de prestataire de paiement, refondre complètement le layout de checkout, réécrire l’intégralité des textes produit.

Critères d’acceptation (rendre testable)

Utilisez l’IA pour rédiger des critères d’acceptation puis resserrez‑les :

- L’indicateur de progression apparaît sur mobile et desktop.

- Les étapes reflètent l’état courant (Livraison, Paiement, Vérification).

- Le libellé du bouton est mis à jour sur les écrans Livraison et Paiement.

- Aucun changement sur les prix, taxes ou traitement des paiements.

Garder les retours traçables

Stockez toujours :

- le retour original (citation/lien de ticket/enregistrement d’appel)

- la tâche transformée par l’IA

- la décision finale et sa justification

Cette traçabilité protège la responsabilité, évite le « l’IA l’a dit » et accélère les itérations futures car vous pouvez voir ce qui a changé — et pourquoi.

Tester les améliorations : expériences que l’IA peut accélérer

Commencez avec une stack réelle

Transformez votre prochaine idée en une application React avec un backend Go et PostgreSQL, guidé par le chat.

L’itération devient concrète quand vous testez un changement contre un résultat mesurable. L’IA peut vous aider à concevoir des petites expériences rapides — sans transformer chaque amélioration en projet d’une semaine.

Un modèle simple d’expérience (que l’IA peut aider à rédiger)

Un modèle pratique :

- Hypothèse : Si nous changeons X, alors Y s’améliorera parce que Z.

- Variantes : Version A (actuelle) vs Version B (un changement intentionnel).

- Métrique de succès : Le nombre unique que vous utiliserez pour décider (open rate, taux d’activation, taux de conversion, temps jusqu’à la première valeur).

- Audience + durée : Qui voit le test et pendant combien de temps.

Demandez à l’IA de proposer 3–5 hypothèses candidates basées sur vos thèmes de retours, puis de les reformuler en déclarations testables avec métriques claires.

Exemples rapides que l’IA peut générer (et que vous pouvez tester)

Objets d’email (métrique : open rate) :

- A : « Votre rapport hebdomadaire est prêt »

- B : « 3 insights de votre semaine (2 minutes de lecture) »

Message d’onboarding (métrique : taux de complétion de l’étape 1) :

- A : « Bienvenue ! Configurons votre compte. »

- B : « Bienvenue — ajoutez votre premier projet pour voir des résultats en moins de 5 minutes. »

Microcopy d’un bouton (métrique : CTR) :

- A : « Envoyer »

- B : « Enregistrer et continuer »

L’IA est utile ici car elle peut produire rapidement plusieurs variantes plausibles — tons, longueurs et propositions de valeur différentes — afin que vous puissiez choisir une modification claire à tester.

Garde‑fous : rendre le test interprétable

La vitesse est excellente, mais rendez les expériences lisibles :

- Changer une variable à la fois quand c’est possible. Si vous réécrivez le titre et le bouton et la mise en page, vous ne saurez pas ce qui a fonctionné.

- Conserver un contrôle. Toujours garder la Version A.

- Définir la métrique avant d’observer. Sinon vous trouverez des victoires par hasard.

Mesurer les résultats, pas les impressions

L’IA peut vous dire ce qui « sonne mieux », mais ce sont les utilisateurs qui décident. Utilisez l’IA pour :

- proposer des seuils de succès (par ex. « on publie B si CTR +5 % »)

- rédiger un modèle de résumé des résultats

- traduire les conclusions en hypothèses suivantes

Ainsi chaque test enseigne quelque chose, même si la nouvelle version perd.

Mesurer les résultats et apprendre à chaque cycle

L’itération ne fonctionne que si vous savez si la dernière modification a réellement aidé. L’IA peut accélérer l’étape « mesure → apprentissage », mais elle ne remplace pas la rigueur : métriques claires, comparaisons propres et décisions écrites.

Choisir des métriques adaptées à l’objectif

Sélectionnez un petit ensemble de chiffres que vous vérifierez à chaque cycle, groupés selon l’amélioration visée :

- Conversion : inscriptions, essais, complétion de checkout, CTR sur un CTA clé

- Rétention : taux de retour 7/30 jours, churn, réachats, réutilisation d’une fonctionnalité

- Temps à compléter : temps d’onboarding, temps jusqu’à la première valeur, temps de résolution support

- Taux d’erreur / qualité : soumissions échouées, rapports de bugs, remboursements, nombre de défauts QA

- Satisfaction : CSAT, NPS, notes d’app, sentiment dans les tickets

La clé est la cohérence : si vous changez la définition des métriques à chaque sprint, les chiffres n’apprennent rien.

Laisser l’IA résumer les résultats — et pointer ce qui a changé

Une fois que vous avez des exports CSV, dashboards ou comptes rendus d’expériences, l’IA aide à en faire un récit :

- résumer ce qui a bougé (et ce qui n’a pas bougé) en langage simple

- mettre en évidence les segments notables : nouveaux vs utilisateurs récurrents, type d’appareil, source de trafic, région, niveau d’abonnement, power users vs utilisateurs occasionnels

- faire remonter des corrélations surprenantes à creuser (par ex. conversion en hausse globalement, mais en baisse sur mobile Safari)

Un prompt pratique : collez votre tableau de résultats et demandez à l’assistant de produire (1) un paragraphe de synthèse, (2) les principales différences par segment, et (3) des questions de suivi pour validation.

Éviter la certitude trompeuse

L’IA peut faire paraître des résultats définitifs alors qu’ils ne le sont pas. Vérifiez :

- Taille d’échantillon : de petites variations sur de faibles échantillons sont souvent du bruit.

- Saisonnalité et événements externes : jours fériés, promos, pannes, retombées presse.

- Multiples changements simultanés : si trois choses ont changé, vous ne savez pas laquelle a eu l’effet.

Tenir un journal d’apprentissage léger

Après chaque cycle, rédigez une courte entrée :

- Ce qui a changé (lien vers ticket ou doc)

- Ce qui s’est passé (métriques + segments notables)

- Ce que ça signifie selon nous (votre meilleure explication)

- Ce qu’on tente ensuite (un suivi concret)

L’IA peut rédiger l’entrée, mais l’équipe valide la conclusion. Avec le temps, ce journal devient votre mémoire et vous évite de répéter les mêmes expériences.

Rendre le processus répétable : workflows qui montent en charge

Maîtrisez votre production

Conservez l'élan sans verrouillage en exportant le code source quand vous êtes prêt.

La vitesse, c’est bien ; la cohérence, c’est ce qui fait croître l’itération. L’objectif est de transformer « on devrait améliorer ça » en une routine que l’équipe peut exécuter sans héroïsme.

Patrons de workflow légers

Une boucle scalable n’a pas besoin d’un lourd processus. Quelques habitudes simples surpassent un système compliqué :

- Revue hebdomadaire (30–60 minutes) : choisissez 1–3 items à améliorer, passez en revue les changements de la semaine passée et décidez quoi tester ensuite. Apportez des résumés préparés par l’IA (thèmes, plaintes principales, risques émergents) pour garder la réunion ciblée.

- Journal de changements : conservez une note courante de ce qui a changé, pourquoi et ce que vous attendez. Un doc simple suffit ; l’important est la régularité.

- Notes de décision : pour les changements significatifs, capturez la décision en cinq lignes : contexte, options considérées, décision, propriétaire, date. L’IA peut rédiger à partir des notes de réunion, mais vous confirmez le libellé.

Modèles de prompts + checklists réutilisables

Considérez les prompts comme des actifs. Stockez‑les et versionnez‑les comme le reste du travail.

Maintenez une petite bibliothèque :

- Modèles de prompts pour tâches récurrentes (résumer des retours, proposer des variantes, réécrire pour un ton, générer des critères d’acceptation).

- Checklists réutilisables pour la qualité (clarté, exhaustivité, conformité, voix de la marque, accessibilité). Demandez à l’IA d’exécuter la checklist et de signaler les lacunes, puis un humain vérifie.

Une convention simple aide : « Tâche + Audience + Contraintes » (par ex. « Notes de version — non‑technique — 120 mots — inclure les risques »).

Ajouter une étape d’approbation humaine pour les sorties sensibles

Pour tout ce qui touche à la confiance ou à la responsabilité — tarification, formulations juridiques, conseils médicaux ou financiers — utilisez l’IA pour rédiger et signaler les risques, mais exigez un approbateur nommé avant publication. Rendre cette étape explicite évite qu’elle soit sautée sous la pression du temps.

Nommage des versions pour éviter la confusion

L’itération rapide crée des fichiers désordonnés si vous ne nommez pas clairement. Utilisez un schéma prévisible :

FeatureOrDoc_Scope_V#_YYYY-MM-DD_Owner

Exemple : OnboardingEmail_NewTrial_V3_2025-12-26_JP.

Quand l’IA génère des options, regroupez‑les sous la même version (V3A, V3B) pour que tout le monde sache ce qui a été comparé et ce qui a réellement été publié.

Pièges courants, contrôles de sécurité et usage responsable

L’IA accélère l’itération, mais elle peut aussi accélérer les erreurs. Traitez‑la comme un coéquipier puissant : utile, rapide, et parfois sûr de lui à tort.

Trop faire confiance à l’IA. Les modèles peuvent produire des textes, résumés ou « insights » plausibles qui ne correspondent pas à la réalité. Prenez l’habitude de vérifier tout ce qui peut impacter des clients, des budgets ou des décisions.

Prompts vagues → travail vague. Si votre entrée est « améliore ça », vous obtiendrez des edits génériques. Spécifiez audience, objectif, contraintes et ce que signifie « mieux » (plus court, plus clair, conforme à la marque, moins de tickets support, meilleure conversion, etc.).

Pas de métriques, pas d’apprentissage. L’itération sans mesure n’est que du changement. Décidez en amont ce que vous suivrez (taux d’activation, temps jusqu’à la première valeur, churn, thèmes NPS, taux d’erreur) et comparez avant/après.

Gestion des données : protéger utilisateurs et entreprise

Ne collez pas d’informations personnelles, client ou confidentielles dans des outils sauf si votre organisation l’autorise explicitement et que vous comprenez les politiques de rétention/entraînement.

Règle pratique : partagez le minimum nécessaire.

- Retirez noms, emails, numéros, adresses, IDs de commande et notes libres contenant des détails sensibles.

- Résumez en interne, puis demandez au modèle de travailler à partir du résumé.

- Si vous devez analyser des retours réels, redactez d’abord puis stockez l’original dans votre système approuvé.

Hallucinations : vérifier faits et sources

L’IA peut inventer des chiffres, citations, détails produit ou références. Quand l’exactitude compte :

- Demandez les hypothèses et l’incertitude (« Sur quoi n’es‑tu pas sûr ? »).

- Demandez des liens vers les sources primaires seulement si vous pouvez les vérifier vous‑même.

- Recoupez avec vos docs, analytics, changelog ou système de support.

Checklist « avant publication »

Avant de publier un changement assisté par IA, faites une passe rapide :

- Objectif & métrique définis (quel succès attendre).

- PII / données confidentielles retirées des prompts et logs.

- Faits vérifiés (chiffres, politiques, citations).

- Cas limites passés en revue (accessibilité, ton, juridique/compliance).

- Validation humaine par le propriétaire approprié (PM, support, juridique, marque).

- Plan de rollback si le changement performe moins bien.

Employée ainsi, l’IA reste un amplificateur du bon jugement — pas son remplaçant.