À quoi ressemble une « architecture plus propre » dans le travail assisté par IA

« Architecture plus propre » dans cet article ne signifie pas un cadre particulier ou un diagramme parfait. Cela signifie que vous pouvez expliquer le système simplement, le modifier sans casser des parties non liées, et vérifier le comportement sans des tests héroïques.

Une définition pratique : clarté, modularité, testabilité

Clarté signifie que le but et la forme du système sont évidents dans une courte description : ce qu’il fait, qui l’utilise, quelles données il manipule, et ce qu’il ne doit jamais faire. Dans le travail assisté par IA, la clarté signifie aussi que le modèle peut reformuler les exigences d’une manière que vous approuveriez.

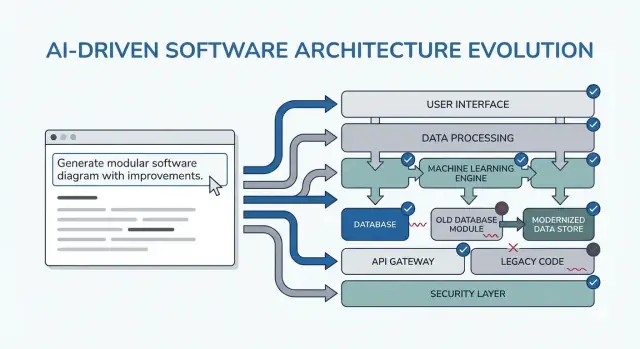

Modularité signifie que les responsabilités ont des frontières nettes. Chaque module a une mission, des entrées/sorties, et une connaissance minimale des internes des autres modules. Quand l’IA génère du code, la modularité empêche qu’elle étale des règles métier dans des contrôleurs, l’UI et l’accès aux données.

Testabilité signifie que l’architecture rend la preuve du fonctionnement peu coûteuse. Les règles métier peuvent être testées sans un système complet en fonctionnement, et les tests d’intégration se concentrent sur quelques contrats plutôt que sur chaque chemin de code.

Pourquoi les réécritures arrivent (et pourquoi l’IA peut les amplifier)

Les réécritures ne sont généralement pas causées par du « mauvais code » — elles sont causées par des contraintes manquantes, un périmètre vague, et des hypothèses cachées. Exemples :

- Une fonctionnalité est construite pour un type d’utilisateur, puis on découvre qu’il y a trois rôles avec des permissions différentes.

- Des règles de performance, de journalisation d’audit ou de rétention apparaissent tardivement.

- Une API externe se comporte différemment de ce qui était attendu, forçant des changements partout.

L’IA peut accélérer ce mode d’échec en produisant rapidement des résultats convaincants, ce qui rend facile de construire sur des fondations fragiles.

À quoi s’attendre des patrons présentés

Les patrons qui suivent sont des modèles à adapter, pas des prompts magiques. Leur objectif réel est de forcer les bonnes conversations tôt : clarifier les contraintes, comparer les options, documenter les hypothèses et définir les contrats. Si vous esquivez cette réflexion, le modèle remplira volontiers les blancs — et vous en paierez le prix plus tard.

Où ces patrons s’insèrent dans votre workflow

Vous les utiliserez tout au long du cycle de livraison :

- Planification : resserrer exigences et critères de succès

- Conception : choisir frontières, flux de données et contrats

- Développement : garder les responsabilités séparées au fur et à mesure de l’implémentation

- Revue : détecter risques et décalages avant qu’ils ne deviennent des réécritures

Si vous utilisez un workflow de type vibe-coding (où le système est généré et itéré via chat), ces points de contrôle ont encore plus d’importance. Par exemple, dans Koder.ai vous pouvez lancer une boucle « mode planification » pour verrouiller exigences et contrats avant de générer du code React/Go/PostgreSQL, puis utiliser des snapshots/rollback pour itérer en sécurité quand les hypothèses changent — sans faire de chaque changement une réécriture.

Les patrons de prompting sont les plus utiles quand ils réduisent le churn décisionnel. L’astuce consiste à les utiliser comme points de contrôle courts et répétables — avant de coder, pendant la conception, et durant la revue — afin que l’IA produise des artefacts réutilisables, pas du texte supplémentaire à trier.

Quand utiliser les patrons

Avant de coder : lancez une boucle d’« alignement » pour confirmer objectifs, utilisateurs, contraintes et métriques de succès.

Pendant la conception : utilisez des patrons qui forcent des compromis explicites (alternatives, risques, frontières de données) avant d’implémenter.

Pendant la revue : utilisez un prompt sous forme de checklist pour repérer les lacunes (cas limites, monitoring, sécurité, performance) tant que les changements sont encore bon marché.

Rassembler d’abord les entrées (légèrement)

Vous obtiendrez de meilleures réponses avec un petit paquet d’entrées cohérent :

- Objectifs : ce que « done » signifie (cibles de latence, résultats UX, limites de coût)

- Utilisateurs : rôles, workflows clés et principales douleurs

- Contraintes : stack technologique, délais, exigences conformité/sécurité

- Données & intégrations : sources, propriété, API, dépendances tierces

Si vous ignorez quelque chose, dites-le explicitement et demandez à l’IA d’énumérer ses hypothèses.

Au lieu de « expliquer le design », demandez des artefacts que vous pouvez coller dans des docs ou tickets :

- Un journal de décision (options → pour/contre → choisi → pourquoi)

- Un tableau de composants avec responsabilités et frontières

- Une checklist pour la fiabilité et les tests

- Une description de diagramme simple (ex. texte Mermaid) que vous pourrez rendre plus tard

Itérer en petites boucles avec critères d’acceptation

Faites des boucles de 10–15 minutes : prompt → survol → resserrement. Incluez toujours des critères d’acceptation (ce qui doit être vrai pour que la conception soit acceptable), puis demandez à l’IA de s’auto-vérifier par rapport à eux. Cela empêche le processus de devenir une refonte sans fin et rend les patrons des sections suivantes rapides à appliquer.

Patron 1 : Clarifier les exigences avant toute conception

La plupart des « réécritures d’architecture » ne sont pas causées par de mauvais diagrammes — elles résultent de la construction de la bonne chose pour le mauvais (ou incomplet) problème. Quand vous utilisez un modèle de langage tôt, ne demandez pas d’abord une architecture. Demandez-lui d’exposer l’ambiguïté.

Utilisez le modèle comme un analyste d’exigences. Votre but est une spécification courte et priorisée que vous pouvez confirmer avant que quiconque conçoive des composants, choisisse des bases ou s’engage sur des API.

Voici un template à copier/coller :

You are my requirements analyst. Before proposing any architecture, do this:

1) Ask 10–15 clarifying questions about missing requirements and assumptions.

- Group questions by: users, workflows, data, integrations, security/compliance, scale, operations.

2) Produce a prioritized scope list:

- Must-have

- Nice-to-have

- Explicitly out-of-scope

3) List constraints I must confirm:

- Performance (latency/throughput targets)

- Cost limits

- Security/privacy

- Compliance (e.g., SOC2, HIPAA, GDPR)

- Timeline and team size

4) End with: “Restate the final spec in exactly 10 bullets for confirmation.”

Context:

- Product idea:

- Target users:

- Success metrics:

- Existing systems (if any):

Ce qu’il faut rechercher dans la sortie

Vous voulez des questions qui forcent des décisions (pas des « dites-m’en plus » génériques), plus une liste de must-have qui peut réellement être livrée dans votre calendrier.

Considérez la reformulation en « 10 puces » comme un contrat : collez-la dans votre ticket/PRD, obtenez un oui/non rapide des parties prenantes, puis ne passez à l’architecture qu’après. Cette étape prévient la cause la plus courante de refactorings tardifs : construire des fonctionnalités qui n’étaient pas réellement nécessaires.

Patron 2 : Parcours utilisateur d’abord, choix techniques ensuite

Quand vous commencez par les outils (« devons-nous utiliser l’event sourcing ? ») vous finissez souvent par concevoir pour l’architecture plutôt que pour l’utilisateur. Un chemin plus rapide vers une structure propre est de demander à l’IA de décrire d’abord les parcours utilisateurs en langage simple, puis de traduire ces parcours en composants, données et API.

Un template simple « parcours d’abord »

Utilisez ceci comme point de départ :

- Rôles : utilisateur / admin / système

- Actions clés : ce que chaque rôle cherche à accomplir

- Cas limites : ce qui peut mal se passer (entrée invalide, permissions manquantes, complétion partielle)

Puis demandez :

-

« Décris le flux étape par étape pour chaque action en langage simple. »

-

« Fournis un petit diagramme d’état ou une liste d’états (ex. Draft → Submitted → Approved → Archived). »

-

« Liste les scénarios non-happy-path : timeouts, retries, requêtes dupliquées, annulations, et entrées invalides. »

Une fois les flux clarifiés, demandez à l’IA de les mapper aux choix techniques :

- Où avons-nous besoin de validation vs règles métier ?

- Quelles étapes exigent idempotence (retries sûrs) ?

- Quelles données doivent être stockées, lesquelles peuvent être dérivées, et ce qui nécessite une piste d’audit ?

Ce n’est qu’après cela que vous devriez demander un croquis d’architecture (services/modules, frontières et responsabilités) lié directement aux étapes des flux.

Convertir les flux en critères d’acceptation testables

Terminez en demandant à l’IA de convertir chaque parcours en critères d’acceptation testables :

- « Given/When/Then pour chaque étape et chaque cas d’échec. »

- « Que doit renvoyer ou afficher le système ? »

- « Que doit être journalisé, et qu’est-ce qui déclenche un retry vs une erreur visible par l’utilisateur ? »

Ce patron réduit les réécritures parce que l’architecture naît du comportement utilisateur — pas d’hypothèses techniques.

Patron 3 : Journal des hypothèses pour éviter les réécritures surprises

La plupart des retravaux d’architecture ne viennent pas d’un « mauvais design » mais d’hypothèses cachées qui se révèlent fausses. Quand vous demandez une architecture à un LLM, il remplira souvent les vides par des suppositions plausibles. Un journal des hypothèses rend ces suppositions visibles tôt, quand les changements sont peu coûteux.

Ce qu’il faut demander au modèle

Votre objectif est de forcer une séparation nette entre les faits que vous avez fournis et les hypothèses qu’il a inventées.

Utilisez ce pattern de prompt :

Template prompt

“Before proposing any solution: list your assumptions. Mark each as validated (explicitly stated by me) or unknown (you inferred it). For each unknown assumption, propose a fast way to validate it (question to ask, metric to check, or quick experiment). Then design based only on validated assumptions, and call out where unknowns could change the design.”

Gardez-le court pour que les gens l’utilisent :

- Hypothèse : …

- Statut : validée / inconnue

- Pourquoi c’est important : quelle décision cela affecte

- Comment valider : question, vérification, ou spike

- Si c’est faux, changement probable : ce que vous redessineriez

Déclencheurs « qu’est-ce qui changerait votre réponse ? »

Ajoutez une ligne qui oblige le modèle à indiquer ses points de bascule :

- « Listez 5 déclencheurs : qu’est-ce qui changerait votre réponse ? (ex. volume utilisateur, objectifs de latence, besoins de conformité, règles de rétention de données). »

Ce patron transforme l’architecture en un ensemble de décisions conditionnelles. Vous n’obtenez pas seulement un diagramme — vous obtenez une carte de ce qui doit être confirmé avant de vous engager.

Patron 4 : Comparer plusieurs architectures avant de choisir

Livrez rapidement une tranche de MVP

Construisez une petite tranche MVP de bout en bout dans le chat et itérez sans transformer les changements en réécritures.

Les outils IA sont bons pour produire un design « optimal » unique — mais c’est souvent la première option plausible. Une architecture plus propre apparaît généralement quand vous forcez une comparaison tôt, alors que les changements sont bon marché.

Template de prompt central

Utilisez un prompt qui exige plusieurs architectures et un tableau structuré d’arbitrage :

Propose 2–3 viable architectures for this project.

Compare them in a table with criteria: complexity, reliability, time-to-ship, scalability, cost.

Then recommend one option for our constraints and explain why it wins.

Finally, list “what we are NOT building” in this iteration to keep scope stable.

Context:

- Users and key journeys:

- Constraints (team size, deadlines, budget, compliance):

- Expected load and growth:

- Current systems we must integrate with:

Pourquoi cela réduit les réécritures

Une comparaison force le modèle (et vous) à faire ressortir des hypothèses cachées : où vit l’état, comment les services communiquent, ce qui doit être synchrone et ce qui peut être différé.

Le tableau de critères empêche que des débats comme « microservices vs monolithe » deviennent subjectifs. Il ancre la décision à ce qui compte vraiment pour vous — livrer vite, réduire l’opérationnel, ou améliorer la fiabilité.

Exiger une recommandation et une frontière

N’acceptez pas « ça dépend ». Demandez une recommandation claire et les contraintes spécifiques qu’elle optimise.

Insistez aussi sur « ce que nous ne construisons pas ». Exemples : « pas de basculement multi-région », « pas de système de plugins », « pas de notifications temps réel ». Cela empêche l’architecture de s’étendre silencieusement pour supporter des fonctionnalités non engagées — et évite des réécritures surprises quand le périmètre change.

Patron 5 : Frontières modulaires et prompts de responsabilités

La plupart des réécritures arrivent parce que les frontières sont vagues : tout « touche tout », et un petit changement se répercute sur tout le code. Ce patron utilise des prompts qui forcent une propriété modulaire claire avant de débattre frameworks ou diagrammes de classes.

L’idée centrale

Demandez à l’IA de définir modules et responsabilités, plus ce qui n’appartient pas explicitement à chaque module. Ensuite, demandez des interfaces (entrées/sorties) et règles de dépendance, pas un plan de construction ou des détails d’implémentation.

Template à copier/coller

Utilisez ceci quand vous esquissez une nouvelle fonctionnalité ou refactorez une zone en désordre :

- Contexte : <une phrase sur le produit/fonctionnalité>

- Objectif : Proposer une architecture modulaire avec 4–8 modules.

-

Lister les modules avec :

- But (1 phrase)

- Responsabilités (3–5 puces)

- Non-responsabilités (« NE gère PAS… ») (2–3 puces)

-

Pour chaque module, définir interfaces seulement :

- Entrées (événements/requêtes/données)

- Sorties (réponses/événements/effets de bord)

- Surface API publique (noms de fonctions ou endpoints OK ; pas de classes internes)

-

Règles de dépendance :

- Dépendances autorisées (A → B)

- Dépendances interdites (A ↛ C) avec raisonnement

- Où vivent les types partagés (et ce qui ne doit jamais être partagé)

-

Test de changement futur : Étant donné ces changements probables : <listez 3>, montrez quel module unique devrait absorber chaque changement et pourquoi.

À quoi ressemble une bonne sortie

Visez des modules que vous pouvez décrire à un collègue en moins d’une minute. Si l’IA propose un module « Utils » ou met des règles métier dans des contrôleurs, poussez-la : « Déplace la prise de décision dans un module domaine et garde les adaptateurs minces. »

Lorsque c’est fait, vous avez des frontières qui survivent aux nouvelles exigences — car les changements ont une maison claire, et les règles de dépendance empêchent le couplage accidentel.

Patron 6 : Données & contrats d’API en premier (éviter le retravail d’intégration)

Le retravail d’intégration est souvent causé non pas par du « mauvais code » mais par des contrats flous. Si le modèle de données et les formes d’API sont décidés tard, chaque équipe (ou module) comble les blancs différemment, et vous passez le sprint suivant à concilier des hypothèses incompatibles.

Commencez par demander les contrats avant de parler frameworks, bases ou microservices. Un contrat clair devient la référence partagée qui aligne UI, backend et pipelines de données.

Le prompt contract-first

Utilisez ce prompt tôt avec votre assistant IA :

- Template : « Décris le modèle de données, la propriété et le cycle de vie pour chaque entité »

Puis enchaînez immédiatement avec :

- Demandez des contrats d’API avec exemples (requêtes, réponses, formes d’erreur)

- Ajoutez le versioning et les attentes de compatibilité ascendante

- Demandez des règles de validation et des cas limites par champ

À quoi ressemble une bonne sortie

Vous voulez des artefacts concrets, pas de la prose. Par exemple :

- Entité :

Subscription

- Propriétaire : service Billing

- Cycle de vie : créé lors du checkout → active → past_due → canceled (soft-delete après 90 jours)

- Source de vérité : DB billing ; autres services cachent des copies en lecture seule

Et un croquis d’API :

POST /v1/subscriptions

{

"customer_id": "cus_123",

"plan_id": "pro_monthly",

"start_date": "2026-01-01"

}

201 Created

{

"id": "sub_456",

"status": "active",

"current_period_end": "2026-02-01"

}

422 Unprocessable Entity

{

"error": {

"code": "VALIDATION_ERROR",

"message": "start_date must be today or later",

"fields": {"start_date": "in_past"}

}

}

Règles de versioning et compatibilité

Faites énoncer des règles comme : « Les champs additifs sont autorisés sans bump de version ; les renommages exigent /v2 ; les clients doivent ignorer les champs inconnus. » Cette étape unique évite des changements silencieux et les réécritures qui s’ensuivent.

Patron 7 : Modes de défaillance et checklist de fiabilité

Obtenez plus de crédits de construction

Créez du contenu sur Koder.ai ou parrainez des collègues et gagnez des crédits au fur et à mesure que vous construisez.

Les architectures sont réécrites quand des designs happy-path rencontrent du trafic réel, des dépendances instables et des comportements utilisateurs inattendus. Ce patron fait de la fiabilité une sortie de conception explicite, pas une réaction post-lancement.

Template à copier/coller

Utilisez ceci avec la description d’architecture choisie :

List failure modes; propose mitigations; define observability signals.

Pour chaque mode de défaillance :

- Qu’est-ce qui le déclenche ?

- Impact utilisateur (ce que l’utilisateur ressent)

- Atténuation (conception + opérationnel)

- Retries, idempotency, rate limits, timeouts considérations

- Observabilité : logs/métriques/traces + seuils d’alerte

Ce qu’il faut couvrir (non négociable)

Concentrez la réponse en nommant les interfaces qui peuvent échouer : API externes, base de données, queues, fournisseur d’auth, jobs en arrière-plan. Puis exigez des décisions concrètes :

- Retries : quand retryer, combien de fois, stratégie de backoff, quelles erreurs sont retryables.

- Idempotence : clés d’idempotence, fenêtres de déduplication, quel état est sûr à rejouer.

- Limites : quotas par utilisateur/IP/service, message au client, protections côté serveur.

- Timeouts : par dépendance, budget global de la requête, et propagation des annulations.

Checklist de fiabilité

Terminez le prompt par : « Retournez une checklist simple que nous pouvons revoir en 2 minutes. » Une bonne checklist contient des éléments comme : timeouts définis, retries bornés, idempotence implémentée pour les actions create/charge, limitation de débit/backpressure en place, chemin de dégradation défini.

Observabilité liée aux actions utilisateurs

Demandez des événements autour des moments utilisateurs (pas seulement l’interne système) : « user_signed_up », « checkout_submitted », « payment_confirmed », « report_generated ». Pour chacun, demandez :

- Champs de log (user_id, request_id, idempotency_key)

- Métriques (taux de succès, latence p95/p99, compteurs de retry)

- Traces (spans par appel de dépendance)

Cela transforme la fiabilité en un artefact de conception vérifiable avant même l’existence du code.

Patron 8 : Planification d’un slice MVP pour réduire le surdéveloppement

Un moyen courant par lequel la conception assistée par IA génère des réécritures est d’encourager des architectures « complètes » trop tôt. La solution est simple : forcez le plan à démarrer par la plus petite tranche utilisable — celle qui livre de la valeur, prouve la conception et garde les options futures ouvertes.

Template du prompt

Utilisez ceci quand la solution s’étend plus vite que les exigences :

Template : « Propose la plus petite tranche utilisable ; définis les métriques de succès ; liste les suites. »

Demandez au modèle de répondre avec :

- Tranche MVP : ce qui est inclus pour livrer quelque chose de réel

- Métriques de succès : comment savoir si ça a marché (utilisateur + technique)

- Suites : ce qui peut attendre sans bloquer l’apprentissage

Exigez une feuille de route en phases (MVP → v1 → v2)

Ajoutez : « Donne une feuille de route en phases : MVP → v1 → v2, et explique quel risque chaque phase réduit. » Cela garde les idées futures visibles sans les forcer dans la première release.

Exemples d’issues attendues :

- MVP valide le flux cœur et un chemin bout-en-bout mince.

- v1 renforce la fiabilité, ajoute l’UX must-have manquant.

- v2 élargit l’étendue (plus d’intégrations, rôles avancés, optimisations).

Exiger des exclusions explicites pour éviter le scope creep

La ligne la plus puissante dans ce patron est : « Liste ce qui est explicitement hors scope pour le MVP. » Les exclusions protègent les décisions d’architecture d’une complexité prématurée.

Bonnes exclusions :

- « Pas de basculement multi-région dans le MVP (loguer incidents ; planifier en v2). »

- « Pas de système de plugins pour l’instant (gardez les frontières propres, livrez des modules fixes). »

- « Un seul fournisseur de paiement ; abstraire plus tard si nécessaire. »

Enfin : « Convertis le MVP en tickets, chacun avec critères d’acceptation et dépendances. » Cela force la clarté et révèle le couplage caché.

Un découpage solide inclut typiquement :

- Un chemin happy-path bout-en-bout mince

- Un modèle de données minimal + contrat d’API

- Gestion d’erreurs minimale et logging

- Un point d’intégration (si nécessaire) avec fallback stub

Si vous le souhaitez, liez ceci directement à votre flux en demandant au modèle de sortir au format de votre équipe (ex. champs style Jira) et gardez les phases futures dans un backlog séparé.

Patron 9 : Prompts axés test-first qui façonnent de meilleures conceptions

Créez une application full stack

Générez une application web React avec un backend Go et PostgreSQL à partir d'un seul flux de chat.

Une manière simple d’empêcher l’architecture de dériver est de forcer la clarté via des tests avant de demander une conception. Quand vous incitez un LLM à commencer par des tests d’acceptation, il doit nommer les comportements, entrées, sorties et cas limites. Cela expose naturellement les exigences manquantes et pousse l’implémentation vers des frontières modulaires propres.

Template à copier/coller

Utilisez ceci comme prompt-gate chaque fois que vous allez concevoir un composant :

- Template : « Écris d’abord des tests d’acceptation ; puis propose une implémentation. Tu dois : (1) lister les hypothèses, (2) nommer tests unitaires vs intégration, (3) définir données de test et mocks vs dépendances réelles, (4) inclure une définition de terminé. »

Demandez des frontières de tests qui correspondent aux modules

Relancez avec : « Regroupe les tests par responsabilité de module (couche API, logique domaine, persistance, intégrations externes). Pour chaque groupe, spécifie ce qui est mocké et ce qui est réel. »

Cela pousse le LLM à s’éloigner des designs emmêlés où tout touche tout. S’il ne peut pas expliquer où commencent les tests d’intégration, l’architecture n’est probablement pas claire.

Stratégie de données de test : éviter les suites fragiles

Demandez : « Propose un plan de données de test : fixtures vs factories, comment générer les cas limites, et comment garder les tests déterministes. Liste quelles dépendances peuvent utiliser des fakes en mémoire et lesquelles nécessitent un service réel en CI. »

Vous découvrirez souvent qu’une fonctionnalité « simple » a en réalité besoin d’un contrat, d’un dataset d’amorçage ou d’IDs stables — mieux vaut le trouver maintenant que pendant une réécriture.

Définition de terminé (pour que la conception soit livrée)

Terminez par une checklist légère :

- Tests verts (unitaires + intégration) et couverture significative des cas d’échec

- Docs minimales : usage, config, et une note de dépannage

- Monitoring/alertes pour les modes de défaillance clés

- Plan de déploiement (feature flag, étapes de migration, rollback)

Patron 10 : Prompts de revue de conception pour détecter les problèmes tôt

Les revues de conception ne doivent pas n’arriver qu’après le code. Avec l’IA, vous pouvez lancer une « review pré-mortem » sur votre ébauche d’architecture (même si ce n’est que quelques paragraphes et un diagramme en mots) et obtenir une liste concrète de faiblesses avant qu’elles ne deviennent des réécritures.

Template de revue central

Commencez par une posture de reviewer franc et exigez de la spécificité :

Prompt : « Agis en tant que reviewer ; liste risques, incohérences et détails manquants dans ce design. Sois concret. Si tu ne peux pas évaluer quelque chose, dis quelle information manque. »

Collez votre résumé de design, contraintes (budget, délai, compétences de l’équipe) et exigences non fonctionnelles (latence, disponibilité, conformité).

Les revues échouent quand le feedback est vague. Demandez une liste de corrections priorisée :

Prompt : « Donne-moi une punch list priorisée. Pour chaque item : gravité (Blocker/High/Medium/Low), pourquoi ça compte, correctif suggéré, et la plus petite étape de validation. »

Cela produit un ensemble de tâches prêtes à la décision plutôt qu’un débat.

Quantifier le risque de réécriture

Un bon forcing function est un score simple :

Prompt : « Attribue un score de risque de réécriture de 1–10. Explique les 3 principaux facteurs. Qu’est-ce qui réduirait le score de 2 points avec l’effort minimal ? »

Vous ne cherchez pas la précision, mais à faire ressortir les hypothèses les plus propices à la réécriture.

Terminer par un « plan de diff »

Enfin, empêchez la revue d’élargir le scope :

Prompt : « Fournis un plan de diff : changements minimaux nécessaires pour atteindre le design cible. Liste ce qui reste, ce qui change, et les impacts breaking éventuels. »

Quand vous répétez ce patron à chaque itération, votre architecture évolue par petites étapes réversibles — pendant que les gros problèmes sont captés tôt.

Un pack de prompts à copier/coller et un workflow simple

Utilisez ce pack comme un workflow léger à répéter pour chaque fonctionnalité. L’idée est de chaîner les prompts pour que chaque étape produise un artefact réutilisable par la suivante — réduisant la « perte de contexte » et les réécritures surprises.

Le workflow en 6 étapes (enchaînez ces patrons)

- Exigences (clarifier + contraintes)

- Options d’architecture (comparer 2–3 approches)

- Frontières (modules + responsabilités)

- Contrats (données + API)

- Tests (acceptation test-first + tests unitaires clés)

- Revue (modes de défaillance + checklist de revue de design)

En pratique, les équipes implémentent souvent cette chaîne comme une « recette de fonctionnalité » répétable. Si vous construisez avec Koder.ai, la même structure se mappe bien à un processus de build piloté par chat : capturez les artefacts au même endroit, générez la première tranche fonctionnelle, puis itérez avec des snapshots pour que les expérimentations restent réversibles. Quand le MVP est prêt, vous pouvez exporter le code source ou déployer/hoster avec un domaine personnalisé — utile quand vous voulez la vitesse de la livraison assistée par IA sans vous verrouiller dans un seul environnement.

Pack de prompts à copier/coller (avec garde-fous)

SYSTEM (optional)

You are a software architecture assistant. Be practical and concise.

Guardrail: When you make a recommendation, cite the specific lines from *my input* you relied on by quoting them verbatim under “Input citations”. Do not cite external sources or general industry claims.

If something is unknown, ask targeted questions.

1) REQUIREMENTS CLARIFIER

Context: <product/system overview>

Feature: <feature name>

My notes: <paste bullets, tickets, constraints>

Task:

- Produce: (a) clarified requirements, (b) non-goals, (c) constraints, (d) open questions.

- Include “Input citations” quoting the exact parts of my notes you used.

2) ARCHITECTURE OPTIONS

Using the clarified requirements above, propose 3 architecture options.

For each: tradeoffs, complexity, risks, and when to choose it.

End with a recommendation + “Input citations”.

3) MODULAR BOUNDARIES

Chosen option: <option name>

Define modules/components and their responsibilities.

- What each module owns (and does NOT own)

- Key interfaces between modules

- “Input citations”

4) DATA & API CONTRACTS

For each interface, define a contract:

- Request/response schema (or events)

- Validation rules

- Versioning strategy

- Error shapes

- “Input citations”

5) TEST-FIRST ACCEPTANCE

Write:

- Acceptance criteria (Given/When/Then)

- 5–10 critical tests (unit/integration)

- What to mock vs not mock

- “Input citations”

6) RELIABILITY + DESIGN REVIEW

Create:

- Failure modes list (timeouts, partial failure, bad data, retries)

- Observability plan (logs/metrics/traces)

- Review checklist tailored to this feature

- “Input citations”

Si vous voulez un compagnon plus approfondi, voyez /blog/prompting-for-code-reviews. Si vous évaluez des outils ou le déploiement en équipe, /pricing est une prochaine étape pratique.