Pourquoi planifier votre schéma Postgres avant de générer du code

Si vous construisez des endpoints et des modèles avant que la forme de la base ne soit claire, vous finissez généralement par réécrire les mêmes fonctionnalités deux fois. L'application fonctionne pour une démo, puis des données réelles et des cas limites arrivent et tout devient fragile.

La plupart des réécritures viennent de trois problèmes prévisibles :

- Les entités ne sont pas claires (les choses ont été mal nommées ou mal groupées).

- Les règles n'étaient pas appliquées (manque de contraintes).

- Des problèmes de performance apparaissent tard (les index ont été ajoutés après les plaintes des utilisateurs).

Chacun force des changements qui se répercutent dans le code, les tests et les applications clientes.

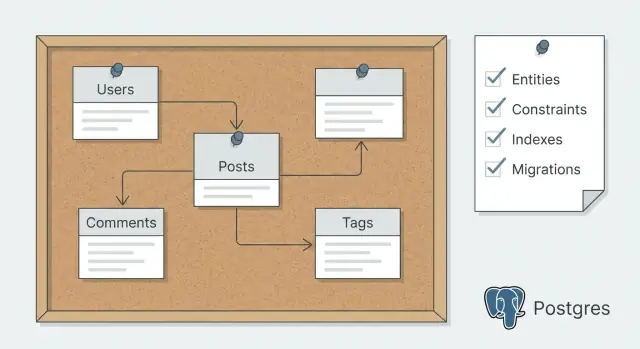

Planifier votre schéma Postgres signifie décider d'abord du contrat de données, puis générer du code qui lui correspond. En pratique, cela ressemble à écrire les entités, les relations et les quelques requêtes qui comptent, puis choisir contraintes, index et approche de migration avant qu'un outil ne scaffold les tables et le CRUD.

C'est d'autant plus important lorsque vous utilisez une plateforme de vibe-coding comme Koder.ai, où vous pouvez générer beaucoup de code rapidement. La génération rapide est excellente, mais elle devient bien plus fiable quand le schéma est fixé. Vos modèles et endpoints générés nécessitent moins de retouches par la suite.

Voici ce qui tourne généralement mal quand vous sautez la planification :

- Une table “User” se transforme discrètement en users, admins et teams mélangés.

- Des doublons apparaissent parce que rien n'impose l'unicité.

- Les suppressions cassent l'historique parce que le comportement des références n'a jamais été décidé.

- Une page de liste populaire devient lente parce que le bon index n'avait pas été prévu.

Un bon plan de schéma est simple : une description en langage courant de vos entités, un brouillon de tables et colonnes, les contraintes et index clés, et une stratégie de migration qui vous permet de changer les choses en toute sécurité au fur et à mesure de la croissance du produit.

Commencez par les besoins en données, pas par les tables

La planification du schéma fonctionne mieux quand vous commencez par ce que l'application doit mémoriser et ce que les gens doivent pouvoir faire avec ces données. Écrivez l'objectif en 2 à 3 phrases simples. Si vous ne pouvez pas l'expliquer simplement, vous créerez probablement des tables supplémentaires dont vous n'avez pas besoin.

Ensuite, concentrez-vous sur les actions qui créent ou modifient des données. Ces actions sont la vraie source de vos lignes, et elles révèlent ce qui doit être validé. Pensez en verbes, pas en noms.

Par exemple, une application de réservation pourrait devoir créer une réservation, la reprogrammer, l'annuler, la rembourser et envoyer un message au client. Ces verbes suggèrent rapidement ce qui doit être stocké (créneaux horaires, changements de statut, montants d'argent) avant même de nommer une table.

Capturez aussi vos chemins de lecture, car les lectures dictent la structure et les index plus tard. Listez les écrans ou rapports que les gens utiliseront réellement et comment ils découpent les données : “Mes réservations” triées par date et filtrées par statut, recherche admin par nom de client ou référence de réservation, revenu journalier par lieu, et une vue d'audit de qui a changé quoi et quand.

Enfin, notez les besoins non fonctionnels qui influencent les choix de schéma, comme l'historique d'audit, les suppressions logiques, la séparation multi-tenant ou les règles de confidentialité (par exemple, limiter qui peut voir les coordonnées).

Si vous prévoyez de générer du code ensuite, ces notes deviennent de puissants prompts. Elles précisent ce qui est requis, ce qui peut changer et ce qui doit être consultable. Si vous utilisez Koder.ai, rédiger cela avant de générer quoi que ce soit rend Planning Mode beaucoup plus efficace parce que la plateforme travaille à partir de vraies exigences plutôt que de suppositions.

Définissez les entités et les relations en langage clair

Avant de toucher aux tables, écrivez une description simple de ce que votre appli stocke. Commencez par lister les noms que vous répétez : user, project, message, invoice, subscription, file, comment. Chaque nom est une entité candidate.

Ajoutez ensuite une phrase par entité qui répond : qu'est-ce que c'est, et pourquoi ça existe ? Par exemple : « A Project is a workspace a user creates to group work and invite others. » Cela évite des tables vagues comme data, items ou misc.

La propriété (ownership) est la décision suivante importante, et elle affecte presque chaque requête que vous écrivez. Pour chaque entité, décidez :

- qui la crée,

- qui peut la voir,

- qui peut la modifier,

- que se passe-t-il quand le propriétaire est supprimé (conserver, transférer ou supprimer).

Décidez ensuite comment vous identifierez les enregistrements. Les UUIDs sont excellents lorsque les enregistrements peuvent être créés depuis de nombreux endroits (web, mobile, jobs en arrière-plan) ou quand vous ne voulez pas d'IDs prévisibles. Les bigint sont plus petits et plus rapides. Si vous avez besoin d'un identifiant lisible, gardez-le séparé (par exemple, un court project_code unique au sein d'un compte) au lieu d'en faire la clé primaire.

Enfin, écrivez les relations en phrases avant de tout schématiser : un utilisateur a plusieurs projets, un projet a plusieurs messages, et les utilisateurs peuvent appartenir à plusieurs projets. Marquez chaque lien comme requis ou optionnel, par exemple « un message doit appartenir à un projet » vs « une facture peut appartenir à un projet ». Ces phrases deviennent votre source de vérité pour la génération de code plus tard.

Traduire les entités en tables et colonnes

Une fois que les entités sont claires en langage courant, transformez chacune en une table avec des colonnes qui correspondent aux faits réels que vous devez stocker.

Commencez par des noms et des types sur lesquels vous pouvez tenir. Choisissez des patterns cohérents : noms de colonnes en snake_case, le même type pour la même idée, et des clés primaires prévisibles. Pour les timestamps, préférez timestamptz afin que les fuseaux horaires ne vous surprennent pas plus tard. Pour l'argent, utilisez numeric(12,2) (ou stockez les cents en entier) plutôt que des floats.

Pour les champs de statut, utilisez soit un enum Postgres, soit une colonne text avec une contrainte CHECK afin que les valeurs autorisées soient contrôlées.

Décidez ce qui est requis vs optionnel en traduisant les règles en NOT NULL. Si une valeur doit exister pour que la ligne ait du sens, rendez-la obligatoire. Si elle est vraiment inconnue ou non applicable, autorisez les nulls.

Un ensemble de colonnes par défaut pratique à prévoir :

id (uuid ou bigint, choisissez une approche et restez-y)created_at et updated_atdeleted_at uniquement si vous avez vraiment besoin de soft deletes et de restaurationscreated_by quand vous avez besoin d'une trace d'audit claire de qui a fait quoi

Les relations many-to-many devraient presque toujours devenir des tables de jonction. Par exemple, si plusieurs utilisateurs peuvent collaborer sur une app, créez app_members avec app_id et user_id, puis imposez l'unicité sur la paire afin d'éviter les doublons.

Pensez à l'historique tôt. Si vous savez que vous aurez besoin de versioning, prévoyez une table immuable telle que app_snapshots, où chaque ligne est une version sauvegardée liée à apps via app_id et horodatée avec created_at.

Ajoutez des contraintes qui protègent vos données

Aller du plan au déploiement

Déployez et hébergez votre application une fois le schéma et les migrations en place.

Les contraintes sont les garde-fous de votre schéma. Décidez quelles règles doivent être vraies quel que soit le service, le script ou l'outil admin qui accède à la base.

Commencez par l'identité et les relations. Chaque table a besoin d'une clé primaire, et tout champ « belongs to » devrait être une vraie clé étrangère, pas juste un entier auquel on espère qu'il correspond.

Ajoutez ensuite l'unicité là où les doublons causeraient un vrai dommage, comme deux comptes avec le même email ou deux lignes d'une commande avec le même (order_id, product_id).

Contraintes de haute valeur à planifier tôt :

- Primary keys : choisissez un style cohérent (UUIDs ou bigints) pour que les joins restent prévisibles.

- Foreign keys : explicitez la relation et empêchez les lignes orphelines.

- Unique constraints : utilisez-les pour l'identité métier (email, username) et les règles « une seule de ces options ».

- Check constraints : règles peu coûteuses comme

amount >= 0, status IN ('draft','paid','canceled'), ou rating BETWEEN 1 AND 5.

- Not null : exigez les champs qui sont obligatoires dans la réalité, pas juste « généralement remplis ».

Le comportement de cascade est là où la planification vous évite des ennuis plus tard. Demandez-vous ce que les gens attendent réellement. Si un client est supprimé, ses commandes ne devraient en général pas disparaître. Cela oriente vers des suppressions restreintes et la conservation de l'historique. Pour des données dépendantes comme les line items d'une commande, cascader depuis la commande vers les items peut avoir du sens car les items n'ont pas de signification sans le parent.

Quand vous générerez ensuite des modèles et des endpoints, ces contraintes deviendront des exigences claires : quelles erreurs gérer, quels champs sont requis et quels cas limites sont impossibles par conception.

Planifiez les index à partir des requêtes réelles

Les index doivent répondre à une question : qu'est-ce qui doit être rapide pour les vrais utilisateurs ?

Commencez par les écrans et les appels d'API que vous prévoyez d'envoyer en premier. Une page de liste qui filtre par statut et trie par le plus récent a des besoins différents d'une page de détail qui charge des enregistrements liés.

Rédigez 5 à 10 motifs de requêtes en langage clair avant de choisir un index. Par exemple : « Afficher mes factures des 30 derniers jours, filtrer par payé/non payé, trier par created_at », ou « Ouvrir un projet et lister ses tâches par due_date. » Cela ancre le choix des index dans l'utilisation réelle.

Un bon ensemble initial d'index inclut souvent les colonnes de foreign key utilisées pour les joins, les colonnes de filtre communes (comme status, user_id, created_at) et un ou deux index composites pour des requêtes multi-filtres stables, comme (account_id, created_at) quand vous filtrez toujours par account_id puis triez par date.

L'ordre des colonnes dans un index composite compte. Mettez la colonne que vous filtrez le plus souvent (et qui est la plus sélective) en premier. Si vous filtrez par tenant_id à chaque requête, elle appartient souvent en tête de beaucoup d'index.

Évitez d'indexer tout « au cas où ». Chaque index ajoute du travail aux INSERT et UPDATE, et cela peut nuire plus qu'une requête rare un peu plus lente.

Planifiez la recherche textuelle séparément. Si vous avez seulement besoin d'un simple « contains », ILIKE peut suffire au départ. Si la recherche est centrale, prévoyez tôt le full-text (tsvector) pour ne pas devoir repenser la chose plus tard.

Décidez de votre stratégie de migration avant de générer du code

Un schéma n'est pas « fini » quand vous créez les premières tables. Il change à chaque fois que vous ajoutez une fonctionnalité, corrigez une erreur ou apprenez davantage sur vos données. Si vous décidez de votre stratégie de migration en amont, vous évitez des réécritures douloureuses après la génération de code.

Gardez une règle simple : changez la base en petites étapes, une fonctionnalité à la fois. Chaque migration doit être facile à relire et sûre à exécuter dans tous les environnements.

La plupart des cassures viennent de renommages ou suppressions de colonnes, ou de changements de type. Au lieu de tout faire d'un coup, prévoyez un chemin sûr :

- Ajoutez d'abord de nouvelles colonnes (nullable si nécessaire), puis rétro-remplissez les données.

- Si l'application doit rester opérationnelle pendant le changement, utilisez le dual-write pendant une courte période (écrire dans l'ancien et le nouveau champ).

- Basculez les lectures vers le nouveau champ, puis nettoyez l'ancienne colonne dans une migration ultérieure.

Cela demande plus d'étapes, mais c'est plus rapide en pratique car cela réduit les interruptions et les patchs d'urgence.

Les données seed font aussi partie des migrations. Décidez quelles tables de référence sont « toujours présentes » (roles, statuses, countries, plan types) et rendez-les prévisibles. Placez les inserts et updates pour ces tables dans des migrations dédiées afin que chaque développeur et chaque déploiement obtienne les mêmes résultats.

Règles de cohérence entre local, dev et prod

Mettez en place des attentes tôt :

- Les mêmes migrations, dans le même ordre, partout.

- Pas de hotfixs manuels en production sans migration correspondante.

- Chaque migration a une story forward claire et un plan de rollback réaliste.

Les rollbacks ne sont pas toujours une « down migration » parfaite. Parfois le meilleur rollback est une restauration depuis une sauvegarde. Si vous utilisez Koder.ai, il vaut aussi la peine de décider quand compter sur des snapshots et des rollbacks pour une récupération rapide, surtout avant des changements risqués.

Un exemple simple que vous pouvez copier et ajuster

Go et Postgres, depuis le schéma

Générez un backend Go + PostgreSQL à partir d'un schéma en lequel vous avez confiance.

Imaginez une petite SaaS où les gens rejoignent des équipes, créent des projets et suivent des tâches.

Commencez par lister les entités et seulement les champs dont vous avez besoin le jour 1 :

- users: id, email, full_name, created_at

- teams: id, org_id, name, created_at

- team_members: team_id, user_id, role, joined_at

- projects: id, team_id, name, status, created_at

- tasks: id, project_id, assignee_user_id (nullable), title, state, due_date (nullable), created_at

Les relations sont simples : une équipe a plusieurs projets, un projet a plusieurs tâches, et les utilisateurs rejoignent les équipes via team_members. Les tâches appartiennent à un projet et peuvent être assignées à un utilisateur.

Ajoutez maintenant quelques contraintes qui évitent des bugs que l'on trouve typiquement trop tard :

- Rendre users.email unique (insensible à la casse si vous utilisez citext).

- Rendre les noms d'équipe uniques au sein de la même org : UNIQUE (org_id, name) sur teams.

- Empêcher les adhésions en double : UNIQUE (team_id, user_id) sur team_members.

Les index doivent correspondre aux écrans réels. Par exemple, si la liste des tâches filtre par project et state et trie par newest, prévoyez un index comme tasks (project_id, state, created_at DESC). Si « Mes tâches » est une vue clé, un index comme tasks (assignee_user_id, state, due_date) peut aider.

Pour les migrations, maintenez la première passe sûre et simple : créez les tables, les primary keys, les foreign keys et les contraintes uniques de base. Un bon changement de suivi est quelque chose que vous ajoutez après validation d'usage, comme introduire la suppression logique (deleted_at) sur les tâches et ajuster les index « tâches actives » pour ignorer les lignes supprimées.

La plupart des réécritures arrivent parce que le premier schéma manque de règles et de détails d'usage réel. Une bonne passe de planification n'est pas une question de diagrammes parfaits. Il s'agit de repérer les pièges tôt.

Une erreur fréquente est de garder des règles importantes uniquement dans le code applicatif. Si une valeur doit être unique, présente ou dans une plage, la base de données devrait l'appliquer aussi. Sinon un job en arrière-plan, un nouvel endpoint ou une importation manuelle peuvent contourner votre logique.

Un autre oubli fréquent est de considérer les index comme un problème ultérieur. Les ajouter après le lancement se transforme souvent en tâtonnements, et vous pouvez finir par indexer la mauvaise chose alors que la vraie requête lente est une jointure ou un filtre sur un champ de statut.

Les tables many-to-many sont aussi une source de bugs silencieux. Si votre table de jonction n'empêche pas les doublons, vous pouvez stocker la même relation deux fois et passer des heures à déboguer « pourquoi cet utilisateur a deux rôles ? »

Il est aussi facile de créer des tables d'abord et réaliser ensuite que vous avez besoin de logs d'audit, de suppressions logiques ou d'un historique d'événements. Ces ajouts se répercutent dans les endpoints et les rapports.

Enfin, les colonnes JSON sont tentantes pour des données « flexibles », mais elles enlèvent des vérifications et rendent l'indexation plus compliquée. Le JSON convient aux payloads vraiment variables, pas aux champs métier centraux.

Avant de générer du code, exécutez cette petite liste de vérification :

- Déplacez les règles clés dans des contraintes : NOT NULL, CHECK, UNIQUE et foreign keys.

- Rédigez 3 à 5 requêtes réelles et indexez pour celles-ci, pas pour des « peut-être plus tard ».

- Ajoutez une UNIQUE composite sur les tables de jonction (par exemple user_id + role_id).

- Décidez tôt si vous avez besoin d'un historique d'audit et modélisez-le comme sa propre table.

- Gardez le JSON pour des attributs rares et optionnels, et promouvez les champs importants en colonnes.

Checklist rapide avant de générer les modèles et endpoints

Possédez le code généré

Conservez le contrôle total en exportant le code source après génération.

Faites une pause ici et assurez-vous que le plan est suffisamment complet pour générer du code sans courir après des surprises. Le but n'est pas la perfection. C'est repérer les lacunes qui causent des réécritures plus tard : relations manquantes, règles floues et index qui ne correspondent pas à l'usage réel.

Utilisez ceci comme un contrôle pré-vol rapide :

- Pour chaque entité, écrivez une phrase sur qui la possède (user, org, system) et ce que « supprimé » signifie (hard delete, soft delete, archived).

- Pour chaque table, confirmez le type de colonne, requis vs optionnel, valeurs par défaut et comment les timestamps sont définis (par l'app ou par la base).

- Écrivez les règles qui ne doivent jamais être enfreintes : primary keys, foreign keys, règles d'unicité et quelques checks simples (comme

amount >= 0 ou statuts autorisés).

- Choisissez vos 3 à 5 écrans ou appels d'API principaux et listez les filtres exacts et l'ordre de tri nécessaires. Assurez-vous que vos index correspondent.

- Esquissez les premières migrations : schéma initial, quelles données doivent exister jour 1 (seed rows), et un changement que vous attendez bientôt (ajouter un statut, scinder un champ name, introduire des orgs).

Un test de bon sens : imaginez qu'un collègue arrive demain. Pourrait-il construire les premiers endpoints sans demander « ceci peut-il être null ? » ou « que se passe-t-il lors d'une suppression ? » toutes les heures ?

Étapes suivantes : passer du plan au code avec moins de réécritures

Une fois que le plan est clair et que les flux principaux ont du sens sur papier, transformez-le en quelque chose d'exécutable : un vrai schéma plus des migrations.

Commencez par une migration initiale qui crée les tables, les types (si vous utilisez des enums) et les contraintes indispensables. Gardez la première passe petite mais correcte. Chargez un peu de données seed et exécutez les requêtes dont votre app aura réellement besoin. Si un flux semble maladroit, corrigez le schéma pendant que l'historique des migrations est encore court.

Générez les modèles et les endpoints seulement après pouvoir tester quelques actions bout en bout avec le schéma en place (create, update, list, delete, plus une action métier réelle). La génération de code est plus rapide quand les tables, clés et noms sont assez stables pour que vous ne renommiez pas tout le lendemain.

Une boucle pratique qui maintient les réécritures basses :

- Mettez à jour le plan quand vous apprenez quelque chose de nouveau lors des tests.

- Ajoutez une nouvelle migration (évitez d'éditer les anciennes après qu'elles aient été utilisées).

- Regénérez modèles et endpoints si le schéma a changé.

- Réexécutez les mêmes flows et requêtes pour confirmer que rien n'a cassé.

- Ajoutez des champs « nice-to-have » et des index supplémentaires seulement après que les chemins principaux soient solides.

Décidez tôt ce que vous validez dans la base vs la couche API. Mettez les règles permanentes dans la base (foreign keys, contraintes d'unicité, check constraints). Gardez les règles souples dans l'API (feature flags, limites temporaires et logique cross-table complexe qui change souvent).

Si vous utilisez Koder.ai, une approche sensée est de s'accorder d'abord sur les entités et les migrations en Planning Mode, puis de générer votre backend Go + PostgreSQL. Quand un changement déraille, les snapshots et le rollback peuvent vous aider à revenir rapidement à une version connue bonne pendant que vous ajustez le plan de schéma.