28 août 2025·8 min

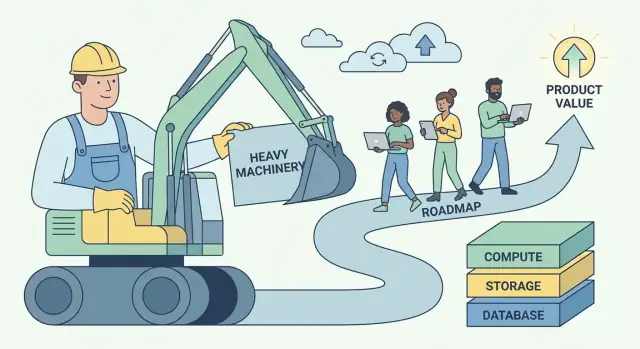

Le playbook AWS d’Andy Jassy : transformer le travail lourd en valeur

Comment Andy Jassy a construit AWS autour du « travail lourd non différenciant » et l’a transformé en un modèle répétable pour créer des entreprises logicielles et plateformes évolutives.

Ce que signifie réellement « travail lourd non différenciant »

« Travail lourd non différenciant » est une idée simple avec un tranchant aigu : c’est le travail nécessaire pour faire tourner votre logiciel, mais qui ne pousse pas les clients à vous choisir.

Cela inclut des tâches comme provisionner des serveurs, patcher des bases de données, faire pivoter des identifiants, mettre en place la supervision, gérer le basculement, dimensionner la capacité et courir après les incidents de production causés par la plomberie plutôt que par le produit. Ces jobs sont réels, importants et souvent urgents — mais ils créent rarement une expérience unique pour les utilisateurs.

Définition en langage courant

Si une tâche est :

- Nécessaire (vous ne pouvez pas l’éviter si vous voulez de la fiabilité)

- Répétable (chaque équipe en fait une version similaire)

- Pas un avantage concurrentiel (les clients ne paieront pas plus parce que vous l’avez fait vous‑même)

…alors c’est du travail lourd non différenciant.

Pourquoi l’expression a trouvé un écho chez les builders et les dirigeants

Les builders y ont entendu un soulagement : la permission d’arrêter de traiter la corvée opérationnelle comme un signe d’honneur. Si tout le monde réinvente les mêmes scripts de déploiement et runbooks d’astreinte, ce n’est pas de l’artisanat — c’est une perte de focus.

Les dirigeants y ont entendu de l’effet de levier : cette catégorie de travail coûte cher, évolue mal avec les effectifs et crée du risque. La réduire améliore la marge, la fiabilité et la vitesse en même temps.

Le modèle commercial vers lequel pointe cette idée

AWS a popularisé une recette reproductible :

- Éliminer la corvée en transformant des opérations fragiles, faites équipe par équipe, en service.

- Standardiser les parties communes pour que la qualité devienne cohérente.

- Monter en échelle via l’automatisation et l’infrastructure partagée.

- Réinvestir les économies dans de meilleurs produits et une livraison plus rapide.

C’est plus vaste que l’infrastructure cloud — c’est la « pensée plateforme » appliquée à toute entreprise logicielle.

À quoi vous attendre dans cet article

Nous traduirons le concept en signaux pratiques que vous pouvez repérer dans votre produit et votre équipe, montrerons comment les services managés et les plateformes internes emballent l’opérationnel comme un produit, et couvrirons les vrais arbitrages (contrôle, coût et verrouillage). Vous repartirez avec un cadre pour décider quoi construire vs. acheter — et comment transformer le travail non différenciant en valeur business composable.

L’intuition centrale d’Andy Jassy : les clients veulent construire, pas faire du baby-sitting

Andy Jassy a été l’un des leaders précoces qui ont aidé à transformer les capacités d’infrastructure internes d’Amazon en ce qui est devenu AWS. Son travail n’était pas seulement de « vendre des serveurs sur internet ». Il consistait à remarquer un problème client répétable et à emballer une solution qui pouvait s’étendre à des milliers d’équipes.

La vraie douleur : l’opérationnel vole l’attention du produit

La plupart des équipes logicielles ne se lèvent pas le matin enthousiastes à l’idée de patcher des systèmes d’exploitation, provisionner de la capacité, faire pivoter des identifiants ou récupérer d’un disque défaillant. Elles le font parce que c’est nécessaire — sinon l’appli ne tourne pas.

L’intuition fondamentale de Jassy était que beaucoup de ce travail est nécessaire mais non différenciant. Si vous gérez un site e‑commerce, une appli fintech ou un outil RH interne, vos clients valorisent vos fonctionnalités : un paiement plus rapide, une meilleure détection de fraude, un onboarding plus fluide. Ils vous récompensent rarement pour le fait d’avoir une flotte parfaitement réglée de serveurs.

Ainsi, le « baby‑sitting » de l’infrastructure devient une taxe :

- Il consomme du temps qui pourrait servir à livrer des améliorations.

- Il oblige les équipes à recruter des compétences qu’elles ne souhaitent pas forcément maîtriser.

- Il augmente le risque car chaque entreprise doit réapprendre les mêmes leçons opérationnelles.

Pourquoi le timing était important

Cette idée est arrivée à un moment où les exigences augmentaient partout :

- L’échelle Internet rendait le trafic imprévisible ; planifier pour le pic coûtait cher.

- Les startups devaient aller vite sans constituer une équipe de datacenter.

- L’IT d’entreprise subissait la pression de livrer plus vite tout en gérant sécurité et conformité.

Le principe n’était pas « tout migrer vers le cloud ». Il était plus simple : éliminer les charges opérationnelles répétables pour que les clients consacrent plus d’énergie à ce qui les différencie. Ce transfert — du temps et de l’attention vers la construction — est devenu la base d’un business plateforme.

Repérer le travail lourd dans votre produit et votre équipe

La première étape est de séparer le travail indispensable (nécessaire pour tenir un produit crédible) de la différenciation (les raisons pour lesquelles les clients vous choisissent).

Le travail indispensable n’est pas « sans importance ». Il est souvent critique pour la fiabilité et la confiance. Mais il crée rarement une préférence à lui seul — surtout une fois que les concurrents peuvent atteindre le même minimum.

Signaux courants de « travail lourd »

Si vous doutez de ce qui appartient au panier non différenciant, cherchez le travail qui est :

- Nécessaire, répétitif et non négociable

- Coûteux quand ça casse, mais surtout invisible quand ça marche

- Résolu de façon globalement similaire entre les entreprises

Dans les équipes logicielles, cela comprend souvent :

- La gestion de serveurs ou de clusters

- Le patching de sécurité et les mises à jour de dépendances

- Les sauvegardes et les exercices de reprise après sinistre

- L’auto‑scaling et la planification de capacité

- La supervision de base, le logging et l’alerte

- Les rotations d’astreinte pour des modes de défaillance prévisibles

Aucune de ces tâches n’est « mauvaise ». La question est de savoir si les faire soi‑même fait partie de la valeur de votre produit — ou si c’est simplement le prix d’entrée.

Le test le plus simple : les clients paieraient‑ils pour ça ?

Une règle pratique :

« Les clients vous paieraient‑ils pour cela spécifiquement, ou s’attendraient‑ils seulement à ce que ce soit inclus ? »

Si la réponse est « ils seraient seulement en colère si c’était absent », vous avez probablement affaire à du travail lourd non différenciant.

Un second test : si vous supprimiez ce travail demain en adoptant un service managé, vos meilleurs clients vous apprécieraient‑ils toujours pour ce qui resterait ? Si oui, vous avez trouvé un candidat à externaliser, automatiser ou productiser.

« Non différenciant » varie selon le marché

Ce qui est non différenciant pour une entreprise peut être un IP central pour une autre. Un éditeur de base de données peut se différencier sur la sauvegarde et la réplication. Une fintech ne le fera probablement pas. Votre objectif n’est pas de copier la frontière de quelqu’un d’autre — c’est de tracer la vôtre en fonction de ce que vos clients récompensent réellement.

En cartographiant votre roadmap et votre travail opérationnel sous ce prisme, vous commencez à voir où temps, talent et attention sont gaspillés juste pour rester au même niveau.

Pourquoi cette idée crée une énorme valeur business

Le « travail lourd non différenciant » n’est pas seulement une astuce de productivité. C’est un modèle économique : prenez un problème que beaucoup d’entreprises doivent résoudre mais sur lequel personne ne veut se différencier, et transformez‑le en service que les gens acceptent de payer.

Les problèmes commoditisés sont du carburant pour les plateformes

Les meilleurs candidats sont des nécessités avec une faible unicité stratégique : provisionner des serveurs, patcher des bases, faire pivoter des identifiants, dimensionner des files, gérer des sauvegardes. Chaque équipe en a besoin, presque toutes préféreraient ne pas les construire, et la « bonne réponse » est globalement similaire entre entreprises.

Cette combinaison crée un marché prévisible : forte demande, besoins récurrents et métriques de succès claires (uptime, latence, conformité, temps de récupération). Une plateforme peut standardiser la solution et continuer à l’améliorer.

Économies d’échelle : partager les coûts fixes entre clients

L’excellence opérationnelle comporte des coûts fixes importants — SREs, spécialistes sécurité, rotations d’astreinte, audits, outils d’incident et supervision 24/7. Quand chaque entreprise construit cela seule, ces coûts se dupliquent des milliers de fois.

Une plateforme répartit ces investissements fixes sur de nombreux clients. Le coût par client diminue avec l’adoption, tandis que la qualité peut augmenter parce que le fournisseur peut justifier une spécialisation plus profonde.

La boucle fiabilité : la spécialisation améliore l’uptime et la sécurité

Quand une équipe de service exécute le même composant pour de nombreux clients, elle voit plus de cas limites, détecte plus vite les patterns et construit une meilleure automatisation. Les incidents deviennent des entrées : chaque panne durcit le système, améliore les playbooks et resserre les garde‑fous.

La sécurité en profite de la même façon. Des équipes dédiées peuvent investir dans la modélisation des menaces, le patching continu et les contrôles de conformité que peinerait à soutenir une équipe produit unique.

Pouvoir de tarification : usage + confiance + coûts de changement (mesurés)

Les plateformes gagnent souvent du pouvoir de tarification via un modèle basé sur l’usage : les clients paient proportionnellement à la valeur consommée et peuvent démarrer petit. Avec le temps, la confiance devient un différenciateur — la fiabilité et la sécurité font du service le « choix par défaut ».

Les coûts de changement augmentent aussi à mesure que les intégrations s’approfondissent, mais la version la plus saine est méritée, pas enfermée : meilleures performances, meilleurs outils, facturation claire et moins d’incidents. C’est ce qui pousse les clients à renouveler même quand il existe des alternatives. Pour en savoir plus sur packaging et monétisation, voir /pricing.

Le modèle AWS : des primitives aux services managés

AWS n’a pas gagné en proposant « des serveurs sur Internet ». Il a gagné en prenant à répétition un problème opérationnel dur, en le découpant en éléments plus simples, puis en re‑regroupant ces éléments en services où AWS gère le travail de day‑2 pour vous.

L’échelle répétable : primitive → service → service managé → plateforme

Pensez‑y comme une échelle de maturité :

- Primitive : Ingrédients bruts que vous assemblez vous‑même (VMs, disques, réseaux)

- Service : API plus orientée autour d’une capacité (stockage d’objets, équilibrage de charge)

- Service managé : Le fournisseur opère le scaling, le patching, les sauvegardes et la reprise (bases, files)

- Plateforme : Un portfolio où les services se composent proprement, avec identité, facturation, supervision et politiques partagées

Chaque étape enlève des décisions, de la maintenance et la peur du « et si ça tombe en panne à 3 h du matin ? » du client.

Exemples AWS (cartographie conceptuelle)

AWS a appliqué le même schéma à des catégories clés :

-

Compute : Commencez par des machines virtuelles (EC2). Montez vers des formes de compute plus haut niveau où le déploiement et le scaling deviennent la norme (conteneurs managés / serverless). Le client se concentre sur le code et l’intention de capacité, pas sur la gestion d’hôtes.

-

Stockage : Des volumes et systèmes de fichiers vers le stockage d’objets (S3). L’abstraction passe de « gérer des volumes » à « put/get des objets », tandis que la durabilité, la réplication et le scaling deviennent la responsabilité d’AWS.

-

Bases de données : De « installer une DB sur une VM » à des bases managées (RDS, DynamoDB). Sauvegardes, patching, réplicas en lecture et basculement cessent d’être des runbooks personnalisés et deviennent de la configuration.

-

Messagerie : Des files et workers bricolés vers des services de messagerie managés (SQS/SNS). Les sémantiques de livraison, les retries et le tuning de débit sont standardisés pour que les équipes construisent des workflows plutôt que de l’infra.

Pourquoi les abstractions réduisent la charge cognitive

Les services managés réduisent la charge cognitive de deux façons :

- Moins d’éléments en mouvement à raisonner. Votre diagramme d’architecture passe de « instances + scripts + cron + alerting + backups » à « service + paramètres ».

- Moins de modes de défaillance dont vous devez être propriétaire. Vous concevez toujours la résilience, mais vous n’êtes plus responsable des mécanismes de patching, clustering et récupération de routine.

Le résultat : onboarding plus rapide, runbooks plus homogènes et opérations plus consistantes entre équipes.

Checklist à réutiliser (dans votre produit)

- Qu’est‑ce que les clients construisent qui est nécessaire mais pas différenciant ?

- Pouvez‑vous transformer leurs runbooks récurrents en une API unique et stable ?

- Quelles tâches pouvez‑vous rendre par défaut (sauvegardes, scaling, upgrades) au lieu d’optionnelles ?

- Les « bords tranchants » sont‑ils déplacés derrière des limites et garde‑fous sensés ?

- Plusieurs équipes peuvent‑elles réutiliser cela sans expertise dédiée ?

- Est‑ce que ça compose avec le reste de votre système (identité, monitoring, facturation, politiques) ?

Emballer l’opérationnel comme un produit

Planifiez avant de construire

Utilisez le Mode Planification pour cartographier le travail avant de générer le code.

Une lecture utile d’AWS est : il ne vend pas seulement de la technologie, il vend l’opérationnel. Le « produit » n’est pas seulement un endpoint d’API — c’est tout ce qu’il faut pour exécuter cette capacité de façon sûre, prévisible et à l’échelle.

API vs self‑service vs gestion complète

Une API vous donne des blocs de construction. Vous pouvez provisionner des ressources, mais vous concevez toujours les garde‑fous, supervisez les échecs, gérez les upgrades et répondez à « qui a changé quoi ? »

Le self‑service ajoute une couche utilisable sans tickets : consoles, templates, defaults sensés et provisioning automatisé. Le client conserve la majorité du travail day‑2, mais c’est moins manuel.

La gestion complète intervient quand le fournisseur prend les responsabilités continues : patching, scaling, sauvegardes, basculement et de nombreuses classes de réponses aux incidents. Les clients se concentrent sur la configuration de ce qu’ils veulent, pas sur comment c’est maintenu.

Les fonctionnalités « ennuyeuses » dont les clients ne peuvent pas se passer

Les capacités sur lesquelles les équipes comptent au quotidien sont rarement tape‑à‑l’œil :

- IAM et permissions : qui peut faire quoi et comment l’accès est audité

- Facturation et visibilité des coûts : budgets, factures, tags et alertes

- Quotas et limites de débit : protections contre les accidents — et définition d’attentes claires

Ce ne sont pas des quêtes secondaires. Ce sont des éléments de la promesse commerciale.

L’opérationnel comme fonctionnalité de première classe

Ce qui rend un service managé « réel », c’est le package opérationnel autour : documentation claire, canaux de support prévisibles et limites de service explicites. Une bonne doc réduit la charge du support, mais plus important encore elle réduit l’anxiété client. Des limites publiées et des processus de quota transforment les surprises en contraintes connues.

Quand vous emballez l’opérationnel comme un produit, vous n’expédiez pas seulement des fonctionnalités — vous expédiez de la confiance.

Le design organisationnel qui fait marcher les plateformes

Une plateforme réussit ou échoue moins sur des diagrammes d’architecture que sur l’organisation. Si les équipes n’ont pas de clients clairs, d’incitations et de boucles de feedback efficaces, la « plateforme » devient un backlog d’opinions.

Les équipes internes comme premiers clients (dogfooding)

La façon la plus rapide de garder une plateforme honnête est de faire des équipes produits internes les premiers — et les plus bruyants — clients. Cela implique :

- Les équipes plateforme expédient vers les équipes internes via les mêmes interfaces et docs que verraient les utilisateurs externes.

- L’adoption se mérite (par l’utilité), pas se décrète (par la politique).

- Tickets de support, revues d’incidents et décisions de roadmap traitent les équipes internes comme de vrais clients, avec des SLA clairs.

Le dogfooding force la clarté : si vos propres équipes fuient la plateforme, les clients externes feront de même.

Modèles centralisés vs fédérés

Deux patterns organisationnels reviennent :

Équipe plateforme centrale : une équipe possède les blocs de base (CI/CD, identité, observabilité, runtime, primitives data). Bon pour la cohérence et les économies d’échelle, mais risque de créer un goulot.

Modèle fédéré : une petite équipe centrale fixe standards et primitives partagées, tandis que les équipes domaine possèdent des « tranches » de plateforme (p. ex. plateforme données, plateforme ML). Cela améliore la vélocité et l’ajustement au domaine, mais requiert une gouvernance forte pour éviter la fragmentation.

Métriques qui comptent (et pièges de la plateforme)

Les bonnes métriques plateforme sont des résultats, pas de l’activité :

- Lead time to production (rapidité à livrer en prod)

- Disponibilité et taux d’incidents des services plateforme

- Coût par charge de travail (unit economics, pas dépense totale)

Les pièges courants incluent des incitations mal alignées (plateforme jugée sur le nombre de fonctionnalités, pas sur l’adoption), le sur‑design (construire pour une échelle hypothétique) et le succès mesuré par des mandats plutôt que par une utilisation volontaire.

Le flywheel de croissance qui s’auto‑alimente

Ne perdez plus de temps avec la configuration

Transformez la configuration répétitive et les tâches techniques en une application exécutable, en une seule conversation.

Les plateformes croissent différemment des produits one‑off. Leur avantage n’est pas seulement « plus de fonctionnalités » — c’est une boucle où chaque nouveau client rend la plateforme plus simple à exploiter, à améliorer et plus difficile à ignorer.

Le flywheel en termes simples

Plus de clients → plus de données d’usage réelles → motifs plus clairs sur ce qui casse, ce qui est lent, ce qui embrouille → meilleurs defaults et automatisation → un meilleur service pour tous → plus de clients.

AWS en a profité parce que les services managés transforment la corvée opérationnelle en capacité partagée et répétable. Quand les mêmes problèmes apparaissent chez des milliers d’équipes (supervision, patching, scaling, sauvegardes), le fournisseur peut les corriger une fois et distribuer l’amélioration à tous.

Pourquoi la standardisation accélère l’innovation

La standardisation est souvent présentée comme « moins de flexibilité », mais pour les plateformes c’est un multiplicateur de vitesse. Quand l’infra et l’opérationnel deviennent cohérents — une API, une approche d’identité, une façon d’observer les systèmes — les builders arrêtent de réinventer les bases.

Le temps récupéré se transforme en innovation de plus haut niveau : meilleures expériences produit, expérimentations plus rapides et nouvelles capacités construites sur la plateforme (plutôt qu’à côté). La standardisation réduit aussi la charge cognitive : moins de décisions, moins de modes de défaillance, onboarding accéléré.

Le pari long terme : la composition à l’échelle

De petites améliorations se composent quand elles s’appliquent à des millions de requêtes et des milliers de clients. Une réduction de 2 % du taux d’incident, un algorithme d’autoscaling légèrement meilleur ou une configuration par défaut plus claire n’aide pas qu’une seule entreprise — ça rehausse la baseline de la plateforme.

Comment la suppression du travail lourd se traduit par une livraison plus rapide

Éliminer le travail lourd non différenciant ne sauve pas seulement des heures — ça change le comportement des équipes. Quand le travail de « garder les lumières allumées » diminue, les roadmaps cessent d’être dominées par des corvées de maintenance (patchs, rotation de clés, baby‑sitting de queues) et commencent à refléter des paris produit : nouvelles fonctionnalités, meilleur UX, plus d’expérimentations.

Effets de second ordre qui se composent

Moins de corvée crée une réaction en chaîne :

- Onboarding plus simple. Les nouveaux ingénieurs peuvent livrer en quelques jours au lieu d’apprendre un labyrinthe de runbooks internes.

- Moins d’incidents — et plus simples. Moins de systèmes sur mesure signifie moins de modes de défaillance étranges et moins d’escalades à 3 h du matin.

- Les releases deviennent routinières. Les équipes peuvent publier plus souvent car déploiement, rollback et supervision sont standardisés.

Vitesse vs thrash : livrer vs faire du feu de paille

La vraie vitesse, c’est un rythme stable de petites releases prévisibles. Le thrash, c’est du mouvement sans progrès : bugs urgents, travail infra d’urgence et changements « rapides » qui génèrent plus de dette.

L’élimination du travail lourd réduit le thrash car elle supprime des catégories entières de travail qui interrompent continuellement la livraison planifiée. Une équipe qui passait 40 % de son temps à réagir peut rediriger cette capacité vers les fonctionnalités — et y rester.

Exemples SaaS concrets

Authentification : Au lieu de maintenir le stockage des mots de passe, les flux MFA, la gestion de sessions et les audits de conformité vous‑même, utilisez un fournisseur d’identité managé. Résultat : moins d’incidents de sécurité, déploiements SSO plus rapides et moins de temps passé à mettre à jour des librairies d’auth.

Paiements : Externalisez le traitement des paiements, la gestion de la TVA/taxes et la détection de fraude à un spécialiste. Résultat : expansion régionale plus rapide, moins de surprises de chargebacks et moins d’ingénierie bloquée sur des cas limites.

Observabilité : Standardisez sur une pile logging/metrics/tracing managée plutôt que des dashboards maison. Résultat : debugging plus rapide, propriété claire pendant les incidents et confiance pour déployer plus fréquemment.

Le schéma est simple : quand l’opérationnel devient un produit que vous consommez, le temps ingénierie revient à construire ce pour quoi les clients paient réellement.

Arbitrages : verrouillage, contrôle et coût

Éliminer le travail lourd non différenciant n’est pas gratuit. Les services managés à la manière d’AWS échangent l’effort quotidien contre un couplage plus fort, moins de réglages fins et des factures susceptibles de surprendre.

Les trois grands arbitrages

Verrouillage fournisseur. Plus vous vous appuyez sur des API propriétaires (queues, politiques IAM, moteurs de workflow), plus il devient difficile de migrer. Le verrouillage n’est pas toujours mauvais — il peut être le prix de la vitesse — mais il faut le choisir délibérément.

Perte de contrôle. Les services managés réduisent votre capacité à tuner la performance, choisir des versions exactes ou diagnostiquer des problèmes infra profonds. Lorsqu’une panne survient, vous pouvez être dépendant du calendrier du fournisseur.

Surprises de coûts. La tarification à la consommation récompense l’usage efficace, mais peut pénaliser la croissance, les architectures bavardes et les defaults « set‑and‑forget ». Les équipes découvrent souvent les coûts après mise en production.

Quand construire est rationnel

Construire (ou héberger soi‑même) peut être le bon choix quand vous avez des exigences uniques (latence custom, modèles de données spéciaux), une échelle massive où l’économie unitaire s’inverse, ou des contraintes de conformité/résidence des données que les services managés ne peuvent satisfaire.

Garde‑fous pour rester rapide sans se faire piéger

Concevez des frontières de service : encapsulez les appels aux fournisseurs derrière votre propre interface pour pouvoir remplacer les implémentations.

Maintenez un plan de portabilité : documentez ce qui serait le plus difficile à migrer et gardez un « exit viable minimum » (même lent).

Ajoutez une surveillance des coûts tôt : budgets, alertes, tagging et revues régulières des plus gros postes de dépense.

Matrice de décision copiable

| Question | Préférer Managé | Préférer Construire / Auto‑hébergé |

|---|---|---|

| Est‑ce un différenciateur pour les clients ? | Non | Oui |

| Pouvons‑nous tolérer les limites/opinion du fournisseur ? | Oui | Non |

| Avons‑nous des besoins spéciaux de conformité/contrôle ? | Non | Oui |

| La vitesse de mise sur le marché est‑elle prioritaire ? | Oui | Non |

| Le coût est‑il prévisible selon notre pattern d’usage ? | Oui | Non |

Un cadre pratique pour appliquer le modèle dans toute entreprise logicielle

Mettez en ligne en toute confiance

Publiez votre app sur un domaine personnalisé lorsque vous êtes prêt à la partager.

Vous n’avez pas besoin de gérer un cloud hyperscale pour utiliser la recette « éliminer le travail lourd non différenciant ». Toute équipe logicielle — SaaS, plateformes internes, produits data, même outils à forte charge de support — a du travail récurrent coûteux, sujet aux erreurs et peu différenciant.

Méthode étape par étape (de la corvée au produit)

-

Lister la corvée récurrente : Notez les tâches répétées pour garder les choses en marche — déploiements manuels, triage de tickets, backfills de données, demandes d’accès, passages d’incident, scripts fragiles, checklists basées sur le savoir tribal.

-

Quantifier : Pour chaque item, estimez fréquence, temps passé et coût en cas d’erreur. Un score simple marche : heures/semaine + gravité des erreurs + nombre d’équipes affectées. Cela transforme la douleur vague en backlog priorisé.

-

Standardiser le flux : Avant d’automatiser, définissez « la meilleure manière ». Créez un template, un golden path ou un ensemble minimal d’options supportées. Réduire la variation est souvent la plus grosse victoire.

-

Automatiser et packager : Bâtissez des outils self‑serve (API, UI, runbooks‑as‑code) et traitez‑les comme un produit : ownership clair, versioning, docs et modèle de support.

Une variante moderne de cette approche est les plateformes « vibe‑coding » qui transforment le scaffolding répétitif et la configuration day‑1 en un workflow guidé. Par exemple, Koder.ai permet aux équipes de créer des apps web, backend et mobiles via une interface chat (React pour le web, Go + PostgreSQL pour le backend, Flutter pour le mobile) puis d’exporter le code source ou déployer/hoster — utile quand le goulot est d’aller de l’idée à une baseline fiable sans refaire le même wiring de projet.

Commencez par un seul workflow (et prouvez la boucle)

Choisissez un workflow unique et fréquent où le succès est mesurable — déploiements, pipelines data ou outils support sont de bons candidats. Visez un win rapide : moins d’étapes, moins de pages, moins d’approvals, récupération plus rapide.

Ordre d’exécution : quoi faire en premier

- Fiabilité d’abord : Rendez le processus cohérent et sûr.

- Fonctionnalités ensuite : Ajoutez les capacités réellement demandées.

- Optimisation enfin : Affinez coût et performance après stabilisation de l’usage.

Points clés et prochaines étapes

La leçon réutilisable de la stratégie AWS d’Andy Jassy est simple : on gagne en faisant disparaître le travail commun. Quand les clients (ou les équipes internes) arrêtent de passer du temps sur la configuration, le patching, le scaling et le baby‑sitting d’incidents, ils peuvent consacrer ce temps à ce qui les différencie vraiment — fonctionnalités, expériences et nouveaux paris.

À retenir

Le « travail lourd non différenciant » n’est pas juste du « travail difficile ». C’est un travail que beaucoup d’équipes répètent, qui doit être fait pour opérer de façon fiable, mais qui rapporte rarement un crédit unique sur le marché. Transformer ce travail en produit — en particulier en service managé — crée de la valeur double : vous baissez le coût d’exploitation du logiciel et vous augmentez le rythme de livraison.

Choisissez une chose à éliminer ce trimestre

Ne commencez pas par un réécriture plateforme grandeur nature. Commencez par une douleur récurrente qui apparaît dans les tickets, les pages d’astreinte ou le débordement de sprint. Bons candidats :

- Mise en place d’environnements variant selon les équipes

- Releases et rollbacks manuels

- Revues de sécurité répétitives pour les mêmes motifs

- Defaults de scaling/monitoring que tout le monde redécouvre à la dure

Choisissez une chose, définissez le « done » en langage clair (ex. « un nouveau service peut se déployer sans risque en 15 minutes ») et expédiez la plus petite version qui élimine le travail répété.

Lectures internes liées

Si vous voulez plus de patterns pratiques sur la pensée plateforme et les décisions build‑vs‑buy, parcourez /blog. Si vous évaluez quoi standardiser vs quoi offrir comme capacité interne (ou payante externe), /pricing peut aider à cadrer le packaging et les niveaux.

Prochaine étape : un backlog plateforme simple

Cette semaine, faites trois choses : auditez où le temps est perdu à cause d’opérations répétées, priorisez selon fréquence × douleur × risque, et construisez un backlog plateforme simple avec 3–5 items livrables de manière incrémentale.