Ce que cet article entend par « base de données documentaire »

Une base de données documentaire stocke les données sous forme de « documents » autonomes, généralement au format de type JSON. Plutôt que de répartir un objet métier sur plusieurs tables, un seul document peut contenir tout ce qui le concerne — champs, sous-champs et tableaux — un peu comme beaucoup d'applications représentent déjà les données dans le code.

Documents et collections (version en langage courant)

- Document : Un enregistrement que vous pouvez lire et écrire dans son ensemble (par exemple, un client, une commande, un ticket de support).

- Collection : Un groupe de documents similaires (par exemple une collection

users ou orders).

Les documents d'une même collection n'ont pas besoin d'avoir la même forme. Un document utilisateur peut contenir 12 champs, un autre 18, et les deux peuvent coexister.

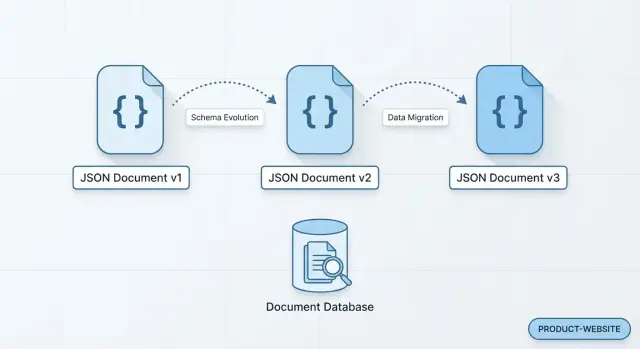

À quoi ressemble un « modèle de données qui change rapidement »

Imaginez un profil utilisateur. Vous commencez avec name et email. Le mois suivant, l'équipe marketing veut preferred_language. Ensuite, le support client demande timezone et subscription_status. Plus tard, vous ajoutez social_links (un tableau) et privacy_settings (un objet imbriqué).

Dans une base documentaire, vous pouvez généralement commencer à écrire ces nouveaux champs immédiatement. Les anciens documents peuvent rester tels quels tant que vous ne choisissez pas de les backfiller (ou pas).

Flexibilité — avec des compromis

Cette flexibilité peut accélérer le travail produit, mais elle déplace la responsabilité vers votre application et votre équipe : vous aurez besoin de conventions claires, de règles de validation optionnelles et d'un design de requêtes réfléchi pour éviter des données en désordre et incohérentes.

Ce que vous apprendrez dans cet article

Nous verrons pourquoi certains modèles changent si souvent, comment les schémas flexibles réduisent la friction, comment les documents correspondent aux requêtes réelles des applications, et les compromis à considérer avant de choisir un stockage documentaire plutôt qu'un relationnel — ou d'adopter une approche hybride.

Pourquoi certains modèles de données changent si souvent

Les modèles de données bougent rarement parce que le produit reste immobile. Ce qui commence par « stocker un profil utilisateur » se transforme vite en préférences, notifications, métadonnées de facturation, infos sur l'appareil, flags de consentement, et une foule d'autres détails qui n'existaient pas dans la première version.

La croissance du produit crée de nouveaux attributs

La plupart des changements de modèle résultent simplement de l'apprentissage. Les équipes ajoutent des champs quand elles :

- introduisent de nouvelles fonctionnalités (par ex. paliers de fidélité, abonnements, rôles)

- exécutent des expériences nécessitant de nouvelles propriétés de suivi

- collectent plus de contexte pour personnaliser l'expérience

Ces changements sont souvent incrémentaux et fréquents — de petites additions difficiles à planifier comme de grosses « migrations ».

Des versions du même entité doivent coexister

Les bases de données réelles gardent de l'historique. Les anciens enregistrements conservent la forme dans laquelle ils ont été écrits, tandis que les nouveaux adoptent la forme la plus récente. Vous pouvez avoir des clients créés avant l'existence de marketing_opt_in, des commandes antérieures à la prise en charge de delivery_instructions, ou des événements loggés avant la définition d'un nouveau champ source.

Vous ne « changez pas un seul modèle » — vous supportez plusieurs versions à la fois, parfois pendant des mois.

Des équipes parallèles et les microservices amplifient le changement

Quand plusieurs équipes publient en parallèle, le modèle de données devient une surface partagée. Une équipe paiements peut ajouter des signaux anti-fraude pendant qu'une équipe croissance ajoute des données d'attribution. Dans les microservices, chaque service peut stocker un concept "client" avec des besoins différents, qui évoluent indépendamment.

Sans coordination, le « schéma parfait unique » devient un goulot d'étranglement.

Intégrations et données semi-structurées imbriquées

Les systèmes externes envoient souvent des payloads partiellement connus, imbriqués ou inconsistants : webhooks, métadonnées partenaires, formulaires, télémétrie d'appareils. Même quand on normalise les éléments importants, on veut souvent garder la structure originale pour des audits, du debug ou un usage futur.

Toutes ces forces poussent les équipes vers un stockage qui tolère le changement avec grâce — surtout quand la vitesse de livraison compte.

Les schémas flexibles réduisent la friction quand les besoins changent

Quand un produit est encore en train de se définir, le modèle de données est rarement « terminé ». De nouveaux champs apparaissent, d'anciens deviennent optionnels, et différents clients peuvent nécessiter des informations légèrement différentes. Les bases documentaires sont prisées dans ces moments car elles permettent d'évoluer sans transformer chaque changement en un projet de migration de base.

Ajouter des champs quand vous en avez besoin (pas de migration de table)

Avec des documents JSON, ajouter une nouvelle propriété peut être aussi simple que l'écrire sur les nouveaux enregistrements. Les documents existants peuvent rester inchangés jusqu'à ce que vous décidiez de les backfiller. Cela signifie qu'une petite expérience — par exemple collecter un nouveau réglage de préférence — ne nécessite pas de coordonner un changement de schéma, une fenêtre de déploiement et un job de backfill juste pour commencer à apprendre.

Parfois, vous avez vraiment des variantes : un compte « free » a moins de réglages qu'un compte « enterprise », ou un type de produit a des attributs supplémentaires. Dans une base documentaire, il peut être acceptable que des documents d'une même collection aient des formes différentes, à condition que votre application sache comment les interpréter.

Plutôt que de tout forcer dans une structure rigide, vous pouvez garder :

- des champs partagés cohérents (comme

id, userId, createdAt)

- des champs variants présents uniquement quand ils sont pertinents

Des valeurs par défaut et la logique applicative gèrent ce qui manque

Les schémas flexibles ne signifient pas « pas de règles ». Un schéma commun consiste à considérer les champs manquants comme « utiliser une valeur par défaut ». Votre application peut appliquer des valeurs par défaut à la lecture (ou les définir à l'écriture), de sorte que les anciens documents se comportent correctement.

Expériences plus rapides et feature flags

Les feature flags introduisent souvent des champs temporaires et des rollouts partiels. Les schémas flexibles facilitent le déploiement d'un changement à une petite cohorte, le stockage d'un état supplémentaire seulement pour les utilisateurs flaggés, et l'itération rapide — sans attendre un travail de schéma avant de tester une idée.

Les documents correspondent à la façon dont beaucoup d'apps pensent les données

De nombreuses équipes produits pensent naturellement en termes de « chose que l'utilisateur voit à l'écran ». Une page de profil, une vue de commande, un tableau de projet — chacun correspond généralement à un objet applicatif unique avec une forme prévisible. Les bases documentaires supportent ce modèle mental en permettant de stocker cet objet comme un seul document JSON, avec beaucoup moins de traductions entre le code applicatif et le stockage.

Des objets applicatifs vers JSON avec moins d'étapes

Avec des tables relationnelles, une même fonctionnalité est souvent répartie sur plusieurs tables, clés étrangères et jointures. Cette structure est puissante, mais peut sembler être une cérémonie supplémentaire quand l'application contient déjà les données sous forme d'objet imbriqué.

Dans une base documentaire, vous pouvez souvent persister l'objet presque tel quel :

- un document

user qui correspond à votre classe/type User

- un document

project qui correspond à l'état Project

Moins de traduction signifie généralement moins de bugs de mapping et une itération plus rapide quand les champs changent.

Les données imbriquées restent ensemble

Les données réelles d'une appli sont rarement plates. Adresses, préférences, réglages de notifications, filtres sauvegardés, flags UI — tout cela est naturellement imbriqué.

Stocker des objets imbriqués dans le document parent maintient les valeurs liées proches, ce qui aide pour les requêtes « un enregistrement = un écran » : récupérer un document, rendre une vue. Cela peut réduire le besoin de jointures et les surprises de performance associées.

Propriété plus claire au sein des équipes

Lorsque chaque équipe fonctionnelle possède la forme de ses documents, les responsabilités deviennent plus claires : l'équipe qui livre la fonctionnalité fait évoluer son modèle de données. Cela marche bien dans des architectures microservices ou modulaires, où les changements indépendants sont la norme.

Itération produit et modèles de déploiement plus rapides

Les bases documentaires conviennent souvent aux équipes qui publient fréquemment car de petites additions de données nécessitent rarement une modification coordonnée de la base de données.

Itérations rapides avec moins de changements bloquants

Si un product manager demande « juste un attribut de plus » (par ex. preferredLanguage ou marketingConsentSource), un modèle documentaire permet généralement de commencer à écrire ce champ immédiatement. Il n'est pas toujours nécessaire de planifier une migration, verrouiller des tables ou négocier une fenêtre de déploiement entre plusieurs services.

Cela réduit le nombre de tâches pouvant bloquer un sprint : la base reste utilisable pendant que l'application évolue.

Déploiements plus simples lors de l'ajout de champs

Ajouter des champs optionnels aux documents JSON est généralement rétrocompatible :

- les anciens enregistrements n'ont simplement pas le nouveau champ

- les nouveaux enregistrements l'incluent

- les lecteurs traitent l'absence comme un cas normal

Ce schéma rend souvent les déploiements plus sereins : vous pouvez déployer l'écriture en premier (commencer à stocker le champ), puis mettre à jour les chemins de lecture et l'UI plus tard — sans mettre à jour immédiatement tous les documents existants.

Supporter plusieurs versions d'applications en production

Les systèmes réels mettent rarement tous les clients à jour en même temps. Vous pouvez avoir :

- des applications mobiles sur d'anciennes versions pendant des semaines

- des tests A/B et des déploiements canary

- plusieurs microservices déployant indépendamment

Avec des bases documentaires, les équipes conçoivent souvent des modèles pour des « versions mixtes » en traitant les champs comme additifs et optionnels. Les nouveaux producteurs peuvent ajouter des données sans casser les anciens consommateurs.

Pratique courante : écrire de nouveaux champs, lire avec des fallback

Un modèle de déploiement pratique :

- Écrire le nouveau champ dans la version la plus récente de l'app/service.

- Lire en appliquant une règle de repli : « si le champ est absent, utiliser l'ancienne valeur ou une valeur par défaut. »

- Optionnellement lancer un backfill en tâche de fond plus tard si la présence du champ sur les anciens documents devient importante.

Cette approche maintient une grande vélocité tout en réduisant les coûts de coordination entre changements de base et versions applicatives.

Modélisation orientée lecture pour des requêtes réelles

Refactorisez en toute confiance

Utilisez des instantanés et des retours en arrière quand une nouvelle forme de données nécessite une restauration rapide.

Une raison pour laquelle les équipes apprécient les bases documentaires est que vous pouvez modéliser les données selon la manière dont votre application les lit le plus souvent. Plutôt que de répartir un concept sur de nombreuses tables et de le reconstituer ensuite, vous pouvez stocker un objet « complet » (souvent en JSON) en un seul endroit.

Dénormalisation : garder les données liées ensemble

La dénormalisation consiste à dupliquer ou embarquer des champs liés afin que des requêtes fréquentes puissent être satisfaites par la lecture d'un seul document.

Par exemple, un document commande peut inclure des champs snapshot du client (nom, email au moment d'achat) et un tableau embarqué des lignes de commande. Ce design rend la requête « afficher mes 10 dernières commandes » rapide et simple, car l'UI n'a pas besoin de multiples recherches pour rendre la page.

Quand les données pour un écran ou une réponse API vivent dans un document, on obtient souvent :

- moins d'allers-retours réseau entre l'app et la base

- moins de jointures côté serveur pour assembler les résultats

Cela réduit la latence pour les chemins en lecture-intensive — fréquent dans les feeds, profils, paniers et tableaux de bord.

Embarquer vs référencer : règle pratique

Embarquez généralement quand :

- les données embarquées sont lues avec le parent

- les données embarquées sont bornées (ex. « jusqu'à 20 éléments »)

- vous tolérez les mettre à jour avec le document parent

Référencez souvent quand :

- l'entité liée est grande ou non bornée (ex. « tous les commentaires de tous les temps »)

- plusieurs parents pointent vers le même enfant (donnée partagée)

- l'enfant change fréquemment et vous ne voulez pas mettre à jour de nombreux documents

Il n'existe pas de forme documentaire universellement « meilleure ». Un modèle optimisé pour une requête peut en ralentir une autre (ou rendre les mises à jour plus coûteuses). L'approche la plus fiable est de partir des requêtes réelles — ce que votre appli a vraiment besoin de récupérer — puis d'ajuster le modèle au fur et à mesure que l'usage évolue.

Schéma-à-la-lecture et validation optionnelle

Le schéma-à-la-lecture signifie que vous n'avez pas à définir chaque champ et forme de table avant de stocker des données. Au lieu de cela, votre application (ou requête analytique) interprète la structure du document à la lecture. Concrètement, cela vous permet de livrer une nouvelle fonctionnalité qui ajoute preferredPronouns ou un nouveau champ imbriqué shipping.instructions sans coordonner une migration de base en amont.

À quoi ressemble le schéma-à-la-lecture au quotidien

La plupart des équipes ont toujours une « forme attendue » en tête — elle est juste appliquée plus tard et de façon sélective. Un document client peut avoir phone, un autre non. Une ancienne commande peut stocker discountCode en string, alors que les nouvelles utilisent un objet discount plus riche.

Prévenir les mauvaises données sans migrations lourdes

La flexibilité n'implique pas le chaos. Approches communes :

- règles de validation dans la base (là où c'est supporté) : exiger des champs clés comme

id, createdAt ou status, et restreindre les types pour les champs à haut risque.

- vérifications côté application : valider les entrées lors de l'écriture (couche API), rejeter ou normaliser les valeurs inattendues.

- jobs de « data hygiene » en arrière-plan : scanner périodiquement les valeurs aberrantes et les corriger ou les signaler.

Gouvernance légère qui s'étend

Un peu de cohérence suffit :

- conventions de nommage (ex.

camelCase, timestamps ISO-8601)

- un petit ensemble de champs requis pour les documents

- versioning des documents (ex.

schemaVersion: 3) pour que les lecteurs gèrent les anciennes et nouvelles formes en toute sécurité

Quand durcir la validation

Quand un modèle se stabilise — généralement après avoir identifié les champs vraiment centraux — introduisez une validation stricte pour ces champs et les relations critiques. Gardez les champs expérimentaux ou optionnels flexibles afin que la base continue de supporter l'itération rapide sans migrations permanentes.

Gérer l'historique des changements et l'évolution des événements

Prototyper des schémas évolutifs

Esquissez la structure de vos documents dans le chat et transformez-la rapidement en application opérationnelle.

Quand votre produit change chaque semaine, ce n'est pas seulement la forme « actuelle » des données qui compte. Il faut aussi raconter comment on en est arrivé là. Les bases documentaires conviennent bien à garder l'historique des changements car elles stockent des enregistrements autonomes qui peuvent évoluer sans réécrire tout l'historique.

Documents d'événements en append-only

Une approche courante est de stocker les changements comme un flux d'événements : chaque événement est un nouveau document (plutôt que de mettre à jour d'anciennes lignes). Par exemple : UserEmailChanged, PlanUpgraded, ou AddressAdded.

Chaque événement, en tant que document JSON autonome, capture le contexte complet du moment — qui l'a fait, ce qui a déclenché l'événement, et les métadonnées utiles ultérieurement.

Ajouter des champs sans réécrire l'historique

Les définitions d'événements évoluent rarement de manière stable. Vous pouvez ajouter source="mobile", experimentVariant, ou un nouvel objet imbriqué comme paymentRiskSignals. Avec le stockage documentaire, les anciens événements peuvent simplement omettre ces champs, et les nouveaux les inclure.

Vos lecteurs (services, jobs, dashboards) appliquent des valeurs par défaut pour les champs manquants au lieu de backfiller et migrer des millions d'enregistrements historiques juste pour ajouter un attribut.

Versioning pour des migrations progressives

Pour garder les consommateurs prévisibles, beaucoup d'équipes ajoutent un champ schemaVersion (ou eventVersion) dans chaque document. Cela permet un déploiement progressif :

- les producteurs commencent à écrire des événements en version 2

- les consommateurs lisent à la fois v1 et v2 pendant un temps

- vous migrez ou retirez les anciennes versions quand c'est pratique

Meilleure analytique et debug dans le temps

Un historique durable de « ce qui s'est passé » sert au-delà des audits. Les équipes analytics peuvent reconstruire un état à n'importe quel moment, et le support peut tracer des régressions en rejouant des événements ou en inspectant le payload exact qui a causé un bug. Sur plusieurs mois, cela accélère l'analyse des causes racines et renforce la fiabilité des rapports.

Compromis à connaître avant de choisir une base documentaire

Les bases documentaires facilitent le changement, mais elles ne suppriment pas le travail de conception — elles le déplacent. Avant de vous engager, clarifiez ce que vous échangez contre cette flexibilité.

Les transactions multi-entités peuvent être plus difficiles

Beaucoup de bases documentaires supportent des transactions, mais les transactions multi-documents peuvent être limitées, plus lentes ou plus coûteuses que dans une base relationnelle — surtout à grande échelle. Si votre flux de travail central exige des mises à jour « tout-ou-rien » sur plusieurs enregistrements (par ex. mise à jour d'une commande, du stock et d'une écriture de grand livre), vérifiez comment votre base gère cela et quel en est le coût en performance ou complexité.

Parce que les champs sont optionnels, les équipes peuvent accidentellement créer plusieurs « versions » d'un même concept en production (ex. address.zip vs address.postalCode). Cela casse des fonctionnalités en aval et complique la détection de bugs.

Une atténuation pratique est de définir un contrat partagé pour les types de documents clés (même léger) et d'ajouter des règles de validation optionnelles pour les champs critiques — paiement, prix, permissions, etc.

Les rapports ad hoc peuvent être plus difficiles sans standardisation

Si les documents évoluent librement, les requêtes analytiques deviennent plus compliquées : les analystes doivent écrire la logique pour plusieurs noms de champs et valeurs manquantes. Pour les équipes qui dépendent de beaucoup de reporting, prévoyez :

- standardiser des champs « reporting-friendly »

- exporter vers un entrepôt

- maintenir des modèles de lecture curatés pour l'analytics

La dénormalisation entraîne duplication et complexité de mise à jour

Embarquer des données liées (ex. snapshot client dans les commandes) accélère les lectures, mais duplique l'information. Quand une donnée partagée change, vous devez décider : mettre à jour partout, garder l'historique, ou tolérer une incohérence temporaire. Cette décision doit être intentionnelle — sinon vous risquez une dérive subtile des données.

Les bases documentaires conviennent parfaitement quand le changement est fréquent, mais elles récompensent les équipes qui traitent la modélisation, le nommage et la validation comme du travail produit continu, pas comme une configuration unique.

Cas d'usage courants où les bases documentaires excellent

Les bases documentaires stockent les données en documents JSON, ce qui les rend naturelles quand vos champs sont optionnels, changent fréquemment ou varient selon le client, l'appareil ou la gamme de produits. Plutôt que de forcer chaque enregistrement dans une table rigide, vous pouvez faire évoluer le modèle progressivement tout en gardant les équipes en mouvement.

Catalogues e‑commerce avec attributs changeants

Les données produit évoluent souvent : nouvelles tailles, matériaux, flags de conformité, bundles, descriptions régionales, champs spécifiques aux marketplaces. Avec des données imbriquées en JSON, un « produit » peut garder des champs de base (SKU, prix) tout en autorisant des attributs spécifiques à une catégorie sans semaines de redesign de schéma.

Profils utilisateurs et préférences avec champs optionnels

Les profils commencent petits et grossissent : réglages de notification, consentements marketing, réponses onboarding, feature flags, signaux de personnalisation. Dans une base documentaire, les utilisateurs peuvent avoir des ensembles de champs différents sans casser les lectures existantes. Cette flexibilité aide aussi le développement agile, où les expériences ajoutent et retirent des champs rapidement.

Gestion de contenu qui évolue dans le temps

Le contenu moderne n'est pas juste « une page ». C'est un mélange de blocs et composants — sections hero, FAQ, carrousels produits, embeds — chacun avec sa propre structure. Stocker les pages comme documents JSON permet aux éditeurs et devs d'introduire de nouveaux types de composants sans migrer immédiatement chaque page historique.

IoT et télémétrie avec payloads spécifiques aux appareils

La télémétrie varie souvent selon la version du firmware, le pack de capteurs ou le fabricant. Les bases documentaires gèrent bien ces modèles changeants : chaque événement peut inclure seulement ce que l'appareil connaît, tandis que le schéma-à-la-lecture permet aux outils analytiques d'interpréter les champs quand ils sont présents.

Si vous hésitez entre NoSQL et SQL, ce sont des scénarios où les bases documentaires offrent souvent une itération plus rapide et moins de friction.

Conseils pratiques de modélisation pour des modèles qui changent vite

Apprenez et soyez récompensé

Partagez ce que vous avez construit avec Koder.ai et gagnez des crédits au fur et à mesure de vos améliorations.

Quand votre modèle de données se stabilise encore, « assez bien et facile à changer » vaut mieux que « parfait sur le papier ». Ces habitudes pratiques vous aident à garder le rythme sans transformer la base en tiroir-poubelle.

1) Partez des patterns d'accès, pas des entités

Commencez chaque fonctionnalité en listant les lectures et écritures principales attendues en production : les écrans à rendre, les réponses API, et les mises à jour fréquentes.

Si une action utilisateur nécessite souvent « commande + items + adresse », modélisez un document capable de satisfaire cette lecture avec peu d'appels. Si une autre action doit « toutes les commandes par statut », assurez-vous de pouvoir interroger ou indexer ce chemin.

2) Décidez tôt d'imbriquer ou de référencer

L'embarquement (nesting) est excellent quand :

- les données enfants sont lues avec le parent

- l'ensemble enfant est borné (ex. 1–20 éléments)

La référence est meilleure quand :

- la collection enfant peut croître ou être non bornée

- l'enfant est partagé entre parents (ex. produit catalogue)

- l'enfant change fréquemment et vous ne voulez pas mettre à jour de nombreux documents

Vous pouvez mêler les deux : embarquer un snapshot pour la vitesse de lecture et garder une référence vers la source de vérité pour les mises à jour.

3) Ajoutez des garde-fous minimaux : validation + versioning

Même avec flexibilité, ajoutez des règles légères pour les champs dont vous dépendez (types, IDs requis, statuts autorisés). Incluez un schemaVersion (ou docVersion) pour que l'application gère les anciens documents en douceur et les migre progressivement.

4) Traitez le nettoyage et les migrations comme une routine normale

Considérez les migrations comme une maintenance périodique, pas un événement unique. À mesure que le modèle mûrit, planifiez de petits backfills et nettoyages (champs inutilisés, clés renommées, snapshots dénormalisés) et mesurez l'impact. Une checklist simple et un script de migration léger font beaucoup pour la propreté des données.

Le choix entre base documentaire et relationnelle dépend moins de « laquelle est meilleure » que du type de changement que votre produit subit le plus souvent.

Choisissez une base documentaire quand flexibilité et vitesse priment

Les bases documentaires conviennent quand la forme des données change fréquemment, quand des enregistrements peuvent avoir des champs différents, ou quand les équipes doivent livrer sans coordonner une migration à chaque sprint.

Elles sont adaptées quand l'application travaille naturellement avec des « objets complets » comme une commande (infos client + items + notes de livraison) ou un profil utilisateur (réglages + préférences + infos appareil) stockés ensemble en JSON.

Choisissez une base relationnelle quand la consistance stricte et les jointures dominent

Les bases relationnelles excellent quand vous avez besoin de :

- structure fortement appliquée (chaque enregistrement respecte les mêmes règles)

- reporting complexe sur de nombreuses entités (beaucoup de jointures)

- transactions couvrant plusieurs tables devant rester parfaitement cohérentes

Si votre travail vise surtout à optimiser des requêtes cross-table et de l'analytics, SQL est souvent un meilleur choix à long terme.

Envisagez une approche hybride quand la réalité est mixte

Beaucoup d'équipes utilisent les deux : relationnel pour le « core system of record » (facturation, stock, droits) et un store documentaire pour des vues en lecture optimisées ou des modèles qui évoluent vite (profils, métadonnées de contenu, catalogues produits). En microservices, chaque service choisit généralement le modèle de stockage qui correspond à ses frontières.

Le "hybride" peut aussi exister dans une base relationnelle : par exemple PostgreSQL peut stocker des champs semi-structurés avec JSON/JSONB aux côtés de colonnes typées — utile quand vous voulez consistance transactionnelle ET un endroit sûr pour des attributs évolutifs.

Où Koder.ai s'insère quand vous itérez vite

Si votre schéma change chaque semaine, le goulot est souvent la boucle end-to-end : mettre à jour les modèles, APIs, UI, migrations (si elles existent) et déployer sans risque. Koder.ai est conçu pour ce type d'itération. Vous décrivez la fonctionnalité et la forme de données en conversation, générez une implémentation web/backend/mobile fonctionnelle, puis la faites évoluer au fil des besoins.

En pratique, les équipes démarrent souvent avec un cœur relationnel (la stack backend de Koder.ai est Go avec PostgreSQL) et adoptent des patterns de type document là où ils sont pertinents (par ex. JSONB pour des attributs flexibles ou des payloads d'événements). Les snapshots et rollback de Koder.ai aident aussi quand une forme expérimentale doit être rapidement revertie.

Prochaines étapes : décider avec un petit pilote

Faites une courte évaluation avant de vous engager :

- Listez 5–10 requêtes réelles que le produit doit satisfaire (pas des hypothèses).

- Modélisez la même fonctionnalité dans les deux approches.

- Mesurez la vitesse d'itération : combien coûte la deuxième demande de changement ?

- Validez les besoins opérationnels (sauvegardes, monitoring, contrôle d'accès).

Si vous comparez des options, gardez le périmètre restreint et limitez le temps — puis étendez une fois que vous voyez quel modèle réduit le plus les surprises. Pour en savoir plus sur l'évaluation des compromis de stockage, voir /blog/document-vs-relational-checklist.