Ce que « prompting » signifie dans le travail d’ingénierie réel

Le prompting en ingénierie n’est pas « parler à une IA ». C’est l’action de fournir des entrées relues qui guident un assistant vers un résultat spécifique et vérifiable — similaire à la rédaction d’un ticket, d’une spec ou d’un plan de tests.

Un bon prompt est généralement un petit paquet composé de :

- But : ce qu’il faut construire ou décider

- Contraintes : langages, frameworks, budgets de performance, règles d’accessibilité, contrats d’API, limites de la plateforme

- Contexte : patterns de code existants, conventions de nommage, frontières architecturales

- Exemples : entrées/sorties d’exemple, cas limites, captures d’écran UI décrites en texte, endpoints existants

- Critères d’acceptation : comment vérifier que c’est correct (tests, règles de lint, comportements attendus)

Le prompting, c’est de la « rédaction de spec », mais plus concis

Dans des projets réels, vous ne demandez pas « une page de connexion ». Vous spécifiez « un formulaire de connexion qui respecte nos tokens de design, valide le format de l’email, affiche les erreurs en ligne et inclut des tests unitaires pour la validation et les états de soumission. » Le prompt devient un artefact concret que quelqu’un peut relire, modifier et réutiliser — souvent versionné dans le repo avec le code.

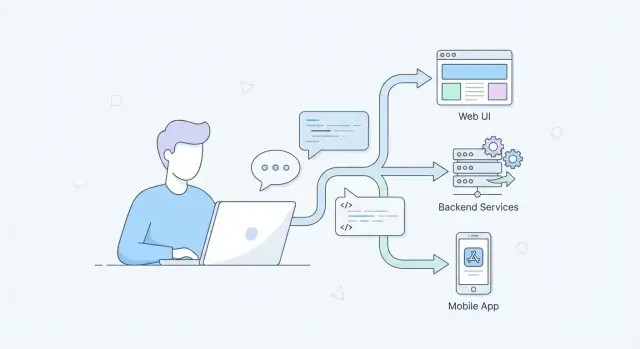

Pourquoi c’est important sur toute la stack

- UI / UX / frontend : les prompts peuvent encoder des exigences d’accessibilité, le comportement responsive, la microcopie et les règles d’API des composants pour éviter que le rendu ne s’éloigne du design system.

- APIs / backend : les prompts peuvent verrouiller la forme des requêtes/réponses, la sémantique d’erreur, l’idempotence, la pagination et les contraintes DB — réduisant le code du type « ça a l’air bon » qui casse sous la charge.

- Mobile : les prompts peuvent prendre en compte le mode hors-ligne, la batterie, la variabilité réseau, les flux d’autorisations, les contraintes UI spécifiques aux appareils et les règles des stores.

Ce que couvre (et évite) ce post

Cet article se concentre sur des pratiques répétables : patrons de prompt, workflows, tests de prompts et habitudes de revue d’équipe.

Il évite le battage et les « résultats magiques ». L’aide de l’IA est utile, mais seulement quand le prompt explicite les attentes — et quand les ingénieurs vérifient la sortie de la même manière qu’un code écrit par un humain.

Pourquoi le prompting devient une compétence centrale maintenant

Le prompting passe d’un « nice-to-have » à une compétence d’ingénierie quotidienne parce qu’il change la vitesse à laquelle les équipes peuvent convertir une idée en quelque chose de révocable.

Itération plus rapide sans sacrifier la rigueur

Les outils assistés par IA peuvent esquisser des variantes d’UI, proposer des formes d’API, générer des cas de test ou résumer des logs en quelques secondes. La rapidité est réelle — mais seulement si vos prompts sont suffisamment spécifiques pour produire des sorties évaluables. Les ingénieurs capables de transformer une intention floue en instructions claires obtiennent plus d’itérations utilisables par heure, et cela se cumule sur les sprints.

Les specs en langage naturel remplacent certains tickets — et elles exigent toujours de la précision

De plus en plus de travail se fait en langage naturel : notes d’architecture, critères d’acceptation, plans de migration, checklists de release et comptes rendus d’incidents. Ce sont toujours des « specs », même si elles n’ont pas l’air d’une spec traditionnelle. Le prompting, c’est l’art d’écrire ces specs pour qu’elles soient non ambiguës et testables : contraintes, cas limites, critères de succès et hypothèses explicites.

Un bon prompt ressemble souvent à un mini brief de design :

- Ce que vous construisez et pour qui

- Entrées/sorties et contraintes (performance, accessibilité, limites d’appareil)

- Non-objectifs et compromis

- Exemples et contre-exemples

L’IA s’intègre à l’IDE, au CI et au flux de docs

À mesure que les fonctionnalités IA pénètrent les IDE, les pull requests, les checks CI et les pipelines de docs, le prompting cesse d’être un chat occasionnel et devient partie intégrante du flux d’ingénierie quotidien. Vous demanderez du code, puis des tests, puis une revue des risques — chaque étape profite d’une structure de prompt cohérente et réutilisable.

Les équipes cross-fonctionnelles utilisent la même interface

Design, produit, QA et ingénierie collaborent de plus en plus via des outils IA partagés. Un prompt clair devient un objet frontière : tout le monde peut le lire, le critiquer et s’aligner sur ce que « terminé » signifie. Cette clarté partagée réduit les reprises et rend les revues plus rapides et plus sereines.

Passer d’une demande vague à un prompt clair et testable

Une demande vague comme « faire une page de login » force le modèle à deviner votre intention. Un prompt testable ressemble davantage à une mini-spec : il énonce les entrées, les sorties attendues, les cas limites et la façon de vérifier la correction.

Commencez par écrire ce que le système reçoit et ce qu’il doit produire.

- Entrées : actions utilisateur, payloads API, contraintes d’appareil

- Sorties : états UI, réponses, logs/métriques

- Cas limites : données invalides, timeouts, états vides, pannes partielles

Par exemple, remplacez « faire fonctionner le formulaire » par : « Quand l’email est invalide, afficher une erreur inline et désactiver l’envoi ; quand l’API renvoie 409, afficher ‘Account already exists’ et conserver les valeurs saisies. »

Ajouter des contraintes pour éviter des réponses « jolies mais fausses »

Les contraintes permettent d’aligner la sortie sur votre réalité.

Incluez des spécificités telles que :

- Stack tech (ex. React + TypeScript, Node + Express)

- Objectifs de performance (ex. rendu < 100ms, éviter les requêtes N+1)

- Accessibilité (niveau WCAG, navigation clavier, attentes ARIA)

- Gestion des erreurs (politique de retry, messages utilisateurs, logging)

Demander des compromis et du raisonnement

Plutôt que de demander uniquement du code, demandez au modèle d’expliquer les décisions et les alternatives. Cela facilite les revues et fait émerger des hypothèses cachées.

Exemple : « Proposez deux approches, comparez avantages/inconvénients en termes de maintenabilité et performance, puis implémentez l’option recommandée. »

Utiliser des exemples et des non-exemples

Les exemples réduisent l’ambiguïté ; les non-exemples préviennent les mauvaises interprétations.

Prompt faible : « Créer un endpoint pour mettre à jour un utilisateur. »

Prompt plus fort : « Concevez PATCH /users/{id}. Acceptez JSON { displayName?: string, phone?: string }. Rejetez les champs inconnus (400). Si l’utilisateur n’est pas trouvé (404). Validez le phone en E.164. Retournez l’utilisateur mis à jour en JSON. Incluez des tests pour phone invalide, payload vide et accès non autorisé. Ne changez pas l’email. »

Une règle utile : si vous ne pouvez pas écrire deux ou trois cas de test à partir du prompt, il n’est probablement pas encore assez précis.

Développement web : prompts pour l’UI, l’UX et la qualité frontend

Le prompting web fonctionne mieux quand vous traitez le modèle comme un coéquipier junior : il a besoin de contexte, de contraintes et d’une définition de « terminé ». Pour le travail UI, cela signifie spécifier les règles de design, les états, l’accessibilité et comment le composant doit être vérifié.

Génération de composants avec de vraies contraintes de design

Au lieu de « Construire un formulaire de login », fournissez le design system et les cas limites :

- Mise en page : breakpoints responsive, échelle d’espacement, largeurs max

- États : défaut, chargement, désactivé, erreur, succès

- A11y : labels, ordre de focus, interactions clavier, ARIA

Exemple de prompt : « Génère un LoginForm React en utilisant nos composants Button/Input. Inclure l’état de chargement au submit, la validation inline et des messages d’erreur accessibles. Fournir des stories Storybook pour tous les états. »

Refactoriser du code UI en toute sécurité

Les refactors se déroulent mieux quand vous définissez des garde-fous :

« Refactorez ce composant pour extraire UserCardHeader et UserCardActions. Conservez l’API des props existantes, préservez les noms de classes CSS et ne modifiez pas le rendu visuel. Si vous devez renommer, fournissez une note de migration. »

Cela réduit les régressions et aide à maintenir la cohérence des noms et du style.

Cohérence contenu + UI

Demandez explicitement la microcopie et les textes d’état, pas seulement le balisage :

« Proposez la microcopie pour l’état vide, l’erreur réseau et l’accès refusé. Gardez le ton neutre et concis. Retournez la copie + l’endroit où elle apparaît dans l’UI. »

Débogage avec étapes de reproduction et logs

Pour les bugs frontend, les prompts doivent agréger les preuves :

« Étant donné ces étapes de reproduction, les logs console et la stack trace, proposez les causes probables, puis classez les corrections par confiance. Incluez comment vérifier dans le navigateur et dans un test unitaire. »

Quand les prompts incluent contraintes et vérification, vous obtenez des livrables UI plus cohérents, accessibles et relisables.

Développement backend : prompts pour les APIs, les données et la fiabilité

Le backend est rempli de cas limites : pannes partielles, données ambiguës, retries et surprises de performance. De bons prompts vous aident à fixer des décisions qu’on a tendance à balayer d’un revers dans une conversation, mais qui coûtent cher en production.

Prompts pour la conception d’API (routes, schémas, codes)

Au lieu de demander « construis une API », poussez le modèle à produire un contrat que vous pouvez relire.

Demandez :

- Routes et verbes, avec un nommage clair des ressources

- Schémas request/response (champs requis vs optionnels)

- Codes d’état pour succès et erreurs

- Stratégie de pagination (curseur vs offset) et tri

- Règles d’idempotence pour les écritures (surtout POST)

Exemple de prompt :

Design a REST API for managing subscriptions.

Return:

1) Endpoints with method + path

2) JSON schemas for request/response

3) Status codes per endpoint (include 400/401/403/404/409/422/429)

4) Pagination and filtering rules

5) Idempotency approach for create/cancel

Assume multi-tenant, and include tenant scoping in every query.

(Ne modifiez pas ce bloc de code — il doit rester intact.)

Validation des données et gestion d’erreur

Demandez une validation cohérente et une « forme d’erreur » stable pour que les clients puissent gérer les problèmes de manière prévisible.

Contraintes utiles :

- Valider à la frontière (DTO/input), puis à nouveau à la persistence si nécessaire

- Utiliser des codes d’erreur typés (plutôt que des chaînes libres)

- Mapper les erreurs de domaine aux statuts HTTP (ex. 409 pour conflit, 422 pour validation sémantique)

- Inclure des correlation IDs dans les réponses et les logs

Les modèles génèrent souvent du code correct mais lent à moins que vous ne demandiez explicitement des choix de performance. Indiquez le trafic attendu, les cibles de latence et la taille des données, puis demandez des compromis.

Bonnes additions :

- “Supposez 1k RPS et un objectif p95 de 50 ms”

- “Évitez les requêtes N+1 ; montrez le plan de requête ou les index”

- “Suggérez des couches de cache (en-mémoire vs Redis) et la stratégie d’invalidation”

- “Regroupez les appels externes ; ajoutez timeouts et circuit breakers”

Observabilité : logs, métriques, traces, alertes

Traitez l’observabilité comme faisant partie de la feature. Demandez ce que vous mesurerez et ce qui déclenchera une action.

Demandez au modèle de produire :

- Logs structurés (nom d’événement + champs clés, sans données sensibles)

- Métriques (RPS, taux d’erreur, latence p50/p95/p99, profondeur des files)

- Spans de trace autour de la DB et des appels externes

- Règles d’alerte actionnables (symptôme + causes probables + indices de runbook)

Développement mobile : prompts pour contraintes et appareils réels

Rendez les prompts vérifiables

Créez un petit contrat de prompt pour les changements, hypothèses, risques et tests, puis itérez dans Koder.ai.

Les applis mobiles échouent non seulement à cause d’un « mauvais code », mais parce que les appareils réels sont désordonnés : réseau instable, batterie, exécution en arrière-plan limitée, et de petites erreurs UI deviennent des blocages d’accessibilité. Les prompts mobiles efficaces demandent au modèle de concevoir pour les contraintes, pas seulement pour les fonctionnalités.

Prompts pour hors-ligne, batterie et variabilité réseau

Au lieu de « Ajouter un mode hors-ligne », demandez un plan qui explicite les compromis :

- « Concevez une approche offline-first pour cet écran. Spécifiez quelles données sont cachées, les règles d’invalidation et ce que l’UI affiche pour des données “périmées mais utilisables”. »

- « Étant donné une connectivité intermittente (2G–5G, captive portals), proposez des règles de retry/backoff et des messages utilisateurs. Incluez les cas limites comme la mise en arrière-plan de l’app pendant une requête. »

- « Suggérez des moyens de réduire l’impact sur la batterie pour cette fonctionnalité. Considérez les tâches en arrière-plan, l’usage de la localisation, les intervalles de polling et quand arrêter le travail. »

Ces prompts forcent le modèle à penser au-delà du happy path et à produire des décisions relisables.

Gestion d’état et flux de navigation

Les bugs mobiles viennent souvent d’un état « presque correct » jusqu’à ce que l’utilisateur appuie sur retour, fasse pivoter l’écran ou revienne d’un deep link.

Utilisez des prompts qui décrivent les flux :

« Voici les écrans et événements (login → onboarding → home → details). Proposez un modèle d’état et des règles de navigation. Incluez comment restaurer l’état après une mort de processus et comment gérer les taps en double et les retours rapides. »

Si vous collez un diagramme de flux simplifié ou une liste de routes, le modèle peut produire une checklist de transitions et de modes de défaillance à tester.

Demandez une revue spécifique à la plateforme, pas des conseils UI génériques :

« Revuez cet écran par rapport aux iOS Human Interface Guidelines / Material Design et à l’accessibilité mobile. Listez des problèmes concrets : taille des cibles tactiles, contraste, mise à l’échelle dynamique des polices, labels pour lecteur d’écran, navigation clavier et usage des haptiques. »

Triage de crashs avec stack traces + contexte appareil

Les rapports de crash deviennent exploitables lorsqu’on associe la stack trace au contexte :

« Étant donné cette stack trace et les infos appareil (version OS, modèle, version de l’app, pression mémoire, étapes de reproduction), proposez les causes les plus probables, quels logs/métriques ajouter et un correctif sûr avec plan de déploiement. »

Cette structure transforme « Que s’est-il passé ? » en « Que fait-on maintenant ? », là où le prompting rapporte le plus sur mobile.

Patrons de prompt qui fonctionnent sur web, backend et mobile

Les bons prompts sont réutilisables. Les meilleurs ressemblent à une petite spécification : intention claire, contexte suffisant pour agir et sortie vérifiable. Ces patrons fonctionnent que vous amélioriez une UI, façonniez une API ou déboguiez un crash mobile.

Structure « Spec Prompt »

Une structure fiable :

- Rôle : qui le modèle doit incarner (ex. « senior frontend engineer »)

- But : ce à quoi ressemble le succès

- Contexte : fichiers pertinents, plateforme, contraintes, comportement actuel

- Contraintes : performance, accessibilité, compatibilité, libs, versions OS

- Exemples : entrées/sorties, cas limites, exemples à faire/ne pas faire

- Format de sortie : ce qu’il doit renvoyer (puces, patch, JSON)

Cela réduit l’ambiguïté sur chaque domaine : web (a11y + support navigateurs), backend (cohérence + contrats d’erreur), mobile (batterie + contraintes d’appareil).

Pas-à-pas vs sortie directe

Utilisez la sortie directe quand vous savez déjà ce dont vous avez besoin : « Génère un type TypeScript + payload d’exemple. » C’est plus rapide et évite de longues explications.

Demandez un bref raisonnement sur les compromis quand les décisions comptent : choisir une stratégie de pagination, décider des frontières de cache ou diagnostiquer un test mobile instable. Un compromis pratique : « Explique brièvement les hypothèses et les compromis, puis donne la réponse finale. »

« Contracts » de prompt (sorties lintables)

Traitez les prompts comme des mini-contrats en exigeant une sortie structurée :

{

"changes": [{"file": "", "summary": "", "patch": ""}],

"assumptions": [],

"risks": [],

"tests": []

}

Cela rend les résultats relisables, faciles à diff et plus simples à valider par schéma.

Réduire les hallucinations

Ajoutez des garde-fous :

- Exigez que le modèle liste ses hypothèses et pose des questions si des informations manquent.

- Demandez-lui de signaler l’incertitude : « Si tu n’es pas sûr, dis-le et propose des options. »

- Demandez des étapes de vérification : commandes, cas de test, ou où chercher dans le code.

- Quand il fait référence à des faits externes, demandez qu’il cite ses sources (ou indique explicitement « aucune source utilisée »).

Workflow d’ingénierie : faire des prompts des artefacts de premier ordre

Élaborez une interface React

Décrivez composants, états et règles d'accessibilité, puis générez une interface React révisable.

Si votre équipe utilise l’IA régulièrement, les prompts cessent d’être des « messages de chat » et deviennent des actifs d’ingénierie. Le moyen le plus rapide d’améliorer la qualité est de traiter les prompts comme vous traitez le code : intention claire, structure cohérente et historique de changements.

Traitez les prompts comme du code

Attribuez une ownership et conservez les prompts en contrôle de version. Quand un prompt change, vous devriez pouvoir répondre : pourquoi, quoi a été amélioré et quoi a cassé. Une approche légère : un dossier /prompts dans chaque repo, avec un fichier par workflow (ex. pr-review.md, api-design.md). Les changements aux prompts se passent en pull request, comme n’importe quelle contribution.

Même si vous utilisez une interface de type chat comme Koder.ai, les entrées qui produisent du code de production doivent être versionnées (ou au moins capturées comme templates) afin que les équipes puissent reproduire les résultats entre sprints.

Utiliser des templates pour le travail répétable

La plupart des équipes répètent les mêmes tâches assistées par IA : revues PR, résumés d’incident, migrations de données, notes de release. Créez des templates de prompt qui standardisent les entrées (contexte, contraintes, définition du done) et les sorties (format, checklists, critères d’acceptation). Cela réduit la variance entre ingénieurs et facilite la vérification.

Un bon template inclut :

- But (résultat attendu)

- Contraintes (langages, frameworks, limites temps/mémoire)

- Contexte projet (liens vers fichiers, notes d’architecture)

- Format de sortie (tables, diffs, plan pas à pas)

Rendre les validations humaines explicites

Documentez où des humains doivent approuver les sorties — en particulier pour la sécurité, la conformité, les edits de DB prod et tout ce qui touche à auth ou paiements. Placez ces règles près du prompt (ou dans /docs/ai-usage.md) pour que personne ne s’en remette à la mémoire.

Quand l’outillage le permet, capturez des mécaniques d’itération sûre dans le workflow lui-même. Par exemple, des plateformes comme Koder.ai supportent des snapshots et rollback, ce qui facilite l’expérimentation avec des changements générés, la revue des diffs et le revert propre si un prompt produit un refactor dangereux.

Quand les prompts deviennent des artefacts de premier ordre, vous gagnez en répétabilité, auditabilité et livraison assistée par IA plus sûre — sans ralentir l’équipe.

Tester et évaluer la qualité des prompts

Traitez les prompts comme tout autre asset d’ingénierie : si vous ne pouvez pas les évaluer, vous ne pouvez pas les améliorer. « On dirait que ça marche » est fragile — surtout quand le même prompt sera réutilisé par une équipe, exécuté en CI ou appliqué à de nouveaux codebases.

Construire des cas de test golden

Créez une petite suite « entrées connues → sorties attendues » pour vos prompts. L’important est que les sorties soient vérifiables :

- Préférez les sorties structurées (JSON, tables, titres explicites) au texte libre

- Incluez des cas limites (entrées vides, longues chaînes, locales inhabituelles, chemins d’erreur)

- Versionnez le prompt et les cas golden ensemble pour que les changements soient volontaires

Exemple : un prompt qui génère un contrat d’erreur d’API doit toujours produire les mêmes champs, avec un nommage et des codes cohérents.

Évaluation par diff

Quand vous mettez à jour un prompt, comparez la nouvelle sortie à l’ancienne et demandez : qu’est-ce qui a changé et pourquoi ? Les diffs rendent les régressions évidentes (champs manquants, tonalité différente, ordre modifié) et aident les réviseurs à se concentrer sur le comportement plutôt que sur le style.

Automatiser les checks dans le pipeline

Les prompts peuvent être testés avec la même discipline que le code :

- Validation de schéma pour les sorties JSON

- Tests unitaires qui affirment des exigences clés (ex. inclut la pagination, gère les nulls)

- Analyse statique pour le code généré

- Vérifications « Ça compile et s’exécute ?» pour attraper des erreurs de syntaxe et dépendances

Si vous générez des applications complètes via un workflow plateforme — comme le processus de build chat-driven de Koder.ai — ces checks sont encore plus importants car vous pouvez produire rapidement de larges changements. La vitesse doit augmenter le débit des revues, pas réduire la rigueur.

Mesurer les résultats réels

Enfin, suivez si les prompts améliorent réellement la livraison :

- Temps économisé par tâche (baseline vs assisté par IA)

- Taux de défauts (bugs détectés en QA/production)

- Taux de reprise (à quel point les sorties nécessitent des retouches manuelles)

Si un prompt fait gagner des minutes mais augmente la reprise, ce n’est pas « bon », c’est juste rapide.

Sécurité, confidentialité et contrôles de risque pour le travail assisté par IA

Utiliser un LLM en ingénierie change la notion de « safe by default ». Le modèle ne sait pas quelles informations sont confidentielles et peut générer du code qui semble correct tout en introduisant des vulnérabilités. Traitez l’assistance IA comme un outil nécessitant des garde-fous — comme le CI, le scan de dépendances ou la revue de code.

Ne pas divulguer de secrets (même accidentellement)

Supposez que tout ce que vous collez dans un chat peut être stocké, loggué ou revu. N’incluez jamais de clés API, tokens d’accès, certificats privés, données clients ou URLs internes. Utilisez des placeholders et des exemples minimaux synthétiques.

Si vous avez besoin d’aide pour déboguer, partagez :

- Le plus petit snippet reproductible avec des valeurs factices

- Un extrait de log redacted (supprimez IDs, emails, tokens)

- Une indication claire de ce qui est public vs confidentiel

Créez un workflow d’équipe pour la redaction (templates et checklists) afin que les gens n’inventent pas leurs propres règles sous pression.

Modélisez les menaces sur la sortie, pas seulement sur l’entrée

Le code généré par l’IA peut introduire des problèmes classiques : risques d’injection, valeurs par défaut non sécurisées, contrôles d’autorisation manquants, choix de dépendances fragiles ou crypto faible.

Une habitude pratique est de demander au modèle de critiquer sa propre sortie :

- « Listez les risques de sécurité possibles dans ce code, classés par impact. »

- « Quelles entrées pourraient être contrôlées par un attaquant ? »

- « Qu’est-ce qui doit être validé côté serveur, et comment ? »

Exiger des prompts de revue sécurité pour les zones sensibles

Pour l’authentification, la cryptographie, les checks de permission et le contrôle d’accès, intégrez des « prompts de revue sécurité » dans la définition du done. Accompagnez-les d’une revue humaine et de checks automatisés (SAST, scan de dépendances). Si vous maintenez des standards internes, renvoyez-les dans le prompt (ex. « Suivez nos guidelines d’auth dans /docs/security/auth »).

L’objectif n’est pas d’interdire l’IA, mais de rendre le comportement sûr le plus simple.

Lancez un prototype Flutter

Transformez un prompt axé sur le flux en une base d'application Flutter prête à itérer.

Le prompting monte en échelle lorsqu’il est traité comme une compétence d’équipe, pas comme une astuce individuelle. L’objectif n’est pas « mieux prompt » en soi — c’est moins de malentendus, des revues plus rapides et des résultats plus prévisibles de l’ingénierie assistée par IA.

Définissez ce que « bon » signifie

Avant que quiconque écrive des prompts, alignez-vous sur une définition partagée du done. Transformez « améliorer » en attentes vérifiables : critères d’acceptation, standards de code, conventions de nommage, exigences d’accessibilité, budgets de performance et besoins d’observabilité.

Une approche pratique est d’inclure un petit « contrat de sortie » dans les prompts :

- Ce que le changement doit faire (critères d’acceptation)

- Ce qu’il ne doit pas faire (non-objectifs, contraintes)

- Comment il doit être livré (fichiers à modifier, style de code, tests requis)

Quand les équipes font cela systématiquement, la qualité des prompts devient relisible — comme le code.

Pair prompting : écrire + sonder

Le pair prompting reflète le pair programming : une personne écrit le prompt, l’autre le révise et le sonder activement. Le rôle du réviseur : poser des questions du type :

- Quels inputs, cas limites et états d’erreur sont sous-entendus mais non-énoncés ?

- Quelles dépendances ou règles produit pourraient être violées ?

- Quels tests prouvent que c’est correct ?

Cela détecte l’ambiguïté tôt et empêche l’IA de construire, en toute confiance, la mauvaise chose.

Créez un playbook de prompts léger avec des exemples tirés de votre codebase : « template endpoint API », « template refactor composant frontend », « template contraintes perf mobile », etc. Stockez-le là où les ingénieurs travaillent déjà (wiki ou repo) et liez-le dans les templates de PR.

Si votre organisation utilise une plateforme unique pour la construction cross-fonctionnelle (produit + design + ingé), capturez aussi ces templates dedans. Par exemple, les équipes Koder.ai standardisent souvent les prompts autour d’un mode planning (s’accorder d’abord sur le périmètre et les critères), puis génèrent les étapes d’implémentation et les tests.

Créer des boucles de feedback depuis les problèmes réels

Quand un bug ou un incident remonte à un prompt peu clair, ne corrigez pas seulement le code — mettez à jour le template de prompt. Avec le temps, vos meilleurs prompts deviennent la mémoire institutionnelle, réduisant les erreurs répétées et le temps d’onboarding.

Plan d’adoption pratique pour votre équipe d’ingénierie

Adopter le prompting IA fonctionne mieux comme un petit changement d’ingénierie, pas une vaste « initiative IA ». Traitez-le comme toute pratique de productivité : commencez petit, mesurez l’impact, puis étendez.

Semaine 1 : Choisissez quelques cas d’usage à forte valeur

Choisissez 3–5 cas d’usage par équipe fréquents, peu risqués et faciles à évaluer. Exemples :

- Génération d’échafaudages d’API (handlers, routing, snippets OpenAPI)

- Génération de tests (unitaires, cas limites, checks de régression)

- Variantes de composants UI (états, notes d’accessibilité)

- Aides aux migrations (migrations SQL, scripts de validation de données)

Rédigez ce que « bien » signifie (temps économisé, moins de bugs, docs plus claires) pour que l’équipe ait un objectif partagé.

Semaines 2–3 : Créez un petit jeu de templates

Construisez une petite librairie de templates de prompt (5–10) et itérez chaque semaine. Gardez chaque template ciblé et structuré : contexte, contraintes, sortie attendue et une définition courte du done. Stockez les templates où les ingénieurs travaillent déjà (dossier repo, wiki interne ou système de ticket).

Si vous évaluez une approche plateforme, considérez si elle supporte le cycle complet : génération de code, exécution de tests, déploiement et export de sources. Par exemple, Koder.ai peut créer des apps web, backend et Flutter à partir d’un chat, supporte l’export du code source, et fournit des options de déploiement — utile quand vous voulez que les prompts produisent des builds reproductibles.