17 août 2025·8 min

Pourquoi les workflows pilotés par l'IA réduisent l'abstraction prématurée

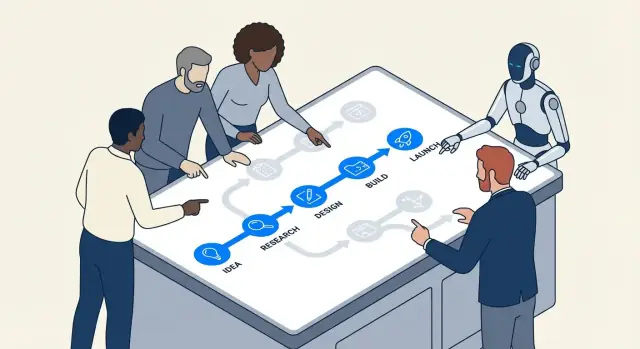

Les workflows pilotés par l'IA poussent les équipes vers des étapes concrètes, un feedback rapide et des résultats mesurables — réduisant la tentation de sur-abstraire et sur-ingénier dès le départ.

Ce que nous entendons par abstraction prématurée et sur-ingénierie

L'abstraction prématurée, c'est construire une « solution générale » avant d'avoir vu suffisamment de cas réels pour savoir ce qui doit être généralisé.

Au lieu d'écrire le code le plus simple qui résout le problème d'aujourd'hui, on invente un cadre : interfaces supplémentaires, systèmes de configuration, points d'extension ou modules réutilisables — parce qu'on suppose qu'on en aura besoin plus tard.

La sur-ingénierie est l'habitude plus large qui la sous-tend. C'est ajouter de la complexité qui ne rapporte pas aujourd'hui : couches supplémentaires, patrons, services ou options qui n'allègent pas clairement le coût ou le risque maintenant.

Exemples en langage courant

Si votre produit n'a qu'un seul plan de facturation et que vous construisez un moteur de tarification multi-tenant « au cas où », c'est de l'abstraction prématurée.

Si une fonctionnalité pourrait être une fonction simple, mais que vous la décomposez en six classes avec des factories et des registries pour la rendre « extensible », c'est de la sur-ingénierie.

Pourquoi cela apparaît tôt dans les projets

Ces habitudes sont courantes au début parce que les projets initiaux sont pleins d'incertitudes :

- Peur de refaire : Les équipes craignent que si elles construisent quelque chose de simple, elles devront le réécrire plus tard.

- Exigences floues : Quand personne n'est sûr de ce que le produit deviendra, il est tentant de bâtir un squelette flexible qui peut « tout gérer ».

- Pression sociale : Les ingénieurs veulent souvent anticiper et « bien faire », même quand le « bien » n'est pas encore connaissable.

Le problème, c'est que « flexible » signifie souvent « plus difficile à changer ». Les couches supplémentaires peuvent rendre les modifications quotidiennes plus lentes, le débogage plus ardu et l'intégration de nouveaux venus plus pénible. Vous payez le coût de la complexité immédiatement, tandis que les bénéfices peuvent ne jamais arriver.

Où l'IA aide (et où elle n'aide pas)

Les flux de travail pilotés par l'IA peuvent encourager les équipes à rester concrètes — en accélérant le prototypage, en produisant des exemples rapidement et en facilitant la validation des hypothèses. Cela peut réduire l'anxiété qui alimente la conception spéculative.

Mais l'IA ne remplace pas le jugement d'ingénierie. Elle peut générer des architectures et des abstractions astucieuses à la demande. Votre travail reste de poser la question : Quelle est la chose la plus simple qui marche aujourd'hui, et quelles preuves justifieraient d'ajouter une structure demain ?

Des outils comme Koder.ai sont particulièrement efficaces ici parce qu'ils facilitent le passage d'une invite de chat à une tranche exécutable d'une vraie application (web, backend ou mobile) rapidement — ainsi les équipes peuvent valider ce qui est nécessaire avant de « pérenniser » quoi que ce soit.

Comment les workflows IA poussent les équipes vers du travail concret

Le développement assisté par IA tend à commencer par quelque chose de tangible : un bug précis, une petite fonctionnalité, une transformation de données, un écran UI. Ce cadrage est important. Quand le flux commence par « voici la chose exacte dont nous avons besoin », les équipes ont moins tendance à inventer une architecture généralisée avant d'avoir appris ce que le problème est réellement.

Des prompts concrets produisent du code concret

La plupart des outils d'IA répondent mieux quand vous fournissez des éléments spécifiques : entrées, sorties, contraintes et un exemple. Une invite comme « concevoir un système de notifications flexible » est vague, donc le modèle remplira souvent les blancs avec des couches supplémentaires — interfaces, factories, configuration — parce qu'il ne voit pas les véritables bornes.

Mais quand le prompt est ancré, la sortie l'est aussi :

- Entrée : « Étant donné ces statuts de commande… »

- Sortie : « Retourner le message utilisateur et l'appel à l'action… »

- Contraintes : « Doit être rapide ; pas d'appel DB ; nécessite i18n… »

- Exemples : « Pour

PENDING_PAYMENTafficher … »

Cela pousse naturellement les équipes à implémenter une tranche étroite qui fonctionne de bout en bout. Une fois que vous pouvez l'exécuter, la relire et la montrer, vous opérez dans la réalité plutôt que dans la spéculation.

« Faire fonctionner d'abord » devient la règle par défaut

Le pair-programming avec IA rend l'itération bon marché. Si une première version est un peu brouillonne mais correcte, l'étape suivante est généralement « refactorisez ceci » plutôt que « concevoir un système pour tous les cas futurs ». Cette séquence — code qui marche d'abord, raffinage ensuite — réduit l'impulsion de construire des abstractions qui n'ont pas mérité leur complexité.

En pratique, les équipes trouvent un rythme :

- Demander une implémentation minimale.

- La tester sur des exemples réels.

- Ajuster en fonction de ce qui casse ou semble maladroit.

- Ce n'est qu'ensuite qu'on extrait un helper, un module ou un patron.

La spécificité expose tôt les exigences manquantes

Les prompts vous forcent à énoncer ce que vous voulez vraiment. Si vous ne pouvez pas définir clairement les entrées/sorties, c'est un signal que vous n'êtes pas prêt à abstraire — vous découvrez encore des exigences. Les outils d'IA récompensent la clarté, donc ils entraînent subtilement les équipes à clarifier d'abord et généraliser plus tard.

Les boucles de feedback courtes réduisent la conception spéculative

Un retour rapide change ce que « bonne ingénierie » signifie. Quand vous pouvez tester une idée en quelques minutes, l'architecture spéculative cesse d'être une couverture de sécurité rassurante et commence à ressembler à un coût évitable.

La boucle : draft → run → inspect → adjust

Les workflows pilotés par l'IA compressent le cycle :

- Draft : demander à l'assistant une petite tranche fonctionnelle (un script, un handler, une requête)

- Run : l'exécuter immédiatement avec des entrées réelles

- Inspect : examiner les sorties, les logs, les cas limites et comment ça échoue

- Adjust : affiner le code et l'exigence en même temps

Cette boucle récompense le progrès concret. Au lieu de débattre « nous aurons besoin d'un système de plugins » ou « cela doit supporter 12 sources de données », l'équipe voit ce que le problème actuel exige réellement.

Pourquoi la vitesse réduit l'architecture spéculative

L'abstraction prématurée survient souvent quand les équipes craignent le changement : si les changements sont coûteux, on essaie de prédire l'avenir et de le concevoir. Avec des boucles courtes, le changement est peu coûteux. Cela inverse l'incitation :

- Vous pouvez différer la généralisation tant que le travail répété ne prouve pas son besoin.

- Vous découvrez les contraintes réelles (performance, forme des données, comportement utilisateur) tôt.

- Vous cessez de construire « au cas où » parce que vous pouvez itérer « au bon moment ».

Un exemple simple : un endpoint avant le framework

Supposons que vous ajoutez une fonctionnalité interne « exporter en CSV ». Le chemin sur-ingénieux commence par concevoir un framework d'export générique, plusieurs formats, des files jobs et des couches de configuration.

Un chemin à boucle rapide est plus petit : générer un seul endpoint /exports/orders.csv (ou un script ponctuel), l'exécuter sur des données de staging et inspecter la taille du fichier, le temps d'exécution et les champs manquants. Si, après deux ou trois exports, vous observez des motifs répétés — même logique de pagination, filtres partagés, en-têtes communs — alors une abstraction mérite d'exister car elle est fondée sur des preuves, pas sur des conjectures.

Les changements incrémentaux font mériter l'abstraction

La livraison incrémentale change l'économie du design. Quand vous livrez en petites tranches, chaque couche « agréable à avoir » doit prouver qu'elle aide maintenant — pas dans un futur imaginé. C'est là que les workflows IA réduisent discrètement l'abstraction prématurée : l'IA excelle à proposer des structures, mais ces structures sont les plus faciles à valider quand le périmètre est petit.

Un petit périmètre rend testables les suggestions IA

Si vous demandez à un assistant de refactorer un module unique ou d'ajouter un nouvel endpoint, vous pouvez rapidement vérifier si son abstraction améliore vraiment la clarté, réduit la duplication ou facilite le changement suivant. Avec un petit diff, le feedback est immédiat : les tests passent ou échouent, le code est plus lisible ou moins, et la fonctionnalité se comporte correctement ou non.

Quand le périmètre est large, les suggestions IA peuvent paraître plausibles sans être prouvablement utiles. Vous pourriez accepter un framework généralisé parce qu'il « a l'air propre », pour découvrir plus tard qu'il complique les cas réels.

Les composants micros révèlent ce qu'il faut garder (et ce qu'il faut supprimer)

Travailler de façon incrémentale encourage à construire d'abord de petits composants jetables — helpers, adaptateurs, formes de données simples. Après quelques itérations, il devient évident quelles pièces sont réutilisées par plusieurs fonctionnalités (à garder) et lesquelles n'étaient que pour une expérience ponctuelle (à supprimer).

Les abstractions deviennent alors un enregistrement de réutilisation réelle, pas de réutilisation prédite.

La livraison incrémentale réduit le risque de refactorisation

Quand les changements sont déployés en continu, refactoriser fait moins peur. Vous n'avez pas besoin de « bien faire » dès le départ car vous pouvez faire évoluer le design au fur et à mesure que les preuves s'accumulent. Si un patron mérite sa place — réduisant le travail répété sur plusieurs incréments — le promouvoir en abstraction est un mouvement à faible risque et haute confiance.

Cela inverse la posture par défaut : construire la version la plus simple d'abord, puis abstraire seulement quand l'étape incrémentale suivante en tire clairement avantage.

L'expérimentation facile favorise la simplicité plutôt que le « big design »

Concevez pour l'étape suivante

Créez un écran React pour le flux principal, puis étendez seulement si la réalité l'exige.

Les workflows pilotés par l'IA rendent l'expérimentation tellement bon marché que « construire un grand système » cesse d'être la règle par défaut. Quand une équipe peut générer, ajuster et relancer plusieurs approches en une seule après-midi, il est plus simple d'apprendre ce qui marche réellement que de prédire ce qui pourrait marcher.

L'IA rend presque gratuites les petites variantes

Au lieu d'investir des jours à concevoir une architecture généralisée, les équipes peuvent demander à l'IA de créer quelques implémentations étroites et concrètes :

- une version simple qui gère bien le happy path

- une version optimisée pour la lisibilité et la maintenabilité

- une version qui ajoute juste une capacité supplémentaire (p.ex. un second format d'entrée)

Comme créer ces variantes est rapide, l'équipe peut explorer les compromis sans s'engager dans un « grand design » dès le départ. Le but n'est pas de livrer toutes les variantes — c'est d'obtenir des preuves.

Comparer les variantes récompense naturellement les solutions simples

Une fois que vous pouvez juxtaposer deux ou trois options fonctionnelles, la complexité devient visible. La variante la plus simple :

- répond souvent aux mêmes exigences réelles

- a moins d'éléments à déboguer

- facilite les changements futurs car il y a moins de couplages cachés

Pendant ce temps, les options sur-ingénieuses se justifient par des besoins hypothétiques. La comparaison de variantes est un antidote : si l'abstraction supplémentaire n'apporte pas d'avantage clair et proche, elle ressemble à un coût.

Checklist : quoi mesurer en comparant des options

Quand vous lancez des expériences légères, mettez-vous d'accord sur ce que « meilleur » signifie. Une checklist pratique :

- Time-to-first-working-result : combien de temps avant d'avoir un résultat basique fonctionnel ?

- Complexité d'implémentation : fichiers/modules modifiés, nombre de concepts introduits, combien de règles un coéquipier doit retenir.

- Coût du changement : difficulté d'ajouter une nouvelle exigence (la prochaine probable, pas une fantaisie lointaine).

- Modes de défaillance : ce qui casse, à quel point, et la facilité de détection (erreurs claires vs sortie silencieusement incorrecte).

- Risque opérationnel : nouvelles dépendances, surface de configuration, et endroits où le comportement en production peut dériver.

- Testabilité : facilité d'écrire un petit ensemble de tests qui expliquent le comportement.

Si une variante plus abstraite ne peut pas gagner sur au moins une ou deux de ces mesures, l'approche la plus simple qui fonctionne est généralement le bon pari — pour l'instant.

L'IA aide à clarifier les exigences avant d'abstraire

L'abstraction prématurée commence souvent par une phrase comme : « On pourrait en avoir besoin plus tard. » C'est différent de : « Nous avons besoin de ça maintenant. » La première est une supposition sur une variabilité future ; la seconde est une contrainte vérifiable aujourd'hui.

Les workflows pilotés par l'IA rendent cette différence plus difficile à ignorer parce qu'ils excellent à transformer des conversations floues en énoncés explicites que vous pouvez inspecter.

Transformer l'ambiguïté en un contrat écrit (sans sur-engagement)

Quand une demande de fonctionnalité est vague, les équipes ont tendance à « pérenniser » en construisant un cadre général. Au lieu de cela, utilisez l'IA pour produire rapidement un résumé d'exigences d'une page qui sépare le réel de l'imaginé :

- Ce que nous savons (contraintes actuelles) : utilisateurs cibles, plateformes supportées, attentes de performance, intégrations requises.

- Ce que nous supposons : « Les utilisateurs auront plusieurs comptes », « nous supporterons 10 locales », « il y aura des niveaux de tarification ».

- Ce que nous ne savons pas encore : cas limites, contraintes légales, montée en charge, besoins de migration.

Cette séparation simple change la conversation d'ingénierie. Vous arrêtez de concevoir pour un futur inconnu et commencez à construire pour un présent connu — tout en gardant une liste visible d'incertitudes à revisiter.

Le Planning Mode de Koder.ai s'aligne bien ici : vous pouvez transformer une demande vague en plan concret (étapes, modèle de données, endpoints, états UI) avant de générer l'implémentation — sans vous engager dans une architecture tentaculaire.

Une approche « prête pour le futur » légère

Vous pouvez toujours laisser de la place pour évoluer sans construire une couche d'abstraction profonde. Favorisez des mécanismes faciles à changer ou à supprimer :

- Feature flags pour livrer une version étroite et apprendre de l'usage réel.

- Configuration pour les valeurs variables (timeouts, seuils, textes) plutôt que des systèmes polymorphes.

- Petits points d'extension (une interface, un hook, un événement) uniquement là où la variation est déjà probable.

Une bonne règle : si vous ne pouvez pas nommer les deux variations concrètes suivantes, ne construisez pas le framework. Notez les variations suspectées comme des « inconnues », livrez la voie la plus simple, puis laissez le feedback réel justifier l'abstraction plus tard.

Si vous voulez formaliser cette habitude, capturez ces notes dans votre template de PR ou dans un document d'« hypothèses » interne lié au ticket (p.ex. /blog/engineering-assumptions-checklist).

Les tests et les exemples révèlent la généralisation inutile

Une raison courante pour laquelle les équipes sur-ingénient est qu'elles conçoivent pour des scénarios imaginés. Les tests et les exemples concrets renversent cela : ils vous forcent à décrire des entrées réelles, des sorties réelles et des modes d'échec réels. Une fois écrits, les abstractions « génériques » paraissent souvent moins utiles — et plus coûteuses — qu'une implémentation petite et claire.

Comment l'IA met en lumière les cas limites (sans inventer d'architecture)

Quand vous demandez à un assistant IA de vous aider à écrire des tests, il vous pousse naturellement vers la spécificité. Au lieu de « rendre flexible », vous obtenez des questions comme : Que renvoie cette fonction lorsque la liste est vide ? Quelle est la valeur maximale autorisée ? Comment représenter un état invalide ?

Ce questionnement est précieux car il trouve tôt les cas limites, alors que vous décidez encore de ce dont la fonctionnalité a vraiment besoin. Si ces cas limites sont rares ou hors du périmètre, vous pouvez les documenter et passer à autre chose — sans construire d'abstraction « au cas où ».

Écrire les tests d'abord révèle si une abstraction est nécessaire

Les abstractions méritent leur place quand plusieurs tests partagent la même configuration ou des motifs de comportement. Si votre suite de tests n'a qu'un ou deux scénarios concrets, créer un framework ou un système de plugins est généralement un signe que vous optimisez pour un travail futur hypothétique.

Règle pratique : si vous ne pouvez pas exprimer au moins trois comportements distincts qui nécessitent la même interface généralisée, votre abstraction est probablement prématurée.

Un mini-template pour cas de test pragmatiques

Utilisez cette structure légère avant d'opter pour un design « généralisé » :

- Happy path : entrée typique → sortie attendue.

- Borne : valeurs minimum/maximum, collections vides, limites (p.ex. 0, 1, 1000).

- Échec : entrée invalide, dépendances manquantes, timeouts, erreurs d'autorisation → erreur attendue ou comportement de secours.

Une fois ces tests écrits, le code veut souvent rester simple. Si la répétition apparaît dans plusieurs tests, c'est votre signal pour refactorer — pas pour commencer par abstraire.

Les coûts de maintenance visibles découragent la sur-ingénierie

Commencez par la version la plus simple

Transformez un besoin concret en application fonctionnelle avant de concevoir des frameworks.

La sur-ingénierie se cache souvent derrière de bonnes intentions : « On en aura besoin plus tard. » Le problème est que les abstractions entraînent des coûts récurrents qui ne sont pas visibles dans le ticket d'implémentation initial.

La vraie facture d'une abstraction

Chaque nouvelle couche introduite crée généralement du travail récurrent :

- Surface d'API : plus de méthodes, paramètres et cas limites à supporter (et maintenir compatibles).

- Documentation et exemples : onboarder d'autres personnes implique d'expliquer l'abstraction, pas seulement la fonctionnalité.

- Migrations : une fois que d'autres codes dépendent d'une interface généralisée, la modifier nécessite des adaptateurs, des dépréciations et des notes de version.

- Matrice de tests : le code « générique » élargit les scénarios — plusieurs implémentations, plus de mocks, plus de points d'intégration.

Les workflows pilotés par l'IA rendent ces coûts plus difficiles à ignorer parce qu'ils peuvent rapidement énumérer ce à quoi vous vous engagez.

Utiliser l'IA pour estimer la complexité : comptez les pièces mobiles

Un prompt pratique est : « Liste les pièces mobiles et dépendances introduites par ce design. » Un bon assistant IA peut décomposer le plan en éléments concrets tels que :

- nouveaux modules/packages

- interfaces publiques et attentes de versioning

- changements de schéma DB et étapes de migration

- appels inter-services et modes de défaillance

- nouveaux flags de configuration, permissions ou files

Voir cette liste à côté d'une implémentation plus simple transforme les arguments d'« architecture propre » en compromis clairs : voulez-vous maintenir huit nouveaux concepts pour éviter une duplication que vous n'aurez peut-être jamais ?

Un « budget de complexité » pour rester honnête

Une politique légère : limitez le nombre de nouveaux concepts par fonctionnalité. Par exemple, autorisez au maximum :

- 1 nouvelle API publique

- 1 nouvelle abstraction partagée (interface/classe de base)

- 1 nouveau modèle de données/table

Si la fonctionnalité dépasse le budget, exigez une justification : quel changement futur cela active-t-il, et quelles preuves avez-vous qu'il est imminent ? Les équipes qui utilisent l'IA pour rédiger cette justification (et prévoir les tâches de maintenance) ont tendance à choisir des étapes plus petites et réversibles — car les coûts récurrents sont visibles avant la mise en production.

Quand l'IA peut vous pousser dans la mauvaise direction (et comment l'éviter)

Les workflows pilotés par l'IA poussent souvent vers de petites étapes testables — mais ils peuvent aussi faire l'inverse. Parce que l'IA est douée pour produire des solutions « complètes » rapidement, elle peut par défaut adopter des patrons familiers, ajouter de la structure ou générer des squelettes dont vous n'avez pas besoin. Le résultat peut être plus de code, plus tôt que nécessaire.

Comment l'IA encourage accidentellement la sur-ingénierie

Un modèle est souvent récompensé (par la perception humaine) pour paraître exhaustif. Cela peut se traduire par des couches additionnelles, plus de fichiers et des conceptions généralisées qui semblent professionnelles mais ne résolvent pas un problème réel et présent.

Signes d'alerte courants :

- Nouvelles abstractions sans cas d'utilisation concret (p.ex. « pour plus de flexibilité »)

- Couches supplémentaires : service → manager → adapter → factory, alors qu'une fonction suffirait

- Interfaces génériques avec une seule implémentation

- Systèmes de plugins, bus d'événements ou setups d'injection de dépendances introduits trop tôt

- Un « framework dans le framework » créé pour standardiser quelque chose que vous n'avez pas encore répété

Atténuations pour garder la sortie IA ancrée

Traitez l'IA comme des mains rapides, pas comme un comité d'architecture. Quelques contraintes suffisent :

- Contrainre les prompts au présent. Demandez le plus petit changement qui satisfait la nécessité du jour, et interdisez explicitement les nouveaux patterns sauf si nécessaire.

- Exiger des exemples concrets. Avant d'accepter une abstraction, demandez 2–3 sites d'appel concrets (ou flux utilisateurs) et vérifiez que l'abstraction les simplifie.

- Limiter le changement d'architecture par itération. Autorisez une seule modification structurelle à la fois (p.ex. « introduire un nouveau module » ou « pas de nouvelles couches dans cette PR »).

- Vérifier la supprimabilité. Si supprimer la nouvelle couche affecterait à peine le comportement, elle n'est probablement pas méritée.

Une règle simple : ne laissez pas l'IA généraliser tant que la base de code n'a pas montré une douleur répétée.

Un cadre de décision pratique : construire d'abord, abstraire plus tard

Rendez les refactorisations réversibles

Refactorisez en toute confiance grâce aux instantanés et au retour en arrière quand une abstraction crée de la friction.

L'IA rend peu coûteux de générer du code, refactorer et essayer des alternatives. C'est un cadeau — si vous l'utilisez pour différer l'abstraction jusqu'à ce qu'elle soit méritée.

Étape 1 : Commencer concret (optimiser l'apprentissage)

Commencez par la version la plus simple qui résout le problème d'aujourd'hui pour un seul « happy path ». Nommez les choses directement d'après ce qu'elles font (pas d'après ce qu'elles pourraient faire plus tard) et gardez les API étroites. Si vous doutez qu'un paramètre, une interface ou un système de plugins soit nécessaire, livrez sans.

Règle utile : préférez la duplication à la spéculation. Le code dupliqué est visible et facile à supprimer ; la généralité spéculative cache la complexité dans l'indirection.

Étape 2 : Extraire plus tard (optimiser la stabilité)

Une fois la fonctionnalité utilisée et modifiée, refactorez avec des preuves. Avec l'aide de l'IA, vous pouvez avancer vite ici : demandez-lui de proposer une extraction, mais insistez sur un diff minimal et des noms lisibles.

Si vos outils le permettent, utilisez des filets de sécurité qui rendent les refactors peu risqués. Par exemple, les snapshots et rollbacks de Koder.ai facilitent l'expérimentation sur des refactors en permettant de revenir rapidement si le « design plus propre » s'avère pire en pratique.

Quand l'abstraction est justifiée (checklist rapide)

Une abstraction mérite sa place quand la plupart de ces conditions sont vraies :

- Logique répétée : le même comportement existe en 2–3 endroits et les mises à jour ont déjà requis plusieurs modifications.

- Variabilité prouvée : vous avez observé de vraies variations en production ou dans des prototypes validés (pas « peut-être X un jour »).

- Propriété claire : une personne/équipe possède l'abstraction, sa doc et ses évolutions futures.

- Borne stable : la forme entrée/sortie est restée cohérente sur au moins quelques itérations.

- Simplification nette : l'extraction réduit le code total et la charge cognitive, elle ne se contente pas de réorganiser.

Un rituel simple : la revue « une semaine plus tard »

Ajoutez un rappel une semaine après la mise en production d'une fonctionnalité :

- Rouvrez le diff et listez les changements depuis la release.

- Identifiez tout copier-coller ou bug récurrent.

- Décidez l'une des trois issues : garder concret, extraire un petit helper, ou introduire un module partagé.

Cela maintient la posture par défaut : construire d'abord, généraliser seulement quand la réalité vous y force.

Que mesurer pour garder l'ingénierie légère

L'ingénierie lean n'est pas une impression — c'est observable. Les workflows IA facilitent la livraison rapide de petites modifications, mais vous avez quand même besoin de quelques signaux pour remarquer quand l'équipe retombe dans la conception spéculative.

Un petit ensemble de métriques qui repèrent la sur-ingénierie tôt

Suivez quelques indicateurs anticipatifs corrélés à l'abstraction inutile :

- Cycle time : temps entre « début du travail » et « mergé et déployé ». Quand le cycle s'allonge sans augmentation nette du scope, cela indique souvent plus d'indirection.

- Taille des diffs : lignes modifiées (ou fichiers touchés) par changement. Les gros diffs sont plus durs à relire et favorisent les solutions généralisées.

- Nombre de concepts introduits : comptez nouveaux modules/services/packages, nouvelles interfaces, nouveaux réglages de configuration, primitives « framework-y ». Les concepts sont une taxe permanente.

- Taux de défauts : bugs en production ou tickets support par release. Les abstractions peuvent cacher des cas limites ; une hausse de défauts après du « cleanup » est un signal d'alarme.

- Temps d'onboarding : temps pour qu'un nouvel ingénieur livre sa première petite modification. Si l'onboarding ralentit, le système privilégie peut-être l'élégance sur la clarté.

Vous n'avez pas besoin de perfection — des tendances suffisent. Passez ces indicateurs en revue chaque semaine ou par itération et demandez : « Avons-nous ajouté plus de concepts que le produit ne l'exigeait ? »

Documentation légère pour éviter les abstractions mystérieuses

Exigez une courte note « pourquoi ceci existe » chaque fois que quelqu'un introduit une nouvelle abstraction (une interface, une couche helper, une librairie interne). Restez concis dans le README ou commentez près du point d'entrée :

- Quel problème concret cela a-t-il résolu aujourd'hui ?

- Quelles alternatives ont été essayées ?

- Qu'est-ce qui justifierait sa suppression ?

Plan d'action pour commencer

Prouvez un petit flux IA-assisté sur une équipe pendant 2–4 semaines : découpage de tickets assisté par l'IA, checklists de revue de code IA-assistées, et cas de test générés par l'IA.

À la fin, comparez les métriques ci-dessus et faites un retro court : conservez ce qui a réduit le cycle et l'onboarding ; annulez ce qui a augmenté le « nombre de concepts introduits » sans bénéfice produit mesurable.

Si vous cherchez un environnement pratique pour mener cette expérience de bout en bout, une plateforme de vibe-coding comme Koder.ai peut aider à transformer ces tranches petites et concrètes en applications déployables rapidement (avec export du code source disponible quand nécessaire), ce qui renforce l'habitude soulignée dans cet article : livrez quelque chose de réel, apprenez, puis seulement alors généralisez.