Pourquoi les premières versions brutes sont si courantes

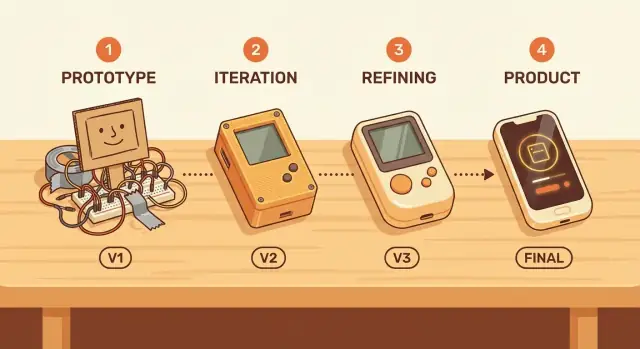

Une « première version brute » n'est pas synonyme de qualité négligée. C'est un produit qui fonctionne suffisamment bien pour être essayé par de vraies personnes, mais qui comporte encore des fonctionnalités manquantes, des flux maladroits et beaucoup de marge d'amélioration. La différence tient à l'intention : brute signifie concentrée et limitée ; négligée signifie peu fiable et dangereuse.

La perfection est rare au départ parce que la plupart des éléments qui définissent la « perfection » sont inconnus tant que les utilisateurs n'interagissent pas avec le produit. Les équipes peuvent deviner quelles fonctionnalités comptent, quel langage est clair, ou où les gens vont bloquer — mais les hypothèses se révèlent souvent fausses. Même des bâtisseurs expérimentés découvrent régulièrement que le vrai problème que veulent résoudre les clients est légèrement différent de ce qui avait été imaginé.

Brute ne veut pas dire « expédier de la camelote »

Le but d'un démarrage imparfait est l'apprentissage, pas l'abaissement des normes. Une bonne première version brute respecte toujours l'utilisateur :

- Elle résout un problème clair de bout en bout.

- Elle est suffisamment stable pour que les échecs soient l'exception, pas la règle.

- Elle fixe des attentes honnêtes sur ce qui est inclus (et ce qui ne l'est pas).

Quand les équipes adoptent une mentalité d'apprendre d'abord, elles cessent de traiter la première livraison comme un examen final et commencent à la considérer comme un test sur le terrain. Ce changement facilite la réduction du périmètre, la sortie anticipée et l'amélioration basée sur des preuves plutôt que des opinions.

Dans les sections suivantes, vous verrez des exemples pratiques — comme des sorties de type MVP et des programmes d'adopteurs précoces — et des garde-fous pour éviter les erreurs courantes (par exemple : comment tracer une ligne nette entre « imparfait » et « inutilisable », et comment capter des retours sans être entraîné dans des demandes personnalisées sans fin).

L'incertitude est la plus forte au début

Au début de la vie d'un produit, la confiance est souvent une illusion. Les équipes peuvent rédiger des spécifications détaillées et des feuilles de route, mais les grandes questions ne peuvent pas être résolues depuis une salle de réunion.

Ce que vous ne pouvez pas vraiment savoir à l'avance

Avant que de vrais utilisateurs n'utilisent votre produit, vous êtes en train de deviner :

- Qui sont vraiment les utilisateurs les plus motivés (et quelles descriptions d'« client idéal » relèvent du souhait)

- Les workflows réels : comment les gens font le travail aujourd'hui, ce qu'ils refusent de changer et ce qu'ils délégueront volontiers au logiciel

- Le prix et la volonté de payer : ce qui semble juste en entretien vs. ce qui déclenche une carte bancaire

- Les canaux d'acquisition : où l'attention est abordable, quels messages résonnent, et ce qui est ignoré

Vous pouvez étudier tout cela, mais vous ne pouvez pas les confirmer sans utilisation.

Pourquoi les plans échouent sans données d'usage réelles

La planification traditionnelle suppose que vous pouvez prédire les besoins, prioriser les fonctionnalités puis construire vers une destination connue. Les produits en phase précoce sont pleins d'inconnues, donc le plan repose sur des hypothèses. Quand ces hypothèses sont fausses, vous ne faites pas qu'atteindre un retard : vous construisez la mauvaise chose efficacement.

C'est pourquoi les premières versions comptent : elles transforment les débats en preuves. Les données d'usage, les tickets de support, le churn, les taux d'activation et même « on l'a essayé puis arrêté » sont des signaux qui clarifient ce qui est réel.

Les fonctionnalités « sympas à avoir » cachent souvent des hypothèses

Une longue liste d'améliorations peut sembler centrée sur le client, mais elle contient souvent des paris cachés :

- « Les utilisateurs voudront des dashboards » suppose qu'ils consulteront l'outil fréquemment.

- « Rôles et permissions d'équipe » suppose une adoption multi-utilisateurs dès le départ.

- « Intégrations avec tout » suppose que les coûts de changement sont votre principal frein.

Construire cela trop tôt, c'est engager des paris avant de les avoir validés.

Apprentissage validé : des progrès fiables

L'apprentissage validé signifie que l'objectif d'une version précoce n'est pas d'avoir l'air fini : c'est de réduire l'incertitude. Une première version brute est réussie si elle vous enseigne quelque chose de mesurable sur le comportement des utilisateurs, la valeur et la volonté de continuer.

Cet apprentissage devient la base de l'itération suivante — basée sur des preuves, pas sur l'espoir.

La vitesse d'apprentissage vaut mieux que la vitesse de construction

Les équipes mesurent souvent le progrès par « plus de fonctionnalités livrées ». Mais au début, l'objectif n'est pas de construire vite — c'est d'apprendre vite. Une première version brute qui atteint de vrais utilisateurs transforme des hypothèses en preuves.

Des cycles de feedback courts changent tout

Quand vous publiez tôt, les boucles de rétroaction passent de mois à jours. Au lieu de débattre de ce que les utilisateurs pourraient faire, vous voyez ce qu'ils font réellement.

Un schéma courant :

- Mois de supposition : rédaction de longs cahiers des charges, perfectionnement des designs, gestion des cas limites pour des problèmes non confirmés.

- Jours de feedback réel : lancement d'une petite version, observation des points de blocage et ajustement avec clarté.

Cette vitesse se compose. Chaque cycle court enlève de l'incertitude et empêche de « construire très bien la mauvaise chose ».

Un apprentissage mesurable

« Apprendre » n'est pas un sentiment vague. Même des produits simples peuvent suivre des signaux montrant si l'idée fonctionne :

- Activation : les gens atteignent-ils le premier moment significatif (ex. créer un projet, inviter un coéquipier, compléter une tâche) ?

- Rétention : reviennent-ils la semaine suivante sans relance ?

- Tickets de support et questions : qu'est-ce qui confond régulièrement les utilisateurs ? Que demandent-ils avec leurs propres mots ?

Ces métriques ne font pas que valider : elles indiquent la prochaine amélioration avec plus de confiance que les avis internes.

Rapide, mais jamais imprudent

La vitesse ne signifie pas ignorer la sécurité ou la confiance. Les premières versions doivent encore protéger les utilisateurs contre les dommages :

- Soyez clair sur ce que le produit fait et ne fait pas.

- Évitez les fonctionnalités qui pourraient exposer des données sensibles ou créer des risques financiers/juridiques.

- Ajoutez des garde-fous basiques (permissions, backups, annuler) avant les « growth hacks ».

Construisez pour apprendre d'abord — tout en gardant les utilisateurs en sécurité — et votre première version brute devient une étape intentionnelle, pas un pari.

Les MVP : petites livraisons qui testent l'idée la plus risquée

Un MVP (produit minimum viable) est la plus petite version de votre produit qui peut tester si une promesse clé a de la valeur pour de vraies personnes. Ce n'est pas « la première version de tout ». C'est le chemin le plus court pour répondre à une question à fort enjeu : quelqu'un l'utilisera-t-il ? Paiera-t-il ? Changeront-ils leur routine pour ça ?

Ce qu'est — et n'est pas — un MVP

Un MVP est une expérience concentrée que vous pouvez publier, apprendre et améliorer.

Un MVP n'est pas :

- Une démo soignée qui évite l'usage réel

- Une version « à moitié cassée » qui frustre les gens

- Une pile de fonctionnalités qui retarde l'apprentissage

L'objectif est la viabilité : l'expérience doit fonctionner de bout en bout pour un ensemble restreint d'utilisateurs, même si le périmètre est petit.

Différents produits peuvent tester la même valeur sous différentes formes :

- Concierge MVP : vous fournissez la valeur manuellement (fort contact) à quelques utilisateurs. Idéal pour comprendre les besoins et la volonté de payer.

- « Manuel en coulisses » (Wizard-of-Oz) : les utilisateurs voient une interface simple, mais le travail est fait manuellement ou avec des outils bricolés en interne. Idéal pour valider la demande avant d'automatiser.

- Produit à fonctionnalités limitées : vous construisez seulement le flux central qui prouve le bénéfice principal, en laissant volontairement de côté les « sympas à avoir ». Idéal quand l'interaction nécessite un logiciel.

Commencez par l'hypothèse la plus risquée

Le périmètre d'un MVP doit correspondre à votre plus grande incertitude. Si le risque est la demande, priorisez le test de l'usage réel et des signaux de paiement. Si le risque est l'issue, concentrez-vous à prouver que vous pouvez délivrer le résultat de façon fiable — même si le processus est manuel.

Une façon pratique d'appuyer cette approche est d'utiliser un workflow build-and-iterate qui minimise le coût de mise en place. Par exemple, une plateforme de prototypage comme Koder.ai permet de prototyper des apps web, backend ou mobile via chat, puis d'exporter le code source et de déployer — utile quand vous voulez un vrai MVP bout en bout sans vous engager dans un long cycle d'ingénierie avant d'avoir validé la promesse centrale.

La différence entre « imparfait » et « inutilisable »

Une première version brute peut être un excellent départ — si elle aide une personne spécifique à accomplir un travail précis. « Assez bien » n'est pas une norme universelle ; elle dépend du job-to-be-done de l'utilisateur. Le parcours prototype→produit fonctionne mieux quand vous définissez clairement ce travail (par exemple : « envoyer une facture en moins de deux minutes » ou « partager un fichier en toute sécurité avec un seul lien »).

Une barre de qualité simple : fiable pour la tâche centrale

Un démarrage imparfait peut être petit et un peu maladroit. Il n'a pas le droit d'être peu fiable sur la seule chose qu'il promet.

Une barre de qualité minimale pratique pour un MVP :

- La tâche centrale fonctionne de bout en bout, à chaque fois, sans corrections manuelles.

- Les erreurs sont compréhensibles (pas de pannes mystérieuses).

- Les utilisateurs peuvent se récupérer (annuler, réessayer ou obtenir des étapes claires).

Si le flux central casse, les early adopters ne peuvent pas fournir de retours utiles — car ils n'atteignent jamais le moment où le produit délivre de la valeur.

Arbitrages : moins de fonctionnalités, plus de clarté

« Livrer vite » tourne souvent mal quand les équipes coupent les mauvaises choses. Supprimer des fonctionnalités supplémentaires est acceptable ; supprimer la clarté ne l'est pas. Un produit minimum viable devrait privilégier :

- Moins d'options, mais des choix par défaut plus clairs

- Un onboarding simple, pas une longue liste de fonctionnalités

- Un cas d'usage bien défini, pas cinq pris en charge à moitié

Cela rend l'itération plus rapide parce que les retours portent sur l'essentiel, pas sur la confusion.

Même dans une version précoce, l'accessibilité et une performance minimale ne doivent pas être considérées comme des « extras ». Si le texte est illisible, si les actions ne sont pas réalisables au clavier ou si les pages prennent trop de temps à charger, vous ne testez pas l'adéquation produit-marché — vous testez la patience des gens. L'amélioration continue commence par une base qui respecte le temps et les besoins des utilisateurs.

Trouver l'adéquation produit-marché nécessite un usage réel

Testez un MVP mobile

Validez la demande avec un MVP mobile Flutter, sans mois de préparation.

L'adéquation produit-marché (PMF) se définit simplement : les utilisateurs ressentiraient un manque si votre produit disparaissait. Pas « ils aiment l'idée », pas « ils ont cliqué sur l'annonce », mais une dépendance réelle — quelque chose qu'ils ont intégré à leur routine.

Pourquoi vous ne pouvez pas prédire la PMF de l'intérieur

Les équipes sont biaisées par leurs propres hypothèses. Vous connaissez la feuille de route, vous comprenez les cas limites et vous imaginez toute la valeur future. Mais les clients n'achètent pas votre intention — ils vivent ce qui existe aujourd'hui.

Les avis internes souffrent aussi d'un biais d'échantillon : « les personnes comme nous ». Collègues, amis et testeurs précoces partagent souvent votre contexte. L'usage réel introduit des contraintes désordonnées que vous ne pouvez pas simuler : pression temporelle, alternatives concurrentes et zéro patience pour des flux confus.

Signaux précoces que la PMF se constitue

Cherchez des comportements suggérant que le produit résout un problème récurrent :

- Usage répété : les gens reviennent sans rappels et l'usage se maintient après l'effet de nouveauté.

- Parrainages : les utilisateurs recommandent spontanément parce que cela les fait paraître utiles.

- Volonté de payer : pas seulement « je paierais », mais payer réellement, passer à une offre payante ou accepter un compromis significatif.

Ne pas surinterpréter les métriques de vanité

Les chiffres précoces peuvent induire en erreur. Méfiez-vous de :

- Pages vues et inscriptions qui ne se traduisent pas en activation

- Pics d'essai gratuits liés à la curiosité ou à des promotions

- Engagement social qui reflète l'intérêt pour le sujet, pas pour le produit

Une première version brute vaut car elle vous amène rapidement à ces contrôles de réalité. La PMF n'est pas une réunion — c'est un motif observé une fois que de vrais utilisateurs utilisent le produit.

Les early adopters aident à façonner le produit

Les early adopters n'acceptent pas les bords rugueux pour le plaisir des bugs : ils le font parce que le bénéfice pour eux est exceptionnellement élevé. Ce sont des personnes qui ont un problème aigu et fréquent, et qui cherchent activement une solution. Si votre première version brute soulage fortement cette douleur (même imparfaitement), elles échangeront du polish contre du progrès.

Pourquoi les early adopters acceptent les imperfections

Les early adopters :

- Payent du temps ou de l'argent pour des alternatives bricolées (tableurs, contrôles manuels, copier-coller)

- Ressentent le problème plus intensément que l'utilisateur moyen

- Acceptent d'investir de l'effort si cela leur apporte un soulagement plus tôt

Quand le « avant » est suffisamment douloureux, un « après » inachevé paraît déjà être une victoire.

Cherchez les endroits où la douleur est déjà discutée : Slack/Discord de niche, subreddits, forums sectoriels et communautés professionnelles. Un signal fiable : les personnes qui ont déjà bricolé leurs propres solutions (templates, scripts, tableaux Notion) — elles vous disent qu'elles ont besoin d'un meilleur outil.

Considérez aussi les niches « adjacentes », des segments plus petits ayant le même job-to-be-done mais moins d'exigences. Ils sont souvent plus faciles à servir au départ.

Fixez des attentes ouvertement

Soyez explicite sur ce qui est inclus et ce qui ne l'est pas : ce que le produit peut faire aujourd'hui, ce qui est expérimental, ce qui manque et les types de problèmes que les utilisateurs peuvent rencontrer. Des attentes claires évitent la déception et augmentent la confiance.

Créez des canaux de feedback rapides

Rendez le retour simple et immédiat : une invite courte dans l'app, une adresse e-mail de réponse et quelques appels programmés avec des utilisateurs actifs. Demandez des précisions : ce qu'ils ont essayé, où ils ont été bloqués et ce qu'ils ont fait à la place. Ces détails transforment l'usage précoce en feuille de route ciblée.

Les contraintes peuvent mener à de meilleures décisions

Optimisez le budget de votre MVP

Obtenez des crédits lorsque vous partagez ce que vous avez construit ou recommandez Koder.ai à d'autres.

Les contraintes ont mauvaise réputation, mais elles forcent souvent à réfléchir clairement. Quand le temps, le budget ou la taille de l'équipe est limité, on ne peut pas « résoudre » l'incertitude en ajoutant des fonctionnalités. Il faut décider de ce qui compte, définir ce qu'est le succès et livrer quelque chose qui prouve (ou infirme) la valeur centrale.

Les contraintes créent de la simplicité

Une contrainte serrée agit comme un filtre : si une fonctionnalité n'aide pas à valider la promesse principale, elle attendra. C'est ainsi que naissent des solutions simples et claires : le produit est construit autour d'un travail qu'il réalise bien, pas de dix travaux mal exécutés.

Ceci est particulièrement utile au début, quand vous devinez encore ce que veulent vraiment les utilisateurs. Plus vous contraignez le périmètre, plus il est facile d'attribuer un résultat à un changement.

Les fonctionnalités supplémentaires peuvent masquer une valeur floue

Ajouter des « sympas à avoir » peut masquer le vrai problème : la proposition de valeur n'est pas encore nette. Si les utilisateurs ne sont pas enthousiasmés par la version la plus simple, plus de fonctionnalités ne corrigent pas souvent la situation — elles ajoutent du bruit. Un produit riche en fonctionnalités peut sembler chargé tout en n'apportant pas la réponse à « Pourquoi devrais-je l'utiliser ? »

Exemples pratiques de validation par contraintes

Quelques manières conviviales aux contraintes de tester l'idée la plus risquée :

- Test de landing page : écrivez une promesse claire et un appel à l'action (liste d'attente, demande de démo, précommande). Si les gens ne convertissent pas, vous avez appris sans construire le produit complet.

- Prototype plutôt que plateforme : un prototype cliquable peut valider si le flux a du sens avant d'investir en ingénierie.

- Outil mono-fonction : beaucoup de produits commencent comme un utilitaire pointu (un rapport, une automation, un bouton) auquel les gens reviennent.

Dire « non » protège la concentration

Considérez le « non » comme une compétence produit. Dites non aux fonctionnalités qui ne soutiennent pas l'hypothèse actuelle, non aux segments d'utilisateurs supplémentaires avant qu'un segment ne fonctionne, et non au polish qui ne change pas les décisions. Les contraintes rendent ces « non » plus faciles — et elles maintiennent l'honnêteté de votre produit précoce sur ce qu'il délivre réellement.

Éviter le piège de la surconstruction

La surconstruction survient quand une équipe traite la première livraison comme le verdict final. Plutôt que de tester l'idée centrale, le produit devient un ensemble de « sympas à avoir » qui semblent plus sûrs qu'une expérience claire oui/non.

Pourquoi les équipes surconstruisent

La peur est le principal moteur : peur d'un feedback négatif, peur d'avoir l'air peu professionnel, peur qu'un concurrent apparaisse plus poli.

La comparaison alimente cela. Si vous vous référez à des produits matures, il est facile de copier leur ensemble de fonctionnalités sans voir qu'ils ont gagné ces fonctionnalités au fil des années d'usage réel.

La politique interne peut pousser plus loin. Des fonctionnalités supplémentaires deviennent un moyen de satisfaire plusieurs parties prenantes à la fois (« ajoute ça pour que l'équipe commerciale puisse le vendre », « ajoute ça pour que le support ne râle pas »), même si rien de tout cela ne prouve que le produit sera désiré.

Le coût caché : le coût irrémédiable ralentit le changement

Plus vous construisez, plus il devient difficile de changer de direction. C'est l'effet coût irrécupérable : une fois du temps, de l'argent et de la fierté investis, les équipes défendent des décisions qui devraient être réexaminées.

Les versions surconstruites créent des engagements coûteux : code complexe, onboarding plus lourd, plus de cas limites, plus de documentation, plus de réunions pour coordonner. Alors même des améliorations évidentes semblent risquées parce qu'elles menacent tout cet investissement.

Une première version brute limite vos options de façon bénéfique. En gardant le périmètre petit, vous apprenez plus tôt si l'idée a de la valeur et vous évitez de polir des fonctionnalités qui n'auront pas d'impact.

Une règle simple :

Construisez la plus petite chose qui répond à une question.

Exemples de « une question » :

- Les gens accompliront-ils cette tâche si on retire l'aide manuelle ?

- Les utilisateurs préfèrent-ils l'option A ou B quand il faut choisir ?

- Ce problème est-il assez urgent pour que quelqu'un revienne demain ?

Si votre « MVP » ne peut pas répondre clairement à une question, il n'est probablement pas minimal : c'est juste une surconstruction déguisée en précoce.

Publier tôt est utile, mais ce n'est pas gratuit. Une première version brute peut causer de vrais dommages si vous ignorez les risques.

Les risques les plus courants

Les plus grands risques tombent généralement dans quatre catégories :

- Confiance et crédibilité : une première expérience buggy peut donner l'impression que le produit est négligé ou peu fiable.

- Sécurité et vie privée : le code précoce comporte souvent des lacunes, surtout autour de l'authentification, des permissions et du traitement des données.

- Perte de données : si les utilisateurs investissent du temps à saisir des informations qui disparaissent, ils peuvent ne jamais revenir.

- Mauvaises premières impressions : un onboarding confus ou une valeur peu claire mène au churn « je ne comprends pas ».

Atténuations pratiques pour continuer d'avancer

Vous pouvez réduire les dommages sans ralentir exagérément :

- L'étiqueter clairement : « Bêta » ou « Aperçu » fixe les attentes. Dites ce qui est prêt et ce qui ne l'est pas.

- Limiter l'accès : commencez par un petit groupe (sur invitation, liste d'attente ou segment client spécifique) pour contenir les erreurs.

- Sauvegardes et annuler : même des garde-fous simples — options d'export, historique de versions, sauvegardes nocturnes — protègent les utilisateurs.

- Voies de support claires : un e-mail/chat visible et des temps de réponse rapides peuvent sauver des moments fragiles et construire de la confiance.

Si vous utilisez une plateforme pour livrer rapidement, cherchez des fonctions de sécurité qui soutiennent l'itération précoce. Par exemple, Koder.ai inclut des snapshots et des rollback (pour récupérer d'une mauvaise release) et supporte le déploiement/l'hébergement — utile quand vous voulez aller vite sans transformer chaque changement en événement à haut risque.

Déploiements graduels et feature flags (en termes simples)

Au lieu de tout sortir à la fois, faites un déploiement graduel : 5 % des utilisateurs d'abord, puis 25 %, puis 100 % au fur et à mesure que vous gagnez en confiance.

Un feature flag est un simple interrupteur qui vous permet d'activer ou désactiver une nouvelle fonctionnalité sans redéployer tout.

Quand il ne faut pas publier tôt

Ne « testez pas en production » quand les enjeux sont élevés : fonctionnalités liées à la sécurité, exigences légales/compliance, paiements ou données personnelles sensibles, ou tout ce qui nécessite une fiabilité critique (ex. médical, urgence, finance centrale). Dans ces cas, validez avec des prototypes, des tests internes et des pilotes contrôlés avant usage public.

Construire, puis apprendre

Prototypez d'abord le flux complet, puis peaufinez après des retours réels.

Publier une première version brute n'est utile que si vous transformez les réactions réelles en décisions meilleures. L'objectif n'est pas « plus de retours » : c'est une boucle d'apprentissage régulière qui rend le produit plus clair, plus rapide et plus simple à utiliser.

Que mesurer (pour ne pas deviner)

Commencez par quelques signaux qui reflètent si les gens obtiennent réellement de la valeur :

- Activation : quel pourcentage atteint le moment « aha » (ex. termine un premier projet, invite un coéquipier, publie quelque chose)

- Temps jusqu'à la valeur : combien de temps pour obtenir ce premier résultat

- Rétention : qui revient après un jour/une semaine/un mois

- Raisons du churn : le pourquoi derrière les annulations ou abandons (prix, fonctionnalité manquante, confusion, mauvais fit)

Ces métriques vous aident à distinguer « les gens sont curieux » de « les gens réussissent ».

Collecter des retours qualitatifs qui expliquent les chiffres

Les chiffres vous disent ce qui s'est passé. Les retours qualitatifs expliquent pourquoi.

Utilisez un mix de :

- Courts entretiens avec de nouveaux utilisateurs (15 minutes suffisent)

- Enquêtes légères après des moments clés (« Qu'est-ce qui a été confus ? » « Qu'est-ce qui a failli vous arrêter ? »)

- Logs de support et transcripts de chat (souvent les retours les plus honnêtes)

Capturez les formulations exactes des utilisateurs. Ces mots nourrissent un meilleur onboarding, des boutons plus clairs et une tarification simplifiée.

Ne faites pas une liste de tâches de chaque demande. Regroupez les retours en thèmes, puis priorisez par impact (combien cela améliore l'activation/la rétention) et effort (difficulté à livrer). Une petite correction qui supprime un point de confusion majeur bat souvent une grosse fonctionnalité.

Reliez l'apprentissage à un rythme de sorties régulier — mises à jour hebdomadaires ou bihebdomadaires — pour que les utilisateurs voient des progrès et que vous continuiez à réduire l'incertitude à chaque itération.

Un cadre pratique pour commencer imparfait et réussir

Une première version brute fonctionne quand elle est volontairement imparfaite : concentrée sur la validation d'un pari clé, tout en étant suffisamment digne de confiance pour que de vraies personnes l'essaient.

Étape 1 : Choisir une promesse centrale

Écrivez une phrase qui explique le travail que votre produit fera pour un utilisateur.

Exemples :

- « Aider les freelances à envoyer une facture en moins de 2 minutes. »

- « Permettre aux équipes de voir les ventes d'hier sur un seul écran. »

Si votre MVP ne peut pas tenir cette promesse, il n'est pas prêt — peu importe la qualité visuelle de l'interface.

Étape 2 : Fixer une barre de qualité claire (imparfait, pas inutilisable)

Décidez ce qui doit être vrai pour que les utilisateurs fassent confiance à l'expérience.

Checklist :

- Promesse centrale : quel est l'unique résultat garanti ?

- Barre de qualité : qu'est-ce qui rendrait l'expérience cassée ou risquée (totaux erronés, perte de données, paiement confus, etc.) ?

- Métriques de succès : quels chiffres indiqueront que ça marche (taux d'activation, usage répété, temps jusqu'à la valeur, rétention après 7 jours) ?

Étape 3 : Définir le plus petit test qui peut vous apprendre quelque chose

Réduisez le périmètre jusqu'à pouvoir livrer rapidement sans affaiblir le test. Une bonne règle : coupez les fonctionnalités qui ne changent pas la décision que vous prendrez après le lancement.

Demandez :

- Quelle est l'hypothèse la plus risquée ?

- Quelle est la façon la plus rapide de la valider par l'usage réel ?

Si votre goulot d'étranglement est la vitesse d'implémentation, envisagez une chaîne d'outils qui raccourcit le chemin idée → logiciel fonctionnel. Par exemple, Koder.ai peut générer une app React, un backend Go + PostgreSQL ou une app mobile Flutter à partir d'un cahier des charges par chat, puis vous laisser exporter le code quand vous êtes prêt à posséder le repo — utile pour atteindre un test utilisateur réel plus vite.

Étape 4 : Lancer une boucle de feedback courte

Publiez à un petit groupe spécifique, puis collectez les retours sur deux canaux :

- Comportement : ce que les gens font réellement (abandons, répétitions, temps jusqu'à la valeur)

- Conversation : appels de 10–15 minutes ou courtes enquêtes focalisées sur le résultat, pas sur les opinions

Suggestion de calendrier (pour un plan d'article d'environ 3000 mots)

- Semaine 1 : choisissez la promesse centrale + barre de qualité, recueillez 3–5 user stories

- Semaine 2 : construisez uniquement ce qui est nécessaire pour tenir la promesse une fois

- Semaine 3 : sortez auprès d'utilisateurs précoces, mesurez, faites des entretiens

- Semaine 4 : resserrez l'expérience autour de ce qui est utilisé ; supprimez ce qui ne l'est pas

Appel à l'action

Prenez cinq minutes aujourd'hui : rédigez votre promesse centrale, listez votre barre de qualité et entourez l'hypothèse la plus risquée. Puis réduisez le périmètre de votre MVP jusqu'à ce qu'il puisse tester cette hypothèse dans les 2–3 semaines suivantes.

Si vous voulez plus de modèles et d'exemples, parcourez les articles liés dans /blog.