Pourquoi les prévisions d’AGI de Kurzweil comptent

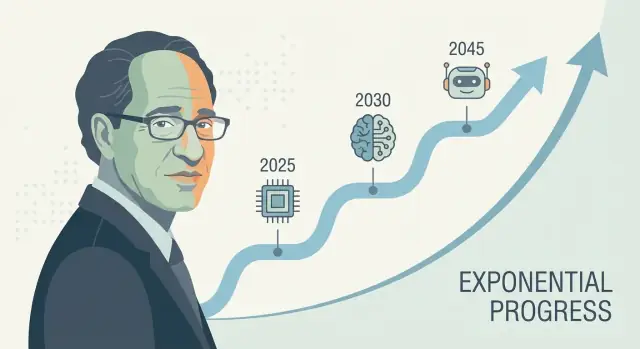

Ray Kurzweil est l’une des voix les plus reconnues en matière de prévisions technologiques à long terme—en particulier autour de l’intelligence artificielle et de la singularité technologique. Quand il produit une prédiction d’AGI concrète (souvent formulée comme une date, et non un vague « un jour »), cela a tendance à faire des vagues : investisseurs qui s’en inspirent, journalistes qui en débattent, chercheurs invités à réagir.

Pourquoi ses prévisions attirent l’attention

L’influence de Kurzweil ne tient pas qu’à son optimisme. Elle tient au fait qu’il propose un récit reproductible expliquant pourquoi le progrès devrait s’accélérer—souvent lié à la croissance exponentielle de la puissance de calcul et à l’idée que chaque génération d’outils aide à construire la suivante. Qu’on soit d’accord ou non, il fournit une manière structurée de discuter d’une chronologie pour l’intelligence artificielle générale plutôt que de traiter le sujet comme de la pure science-fiction.

Ce que signifie vraiment « prévoir des décennies à l’avance »

Une prévision à plusieurs décennies consiste moins à deviner une date précise qu’à projeter un faisceau de tendances : calcul, coût, données, algorithmes et capacité pratique à construire des systèmes qui généralisent. Le pari est que ces courbes continuent de bouger—et que les « pièces manquantes » d’aujourd’hui sont des problèmes d’ingénierie solvables qui diminuent à mesure que les inputs s’améliorent.

Ce que cet article vous apprendra

Ce texte décompose :

- la méthode qui sous-tend les prévisions technologiques de Kurzweil (ce qu’il mesure et extrapole),

- quelles preuves soutiennent l’idée que les indicateurs de progrès de l’IA s’accélèrent—et où les données sont ténues,

- les critiques les plus fortes des prévisions d’IA qui s’appuient sur des extrapolations en ligne droite d’une croissance exponentielle,

- des enseignements pratiques pour utiliser les prévisions comme outils de planification sans les prendre pour des certitudes.

Petite note sur l’incertitude

Même parmi des experts sérieux, les calendriers d’AGI varient largement car ils dépendent d’hypothèses : ce que signifie « AGI », quels goulots d’étranglement comptent le plus, et la vitesse à laquelle des percées se transforment en produits fiables. Les chronologies de Kurzweil sont influentes non parce qu’elles sont garanties, mais parce qu’elles sont assez spécifiques pour être testées—et assez difficiles à ignorer.

Qui est Ray Kurzweil ?

Ray Kurzweil est un inventeur, auteur et futurologue américain connu pour ses prévisions technologiques à long terme—et pour les étayer avec des graphiques, des données historiques et des échéances audacieuses.

Inventeur, entrepreneur et « repère de motifs »

Kurzweil s’est d’abord fait connaître par des inventions pratiques, notamment dans les technologies de la parole et du texte. Il a créé des entreprises axées sur la reconnaissance optique de caractères (OCR), la synthèse vocale et des outils musicaux, et il a passé des décennies au contact des contraintes produits réelles : qualité des données, coûts matériels, et adoption par les utilisateurs. Cet état d’esprit de bâtisseur façonne ses prévisions—il a tendance à voir le progrès comme quelque chose qui peut être conçu et mis à l’échelle.

Il a aussi travaillé dans de grandes organisations technologiques (dont Google), ce qui renforce sa conviction que les grands bonds proviennent souvent d’investissements soutenus, d’outils meilleurs et d’améliorations composées—et pas seulement de percées isolées.

Livres et idées clés qui nourrissent le débat sur l’AGI

La chronologie d’AGI de Kurzweil est généralement discutée à travers ses ouvrages populaires, en particulier The Age of Spiritual Machines (1999) et The Singularity Is Near (2005). Ces travaux soutiennent que les technologies de l’information s’améliorent de façon accélérée et composée—et que cette accélération finira par produire des machines aux capacités de niveau humain (puis supérieures).

Qu’on adhère ou non, ses écrits ont aidé à fixer les termes de la conversation publique : le progrès de l’IA comme mesurable, piloté par des tendances, et (au moins en principe) prévisible.

Définitions rapides (pour parler de la même chose)

AGI (Artificial General Intelligence) : un système d’IA capable d’apprendre et d’exécuter une large gamme de tâches au niveau approximatif d’un humain, en s’adaptant à de nouveaux problèmes sans être spécialisé étroitement.

Singularité : le terme de Kurzweil pour une période où le progrès technologique devient si rapide (et l’IA si capable) qu’il transforme la société de manière imprévisible et difficile à modéliser.

Chronologie : une prévision avec des dates et des jalons (par exemple « AGI de niveau humain d’ici l’année X »), pas simplement une affirmation générale que le progrès se poursuivra.

Les affirmations centrales de Kurzweil sur les calendriers d’AGI

Kurzweil a soutenu à plusieurs reprises qu’une AGI de niveau humain est probable au cours de la première moitié du XXIe siècle—se situant le plus souvent autour de la fin des années 2020 jusqu’aux années 2030 dans ses interventions publiques et ses livres. Il n’est pas toujours rigide sur une année unique, mais la revendication centrale reste cohérente : lorsque la puissance de calcul, les données et les algorithmes franchiront certains seuils, les systèmes égaleront l’étendue et l’adaptabilité de la cognition humaine.

Dans le cadre de Kurzweil, l’AGI n’est pas la ligne d’arrivée—c’est un déclencheur. Une fois les machines au niveau humain (puis supérieures), le progrès se compose : des systèmes plus intelligents aident à concevoir des systèmes encore plus intelligents, accélérant la découverte scientifique, l’automatisation et l’intégration homme–machine. Cette dynamique composée est ce qu’il associe à l’idée plus large de « singularité technologique » : une période où le changement devient si rapide que l’intuition quotidienne cesse d’être un guide fiable.

AGI vs. les systèmes d’IA d’aujourd’hui

Une nuance clé dans ses affirmations de chronologie est la définition d’AGI. Les modèles actuels peuvent être impressionnants sur de nombreuses tâches, mais ils tendent encore à être :

- fragiles en dehors des schémas d’entraînement,

- faibles en planification à long terme et en ancrage dans le monde réel,

- dépendants d’objectifs et d’évaluations définis par l’humain.

L’« AGI » de Kurzweil implique un système capable de transférer l’apprentissage entre domaines, de former et poursuivre des objectifs dans des situations nouvelles, et de gérer de façon fiable la variété ouverte du monde réel—pas seulement d’exceller sur des benchmarks.

Pourquoi préférer des jalons à une date unique

Prédire une année est facile à débattre et difficile à utiliser. Les jalons sont plus pratiques : apprentissage autonome soutenu, utilisation et planification fiables d’outils, forte performance dans des environnements réels désordonnés, et substitution économique claire sur de nombreux types d’emplois. Même si vous n’êtes pas d’accord avec son calendrier exact, ces points de contrôle rendent la prévision testable—et plus utile que parier sur une seule année médiatique.

Bilan : réussites, erreurs et ce qui reste discuté

Kurzweil est souvent décrit comme un « prédicteur en série », et cette réputation explique en partie pourquoi sa chronologie d’AGI attire l’attention. Mais son bilan est mixte de façon instructive : certains de ses appels étaient précis et mesurables, d’autres étaient juste directionnels, et quelques-uns ont sous-estimé des contraintes importantes.

Prédictions notables souvent associées à Kurzweil

Au fil de ses livres et conférences, il est lié à des prévisions telles que :

- l’amélioration continue du rapport coût/performance des ordinateurs (continuation de tendances à la loi de Moore),

- la reconnaissance vocale devenue largement utilisable par les consommateurs,

- l’informatique mobile et toujours connectée devenant par défaut,

- l’IA surpassant les humains sur des tâches étroites (jeux, reconnaissance de motifs),

- une intégration croissante « homme–machine » (wearables, implants, technologies d’assistance).

Prédictions vérifiables vs. vagues

Prédictions vérifiables sont liées à une date et à un résultat mesurable : « d’ici l’an X, la technologie Y atteindra la performance Z », ou « la majorité des appareils disposeront de la fonctionnalité F ». Celles-ci se testent contre des benchmarks publics (taux de précision, données d’adoption, coûts de calcul).

Prédictions vagues paraissent plausibles mais sont difficiles à falsifier, comme « les ordinateurs seront partout », « l’IA transformera la société », ou « l’homme fusionnera avec la technologie ». Elles peuvent sembler vraies même si les détails, le timing ou les mécanismes diffèrent.

Une manière pratique d’évaluer un prévisionniste est de séparer direction, timing et spécificité.

- Juste : le résultat correspond à l’affirmation et le timing est suffisamment proche pour avoir clairement guidé les attentes.

- Partiellement juste : la direction est correcte, mais le timing glisse, l’adoption est plus lente, ou le résultat arrive sous une autre forme (par ex. « marche en démo » vs « marche pour la plupart des gens, la plupart du temps »).

- Faux : des contraintes clés ont été sous-estimées—limites de données, régulation, comportement des utilisateurs, coûts, ou l’écart entre performance en laboratoire et fiabilité réelle.

Le but n’est pas d’étiqueter des prévisions comme « bonnes » ou « mauvaises », mais de remarquer comment des prédictions confiantes et basées sur des données peuvent reposer sur des hypothèses cachées—surtout quand elles impliquent une adoption sociale complexe, pas seulement du matériel ou des algorithmes qui s’améliorent.

La « loi des rendements accélérés » en clair

La « loi des rendements accélérés » de Kurzweil postule que lorsqu’une technologie s’améliore, ces améliorations facilitent souvent les améliorations ultérieures. Cela crée une boucle de rétroaction où le progrès s’accélère avec le temps.

Tendances exponentielles, expliquées sans mathématiques

Une tendance linéaire (en ligne droite) ressemble à ajouter la même quantité chaque année : 1, 2, 3, 4.

Une tendance exponentielle ressemble à multiplier : 1, 2, 4, 8. Au départ, cela paraît lent—puis soudain tout semble arriver en même temps. Kurzweil soutient que de nombreuses technologies (particulièrement celles de l’information) suivent ce motif parce que chaque génération d’outils aide à construire la suivante.

Kurzweil ne se contente pas de demander « Pouvons-nous faire X ? ». Il demande « À quel prix pouvons-nous faire X ? ». Un schéma courant en informatique est : la performance augmente tandis que le coût baisse. Quand le coût d’exécution d’un modèle utile chute, plus de gens peuvent expérimenter, déployer des produits et financer la vague suivante—ce qui accélère le progrès.

C’est pourquoi il regarde des courbes de long terme comme le « calcul par dollar », pas seulement des démonstrations médiatiques.

Où la loi de Moore s’insère—et où elle ne suffit pas

La loi de Moore est l’exemple classique : pendant des décennies, le nombre de transistors sur les puces doublait selon un calendrier régulier, poussant les ordinateurs à devenir plus rapides et moins chers.

L’argument de Kurzweil n’est pas « la loi de Moore continuera éternellement ». Il est plus large : même si une approche matérielle ralentit, d’autres méthodes (meilleures puces, GPU/TPU, parallélisme, nouvelles architectures, efficience logicielle) peuvent maintenir l’amélioration globale du ratio coût/performance.

Pourquoi une pensée en ligne droite induit en erreur

Les gens prédisent souvent l’avenir en prolongeant le rythme récent. Cela manque la composante de composition. Cela peut rendre le progrès initial peu impressionnant—et plus tard, soudainement tout paraît « soudain » alors qu’il se construisait de façon prévisible sur une courbe depuis des années.

Quelles données soutiennent (et limitent) ces prévisions

Ajoutez un vrai backend

Lancez un backend Go avec PostgreSQL et faites-le évoluer au fil des besoins.

Les prévisions comme celles de Kurzweil commencent généralement par des tendances mesurables—des éléments que l’on peut tracer sur un graphique. C’est une force : on peut débattre des entrées au lieu de s’appuyer sur l’intuition pure. C’est aussi là que surgissent les plus grandes limites.

Les courbes « faciles à mesurer » : calcul, stockage, bande passante, coût

Les prévisionnistes technologiques suivent souvent :

- Calcul (combien d’opérations on peut acheter par dollar),

- Stockage (combien de données on peut garder par dollar),

- Bande passante (à quelle vitesse on peut déplacer des données, et à quel prix),

- Baisse des coûts (pour les puces, instances cloud, runs d’entraînement et énergie par unité de travail).

Ces courbes sont convaincantes parce qu’elles durent dans le temps et sont fréquemment mises à jour. Si votre vision de l’AGI est « assez de matériel plus bon logiciel », ces jeux de données donnent une base solide.

Le progrès matériel n’est pas équivalent au progrès des capacités

Le principal écart : plus de matériel ne produit pas automatiquement des systèmes plus intelligents. La capacité d’une IA dépend des algorithmes, de la qualité des données, des recettes d’entraînement, des outils et du feedback humain—pas seulement des FLOPs.

Une façon utile d’y penser : le matériel est un budget, la capacité est le résultat. La relation entre les deux est réelle, mais elle n’est pas fixe. Parfois un petit changement algorithmique débloque des gains importants ; parfois l’échelle rencontre des rendements décroissants.

Pourquoi les benchmarks et l’usage réel comptent

Pour relier les « inputs » (calcul, argent) aux « outputs » (ce que les modèles peuvent réellement faire), il faut :

- Des benchmarks mesurant le raisonnement, la planification et la généralisation—pas seulement le matching de motifs,

- Des performances en conditions réelles : fiabilité, sécurité, tâches à horizon long, adaptabilité.

Les benchmarks peuvent être biaisés ; les signaux les plus convaincants combinent scores de tests et preuves d’utilité durable.

Pièges courants : graphiques propres, goulets d’étranglement cachés

Deux erreurs fréquentes sont sélectionner les courbes qui semblent les plus exponentielles (cherry-picking) et ignorer des goulots d’étranglement comme la contrainte énergétique, les limites de données, la latence, la régulation ou la difficulté de transformer une compétence étroite en compétence générale. Ces problèmes n’annulent pas la prévision, mais ils élargissent les marges d’erreur.

Hypothèses clés derrière les prévisions à plusieurs décennies

Les chronologies d’AGI à long terme—y compris celles de Kurzweil—reposent moins sur un moment unique de percée que sur un empilement d’hypothèses qui doivent toutes tenir en même temps. Si une couche fléchit, la date peut reculer même si le progrès continue.

1) Calcul, algorithmes et données continuent de se composer

La plupart des prévisions à plusieurs décennies supposent que trois courbes montent ensemble :

- Échelle du calcul : le calcul reste moins cher et plus facile à déployer (plus de puces, plus de clusters, meilleure utilisation).

- Progrès algorithmique : des gains d’efficacité majeurs font que chaque unité de calcul produit plus de capacité.

- Disponibilité des données : les sources restent suffisantes, par de nouvelles données multimodales, données synthétiques, meilleurs outils d’étiquetage ou auto-supervision améliorée.

Une hypothèse cachée : ces trois moteurs ne se remplacent pas parfaitement. Si la qualité des données plafonne, « ajouter juste du calcul » peut produire des rendements moindres.

2) Les contraintes physiques et industrielles ne mordent pas trop fort

Les prévisions traitent souvent le calcul comme une courbe lisse, mais la réalité passe par des usines et des réseaux électriques.

Coûts énergétiques, capacité de fabrication de puces, contrôles d’exportation, bande passante mémoire, équipements réseau et chocs de la chaîne d’approvisionnement peuvent tous limiter la vitesse d’entraînement et de déploiement. Même si la théorie dit « ×10 de calcul », le chemin peut être cahoteux et coûteux.

3) Les systèmes humains permettent un déploiement rapide

Les prévisions à long terme supposent aussi que la société n’entravera pas trop l’adoption :

Régulation, responsabilité, confiance publique, intégration au travail et retour sur investissement influencent si des systèmes avancés sont entraînés et largement utilisés—ou gardés dans des contextes étroits et à haute friction.

4) Les gains de capacité se traduisent en généralité

Peut-être l’hypothèse la plus lourde : les améliorations par montée en charge (meilleur raisonnement, planification, usage d’outils) convergent naturellement vers l’intelligence générale.

« Plus de calcul » peut produire des modèles plus fluides et utiles, mais pas automatiquement plus généraux au sens d’un transfert fiable entre domaines, d’une autonomie à long terme ou d’objectifs stables. Les chronologies longues supposent souvent que ces écarts sont des problèmes d’ingénierie—et non des barrières fondamentales.

Ce qui pourrait retarder l’AGI (même si les tendances montent)

Livrez une interface React rapidement

Créez un front-end React et affinez-le avec des invites simples.

Même si la puissance de calcul et la taille des modèles continuent d’augmenter, l’AGI pourrait arriver plus tard que prévu pour des raisons qui ont peu à voir avec la vitesse brute. Plusieurs goulets sont liés à ce que nous construisons et comment nous savons que ça marche.

1) La définition du problème peut rester floue

« AGI » n’est pas une fonctionnalité unique que l’on active. Une définition utile implique généralement un agent capable de apprendre vite de nouvelles tâches, transférer des compétences, planifier à long terme et gérer des objectifs changeants avec une grande fiabilité.

Si la cible change—assistant bavard vs travailleur autonome vs raisonneur de niveau scientifique—le progrès peut paraître impressionnant tout en manquant des capacités clés comme mémoire à long terme, raisonnement causal ou cohérence décisionnelle.

2) Mesurer l’AGI est plus difficile que mesurer des GPU

Les benchmarks peuvent être manipulés, sur-ajustés ou devenir obsolètes. Les sceptiques demandent des preuves qu’une IA réussit sur tâches inédites, sous contraintes nouvelles, avec faibles taux d’erreur et des résultats reproductibles.

Si le champ ne s’accorde pas sur des tests qui distinguent clairement « excellente complétion de motifs » et « compétence générale », les calendriers restent des conjectures—et la prudence peut ralentir le déploiement.

3) L’alignement et la sécurité peuvent devenir l’élément d’accélération

Les capacités peuvent croître plus vite que la contrôlabilité. Si les systèmes gagnent en agentivité, la barre pour prévenir tromperie, dérives d’objectifs et effets secondaires nocifs monte.

La régulation, les audits et l’ingénierie de la sécurité peuvent ajouter du temps même si les modèles sous-jacents s’améliorent rapidement—surtout pour des usages à forts enjeux.

4) L’incarnation et l’interaction dans le monde réel restent des questions ouvertes

Beaucoup de définitions d’AGI supposent une compétence dans le monde physique : manipuler des objets, mener des expériences, utiliser des outils et s’adapter au feedback en temps réel.

Si l’apprentissage dans le monde réel s’avère gourmand en données, lent ou risqué, l’AGI peut stagner au stade « brillant sur écran »—tandis que la généralité pratique attend de meilleurs robots, simulations et méthodes d’entraînement sûres.

Principales critiques de l’approche de Kurzweil

Les prévisions de Kurzweil sont influentes en partie parce qu’elles sont claires et quantitatives—mais cette même clarté attire des critiques sévères.

Une objection courante est que Kurzweil s’appuie fortement sur l’extension de courbes historiques (calcul, stockage, bande passante). Les critiques soutiennent que la technologie ne se scale pas toujours de manière lisse : le progrès des puces peut ralentir, les coûts énergétiques peuvent peser, et les incitations économiques peuvent changer. Même si la direction à long terme est ascendante, le rythme peut changer de façon à rendre les dates précises peu fiables.

2) Les systèmes complexes n’offrent pas de percées selon un calendrier

L’AGI n’est pas seulement une question de matériel plus rapide. C’est un problème de systèmes complexes impliquant algorithmes, données, méthodes d’entraînement, évaluation, contraintes de sécurité et adoption humaine. Les percées peuvent être bloquées par une idée manquante—quelque chose qui ne se « calendarise » pas. Les sceptiques rappellent que la science avance souvent par des étapes inégales : de longues phases de plateau puis des sauts soudains.

3) Les effets de sélection donnent une meilleure perception des prédictions audacieuses

Une autre critique est psychologique : on se souvient davantage des appels dramatiques réussis que des échecs ou quasi-échecs. Si quelqu’un formule de nombreuses prédictions fortes, quelques succès marquants peuvent dominer la perception publique. Cela n’implique pas que le prévisionniste ait tort, mais cela peut gonfler la confiance dans l’exactitude des calendriers.

4) Pourquoi des personnes intelligentes divergent sur les calendriers

Même des experts qui acceptent un progrès rapide de l’IA diffèrent sur ce qui « compte » comme AGI, quelles capacités doivent se généraliser et comment les mesurer. De fines différences de définition (étendue des tâches, autonomie, fiabilité, apprentissage dans le monde réel) peuvent déplacer les prévisions de plusieurs décennies—sans que quiconque ne change fondamentalement sa lecture du progrès actuel.

Kurzweil est une voix forte, mais les calendriers d’AGI forment un débat crowded. Une manière utile de le cartographier est le camp court terme (AGI en quelques années à quelques décennies) versus le camp long terme (plusieurs décennies ou « pas ce siècle »). Ils regardent souvent les mêmes tendances mais divergent sur ce qui manque : les optimistes à court terme misent sur la montée en charge et l’émergence de capacités, tandis que les sceptiques long terme insistent sur des problèmes non résolus comme le raisonnement fiable, l’autonomie et la robustesse dans le monde réel.

Enquêtes d’experts qui agrègent les croyances de chercheurs et praticiens (par ex. sondages demandant la probabilité à 50 % d’une IA de niveau humain). Elles montrent l’évolution du sentiment, mais reflètent qui a été interrogé et la formulation des questions.

Planification de scénarios évite de choisir une date unique. On dessine plusieurs futurs plausibles (progrès rapide, lent, goulots réglementaires, contraintes matérielles) et on identifie quels signaux indiquerait chaque voie.

Prévisions fondées sur benchmarks et capacités suivent des jalons concrets (tâches de codage, raisonnement scientifique, fiabilité d’agent) et estiment le rythme d’amélioration nécessaire pour atteindre une compétence plus large.

Les définitions changent la date

« AGI » peut signifier réussir une large suite de tests, accomplir la plupart des emplois, fonctionner comme un agent autonome, ou égaler les humains sur des domaines avec une supervision minimale. Une définition stricte rallonge généralement les délais, et ces désaccords expliquent une grande partie de la dispersion des estimations.

L’un des rares points de consensus : l’incertitude

Même les experts optimistes et sceptiques s’accordent souvent sur un point : les calendriers sont fortement incertains, et les prévisions doivent être traitées comme des intervalles conditionnels dépendant d’hypothèses—pas comme des engagements calendaires.

Signaux à surveiller pour les 5–10 prochaines années

Rendez-la prête pour la production

Lancez avec un domaine personnalisé quand votre prototype devient un vrai produit.

Les prévisions d’AGI peuvent paraître abstraites ; il est donc utile de suivre des signaux concrets qui devraient bouger avant tout « grand moment ». Si les chronologies à la Kurzweil sont directionnellement correctes, la prochaine décennie devrait montrer des gains réguliers en capacité, fiabilité, économie et gouvernance.

1) Indicateurs de capacité (ce que les systèmes peuvent réellement faire)

Surveillez des modèles qui planifient de manière fiable sur plusieurs étapes, s’adaptent quand un plan échoue, et utilisent des outils (code, navigateurs, apps de données) sans intervention humaine constante. Le signe le plus significatif n’est pas une démo spectaculaire, mais l’autonomie avec des limites claires : agents qui terminent des tâches de plusieurs heures, posent des questions clarificatrices et délèguent ou stoppent le travail en sécurité quand ils sont incertains.

2) Indicateurs de fiabilité (à quelle fréquence ils se trompent)

Le progrès ressemblera à des taux d’erreur plus faibles dans des workflows réalistes, pas seulement à des scores de benchmark en hausse. Observez si les « hallucinations » diminuent lorsque les systèmes doivent citer leurs sources, effectuer des vérifications ou s’auto-valider. Un jalon clé : de bonnes performances en condition d’audit—même tâche, exécutions multiples, résultats cohérents.

3) Indicateurs économiques (où la valeur apparaît)

Cherchez des gains de productivité mesurables dans des rôles spécifiques (support, analyse, développement logiciel, opérations), ainsi que de nouvelles catégories d’emplois centrées sur la supervision et l’intégration d’IA. Les coûts comptent aussi : si la production de haute qualité devient moins chère (par tâche, par heure), l’adoption s’accélère—surtout pour les petites équipes.

Si les capacités augmentent, la gouvernance devrait évoluer des principes à la pratique : normes, audits tiers, rapports d’incident et régulation clarifiant la responsabilité. Surveillez aussi le monitoring du calcul et les règles de reporting—des signaux que gouvernements et industrie traitent la montée en charge comme un levier traçable et contrôlable.

Si vous voulez utiliser ces signaux sans vous laisser emporter par les gros titres, voyez /blog/ai-progress-indicators.

Enseignements pratiques : utiliser les prévisions sans leur faire une confiance aveugle

Les chronologies d’AGI sont mieux traitées comme des prévisions météo pour une date lointaine : utiles pour planifier, peu fiables comme promesse. Les prédictions à la Kurzweil peuvent vous aider à repérer des tendances long terme et à éprouver vos décisions, mais elles ne doivent pas être le seul point de défaillance de votre stratégie.

Utilisez les prévisions pour explorer des plages et des scénarios, pas une seule année. Si quelqu’un dit « AGI d’ici 203X », traduisez cela par : « Quels changements doivent se produire pour que cela soit vrai—et que se passe-t-il s’ils ne surviennent pas ? » Puis planifiez plusieurs issues.

Questions à poser sur toute prévision

- Définition : Que veulent-ils dire par « AGI » ? Niveau humain aux tests, utilité large au travail, ou « peut tout apprendre » ? Différentes définitions produisent différents calendriers.

- Données : Quels indicateurs utilisent-ils—calcul, efficience d’entraînement, benchmarks, taux de déploiement—et qu’est-ce qui est ignoré ?

- Hypothèses : Supposent-ils que les algorithmes, la disponibilité des données, l’énergie, les puces et la gouvernance continuent sans heurt ?

- Incitations : Vendent-ils un produit, lèvent-ils des fonds ou militent-ils pour une politique ? Les incitations peuvent biaiser la certitude et les délais.

Planification pratique : compétences, stratégie et conscience des risques

Pour les individus : développez des compétences durables (mise en cadre de problèmes, expertise sectorielle, communication) et entretenez l’habitude d’apprendre de nouveaux outils.

Pour les entreprises : investissez dans la littératie IA, la qualité des données et des projets pilotes avec ROI clair—tout en gardant une stratégie « sans regrets » qui fonctionne si l’AGI arrive plus tard.

Une façon pragmatique d’opérationnaliser « surveiller les signaux et itérer » est de raccourcir les cycles de construction : prototyper des workflows, tester la fiabilité et quantifier les gains de productivité avant de faire de gros paris. Des plateformes comme Koder.ai s’inscrivent dans cette approche en permettant aux équipes de créer des applications web, backend et mobiles via une interface conversationnelle (mode planification, snapshots et rollback), pour prototyper rapidement des processus assistés par agents, exporter le code source si nécessaire et éviter de verrouiller la stratégie sur une seule prévision.

Conclusion équilibrée : les calendriers peuvent guider la préparation, pas déterminer la certitude. Utilisez-les pour prioriser des expériences et réduire les angles morts—puis réévaluez régulièrement vos hypothèses à mesure que de nouvelles preuves apparaissent.