Ce que sont les runtimes JavaScript et pourquoi ils comptent

JavaScript est le langage. Un runtime JavaScript est l’environnement qui rend le langage utile en dehors d’un navigateur : il embarque un moteur JavaScript (comme V8) et l’entoure des fonctionnalités système dont les vraies applications ont besoin — accès aux fichiers, réseau, timers, gestion des processus et APIs pour la crypto, les streams, et plus encore.

Si le moteur est le « cerveau » qui comprend JavaScript, le runtime est tout le « corps » capable de parler à votre système d’exploitation et à Internet.

Où les runtimes interviennent

Les runtimes modernes ne servent pas seulement aux serveurs web. Ils alimentent :

- Serveurs et APIs (applications backend traditionnelles)

- Outils CLI (formatters, outils de build, scripts d’automatisation)

- Fonctions edge (code exécuté proche des utilisateurs, souvent avec des limites plus strictes)

- Applications desktop (souvent via des frameworks qui embarquent un runtime)

Le même langage peut s’exécuter partout, mais chaque environnement a des contraintes différentes — temps de démarrage, limites mémoire, frontières de sécurité et APIs disponibles.

Pourquoi plusieurs runtimes existent (et évoluent)

Les runtimes évoluent parce que les développeurs veulent des compromis différents. Certains privilégient la compatibilité maximale avec l’écosystème Node.js existant. D’autres visent des paramètres de sécurité plus stricts par défaut, une ergonomie TypeScript améliorée, ou des démarrages à froid plus rapides pour les outils.

Même lorsque deux runtimes partagent le même moteur, ils peuvent différer de façon spectaculaire sur :

- Les APIs intégrées et le support des standards

- L’approche de gestion des paquets

- Le modèle d’autorisations et d’isolation

- L’expérience tooling (tests, formatage, bundling)

Ce que signifie vraiment « se concurrencer »

La concurrence ne porte pas seulement sur la vitesse. Les runtimes se disputent l’adoption (communauté et part de voix), la compatibilité (dans quelle mesure le code existant « fonctionne tel quel ») et la confiance (posture de sécurité, stabilité, maintenance à long terme). Ces facteurs déterminent si un runtime devient un choix par défaut — ou un outil de niche qu’on n’utilise que pour certains projets.

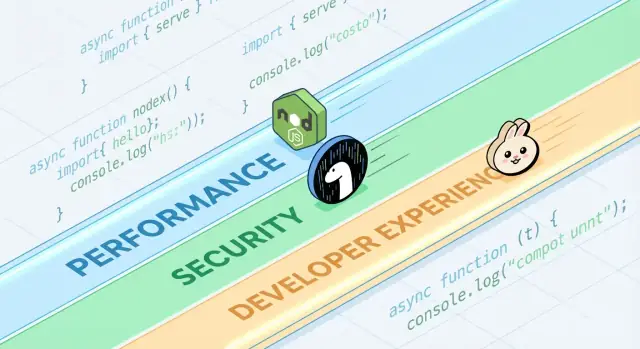

Tour d’horizon rapide des runtimes populaires

Quand on parle de « runtime JavaScript », on entend généralement « l’environnement qui exécute JS en dehors (ou à l’intérieur) d’un navigateur, plus les APIs que vous utilisez pour réellement construire des choses. » Le runtime choisi façonne la manière dont vous lisez des fichiers, démarrez des serveurs, installez des paquets, gérez les permissions et déboguez en production.

Exemples courants dont vous entendrez parler

Node.js est le choix de longue date pour JavaScript côté serveur. Il possède l’écosystème le plus large, des outils matures et une énorme dynamique communautaire.

Deno a été conçu avec des choix modernes : support TypeScript natif, posture de sécurité plus stricte par défaut, et une approche bibliothèque standard « batteries included ».

Bun met fortement l’accent sur la vitesse et la commodité développeur, regroupant un runtime rapide avec une chaîne d’outils intégrée (installation de paquets, tests) visant à réduire le travail de configuration.

Runtimes navigateur (Chrome, Firefox, Safari) restent les runtimes JS les plus répandus globalement. Ils sont optimisés pour l’UI et livrent des Web APIs comme le DOM, fetch et le stockage — mais ils n’offrent pas d’accès direct au système de fichiers comme le font les runtimes serveur.

Ce qui est commun aux runtimes

La plupart des runtimes associent un moteur JavaScript (souvent V8) à une boucle d’événements et un ensemble d’APIs pour le réseau, les timers, les streams, et plus. Le moteur exécute le code ; la boucle d’événements coordonne le travail asynchrone ; les APIs sont ce que vous appelez au quotidien.

Ce qui diffère (et pourquoi cela compte au quotidien)

Les différences apparaissent dans les fonctionnalités intégrées (comme le traitement TypeScript natif), les outils par défaut (formatter, linter, test runner), la compatibilité avec les APIs Node, et les modèles de sécurité (par exemple, accès fichier/réseau libre ou soumis à permissions). C’est pourquoi le choix du runtime n’est pas abstrait — il affecte la rapidité de démarrage d’un projet, la sécurité d’exécution des scripts et la facilité (ou difficulté) du déploiement et du debug.

« Rapide » n’est pas un nombre unique. Un runtime JavaScript peut briller sur un graphique et paraître ordinaire sur un autre, parce qu’il optimise des définitions de vitesse différentes.

Latence vs débit

La latence est la rapidité d’exécution d’une seule requête ; le débit est le nombre de requêtes traitées par seconde. Un runtime optimisé pour un temps de démarrage faible et des réponses rapides peut sacrifier le débit maximal sous forte concurrence, et inversement.

Par exemple, une API qui sert des profils utilisateurs se soucie de la latence de queue (p95/p99). Un job batch qui traite des milliers d’événements par seconde se préoccupera davantage du débit et de l’efficacité en régime permanent.

Temps de démarrage à froid (serverless et CLI)

Le cold start est le temps entre « rien ne tourne » et « prêt à travailler ». Il compte beaucoup pour les fonctions serverless qui scale to zero, et pour les outils CLI lancés fréquemment par les utilisateurs.

Les cold starts sont influencés par le chargement des modules, la transpilation TypeScript (le cas échéant), l’initialisation des APIs intégrées et la quantité de travail que le runtime effectue avant que votre code ne s’exécute. Un runtime peut être très rapide une fois chaud, mais donner l’impression d’être lent s’il met du temps à démarrer.

La majeure partie du JavaScript côté serveur est lié à l’I/O : requêtes HTTP, appels BD, lecture de fichiers, streaming de données. Ici, la performance tient souvent à l’efficacité de la boucle d’événements, à la qualité des bindings I/O asynchrones, aux implémentations de streams et à la gestion du backpressure.

De petites différences — comme la vitesse d’analyse des en‑têtes, la programmation des timers ou la vidange des écritures — peuvent se traduire par des gains concrets dans des serveurs web et des proxies.

Travail lié au CPU : forces et limites des moteurs

Les tâches lourdes en CPU (parsing, compression, traitement d’images, crypto, analytics) sollicitent le moteur JavaScript et le compilateur JIT. Les moteurs peuvent optimiser les chemins chauds, mais JavaScript garde des limites pour des charges numériques soutenues.

Si le travail CPU domine, le « runtime le plus rapide » peut être celui qui facilite le déplacement des boucles chaudes vers du code natif ou l’utilisation de workers sans complexité excessive.

Vérification pragmatique des benchmarks (et pièges courants)

Les benchmarks peuvent être utiles, mais ils sont faciles à mal interpréter — surtout lorsqu’ils sont traités comme des tableaux de scores universels. Un runtime qui « gagne » un graphique peut néanmoins être plus lent pour votre API, votre pipeline de build ou votre traitement de données.

Microbenchmarks vs applications réelles

Les microbenchmarks testent généralement une petite opération (parsing JSON, regex, hashing) dans une boucle serrée. C’est utile pour mesurer un ingrédient, pas le plat complet.

Les applications réelles passent du temps sur des choses ignorées par les microbenchmarks : latences réseau, appels BD, I/O fichiers, surcharge de framework, logging et pression mémoire. Si votre charge est surtout I/O‑bound, une boucle CPU 20 % plus rapide ne changera peut‑être pas votre latence de bout en bout.

Les résultats changent selon la charge, l’OS et les versions

De petites différences d’environnement peuvent inverser les résultats :

- Forme de la charge : nombreuses petites requêtes vs quelques grosses ; streaming vs buffering.

- OS et matériel : Linux vs macOS ; CPU différents ; limites de conteneur.

- Versions du runtime et dépendances : mises à jour du moteur, différences de libc, changements de bibliothèques.

Quand vous voyez une capture de benchmark, demandez quelles versions et quels flags ont été utilisés — et si cela correspond à votre setup de production.

Effets de warm‑up (JIT) et de cache

Les moteurs JavaScript utilisent la compilation JIT : le code peut être plus lent au départ, puis s’accélérer une fois que le moteur « apprend » les chemins chauds. Si un benchmark ne mesure que les premières secondes, il peut récompenser les mauvais comportements.

Le cache compte aussi : cache disque, cache DNS, keep‑alive HTTP et caches applicatifs peuvent rendre les exécutions ultérieures beaucoup meilleures. Cela peut être réel, mais doit être contrôlé.

Concevoir des tests justes et reproductibles

Visez des benchmarks qui répondent à vos questions, pas à celles des autres :

- Mesurez bout à bout : incluez le framework + middleware typique + tailles de payload réalistes.

- Séparez cold vs warm : enregistrez le démarrage, la première requête et l’état stable.

- Lancez plusieurs essais : rapportez la médiane et la variance, pas seulement la meilleure exécution.

- Verrouillez l’environnement : figez les versions, isolez le CPU et documentez les commandes.

Si vous avez besoin d’un modèle pratique, capturez votre harness de test dans un repo et liez‑le depuis la documentation interne (ou une page /blog/runtime-benchmarking-notes) afin que les résultats puissent être reproduits plus tard.

Sous le capot : moteurs, APIs et modèles d’exécution

Testez le démarrage à froid d'une CLI

Élaborez rapidement un outil CLI et comparez les compromis entre démarrage à froid et packaging.

Quand on compare Node.js, Deno et Bun, on parle souvent de fonctionnalités et de benchmarks. En profondeur, le « ressenti » d’un runtime est façonné par quatre éléments : le moteur JavaScript, les APIs intégrées, le modèle d’exécution (boucle d’événements + planificateurs) et la manière dont le code natif est connecté.

Moteurs : V8, JavaScriptCore, et pourquoi ça compte

Le moteur est la partie qui parse et exécute le JavaScript. V8 (utilisé par Node.js et Deno) et JavaScriptCore (utilisé par Bun) réalisent des optimisations avancées comme la compilation JIT et la gestion de la mémoire.

En pratique, le choix du moteur peut influencer :

- Le temps de démarrage et le comportement mémoire (à quelle vitesse un processus devient utile)

- La performance du « code chaud » après optimisation

- Quelles fonctionnalités bas‑niveau arrivent en premier (certains moteurs livrent de nouvelles capacités JS plus tôt que d’autres)

APIs intégrées : plus que « puis‑je fetcher ? »

Les runtimes modernes se concurrencent sur la complétude de leur bibliothèque standard. Avoir des éléments intégrés comme fetch, Web Streams, utilitaires URL, APIs fichiers et crypto peut réduire la prolifération de dépendances et rendre le code plus portable entre serveur et navigateur.

La nuance : un même nom d’API ne signifie pas toujours un comportement identique. Les différences de streaming, timeouts ou file watching peuvent impacter davantage les apps réelles que la simple vitesse brute.

Modèles d’exécution : boucles d’événements, planificateurs et bindings natifs

Le JavaScript est mono‑thread au niveau supérieur, mais les runtimes coordonnent du travail en arrière‑plan (réseau, I/O fichiers, timers) via une boucle d’événements et des planificateurs internes. Certains runtimes s’appuient fortement sur des bindings natifs (code compilé) pour l’I/O et les tâches critiques en performance, tandis que d’autres privilégient les interfaces web‑standard.

WebAssembly : quand ça aide

WebAssembly (Wasm) est utile lorsque vous avez besoin de calcul rapide et prévisible (parsing, traitement d’images, compression) ou que vous voulez réutiliser du code Rust/C/C++. Ça n’accélèrera pas magiquement des serveurs web I/O‑bound, mais c’est un excellent outil pour des modules CPU‑bound.

Sécurité : valeurs par défaut, permissions et réalité de la supply chain

« Sécurisé par défaut » dans un runtime JavaScript signifie généralement que le runtime considère le code comme non fiable jusqu’à ce que vous accordiez explicitement l’accès. Cela inverse le modèle serveur traditionnel (où les scripts peuvent souvent lire des fichiers, appeler le réseau, et inspecter l’environnement par défaut) en une posture plus prudente.

Dans le même temps, beaucoup d’incidents réels commencent avant même l’exécution de votre code — dans vos dépendances et le processus d’installation — donc la sécurité au niveau du runtime n’est qu’une couche parmi d’autres.

Permissions et allowlists

Certains runtimes peuvent filtrer les capacités sensibles derrière des permissions. La version pratique de cela est une allowlist :

- Système de fichiers : autoriser lecture/écriture seulement sur des chemins précis (ex. un dossier de config)

- Réseau : autoriser les requêtes sortantes seulement vers des hôtes/ports approuvés

- Variables d’environnement : exposer seulement des clés spécifiques plutôt que tout le process env

Cela peut réduire les fuites accidentelles (comme envoyer des secrets vers un endpoint inattendu) et limiter le rayon d’impact quand vous exécutez du code tiers — notamment dans les CLI, outils de build et automatisations.

Le sandboxing a des limites

Les permissions ne sont pas une protection magique. Si vous accordez l’accès réseau à « api.monentreprise.com », une dépendance compromise peut toujours exfiltrer des données vers ce même hôte. Et si vous autorisez la lecture d’un répertoire, vous faites confiance à tout ce qui s’y trouve. Le modèle aide à exprimer l’intention, mais il faut aussi de la vérification des dépendances, des lockfiles et une revue attentive de ce qu’on autorise.

Valeurs par défaut sécurisées dans les APIs courantes

La sécurité se niche aussi dans les petits choix par défaut :

- TLS/HTTPS : validation des certificats et réglages modernes par défaut

- HTTP : comportement sûr pour les redirections et contrôle clair des headers/cookies

- APIs crypto : primitives modernes avec des interfaces difficiles à mal utiliser

Le compromis est la friction : des defaults plus stricts peuvent casser des scripts legacy ou ajouter des flags à maintenir. Le meilleur choix dépend de si vous privilégiez la commodité pour des services de confiance, ou des garde‑fous pour l’exécution de code à confiance mixte.

Risques de supply chain à ne pas ignorer

Les attaques sur la supply chain exploitent souvent la manière dont les paquets sont découverts et installés :

- Typosquatting : un paquet malveillant nommé presque comme un paquet populaire (ex.

expresss).

- Dependency confusion : un paquet public publié avec le même nom qu’un paquet interne, trompant l’installeur.

- Mainteneurs compromis : un compte piraté qui publie une mise à jour « légitime » injectant du code.

Ces risques touchent tout runtime qui récupère depuis un registre public — l’hygiène compte donc autant que les fonctionnalités du runtime.

Lockfiles, vérifications d’intégrité et provenance

Les lockfiles fixent des versions exactes (y compris les dépendances transitives), rendant les installations reproductibles et limitant les mises à jour surprises. Les vérifications d’intégrité (hashes enregistrés dans le lockfile ou metadata) aident à détecter une altération pendant le téléchargement.

La provenance est l’étape suivante : pouvoir répondre à « qui a construit cet artefact, depuis quel code source, avec quel workflow ? » Même si vous n’adoptez pas encore des outils de provenance complets, vous pouvez vous en rapprocher en :

- préférant des paquets bien maintenus avec des pratiques de release transparentes,\n- évitant les dépendances Git non figées pour les builds de production,\n- exigeant des tags/releases plutôt que d’installer depuis des commits aléatoires.

Workflows d’audit et de mise à jour qui fonctionnent

Traitez les dépendances comme de la maintenance régulière :

- lancez des audits automatisés en CI pour chaque pull request,\n- planifiez des fenêtres régulières de mise à jour (hebdomadaires/bihebdomadaires) pour éviter les upgrades « big bang »,\n- lisez les changelogs pour les sauts majeurs et les correctifs de sécurité.

Politiques d’équipe qui n’entravent pas la livraison

Des règles légères sont souvent suffisantes :

- bloquer les nouvelles dépendances sauf nécessité claire et propriétaire dédié,\n- restreindre les scripts d’installation quand c’est possible (ils sont une voie d’exécution courante),\n- utiliser un registre privé ou des packages scoped pour les noms internes afin de réduire la confusion.

La bonne hygiène, c’est moins la perfection que des habitudes constantes et ennuyeuses.

Compatibilité et écosystème comme avantages concurrentiels

La performance et la sécurité font la une, mais la compatibilité et l’écosystème déterminent souvent ce qui est effectivement déployé. Un runtime qui exécute votre code existant, supporte vos dépendances et se comporte de la même façon entre environnements réduit le risque plus que n’importe quelle fonctionnalité isolée.

La compatibilité affecte la sécurité et la maintenance

La compatibilité n’est pas qu’une question de commodité. Moins de réécritures signifie moins d’occasions d’introduire des bugs subtils, et moins de correctifs ad hoc qu’on oubliera de maintenir. Les écosystèmes matures ont aussi des modes d’échec mieux connus : les bibliothèques communes ont été plus souvent auditées, les problèmes sont documentés et les mesures d’atténuation sont plus faciles à trouver.

En contrepartie, « compatibilité à tout prix » peut maintenir des patterns legacy (comme des accès large au fichier/réseau), donc les équipes ont toujours besoin de limites claires et d’une bonne hygiène des dépendances.

Couches de compatibilité Node vs APIs standard web

Les runtimes qui visent une compatibilité drop‑in avec Node.js peuvent exécuter la plupart du JavaScript serveur immédiatement, ce qui est un avantage pratique énorme. Les couches de compatibilité peuvent lisser les différences, mais elles peuvent aussi masquer des comportements spécifiques au runtime — surtout autour du système de fichiers, du réseau et de la résolution de modules — rendant le debug plus difficile lorsqu’un comportement diffère en production.

Les APIs web‑standards (comme fetch, URL et Web Streams) poussent le code vers la portabilité entre runtimes et même vers les environnements edge. Le compromis : certains paquets Node supposent les internals de Node et ne fonctionneront pas sans shims.

Écosystème NPM : forces et compromis

La plus grande force de NPM est simple : il contient presque tout. Cette étendue accélère la livraison, mais augmente l’exposition au risque de la supply chain et au gonflement des dépendances. Même quand un paquet est « populaire », ses dépendances transitives peuvent vous surprendre.

Quand « marche partout » l’emporte sur les nouvelles fonctionnalités

Si votre priorité est des déploiements prévisibles, un recrutement plus facile et moins de surprises d’intégration, « marche partout » est souvent la caractéristique gagnante. Les nouvelles capacités runtime sont excitantes — mais la portabilité et un écosystème éprouvé peuvent vous faire gagner des semaines sur la durée d’un projet.

Expérience développeur : outils, typage et debug

Comparez Node et les API web

Prototypiez une version compatible Node et une version conforme aux standards web côte à côte.

L’expérience développeur est l’endroit où les runtimes gagnent ou perdent en silence. Deux runtimes peuvent exécuter le même code, mais donner des sensations totalement différentes lorsqu’on configure un projet, traque un bug ou essaie de livrer un petit service rapidement.

Support TypeScript : natif vs « apportez vos propres outils »

TypeScript est un bon test UX. Certains runtimes le traitent comme une entrée de première classe (vous pouvez exécuter des fichiers .ts avec peu de cérémonie), tandis que d’autres attendent une chaîne d’outils traditionnelle (tsc, un bundler, ou un loader) à configurer.

Aucune approche n’est universellement « meilleure » :

- Le support intégré réduit la configuration et peut standardiser des defaults pour une équipe.\n- La chaîne configurée vous donne un contrôle fin sur tsconfig, cibles d’émission et sortie — utile pour les librairies et les monorepos plus larges.

La question clé est de savoir si l’histoire TypeScript du runtime correspond à la manière dont votre équipe livre réellement le code : exécution directe en dev, builds compilés en CI, ou les deux.

Bundling, transpilation et defaults de test

Les runtimes modernes intègrent de plus en plus des outils opinionnés : bundlers, transpilers, linters et test runners prêts à l’emploi. Cela peut éliminer le coût de “choisir sa propre stack” pour les petits projets.

Mais les defaults ne sont positifs pour la DX que s’ils sont prévisibles :

- Pouvez‑vous facilement changer les formats de sortie (ESM/CJS), les cibles et les dépendances externes ?\n- Le test runner s’intègre‑t‑il bien avec le coverage et la CI ?\n- La configuration est‑elle minimale et stable entre versions ?

Si vous démarrez souvent de nouveaux services, un runtime avec de bons outils intégrés et une documentation claire peut vous faire gagner des heures par projet.

Debugging : traces de pile, sourcemaps et inspecteurs

Le debug révèle la qualité d’un runtime. Des stack traces lisibles, une gestion correcte des sourcemaps et un inspecteur qui « fonctionne » réduisent le temps pour comprendre des défaillances.

Cherchez :

- Des erreurs claires pointant vers votre code (et non du code généré)

- Des traces asynchrones fiables

- Une bonne intégration avec les éditeurs et des inspecteurs de style Chrome DevTools

Templates et scaffolds qui réduisent la friction

Les générateurs de projet peuvent être sous‑estimés : un template propre pour une API, un CLI ou un worker donne souvent le ton d’une base de code. Préférez des scaffolds qui créent une structure minimale et orientée production (logging, gestion d’env, tests) sans vous enfermer dans un framework lourd.

Si vous cherchez de l’inspiration, voyez les guides liés dans /blog.

Comme workflow pratique, les équipes utilisent parfois Koder.ai pour prototyper un petit service ou CLI dans différents « styles de runtime » (Node‑first vs APIs web‑standards), puis exporter le code généré pour un véritable test de benchmark. Ce n’est pas un substitut aux tests en production, mais cela raccourcit le temps entre idée → comparaison exécutable quand vous évaluez des compromis.

La gestion des paquets façonne la DX

La gestion des paquets est l’endroit où « expérience développeur » devient tangible : vitesse d’installation, comportement du lockfile, support des workspaces et reproductibilité des builds en CI. Les runtimes la traitent de plus en plus comme une fonctionnalité première plutôt qu’un après‑pensée.

Node.js a historiquement reposé sur des outils externes (npm, Yarn, pnpm), ce qui est à la fois une force (choix) et une source d’incohérence entre équipes. Les runtimes récents livrent des opinions : Deno intègre la gestion des dépendances via deno.json (et supporte les paquets npm), tandis que Bun embarque un installeur rapide et un lockfile.

Ces outils natifs optimisent souvent pour moins d’aller‑retour réseau, un cache agressif et une intégration serrée avec le loader du runtime — utile pour les cold starts en CI et l’onboarding des nouveaux arrivants.

Monorepos, workspaces et bases de cache

La plupart des équipes finissent par avoir besoin de workspaces : packages internes partagés, versions de dépendances cohérentes et règles de hoisting prévisibles. npm, Yarn et pnpm supportent tous les workspaces, mais diffèrent sur l’usage disque, la disposition de node_modules et la déduplication. Cela affecte le temps d’installation, la résolution dans l’éditeur et les bugs “ça marche chez moi”.

Le cache compte tout autant. Une bonne base est de mettre en cache le store du gestionnaire (ou le cache de téléchargement) + étapes d’installation basées sur le lockfile, puis de garder les scripts déterministes. Si vous voulez un point de départ simple, documentez‑le dans /docs.

Publication et consommation : ce que les équipes doivent savoir

La publication interne (ou la consommation de registres privés) pousse à standardiser l’auth, les URLs de registre et les règles de versioning. Assurez‑vous que votre runtime/outillage supporte les mêmes conventions .npmrc, vérifications d’intégrité et attentes de provenance.

Inquiétudes de migration : changements de lockfile et ajustements CI

Changer de gestionnaire de paquets ou adopter un installeur fourni par le runtime modifie typiquement les lockfiles et les commandes d’installation. Préparez le churn de PRs, mettez à jour les images CI et alignez‑vous sur un seul lockfile « source of truth » — sinon vous déboguerez la dérive des dépendances au lieu de livrer des fonctionnalités.

Choisir un runtime par cas d’usage (pas par hype)

Créez une API prête pour les benchmarks

Créez une petite API depuis le chat, puis utilisez-la comme cible réaliste de benchmark de bout en bout.

Choisir un runtime JavaScript, c’est moins choisir « le plus rapide sur un graphique » que considérer la forme de votre travail : comment vous déployez, à quoi vous devez vous intégrer, et quel niveau de risque votre équipe peut absorber. Un bon choix est celui qui réduit la friction pour vos contraintes.

Serverless et workloads edge

Ici, le cold‑start et le comportement en concurrence comptent autant que le débit brut. Cherchez :

- Temps de démarrage (rapidité à commencer à traiter des requêtes)

- Modèle d’isolation (processus vs isolates/workers)

- Disponibilité des APIs (Web APIs,

fetch, streams, crypto) sur la plateforme cible

Node.js est largement supporté chez les providers ; les APIs web‑standards et le modèle d’autorisations de Deno peuvent être attractifs quand ils sont disponibles ; la rapidité de Bun peut aider, mais vérifiez le support plateforme et la compatibilité edge avant de vous engager.

Outils CLI et automatisation

Pour les utilitaires en ligne de commande, la distribution peut dominer la décision. Priorisez :

- Builds en un seul binaire et installations prévisibles

- Comportement cross‑platform (macOS, Windows, Linux)

- Démarrage rapide et bonne ergonomie développeur

Le tooling intégré et la distribution facile de Deno sont forts pour les CLI. Node.js est solide si vous avez besoin de l’étendue de npm. Bun peut être excellent pour des scripts rapides, mais validez l’emballage et le support Windows pour votre audience.

Conteneurs et services longue durée

Dans les conteneurs, la stabilité, le comportement mémoire et l’observabilité l’emportent souvent sur les benchmarks. Évaluez l’utilisation mémoire en régime, le GC sous charge et la maturité des outils de debug/profiling. Node.js tend à être le « par défaut sûr » pour des services de longue durée en production grâce à la maturité de son écosystème et la familiarité opérationnelle.

Contraintes d’équipe qui surpassent la nouveauté

Choisissez le runtime qui correspond aux compétences actuelles de votre équipe, aux bibliothèques et à l’exploitation (CI, monitoring, incident response). Si un runtime vous force à réécrire, introduire de nouveaux workflows de debug ou clarifier des pratiques de dépendances, tout gain de performance peut être effacé par le risque de livraison.

Si votre objectif est de livrer des fonctionnalités produit plus vite (et pas de débattre des runtimes), considérez où JavaScript se place réellement dans votre stack. Par exemple, Koder.ai se concentre sur la construction complète d’applications via chat — frontends web en React, backends en Go avec PostgreSQL, mobiles en Flutter — donc les équipes réservent souvent les « décisions de runtime » aux endroits où Node/Deno/Bun comptent vraiment (outillage, scripts edge, services JS existants), tout en avançant rapidement avec une base production‑shaped.

Checklist de décision et prochaines étapes

Choisir un runtime, c’est moins choisir un « gagnant » que réduire le risque tout en améliorant les résultats pour votre équipe et produit.

Une checklist courte

- Tests de performance : Connaissez‑vous vos 3 principaux goulots d’étranglement (démarrage, débit de requêtes, travail CPU, latence I/O) ? Pouvez‑vous les reproduire localement et en CI ?

- Besoins de sécurité : Avez‑vous besoin d’un modèle de permissions (accès fichier/réseau/env), d’un sandboxing plus serré, ou de contrôles conformes ?

- Priorités DX : Quelle friction vous coûte le plus aujourd’hui — configuration TypeScript, debugging, hot reload, tooling de test, packaging de déploiement ?

Questions à poser avant de changer de runtime

- Quel problème essayons‑nous de résoudre : coût, latence, vitesse des développeurs ou sécurité ?

- Quelles parties de notre système sont sensibles au runtime (fonctions edge, CLI, APIs, jobs background) ?

- Sommes‑nous liés à un comportement d’écosystème spécifique (addons natifs, scripts postinstall, attentes CommonJS/ESM) ?

- Quel est notre plan de rollback si une dépendance ou une intégration plateforme se comporte différemment ?

- Qui prendra en charge les mises à jour du runtime et le suivi des breaking changes ?

Plan pilote pratique

Commencez petit et mesurable :

- Choisissez un service ou outil interne avec entrées/sorties claires (ex. un handler webhook, un CLI, un petit worker).\n2. Définissez des métriques de succès : latence p95, mémoire, CPU, temps de build, cold start et temps développeur pour corriger un bug.\n3. Lancez le pilote dans deux environnements : staging et un canary production (si faisable).\n4. Comparez les résultats, documentez les surprises, puis itérez (ajustez la config, les choix de dépendances) avant d’envisager une migration plus large.

Si vous voulez accélérer la boucle de feedback, vous pouvez prototyper le service et le harness de benchmark rapidement dans Koder.ai, utiliser Planning Mode pour définir l’expérience (métriques, endpoints, payloads), puis exporter le code source afin que les mesures finales s’exécutent dans l’environnement exact que vous contrôlez.

Où en apprendre plus ensuite

Consultez les sources primaires et signaux continus :

- La documentation officielle et les notes de compatibilité pour Node.js, Deno et Bun

- Les notes de version et changelogs (surveillez les correctifs de sécurité et les breaking changes)

- Les avis de sécurité et flux CVE pertinents pour vos dépendances

- Les trackers d’issues communautaires pour repérer des cas réels limites

Si vous voulez un guide plus approfondi pour mesurer les runtimes équitablement, voyez /blog/benchmarking-javascript-runtimes.