Définir les objectifs et le sens de la couverture d’automatisation

Avant de construire quoi que ce soit, écrivez ce que « couverture d’automatisation » signifie dans votre organisation. Sinon, le tableau de bord devient un fourre‑tout de chiffres sans lien, interprétés différemment par chaque équipe.

Qu’est‑ce qui compte comme couverture d’automatisation ?

Commencez par choisir les unités que vous mesurez. Options courantes :

- Processus métier ou opérationnels (par ex. « onboarding d’un nouveau client ») : la couverture signifie « étapes automatisées vs manuelles ».

- Tests (unitaires/intégration/e2e) : la couverture signifie « quels flux critiques sont vérifiés automatiquement ».

- Jobs et runbooks (tâches planifiées, playbooks d’incident) : la couverture signifie « quelle part du travail peut tourner sans intervention humaine ».

- Scripts et bots (scripts ponctuels, RPA, outils internes) : la couverture signifie « tâches répétables prises en charge avec une intervention humaine minimale ».

Choisissez une définition primaire pour la v1, puis notez les types secondaires à ajouter plus tard. Soyez explicite sur les cas limites, comme les étapes « semi‑automatisées » qui requièrent encore des approbations.

Qui utilisera l’app et quelles questions doivent-ils pouvoir répondre ?

Différents publics posent des questions différentes :

- Engineering / QA : Quelles zones manquent d’automatisation ? Qu’est‑ce qui a changé cette semaine ? Où sont les automatisations instables ?

- Ops / Support : Quels workflows dépendent encore d’humains ? Qu’est‑ce qui casse le plus souvent ?

- Direction : Réduisons‑nous le risque et le travail manuel dans le temps ? Quelles équipes nécessitent un investissement ?

Rédigez 5–10 « questions principales » et traitez‑les comme des exigences produit.

Résultats attendus, périmètre et critères de succès

Définissez les résultats principaux : visibilité (ce qui existe), priorisation (quoi automatiser ensuite), responsabilisation (qui en est responsable) et suivi des tendances (ça s’améliore‑t‑il ?).

Fixez des limites claires pour la v1. Exemples : « Nous n’évaluerons pas encore la qualité », « Nous ne mesurerons pas le temps économisé », ou « Nous n’inclurons que les tests basés CI, pas les scripts locaux ».

Enfin, décidez ce qu’est le succès : adoption régulière (utilisateurs actifs hebdomadaires), fraîcheur des données élevée (mises à jour sous 24h), moins de zones aveugles (couverture cartographiée pour tous les systèmes critiques) et suivi mesurable (propriétaires assignés et écarts qui diminuent mois après mois).

Cartographier les sources de données et les options d’ingestion

Avant de mesurer la couverture d’automatisation, identifiez où se trouvent réellement les « preuves d’automatisation ». Dans la plupart des organisations, l’automatisation est dispersée dans des outils adoptés à des moments différents par diverses équipes.

Inventoriez vos sources d’automatisation

Commencez par un inventaire pragmatique qui répond : Quels signaux prouvent qu’une activité est automatisée, et où peut‑on les récupérer ?

Sources typiques : pipelines CI (jobs de build/test), frameworks de test (unitaires/intégration/E2E), outils de workflow (approbations, déploiements, transitions de tickets), runbooks (scripts et procédures documentées) et plateformes RPA. Pour chaque source, capturez l’identifiant de jonction (repo, nom du service, environnement, équipe) et la « preuve » que vous stockerez (exécution de job, rapport de suite de tests, règle d’automatisation, exécution de script).

Identifiez les systèmes d’enregistrement

Ensuite, listez vos systèmes d’enregistrement qui définissent ce qui « devrait exister » : hébergement de repos, tracker d’incidents et CMDB/catalogue de services. Ces sources fournissent souvent la liste faisant foi des services, des propriétaires et de la criticité—essentiel pour calculer la couverture plutôt que de simplement compter l’activité.

Choisissez des méthodes d’ingestion

Associez chaque source à la méthode d’ingestion la moins fragile :

- Requêtes API pour des outils avec de bonnes API mais un faible support de webhooks.

- Webhooks quand vous avez besoin d’updates quasi temps réel (par ex. événement de fin de pipeline).

- Imports programmés pour exports CSV ou entrepôts de données.

- Saisie manuelle pour combler les lacunes (avec étiquetage clair), particulièrement pour les runbooks ou l’automatisation legacy.

Documentez contraintes et confiance

Notez les limites de taux, méthodes d’authentification (PAT, OAuth, comptes de service), fenêtres de rétention et problèmes de qualité de données connus (services renommés, noms incohérents, propriétaires manquants).

Enfin, planifiez un score de fiabilité de la source par connecteur (et éventuellement par métrique) afin que les utilisateurs puissent voir si un chiffre est « haute confiance » ou « effort estimé ». Cela évite une fausse précision et aide à prioriser l’amélioration des connecteurs ultérieurement.

Concevoir un modèle de données pour la couverture, les preuves et la propriété

Un tableau de bord de couverture utile commence par un modèle de données qui sépare ce que vous avez l’intention d’automatiser de ce qui a réellement fonctionné récemment. Si vous mélangez ces notions, vos chiffres peuvent paraître bons alors que l’automatisation est obsolète.

Entités principales (peu, mais explicites)

Commencez par ces briques :

- Application/Service : l’aire produit reportée (souvent mappée à un repo ou une entrée du catalogue de services).

- Processus : le workflow métier ou engineering que vous voulez automatiser (ex. « Déployer en staging », « Rapprochement des factures »).

- Requirement : un objectif à couvrir (étape de processus, contrôle, cas de test ou élément de checklist).

- Automation Asset : l’élément qui revendique la couverture (workflow CI, script, bot, suite de tests).

- Run (preuve) : une exécution avec statut, logs/URL et environnement.

- Owner : personne/équipe responsable du requirement ou de l’asset.

Décidez de la granularité tôt

Choisissez un niveau de reporting primaire et tenez‑vous‑y :

- par service (bien pour les synthèses directionnelles)

- par processus ou étape de processus (meilleur pour la vérité opérationnelle)

- par suite de tests (fonctionne pour les organisations pilotées par la QA)

- par environnement (prod vs staging change souvent la donne)

Vous pouvez supporter plusieurs vues plus tard, mais la première version devrait avoir un niveau « source de vérité ».

Identifiants stables (évitez que des renommages cassent l’historique)

Utilisez des IDs qui survivent aux refactors :

- repo + chemin de fichier (pour workflows/scripts)

- ID de job/workflow CI (si stable)

- IDs personnalisés stockés dans un manifeste (idéal quand les outils varient)

Traitez les noms d’affichage comme éditables, pas comme identifiants.

Modéliser les relations : cibles, assertions et preuves

Un schéma pratique :

- Requirement est la cible.

- CoverageClaim lie un Requirement ↔ Automation Asset (l’assertion de couverture).

- Run lie un Automation Asset (la preuve).

Cela vous permet de répondre : « Qu’est‑ce qui devrait être couvert ? », « Qu’est‑ce qui prétend le couvrir ? » et « Qu’est‑ce qui a réellement tourné ? »

Horodatages de fraîcheur qui instaurent la confiance

Capturez :

last_seen_at (l’asset existe toujours)last_run_at, last_failure_atlast_reviewed_at (quelqu’un a confirmé que la claim reste valide)

Ces champs de fraîcheur permettent de mettre en évidence les éléments « couverts mais obsolètes » sans discussion interminable.

Définir les métriques de couverture et les règles de scoring

Si votre métrique de couverture est floue, chaque graphique devient source de débat. Choisissez une métrique principale pour les résumés exécutifs, puis ajoutez des découpages complémentaires pour les équipes.

Choisir la métrique à optimiser

La plupart des organisations retiennent une des options suivantes :

- % automatisé par nombre : le plus simple à expliquer (ex. « 120 sur 200 tâches »). Bien quand les tâches sont comparables.

- % automatisé pondéré par effort : mieux quand certains éléments sont bien plus lourds. Pondérez par heures estimées ou complexité.

- % automatisé par risque : dirige l’attention sur ce qui peut vous nuire (impact client, conformité, incidents).

Vous pouvez afficher les trois, mais indiquez explicitement laquelle est le chiffre « principal ».

Définir ce que signifie « automatisé »

Rédigez des règles explicites pour que les équipes scorent de façon cohérente :

- Automatisé : s’exécute bout‑en‑bout sans étapes manuelles et produit une sortie vérifiable.

- Partiellement automatisé : une automatisation existe, mais nécessite encore approbation manuelle, préparation de données manuelle ou corrections fréquentes.

- Manuel : pas d’automatisation, ou des scripts existent mais ne sont pas exécutables de façon fiable.

Rendez les règles mesurables. Si deux personnes ne peuvent pas scorer le même élément de la même façon, affinez la définition.

Ajouter des poids simples (gardez les échelles basiques)

Utilisez des échelles entières petites (1–5) pour des inputs comme risque, impact business, fréquence d’exécution et temps économisé. Exemple : weight = risk + impact + frequency.

Empêcher le « gaming » avec des exigences d’évidence

Ne comptez pas un élément comme « automatisé » sans preuve, par exemple :

- au moins N runs réussis dans les 30 derniers jours

- un job CI lié, un log d’exécution ou un ticket prouvant l’exécution

Cela transforme la couverture d’une déclaration auto‑reportée à un signal observable.

Documenter les hypothèses

Placez les règles de scoring et des exemples concrets sur une page partagée (lien depuis le tableau de bord). Une interprétation cohérente est ce qui rend les tendances dignes de confiance.

Choisir une architecture adaptée à un usage interne

Une appli interne de couverture d’automatisation doit être « ennuyeuse » dans le bon sens : facile à exploiter, simple à faire évoluer et claire sur l’origine des chiffres. Une architecture simple « API + base de données + tableau de bord » bat généralement un système distribué tant que la charge n’exige pas le contraire.

Commencez par une stack simple

Choisissez une stack que votre équipe connaît déjà. Baseline commune :

- Backend : une API web unique (ex. Node/Express, Python/FastAPI, Ruby on Rails)

- Base : Postgres pour les entités centrales

- Frontend : un tableau de bord léger (React/Vue) qui consomme l’API

Si vous voulez aller plus vite pour la première version interne, une approche de type « vibe‑coding » peut aider : par exemple, Koder.ai peut générer un dashboard React plus un backend Go + PostgreSQL à partir d’un spec structuré, puis laisser votre équipe itérer via chat tout en conservant l’export complet du code et des déploiements conventionnels.

Composants essentiels

Même dans un système « simple », séparez les responsabilités :

- Workers d’ingestion : récupèrent les données CI, tickets, repos ou outils de test et écrivent des enregistrements normalisés

- API : fournit les métriques de couverture, listes détaillées et vues par propriétaire

- UI : dashboards, filtres et pages de détail pour équipes et services

- Auth : SSO + contrôle d’accès par rôle

- Jobs background : recalculs programmés, déduplication, backfills

- Notifications : alertes, résumés hebdo et messages « action requise »

Ajustement base de données : relationnel + tendances

Utilisez des tables relationnelles pour les entités canoniques (équipes, services, automations, preuves, propriétaires). Pour les tendances (runs dans le temps, couverture semaine après semaine), conservez soit :

- Une table time‑series dédiée dans Postgres (partitionnée par date), ou

- Un store time‑series séparé seulement si le volume de requêtes l’exige

Prévoir la séparation multi‑équipe

Si plusieurs équipes partagent l’app, ajoutez tôt des champs org_id/team_id. Cela active les permissions et évite des migrations douloureuses si la direction veut « un seul tableau, mais segmenté ».

Exécutez dev/staging/prod et définissez comment les données évoluent :

- Utilisez des schémas proches de la production partout

- En staging, ingérez des scopes limités ou des jeux synthétiques

- Promouvez le code via CI ; évitez les modifications manuelles des mappings en prod (préférez des changements audités via l’UI)

Pour plus sur l’ergonomie UI, voir /blog/design-dashboard-ux.

Authentification, rôles et principes de sécurité

Créez rapidement un tableau de bord de couverture

Transformez vos questions sur la couverture d'automatisation en un tableau de bord interne fonctionnel à partir d'une spec de chat.

Un tableau de bord de couverture devient vite une source de vérité ; le contrôle d’accès et le traitement des données comptent autant que les graphiques. Commencez simple, mais concevez pour qu’on puisse durcir la sécurité sans réécritures majeures.

Connexion : SSO d’abord, proxy si besoin d’un lancement rapide

Si la société a déjà un SSO, intégrez‑le dès le jour 1 (OIDC souvent le plus simple ; SAML fréquent dans les grandes structures). Si vous avez besoin d’un lancement interne rapide, vous pouvez débuter derrière un proxy d’auth interne qui injecte des en‑têtes d’identité, puis basculer vers un SSO natif plus tard.

Quel que soit le choix, normalisez l’identité sur une clé utilisateur stable (l’email peut changer). Persistez un profil utilisateur minimal et récupérez l’appartenance aux groupes/équipes à la demande si possible.

Rôles et permissions qui reflètent le travail réel

Définissez un petit ensemble de rôles et gardez l’autorisation cohérente UI/API :

- Viewer : lire les dashboards et les preuves.

- Editor : proposer ou appliquer des changements de métadonnées (propriétés, tags) et soumettre des corrections.

- Admin : gérer les intégrations, règles de scoring et paramètres globaux.

- Service owner (périmètre) : mettre à jour les claims et workflows seulement pour les services dont il/elle est propriétaire.

Privilégiez des permissions basées sur le périmètre (équipe/service) plutôt que des « super users ». Cela réduit le risque et évite les goulots.

Traiter les preuves sensibles avec précaution

Les preuves de couverture incluent souvent des liens vers des logs CI, tickets d’incident ou docs internes. Restreignez l’accès à ces URLs et à tout log brut. Stockez seulement l’essentiel pour vérification (par ex. ID de build, horodatage et bref résumé) plutôt que de copier l’intégralité des logs en base.

Auditing et rétention

Toute modification manuelle d’un claim ou d’une métadonnée doit créer un enregistrement d’audit : qui a changé quoi, quand et pourquoi (raison libre). Enfin, définissez une politique de rétention pour l’historique des runs et des preuves—combien de temps conserver, et implémentez une purge sûre pour supprimer les anciens enregistrements sans casser les calculs courants de couverture.

Concevoir l’UX du tableau de bord pour clarté et exploration

Un tableau de bord de couverture réussit quand quelqu’un peut répondre trois questions en moins d’une minute : Où en sommes‑nous ? Qu’est‑ce qui change ? Que faut‑il réparer ensuite ? Concevez l’UX autour de ces décisions, pas autour des seules sources de données.

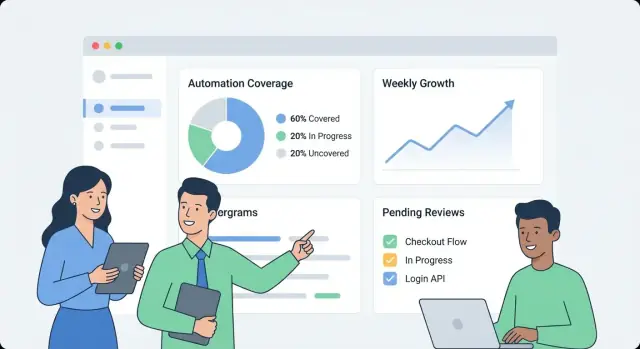

Commencez par un « panneau de statut » principal

Faites de l’écran d’accueil une synthèse simple :

- Couverture d’automatisation globale (un chiffre principal) avec une courte infobulle de définition (« % de processus ayant au moins une exécution vérifiée dans les X derniers jours »).

- Tendance (30/90 derniers jours) pour voir si la couverture s’améliore ou recule.

- Fraîcheur (à quand remontent les dernières preuves). Un signal obsolète doit être visuellement distinct d’un run en échec.

- Principaux écarts : une courte liste des zones les plus découvertes ou obsolètes, classées par impact (criticité × volume).

Utilisez des libellés en langage clair (« Automatisé récemment » vaut mieux que « Récence d’évidence ») et évitez d’obliger le lecteur à interpréter des statuts techniques.

Faire du drill‑down une narration

Depuis un indicateur global, permettez au user de cliquer vers une page service/processus qui répond à « quoi » et « par quoi » :

- Ce qui est automatisé (quelles étapes/capacités) et ce qui ne l’est pas.

- Par quel asset (script, workflow, job CI, bot RPA), incluant dernier run et dernier résultat.

- Une timeline compacte ou l’historique des runs pour montrer si les échecs sont isolés ou récurrents.

Concevez chaque ligne/carte pour inclure le « pourquoi » derrière le chiffre : lien de preuve, propriétaire, statut du dernier run, et une prochaine action claire (« Relancer le job », « Assigner un propriétaire », « Ajouter une preuve manquante »).

Filtres qui répondent à des questions réelles

Proposez des filtres mappant au fonctionnement de l’organisation :

- Équipe, environnement (prod/staging), criticité, plage de dates et système source.

Gardez l’état des filtres visible et partageable (paramètres d’URL), pour qu’on puisse envoyer un lien du type « Prod + Tier‑1 + 14 derniers jours » à un intervenant.

Aider les lecteurs non techniques sans encombrer

Utilisez des définitions inline plutôt qu’une documentation longue :

- Infobulles pour les métriques, et courts encadrés « Coverage exclut les vérifications manuelles ».

- Sémantique de couleurs cohérente (ex. vert = vérifié, ambre = obsolète, rouge = en échec), avec icônes/texte pour l’accessibilité.

- Un lien « En savoir plus » vers une page explicative interne comme /docs/coverage-metrics.

Implémenter les intégrations et la normalisation des données

Financez l'itération avec des crédits

Partagez vos notes internes de build ou parrainez des collègues et gagnez des crédits pour l'utilisation de Koder.ai.

Les intégrations rendent votre appli de couverture réelle. Le but n’est pas de reproduire toutes les fonctions de votre CI ou outils de test—mais d’extraire un ensemble cohérent de faits : qui a tourné, quand, ce que ça couvre et qui en est propriétaire.

Construire des connecteurs pour CI et outils de test

Commencez avec les systèmes qui produisent déjà des signaux : CI (GitHub Actions, GitLab CI, Jenkins), runners de test (JUnit, pytest) et outils qualité (rapports de couverture, linters, scans de sécurité).

Un connecteur doit récupérer (ou recevoir via webhook) la charge minimale :

- identifiants de pipeline/build et statuts

- noms de suites de tests, résultats individuels (optionnels) et compteurs pass/fail

- horodatage de run, durée et environnement (ex. staging/prod)

- repo, branche et commit SHA

Gardez les connecteurs idempotents : des pulls répétés ne doivent pas créer de doublons.

Ajouter un workflow manuel pour les exceptions

Certaines lacunes de couverture sont voulues (systèmes legacy, contraintes tierces, initiatives en pause). Fournissez un enregistrement « exception » léger qui exige :

- un propriétaire (personne ou équipe)

- une raison/catégorie (ex. bloqué, hors périmètre, déprécié)

- une date de revue (pour que l’exception expire à moins d’être réaffirmée)

Cela évite des zones aveugles permanentes et maintient la vue directionnelle honnête.

Normaliser les noms entre outils

Les sources diffèrent rarement sur les identifiants : un système dit « payments-service », un autre « payments », un troisième utilise un slug de repo.

Créez des règles de normalisation pour :

- noms de services

- noms de repo

- environnements (prod, production, live → prod)

Faites‑le tôt ; chaque métrique en aval en dépend.

Gérer doublons et renommages avec des alias

Introduisez des tables d’alias (ex. service_aliases, repo_aliases) qui mappent plusieurs noms externes à une entité canonique. Quand de nouvelles données arrivent, matchtez d’abord avec l’ID canonique, puis avec les alias.

Si un nouveau nom ne matche pas, générez des suggestions de fusion (ex. « payments‑api » ressemble à « payments‑service ») pour qu’un admin approuve.

Ajouter un job de fraîcheur des données

Planifiez un job récurrent qui vérifie le dernier horodatage de run par source et signale ce qui est obsolète (ex. pas de runs CI depuis 7 jours). Exposez cela dans l’UI pour que « faible couverture » ne soit pas confondue avec « données manquantes ».

Ajouter alertes, rapports et workflows de responsabilité

Un tableau de bord est utile, mais ce sont les alertes et workflows légers qui transforment les données intéressantes en amélioration continue. L’objectif : notifier les bonnes personnes au bon moment, avec le contexte suffisant pour agir.

Types d’alertes qui poussent à l’action

Commencez avec un petit ensemble d’alertes à fort signal :

- Chutes de couverture (ex. un service passe de 80 % à 65 % après une release)

- Preuves obsolètes (l’automatisation existe mais les preuves n’ont pas été mises à jour dans N jours)

- Automatisation en échec (tests/jobs qui échouent de façon répétée, rendant la couverture non fiable)

- Propriétaires manquants (service ou workflow critique sans responsable)

Chaque alerte doit pointer directement vers la vue de détail concernée (par ex. /services/payments?tab=coverage ou /teams/platform?tab=owners) pour éviter la chasse aux informations.

Seuils par équipe/service (éviter des règles globales bruyantes)

Évitez des seuils universels. Laissez les équipes définir des règles comme :

- couverture minimale pour leurs services

- fenêtre « stale » pour les preuves (7 jours pour systèmes dynamiques, 30 pour systèmes stables)

- nombre d’échecs ou durée avant paging vs « notification uniquement »

Cela garde les signaux pertinents et réduit la fatigue d’alerte.

Notifications + résumés hebdo

Envoyez les alertes vers les canaux existants (email et Slack), et incluez : ce qui a changé, pourquoi c’est important et le propriétaire. En complément d’alertes temps réel, ajoutez un résumé hebdomadaire couvrant :

- changements de couverture depuis la semaine précédente

- principales opportunités d’automatisation (plus grands écarts par impact)

- éléments bloqués (propriétaires manquants, pipelines cassés, preuves manquantes)

Accuser réception, assigner et boucler

Traitez les alertes comme des tâches : permettez accusé de réception, assignation et statut (ouvert/trié/résolu). Un court fil de commentaires (« corrigé dans la PR #1234 ») rend le reporting crédible et évite que les mêmes problèmes réapparaissent silencieusement.

Un tableau de bord de surveillance semble réactif lorsque l’API répond aux questions que l’UI pose—sans forcer le navigateur à enchaîner des dizaines d’appels. Commencez par une surface API minimale, orientée dashboard, et ajoutez des jobs de pré‑calcul pour tout ce qui est coûteux.

Démarrez avec une API minimale qui reflète l’UI

Concentrez la première version sur les écrans principaux :

- Services list :

GET /api/services (filtres comme équipe, langage, tier)

- Coverage summary :

GET /api/services/{id}/coverage (score global + découpages clés)

- Evidence runs :

GET /api/services/{id}/evidence?status=passed&since=...

- Update metadata (owner, tags, statut) :

PATCH /api/services/{id}

Concevez les réponses pour que le dashboard puisse s’afficher immédiatement : incluez nom du service, propriétaire, dernier horodatage de preuve et score courant dans un seul payload plutôt que d’imposer des recherches supplémentaires.

Les listes et tableaux détaillés doivent toujours être paginés (limit + cursor). Pour les endpoints fréquemment sollicités, ajoutez du caching côté API (ou un cache partagé) clé́ par les filtres et le périmètre d’accès de l’appelant.

Pour tout ce qui nécessite de scanner beaucoup de preuves (ex. « couverture par équipe »), pré‑calculez des rollups dans un job nocturne. Stockez ces rollups dans une table séparée (ou une vue matérialisée) pour que les lectures soient simples et prévisibles.

Ajouter des tendances via snapshots quotidiens

Les tendances sont plus simples si vous stockez des snapshots quotidiens :

- Un job programmé calcule la couverture par service chaque jour.

- L’API expose

GET /api/services/{id}/trend?days=90.

Les snapshots évitent de recalculer des métriques historiques à chaque chargement et facilitent le traçage de la « fraîcheur » pour les graphiques.

Import/export et gardes‑fous de cohérence

L’onboarding massif s’adoucit avec :

POST /api/import/services (upload CSV)GET /api/export/services.csv

Enfin, imposez des validations à l’écriture : owner requis, valeurs de statut permises et horodatages sensés (pas de preuves « futures »). Rejeter les mauvaises données tôt évite des corrections longues plus tard—surtout quand des rollups en dépendent.

Déploiement, observabilité et maintenance

Transformez les questions en écrans

Transformez votre FAQ et les principales questions utilisateurs en exigences, écrans et endpoints rapidement.

Un tableau de bord de couverture n’est utile que si on a confiance en lui. Traitez le déploiement et l’exploitation comme une partie du produit : releases prévisibles, signaux de santé clairs et récupérations simples quand ça casse.

Commencez par un déploiement adapté à l’interne

Pour une appli interne, optimisez pour une faible charge opérationnelle et des itérations rapides.

- Déployez en interne d’abord avec une image conteneur et une base managée (ex. Postgres), ou utilisez une plateforme PaaS qui supporte les jobs planifiés et les variables d’environnement.

- Gardez la configuration hors de l’image (env vars ou gestionnaire de secrets) pour promouvoir la même build entre environnements.

Si vous utilisez une plateforme comme Koder.ai pour accélérer, profitez de l’export de code source et des workflows de déploiement tôt, afin que votre app interne suive des pratiques standards de promotion, revue et rollback.

Ajoutez l’observabilité minimale qui répond à « ça marche ? »

Vous n’avez pas besoin d’une stack complexe pour obtenir des signaux fiables.

- Instrumentez des logs structurés pour les événements clés : début/fin d’ingestion, enregistrements traités, erreurs de normalisation.

- Suivez des métriques qui impactent la confiance utilisateur :

- Latence d’ingestion (fraîcheur des données)

- Échecs de job (connecteurs, parseurs, jobs de scoring)

- Latence API (p95 pour endpoints clés)

- Exposez des health checks (liveness/readiness) et créez une petite page admin montrant le statut des connecteurs, le dernier sync réussi et le dernier message d’erreur.

Sauvegardes et restauration : testez, ne présumez pas

Mettez en place des backups automatiques et une politique de rétention adaptée :

- Planifiez des backups et vérifiez que vous pouvez restaurer sur une nouvelle instance.

- Faites un petit exercice de restauration après des changements de schéma ou des mises à jour de connecteurs.

Runbooks opérationnels gardent l’app « ennuyeuse » (dans le bon sens)

Documentez des runbooks pour :

- Rotation des secrets et tokens d’API

- Relance d’imports en toute sécurité (jobs idempotents, backfills)

- Étapes d’incident : désactiver un connecteur, rollback, communiquer la fraîcheur des données sur le dashboard

Un peu de discipline opérationnelle empêche la « couverture » de devenir de la conjecture.

Plan de déploiement, gouvernance et amélioration continue

Un outil de monitoring n’aide que si les équipes lui font confiance et l’utilisent. Traitez le déploiement comme un lancement produit : démarrez petit, définissez une responsabilité claire et installez un rythme prévisible de mises à jour.

Onboarder une nouvelle équipe

Gardez l’onboarding léger et répétable :

- Cartographier ce qu’il faut suivre : lister services, repos et pipelines représentant le flux réel de livraison de l’équipe.

- Connecter les sources : CI, ticketing, runbooks, outils d’incident, plateformes de test—tout ce qui sert de preuve.

- Assigner des propriétaires : un propriétaire principal par service (et un backup). Les owners sont responsables de corriger les données obsolètes et de revoir les lacunes.

Un bon objectif : « première vue du dashboard en 30 minutes », pas une semaine de configuration.

Rythme de revue

Établissez deux cadences :

- Revue mensuelle de couverture : chaque équipe passe en revue les changements, explique les baisses/hausses majeures et confirme 1–3 améliorations prioritaires.

- Contrôle trimestriel des règles métriques : revoir les règles de scoring pour l’équité et la pertinence (ex. nouveau standard CI, outils dépréciés).

Gouvernance : qui peut changer les définitions

Les scores de couverture deviennent politiques si on change les règles sans prévenir. Définissez un petit groupe de gouvernance (souvent Eng Productivity + Security/Quality) qui peut :

- modifier les définitions globales (ce qui compte comme preuve)

- changer les règles et poids de scoring

- approuver de nouveaux connecteurs affectant plusieurs équipes

Publiez les changements dans un changelog simple comme /docs/scoring-changelog.

Mesurer l’adoption et s’améliorer continuellement

Suivez l’adoption avec quelques métriques simples : utilisateurs actifs, services suivis, et conformité de fraîcheur (combien de services ont des preuves à jour). Utilisez‑les pour prioriser l’itération : meilleures pondérations, types de preuves plus riches et connecteurs supplémentaires—toujours en priorisant les améliorations qui réduisent le travail manuel des équipes.

Si vous décidez de partager vos retours en externe, pensez à standardiser vos notes de build et templates : les équipes utilisant Koder.ai peuvent aussi gagner des crédits en documentant leur workflow de développement ou en parrainant d’autres utilisateurs, ce qui peut aider à financer l’itération continue des outils internes.