Commencez par le problème : quel travail manuel suivez‑vous ?

Avant de dessiner des écrans ou de choisir une base de données, clarifiez ce que vous voulez mesurer. L'objectif n'est pas de « suivre tout ce que font les employés ». C'est de capturer le travail manuel de manière suffisamment fiable pour décider quoi automatiser en premier — sur la base de preuves, pas d'opinions.

Définissez le travail manuel en termes simples

Écrivez les activités récurrentes actuellement faites à la main (copier/coller entre systèmes, ressaisie, vérification de documents, relances pour approbation, rapprochement de feuilles). Pour chaque activité, décrivez :

- Ce qui la déclenche (une nouvelle commande, un e‑mail, une échéance hebdomadaire)

- À quoi ressemble le « terminé » (soumis, vérifié, payé, expédié)

- Où elle a lieu (quels outils, dossiers, boîtes de réception)

Si vous ne pouvez pas la décrire en deux phrases, vous mélangez probablement plusieurs workflows.

Identifiez les utilisateurs cibles (et leurs motivations)

Une application de suivi fonctionne lorsqu'elle sert toutes les personnes impliquées — pas seulement celle qui veut le rapport.

- Opérateurs / personnel de première ligne : ont besoin d'un enregistrement rapide avec un minimum de perturbation.

- Chefs d'équipe : ont besoin de visibilité sur les goulots d'étranglement et les exceptions.

- Managers : veulent des signaux de priorisation pour l'automatisation et le staffing.

- Finance : a besoin de chiffres crédibles pour le coût, le ROI et le budget.

- IT / équipe d'automatisation : a besoin d'entrées propres pour construire des automatisations en sécurité.

Attendez‑vous à des motivations différentes : les opérateurs veulent moins d'administration ; les managers, de la prévisibilité ; l'IT, des exigences stables.

Décidez des résultats que vous mesurerez

Le suivi n'est utile que s'il se connecte à des résultats. Choisissez un petit ensemble que vous pouvez calculer de façon constante :

- Temps économisé : minutes manuelles de référence par tâche, puis comparaison après les changements.

- Erreurs réduites : nombre de reprises, corrections, contrôles échoués.

- Délai de traitement : du déclencheur à la clôture, incluant les temps d'attente.

- Conformité / auditabilité : preuve que les étapes requises ont eu lieu (qui, quoi, quand).

Clarifiez ce que l'application n'est pas

Définissez les limites tôt pour éviter de créer un monstre accidentel.

Cette application n'est généralement pas :

- Un remplaçant complet d'ERP

- Un système complet de ticketing

- Un outil de surveillance du personnel

Elle peut compléter ces systèmes — et parfois remplacer une tranche étroite — si c'est explicitement votre intention. Si vous utilisez déjà des tickets, votre application de suivi peut simplement attacher des données structurées de « travail manuel » aux éléments existants (voir /blog/integrations).

Choisissez les workflows et fixez un périmètre clair

Une application de suivi réussit ou échoue en fonction de son focus. Si vous essayez de capturer chaque « activité occupée », vous collecterez des données bruyantes, frustrerez les utilisateurs et vous ne saurez toujours pas quoi automatiser en premier. Commencez par un périmètre petit et explicite, mesurable de façon cohérente.

Choisissez les 3–5 premiers workflows

Optez pour des workflows fréquents, répétables et déjà douloureux. Un bon ensemble de départ couvre différents types d'effort manuel, par exemple :

- Copier/coller entre systèmes (ex. CRM → feuille → e‑mail)

- Saisie et reformatage de données (ex. factures, mises à jour client)

- Approbations (ex. remises, remboursements, demandes d'accès)

- Rapprochements (ex. paiements, inventaires)

- Reporting (ex. rapports hebdomadaires assemblés manuellement)

Définissez ce qui compte comme « travail manuel »

Écrivez une définition simple que tout le monde peut appliquer de la même façon. Par exemple : « Toute étape où une personne déplace, vérifie ou transforme une information sans qu'un système le fasse automatiquement. » Incluez des exemples et quelques exclusions (p. ex. appels clients, écriture créative, gestion des relations) pour éviter que l'on enregistre tout.

Fixez des limites pour éviter l'étalement du périmètre

Soyez explicite sur où le workflow commence et finit :

- Départements/équipes inclus (et exclus)

- Régions et canaux (téléphone, e‑mail, présentiel)

- Systèmes impliqués (et ceux que vous n'intégrerez pas encore)

Convenir d'une fenêtre de mesure

Décidez comment le temps sera enregistré : par tâche, par poste, ou par semaine. « Par tâche » donne le meilleur signal pour l'automatisation, mais « par poste/semaine » peut être un MVP pratique si les tâches sont trop fragmentées. L'essentiel est la cohérence, pas la précision.

Cartographiez le processus actuel avant de concevoir quoi que ce soit

Avant de choisir des champs, écrans ou tableaux de bord, obtenez une image claire de la façon dont le travail se déroule aujourd'hui. Une cartographie légère dévoilera ce que vous devez suivre et ce que vous pouvez ignorer.

Construisez une carte de flux simple

Commencez par un seul workflow et écrivez‑le en ligne droite :

Déclencheur → étapes → transferts → résultat

Restez concret. « La demande arrive dans une boîte partagée » vaut mieux que « une saisie a lieu ». Pour chaque étape, notez qui la réalise, quel outil est utilisé et ce que signifie « terminé ». Si des transferts existent (Ventes → Ops, Ops → Finance), signalez‑les — ce sont des endroits où le travail disparaît.

Repérez où surviennent les délais et les reprises

Votre application de suivi doit mettre en évidence les frictions, pas seulement l'activité. Pendant que vous cartographiez, marquez :

- Attente d'informations manquantes (détails client, pièces jointes, confirmation)

- Approbations (qui approuve, durée typique, motifs de rejet)

- Contraintes d'accès système (permissions, files d'attente, limites de débit)

- Boucles de reprise (tâche renvoyée à une étape précédente)

Ces points de retard deviennent plus tard des champs à forte valeur (ex. « raison de blocage ») et des candidats prioritaires à l'automatisation.

Identifiez les sources de vérité

Listez les systèmes sur lesquels les gens s'appuient pour compléter le travail : fils d'e‑mail, feuilles, outils de ticketing, drives partagés, applications legacy, messages de chat. Quand plusieurs sources divergent, notez laquelle « prime ». C'est essentiel pour les intégrations futures et pour éviter la saisie en double.

Documentez la variabilité et les exceptions

La plupart du travail manuel est désordonné. Notez les raisons courantes des écarts : conditions client spéciales, documents manquants, règles régionales, validations ponctuelles. Vous ne cherchez pas à modéliser chaque cas limite — contentez‑vous d'enregistrer les catégories qui expliquent pourquoi une tâche a pris plus de temps ou a nécessité des étapes supplémentaires.

Concevez les données à capturer (sans trop en faire)

Un tracker de travail manuel réussit s'il permet aux gens d'enregistrer rapidement le travail tout en générant des données exploitables. L'objectif n'est pas de tout collecter, mais de capturer juste assez de structure pour repérer des motifs, quantifier l'impact et transformer la douleur répétée en candidats à l'automatisation.

Commencez par un petit ensemble réutilisable d'entités

Gardez votre modèle de données central simple et cohérent entre équipes :

- Work Item : la chose traitée (commande, demande, ticket, réclamation). Incluez un ID de référence externe si disponible.

- Process et Step : où se situe le travail (ex. « Remboursements » → « Valider le reçu »). Les étapes vous aident à détecter les goulots sans analyses complexes.

- Task : une unité d'effort manuel réalisée à un instant donné (souvent liée à un Work Item + Step).

- Assignee : qui l'a fait (et optionnellement équipe/rôle).

- System : quels outils ont été impliqués (CRM, feuille, e‑mail, portail).

- Evidence (optionnel) : pièces jointes ou liens vers captures/fichiers pour les audits.

Cette structure supporte l'enregistrement quotidien et l'analyse ultérieure sans forcer l'utilisateur à remplir un long questionnaire.

Mesurez le temps de façon conviviale et peu intrusive

Le temps est essentiel pour prioriser l'automatisation, mais il doit être simple à capturer :

- Minuteur démarrer/arrêter pour le travail concentré.

- Saisie manuelle quand les tâches sont en courtes rafales.

- Éditions groupées pour des actions répétées (« je l'ai fait 12 fois aujourd'hui »).

Si le temps ressemble à du contrôle, l'adoption chute. Positionnez‑le comme un moyen de supprimer le travail inutile, pas de surveiller les individus.

Capturez le « pourquoi manuel » avec des catégories légères

Ajoutez un champ requis qui explique pourquoi le travail n'a pas été automatisé :

- Intégration manquante

- Exigence de conformité/politique

- Règles peu claires/cas limites

- Limitations de l'outil ou mauvaise UX

Utilisez un court menu déroulant plus une note optionnelle. Le menu facilite les rapports ; la note donne du contexte pour les exceptions.

Stockez des résultats structurés (pour que les logs deviennent exploitables)

Chaque Task doit se terminer avec quelques résultats cohérents :

- Statut (terminé, bloqué, escaladé)

- Type d'erreur (si pertinent)

- Nombre de reprises (0, 1, 2+)

- Notes de clôture (courtes, optionnelles)

Avec ces champs, vous pouvez quantifier le gaspillage (reprises), identifier les modes de défaillance (types d'erreur) et construire un backlog d'automatisation crédible basé sur le travail réel, pas sur des opinions.

Si enregistrer une tâche prend plus de temps que de la faire, les gens l'ignoreront — ou saisiront des données vagues inutilisables. L'objectif UX est simple : capturer le minimum utile avec le moins de friction.

Écrans indispensables (gardez‑les simples)

Commencez par un petit ensemble d'écrans couvrant la boucle complète :

- Saisie de tâche : moyen rapide d'ajouter du travail (saisie manuelle ou « créer depuis un modèle »).

- File de travail : liste priorisée avec filtres (nouveau, en cours, bloqué, fait).

- Détail du Work Item : contexte, statut, notes et un « prochain acte » clair.

- Capture temps/preuves : minuteur, saisie rapide de durée, joindre des fichiers ou coller des liens.

- Rapports : vue légère du volume, du temps passé et des principales raisons/résultats.

Rendez‑le rapide : moins de clics, plus de flux

Concevez pour la vitesse plutôt que l'exhaustivité. Utilisez raccourcis clavier pour les actions courantes (créer un item, changer le statut, enregistrer). Proposez des modèles pour le travail répétitif afin que les utilisateurs ne retapent pas les mêmes descriptions.

Favorisez l'édition en place et des valeurs par défaut sensées (ex. auto‑assignation à l'utilisateur courant, définir « débuté à » à l'ouverture de l'item).

Champs guidés qui standardisent les données

Le texte libre est utile, mais il n'agrège pas bien. Ajoutez des champs guidés qui rendent les rapports fiables :

- Menus pour raison, résultat, type d'erreur, et canal (e‑mail/chat/téléphone).

- Champs requis uniquement quand ils évitent l'ambiguïté — pas « parce qu'on peut ».

Principes d'accessibilité à ne pas négliger

Rendez l'app lisible et utilisable par tous : fort contraste, étiquettes claires (pas seulement des placeholders), états de focus visibles pour la navigation clavier, et mises en page mobiles pour un enregistrement rapide en mobilité.

Permissions, approbations et traçabilité

Gardez la maîtrise de votre code

Gardez le contrôle total en exportant le code source quand vous êtes prêt.

Si votre app doit guider des décisions d'automatisation, les gens doivent faire confiance aux données. Cette confiance se brise quand n'importe qui peut tout éditer, que les validations sont floues ou qu'il n'y a pas d'historique des changements. Un modèle de permissions simple plus un journal d'audit léger résolvent la plupart des cas.

Définissez des rôles clairs (et gardez‑les simples)

Commencez par quatre rôles qui reflètent la façon dont le travail est enregistré :

- Contributeur : enregistre le travail (temps, étapes, preuves) et édite ses brouillons.

- Relecteur/Validateur : valide les entrées, demande des clarifications, approuve ou rejette.

- Manager : voit l'activité d'équipe, résout les différends et peut outrepasser les validations.

- Admin : configure workflows, permissions, rétention et intégrations.

Évitez les règles personnalisées par utilisateur au départ ; l'accès par rôle est plus simple à expliquer et à maintenir.

Règles d'édition après soumission

Décidez quels champs sont des « faits » vs des « notes », et verrouillez les faits une fois revus.

Approche pratique :

- Les contributeurs peuvent éditer librement les brouillons.

- Après soumission, les contributeurs ne peuvent modifier que les champs non critiques (ex. description) tant que la revue n'a pas commencé.

- Après approbation, les modifications des entrées de temps, statut, coût ou preuves doivent être limitées aux relecteurs/managers et idéalement nécessiter une raison.

Cela stabilise les rapports tout en autorisant les corrections légitimes.

Journal d'audit qui répond à « qui a changé quoi ? »

Ajoutez un log d'audit pour les événements clés : changements de statut, ajustements de temps, approbations/rejets, preuves ajoutées/supprimées, et modifications de permissions. Stockez au minimum : acteur, horodatage, ancienne valeur, nouvelle valeur, et (optionnel) un court commentaire.

Rendez‑le visible sur chaque enregistrement (ex. onglet « Activité ») pour que les litiges n'aient pas à redevenir de l'archéologie Slack.

Rétention et gestion des preuves

Fixez des règles de rétention tôt : combien de temps conserver les logs et les preuves associées (images, fichiers, liens). Beaucoup d'équipes font 12–24 mois pour les logs, et moins pour les pièces volumineuses.

Si vous autorisez les uploads, traitez‑les comme partie intégrante de l'historique : versionnez les fichiers, consignez les suppressions et restreignez l'accès par rôle. Cela compte quand une entrée devient la base d'un projet d'automatisation.

Architecture technique pour un MVP pratique

Un MVP pratique doit être facile à construire, à modifier et banal à exploiter. L'objectif n'est pas de prédire votre plateforme d'automatisation future, mais de capturer des preuves de travail manuel avec un minimum de friction.

Une base simple et scalable

Commencez par une architecture claire :

- Client web (interface navigateur)

- API (logique métier + validations)

- Base de données (enregistrements structurés)

- Stockage de fichiers (captures d'écran, PDFs, e‑mails exportés)

Cette séparation garde l'UI rapide à itérer tandis que l'API reste la source de vérité.

Choisissez des composants éprouvés

Optez pour une stack que votre équipe peut livrer rapidement avec une forte communauté :

- Frontend : React ou Vue

- Backend : Node (Express/Nest), Django ou Rails

- Base de données : Postgres

- Stockage de fichiers : stockage compatible S3 (ou équivalent managé)

Évitez les technos exotiques au départ — votre plus grand risque est l'incertitude produit, pas la performance.

Si vous voulez accélérer le MVP sans vous enfermer, une plateforme de développement assisté comme Koder.ai peut vous aider à passer d'un cahier des charges à une application React avec une API Go et PostgreSQL — via chat — tout en conservant la possibilité d'exporter le code source, déployer/hos ter et revenir en arrière en toute sécurité avec des snapshots. C'est particulièrement utile pour des outils internes où les exigences évoluent vite après le premier pilote.

Concevez l'API autour des actions utilisateur

Définissez des endpoints qui reflètent ce que font les utilisateurs, pas la structure des tables en base. Capacités typiques formulées en verbes :

- Créer un work item (tâche/case)

- Enregistrer du temps (démarrer/arrêter ou durée + notes)

- Joindre une preuve (upload de fichier + courte description)

- Changer le statut (ex. New → In Progress → Done)

Cela facilite le support de futurs clients (mobile, intégrations) sans réécrire le cœur.

POST /work-items

POST /work-items/{id}/time-logs

POST /work-items/{id}/attachments

POST /work-items/{id}/status

GET /work-items?assignee=me&status=in_progress

Prévoyez l'import/export CSV dès le départ

Même les premiers utilisateurs demanderont : « Puis‑je uploader ce que j'ai déjà ? » et « Puis‑je récupérer mes données ? » Ajoutez :

- Import CSV pour la migration initiale ou la création en masse

- Export CSV pour le reporting, les audits et la confiance

Cela réduit la ressaisie, accélère l'onboarding et empêche votre MVP de ressembler à une impasse.

Intégrations qui réduisent l'effort de saisie

Déployez auprès d'une équipe pilote

Déployez et hébergez votre outil interne quand la première équipe est prête à piloter.

Si votre app dépend que les gens pensent à tout enregistrer, l'adoption s'effritera. Une approche pratique : commencer par la saisie manuelle (clarifie le flux), puis ajouter des connecteurs uniquement là où ils réduisent vraiment l'effort — surtout pour le travail à fort volume et répétitif.

Là où les intégrations aident le plus

Cherchez les étapes où les gens laissent déjà une trace ailleurs. Intégrations « faible friction » courantes :

- Ingestion d'e‑mails : faire suivre des messages vers une adresse spéciale pour créer/mettre à jour un work item.

- Feuilles de calcul : importer des lignes (ou synchroniser) depuis les sheets que les équipes maintiennent.

- Notifications Slack/Teams : rappels rapides (« notez le résultat ») et mises à jour de statut quand un item est approuvé ou réaffecté.

- Webhooks : recevoir des événements d'autres outils (soumissions de formulaire, mises à jour de ticket, échecs de paiement) pour créer automatiquement un brouillon.

Utilisez des identifiants uniques pour relier les éléments

Les intégrations se compliquent rapidement si vous ne pouvez pas faire correspondre de façon fiable les éléments entre systèmes. Créez un identifiant unique (ex. MW-10482) et stockez les IDs externes en parallèle (ID de message e‑mail, clé de ligne de feuille, ID de ticket). Affichez cet identifiant dans les notifications et les exports pour que tout le monde référence le même item.

Conceptez pour l'automatisation partielle (pas tout ou rien)

L'objectif n'est pas d'éliminer immédiatement l'humain, mais de réduire la frappe et d'éviter la reprise. Pré‑remplissez les champs depuis les intégrations (demandeur, sujet, horodatages, pièces jointes), mais gardez la possibilité d'override humain pour que le log reflète la réalité. Par exemple, un e‑mail peut suggérer une catégorie et une estimation d'effort, la personne confirme le temps réel et le résultat.

Bonne règle : les intégrations créent des brouillons par défaut, et les humains « confirment et soumettent » jusqu'à ce que le mapping soit fiable.

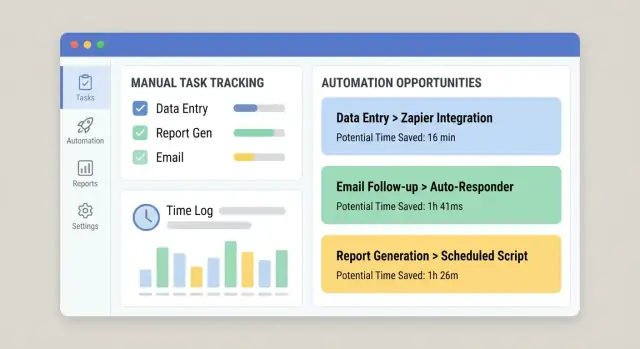

Le suivi n'a de valeur que s'il conduit à des décisions. L'objectif de votre app doit être de convertir les logs bruts en une liste priorisée d'opportunités d'automatisation — votre « backlog d'automatisation » — facile à revoir en réunion ops/amelioration hebdomadaire.

Créez des critères de scoring que l'on comprend

Commencez par un score simple et explicable pour que les parties prenantes voient pourquoi un élément monte en priorité. Critères pratiques :

- Volume : fréquence (par jour/semaine/mois)

- Temps par tâche : minutes médianes par réalisation (préférez la médiane au max)

- Taux d'erreur : reprises, corrections, escalades

- Impact business : coût, impact client, risque conformité, SLA

- Faisabilité : clarté des règles, accès aux systèmes, stabilité des entrées, nombre d'exceptions

Affichez le score à côté des chiffres sous‑jacents pour qu'il ne ressemble pas à une boîte noire.

Générez un « backlog d'automatisation » depuis l'activité réelle

Ajoutez une vue dédiée qui regroupe les logs en « work items » répétables (par ex. « Mettre à jour l'adresse client dans le Système A puis confirmer dans le Système B »). Classez automatiquement par score et montrez :

- Temps total passé (30/90 derniers jours)

- Tendance de fréquence

- Principales équipes/rôles impliqués

- Points d'échec fréquents (où les utilisateurs marquent « bloqué » ou « reprise »)

Étiquetez les motifs répétitifs pour trouver ce qui est automatisable

Rendez le tagging léger : tags en un clic tels que system, type d'entrée, type d'exception. Avec le temps, ils révèleront les motifs stables (bons candidats à l'automatisation) vs les cas limites (mieux traités par formation ou amélioration de processus).

Ajoutez une estimation ROI basique

Une estimation simple suffit :

ROI (temps) = (temps économisé × fréquence) − hypothèse de maintenance

Pour la maintenance, utilisez une estimation horaire fixe par mois (ex. 2–6 h/mois) pour comparer les opportunités de façon cohérente. Cela garde le backlog axé sur l'impact, pas sur les opinions.

Rapports et tableaux de bord que les gens utiliseront vraiment

Les tableaux de bord ne servent que si ils répondent vite aux vraies questions : « Où passons‑nous du temps ? » « Qu'est‑ce qui nous ralentit ? » et « Notre dernier changement a‑t‑il aidé ? » Concevez le reporting autour des décisions, pas des graphiques de vanité.

Commencez par des vues pour les leaders

La plupart des responsables ne veulent pas tous les détails — ils veulent des signaux clairs. Baseline pratique :

- Heures passées sur le travail manuel, par équipe, workflow et catégorie

- Top processus manuels (classés par temps total, fréquence ou les deux)

- Cycle time (du début à la fin) et où le temps est en attente

- Reprise (items rouverts, renvoyés, ou modifiés après soumission)

Rendez chaque vignette cliquable pour qu'un leader passe du chiffre au détail responsable.

Montrez les tendances et les comparaisons avant/après

Une semaine est souvent trompeuse. Ajoutez des séries temporelles et des filtres simples (7/30/90 derniers jours). Quand vous changez un workflow — intégration ajoutée ou formulaire simplifié — facilitez la comparaison avant vs après.

Approche légère : stockez un « marqueur de changement » (date et description) et affichez une ligne verticale sur les graphiques. Cela aide à relier les améliorations à des interventions concrètes.

Évitez les métriques trompeuses

Le suivi du travail manuel mélange souvent données dures (horodatages, comptes) et entrées plus souples (temps estimé). Étiquetez clairement :

- Mesuré : capturé automatiquement (début/fin, nombre d'items)

- Déclaré : saisi par les utilisateurs (temps passé, codes raison)

- Dérivé : calculé (cycle time, taux de reprise)

Si le temps est estimé, indiquez‑le dans l'UI. Mieux vaut être transparent que paraître précis à tort.

Permettez le drill‑down vers les work items

Chaque graphique doit permettre « montre‑moi les enregistrements ». Le drill‑down renforce la confiance et accélère l'action : filtrez par workflow, équipe et plage de dates, puis ouvrez les work items sous‑jacents pour voir notes, transferts et blocages.

Liez les tableaux de bord à la vue « backlog d'automatisation » pour que les gros postes de temps deviennent des candidats pendant que le contexte est encore frais.

Sécurité et fiabilité de base

Prototyper rapidement le tracker

Créez une application web React avec une API Go et PostgreSQL sans repartir de zéro.

Si votre app capture comment le travail est fait, elle collectera vite des détails sensibles : noms de clients, notes internes, pièces jointes, et « qui a fait quoi quand ». La sécurité et la fiabilité ne sont pas des options — vous perdrez la confiance (et l'adoption) sans elles.

Protégez les données avec le principe du moindre privilège

Commencez avec un accès basé sur les rôles correspondant aux responsabilités réelles. La plupart des utilisateurs ne devraient voir que leurs propres logs ou ceux de leur équipe. Limitez les pouvoirs d'admin à un petit groupe, et séparez « peut éditer des entrées » de « peut approuver/exporter des données ».

Pour les uploads, supposez que chaque pièce jointe est non fiable :

- Analysez les uploads (ou routez‑les via un fournisseur qui le fait).

- Stockez les fichiers dans un stockage d'objets privé, pas sur le filesystem du serveur web.

- Utilisez des URLs signées à courte durée pour le téléchargement.

Défenses de base pour l'application

Vous n'avez pas besoin d'une sécurité d'entreprise pour lancer un MVP, mais vous avez besoin des essentiels :

- Authentification (SSO si possible, sinon mot de passe fort + MFA)

- Limitation de débit sur les points d'accès login et endpoints intensifs en écriture

- Validation côté serveur de chaque champ, surtout texte libre et IDs

- Sauvegardes régulières avec procédure de restauration testée (une sauvegarde non restaurable n'en est pas une)

Journalisation utile (sans fuites)

Enregistrez les événements système pour le dépannage et l'audit : connexions, changements de permissions, approbations, jobs d'import, intégrations échouées. Gardez les logs structurés et consultables, mais n'y stockez pas de secrets — ne logguez jamais de tokens API, mots de passe ou contenus complets de pièces jointes. Redactez les champs sensibles par défaut.

Si vous manipulez des données personnelles, décidez tôt :

- Règles de rétention (durée de conservation des logs et fichiers)

- Flux d'export/suppression pour les demandes d'accès

- Où les données sont stockées et qui y a accès

Ces choix impactent le schéma, les permissions et les sauvegardes — plus simple à planifier maintenant que le retrofit plus tard.

Plan de déploiement, adoption et amélioration continue

Une application de suivi réussit ou échoue sur l'adoption. Traitez le déploiement comme un lancement produit : commencez petit, mesurez le comportement et itérez rapidement.

Commencez par un pilote ciblé

Pilotez avec une équipe — idéalement un groupe qui ressent la douleur du travail manuel et a un workflow clair. Gardez le périmètre étroit (1–2 types de travail) pour pouvoir accompagner les utilisateurs et ajuster l'application sans perturber l'organisation.

Pendant le pilote, recueillez du feedback sur le moment : un bouton « Quelque chose était difficile » après la saisie, plus un point hebdo de 15 minutes. Quand l'adoption se stabilise, étendez à l'équipe suivante aux patterns similaires.

Définissez tôt des métriques de succès

Fixez des objectifs simples et visibles pour que tout le monde sache ce qu'est le « bon » :

- % du travail enregistré (couverture)

- Qualité des données (champs requis remplis, moins de « Autre »)

- Heures manuelles réduites (auto‑rapportées ou inférées)

Suivez‑les dans un dashboard interne et révisez‑les avec les chefs d'équipe.

Facilitez l'apprentissage en situation

Ajoutez des aides in‑app où les gens bloquent :

- Exemples sous chaque champ (« Bonne description : ‘Rapprocher la facture #1842’ »)

- Infobulles pour catégories et tags

- Petit onboarding les premières fois qu'on saisit (2–3 étapes max)

Maintenez une amélioration continue (et visible)

Mettez en place un rythme de revue (mensuel fonctionne bien) pour décider ce qui s'automatise ensuite et pourquoi. Utilisez les logs pour prioriser : fréquence élevée + temps élevé d'abord, avec des propriétaires et impact attendu.

Fermez la boucle en montrant les résultats : « Grâce à vos logs X, nous avons automatisé Y. » C'est le moyen le plus rapide de maintenir l'enregistrement.

Si vous itérez vite entre équipes, considérez des outils qui facilitent les changements rapides sans déstabiliser l'app. Par exemple, le mode de planification de Koder.ai aide à définir portée et flux avant de générer des changements, et les snapshots/rollback rendent plus sûr l'ajustement des workflows, champs et permissions au fil du pilote.