Pourquoi le code généré par l'IA et les tests auto-générés vont ensemble

Le code applicatif écrit par l'IA signifie que les parties « qui fonctionnent » de votre base de code sont rédigées avec l'aide d'un assistant : nouvelles fonctions, petites fonctionnalités, refactorings, gestion de cas limites, voire réécritures de modules existants. Vous décidez toujours quoi construire, mais la première version de l'implémentation arrive souvent plus vite — et parfois avec des hypothèses que vous ne remarquerez que plus tard.

La génération automatique de tests est la capacité correspondante côté vérification. Plutôt que d'écrire chaque test à la main, des outils peuvent proposer des cas de test et des assertions à partir de votre code, d'une spécification ou de motifs tirés de bugs précédents. En pratique, cela peut ressembler à :

- « Étant donné cette signature de fonction et ces branches, voici des tests qui couvrent les entrées typiques, les bornes et les chemins d'erreur. »

- « Voici des tests de régression qui reproduisent le crash que nous avons vu en production. »

L'attente clé : les tests générés ne sont pas automatiquement “bons”

Un test généré peut être trompeur : il peut affirmer le comportement actuel même si le comportement est faux, ou il peut manquer des règles produit qui vivent dans la tête des gens ou dans les commentaires de ticket. C'est pourquoi la revue humaine compte. Quelqu'un doit confirmer que le nom du test, la configuration et les assertions reflètent l'intention réelle — pas seulement ce que le code fait aujourd'hui.

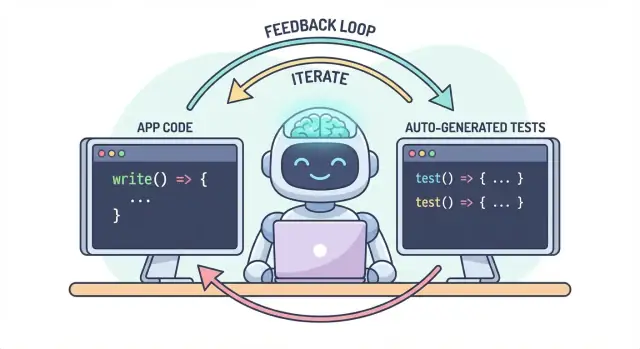

Un workflow, deux livrables

L'idée centrale est simple : le code et les tests doivent évoluer ensemble dans un seul flux. Si l'IA vous aide à changer la logique rapidement, la génération automatique de tests vous aide à verrouiller le comportement voulu tout aussi vite — pour que le changement suivant (humain ou IA) ait une définition exécutable claire de « toujours correct ».

En pratique, cette approche de « livrable pairé » est plus facile à maintenir quand votre flux de dev est déjà axé chat. Par exemple, sur Koder.ai (une plateforme vibe-coding pour construire des applications web, backend et mobiles via chat), il est naturel de considérer « fonctionnalité + tests » comme un seul livrable : vous décrivez le comportement, générez l'implémentation, puis générez et relisez les tests dans la même boucle conversationnelle avant le déploiement.

Le problème : coder plus vite peut signifier générer des bugs plus vite

Le code écrit par l'IA peut ressembler à un superpouvoir : les fonctionnalités apparaissent rapidement, le boilerplate disparaît et des refactorings qui prenaient des heures peuvent être faits avant que votre café refroidisse. Le hic, c'est que la vitesse change la forme du risque. Quand le code est plus facile à produire, il est aussi plus facile d'envoyer des erreurs — parfois subtiles.

Modes d'échec courants du code généré par l'IA

Les assistants IA sont bons pour générer des implémentations « raisonnables », mais raisonnable n'est pas synonyme de correct pour votre domaine spécifique.

Les cas limites sont les premières victimes. La logique générée par l'IA gère souvent bien le chemin heureux, puis trébuche sur les conditions limites : entrées vides, subtilités de fuseau horaire, arrondis, valeurs nulles, comportement de retry, ou des états « cela ne devrait jamais arriver » qui arrivent pourtant en production.

Les mauvaises hypothèses sont un autre problème fréquent. Un assistant peut inférer des exigences non déclarées (« les utilisateurs sont toujours authentifiés », « les IDs sont numériques », « ce champ est toujours présent »), ou implémenter un pattern familier qui ne correspond pas aux règles de votre système.

Les régressions silencieuses sont souvent les plus coûteuses. Vous demandez un petit changement, l'assistant réécrit un bout de logique, et quelque chose d'autre casse — sans erreur évidente. Le code compile toujours, l'UI se charge, mais une règle de tarification, une vérification d'autorisation ou une conversion de données est désormais légèrement erronée.

Pourquoi les tests manuels ne suivent pas le rythme

Quand les changements de code s'accélèrent, les tests manuels deviennent un goulot d'étranglement et un pari. Soit vous passez plus de temps à cliquer (ralentissant la livraison), soit vous testez moins (augmentant les fuites). Même des équipes QA disciplinées ne peuvent pas couvrir manuellement toutes les variantes quand les changements sont fréquents et étendus.

Pire : les vérifications manuelles sont difficiles à répéter de façon cohérente. Elles vivent dans la mémoire de quelqu'un ou dans une checklist, et sont faciles à sauter quand les délais se resserrent — précisément quand le risque est le plus élevé.

Les tests comme filet de sécurité et outil de communication

Les tests automatisés créent un filet de sécurité durable : ils rendent les attentes exécutables. Un bon test dit : « Étant donné ces entrées et ce contexte, voici le résultat sur lequel nous comptons. » Ce n'est pas seulement de la vérification ; c'est de la communication pour le vous futur, vos coéquipiers et même l'assistant IA.

Quand des tests existent, les changements deviennent moins effrayants parce que le retour est immédiat. Plutôt que de découvrir des problèmes après la revue de code, en staging ou via les clients, vous les trouvez quelques minutes après le changement.

Attraper les problèmes tôt pour réduire les retouches

Plus tôt un bug est détecté, moins il coûte à corriger. Les tests raccourcissent la boucle de feedback : ils mettent en lumière les hypothèses discordantes et les cas limites manqués pendant que l'intention est encore fraîche. Cela réduit les retouches, évite les patches « fix-forward » et empêche la vitesse de l'IA de se transformer en churn piloté par l'IA.

Le code écrit par l'IA est le plus efficace quand vous le traitez comme une conversation, pas comme un livrable ponctuel. Les tests sont ce qui rend cette conversation mesurable.

La boucle « spec → code → tests » (en clair)

-

Spec : Vous décrivez ce qui doit arriver (entrées, sorties, cas limites).

-

Code : L'IA écrit l'implémentation qui prétend correspondre à cette description.

-

Tests : Vous (ou l'IA) générez des vérifications qui prouvent que le comportement est réellement vrai.

Répétez cette boucle et vous ne produisez pas seulement plus de code — vous resserrez continuellement la définition de « terminé ».

Les tests forcent des exigences et interfaces plus claires

Une exigence vague comme « gérer proprement les utilisateurs invalides » est facile à laisser filer dans le code. Un test ne peut pas être vague. Il force des spécifications :

- Qu'est-ce qui compte comme « invalide » ? ID manquant, statut banni, email malformé ?

- Que signifie « gérer proprement » ? Message d'erreur, code de statut, valeur de repli ?

- Quelle est l'interface ? Signature de fonction, forme de retour, exceptions ?

Dès que vous essayez d'exprimer ces détails dans un test, les zones d'ombre apparaissent immédiatement. Cette clarté améliore le prompt que vous donnez à l'IA et conduit souvent à des interfaces plus simples et plus stables.

Les tests générés valident les prétentions du code

Le code IA peut sembler correct tout en cachant des hypothèses. Les tests générés sont un moyen pratique de vérifier les affirmations que le code fait :

- « Cette fonction est pure » → testez l'absence d'effets externes.

- « Gère les cas limites » → testez nulls, listes vides, valeurs frontières.

- « Compatible en arrière » → testez les anciennes entrées et sorties attendues.

Le but n'est pas de faire une confiance aveugle aux tests générés, mais de les utiliser comme un scepticisme structuré et rapide.

Les tests qui échouent deviennent le prochain prompt

Un test qui échoue est un retour d'information actionnable : il pointe un désaccord précis entre la spec et l'implémentation. Plutôt que de demander à l'IA « corrige-le », vous pouvez coller l'échec et dire : « Mets à jour le code pour que ce test passe sans changer l'API publique. » Cela transforme le débogage en itération ciblée plutôt qu'en jeu de devinettes.

Où placer la génération automatique de tests dans votre pyramide de tests

La génération automatique de tests est la plus utile quand elle soutient votre stratégie de test existante — en particulier la pyramide classique. La pyramide n'est pas une règle pour elle-même ; c'est un moyen de garder les retours rapides et fiables tout en détectant les échecs réels.

L'IA peut vous aider à créer des tests à chaque couche, mais vous obtiendrez les meilleurs résultats en générant plus de tests peu coûteux (bas de la pyramide) et moins de tests coûteux (haut). Cet équilibre garde votre pipeline CI rapide tout en protégeant l'expérience utilisateur.

Tests unitaires : rapides, ciblés et très générables

Les tests unitaires sont de petites vérifications pour des fonctions, méthodes ou modules individuels. Ils s'exécutent vite, n'ont pas besoin de systèmes externes et sont idéaux pour couvrir automatiquement des cas limites.

Un bon usage consiste à :

- Exercicer la validation d'entrée et les valeurs frontières

- Valider les règles métier (remises, permissions, transitions d'état)

- Verrouiller les corrections de bugs avec des tests de régression difficiles à oublier

Parce qu'ils sont étroitement ciblés, ils sont plus faciles à relire et moins susceptibles de devenir flaky.

Tests d'intégration : moins nombreux, mais à fort impact

Les tests d'intégration valident comment les pièces fonctionnent ensemble : votre API avec la base de données, un service appelant un autre service, le traitement d'une file, l'authentification, etc.

Les tests d'intégration générés par l'IA peuvent être précieux, mais nécessitent plus de discipline :

- Setup/teardown clair pour éviter la fuite de données

- Environnements de test stables (containers, BD de test, mocks appropriés)

- Assertions focalisées sur les résultats, pas sur les détails internes

Considérez-les comme des vérifications de contrat qui prouvent que les jonctions entre composants tiennent toujours.

Tests end-to-end : générer avec parcimonie

Les tests E2E valident les parcours utilisateurs clés. Ce sont aussi les plus coûteux : lents à exécuter, plus fragiles et plus difficiles à déboguer.

La génération automatique peut aider à esquisser des scénarios E2E, mais vous devez les curer strictement. Maintenez un petit ensemble de chemins critiques (inscription, paiement, flux cœur) et évitez de générer des E2E pour chaque fonctionnalité.

Recommandation pratique : générer un mix équilibré

Ne cherchez pas à tout générer. Au lieu de cela :

- Générez beaucoup de tests unitaires pour garder la logique IA honnête au niveau fonction

- Ajoutez des tests d'intégration ciblés pour protéger les jonctions les plus risquées (BD, auth, paiements)

- Maintenez une suite E2E minimale pour les parcours utilisateurs incontournables

Cette approche préserve la pyramide et fait de la génération automatique un multiplicateur de force plutôt qu'une source de bruit.

Ce qu'on peut générer : depuis le code, les specs et les bugs réels

La génération automatique de tests ne se limite pas à « écrire des tests unitaires pour cette fonction ». Les générateurs les plus utiles puisent dans trois sources : le code existant, l'intention qui le sous-tend et les échecs déjà observés.

1) Depuis la structure du code : exercer le comportement, pas seulement les lignes

Étant donné une fonction ou un module, les outils peuvent déduire des cas de test à partir des entrées/sorties, branches et chemins d'exception. Typiquement :

- Entrées du chemin heureux produisant un résultat connu

- Valeurs frontières (chaînes vides, zéro, longueurs max)

- Couverture de branches (if/else)

- Gestion des erreurs (entrées invalides, champs manquants, timeouts)

Ce style est excellent pour entourer rapidement la logique générée par l'IA de vérifications confirmant ce qu'elle fait aujourd'hui.

Si vous avez des critères d'acceptation, des user stories ou des tableaux d'exemples, les générateurs peuvent les convertir en tests qui lisent comme la spec. C'est souvent plus précieux que des tests dérivés du code car cela verrouille le « ce qui doit arriver », pas seulement « ce qui arrive actuellement ».

Un motif pratique : fournissez quelques exemples concrets (entrées + résultats attendus) et demandez au générateur d'ajouter des cas limites cohérents avec ces règles.

3) Depuis les rapports de bug : reproduire d'abord, prévenir ensuite

La génération basée sur des bugs est le moyen le plus rapide de bâtir une suite de régression significative. Fournissez les étapes de reproduction (ou les logs et un payload minimal) et générez :

- un test qui échoue sur le comportement buggy actuel, puis

- le même test passant une fois la correction appliquée — protégeant ainsi contre sa réintroduction.

Tests de snapshot/golden : utiles, avec une mise en garde

Les snapshots peuvent être efficaces pour des sorties stables (UI render, réponses sérialisées). Utilisez-les prudemment : de gros snapshots peuvent « approuver » des erreurs subtiles. Préférez de petits snapshots ciblés et associez-les à des assertions sur des champs-clés devant être corrects.

Choisir quoi tester en premier (sans noyer le projet)

La génération automatique est plus efficace quand vous lui donnez des priorités claires. Si vous la lancez sur tout le code et demandez « tous les tests », vous obtiendrez du bruit : beaucoup de contrôles de faible valeur, une couverture dupliquée et des tests fragiles qui ralentissent la livraison.

Commencez là où l'entreprise sentirait la douleur

Démarrez par les flux dont la rupture serait la plus coûteuse — financièrement, légalement ou en réputation. Un filtre basé sur le risque garde le scope réaliste tout en améliorant rapidement la qualité.

Concentrez-vous d'abord sur :

- Les parcours critiques pour le business (inscription, paiement, workflows centraux) et les zones qui changent souvent (features actives, refactorings, nouvelles intégrations).

- Les domaines à haut risque : paiements, authentification, intégrité des données, permissions/roles et tout ce qui affecte ce que les utilisateurs voient ou peuvent faire.

Pour chaque flux choisi, générez des tests en couches : quelques tests unitaires rapides pour la logique délicate, plus un ou deux tests d'intégration confirmant que le chemin complet fonctionne.

« Happy path + principaux cas limites » vaut mieux qu'une combinaison exhaustive

Demandez une couverture qui correspond aux échecs réels, pas aux permutations théoriques. Un bon jeu de départ est :

- Un test du chemin heureux qui prouve le comportement attendu.

- Les principaux cas limites qui vous inquiètent : entrée manquante/invalide, tokens expirés, permissions insuffisantes, conflits de concurrence et état « vide ».

Vous pouvez étendre ensuite en fonction des bugs, rapports d'incidents ou retours utilisateurs.

Définissez « done » pour que ça reste fait

Rendez la règle explicite : une fonctionnalité n'est pas complète tant que des tests n'existent pas. Cette définition de done compte encore plus avec le code généré par l'IA, car elle empêche le « shipping rapide » de devenir « régressions rapides ».

Si vous voulez que cela tienne, intégrez-le dans votre workflow (par ex. exiger les tests pertinents avant merge dans votre CI) et mentionnez l'attente dans la doc d'équipe (ex. /engineering/definition-of-done).

Schémas de prompt qui produisent de meilleurs tests

L'IA peut générer des tests rapidement, mais la qualité dépend fortement de la manière dont vous demandez. L'objectif est de guider le modèle vers des tests qui protègent le comportement — pas des tests qui exécutent simplement du code.

Mettez votre standard de code directement dans le prompt

Commencez par ancrer la « forme » des tests pour que la sortie corresponde à votre repo.

Incluez :

- Langage + framework de test (ex. TypeScript + Jest, Python + pytest)

- Règles de nommage (ex.

should_<behavior>_when_<condition>)

- Emplacement et structure des fichiers (ex.

src/ et tests/, ou __tests__/)

- Conventions (fixtures, helpers de factory, bibliothèque de mocking)

Cela évite que le modèle n'invente des patterns que votre équipe n'utilise pas.

Fournissez 1–2 vrais exemples de test à copier

Collez un fichier de test existant (ou un court extrait) et dites explicitement : « Imitez ce style. » Cela ancre des décisions comme l'organisation des données de test, le nommage des variables et si vous préférez des tests pilotés par tableaux.

Si votre projet a des helpers (ex. buildUser() ou makeRequest()), incluez ces extraits pour que les tests générés les réutilisent au lieu de les réimplémenter.

Demandez des assertions significatives (pas seulement « ça s'exécute »)

Soyez explicite sur ce qu'est un « bon » test :

- Affirmez les sorties et les changements d'état

- Vérifiez les effets de bord (ex. écritures en base, événements émis)

- Affirmez les types/messages d'erreur quand nécessaire

Une ligne de prompt utile : « Chaque test doit contenir au moins une assertion sur le comportement métier (pas seulement ‘aucune exception levée’). »

Exigez des tests négatifs et de frontière

La plupart des suites générées penchent vers le chemin heureux. Contrez cela en demandant :

- Entrées invalides et échecs attendus

- Valeurs frontières (chaînes vides, zéro, longueur max)

- Échecs d'autorisation/permission

- Dépendances manquantes (réponses null, timeouts)

Un modèle de prompt pratique

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Relecture humaine : s'assurer que les tests générés aident vraiment

L'IA peut rédiger beaucoup de tests rapidement, mais elle ne peut pas juger si ces tests représentent votre intention. Une passe humaine transforme « tests qui s'exécutent » en « tests qui nous protègent ». L'objectif n'est pas de chipoter le style, mais de confirmer que la suite détectera des régressions significatives sans devenir un coût de maintenance.

Relire pour la correction et la pertinence

Commencez par deux questions :

- Le test affirme-t-il un comportement dont le produit a réellement besoin ?

- Seriez-vous content si ce test échouait sur un changement futur — parce qu'il a signalé un vrai problème ?

Les tests générés verrouillent parfois des comportements accidentels (détails d'implémentation) au lieu de la règle voulue. Si un test ressemble à une copie du code plutôt qu'à une description du résultat attendu, orientez-le vers des assertions de haut niveau.

Surveillez la fragilité (le tueur silencieux de productivité)

Les sources communes de flakiness sont le sur-mocking, les timestamps codés, et les valeurs aléatoires. Préférez des entrées déterministes et des assertions stables (par ex. assert sur une date parsée ou une plage plutôt que sur la chaîne brute de Date.now()). Si un test demande un mocking excessif pour passer, il teste peut-être le wiring plutôt que le comportement.

Assurez-vous que les échecs arrivent pour la bonne raison

Un test « passant » peut être inutile s'il passerait même lorsque la fonctionnalité est cassée (faux positif). Repérez les assertions faibles comme « ne lève pas d'exception » ou vérifier seulement qu'une fonction a été appelée. Renforcez-les en affirmant des sorties, des changements d'état, des erreurs retournées ou des données persistées.

Utilisez une checklist de revue légère

Une checklist simple maintient la cohérence des revues :

- Lisibilité : noms clairs, setup minimal, intention évidente

- Couverture de l'intention : cas limites et chemins d'erreur inclus

- Maintenabilité : n'évite pas de sur-spécifier les internes ; mock minimal

- Qualité du signal : échouerait-elle sur une vraie régression, pas sur des refactorings inoffensifs ?

Traitez les tests générés comme n'importe quel autre code : mergez seulement ce que vous accepterez d'assumer dans six mois.

Faire tenir la solution : contrôles CI qui gardent le code IA honnête

L'IA peut vous aider à écrire vite, mais le vrai bénéfice est de garder ce code correct dans le temps. La façon la plus simple de verrouiller la qualité est de faire exécuter les tests et contrôles automatiquement à chaque changement — ainsi les régressions sont détectées avant le déploiement.

Un flux pratique qui marche

Un workflow léger que beaucoup d'équipes adoptent :

- Générez ou modifiez la feature (assisté par l'IA ou non).

- Générez des tests pour le nouveau comportement (et pour le bug que vous venez de corriger).

- Exécutez tout localement pour confirmer que tout passe.

- Commitez code + tests ensemble.

La dernière étape est importante : du code IA sans tests a tendance à dériver. Avec des tests, vous consignez le comportement voulu d'une manière que le CI peut appliquer.

Le CI comme filet de sécurité incontournable

Configurez votre pipeline CI pour s'exécuter à chaque pull request (et idéalement sur les merges vers main). Au minimum, il doit :

- Installer les dépendances dans un environnement propre

- Exécuter les tests unitaires/intégration

- Faire échouer la build sur toute erreur de test

Cela évite les surprises du type « ça marchait sur ma machine » et attrape les cassures accidentelles quand un coéquipier (ou un prompt IA ultérieur) modifie du code ailleurs.

Ajoutez quelques garde-fous légers (rapides)

Les tests sont essentiels, mais ne captent pas tout. Ajoutez des contrôles rapides et rapides qui complètent la génération de tests :

- Linting (style + erreurs communes)

- Vérifications de types (là où c'est applicable)

- Vérifications de format (pour garder des diffs lisibles)

Gardez ces contrôles rapides — si le CI est lent ou bruyant, les gens cherchent des moyens de l'éviter.

Planification des coûts et capacité

Si vous élargissez les exécutions CI parce que vous générez plus de tests, assurez-vous que votre budget suit. Si vous suivez les minutes CI, revoyez les limites et options (voir /pricing).

Utiliser les tests qui échouent pour guider l'itération IA suivante

Une façon étonnamment efficace de travailler avec du code IA est de traiter les tests qui échouent comme votre « prochain prompt ». Plutôt que de demander au modèle d'« améliorer la feature » de façon vague, vous lui fournissez un échec concret et laissez cet échec contraindre la modification.

Le workflow : échec → prompt → correction → répéter

- Exécutez la suite (ou CI) et capturez un échec. Copiez le nom du test qui échoue et le message d'assertion/stack trace pertinent.

- Demandez à l'IA de traiter uniquement cet échec. Fournissez le contexte de code minimal (le test qui échoue et la fonction/module testé), plus toute règle métier potentiellement violée.

- Exigez un test de régression d'abord. Si l'échec vient d'un bug ou d'un incident de production, demandez à l'IA d'ajouter ou d'ajuster un test qui reproduit le bug avant de modifier l'implémentation.

- Appliquez le plus petit changement qui fait passer le test. Réexécutez les tests immédiatement.

- Passez au test suivant qui échoue. Une erreur à la fois garde l'itération ciblée et compréhensible.

Schéma de prompt : gardez-le petit et vérifiable

Au lieu de :

- « Corrige la logique de login et mets à jour les tests. »

Utilisez :

- « Ce test échoue :

shouldRejectExpiredToken. Voici la sortie d'échec et le code pertinent. Mets à jour l'implémentation pour que ce test passe sans changer le comportement public. Si nécessaire, ajoute un test de régression qui capture le bug. »

Pourquoi cela réduit les allers-retours

Les tests qui échouent éliminent les conjectures. Ils définissent ce que « correct » signifie de façon exécutable, donc vous ne négociez pas les exigences dans une conversation. Vous évitez aussi les modifications tentaculaires : chaque prompt est limité à un résultat mesurable, ce qui facilite la revue humaine et permet de repérer lorsque l'IA « corrige » le symptôme mais casse autre chose.

C'est aussi l'endroit où un workflow de type agent peut payer : un agent se concentre sur la modification minimale du code, un autre propose l'ajustement de test, et vous relisez le diff. Des plateformes comme Koder.ai sont construites autour de ce type de développement itératif axé chat — elles rendent la pratique « tests comme prochain prompt » naturelle.

Mesurer le succès sans poursuivre des métriques de vanité

La génération automatique peut gonfler votre suite du jour au lendemain — mais « plus grand » n'est pas synonyme de « meilleur ». L'objectif est la confiance : attraper les régressions tôt, réduire les défauts en production et maintenir l'équipe en mouvement.

Métriques qui reflètent réellement la qualité

Commencez par des signaux qui mappent aux résultats souhaités :

- Taux de builds passant (sur main) : si des merges cassent souvent, les tests générés sont peut‑être trop fragiles ou vos prompts produisent des hypothèses incorrectes.

- Taux de tests flaky : suivez la fréquence des tests qui échouent/passent au rerun. Une hausse du flaky rate est une taxe sur la confiance développeur.

- Temps pour détecter une régression : mesurez l'intervalle entre l'introduction d'un bug et le test CI qui l'attrape. Les tests générés doivent raccourcir cette fenêtre.

Traitez la couverture comme un indice, pas un score

La couverture peut être une alerte intéressante — surtout pour repérer des chemins non testés — mais elle est facile à gonfler. Les tests générés peuvent augmenter la couverture tout en effectuant peu d'assertions pertinentes. Préférez des indicateurs comme :

- Assertions par test (vérification rapide, pas un KPI absolu)

- Résultats de mutation testing (si vous l'utilisez)

- Est-ce que les tests échouent quand on casse volontairement le comportement

Concentrez-vous sur « défauts attrapés avant release »

Si vous suivez juste le nombre de tests ou la couverture, vous optimiserez le volume. Suivez les défauts attrapés avant la mise en production : bugs trouvés en CI, QA ou staging qui auraient atteint les utilisateurs. Quand la génération automatique fonctionne, ce nombre augmente tandis que les incidents en production diminuent.

Planifiez un nettoyage récurrent

Les suites générées demandent de la maintenance. Programmez une tâche récurrente pour :

- Supprimer les tests redondants qui n'ajoutent pas de protection unique

- Stabiliser ou supprimer les tests flaky

- Consolider les cas qui se chevauchent en tests plus clairs et révélateurs d'intention

Le succès, c'est un CI plus calme, des retours plus rapides et moins de surprises — pas un tableau de bord impressionnant.

Pièges courants et plan de déploiement pratique

La génération automatique peut améliorer la qualité rapidement — mais seulement si vous la traitez comme une aide et non comme une autorité. Les échecs les plus fréquents se ressemblent d'équipe en équipe, et ils sont évitables.

Pièges courants à surveiller

La dépendance excessive est le piège classique : les tests générés peuvent créer l'illusion de sécurité tout en manquant les vrais risques. Si les gens arrêtent de réfléchir (« l'outil a écrit les tests, donc on est couverts »), vous enverrez des bugs plus vite — simplement avec plus de coches vertes.

Un autre problème fréquent est de tester des détails d'implémentation plutôt que le comportement. Les outils IA s'accrochent souvent aux noms de méthodes actuels, helpers internes ou messages d'erreur exacts. Ces tests deviennent fragiles : les refactorings les cassent même quand la fonctionnalité fonctionne toujours. Préférez des tests qui décrivent ce qui doit arriver, pas comment c'est implémenté.

Sécurité et confidentialité : ne divulguez pas ce que vous ne devriez pas partager

La génération de tests implique souvent de copier du code, des traces ou des specs dans un prompt. Cela peut exposer des secrets (clés API), des données clients ou de la logique propriétaire.

Gardez les prompts et fixtures de test exempts d'informations sensibles :

- Masquez tokens, credentials et URLs internes.

- Évitez de coller des logs de production contenant des données personnelles.

- Utilisez des exemples synthétiques (comptes factices, IDs factices) pour les données de test.

- Si vous devez partager des cas réels, anonymisez et minimisez.

Si vous utilisez une plateforme IA hébergée, appliquez la même discipline. Même avec des déploiements régionaux, traitez vos prompts comme des éléments de posture de sécurité.

Un plan de déploiement pratique (que les équipes suivent réellement)

Commencez petit et rendez-le routinier :

- Choisissez un service ou module avec des changements fréquents.

- Générez des tests unitaires pour les chemins à plus haut risque (mouvements d'argent, permissions, transformations de données).

- Ajoutez une règle CI simple : les nouvelles features assistées par l'IA doivent inclure des tests (voir /blog/ci-checks-for-ai-code).

- Exigez une revue rapide avec checklist : « Ce test affirme-il un comportement ? Échouerait-il pour la bonne raison ? »

- Suivez les régressions évitées (pas seulement la couverture), puis étendez aux tests d'intégration une fois que les unit tests sont stables.

L'objectif n'est pas un maximum de tests — c'est un feedback fiable qui garde la logique IA honnête.