Pourquoi Shannon compte encore pour la tech de tous les jours

Vous utilisez les idées de Claude Shannon chaque fois que vous envoyez un texto, regardez une vidéo ou vous connectez au Wi‑Fi. Pas parce que votre téléphone « connaît Shannon », mais parce que les systèmes numériques modernes sont construits autour d'une promesse simple : nous pouvons transformer des messages du monde réel en bits, faire traverser ces bits par des canaux imparfaits, et quand même récupérer le contenu original avec une grande fiabilité.

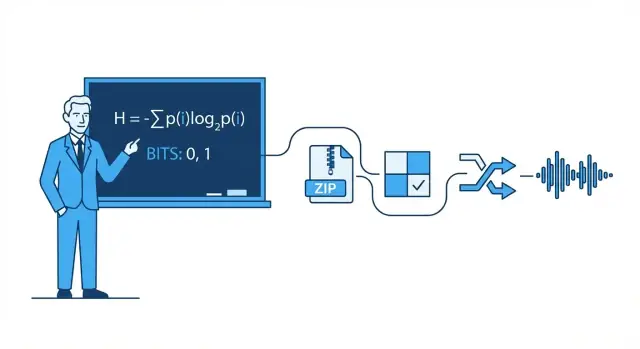

La théorie de l'information est la mathématique des messages : combien de choix (incertitude) contient un message, à quel point il peut être représenté efficacement, et comment il peut être transmis de façon fiable quand bruit, interférence et congestion s'en mêlent.

Il y a des maths derrière tout ça, mais vous n'avez pas besoin d'être mathématicien pour saisir l'intuition pratique. Nous utiliserons des exemples quotidiens — comme pourquoi certaines photos se compressent mieux que d'autres, ou pourquoi votre appel peut sembler correct même lorsque le signal est faible — pour expliquer les idées sans formules lourdes.

Les quatre piliers que vous verrez partout

Cet article tourne autour de quatre piliers inspirés par Shannon qui apparaissent dans la tech moderne :

- Compression : réduire les données (audio, vidéo, fichiers) sans perdre l'essentiel.

- Correction d'erreurs : ajouter juste assez de bits supplémentaires pour détecter et réparer les fautes.

- Fiabilité réseau : gérer les paquets perdus via renvois, ordonnancement et compromis de débit.

- Communication numérique de bout en bout : voir la chaîne complète de la source (votre message) au canal (Wi‑Fi, cellulaire, fibre) et retour.

Ce que vous saurez raisonner après

À la fin, vous devriez pouvoir raisonner clairement sur les compromis réels : pourquoi une meilleure qualité vidéo demande plus de bande passante, pourquoi « plus de barres » n'implique pas forcément un internet plus rapide, pourquoi certaines applications semblent instantanées alors que d'autres mettent en tampon, et pourquoi tout système atteint des limites — en particulier la célèbre limite de Shannon sur la quantité d'information fiable qu'un canal peut porter.

Claude Shannon en une page : l'idée principale

En 1948, le mathématicien et ingénieur Claude Shannon publia un article au titre discret — A Mathematical Theory of Communication — qui a discrètement réorganisé notre manière de penser l'envoi de données. Plutôt que de traiter la communication comme un art, il en fit un problème d'ingénierie : une source produit des messages, un canal les véhicule, le bruit les corrompt, et un récepteur tente de reconstruire ce qui a été envoyé.

Le geste clé de Shannon fut de définir l'information de façon mesurable et utile aux machines. Dans son cadre, l'information ne concerne pas l'importance ou la signification d'un message, ni sa véracité. Il s'agit de ce qui est surprenant — combien d'incertitude est levée quand on apprend le résultat.

Si vous savez déjà ce qui va se passer, le message porte presque pas d'information. Si vous êtes vraiment dans l'incertitude, apprendre le résultat apporte davantage d'information.

Le bit : l'unité la plus simple qu'on peut compter

Pour mesurer l'information, Shannon popularisa le bit (abréviation de binary digit). Un bit est la quantité d'information nécessaire pour résoudre une incertitude simple oui/non.

Exemple : si je demande « La lumière est-elle allumée ? » et que vous n'en savez rien auparavant, la réponse (oui ou non) peut être vue comme apportant 1 bit d'information. Beaucoup de messages réels peuvent être découpés en longues séquences de ces choix binaires, ce qui explique pourquoi tout, du texte aux photos en passant par l'audio, peut être stocké et transmis en bits.

Ce que cet article fera (et ne fera pas)

Cet article met l'accent sur l'intuition pratique derrière les idées de Shannon et pourquoi elles apparaissent partout : compression (rendre les fichiers plus petits), correction d'erreurs (réparer la corruption), fiabilité réseau (renvois et débit) et capacité de canal (à quelle vitesse on peut envoyer des données sur un lien bruyant).

Il ne passera pas par des démonstrations mathématiques lourdes. Vous n'avez pas besoin de maths avancées pour comprendre l'essentiel : une fois qu'on sait mesurer l'information, on peut concevoir des systèmes qui se rapprochent du meilleur rendement possible — souvent étonnamment près des limites théoriques décrites par Shannon.

Bits, symboles et codes : un vocabulaire pratique

Avant de parler d'entropie, de compression ou de correction d'erreurs, il est utile de préciser quelques termes quotidiens. Les idées de Shannon deviennent plus faciles quand on peut nommer les pièces.

Symboles, alphabets et messages

Un symbole est un « jeton » au sens où il appartient à un ensemble convenu. Cet ensemble est l'alphabet. En anglais, l'alphabet peut être les lettres (plus l'espace et la ponctuation). Dans un fichier informatique, l'alphabet peut être les valeurs d'octet 0–255.

Un message est une séquence de symboles de cet alphabet : un mot, une phrase, un fichier image, ou un flux d'échantillons audio.

Pour rester concret, imaginez un petit alphabet : {A, B, C}. Un message pourrait être :

A A B C A B A ...

Bits et codes

Un bit est un chiffre binaire : 0 ou 1. Les ordinateurs stockent et transmettent des bits parce que le matériel peut distinguer de façon fiable deux états.

Un code est une règle pour représenter des symboles en bits (ou autres symboles). Par exemple, avec notre alphabet {A, B, C}, un code binaire possible est :

Désormais, tout message composé de A/B/C peut être transformé en un flux de bits.

Encodage vs compression vs chiffrement

Ces termes sont souvent confondus :

- Encodage : traduire des données dans un format choisi pour qu'elles puissent être stockées/transmises/traitées (comme mapper A/B/C en bits, ou convertir du texte en UTF‑8).

- Compression : encodage qui utilise moins de bits en moyenne en exploitant des motifs et des fréquences inégales.

- Chiffrement : brouiller les données avec une clé pour qu'un tiers ne puisse pas les lire ; il s'agit de confidentialité, pas de taille.

Une intuition rapide sur les probabilités

Les messages réels ne sont pas aléatoires : certains symboles apparaissent plus souvent que d'autres. Supposons que A apparaisse 70 % du temps, B 20 %, C 10 %. Un bon schéma de compression donnera en moyenne des codes plus courts aux symboles fréquents (A) et des codes plus longs aux symboles rares (C). Cette inégalité est ce que l'entropie quantifiera plus loin.

Entropie : mesurer la surprise (et pourquoi elle prédit la compressibilité)

L'idée la plus célèbre de Shannon est l'entropie : une façon de mesurer combien de « surprise » contient une source d'information. Pas la surprise émotionnelle — la surprise comme imprévisibilité. Plus le prochain symbole est imprévisible, plus il apporte d'information lorsqu'il arrive.

L'entropie comme « surprise moyenne »

Imaginez que vous regardez des lancers de pièce.

- Pièce équitable (50/50 faces ou piles) : chaque lancer est difficile à prédire. Faces est aussi probable que piles, donc vous êtes régulièrement « surpris » dans un sens ou l'autre. Cette forte imprévisibilité signifie entropie élevée.

- Pièce biaisée (par exemple 95 % faces, 5 % piles) : la plupart des lancers donnent faces. Après quelques lancers, vous vous attendez à faces, donc voir faces apporte peu d'information. Seul le rare pile est vraiment surprenant. En moyenne, la suite a entropie faible.

Cette vision de « surprise moyenne » correspond à des motifs quotidiens : un fichier texte avec des espaces et des mots communs répétés est plus facile à prédire qu'un fichier de caractères aléatoires.

Pourquoi la prévisibilité implique la compressibilité

La compression fonctionne en donnant des codes plus courts aux symboles fréquents et des codes plus longs aux rares. Si la source est prévisible (entropie faible), vous pouvez utiliser massivement des codes courts et économiser beaucoup de place. Si elle est proche de l'aléatoire (entropie élevée), il reste peu de marge pour la réduire parce que rien n'apparaît assez souvent pour être exploité.

Entropie et meilleure longueur moyenne de code possible

Shannon a montré que l'entropie fixe un repère conceptuel : c'est la borne inférieure sur la longueur moyenne en bits par symbole que vous pouvez atteindre quand vous encodez des données venant de cette source.

Important : l'entropie n'est pas un algorithme de compression. Elle ne vous dit pas exactement comment compresser un fichier. Elle vous dit ce qui est théoriquement possible — et quand vous êtes déjà proche de la limite.

La compression, c'est prendre un message qui pourrait être décrit en moins de bits et le décrire effectivement en moins de bits. L'idée clé de Shannon est que les données à faible entropie (plus prévisibles) ont de la « place » pour être réduites, tandis que les données à entropie élevée (proches du hasard) n'en ont pas.

Pourquoi les motifs et fréquences inégales se compressent bien

Les répétitions sont la victoire évidente : si un fichier contient les mêmes séquences encore et encore, on peut stocker la séquence une fois et y référer plusieurs fois. Mais même sans répétitions claires, des fréquences de symboles biaisées aident.

Si un texte utilise « e » bien plus souvent que « z », ou si un journal d'événements répète les mêmes horodatages et mots-clés, vous n'avez pas besoin du même nombre de bits pour chaque caractère. Plus les fréquences sont inégales, plus la source est prévisible et compressible.

Codage à longueur variable (l'intuition centrale)

Un moyen pratique d'exploiter des fréquences biaisées est le codage à longueur variable :

- Les symboles fréquents reçoivent des codes courts

- Les symboles rares reçoivent des codes longs

Fait soigneusement, cela réduit la taille moyenne sans perte d'information.

Les compresseurs sans perte réels mélangent souvent plusieurs idées, mais voici des familles courantes :

- Codage de Huffman : construit une table efficace « court-pour-fréquent »

- Codage arithmétique : place les symboles dans un intervalle fractionnaire, souvent plus proche de la limite d'entropie

- Méthodes LZ (Lempel–Ziv) : trouvent des sous-chaînes répétées et les remplacent par des références (utilisées dans de nombreux formats ZIP)

Sans perte vs avec perte (ZIP vs JPEG/MP3)

Compression sans perte reproduit parfaitement l'original (par ex. ZIP, PNG). Elle est essentielle pour les logiciels, documents et tout ce où un bit erroné est critique.

Compression avec perte sacrifie volontairement des informations que l'on juge peu perceptibles (par ex. JPEG pour photos, MP3/AAC pour audio). L'objectif devient « même expérience » plutôt que « mêmes bits », ce qui permet d'obtenir des fichiers beaucoup plus petits en éliminant des détails perceptuellement mineurs.

Les erreurs arrivent : pourquoi la redondance est utile

Testez débit et fiabilité

Lancez un front React et un back Go pour tester les limites réelles de débit et de latence.

Tout système numérique repose sur une hypothèse fragile : un 0 reste 0 et un 1 reste 1. En réalité, des bits peuvent basculer.

D'où viennent les erreurs

En transmission, l'interférence électrique, un signal Wi‑Fi faible ou le bruit radio peuvent pousser un signal au-delà d'un seuil, si bien qu'un récepteur interprète mal un symbole. En stockage, de petits effets physiques — l'usure de la mémoire flash, des rayures sur un média optique, ou même des radiations parasites — peuvent changer un état stocké.

Parce que les erreurs sont inévitables, les ingénieurs ajoutent délibérément de la redondance : des bits supplémentaires qui ne portent pas d'information « nouvelle », mais aident à détecter ou réparer les dégâts.

Redondance simple que vous avez déjà utilisée

Bit de parité (détection rapide). Ajoutez un bit pour que le nombre total de 1 soit pair (parité paire) ou impair (parité impaire). Si un seul bit flippe, le contrôle de parité échoue.

- Force : peu coûteux et rapide.

- Limite : il ne permet généralement pas de dire quel bit est faux, et deux inversions peuvent s'annuler et paraître correctes.

Somme de contrôle (meilleure détection pour des blocs). Plutôt qu'un bit, calculez un petit résumé d'un paquet ou d'un fichier (par ex. somme additive, CRC). Le récepteur recalcule et compare.

- Force : détecte beaucoup d'erreurs multi-bits sur un bloc.

- Limite : détection seulement ; si elle échoue, il faut souvent un renvoi ou une copie de secours.

Code de répétition (correction simple). Envoyer chaque bit trois fois : 0 devient 000, 1 devient 111. Le récepteur fait un vote majoritaire.

- Force : peut corriger un bit erroné sur chaque groupe de trois.

- Limite : extrêmement inefficace — triple les données.

Détection vs correction (et quand s'en servir)

La détection d'erreurs répond à : « Quelque chose s'est-il mal passé ? » Elle est courante quand les renvois sont peu coûteux — comme pour des paquets réseau qui peuvent être retransmis.

La correction d'erreurs répond à : « Quels étaient les bits originaux ? » Elle est utilisée quand renvoyer est coûteux ou impossible — streaming audio sur un lien bruyant, communications spatiales lointaines, ou lecture de stockage endommagé.

La redondance semble gaspilleuse, mais c'est ce qui permet aux systèmes modernes d'être rapides et fiables malgré le matériel imparfait et les canaux bruyants.

Capacité de canal et limite de Shannon (sans maths lourdes)

Quand vous envoyez des données sur un canal réel — Wi‑Fi, cellulaire, un câble USB, ou même un disque dur — le bruit et l'interférence peuvent inverser des bits ou brouiller des symboles. La grande promesse de Shannon était surprenante : la communication fiable est possible, même sur des canaux bruyants, tant que vous n'essayez pas d'envoyer trop d'information en même temps.

La capacité de canal en clair

La capacité du canal est la « limite de vitesse » du canal pour l'information : le débit maximal (bits par seconde) que vous pouvez transmettre avec des erreurs ramenées arbitrairement proches de zéro, étant donné le niveau de bruit et des contraintes comme la bande passante et la puissance.

Ce n'est pas la même chose que le taux de symbole brut (à quelle vitesse vous basculez un signal). Il s'agit de la quantité significative d'information qui survit au bruit — une fois qu'on a inclus un encodage intelligent, de la redondance et un décodage adapté.

La limite de Shannon : une frontière que les ingénieurs poursuivent

La limite de Shannon est le nom pratique donné à cette frontière : en dessous, on peut (en théorie) rendre la communication aussi fiable qu'on veut ; au‑dessus, on ne peut pas — des erreurs persistent quel que soit l'ingéniosité.

Les ingénieurs s'emploient à approcher cette limite avec une meilleure modulation et de meilleurs codes de correction d'erreurs. Les systèmes modernes comme LTE/5G et Wi‑Fi utilisent des codages avancés pour fonctionner près de cette frontière plutôt que de gaspiller énormément de puissance de signal ou de bande passante.

Le compromis clé (débit vs probabilité d'erreur)

Pensez-y comme charger un camion sur une route cahoteuse :

- Charger trop serré (débit au‑dessus de la capacité) et certains objets se briseront toujours (taux d'erreur non nul).

- Charger avec marge et rembourrage (débit en dessous de la capacité) et vous pouvez rendre la casse aussi rare que vous voulez — au prix d'un débit plus faible ou de plus de redondance.

Shannon ne nous a pas donné un « meilleur code » unique, mais il a prouvé que la limite existe — et qu'il vaut la peine de s'en approcher.

Codes correcteurs d'erreurs dans les systèmes réels

Mesurez les performances mobiles

Prototypiez un client Flutter pour voir comment les signaux faibles affectent l'UX et le buffering.

Le théorème de Shannon sur les canaux bruyants est souvent résumé ainsi : si vous envoyez des données en dessous de la capacité d'un canal, il existe des codes qui rendent les erreurs arbitrairement rares. L'ingénierie réelle consiste à transformer cette preuve d'existence en schémas pratiques qui tiennent dans des puces, des batteries et des contraintes de délai.

La boîte à outils pratique : blocs, entrelacement et meilleures décisions

La plupart des systèmes réels utilisent des codes en blocs (protéger un morceau de bits à la fois) ou des codes en flux (protéger une séquence continue).

Avec les codes en blocs, vous ajoutez de la redondance soigneusement conçue à chaque bloc pour que le récepteur puisse détecter et corriger des erreurs. Avec l'entrelacement, vous remélangez l'ordre des bits/symboles transmis pour transformer une rafale de bruit (beaucoup d'erreurs consécutives) en erreurs éparses et corrigeables à travers plusieurs blocs — crucial pour le sans fil et le stockage.

Un autre grand séparateur est la façon dont le récepteur « décide » ce qu'il a entendu :

- Décisions dures : chaque signal reçu devient immédiatement 0 ou 1.

- Décisions douces : le récepteur conserve aussi la confiance (par ex. « c'est probablement un 1, mais pas sûr »).

Les décisions douces fournissent plus d'information au décodeur et peuvent améliorer sensiblement la fiabilité, surtout en Wi‑Fi et en cellulaire.

Des codes que vous avez déjà utilisés

- Reed–Solomon : opèrent sur des symboles (pas sur des bits) et excellent contre les rafales d'erreurs. Utilisés dans QR codes, CD/DVD et certains systèmes de diffusion/stockage.

- Codes convolutionnels : choix classique pour les flux continus ; historiquement employés sur les liaisons satellite.

- Codes Turbo : grand saut dans les années 1990, largement utilisés en 3G/4G.

- LDPC (Low-Density Parity-Check) : codes en blocs modernes très efficaces employés en Wi‑Fi, 5G et de nombreux systèmes à haut débit.

Où ils importent

Des communications spatiales (où renvoyer est coûteux ou impossible) aux satellites, Wi‑Fi et 5G, les codes correcteurs d'erreurs sont le pont pratique entre la théorie de Shannon et la réalité des canaux bruyants — ils échangent des bits et du calcul contre moins d'appels coupés, des téléchargements plus rapides et des liaisons plus fiables.

Fiabilité réseau : paquets, renvois et débit

L'internet fonctionne même si les liaisons individuelles sont imparfaites. Le Wi‑Fi s'affaiblit, les signaux mobiles sont bloqués, et cuivre/fibre subissent toujours du bruit, des interférences et des pannes matérielles occasionnelles. Le message central de Shannon — le bruit est inévitable mais la fiabilité est atteignable — se matérialise en réseau par un mélange réfléchi de détection/correction d'erreurs et de retransmission.

Paquets : petits paris au lieu d'un gros

Les données sont découpées en paquets pour que le réseau puisse contourner les problèmes et récupérer des pertes sans renvoyer tout. Chaque paquet porte des bits supplémentaires (en‑têtes et contrôles) qui aident le récepteur à décider si ce qu'il a reçu est fiable.

Un schéma courant est ARQ (Automatic Repeat reQuest) :

- Le récepteur vérifie un paquet (typiquement avec une somme/CRC).

- S'il est correct, il envoie une accusé de réception (ACK).

- S'il est manquant ou corrompu, l'émetteur retransmet après un délai (ou après un signal négatif).

Corriger vs retransmettre : le compromis de latence

Quand un paquet est erroné, vous avez deux choix principaux :

- Le corriger immédiatement avec une correction d'erreurs en avant (FEC) : ajoutez assez de redondance pour que le récepteur puisse réparer certaines erreurs sans demander le renvoi.

- Le retransmettre avec ARQ : envoyez moins de redondance au départ, mais payez en temps si quelque chose foire.

Le FEC réduit la latence sur des liens où les retransmissions sont coûteuses (haute latence, pertes intermittentes). L'ARQ est efficace quand les pertes sont rares, car on n'alourdit pas chaque paquet inutilement.

Débit, congestion et pourquoi la fiabilité n'est pas gratuite

Les mécanismes de fiabilité consomment de la capacité : bits supplémentaires, paquets en plus et attente. Les retransmissions augmentent la charge et peuvent aggraver la congestion ; la congestion augmente le délai et la perte, ce qui déclenche encore plus de renvois.

Un bon design réseau vise un équilibre : assez de fiabilité pour livrer des données correctes, tout en gardant l'overhead bas pour que le réseau conserve un débit sain dans des conditions variables.

Communication numérique de bout en bout : de la source au canal

Une façon utile de comprendre les systèmes numériques modernes est de les voir comme un pipeline avec deux objectifs : rendre le message plus petit et faire en sorte qu'il survive le voyage. L'idée de Shannon était qu'on peut souvent penser à ces deux tâches comme des couches séparées — même si les produits réels les mélangent parfois.

Étape 1 : codage source (compression)

Vous partez d'une « source » : texte, audio, vidéo, lectures de capteurs. Le codage source retire la structure prévisible pour ne pas gaspiller de bits. Cela peut être ZIP pour des fichiers, AAC/Opus pour l'audio, ou H.264/AV1 pour la vidéo.

La compression est l'endroit où l'entropie se manifeste en pratique : plus le contenu est prévisible, moins vous avez besoin de bits en moyenne.

Étape 2 : codage de canal (correction d'erreurs)

Ensuite, les bits compressés doivent traverser un canal bruyant : Wi‑Fi, cellulaire, fibre, câble USB. Le codage de canal ajoute une redondance conçue pour que le récepteur puisse détecter et corriger les erreurs. C'est le domaine des CRC, Reed–Solomon, LDPC et autres méthodes de FEC.

L'idée de « séparation » de Shannon (un modèle mental utile)

Shannon a montré que, en théorie, vous pouvez concevoir le codage source pour approcher la meilleure compression possible, et le codage de canal pour approcher la meilleure fiabilité jusqu'à la capacité du canal — indépendamment l'un de l'autre.

Dans la pratique, cette séparation reste un bon moyen de déboguer : si la performance est mauvaise, demandez si vous perdez en efficacité dans la compression (codage source), si la liaison est inefficace (codage de canal), ou si vous payez trop en latence avec les renvois et le buffering.

Exemple concret : streaming vidéo sur Wi‑Fi

Quand vous streamez une vidéo, l'application utilise un codec pour compresser les images. Sur le Wi‑Fi, des paquets peuvent être perdus ou corrompus, donc le système ajoute une détection d'erreur, parfois du FEC, puis utilise des retransmissions (ARQ) quand nécessaire. Si la connexion se dégrade, le lecteur peut basculer vers un flux à plus faible débit.

Les systèmes réels brouillent la séparation parce que le temps compte : attendre des renvois peut provoquer du buffering, et les conditions sans fil changent vite. C'est pourquoi les piles de streaming combinent choix de compression, redondance et adaptation ensemble — pas parfaitement séparés, mais guidés par le modèle de Shannon.

Idées reçues et compromis pratiques

Soyez récompensé pour vos créations

Gagnez des crédits en partageant ce que vous avez construit avec Koder.ai et ce que vous avez appris.

La théorie de l'information est souvent citée, et quelques idées sont simplifiées à l'excès. Voici des malentendus courants — et les compromis réels que font les ingénieurs lorsqu'ils conçoivent compression, stockage et réseaux.

Idée reçue 1 : « Entropie = hasard »

Dans le langage courant, « aléatoire » peut signifier « désordonné » ou « imprévisible ». L'entropie de Shannon est plus précise : elle mesure la surprise par rapport à un modèle de probabilité.

- Un flux parfaitement prévisible (tous zéros) a une faible entropie.

- Un flux difficile à prédire au vu de ce que vous savez a une entropie plus élevée.

L'entropie n'est pas une impression ; c'est un nombre lié aux hypothèses sur le comportement de la source.

Idée reçue 2 : « Plus de compression, c'est toujours mieux »

La compression supprime la redondance. La correction d'erreurs ajoute souvent de la redondance à dessein pour que le récepteur puisse récupérer des erreurs.

Cela crée une tension pratique :

- Si vous compressez agressivement puis envoyez sur un canal bruyant, vous avez peut-être moins de marge pour récupérer des dégâts.

- Les systèmes bien conçus compressent d'abord (retirer les motifs prévisibles), puis ajoutent une redondance structurée (codes correcteurs) pour le canal.

Idée reçue 3 : « On peut être parfaitement fiable à n'importe quelle vitesse »

La capacité de Shannon dit qu'il existe un débit maximal fiable pour un canal donné et un niveau de bruit. En dessous de cette limite, on peut rendre les taux d'erreur extrêmement faibles avec le bon codage ; au‑dessus, les erreurs deviennent inévitables quoi qu'on fasse.

C'est pourquoi « parfaitement fiable à n'importe quelle vitesse » est impossible : augmenter la vitesse implique d'accepter un taux d'erreur plus élevé, une latence supérieure (plus de renvois), ou plus d'overhead (codage plus fort).

Une checklist simple pour les systèmes réels

En évaluant un produit ou une architecture, demandez :

- Statistiques de la source : les données sont-elles prévisibles (texte, logs) ou proches du hasard (chiffrées, déjà compressées) ?

- Bruit : qu'est-ce qui peut les corrompre — interférence sans fil, bit rot, perte de paquets ?

- Budget de latence : pouvez-vous tolérer des renvois et du buffering, ou faut-il du temps réel ?

- Choix d'overhead : dépensez-vous des bits pour la compression, la correction d'erreurs, les renvois, ou un mélange ?

Bien régler ces quatre éléments compte plus que mémoriser des formules.

Principaux enseignements et suites possibles

Le message central de Shannon est que l'information peut être mesurée, déplacée, protégée et compressée avec un petit ensemble d'idées.

- Un bit est la monnaie commune qui permet de traiter texte, audio, vidéo et données de capteurs une fois encodés.

- L'entropie mesure l'imprévisibilité d'une source et prédit combien elle peut être compressée.

- Le bruit et la perte sont inévitables, donc les systèmes fiables ajoutent de la redondance via la détection et les codes correcteurs d'erreurs.

- La capacité de canal fixe un plafond réel : au-delà d'un certain débit, on ne peut plus être fiable ; il faut baisser le débit, améliorer le canal ou changer le codage.

Les réseaux et systèmes de stockage modernes sont constamment le théâtre de compromis entre débit, fiabilité, latence et calcul.

Une note pratique pour les concepteurs

Si vous construisez des produits réels — APIs, fonctions de streaming, applications mobiles, pipelines de télémétrie — le cadre de Shannon est une checklist de conception utile : compressez ce que vous pouvez, protégez ce qui doit l'être et soyez explicite sur le budget latence/débit. Un endroit où cela se voit tout de suite est lorsque vous prototypez des systèmes bout à bout puis itérez : avec une plateforme de type « vibe-coding » comme Koder.ai, les équipes peuvent lancer une app web React, un backend Go avec PostgreSQL et même un client mobile Flutter à partir d'une spécification pilotée par chat, puis tester tôt les compromis réels (taille des payloads, renvois, comportement de buffering). Des fonctionnalités comme le mode planning, les snapshots et le rollback facilitent l'expérimentation entre « fiabilité plus forte vs overhead plus faible » sans perdre en rapidité d'exécution.

Qui devrait creuser davantage

Un approfondissement est utile pour :

- Étudiants qui veulent un modèle mental clair reliant probabilité, compression et codage

- Product managers qui doivent arbitrer qualité, latence, bande passante et coûts

- Ingénieurs travaillant sur réseaux, codecs médias, stockage, télémétrie ou pipelines de données ML

Pour aller plus loin, parcourez les explications liées dans /blog, puis consultez /docs pour voir comment notre produit expose les réglages et APIs liés à la communication et à la compression. Si vous comparez des offres ou des limites de débit, /pricing est la prochaine étape.