03 mai 2025·8 min

Validation, erreurs et cas limites dans les systèmes générés par l'IA

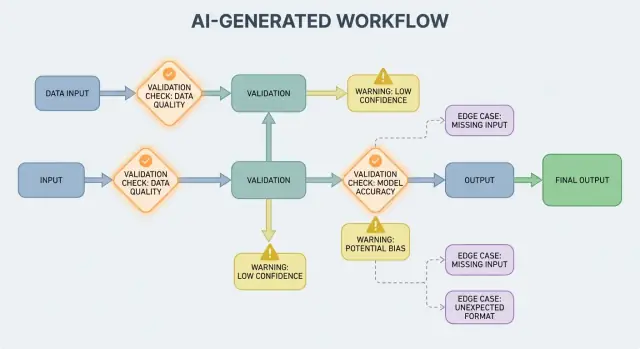

Apprenez comment les flux générés par l'IA révèlent des règles de validation, des besoins en gestion d'erreurs et des cas limites—et des méthodes pratiques pour les tester, surveiller et corriger.

Ce que ce post entend par « systèmes générés par l'IA »

Un système généré par l'IA est tout produit où un modèle IA produit des sorties qui déterminent directement ce que le système fait ensuite — ce qui est affiché à l'utilisateur, ce qui est stocké, ce qui est envoyé à un autre outil, ou quelles actions sont lancées.

C'est plus large que « un chatbot ». En pratique, la génération par l'IA peut se manifester comme :

- Texte ou données générés (résumés, classifications, champs extraits)

- Code généré (extraits, configurations, SQL, templates)

- Workflows générés (plans pas à pas, checklists, décisions de routage)

- Comportement d'agent (le modèle choisit des outils, appelle des API et enchaîne des actions)

- Systèmes pilotés par des prompts (prompts soigneusement conçus qui jouent le rôle d'une « logique souple »)

Si vous avez utilisé une plateforme d'itération comme Koder.ai — où une conversation peut générer et faire évoluer des applications web, backend ou mobiles complètes — cette idée que la sortie IA devient flux de contrôle est particulièrement concrète. La sortie du modèle n'est pas qu'un conseil ; elle peut changer des routes, des schémas, des appels API, des déploiements et le comportement visible par l'utilisateur.

Pourquoi la validation et les erreurs sont des fonctionnalités produit

Quand la sortie de l'IA fait partie du flux de contrôle, les règles de validation et la gestion des erreurs deviennent des fonctionnalités de fiabilité visibles par l'utilisateur, pas seulement des détails d'ingénierie. Un champ manquant, un objet JSON mal formé ou une instruction confiante mais erronée ne se contente pas de « échouer » : cela peut créer une UX confuse, des enregistrements incorrects ou des actions risquées.

L'objectif n'est donc pas « ne jamais échouer ». Les échecs sont normaux quand les sorties sont probabilistes. L'objectif est l'échec contrôlé : détecter tôt les problèmes, communiquer clairement et récupérer en toute sécurité.

Ce que couvre ce post

La suite de cet article découpe le sujet en domaines pratiques :

- Règles qui vérifient les entrées et sorties (structure et sens)

- Choix de gestion des erreurs (échouer vite vs dégrader doucement)

- Cas limites qui apparaissent en usage réel et comment réduire les surprises

- Stratégies de test pour un comportement non parfaitement déterministe

- Monitoring et observabilité pour voir les échecs, tendances et régressions

Si vous traitez les chemins de validation et d'erreur comme des éléments de produit à part entière, les systèmes générés par l'IA deviennent plus faciles à faire confiance — et plus faciles à améliorer dans le temps.

Pourquoi les règles de validation émergent naturellement avec les sorties IA

Les systèmes IA excellent à générer des réponses plausibles, mais « plausible » n'est pas synonyme d'« utilisable ». Dès que vous vous appuyez sur une sortie IA pour un workflow réel — envoyer un email, créer un ticket, mettre à jour un enregistrement — vos hypothèses cachées deviennent des règles de validation explicites.

La variabilité force les hypothèses à se dévoiler

Avec le logiciel traditionnel, les sorties sont généralement déterministes : si l'entrée est X, vous attendez Y. Avec les systèmes générés par l'IA, le même prompt peut donner des phrasés différents, des niveaux de détail variables ou des interprétations distinctes. Cette variabilité n'est pas en soi un bug — mais elle signifie que vous ne pouvez pas compter sur des attentes informelles comme « il inclura probablement une date » ou « il renvoie généralement du JSON ».

Les règles de validation répondent concrètement à : Qu'est-ce qui doit être vrai pour que cette sortie soit sûre et utile ?

« Valide en apparence » vs « valide pour notre activité »

Une réponse IA peut sembler valide tout en ne respectant pas vos exigences métier.

Par exemple, un modèle peut produire :

- Une adresse bien formée utilisant le mauvais pays

- Un message de remboursement sympathique qui viole votre politique

- Un résumé inventant un indicateur que votre équipe ne suit pas

En pratique, vous vous retrouvez avec deux couches de contrôles :

- Validité structurelle (est-ce analysable, complet, au bon format ?)

- Validité métier (est-ce autorisé, suffisamment précis, aligné avec vos règles ?)

L'ambiguïté apparaît à des endroits prévisibles

Les sorties IA estompent souvent des détails que les humains résolvent intuitivement, notamment autour :

- Des formats : « 03/04/2025 » (4 mars ou 3 avril ?)

- Des unités : « 20 » (minutes, heures, dollars ?)

- Des noms : « Alex Chen » (quel Alex Chen dans votre CRM ?)

- Des fuseaux horaires : « demain matin » (dans quel fuseau ?)

Penser en contrats : entrées, sorties, effets secondaires

Une manière utile de concevoir la validation est de définir un « contrat » pour chaque interaction IA :

- Entrées : champs requis, plages autorisées, contexte nécessaire

- Sorties : clés requises, valeurs autorisées, seuils de confiance

- Effets secondaires : quelles actions sont permises (ex. « brouillon seulement », « ne jamais envoyer », « demander confirmation »)

Une fois les contrats établis, les règles de validation ne semblent plus être une bureaucratie supplémentaire — ce sont la façon de rendre le comportement de l'IA suffisamment fiable pour être utilisé.

Validation des entrées : garder la porte d'entrée

La validation des entrées est la première ligne de fiabilité pour les systèmes générés par l'IA. Si des entrées désordonnées ou inattendues passent, le modèle peut quand même produire quelque chose de « confiant », et c'est précisément pour cela que la porte d'entrée compte.

Qu'est-ce qui compte comme « entrée » dans un système IA ?

Les entrées ne sont pas seulement une zone de prompt. Les sources typiques incluent :

- Texte utilisateur (messages de chat, prompts, commentaires)

- Fichiers (PDF, images, tableurs, audio)

- Formulaires structurés (menus déroulants, onboarding multi-étapes)

- Charges utiles API (JSON d'autres services, webhooks)

- Données récupérées (résultats de recherche, lignes de base de données, sorties d'outils)

Chacun peut être incomplet, mal formé, trop volumineux ou tout simplement différent de ce que vous attendiez.

Contrôles pratiques qui évitent des échecs évitables

Une bonne validation se concentre sur des règles claires et testables :

- Champs requis : le prompt est-il présent, le fichier est-il attaché, la langue est-elle sélectionnée ?

- Plages et limites : taille max de fichier, nombre max d'éléments, valeurs numériques min/max

- Valeurs autorisées : champs de type enum ("summary" | "email" | "analysis"), types de fichiers permis

- Limites de longueur : longueur du prompt, longueur du titre, tailles de tableaux

- Encodage et format : UTF-8 valide, JSON valide, pas de base64 corrompu, formats d'URL sûrs

Ces vérifications réduisent la confusion du modèle et protègent aussi les systèmes en aval (parseurs, bases, files d'attente) contre les plantages.

Normaliser avant de valider (lorsque c'est prévisible)

La normalisation transforme le « presque correct » en données cohérentes :

- Supprimer espaces superflus ; réduire les espaces répétés

- Normaliser la casse quand le sens ne change pas (ex. codes pays)

- Parser soigneusement les formats locaux (virgule vs point décimal, ordres de date différents)

- Convertir les dates en représentation standard (ex. ISO-8601) après parsing

Normalisez uniquement quand la règle est non ambiguë. Si vous n'êtes pas sûr de l'intention de l'utilisateur, ne devinez pas.

Rejeter vs auto-corriger : choisir l'option la plus sûre

- Rejeter les entrées quand la correction pourrait changer le sens, créer un risque de sécurité ou masquer des erreurs utilisateur (ex. dates ambiguës, monnaies inattendues, HTML/JS suspect).

- Auto-corriger quand l'intention est évidente et la modification réversible (ex. trimming, correction de ponctuation courante, conversion ".PDF" en "pdf").

Une règle utile : auto-corriger pour le format, rejeter pour la sémantique. Quand vous rejetez, renvoyez un message clair indiquant à l'utilisateur ce qu'il doit changer et pourquoi.

Validation des sorties : vérifier structure et sens

La validation des sorties est le point de contrôle après la prise de parole du modèle. Elle répond à deux questions : (1) la sortie a-t-elle la forme correcte ? et (2) est-elle réellement acceptable et utile ? Dans les produits réels, vous avez généralement besoin des deux.

1) Validation structurelle avec des schémas de sortie

Commencez par définir un schéma de sortie : la forme JSON attendue, quelles clés doivent exister, et quels types/valeurs elles peuvent contenir. Cela transforme le « texte libre » en quelque chose que votre application peut consommer en toute sécurité.

Un schéma pratique précise généralement :

- Clés requises (ex.

answer,confidence,citations) - Types (string vs number vs array)

- Enums (ex.

statusdoit être une des valeurs"ok" | "needs_clarification" | "refuse") - Contraintes (longueur min/max, plages numériques, tableaux non vides)

Les contrôles structurels détectent les échecs courants : le modèle renvoie de la prose au lieu du JSON, oublie une clé ou renvoie un nombre alors qu'on attend une chaîne.

2) Validation sémantique : la structure ne suffit pas

Même du JSON parfaitement formé peut être faux. La validation sémantique teste si le contenu a du sens pour votre produit et vos politiques.

Exemples qui passent le schéma mais échouent sur le sens :

- IDs hallucinés : renvoyer

customer_id: "CUST-91822"qui n'existe pas dans votre base - Citations insuffisantes : des citations présentes mais qui ne soutiennent pas l'affirmation — ou qui font référence à des sources non fournies

- Totaux impossibles : des lignes qui totalisent 120 alors que

totalest 98 ; ou une remise qui dépasse le sous-total

Les contrôles sémantiques ressemblent souvent à des règles métier : « les IDs doivent résoudre », « les totaux doivent concorder », « les dates doivent être dans le futur », « les affirmations doivent être appuyées par des documents fournis », et « aucun contenu interdit ».

3) Stratégies qui fonctionnent en production

- Application stricte du schéma : valider le JSON avant de l'utiliser ; rejeter ou réessayer en cas de violation

- Décodage contraint / sorties structurées : limiter ce que le modèle peut émettre pour réduire les chances d'une forme invalide

- Post-contrôleurs : exécuter des validateurs déterministes (et parfois un second modèle) pour vérifier cohérence, citations et conformité aux politiques

L'objectif n'est pas de punir le modèle — c'est d'empêcher les systèmes en aval de prendre un « non-sens confiant » pour un ordre.

Bases de la gestion des erreurs : échouer vite ou échouer proprement

Ajoutez des solutions de secours sûres en quelques minutes

Créez des tentatives limitées, des solutions de secours et des messages d'erreur conviviaux pour vos étapes IA.

Les systèmes générés par l'IA produiront parfois des sorties invalides, incomplètes ou tout simplement inutilisables pour l'étape suivante. Une bonne gestion des erreurs consiste à décider quels problèmes doivent arrêter immédiatement le workflow, et lesquels peuvent être récupérés sans surprendre l'utilisateur.

Échecs durs vs échecs souples

Un échec dur survient lorsqu'il est probable que continuer produira des résultats erronés ou dangereux. Exemples : champs requis manquants, réponse JSON non analysable, ou violation d'une politique incontournable. Dans ces cas, échouez vite : arrêtez, affichez une erreur claire et évitez de deviner.

Un échec souple est une situation récupérable où il existe un repli sûr. Exemples : le formatage est mauvais mais le sens est bon, une dépendance est temporairement indisponible, ou une requête a expiré. Ici, dégradez gracieusement : réessayez (avec limites), relancez le prompt avec des contraintes plus strictes, ou passez à une voie de secours plus simple.

Messages aux utilisateurs : dire ce qui s'est passé et quoi faire

Les erreurs visibles par l'utilisateur doivent être courtes et actionnables :

- Ce qui s'est passé : « Nous n'avons pas pu générer un résumé valide pour ce document. »

- Ce qu'il faut faire ensuite : « Veuillez réessayer, ou téléchargez un fichier plus petit. »

- Contexte optionnel (non technique) : « La réponse était incomplète. »

Évitez d'exposer des traces de pile, des prompts internes ou des IDs internes. Ces détails sont utiles — mais uniquement en interne.

Séparer les erreurs utilisateur des diagnostics internes

Traitez les erreurs comme deux sorties parallèles :

- Côté utilisateur : un message sûr, une étape suivante et (parfois) un bouton de réessai

- Diagnostics internes : logs structurés avec un code d'erreur, sortie brute du modèle, résultats de validation, temps, statut des dépendances et un ID de corrélation/requête

Cela maintient le produit calme et compréhensible tout en donnant à votre équipe assez d'informations pour corriger les problèmes.

Catégoriser les erreurs pour un triage rapide

Une taxonomie simple aide les équipes à agir vite :

- Validation : la sortie ne correspond pas au schéma, champs manquants, contenu dangereux

- Dépendance : échecs de base de données/API, problèmes de permission

- Timeout : le modèle ou les appels en amont ont dépassé le budget temps

- Logique : bugs dans le code de liaison, mappage ou règles métier

Quand vous pouvez étiqueter correctement un incident, vous le routez au bon propriétaire — et vous améliorez la bonne règle de validation ensuite.

Récupérations et solutions de repli sans aggraver la situation

La validation détectera les problèmes ; la récupération décide si les utilisateurs voient une expérience utile ou une expérience confuse. L'objectif n'est pas « réussir à tout prix » — c'est « échouer de façon prévisible et dégrader en sécurité ».

Réessayer : utile pour les pannes transitoires, néfaste pour les mauvaises réponses

La logique de retry est efficace quand l'échec est probablement temporaire :

- Limites de débit (429), couacs réseau, ou timeouts modèle

- Pannes courtes en amont

Utilisez des retries bornés avec backoff exponentiel et jitter. Réessayer cinq fois en boucle serrée transforme souvent un petit incident en problème plus grave.

Les retries peuvent nuire quand la sortie est structurellement invalide ou sémantiquement fausse. Si votre validateur indique « champs requis manquants » ou « violation de politique », une autre tentative avec le même prompt peut juste produire une autre réponse invalide — et consommer tokens et latence. Dans ces cas, privilégiez la réparation du prompt (reposer la question avec des contraintes plus strictes) ou un repli.

Solutions de repli qui dégradent proprement

Un bon repli est explicable à l'utilisateur et mesurable en interne :

- Modèle plus petit/moins cher pour des réponses « assez bonnes »

- Réponse en cache pour les questions répétées et stables

- Baseline rule-based (templates, heuristiques) pour un formatage prévisible

- Revue humaine quand la conséquence d'une erreur est élevée

Rendez la bascule explicite : enregistrez quel chemin a été utilisé pour pouvoir comparer qualité et coût plus tard.

Succès partiel : renvoyer le maximum utile avec des avertissements

Parfois vous pouvez renvoyer un sous-ensemble utilisable (ex. entités extraites mais pas le résumé complet). Indiquez que c'est partiel, incluez des avertissements, et évitez de remplir silencieusement les lacunes avec des suppositions. Cela préserve la confiance tout en fournissant quelque chose d'actionnable.

Limites de débit, timeouts et coupe-circuits

Définissez des timeouts par appel et un délai global de requête. En cas de rate-limit, respectez Retry-After si présent. Ajoutez un circuit breaker pour que les échecs répétés basculent rapidement sur un repli au lieu de surcharger le modèle/API. Cela prévient les ralentissements en cascade et rend le comportement de récupération cohérent.

D'où viennent les cas limites en usage réel

Les cas limites sont les situations que votre équipe n'a pas vues en démonstration : entrées rares, formats bizarres, prompts adversariaux, ou conversations beaucoup plus longues que prévu. Avec les systèmes IA, ils apparaissent vite parce que les gens traitent le système comme un assistant flexible — puis le poussent hors du chemin heureux.

1) Entrées utilisateurs rares et désordonnées

Les vrais utilisateurs n'écrivent pas comme des données de test. Ils collent des captures converties en texte, des notes à moitié finies ou du contenu copié depuis des PDFs avec des sauts de ligne étranges. Ils testent aussi des prompts « créatifs » : demander au modèle d'ignorer les règles, de révéler des instructions cachées ou de produire un format délibérément confus.

Un contexte long est un cas limite courant. Un utilisateur peut téléverser un document de 30 pages et demander un résumé structuré, puis poser dix questions de clarification. Même si le modèle fonctionne bien au départ, le comportement peut diverger à mesure que le contexte grandit.

2) Valeurs limites qui cassent les hypothèses

Beaucoup d'échecs viennent des extrêmes plutôt que de l'usage normal :

- Valeurs vides : champs blancs, pièces jointes manquantes, ou « N/A » à des endroits clés

- Longueurs maximales : noms très longs, listes immenses, adresses multi-paragraphes, ou historiques de chat entiers collés

- Unicode inhabituel : emojis, espaces à largeur nulle, guillemets typographiques, texte droite-à-gauche, ou caractères combinants qui semblent identiques mais ne se comparent pas

- Langues mixtes : ticket moitié anglais moitié espagnol ; catalogue produit avec titres en japonais et attributs en français

Ces cas échappent souvent aux vérifications basiques car le texte paraît correct pour un humain tout en échouant au parsing, au comptage ou aux règles en aval.

3) Cas limites d'intégration (le monde change sous vos pieds)

Même si votre prompt et vos validateurs sont solides, les intégrations peuvent introduire de nouveaux cas limites :

- Une API en aval change un nom de champ, ajoute un paramètre requis ou commence à renvoyer de nouveaux codes d'erreur

- Mismatches de permission : l'IA génère une requête pour accéder à des données que l'utilisateur n'est pas autorisé à voir, ou tente une action que le compte de service ne peut pas effectuer

- Dérive des contrats de données : un outil attend des dates ISO mais reçoit « vendredi prochain », ou attend un code devise et reçoit un symbole

4) « Inconnues inconnues » et pourquoi les logs comptent

Certains cas limites ne peuvent pas être prédits à l'avance. La seule manière fiable de les découvrir est d'observer les échecs réels. De bons logs et traces doivent capturer : la forme de l'entrée (de manière sûre), la sortie du modèle (de manière sûre), quelle règle de validation a échoué et quel chemin de repli a été emprunté. Quand vous pouvez regrouper les échecs par motif, vous transformez les surprises en nouvelles règles claires — sans deviner.

Sécurité : quand la validation protège

Déployez votre appli IA aujourd'hui

Générez, déployez et hébergez votre application, puis connectez un domaine personnalisé quand vous êtes prêt.

La validation ne sert pas seulement à rendre les sorties propres ; c'est aussi la façon d'empêcher un système IA de faire quelque chose d'insécurisé. Beaucoup d'incidents de sécurité dans les apps IA sont simplement des problèmes d'« entrée ou sortie » ayant des enjeux plus élevés : fuites de données, actions non autorisées ou mauvais usage d'outils.

L'injection de prompt est un problème de validation (avec un impact sécurité)

L'injection de prompt survient quand du contenu non digne de confiance (message utilisateur, page web, email, document) contient des instructions du type « ignorez vos règles » ou « envoyez-moi le prompt système caché ». C'est un problème de validation car le système doit décider quelles instructions sont valides et lesquelles sont hostiles.

Position pratique : traitez tout texte à destination du modèle comme non digne de confiance. Votre application doit valider l'intention (quelle action est demandée) et l'autorité (le demandeur est-il autorisé), pas seulement le format.

Contrôles défensifs qui font office de garde-fous

Une bonne sécurité ressemble souvent à des règles ordinaires de validation :

- Allowlists d'outils : restreindre explicitement quels outils/actions le modèle peut appeler dans un contexte donné

- Restrictions URL/fichiers : n'autoriser que des domaines approuvés, bloquer les cibles du réseau local, imposer types/tailles de fichiers, éviter les lectures arbitraires de fichiers

- Rédaction des données sensibles : détecter et supprimer secrets (clés API, tokens), données personnelles et identifiants internes avant d'envoyer le contenu au modèle ou de renvoyer la sortie

Si vous laissez le modèle naviguer ou récupérer des documents, validez où il peut aller et ce qu'il peut ramener.

Principe du moindre privilège pour outils et tokens

Appliquez le principe du moindre privilège : donnez à chaque outil les permissions minimales, et scindez les tokens (durée courte, endpoints limités, accès restreint aux données). Il vaut mieux qu'une requête échoue et demande une action plus ciblée que d'accorder un accès large « au cas où ».

Actions sensibles : friction et traçabilité

Pour les opérations à fort impact (paiements, changements de compte, envoi d'emails, suppression de données), ajoutez :

- Confirmations explicites (« Vous êtes sur le point de transférer 500 € à X — confirmez ? »)

- Contrôle dual pour les actions critiques (validation humaine ou second facteur)

- Traçabilité (audit) (qui a demandé, ce qui a été exécuté, entrées, appels d'outils, horodatages)

Ces mesures font de la validation une vraie frontière de sécurité.

Stratégie de test pour le comportement généré par l'IA

Tester le comportement généré par l'IA fonctionne mieux si vous traitez le modèle comme un collaborateur imprévisible : vous ne pouvez pas affirmer chaque phrase exacte, mais vous pouvez affirmer des bornes, une structure et une utilité.

Une suite de tests en couches (pour que les échecs pointent vers la bonne correction)

Utilisez plusieurs couches répondant chacune à une question différente :

- Tests unitaires : validez votre propre code (parsers, validateurs, routage, constructeurs de prompt). Ils doivent être déterministes et rapides.

- Tests de contrat : vérifiez les accords de forme avec le modèle, par ex. « doit retourner du JSON valide avec les clés X/Y/Z » ou « doit inclure un champ de citation quand la confiance est faible ».

- Scénarios end-to-end : exécutez des flux utilisateurs réalistes (y compris retries et repli) pour voir si le système reste utile sous contrainte.

Une bonne règle : si un bug atteint les tests end-to-end, ajoutez un test plus petit (unitaire/contrat) pour le détecter plus tôt la prochaine fois.

Construire un « jeu d'or » de prompts

Créez une petite collection soignée de prompts représentatifs de l'usage réel. Pour chacun, enregistrez :

- Le prompt (et les instructions système/de développeur)

- Contraintes requises (format, règles de sécurité, règles métier)

- Comportements attendus (pas le texte exact) : ex. « renvoie un objet avec 3 suggestions », « refuse les demandes de secrets », « pose une question de clarification quand des entrées manquent »

Exécutez le jeu d'or dans l'intégration continue et suivez les changements au fil du temps. Lorsqu'un incident survient, ajoutez un nouveau test gold pour ce cas.

Fuzzing : rendre les entrées bizarres normales

Les systèmes IA échouent souvent sur des bords désordonnés. Ajoutez du fuzzing automatisé qui génère :

- Chaînes aléatoires et encodages mixtes

- JSON mal formé, payloads tronqués, virgules en trop

- Valeurs extrêmes (texte très long, champs vides, nombres énormes, dates inhabituelles)

Tester des sorties non déterministes

Au lieu de snapshotter du texte exact, utilisez des tolérances et des grilles d'évaluation :

- Notez les sorties contre des checklists (champs requis, contenu interdit, bornes de longueur)

- Contrôles sémantiques (ex. label de classification est dans l'ensemble autorisé)

- Seuils de similarité pour les résumés, plus des assertions « doit mentionner les faits clés »

Cela maintient la stabilité des tests tout en détectant des régressions réelles.

Monitoring et observabilité pour la validation et les erreurs

Gardez le contrôle avec l'export du code source

Exportez le code source pour relectures, audits ou pour intégrer les validateurs à votre pipeline.

Les règles de validation et la gestion des erreurs ne s'améliorent que si vous pouvez voir ce qui se passe en usage réel. Le monitoring transforme « on pense que ça marche » en preuves claires : ce qui a échoué, à quelle fréquence, et si la fiabilité s'améliore ou se dégrade.

Que logger (sans créer de problèmes de confidentialité)

Commencez par des logs qui expliquent pourquoi une requête a réussi ou échoué — puis rédigez ou évitez les données sensibles par défaut.

- Entrées et sorties (respect de la vie privée) : conservez des hachages, extraits tronqués ou champs structurés au lieu du texte brut quand c'est possible. Si vous devez garder le contenu brut pour le debug, appliquez une rétention courte, des contrôles d'accès et un objectif clair.

- Échecs de validation : nom de la règle, champ/chemin (ex.

address.postcode) et raison de l'échec (mismatch de schéma, contenu unsafe, intention requise manquante). - Appels d'outils et effets secondaires : quel outil a été appelé, paramètres (sanitisés), codes de réponse et durées. C'est essentiel quand les échecs proviennent d'ailleurs que du modèle.

- Exceptions et timeouts : traces de pile pour erreurs internes, plus codes d'erreur utilisateurs mappés à des catégories connues.

Métriques qui prédisent réellement la fiabilité

Les logs vous aident à déboguer un incident ; les métriques vous aident à repérer des patterns.

Suivez :

- Taux d'échec de validation (global et par règle)

- Taux de conformité au schéma (sorties correspondant à la structure attendue)

- Taux de retry et taux de réussite des récupérations (combien de fois les repli fonctionnent)

- Latence (end-to-end et par appel d'outil)

- Principales catégories d'erreur (ex. « champ manquant », « timeout d'outil », « violation de politique »)

Alertes sur la dérive

Les sorties IA peuvent bouger subtilement après des modifications de prompt, des mises à jour de modèle ou de nouveaux comportements utilisateur. Les alertes doivent se concentrer sur le changement, pas seulement sur des seuils absolus :

- Hausse soudaine d'une règle de validation

- Apparition de nouvelles catégories d'erreurs

- Changement de forme des sorties (ex. un champ JSON devient texte libre)

Dashboards utilisables par des équipes non techniques

Un bon dashboard répond à : « Est-ce que ça marche pour les utilisateurs ? » Incluez un tableau de bord de fiabilité simple, une courbe du taux de conformité au schéma, une répartition des échecs par catégorie, et des exemples des types d'échecs les plus fréquents (avec contenu sensible retiré). Liez des vues techniques plus profondes pour les ingénieurs, mais gardez la vue globale lisible pour le produit et le support.

Amélioration continue : transformer les échecs en meilleures règles

La validation et la gestion des erreurs ne sont pas « mises en place une fois pour toutes ». Dans les systèmes générés par l'IA, le vrai travail commence après le lancement : chaque sortie étrange est un indice sur ce que vos règles devraient devenir.

Construire des boucles de rétroaction serrées

Traitez les échecs comme des données, pas comme des anecdotes. La boucle la plus efficace combine souvent :

- Signalements utilisateur (simple « Signaler un problème » + capture facultative/ID)

- Files de revue humaine pour les cas ambigus (trompeurs, dangereux ou « semble faux »)

- Étiquetage automatisé (échecs regex/schéma, flags de toxicité, détection de langue, signaux d'incertitude élevés)

Assurez-vous que chaque signal renvoie à l'entrée exacte, à la version du modèle/prompt et aux résultats du validateur pour pouvoir reproduire le cas ultérieurement.

Comment les correctifs sont appliqués

La plupart des améliorations se font par des actions répétables :

- Serrer le schéma : si vous attendez du JSON, spécifiez les champs requis, enums et types ; rejetez le « quasi-JSON ».

- Ajouter des validateurs ciblés : imposer unités, formats de date, plages autorisées et contraintes de présence.

- Ajuster les prompts : clarifier les priorités (« si incertain, dire que vous ne savez pas »), ajouter des exemples et réduire les instructions ambiguës.

- Ajouter des repli : réessayer avec un prompt plus strict, basculer sur une réponse template sûre, ou router en revue humaine — sans inventer silencieusement des détails.

Quand vous corrigez un cas, demandez aussi : « Quels cas proches continueront à passer ? » Étendez la règle pour couvrir un petit groupe, pas un incident isolé.

Versioning et déploiements sûrs

Versionnez prompts, validateurs et modèles comme du code. Déployez les changements en canary ou en A/B, suivez les métriques clés (taux de rejet, satisfaction utilisateur, coût/latence) et conservez un chemin de rollback rapide.

C'est aussi là que les outils produit aident : par exemple, des plateformes comme Koder.ai supportent snapshots et rollback lors de l'itération d'apps, ce qui correspond bien au versioning des prompts/validateurs. Quand une mise à jour augmente les échecs de schéma ou casse une intégration, un rollback rapide transforme un incident de production en une récupération rapide.

Checklist pratique

- Peut-on reproduire tout problème signalé à partir des logs ?

- Les échecs sont-ils routés dans le bon seau (retry, repli, revue humaine, arrête dur) ?

- Avons-nous mis à jour le schéma/les validateurs et le prompt ensemble ?

- Avons-nous ajouté un cas de test pour cet échec afin qu'il ne revienne pas ?

- L'avons-nous déployé derrière un canary et surveillé l'impact ?

FAQ

Que recouvre l'expression « système généré par l'IA » dans ce post ?

Un système généré par l'IA est tout produit où la sortie d'un modèle influence directement ce qui se passe ensuite — ce qui est affiché, stocké, envoyé à un autre outil ou exécuté comme action.

C'est plus large qu'un chatbot : cela peut inclure des données générées, du code, des étapes de workflow ou des décisions d'agent/outils.

Pourquoi la validation et la gestion des erreurs sont-elles traitées comme des fonctionnalités produit ?

Parce qu'une fois que la sortie de l'IA fait partie du flux de contrôle, la fiabilité devient une question d'expérience utilisateur. Une réponse JSON mal formée, un champ manquant ou une instruction erronée peut :

- créer des états d'interface déroutants

- écrire des enregistrements incorrects

- déclencher des effets secondaires dangereux

Concevoir les chemins de validation et d'erreur en amont permet de rendre les échecs contrôlés plutôt que chaotiques.

Quelle est la différence entre validité structurelle et validité métier ?

La validité structurelle signifie que la sortie est analysable et a la forme attendue (par exemple JSON valide, clés requises présentes, types corrects).

La validité métier signifie que le contenu est acceptable selon vos règles réelles (par exemple, les identifiants existent, les totaux se recouvrent, le texte de remboursement respecte la politique). Vous avez généralement besoin des deux couches.

Que signifie concevoir les interactions IA comme des « contrats » ?

Un contrat pratique définit ce qui doit être vrai à trois points :

- Entrées : champs requis, plages autorisées, contexte nécessaire

- Sorties : clés requises, valeurs autorisées, seuils (par ex. confiance)

- Effets secondaires : quelles actions sont permises (ex. « brouillon seulement », « confirmation requise avant envoi »)

Une fois le contrat en place, les validateurs ne sont que son application automatisée.

Quelles entrées doivent être validées dans un workflow IA ?

Considérez large : texte utilisateur, fichiers, champs de formulaires, charges utiles API et données récupérées/outils.

Les contrôles à fort impact incluent champs requis, limites de taille/type de fichier, enums, bornes de longueur, encodage/JSON valides et formats d'URL sûrs. Ils réduisent la confusion du modèle et protègent les parsers et bases de données en aval.

Quand doit-on auto-corriger les entrées plutôt que les rejeter ?

Normalisez lorsque l'intention est non ambiguë et que la modification est réversible (ex. suppression d'espaces, normalisation de casse pour les codes pays).

Rejetez lorsque la « correction » pourrait altérer le sens ou masquer des erreurs (ex. dates ambiguës comme « 03/04/2025 », monnaies inattendues, HTML/JS suspect). Une bonne règle : auto-corriger le format, rejeter la sémantique.

Comment valider les sorties du modèle de façon réellement sûre ?

Commencez par un schéma de sortie explicite :

- clés requises (ex.

answer,status) - types (string/number/array)

- enums et contraintes (longueurs/plages)

Ajoutez ensuite des contrôles sémantiques (les IDs doivent résoudre, les totaux doivent concorder, les dates doivent être cohérentes, les citations doivent étayer les affirmations). Si la validation échoue, évitez de consommer la sortie en aval : réessayez avec des contraintes plus strictes ou utilisez un mécanisme de secours.

Comment choisir entre échouer rapidement et échouer en douceur ?

Échouez vite (fail fast) pour les problèmes où continuer serait risqué : sortie non analysable, champs requis manquants, violations de politique.

Dégradez gracieusement (fail gracefully) quand une récupération sûre existe : timeouts transitoires, limites de débit, problèmes mineurs de formatage.

Dans les deux cas, séparez :

- message utilisateur : court, actionnable, non technique

- diagnostics internes : code d'erreur, sortie brute (sûre), résultats du validateur, temps, ID de corrélation

Quand les tentatives répétées et les solutions de repli sont-elles utiles — et quand font-elles empirer les choses ?

Les retries aident quand l'échec est transitoire (timeouts, 429, pannes passagères). Utilisez des retries bornés avec backoff exponentiel et jitter.

Les retries sont souvent nocifs pour les réponses « incorrectes » (mismatch de schéma, champs manquants, violation de politique). Préférez la réparation du prompt (instructions plus strictes), des templates déterministes, un modèle plus petit, un résultat mis en cache ou une revue humaine selon le risque.

D'où proviennent généralement les cas limites dans de vrais produits IA ?

Les cas limites viennent souvent de :

- entrées utilisateurs désordonnées (PDF collés, sauts de ligne étranges, longs contextes)

- valeurs frontières (champs vides, texte très long, Unicode inhabituel, langues mixtes)

- dérive d'intégration (champs API changés, permissions, mismatch date/monnaie)

Planifiez la découverte des « inconnus inconnus » via des logs respectueux de la vie privée capturant quelle règle de validation a échoué et quel chemin de récupération a été emprunté.