Ce que Khosla entend par « l’IA remplacera les médecins »

Quand Vinod Khosla dit « l’IA remplacera les médecins », il ne décrit généralement pas un hôpital de science‑fiction sans humains. Il formule une affirmation plus précise et opérationnelle : de nombreuses tâches qui occupent aujourd’hui le temps des médecins — en particulier les travaux riches en information — peuvent être effectuées par des logiciels plus rapides, moins chers et de plus en plus précis.

L’ampleur : remplacer des tâches, pas l’empathie

Dans le cadrage de Khosla, « remplacer » signifie souvent substituer une large part de ce que les médecins font au quotidien, pas effacer la profession. Pensez aux parties répétitives des soins : recueillir les symptômes, vérifier les guides, classer les diagnostics probables, recommander les examens suivants, surveiller les maladies chroniques et signaler les risques précocement.

C’est pourquoi l’idée est plus « pro‑automatisation » que « anti‑médecin ». Le pari sous‑jacent est que la santé regorge de motifs — et que la reconnaissance de motifs à grande échelle est le domaine où l’IA excelle souvent.

Ce que cet article vise

Ce texte traite l’affirmation comme une hypothèse à évaluer, pas comme un slogan à applaudir ou à rejeter. Nous examinerons le raisonnement qui la sous‑tend, les types de produits de santé qui s’y alignent, et les contraintes réelles : réglementation, sécurité, responsabilité et la dimension humaine de la médecine.

Termes clés que nous utiliserons

- Remplacer : l’IA exécute une tâche de bout en bout avec une implication minimale du clinicien.

- Augmenter : l’IA assiste, mais un clinicien reste le décideur.

- Clinicien : un professionnel autorisé (médecin, infirmier praticien, assistant médical) fournissant des soins.

- Diagnostic : pas seulement nommer une maladie, mais formuler une explication pondérée par probabilités et choisir les actions suivantes (examens, traitement, suivi).

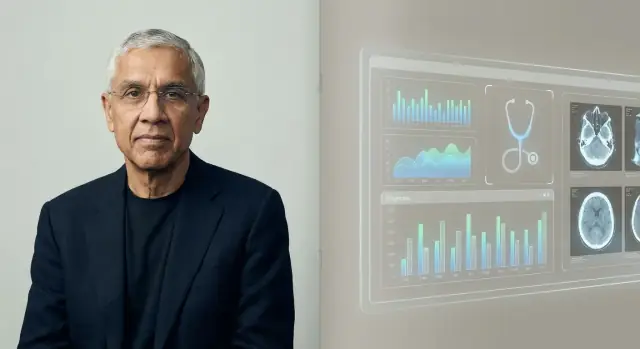

Qui est Vinod Khosla, et pourquoi son point de vue compte

Un rapide rappel factuel

Vinod Khosla est un entrepreneur et investisseur de la Silicon Valley, surtout connu pour avoir cofondé Sun Microsystems dans les années 1980 puis pour sa longue carrière en capital‑risque. Après un passage chez Kleiner Perkins, il a créé Khosla Ventures en 2004.

Ce mélange d’expérience d’opérateur et de décennies d’investissement aide à expliquer pourquoi ses propos sur l’IA et la santé sont relayés bien au‑delà des cercles tech.

Le « style » de Khosla Ventures en clair

Khosla Ventures a la réputation de soutenir de gros paris à forte conviction qui peuvent sembler déraisonnables au départ. Le fonds met souvent l’accent sur :

- des thèses contrariennes (idées que beaucoup d’experts rejettent au début)

- des ruptures de plateforme (technologies qui refaçonnent plusieurs industries)

- des horizons temporels longs (prêt à attendre réglementation, adoption ou infrastructures)

Cela compte parce que des prédictions comme « l’IA remplacera les médecins » ne sont pas que rhétorique — elles influencent quels startups sont financées, quels produits sont construits et quelles narrations les conseils d’administration prennent au sérieux.

Pourquoi la santé est devenue une cible majeure pour ces paris

La santé est une des plus grandes et coûteuses parties de l’économie, et elle est remplie de signaux dont l’IA peut potentiellement tirer parti : images, analyses, notes, données de capteurs et résultats. Même des améliorations modestes en précision, vitesse ou coût peuvent se traduire par des économies et des gains d’accès significatifs.

Khosla et son fonds ont à plusieurs reprises soutenu que la médecine est mûre pour un changement piloté par le logiciel — notamment dans le triage, le support au diagnostic et l’automatisation des flux de travail. Que vous adhériez ou non au cadrage « remplacement », son point de vue compte parce qu’il reflète la façon dont une part importante du capital‑risque évalue l’avenir de la médecine — et où l’argent ira ensuite.

La logique derrière la prédiction

La prédiction de Khosla repose sur une affirmation simple : une grande part de la médecine — surtout les soins primaires et le triage initial — est de la reconnaissance de motifs dans l’incertitude. Si le diagnostic et le choix du traitement consistent souvent à « associer cette présentation à ce qui est le plus probable », alors un logiciel entraîné sur des millions d’exemples devrait finir par surpasser des cliniciens individuels qui apprennent à partir de milliers.

Reconnaissance de motifs à l’échelle

Les humains excellent pour repérer des motifs, mais nous sommes limités par la mémoire, l’attention et l’expérience. Un système d’IA peut ingérer beaucoup plus de cas, de guides et de résultats que ce qu’un médecin rencontre dans une carrière, puis appliquer cet appariement de façon cohérente. Dans le cadrage de Khosla, une fois que le taux d’erreur du système descend en‑dessous de la moyenne des cliniciens, le choix rationnel pour patients et payeurs est d’orienter les décisions routinières vers la machine.

Coût, accès et constance

L’économie est l’autre moteur puissant. La médecine primaire est limitée par le temps, la géographie et les pénuries de personnel ; les consultations peuvent être coûteuses, brèves et variables en qualité. Un service IA peut être disponible 24/7, s’étendre aux zones mal desservies et fournir une prise de décision plus uniforme — réduisant le problème du « cela dépend de qui vous avez vu ».

Pourquoi c’est devenu faisable

Les premiers systèmes experts peinaient car ils reposaient sur des règles codées à la main et des jeux de données étroits. La faisabilité s’est améliorée à mesure que les données médicales se sont numérisées (DSE, imagerie, analyses, objets connectés) et que le calcul a rendu pratique l’entraînement de modèles sur d’énormes corpus et leur mise à jour continue.

Automatisation vs soins humains

Même dans cette logique, la ligne « remplacement » est généralement tracée autour des diagnostics routiniers et de la prise en charge guidée par des protocoles — pas des parties de la médecine centrées sur la confiance, les arbitrages complexes et l’accompagnement des patients face à la peur, l’ambiguïté ou des décisions qui changent la vie.

Principaux arguments et citations (avec contexte)

La phrase « l’IA remplacera les médecins » de Khosla est souvent prononcée comme une prévision provocante, non comme une promesse littérale d’hôpitaux sans médecins. Le thème récurrent dans ses interventions est que beaucoup de la médecine — en particulier le diagnostic et les décisions de traitement routinières — suit des motifs que le logiciel peut apprendre, mesurer et améliorer.

Argument 1 : la reconnaissance de motifs évolue plus vite que la formation humaine

Il présente fréquemment le raisonnement clinique comme une forme d’appariement de motifs entre symptômes, antécédents, images, analyses et résultats. L’affirmation centrale est qu’une fois qu’un modèle IA atteint un certain niveau de qualité, il peut être déployé largement et mis à jour en continu — tandis que la formation des cliniciens est lente, coûteuse et inégale selon les régions.

Un point clé de son cadrage est la variabilité : les cliniciens peuvent être excellents mais incohérents à cause de la fatigue, de la charge de travail ou d’une exposition limitée à des cas rares. L’IA, en revanche, peut offrir une performance plus stable et potentiellement des taux d’erreur plus faibles quand elle est testée, surveillée et réentraînée correctement.

Argument 3 : l’avis secondaire devient la norme

Plutôt que d’imaginer l’IA comme un remplacement tranchant, sa version la plus forte ressemble plus à : la plupart des patients consulteront d’abord une IA, et les cliniciens humains agiront de plus en plus comme réviseurs pour les cas complexes, les situations limites et les décisions à forts enjeux.

Contexte important : une prévision débattue, pas un fait établi

Les partisans voient dans sa position une impulsion vers des résultats mesurables et un meilleur accès. Les critiques font valoir que la médecine réelle inclut ambiguïté, éthique et responsabilité — et que le « remplacement » dépend autant de la réglementation, des flux de travail et de la confiance que de la précision des modèles.

Les paris en santé qui s’alignent avec la thèse

L’affirmation « l’IA remplacera les médecins » s’aligne bien sur les types de startups santé que les VCs aiment financer : des sociétés qui peuvent croître vite, standardiser un travail clinique désordonné et transformer un jugement d’expert en logiciel.

Principales catégories d’investissement

Beaucoup des paris qui s’accordent avec cette thèse se regroupent autour de thèmes récurrents :

- Diagnostics et détection précoce : outils qui repèrent une maladie plus tôt que les soins de routine, souvent en combinant analyses, symptômes, antécédents et dossiers en un score de risque.

- Triage et orientation : « portes d’entrée » IA qui décident qui a besoin de soins urgents, qui peut s’auto‑soigner, et quel spécialiste consulter.

- Imagerie et interprétation de signaux : radiologie, anatomopathologie, photos dermatologiques, ECG — domaines où la reconnaissance de motifs est centrale et la performance mesurable.

- Automatisation des flux de travail : résumé de dossiers, documentation, support aux autorisations préalables, codage et gestion de la boîte de réception — moins spectaculaire, mais directement lié au temps des cliniciens.

Pourquoi ces paris correspondent aux incitations des VCs

Remplacer (ou réduire) le besoin de cliniciens représente un énorme enjeu : les dépenses de santé sont massives et la main‑d’œuvre en est un poste majeur. Cela crée des incitations à présenter des calendriers ambitieux — car lever des fonds récompense une histoire claire et à fort potentiel, même si l’adoption clinique et la réglementation avancent plus lentement que le logiciel.

Une solution point fait très bien une tâche (par ex. lire les radios thoraciques). Une plateforme vise à s’intégrer à de nombreux flux — triage, support au diagnostic, suivi, facturation — en utilisant des pipelines de données et des modèles partagés.

La narration « remplacer les médecins » repose davantage sur les plateformes : si l’IA ne gagne que sur une tâche étroite, les médecins s’adaptent ; si elle coordonne de nombreuses tâches de bout en bout, le rôle du clinicien peut basculer vers la supervision, les exceptions et la responsabilité.

Pour les fondateurs explorant ces idées de « plateforme », la vitesse compte tôt : il faut souvent des prototypes fonctionnels de flux d’admission, tableaux de bord pour cliniciens et pistes d’audit avant même de tester un flux. Des outils comme Koder.ai peuvent aider les équipes à construire des applications web internes (typiquement React en front, Go + PostgreSQL en back) depuis une interface de chat, puis exporter le code source et itérer rapidement. Pour tout ce qui touche aux décisions cliniques, il faudra néanmoins une validation appropriée, une revue sécurité et une stratégie réglementaire — mais le prototypage rapide peut raccourcir le chemin vers un pilote réaliste.

Où l’IA peut raisonnablement égaler ou battre les cliniciens

Créez des check-ins mobiles

Créez des applications Flutter pour les suivis et questionnaires à distance à partir d'instructions dans le chat.

L’IA dépasse déjà les humains dans des tranches spécifiques de travail clinique — surtout quand la tâche consiste principalement en reconnaissance de motifs, vitesse et constance. Cela ne signifie pas « médecin IA » au sens complet. Cela signifie que l’IA peut être une composante très forte des soins.

Les tâches où l’IA excelle vraiment

L’IA brille là où il y a beaucoup d’informations répétitives et des boucles de rétroaction claires :

- Résumé : transformer de longs dossiers en une chronologie claire (médicaments, analyses, diagnostics antérieurs) ou rédiger des notes de consultation à partir de transcriptions.

- Triage : classer symptômes et facteurs de risque en catégories d’urgence (auto‑soin vs consultation le jour même vs urgences), surtout en milieu à fort volume.

- Détection de motifs : repérer des signaux subtils dans images et tracés (radiologie, photos dermatologiques, ECG) et remarquer des combinaisons de tendances biologiques que l’humain peut manquer quand il est fatigué.

Dans ces domaines, « meilleur » signifie souvent moins de découvertes manquées, des décisions plus standardisées et des délais plus courts.

Support décisionnel clinique vs diagnostic autonome

Les succès réels aujourd’hui viennent surtout du support décisionnel clinique (CDS) : l’IA suggère des conditions probables, signale des alternatives dangereuses, recommande des examens suivants ou vérifie l’adhérence aux guides — tandis qu’un clinicien reste responsable.

Le diagnostic autonome (l’IA prend la décision de bout en bout) est possible dans des contextes limités et bien définis — comme des flux de dépistage avec protocoles stricts — mais ce n’est pas la norme pour des patients complexes présentant plusieurs affections.

L’accro : qualité et représentativité des données

La précision de l’IA dépend fortement des données d’entraînement qui reflètent la population et le contexte de soins. Les modèles peuvent dériver lorsque :

- l’hôpital utilise un équipement ou des styles de documentation différents,

- la composition des patients diffère (âge, origine ethnique, comorbidités),

- les labels de « vérité terrain » étaient inconsistants.

Pourquoi la supervision humaine reste essentielle

En milieu à forts enjeux, la supervision n’est pas optionnelle — c’est la couche de sécurité pour les cas limites, les présentations inhabituelles et le jugement basé sur les valeurs (ce qu’un patient est prêt à faire, tolérer ou prioriser). L’IA peut être excellente pour voir, mais les cliniciens doivent encore décider ce que cela signifie pour cette personne, aujourd’hui.

Là où l’IA échoue encore

L’IA peut être impressionnante pour faire correspondre des motifs, résumer des dossiers et proposer des diagnostics probables. Mais la médecine n’est pas seulement une tâche de prédiction. Les parties les plus difficiles surviennent quand la « bonne » réponse est floue, que les objectifs du patient contredisent les guides, ou que le système de soins est désordonné.

Confiance, présence au chevet et décisions partagées

Les gens ne veulent pas seulement un résultat — ils veulent se sentir entendus, crus et en sécurité. Un clinicien peut repérer la peur, la honte, la confusion ou les risques domestiques, puis adapter la conversation et le plan en conséquence. La prise de décision partagée exige aussi de négocier des compromis (effets secondaires, coût, mode de vie, soutien familial) de façon à construire une relation de confiance au fil du temps.

Ambiguïté, multi‑morbidité et cas rares

Les patients réels ont souvent plusieurs affections, des historiques incomplets et des symptômes qui ne rentrent pas dans une fiche propre. Les maladies rares et les présentations atypiques peuvent ressembler à des problèmes communs — jusqu’à ce qu’elles ne le soient pas. L’IA peut générer des suggestions plausibles, mais « plausible » n’est pas équivalent à « cliniquement prouvé », surtout quand le contexte subtil compte (voyage récent, nouveau médicament, facteurs sociaux, « quelque chose cloche »).

Responsabilité quand l’IA se trompe

Même un modèle très précis échouera parfois. La question difficile est : qui porte la responsabilité ? le clinicien qui a suivi l’outil, l’hôpital qui l’a déployé ou le fournisseur qui l’a construit ? Une responsabilité claire influence la prudence des équipes et la capacité des patients à obtenir réparation.

Réalité opérationnelle : s’intégrer aux cliniques et aux DSE

Les soins se déroulent dans des flux de travail. Si un outil IA ne s’intègre pas proprement aux DSE, aux systèmes d’ordonnances, à la documentation et à la facturation — ou s’il ajoute des clics et de l’incertitude — les équipes surchargées ne s’y fieront pas, aussi bonne que soit la démo.

Réglementation, éthique et sécurité dans l’IA médicale

L’IA médicale n’est pas qu’un problème d’ingénierie — c’est un problème de sécurité. Quand un logiciel influence un diagnostic ou un traitement, les régulateurs le traitent souvent comme un dispositif médical plutôt que comme une appli classique.

FDA et marquage CE : l’essentiel

Aux États‑Unis, la FDA régule de nombreux outils « Software as a Medical Device », surtout ceux qui diagnostiquent, recommandent un traitement ou affectent directement les décisions de soins. En UE, le marquage CE sous le règlement des dispositifs médicaux (MDR) a un rôle similaire.

Ces cadres exigent des preuves que l’outil est sûr et efficace, la clarté de l’usage prévu et une surveillance continue une fois déployé. Les règles comptent parce qu’un modèle impressionnant en démo peut échouer dans de vraies cliniques, avec de vrais patients.

Un risque éthique majeur est la performance inégale selon les populations (par ex. groupes d’âge, tons de peau, langues, comorbidités). Si les données d’entraînement sous‑représentent certains groupes, le système peut rater des diagnostics ou sur‑recommander des interventions pour eux. Tester l’équité, publier des rapports par sous‑groupes et concevoir soigneusement les jeux de données ne sont pas des options facultatives — ils font partie de la sécurité de base.

Confidentialité, consentement et données patients

L’entraînement et l’amélioration des modèles nécessitent souvent de grandes quantités de données sensibles. Cela soulève des questions de consentement, d’utilisation secondaire, des limites de la dé‑identification et de qui profite financièrement. Une bonne gouvernance inclut des avis clairs aux patients, des contrôles d’accès stricts et des politiques sur la rétention des données et la mise à jour des modèles.

« Human‑in‑the‑loop » comme modèle de sécurité

Beaucoup d’outils cliniques IA sont conçus pour assister plutôt que remplacer, en maintenant un clinicien responsable de la décision finale. Cette approche « humain‑dans‑la‑boucle » peut attraper des erreurs, fournir le contexte manquant au modèle et créer de la responsabilité — bien qu’elle ne fonctionne que si les flux et les incitations empêchent l’automatisation aveugle.

Ce que cela signifie pour les médecins et les emplois en santé

Commencez gratuitement, évoluez ensuite

Choisissez un forfait gratuit pour explorer, puis passez à un plan supérieur quand votre pilote en aura besoin.

L’affirmation de Khosla est souvent entendue comme « les médecins deviendront obsolètes ». Une lecture plus utile consiste à distinguer remplacement (l’IA exécute une tâche de bout en bout avec peu d’intervention) et réallocation (les humains restent propriétaires des résultats, mais le travail change vers la supervision, l’empathie et la coordination).

Remplacement vs réallocation

Dans beaucoup de contextes, l’IA va d’abord remplacer des morceaux de travail clinique : rédiger des notes, faire émerger des diagnostics différentiels, vérifier l’adhérence aux guides et résumer l’historique patient. Le rôle du clinicien se déplace de la génération de réponses vers l’audit, la contextualisation et la communication de celles‑ci.

Quels rôles changent en premier

La médecine primaire ressentira probablement le changement par une amélioration de l’accueil : les symptom checkers et la documentation ambiante réduiront le temps consacré aux visites de routine, tandis que les cas complexes et le soin relationnel resteront dirigés par des humains.

La radiologie et l’anatomopathologie pourraient voir un remplacement direct des tâches parce que le travail est déjà numérique et basé sur la reconnaissance de motifs. Cela n’implique pas moins de spécialistes du jour au lendemain — plutôt une plus grande productivité, de nouveaux flux qualité et une pression sur les remboursements.

Les soins infirmiers portent moins sur le diagnostic que sur l’évaluation continue, l’éducation et la coordination. L’IA peut réduire la charge administrative, mais les soins au chevet et les décisions d’escalade restent centrés sur les personnes.

Nouveaux métiers qui apparaîtront

On peut s’attendre à la croissance de postes comme superviseur IA (surveillance des performances des modèles), informatique clinique (workflow + gouvernance des données) et coordinateur de soins (fermeture des lacunes signalées par le modèle). Ces rôles pourront s’asseoir au sein des équipes existantes plutôt que d’être des titres séparés.

La formation médicale pourrait intégrer la littératie IA : comment valider des sorties, documenter l’appui et repérer des modes de faille. L’accréditation pourrait évoluer vers des standards « humain‑dans‑la‑boucle » — qui peut utiliser quels outils, sous quelle supervision et comment la responsabilité est attribuée lorsque l’IA se trompe.

Les contre‑arguments les plus solides à la vue de Khosla

La thèse de Khosla est provocante parce qu’elle réduit le « médecin » à une sorte de moteur diagnostique. Les objections les plus fortes soutiennent que, même si l’IA égalise les cliniciens en reconnaissance de motifs, remplacer le médecin est un travail différent.

La médecine, c’est plus que le diagnostic

Une large part de la valeur clinique réside dans le cadrage du problème, pas seulement sa résolution. Les médecins traduisent des histoires désordonnées en options praticables, négocient des compromis (risque, coût, temps, valeurs) et coordonnent les soins entre spécialistes. Ils gèrent aussi le consentement, l’incertitude et l’attente vigilante — domaines où confiance et responsabilité comptent autant que la précision.

Lacunes de preuve : essais, résultats et généralisation

Beaucoup de systèmes IA paraissent impressionnants dans des études rétrospectives, mais ce n’est pas équivalent à améliorer des résultats réels. La preuve la plus difficile est prospective : l’IA réduit‑elle les diagnostics manqués, les complications ou les tests inutiles à travers différents hôpitaux, groupes de patients et flux ?

La généralisation est un autre talon d’Achille. Les modèles peuvent se dégrader quand la population change, l’équipement diffère ou les habitudes de documentation évoluent. Un système performant sur un site peut échouer ailleurs — surtout pour les conditions rares.

Biais d’automatisation et sur‑confiance

Même de bons outils peuvent créer de nouveaux modes de défaillance. Les cliniciens peuvent se fier au modèle quand il a tort (biais d’automatisation) ou cesser de poser la seconde question qui attrape les cas limites. Avec le temps, les compétences peuvent s’atrophier si les humains deviennent des « tampons », rendant l’intervention difficile quand l’IA est incertaine ou incorrecte.

L’adoption peut traîner même si la technologie fonctionne

La santé n’est pas un marché purement technologique. Responsabilité, remboursement, cycles d’achat, intégration aux DSE et formation clinique ralentissent tous le déploiement. Les patients et les régulateurs peuvent aussi exiger un décideur humain pour les décisions à forts enjeux — ce qui fait que « l’IA partout » peut rester longtemps « l’IA supervisée par des médecins ».

Conseils pratiques pour les patients

Créez un prototype de flux de travail clinique

Transformez vos idées d'admission, de routage et de journal d'audit en une application fonctionnelle via le chat.

L’IA apparaît déjà dans la santé de façon discrète — scores de risque dans votre dossier, lectures automatisées d’imagerie, symptom checkers et outils qui priorisent qui est vu en premier. Pour les patients, l’objectif n’est pas de « faire confiance à l’IA » ou de la « rejeter », mais de savoir quoi attendre et comment garder le contrôle.

À quoi vous pouvez vous attendre (bon et moins bon)

Vous verrez probablement plus de dépistage (messages, questionnaires, données de wearables) et un triage plus rapide — surtout dans les cliniques et les urgences surchargées. Cela peut signifier des réponses plus rapides pour des problèmes courants et une détection plus précoce de certaines conditions.

La qualité sera mixte. Certains outils excellent dans des tâches étroites ; d’autres sont inconsistants selon l’âge, le teint de peau, les maladies rares ou les données du monde réel. Traitez l’IA comme une aide, pas comme un verdict final.

Questions à poser quand l’IA est impliquée

Si un outil IA influence vos soins, demandez :

- L’IA a‑t‑elle été utilisée pour le diagnostic, l’interprétation d’imagerie, le triage ou les recommandations de traitement ?

- Quelles données a‑t‑elle utilisées (mon historique, mes analyses, mes images, données de wearable) ?

- A‑t‑elle été validée sur des patients comme moi (âge, sexe, origine ethnique, pathologies) ?

- Qui est responsable de la décision finale — mon clinicien ou le logiciel ?

- Puis‑je voir le raisonnement ou les preuves derrière la recommandation ?

Beaucoup de sorties de l’IA sont des probabilités (« 20 % de risque ») plutôt que des certitudes. Demandez ce que ce chiffre signifie pour vous : que se passe‑t‑il à différents niveaux de risque, et quel est le taux de fausses alertes.

Si la recommandation est à forts enjeux (chirurgie, chimiothérapie, arrêt d’un médicament), demandez un second avis — humain et/ou un autre outil. Il est raisonnable de demander : « Que feriez‑vous si ce résultat d’IA n’existait pas ? »

Consentement éclairé et transparence

On doit vous informer lorsqu’un logiciel façonne de manière significative les décisions. Si cela vous met mal à l’aise, demandez les alternatives, comment vos données sont stockées et si le fait d’opter pour ne pas l’utiliser affecte l’accès aux soins.

Conseils pratiques pour cliniques et équipes de santé

L’IA est plus facile à adopter quand vous la traitez comme tout autre outil clinique : définissez l’usage, testez‑le, surveillez‑le et rendez la responsabilité évidente.

Commencez là où le risque est faible et le volume élevé

Avant d’utiliser l’IA pour diagnostiquer, employez‑la pour réduire les frictions quotidiennes. Les premières victoires les plus sûres sont les flux qui améliorent le débit sans prendre de décisions médicales :

- support à la documentation (notes de consultation, résumés après visite)

- planification, orientations, rédaction d’autorisations préalables

- routage et triage des messages patients

Ces domaines apportent souvent des gains de temps mesurables et aident les équipes à prendre confiance dans le changement. Si votre équipe a besoin d’outils internes légers pour soutenir ces workflows — formulaires d’admission, tableaux de routage, pistes d’audit, bases de connaissances pour le personnel — la construction rapide d’applications peut valoir autant que la qualité du modèle. Des plateformes comme Koder.ai sont conçues pour des équipes « vibe‑coding » : vous décrivez l’application en chat, itérez vite et exportez le code source quand vous êtes prêt à la durcir pour la production. Pour des contextes cliniques, considérez cela comme un accélérateur d’opérations et de pilotes, tout en effectuant le travail nécessaire de sécurité, conformité et validation.

Liste de contrôle simple avant le déploiement

Pour tout système IA qui touche aux soins — même indirectement — exigez des preuves et des contrôles opérationnels :

- Précision : validez sur votre mix de patients, pas seulement sur la démo du fournisseur

- Tests de biais : vérifiez les performances par âge, sexe, race/ethnicité, langue et comorbidités

- Surveillance : définissez des contrôles de dérive, des seuils d’alerte et qui répond

- Pistes d’audit : consignez les entrées, sorties, modèle/version et actions cliniques entreprises

Si un fournisseur ne peut pas expliquer comment le modèle a été évalué, mis à jour et audité, considérez‑le comme un signal de sécurité.

Bases d’implémentation qui évitent des échecs douloureux

Rendez « comment nous l’utilisons » aussi clair que « ce que ça fait ». Fournissez une formation aux cliniciens qui inclut les modes de défaillance communs et établissez des voies d’escalade explicites (quand ignorer l’IA, quand demander un collègue, quand référer, quand envoyer aux urgences). Désignez un propriétaire pour les revues de performance et le signalement des incidents.

Si vous souhaitez de l’aide pour sélectionner, piloter ou gouverner des outils, ajoutez une voie interne pour que les parties prenantes demandent du soutien via /contact (ou /pricing si vous proposez des services de déploiement).

Un calendrier réaliste et ce qu’il faut surveiller

Les prédictions selon lesquelles l’IA « remplacera les médecins » échouent souvent parce qu’elles traitent la médecine comme un seul métier à un seul terme final. Une vue plus réaliste est que le changement arrivera de façon inégale — selon la spécialité, le contexte et la tâche — et qu’il sera accéléré quand les incitations et les règles s’aligneront.

Attentes à court et long terme (sans prétendre connaître la date)

À court terme, les gains les plus visibles seront des « victoires de flux » : meilleur triage, documentation plus claire, autorisations préalables plus rapides et support décisionnel réduisant les erreurs évidentes. Ceux‑ci peuvent élargir l’accès sans forcer les patients à faire confiance à une machine seule.

Sur le long terme, vous verrez des changements graduels dans qui fait quoi — surtout dans les soins standardisés à fort volume où les données sont abondantes et les résultats mesurables.

À quoi le « remplacement » peut ressembler par étapes

Le remplacement signifie rarement la disparition des médecins. Il peut ressembler à :

- Assister : l’IA suggère, résume et signale le risque ; les cliniciens restent décideurs principaux.

- Superviser : les cliniciens supervisent les évaluations menées par l’IA, intervenant pour les cas limites et la responsabilité.

- Automatiser : pour des problèmes étroits et bien définis, l’IA gère la boucle complète (dépistage → décision → suivi) avec escalade humaine.

Signaux à surveiller

- Remboursement : les assureurs paient pour des visites soutenues par l’IA, la surveillance à distance ou le dépistage autonome.

- Approbations réglementaires : outils validés non seulement comme « support », mais pour prendre ou exécuter des décisions cliniques.

- Normes de responsabilité : règles plus claires sur qui est responsable quand l’IA se trompe — fournisseur, clinicien ou système de santé.

La prise de position équilibrée : les progrès seront réels et parfois étonnants, mais la médecine n’est pas que reconnaissance de motifs. La confiance, le contexte et les soins centrés sur le patient maintiendront les humains au centre — même si la boîte à outils évolue.