Pourquoi VMware compte au‑delà des machines virtuelles

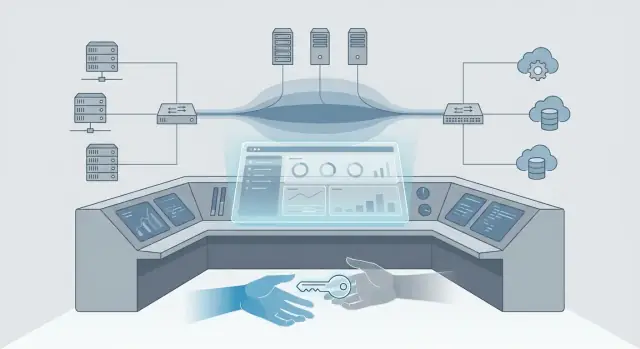

La virtualisation, en termes simples, permet d’exécuter de nombreux « serveurs » virtuels sur une seule machine physique — ainsi une seule machine peut se comporter en toute sécurité comme plusieurs. Un plan de contrôle est l’ensemble d’outils et de règles qui dit à un système ce qui doit tourner où, qui peut le modifier et comment c’est surveillé. Si la virtualisation est le moteur, le plan de contrôle est le tableau de bord, le volant et le code de la route.

Le rôle de VMware : la fondation par défaut

VMware n’a pas seulement aidé les organisations à acheter moins de serveurs. Avec le temps, vSphere et vCenter sont devenus l’endroit où les équipes :

- allouent la capacité de calcul (et acceptent ou refusent des demandes)

- standardisent templates, clusters et garde‑fous opérationnels

- connectent sauvegardes, supervision, contrôles de sécurité et gestion des changements

C’est pourquoi VMware compte au‑delà du simple « exécution de VM ». Dans de nombreuses entreprises, il est devenu la couche opératoire de l’infrastructure — le point où les décisions sont appliquées et auditées.

Ce que couvre cet article

Cet article examine comment la virtualisation est devenue un plan de contrôle d’entreprise, pourquoi cette position est stratégique et ce qui tend à changer lorsqu’un propriétaire ou une stratégie produit évolue. Nous ferons un bref historique, puis nous nous concentrerons sur les impacts pratiques pour les équipes IT : opérations, signaux budgétaires, risques, dépendances de l’écosystème et options réalistes (rester, diversifier ou migrer) sur les 6–18 prochains mois.

Ce que nous pouvons (et ne pouvons pas) savoir

Nous ne devinerons pas de feuilles de route confidentielles ni ne prédirons des mouvements commerciaux spécifiques. Nous nous focaliserons sur des schémas observables : ce qui change typiquement en premier après une acquisition (packaging, licences, modalités de support), comment ces changements affectent les opérations quotidiennes et comment décider avec une information incomplète — sans se figer ni sur‑réagir.

De la consolidation à la pratique standard : un bref historique

La virtualisation n’a pas commencé comme une idée de « plateforme ». Elle est née d’un besoin pratique : trop de serveurs sous‑utilisés, un encombrement matériel important et trop d’incidents causés par une application qui occupait une machine physique entière.

Une frise rapide : de l’efficacité à l’attente

Aux débuts, l’argument était simple — exécuter plusieurs charges sur un hôte physique et arrêter d’acheter autant de serveurs. Cela a vite évolué en habitude opérationnelle.

- Ère de la consolidation serveur : moins de machines physiques, meilleure utilisation, approvisionnement plus rapide.

- Ère de la standardisation : une approche unique pour les abstractions compute, stockage et réseau à travers les équipes.

- Ère des opérations : la gestion centralisée est devenue aussi importante que l’hyperviseur lui‑même.

Une fois la virtualisation répandue, le plus grand bénéfice n’était pas seulement « nous avons économisé sur le matériel ». C’était que les équipes pouvaient répéter les mêmes modèles partout.

Au lieu d’avoir un équipement serveur unique par site, la virtualisation a encouragé une base cohérente : builds d’hôtes similaires, templates communs, planification de capacité prévisible et pratiques partagées pour les patchs et la reprise. Cette cohérence comptait pour :

- le siège vs les agences locales

- production vs environnements de test

- équipes applicatives avec des calendriers de livraison différents

Même lorsque le matériel sous‑jacent différait, le modèle opérationnel pouvait rester majoritairement le même.

La gestion de type vCenter : la surface de travail quotidienne

À mesure que les environnements grandissaient, le centre de gravité est passé des hôtes individuels à la gestion centralisée. Des outils comme vCenter n’ont pas seulement « géré la virtualisation » — ils sont devenus l’endroit où les administrateurs réalisaient le travail courant : contrôle d’accès, inventaire, alarmes, santé des clusters, allocation des ressources et fenêtres de maintenance sûres.

Dans beaucoup d’organisations, si ce n’était pas visible dans la console de gestion, c’était pratiquement ingérable.

Pourquoi « assez bon partout » l’emporte sur « meilleur partout »

Une plateforme standard peut dépasser un ensemble d’outils best‑of‑breed quand la répétabilité est prioritaire. « Assez bon partout » signifie souvent :

- moins de transferts entre équipes

- formation et onboarding plus simples

- responsabilité opérationnelle plus claire

C’est ainsi que la virtualisation est passée d’un levier d’économie à une pratique standard — et a préparé le terrain pour devenir un plan de contrôle d’entreprise.

La virtualisation a commencé comme un moyen d’exécuter plus de charges sur moins de serveurs. Mais une fois que la plupart des applications ont vécu sur une plateforme virtuelle partagée, « l’endroit où l’on clique en premier » est devenu l’endroit où les décisions sont appliquées. C’est ainsi qu’une pile hyperviseur évolue vers un plan de contrôle d’entreprise.

Les équipes IT ne gèrent pas seulement le « compute ». Les opérations quotidiennes couvrent :

- Compute : allocation CPU/mémoire, clusters d’hôtes, capacité

- Stockage : datastores, niveaux de performance, snapshots, réplication

- Réseau : commutateurs virtuels, segmentation, schémas d’équilibrage de charge

- Identité et accès : qui peut provisionner, qui peut changer les politiques, traces d’audit

- Apps et services : règles de placement, exigences de disponibilité, fenêtres de maintenance

Quand ces couches sont orchestrées depuis une seule console, la virtualisation devient le centre pratique des opérations — même si le matériel sous‑jacent est hétérogène.

Provisioning centralisé, politiques et accès

Un changement clef est que le provisioning devient piloté par la politique. Au lieu de « construire un serveur », les équipes définissent des garde‑fous : images approuvées, limites de dimensionnement, zones réseau, règles de sauvegarde et permissions. Les demandes se traduisent en résultats standardisés.

Voilà pourquoi des plateformes comme vCenter finissent par fonctionner comme un système d’exploitation pour le datacenter : non pas parce qu’elles exécutent vos applications, mais parce qu’elles décident comment les applications sont créées, placées, sécurisées et maintenues.

Templates, images maîtresses et pipelines d’automatisation verrouillent silencieusement des comportements. Une fois que les équipes standardisent un template VM, un schéma de tags ou un workflow de patching et de reprise, cela se diffuse dans les départements. Avec le temps, la plateforme n’héberge pas juste des charges — elle ancre des pratiques opérationnelles.

Où se déplace le centre de gravité

Quand une console pilote « tout », le centre de gravité passe des serveurs à la gouvernance : validations, preuves de conformité, séparation des tâches et contrôle des changements. Voilà pourquoi un changement de propriété ou de stratégie n’affecte pas seulement les prix — il affecte la façon dont l’IT opère, la rapidité de réponse et la sécurité des modifications.

Ce que « plan de contrôle » signifie pour les opérations quotidiennes

Quand on qualifie VMware de « plan de contrôle », on ne veut pas dire qu’il s’agit seulement de l’endroit où les machines virtuelles tournent. On veut dire que c’est l’endroit où le travail quotidien est coordonné : qui peut faire quoi, ce qui est sûr de changer et comment les problèmes sont détectés et résolus.

Les opérations Day‑2 : le travail qui remplit l’agenda

La majorité de l’effort IT survient après le déploiement initial. Dans un environnement VMware, le plan de contrôle est l’endroit où vivent les opérations Day‑2 :

- Patching et mises à jour : coordination des firmwares d’hôtes, patch ESXi, mises à jour vCenter, contrôles d’intégrité de cluster et plans de rollback.

- Capacité et performance : suivi des marges CPU/RAM/stockage, redimensionnement des charges et décision d’ajouter des hôtes ou de rééquilibrer.

- Dépannage : corrélation des alarmes, événements et graphiques de performance pour isoler si le problème vient du compute, du stockage, du réseau ou de l’app.

Parce que ces tâches sont centralisées, les équipes construisent des runbooks reproductibles autour d’elles — fenêtres de changement, étapes d’approbation et séquences « connues bonnes ».

Compétences, runbooks et outils sont persistants pour une raison

Avec le temps, la connaissance VMware devient une mémoire opérationnelle : standards de nommage, modèles de conception de clusters et exercices de reprise. C’est difficile à remplacer, non pas parce que des alternatives n’existent pas, mais parce que la cohérence réduit le risque. Une nouvelle plateforme implique souvent d’apprendre de nouveaux cas limites, de réécrire les runbooks et de revalider des hypothèses sous pression.

La réponse aux incidents dépend de la visibilité et des permissions

Lors d’une panne, les intervenants s’appuient sur le plan de contrôle pour :

- Visibilité : alertes, chronologies d’événements et historique de performance.

- Permissions : qui peut redémarrer une VM, déplacer des charges ou modifier le réseau.

- Traces d’audit : prouver ce qui a changé, quand et par qui.

Si ces workflows évoluent, le temps moyen de rétablissement peut aussi augmenter.

Dépendances cachées que l’on remarque seulement quand elles cassent

La virtualisation est rarement isolée. Sauvegarde, supervision, reprise après sinistre, gestion de configuration et systèmes de ticketing s’intègrent étroitement à vCenter et à ses APIs. Les plans DR peuvent supposer un comportement de réplication précis ; les jobs de sauvegarde peuvent dépendre de snapshots ; la supervision peut s’appuyer sur des tags et des dossiers. Quand le plan de contrôle change, ces intégrations sont souvent les premières « surprises » à inventorier et tester.

Changements de propriété : ce qui bouge en premier

Quand une plateforme aussi centrale que VMware change de propriétaire, la technologie ne cesse généralement pas de fonctionner du jour au lendemain. Ce qui change d’abord, c’est l’enveloppe commerciale : comment vous l’achetez, comment vous le renouvelez et ce à quoi ressemble le « normal » en termes de budget et de support.

Séparez la valeur produit des termes commerciaux

Beaucoup d’équipes tirent encore une énorme valeur opérationnelle de vSphere et vCenter — provisioning standardisé, opérations cohérentes et chaîne d’outils familière. Cette valeur peut rester stable même si les conditions commerciales évoluent rapidement.

Il est utile de traiter ces deux conversations séparément :

- Valeur produit : ce que la plateforme permet (stabilité, automatisation, gouvernance).

- Conditions commerciales : métriques de licence, bundles, niveaux de support, mécanismes de renouvellement et remises.

Pourquoi les changements de propriété déclenchent des revues de prix et d’assemblage

Un nouveau propriétaire a souvent pour mandat de simplifier le catalogue, augmenter la valeur moyenne des contrats ou faire migrer les clients vers moins de bundles. Cela peut se traduire par des changements de :

- métriques de licence et minima

- composition des bundles (ce qui est « inclus » vs en add‑on)

- droits de support et niveaux de réponse

- calendriers de renouvellement et structures contractuelles

Préoccupations concrètes des entreprises : renouvellements et prévisibilité

Les inquiétudes pratiques sont souvent peu glamours mais réelles : « Quel sera le coût l’an prochain ? » et « Peut‑on obtenir une prévision pluriannuelle ? ». La finance veut des prévisions stables ; l’IT veut l’assurance qu’un renouvellement ne forcera pas des décisions d’architecture précipitées.

Que rassembler avant les discussions de renouvellement

Avant de parler chiffres, construisez une base factuelle :

- Inventaire : clusters, hosts, coeurs, éditions et quels environnements importent le plus.

- Réalité d’utilisation : quelles fonctionnalités vous utilisez réellement vs ce à quoi vous avez droit.

- Contrats et historique : SKUs/bundles actuels, dates de renouvellement, niveau de support, clauses de true‑up et concessions antérieures.

Avec cela, vous négociez depuis la clarté — que votre plan soit de rester, diversifier ou préparer une migration.

Changements de stratégie : bundles, roadmaps et focus produit

Rendez la planification des renouvellements visible

Créez un tableau de bord de préparation aux renouvellements que vos équipes plateforme et finance peuvent mettre à jour ensemble.

Quand un éditeur change de stratégie, la première chose ressentie par beaucoup d’équipes n’est pas une nouvelle fonctionnalité, mais une nouvelle manière d’acheter et de planifier. Pour les clients VMware observant la direction de Broadcom, l’impact pratique apparaît souvent dans les bundles, les priorités de feuille de route et les produits qui reçoivent le plus d’attention.

Bundles : achats simplifiés, flexibilité réduite

Le bundling peut être utile : moins de SKUs, moins de débats « avons‑nous acheté le bon add‑on ? » et une standardisation plus claire.

Le compromis est la flexibilité. Si le bundle inclut des composants que vous n’utilisez pas (ou que vous ne voulez pas standardiser), vous risquez de payer du shelfware ou d’être poussé vers une architecture « one size fits most ». Les bundles compliquent aussi les pilotes progressifs, car vous n’achetez plus forcément la pièce isolée dont vous avez besoin.

Les feuilles de route produit favorisent souvent les segments clients qui génèrent le plus de revenus et de renouvellements. Cela peut signifier :

- plus d’attention aux grandes fermes standardisées

- moins d’attention aux cas limites, petites déploiements ou intégrations niche

- des changements dans la rapidité d’application des correctifs pour les versions anciennes

Rien de tout cela n’est intrinsèquement mauvais — mais cela change la façon de planifier les upgrades et les dépendances.

Focus produit et risque d’explosion des outils

Si certaines capacités sont dépriorisées, les équipes comblent souvent les lacunes avec des solutions pointues (sauvegarde, supervision, sécurité, automatisation). Cela résout des problèmes immédiats mais crée de la spaghettification d’outils : plus de consoles, plus de contrats, plus d’intégrations à maintenir et plus d’endroits où les incidents peuvent se cacher.

Questions à poser aux fournisseurs (et obtenir par écrit)

Demandez des engagements et des limites claires :

- Quel est le calendrier de support pour nos versions et notre modèle de déploiement actuels ?

- Quelles fonctionnalités sont sur la roadmap et quelles sont les fenêtres de livraison visées ?

- Qu’est‑ce qui est explicitement hors périmètre (et ne sera pas supporté) à l’avenir ?

- Où s’arrête le support : produit éditeur, intégration partenaire ou « effort de bonne volonté » ?

Ces réponses transforment un « changement de stratégie » en entrées de planification concrètes pour budgets, effectifs et risque.

Ce qui change pour les équipes IT, pas seulement pour le CFO

Quand VMware est traité comme un plan de contrôle, un changement de licence ou d’emballage ne reste pas dans les mains des achats. Il modifie la façon dont le travail circule dans l’IT : qui peut approuver les changements, la vitesse de provisionnement des environnements et ce que « standard » signifie entre équipes.

Les administrateurs plateforme ressentent souvent les effets de premier ordre. Si les droits sont simplifiés en moins de bundles, les opérations quotidiennes peuvent devenir moins flexibles : il peut falloir une approbation interne pour utiliser une fonctionnalité auparavant « disponible », ou se standardiser sur moins de configurations.

Cela se traduit par plus de travail administratif là où on ne le voit pas toujours — contrôles de licence avant le démarrage d’un projet, fenêtres de changement plus strictes pour aligner les upgrades et plus de coordination avec sécurité et équipes applicatives autour du patching et de la dérive de configuration.

Les équipes applicatives sont mesurées sur la performance et la disponibilité, mais les changements de plateforme peuvent modifier les hypothèses sous‑jacentes. Si des clusters sont rééquilibrés, le nombre d’hôtes change ou l’usage des fonctionnalités est ajusté pour correspondre aux nouveaux droits, les propriétaires d’applications devront retester la compatibilité et rebaseliner la performance.

C’est particulièrement vrai pour les charges dépendant de comportements de stockage, réseau ou HA/DR spécifiques. Le résultat pratique : des cycles de test plus structurés et une documentation claire de « ce dont cette application a besoin » avant les changements approuvés.

Si la couche de virtualisation est votre point d’application pour la segmentation, l’accès privilégié et les traces d’audit, tout changement d’outillage ou de configurations standard affecte la conformité.

Les équipes sécurité demanderont une séparation des tâches plus claire (qui peut changer quoi dans vCenter), une conservation cohérente des logs et moins de configurations « exceptionnelles ». Attendez‑vous à des revues d’accès plus formalisées et à des enregistrements de changement.

Achats et finance : l’onde de choc opérationnelle du coût

Même si le déclencheur est le coût, l’impact est opérationnel : les modèles de refacturation peuvent devoir être mis à jour, les centres de coût peuvent renégocier ce qui est « inclus » et les prévisions deviennent une collaboration avec les équipes plateforme.

Un bon indicateur que vous traitez la virtualisation comme un plan de contrôle est quand IT et finance planifient ensemble au lieu de concilier des surprises après le renouvellement.

Gestion du risque : continuité, support et exposition opérationnelle

Opérationnalisez les runbooks Day‑2

Transformez les runbooks en une application de check‑list légère pour les correctifs, les mises à niveau et la validation avant changement.

Quand une plateforme comme VMware change de propriétaire et de stratégie, les risques majeurs apparaissent souvent dans les parties « calmes » de l’IT : plans de continuité, attentes de support et sécurité opérationnelle quotidienne. Même si rien ne casse immédiatement, des hypothèses sur lesquelles vous comptiez depuis des années peuvent évoluer.

Continuité n’est pas que DR — c’est votre workflow de restauration

Un changement majeur peut impacter subtilement sauvegarde, reprise et rétention. Les produits de sauvegarde peuvent dépendre d’APIs spécifiques, de permissions vCenter ou du comportement des snapshots. Les runbooks DR supposent souvent des fonctionnalités de cluster, des defaults réseau et des étapes d’orchestration. Les plans de rétention peuvent aussi être affectés si des intégrations de stockage ou d’archivage changent.

Actionnable : validez votre processus de restauration de bout en bout (pas seulement le succès de la sauvegarde) pour les systèmes qui comptent le plus — identité tier‑0, outils de management et applications métiers critiques.

Exposition opérationnelle : où l’on se fait surprendre

Les zones de risque communes sont opérationnelles plus que contractuelles :

- Upgrades et patchs : un changement de cadence ou d’exigences peut transformer une mise à jour « routinière » en projet.

- Compatibilité drivers/firmware : des matrices de support plus strictes peuvent bloquer des serveurs plus anciens, des HBA, NIC ou arrays.

- Intégrations : agents de supervision/sécurité, connecteurs de sauvegarde et scripts d’automatisation peuvent échouer si APIs, permissions ou packaging changent.

Le risque pratique est une indisponibilité due aux « inconnues inconnues », pas seulement à des coûts plus élevés.

Concentration des fournisseurs : les compromis

Quand une plateforme domine, vous gagnez en standardisation, en réduction des compétences nécessaires et en outils cohérents. Le compromis est la dépendance : moins de voies de sortie si la licence, le support ou le focus produit changent.

Le risque de concentration est maximal quand VMware soutient non seulement les workloads, mais aussi l’identité, les sauvegardes, la journalisation et l’automatisation.

Atténuations pratiques à débuter maintenant

Documentez ce que vous exécutez réellement (versions, dépendances et points d’intégration), resserrez les revues d’accès pour les rôles vCenter/admin, et fixez un rythme de tests : restaurations trimestrielles, exercices DR semiannuels et une checklist de pré‑upgrade qui inclut la compatibilité hardware et la confirmation des fournisseurs tiers.

Ces étapes réduisent le risque opérationnel quelle que soit la direction stratégique prise.

L’effet écosystème : partenaires, outils et interopérabilité

VMware fonctionne rarement en silo. La plupart des environnements dépendent d’un réseau de fournisseurs hardware, MSPs, plateformes de sauvegarde, outils de supervision, agents de sécurité et services DR. Quand la propriété et la stratégie produit changent, le rayon d’impact se voit souvent d’abord dans cet écosystème — parfois avant d’être visible dans vCenter.

Pourquoi les certifications et matrices de support comptent

Les vendeurs hardware, MSPs et ISVs alignent leur support sur des versions, éditions et modèles de déploiement précis. Leurs certifications et matrices de support déterminent ce qu’ils dépanneront — et ce sur quoi ils vous demanderont de faire une mise à niveau avant d’intervenir.

Un changement de licence ou de packaging peut indirectement forcer des mises à niveau (ou les empêcher), ce qui impacte alors la liste des matériels supportés : serveurs, HBA, NIC, arrays ou proxies de sauvegarde.

Outils tiers : hypothèses de tarification et support qui peuvent bouger

Beaucoup d’outils tiers ont historiquement tarifé ou empaqueté autour d’hypothèses « par socket », « par host » ou « par VM ». Si le modèle commercial de la plateforme change, ces outils peuvent ajuster leur comptage, quelles fonctionnalités requièrent des add‑ons ou quelles intégrations sont incluses.

Les attentes de support peuvent aussi évoluer. Par exemple, un éditeur peut exiger un accès API spécifique, une compatibilité plugin ou des versions minimales de vSphere/vCenter pour supporter une intégration. Avec le temps, « ça marchait » devient « ça marche, mais seulement sur ces versions et ces niveaux ».

Kubernetes et conteneurs : à côté, pas en remplacement

Les conteneurs et Kubernetes réduisent parfois la pression sur la prolifération de VM, mais n’éliminent pas le besoin de virtualisation dans beaucoup d’entreprises. Les équipes exécutent souvent Kubernetes sur des VM, dépendent des politiques réseau et stockage virtuel et utilisent les modèles de sauvegarde/DR existants.

Cela signifie que l’interopérabilité entre l’outillage conteneur et la couche de virtualisation reste importante — particulièrement autour de l’identité, du réseau, du stockage et de l’observabilité.

Éviter les surprises : valider les dépendances tôt

Avant de vous engager à « rester, diversifier ou migrer », inventoriezz les intégrations sur lesquelles vous comptez : sauvegardes, DR, supervision, CMDB, scans de vulnérabilités, MFA/SSO, recouvrements réseau/sécurité, plugins de stockage et runbooks MSP.

Validez ensuite trois choses : ce qui est supporté aujourd’hui, ce qui sera supporté sur votre upgrade suivant, et ce qui deviendrait non‑supporté si le packaging/licence modifiait votre manière de déployer ou gérer la plateforme.

Vos options : rester, diversifier ou migrer

Une fois que la virtualisation sert de plan de contrôle Day‑to‑day, un changement ne peut pas se traiter comme un simple « switch » de plateforme. La plupart des organisations suivent une de quatre voies — parfois combinées.

1) Rester (et traiter ça comme un projet de renouvellement)

Rester ne signifie pas « ne rien faire ». Cela implique généralement de consolider l’inventaire, standardiser les designs de clusters et supprimer la spaghettification afin de ne payer que ce que vous exploitez réellement.

Si votre objectif principal est maîtriser les coûts, commencez par right‑sizer les hôtes, réduire les clusters sous‑utilisés et valider les fonctionnalités réellement nécessaires. Si votre objectif est la résilience, concentrez‑vous sur l’hygiène opérationnelle : cadence de patchs, tests de sauvegarde et étapes de récupération documentées.

2) Optimiser (s’alléger avant de bouger)

L’optimisation est le mouvement à court terme le plus fréquent car elle réduit le risque et achète du temps. Actions typiques : consolider les domaines de gestion, nettoyer templates/snapshots et aligner standards stockage/réseau pour que d’éventuelles migrations futures soient moins douloureuses.

3) Diversifier (utiliser des alternatives là où elles conviennent)

La diversification fonctionne mieux quand vous choisissez des zones « sûres » pour introduire une autre pile sans tout replatformer. Cas courants :

- Petits clusters pour une seule équipe applicative

- Sites edge avec faible overhead opérationnel

- Dev/test où la tolérance aux interruptions est plus élevée

- Pilotes VDI ou pools isolés

L’objectif est souvent diversification fournisseur ou agilité, pas remplacement immédiat.

4) Migrer (partiellement ou totalement)

« Migrer » signifie plus que déplacer des VM. Préparez le bundle complet : workloads, réseau (VLANs, routage, firewalls, load balancers), stockage (datastores, réplication), sauvegardes, supervision, identité/accès et — souvent sous‑estimé — compétences et procédures opérationnelles.

Fixez des objectifs réalistes : optimisez‑vous pour le prix, la rapidité, la réduction du risque ou la flexibilité stratégique ? Des priorités claires évitent qu’une migration ne se transforme en reconstruction sans fin.

Un cadre décisionnel pratique pour les 6–18 prochains mois

Conservez la propriété du code que vous créez

Conservez le contrôle total en exportant le code source lorsque votre application interne est prête à être prise en charge à long terme.

Si VMware est votre plan de contrôle opérationnel, les décisions liées à VMware/Broadcom ne doivent pas commencer par un communiqué de presse — elles doivent commencer par votre environnement. Sur les 6–18 prochains mois, remplacez les hypothèses par des faits mesurables, puis choisissez une voie selon le risque et l’adéquation opérationnelle.

1) Construire un inventaire prêt pour la décision

Créez un inventaire que votre équipe d’exploitation ferait confiance en cas d’incident, pas une feuille Excel conçue pour les achats.

- Charges : ce qui tourne sur vSphere aujourd’hui (et où)

- Criticité : impact métier, RTO/RPO, saisons hautes

- Dépendances : stockage partagé, sauvegarde, outillage réseau/sécurité, identité

- Propriétaires : propriétaire application + propriétaire plateforme + contact d’escalade

Cet inventaire est la base pour comprendre ce que vCenter permet réellement — et ce qu’il serait difficile de reproduire ailleurs.

2) Mesurer l’utilisation et right‑sizer avant de comparer des options

Avant de débattre de licences vSphere ou d’autres plateformes, quantifiez votre baseline et éliminez le gaspillage évident.

Concentrez‑vous sur :

- CPU, mémoire, stockage au niveau cluster et VM

- Patterns de sur‑provisionnement (VMs inactives, templates surdimensionnés)

- Exposition licences (ce qui est utilisé vs ce qui est déployé)

Le right‑sizing peut réduire immédiatement vos coûts de virtualisation et rend toute planification de migration plus précise.

3) Définir des critères qui reflètent vos contraintes

Rédigez vos critères de décision et pesez‑les. Catégories typiques :

- Risque : tolérance aux pannes, dépendance fournisseur, continuité de support

- Coût : licences, renouvellement hardware, effectif ops, formation

- Temps : rapidité nécessaire pour obtenir une réponse (et un rollback)

- Compétences : ce que votre équipe maîtrise

- Conformité & performance : audits, résidence des données, latence

4) Lancer un pilote avec garde‑fous

Choisissez une charge représentative (pas la plus simple) et exécutez un pilote avec :

- Métriques de succès (performance, récupération, effort opérationnel)

- Un plan de rollback testé, avec conditions de déclenchement claires

- Validation signée des limites de risque par la direction

Traitez le pilote comme une répétition pour les opérations Day‑2 — pas juste comme une démo de migration.

5) Ne pas ignorer la couche « outillage interne »

Dans la réalité, une grande part du plan de contrôle est l’ensemble des petits systèmes autour : trackers d’inventaire, tableaux de bord de renouvellement, workflows de revue d’accès, checklists de runbook et coordination des fenêtres de changement.

Si vous devez construire ou moderniser rapidement cet outillage, une plateforme de type "vibe‑coding" comme Koder.ai peut aider les équipes à créer des web apps internes légères via une interface chat (mode planification, snapshots/rollback, export de code source). Par exemple, vous pouvez prototyper une appli d’inventaire d’intégration vCenter ou un tableau de bord de readiness pour les renouvellements (front‑end React, back‑end Go + PostgreSQL), l’héberger sous un domaine personnalisé et itérer vite sans attendre un cycle de développement complet.

Prochaines étapes : une checklist pour commencer cette semaine

Vous n’avez pas besoin d’une stratégie plateforme achevée pour avancer. L’objectif cette semaine est de réduire l’incertitude : connaître vos dates, connaître votre couverture et savoir qui doit être présent quand les décisions arrivent.

1) Confirmer votre réalité contractuelle et de support (aujourd’hui)

Commencez par des faits que vous pouvez montrer en réunion.

- Dates clés : début/fin de l’abonnement/ELA actuel, fenêtres de true‑up, période de préavis de renouvellement et clauses de renouvellement automatique

- Couverture de support : niveau de support actif, quels produits sont couverts (vSphere, vCenter, NSX, etc.) et quels environnements sont exclus (lab, DR, filiales)

- Calendrier de renouvellement : travaillez à rebours depuis la date de renouvellement pour fixer des délais internes d’évaluation, budgétisation, achats et approbations

2) Mettre en place un plan de communication (cette semaine)

Les changements de propriété et de licence créent des surprises quand différentes équipes tiennent des morceaux distincts du puzzle.

Rassemblez un petit groupe de travail : plateforme/virtualisation, sécurité, propriétaires applicatifs et finance/achats. Mettez‑vous d’accord sur :

- un propriétaire accountable pour le plan

- un checkpoint hebdomadaire de 30 minutes jusqu’à clarification du renouvellement

- un seul endroit pour stocker décisions et hypothèses (un document partagé suffit)

3) Constituer un pack documentaire prêt décision (2–3 heures)

Visez « suffisant pour estimer risque et coût », pas un inventaire parfait.

- Diagrammes d’architecture : clusters, topologie vCenter, dépendances clés (sauvegarde, supervision, IAM)

- Runbooks : cadence de patchs, étapes d’incident, procédures DR et qui peut approuver les changements

- Modèle d’accès : rôles admin, comptes break‑glass, état MFA et accès tiers

4) Mettre trois points en revue trimestrielle

Considérez cela comme un cycle de gestion continu, pas un événement ponctuel.

Revoyez trimestriellement : roadmap/licences fournisseur, coût courant vs budget et KPIs opérationnels (volume d’incidents, conformité aux patchs, résultats des tests de restauration). Ajoutez les conclusions à vos notes de renouvellement et de planification de migration.